هوش مصنوعی در حال پارگی است. ماشین ها می توانند صحبت کنند، بنویسند، بازی کنند و تصاویر، ویدیو و موسیقی اصلی تولید کنند. اما با افزایش قابلیتهای هوش مصنوعی، الگوریتمهای آن نیز رشد کردهاند.

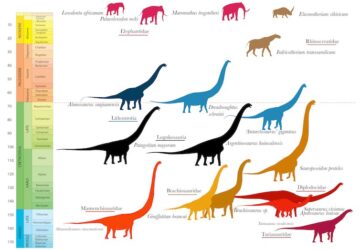

یک دهه پیش، الگوریتم های یادگیری ماشینی به ده ها میلیون اتصال داخلی متکی بود، یا پارامترها الگوریتم های امروزی به طور منظم به صدها میلیارد و حتی تریلیون ها پارامتر. محققان میگویند که افزایش مقیاس همچنان باعث افزایش عملکرد میشود و مدلهایی با دهها تریلیون پارامتر ممکن است در کوتاهمدت وارد بازار شوند.

برای آموزش مدل هایی به این بزرگی، به کامپیوترهای قدرتمندی نیاز دارید. در حالی که هوش مصنوعی در اوایل دهه 2010 بر روی تعداد معدودی از واحدهای پردازش گرافیکی اجرا میشد - تراشههای رایانهای که در پردازش موازی بسیار مهم برای هوش مصنوعی عالی هستند - نیازهای محاسباتی به صورت تصاعدی رشد کرده اند، و مدل های برتر اکنون به صدها یا هزاران مورد نیاز دارند. OpenAI، مایکروسافت, متاو دیگران در حال ساخت ابررایانه های اختصاصی برای انجام این کار هستند و آنها می گویند که این ماشین های هوش مصنوعی در بین سریع ترین ها در این سیاره قرار دارند.

اما حتی با وجود اینکه پردازندههای گرافیکی برای مقیاسبندی هوش مصنوعی بسیار مهم بودهاند – برای مثال A100 انویدیا هنوز یکی از سریعترین و رایجترین تراشههای مورد استفاده در خوشههای هوش مصنوعی است – جایگزینهای عجیبتری که بهطور خاص برای هوش مصنوعی طراحی شدهاند در سالهای اخیر ظاهر شدهاند.

Cerebras یکی از این جایگزین ها را ارائه می دهد.

درست کردن یک وعده غذایی با هوش مصنوعی

اندازه یک بشقاب شام - حدود 8.5 اینچ در یک طرف - موتور مقیاس ویفر این شرکت است. بزرگترین تراشه سیلیکونی در جهانبا 2.6 تریلیون ترانزیستور و 850,000 هسته حک شده بر روی یک ویفر سیلیکونی. هر موتور مقیاس ویفر به عنوان قلب کامپیوتر CS-2 این شرکت عمل می کند.

CS-2 به تنهایی یک جانور است، اما پارسال سربراس از طرحی رونمایی کرد برای اتصال CS-2 به یک سیستم حافظه خارجی به نام MemoryX و یک سیستم برای اتصال CS-2 به نام SwarmX. این شرکت گفت که فناوری جدید میتواند تا 192 تراشه را به هم متصل کند و مدلهای قطار را دو مرتبه بزرگتر از بزرگترین و پیشرفتهترین هوش مصنوعیهای امروزی به هم متصل کند.

اندرو فلدمن، مدیرعامل و بنیانگذار سربراس گفت: «صنعت در حال عبور از مدلهای 1 تریلیون پارامتری است و ما در حال گسترش این مرز با دو مرتبه بزرگی هستیم و شبکههای عصبی در مقیاس مغز را با 120 تریلیون پارامتر فعال میکنیم.»

در آن زمان همه اینها تئوری بود. اما هفته گذشته، شرکت اعلام کرد آنها 16 CS-2 را به یک ابررایانه هوش مصنوعی در کلاس جهانی متصل کردند.

با آندرومدا آشنا شوید

دستگاه جدید که آندرومدا نام دارد، دارای 13.5 میلیون هسته است که قادر به سرعت بالای یک اگزافلاپ (یک کوینتیلیون عملیات در ثانیه) با دقت 16 بیتی است. با توجه به تراشه منحصربفرد موجود در هسته آن، آندرومدا به راحتی با ابررایانه هایی که بر روی CPU ها و GPU های سنتی تر کار می کنند مقایسه نمی شود، اما فلدمن گفت سیم HPC آندرومدا تقریباً معادل ابررایانه Polaris آزمایشگاه ملی آرگون است که رتبه هفدهمین سریعترین جهانطبق آخرین لیست Top500.

علاوه بر عملکرد، زمان ساخت سریع، هزینه و ردپای آندرومدا قابل توجه است. آرگون شروع به نصب Polaris کرد در تابستان 2021 و ابرکامپیوتر حدود یک سال بعد زنده شد. 40 قفسه را اشغال می کند، محفظه های بایگانی مانند اجزای ابر رایانه را در خود جای داده است. در مقام مقایسه، آندرومدا 35 میلیون دلار هزینه داشت - قیمت متوسطی برای دستگاهی با قدرت آن - قیمت پایینی داشت فقط سه روز مونتاژ، و از 16 قفسه استفاده می کند.

Cerebras سیستم را با آموزش پنج نسخه از مدل زبان بزرگ OpenAI GPT-3 و همچنین GPT-J و GPT-NeoX منبع باز Eleuther AI آزمایش کرد. و به گفته سربراس، شاید مهمترین یافته این باشد که آندرومدا آنچه را که آنها «مقیاسگذاری خطی تقریباً کامل» بارهای کاری هوش مصنوعی را برای مدلهای زبان بزرگ مینامند، نشان داد. به طور خلاصه، این بدان معناست که با اضافه شدن CS-2 های اضافی، زمان تمرین به طور متناسب کاهش می یابد.

به طور معمول، شرکت گفت، با اضافه کردن تراشه های بیشتر، افزایش عملکرد کاهش می یابد. از سوی دیگر، تراشه WSE Cerebras ممکن است کارآمدتر شود زیرا 850,000 هسته آن بر روی یک قطعه سیلیکون به یکدیگر متصل شده اند. علاوه بر این، هر هسته یک ماژول حافظه درست در کنار خانه دارد. در مجموع، تراشه زمان صرف شده برای جابجایی داده ها بین هسته ها و حافظه را کاهش می دهد.

«مقیاسگذاری خطی به این معناست که وقتی از یک سیستم به دو سیستم میروید، نیمی از زمان طول میکشد تا کار شما تکمیل شود. فلدمن گفت که این یک ویژگی بسیار غیرعادی در محاسبات است سیم HPC. و او گفت که می تواند فراتر از 16 سیستم متصل شود.

فراتر از آزمایش خود Cerebras، نتایج مقیاسگذاری خطی نیز در حین کار در آزمایشگاه ملی Argonne نشان داده شد، جایی که محققان از Andromeda برای آموزش الگوریتم زبان بزرگ GPT-3-XL بر روی توالیهای طولانی ژنوم Covid-19 استفاده کردند.

البته، اگرچه مقیاس سیستم ممکن است فراتر از 16 CS-2 باشد، هنوز مشخص نیست که مقیاس بندی خطی تا چه حد ادامه دارد. همچنین، ما هنوز نمی دانیم که Cerebras چگونه در برابر سایر تراشه های هوش مصنوعی عمل می کند. سازندگان تراشه های هوش مصنوعی مانند انویدیا و اینتل شروع به کار کرده اند شرکت در معیارهای عادی شخص ثالث توسط افرادی مانند MLperf. Cerebras هنوز شرکت نکرده است.

فضا به یدکی

با این حال، به نظر میرسد که این رویکرد جایگاه خاص خود را در دنیای ابررایانهها ایجاد میکند، و مقیاسپذیری مداوم در هوش مصنوعی زبان بزرگ یک مورد استفاده اصلی است. در واقع، فلدمن گفته شده سیم پارسال این شرکت قبلاً با مهندسان OpenAI که پیشرو در مدلهای زبان بزرگ است صحبت میکرد. (موسس OpenAI، سام آلتمن، همچنین یک سرمایه گذار در Cerebras است.)

در سال 2020، مدل زبان بزرگ OpenAI GPT-3، بازی را هم از نظر عملکرد و هم از نظر اندازه تغییر داد. این مدل با وزن 175 میلیارد پارامتر، بزرگترین مدل هوش مصنوعی در آن زمان بود و محققان را با توانایی های خود شگفت زده کرد. از آن زمان، مدلهای زبان به تریلیونها پارامتر رسیدهاند و ممکن است مدلهای بزرگتری در راه باشند. شایعات وجود دارد- فقط تا اینجا - که OpenAI GPT-4 را در آینده ای نه چندان دور منتشر خواهد کرد و این یک جهش دیگر از GPT-3 خواهد بود. (باید منتظر بمانیم و در این مورد ببینیم.)

گفته میشود، علیرغم قابلیتهایشان، مدلهای زبان بزرگ نه کامل هستند و نه در سطح جهانی مورد تحسین قرار میگیرند. معایب آنها شامل خروجی هایی است که می تواند نادرست، جانبدارانه و توهین آمیز باشد. Galactica متا، آموزش دیده بر روی متون علمی، است یک مثال اخیر. با وجود مجموعه داده ای که ممکن است تصور شود نسبت به آموزش در اینترنت باز کمتر مستعد سمیت است، این مدل به راحتی برای تولید متن مضر و نادرست تحریک شد و تنها در سه روز حذف شد. اینکه آیا محققان میتوانند کاستیهای هوش مصنوعی زبان را حل کنند، نامشخص است یا خیر.

اما به نظر میرسد که افزایش مقیاس تا زمانی که بازدهی کاهشی آغاز شود، ادامه خواهد داشت. جهش بعدی میتواند نزدیک به گوشه باشد—و ممکن است از قبل سختافزاری برای تحقق آن داشته باشیم.

تصویر های اعتباری: مغزها