صنعت خدمات مالی (FinServ) دارای الزامات هوش مصنوعی مولد منحصربهفرد مربوط به دادههای خاص دامنه، امنیت دادهها، کنترلهای نظارتی و استانداردهای انطباق صنعت است. علاوه بر این، مشتریان به دنبال انتخابهایی برای انتخاب کارآمدترین و مقرونبهصرفهترین مدل یادگیری ماشین (ML) و توانایی انجام سفارشیسازی لازم (تنظیم دقیق) هستند تا متناسب با موارد استفاده تجاری خود باشند. Amazon SageMaker JumpStart به طور ایده آل برای موارد استفاده مولد هوش مصنوعی برای مشتریان FinServ مناسب است زیرا کنترل های امنیتی داده های لازم را فراهم می کند و الزامات استانداردهای انطباق را برآورده می کند.

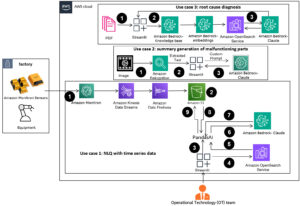

در این پست، ما وظایف پاسخگویی به سوال را با استفاده از یک رویکرد مبتنی بر بازیابی (RAG) با مدلهای زبان بزرگ (LLM) در SageMaker JumpStart با استفاده از یک مورد استفاده از دامنه مالی ساده نشان میدهیم. RAG چارچوبی برای بهبود کیفیت تولید متن با ترکیب یک LLM با یک سیستم بازیابی اطلاعات (IR) است. LLM متن تولید می کند و سیستم IR اطلاعات مربوطه را از پایگاه دانش بازیابی می کند. سپس اطلاعات بازیابی شده برای تقویت ورودی LLM استفاده می شود، که می تواند به بهبود دقت و ارتباط متن تولید شده مدل کمک کند. نشان داده شده است که RAG برای انواع وظایف تولید متن، مانند پاسخ به سؤال و خلاصهسازی، مؤثر است. این یک رویکرد امیدوارکننده برای بهبود کیفیت و دقت مدلهای تولید متن است.

مزایای استفاده از SageMaker JumpStart

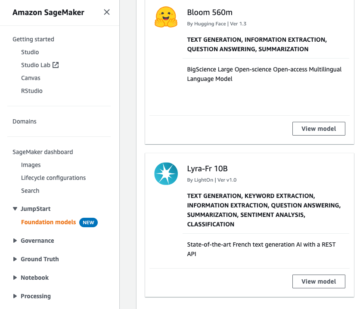

با SageMaker JumpStart، پزشکان ML میتوانند از میان مجموعه گستردهای از مدلهای پیشرفته برای موارد استفاده مانند نوشتن محتوا، تولید تصویر، تولید کد، پاسخگویی به سؤال، کپینویسی، خلاصهسازی، طبقهبندی، بازیابی اطلاعات و موارد دیگر انتخاب کنند. پزشکان ML می توانند مدل های پایه را به صورت اختصاصی به کار گیرند آمازون SageMaker نمونه هایی از یک محیط جدا شده از شبکه و سفارشی کردن مدل ها با استفاده از SageMaker برای آموزش و استقرار مدل.

SageMaker JumpStart برای موارد استفاده مولد هوش مصنوعی برای مشتریان FinServ ایده آل است زیرا موارد زیر را ارائه می دهد:

- قابلیت های سفارشی سازی – SageMaker JumpStart نمونههای نوتبوک و پستهای دقیق را برای راهنمایی گام به گام در مورد تطبیق دامنه مدلهای پایه ارائه میکند. شما می توانید این منابع را برای تنظیم دقیق، تطبیق دامنه، و آموزش مدل های پایه یا ساخت برنامه های کاربردی مبتنی بر RAG دنبال کنید.

- امنیت داده ها - اطمینان از امنیت داده های بار استنتاج بسیار مهم است. با SageMaker JumpStart، میتوانید مدلها را در ایزوله شبکه با ارائه نقطه پایانی تک اجارهای مستقر کنید. علاوه بر این، میتوانید کنترل دسترسی به مدلهای انتخابی را از طریق قابلیت هاب مدل خصوصی مدیریت کنید، که با الزامات امنیتی فردی هماهنگ باشد.

- کنترل های نظارتی و انطباق - مطابقت با استانداردهایی مانند HIPAA BAA، SOC123، PCI، و HITRUST CSF یکی از ویژگی های اصلی SageMaker است که از همسویی با چشم انداز نظارتی دقیق بخش مالی اطمینان می دهد.

- انتخاب های مدل – SageMaker JumpStart مجموعهای از پیشرفتهترین مدلهای ML را ارائه میکند که به طور مداوم در بین معیارهای HELM شناختهشده در صنعت رتبهبندی میشوند. اینها شامل مدلهای Llama 2، Falcon 40B، AI21 J2 Ultra، AI21 Summarize، Hugging Face MiniLM و BGE میشود، اما محدود به آنها نیست.

در این پست، ساختن یک ربات چت متنی برای سازمان های خدمات مالی با استفاده از معماری RAG با مدل پایه Llama 2 و صورت در آغوش گرفته GPTJ-6B-FP16 مدل embeddings، هر دو در SageMaker JumpStart موجود است. ما نیز استفاده می کنیم موتور بردار برای بدون سرور جستجوی باز آمازون (در حال حاضر در پیش نمایش) به عنوان ذخیره داده های برداری برای ذخیره جاسازی ها.

محدودیت های مدل های زبان بزرگ

LLM ها بر روی حجم وسیعی از داده های بدون ساختار آموزش دیده اند و در تولید متن عمومی عالی هستند. از طریق این آموزش، LLM ها دانش واقعی را کسب و ذخیره می کنند. با این حال، LLM های خارج از قفسه محدودیت هایی دارند:

- آموزش آفلاین آنها را از اطلاعات به روز بی خبر می کند.

- آموزش آنها بر روی دادههای عمدتاً تعمیمیافته، کارایی آنها را در وظایف حوزه خاص کاهش میدهد. به عنوان مثال، یک شرکت مالی ممکن است ربات پرسش و پاسخ خود را ترجیح دهد تا پاسخ ها را از آخرین اسناد داخلی خود تهیه کند و از صحت و انطباق با قوانین تجاری خود اطمینان حاصل کند.

- اتکای آنها به اطلاعات جاسازی شده، قابلیت تفسیر را به خطر می اندازد.

برای استفاده از داده های خاص در LLM ها، سه روش رایج وجود دارد:

- تعبیه داده ها در مدل، به آن اجازه می دهد تا از این زمینه در طول تولید خروجی استفاده کند. این می تواند صفر شات (بدون مثال)، چند شات (نمونه های محدود)، یا چند شات (نمونه های فراوان). چنین انگیزه های متنی مدل ها را به سمت نتایج ظریف تر هدایت می کند.

- تنظیم دقیق مدل با استفاده از جفت اعلانها و تکمیلها.

- RAG، که داده های خارجی (غیر پارامتریک) را بازیابی می کند و این داده ها را در دستورات ادغام می کند و زمینه را غنی می کند.

با این حال، روش اول با محدودیت های مدل در اندازه زمینه دست و پنجه نرم می کند، که ورود اسناد طولانی و احتمالاً افزایش هزینه ها را دشوار می کند. رویکرد تنظیم دقیق، در حالی که قدرتمند است، منابع فشرده است، به ویژه با داده های خارجی همیشه در حال تکامل، که منجر به تاخیر در استقرار و افزایش هزینه ها می شود. RAG همراه با LLM ها راه حلی برای محدودیت های ذکر شده قبلی ارائه می دهد.

بازیابی نسل افزوده

RAG داده های خارجی (غیر پارامتریک) را بازیابی می کند و این داده ها را در دستورات ML ادغام می کند و زمینه را غنی می کند. لوئیس و همکاران مدل های RAG را در سال 2020 معرفی کرد و آنها را به عنوان تلفیقی از یک مدل توالی به دنباله از پیش آموزش دیده (حافظه پارامتریک) و یک شاخص برداری متراکم از ویکی پدیا (حافظه ناپارامتریک) که از طریق یک بازیابی عصبی قابل دسترسی است، مفهوم سازی کرد.

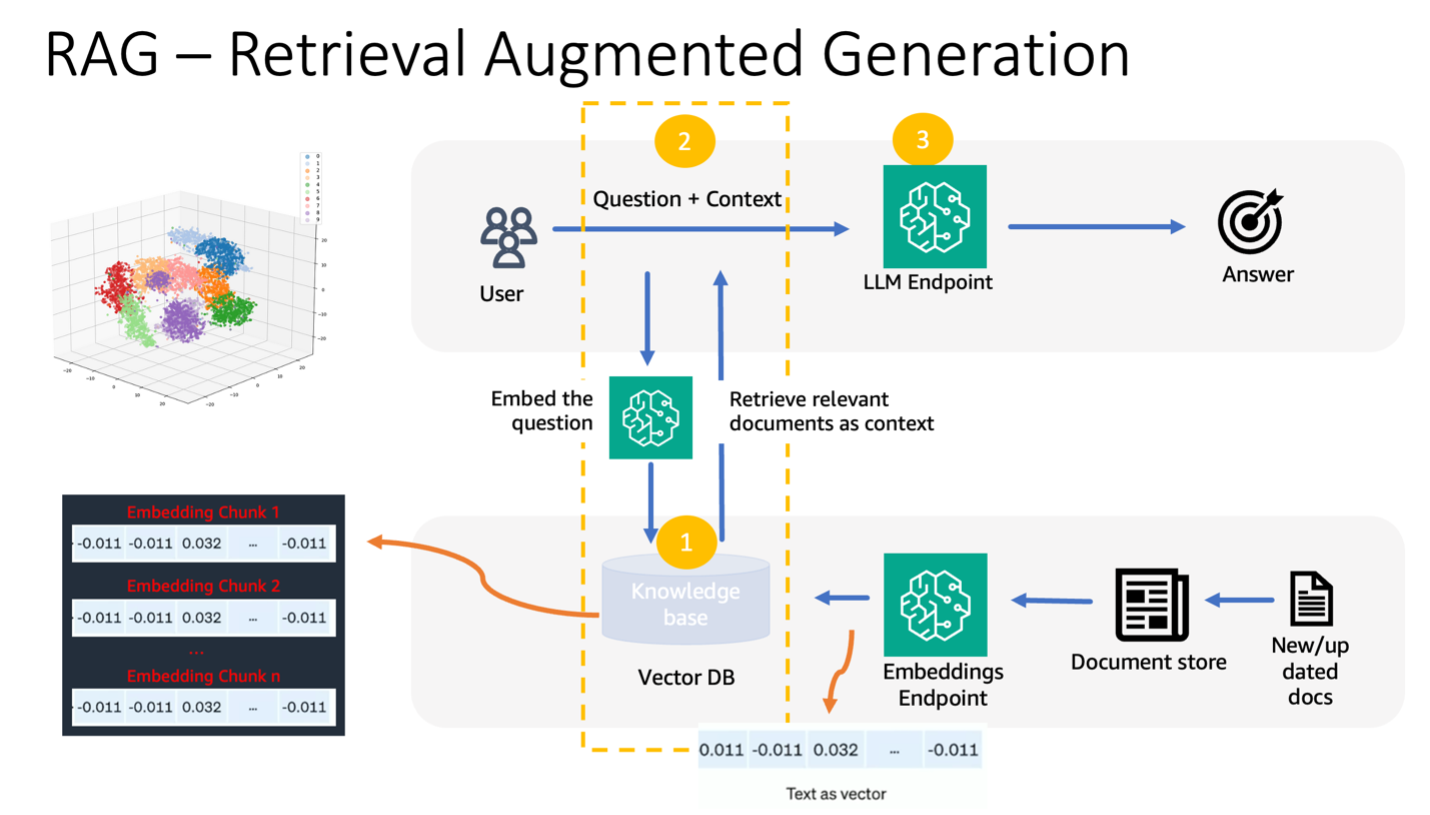

در اینجا نحوه عملکرد RAG آمده است:

- منابع داده - RAG میتواند از منابع دادههای مختلف، از جمله مخازن اسناد، پایگاههای داده یا APIها استخراج کند.

- قالب بندی داده ها - هم درخواست کاربر و هم اسناد به قالبی مناسب برای مقایسه ارتباط تبدیل می شوند.

- درونه گیریها - برای تسهیل این مقایسه، پرس و جو و مجموعه اسناد (یا کتابخانه دانش) با استفاده از مدل های زبانی به جاسازی های عددی تبدیل می شوند. این تعبیهها به صورت عددی مفاهیم متنی را در بر میگیرند.

- جستجوی مرتبط – جاسازی پرس و جو کاربر با جاسازی های مجموعه سند مقایسه می شود و متن مربوطه را از طریق جستجوی شباهت در فضای جاسازی شناسایی می کند.

- غنی سازی زمینه - متن مربوطه شناسایی شده به درخواست اصلی کاربر الحاق می شود و در نتیجه زمینه آن را تقویت می کند.

- پردازش LLM - با زمینه غنی شده، درخواست به LLM داده می شود، که به دلیل گنجاندن داده های خارجی مربوطه، خروجی های مرتبط و دقیق را تولید می کند.

- به روز رسانی ناهمزمان - برای اطمینان از جاری بودن اسناد مرجع، می توان آنها را به صورت ناهمزمان همراه با نمایش های جاسازی شده به روز کرد. این تضمین میکند که پاسخهای مدل آینده مبتنی بر آخرین اطلاعات است و دقت را تضمین میکند.

در اصل، RAG یک روش پویا برای القای اطلاعات مرتبط و همزمان در LLM ارائه میکند و از تولید خروجیهای دقیق و به موقع اطمینان میدهد.

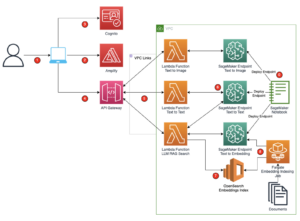

نمودار زیر جریان مفهومی استفاده از RAG با LLM ها را نشان می دهد.

بررسی اجمالی راه حل

مراحل زیر برای ایجاد یک ربات چت پاسخگویی متنی برای یک برنامه خدمات مالی لازم است:

- از مدل جاسازی SageMaker JumpStart GPT-J-6B برای ایجاد جاسازی برای هر سند PDF در سرویس ذخیره سازی ساده آمازون دایرکتوری آپلود (Amazon S3).

- با استفاده از مراحل زیر اسناد مربوطه را شناسایی کنید:

- با استفاده از همان مدل، یک جاسازی برای درخواست کاربر ایجاد کنید.

- از OpenSearch Serverless با ویژگی موتور برداری برای جستجوی K مرتبط ترین نمایه های سند در فضای جاسازی استفاده کنید.

- اسناد مربوطه را با استفاده از نمایه های شناسایی شده بازیابی کنید.

- اسناد بازیابی شده را به عنوان زمینه با درخواست و سوال کاربر ترکیب کنید. این را برای تولید پاسخ به SageMaker LLM ارسال کنید.

ما از LangChain، یک چارچوب محبوب، برای هماهنگ کردن این فرآیند استفاده می کنیم. LangChain به طور خاص برای تقویت برنامه های کاربردی طراحی شده توسط LLM ها طراحی شده است و یک رابط جهانی برای LLM های مختلف ارائه می دهد. این یکپارچه سازی چندین LLM را ساده می کند و از تداوم حالت یکپارچه بین تماس ها اطمینان می دهد. علاوه بر این، کارایی توسعهدهندگان را با ویژگیهایی مانند قالبهای سریع قابل تنظیم، عوامل جامع برنامهسازی، و فهرستهای تخصصی برای جستجو و بازیابی افزایش میدهد. برای درک عمیق، به مستندات LangChain.

پیش نیازها

برای ساخت ربات چت آگاه ما به پیش نیازهای زیر نیاز دارید:

برای دستورالعملهای مربوط به نحوه راهاندازی موتور برداری بدون سرور OpenSearch، به مراجعه کنید معرفی موتور برداری برای Amazon OpenSearch Serverless، اکنون در پیش نمایش.

برای بررسی جامع راه حل زیر، آن را شبیه سازی کنید GitHub repo و رجوع به نوت بوک ژوپیتر.

مدل های ML را با استفاده از SageMaker JumpStart اجرا کنید

برای استقرار مدل های ML، مراحل زیر را انجام دهید:

- Llama 2 LLM را از SageMaker JumpStart اجرا کنید:

- مدل تعبیههای GPT-J را اجرا کنید:

داده ها را تکه تکه کنید و یک شی جاسازی سند ایجاد کنید

در این بخش، داده ها را به اسناد کوچکتر تقسیم می کنید. قطعه قطعه کردن تکنیکی برای تقسیم متون بزرگ به تکه های کوچکتر است. این یک مرحله ضروری است زیرا ارتباط جست و جو را برای مدل RAG ما بهینه می کند، که به نوبه خود کیفیت ربات چت را بهبود می بخشد. اندازه قطعه به عواملی مانند نوع سند و مدل استفاده شده بستگی دارد. یک chunk chunk_size=1600 انتخاب شده است زیرا این اندازه تقریبی یک پاراگراف است. با بهبود مدلها، اندازه پنجره زمینه آنها افزایش مییابد و امکان اندازههای بزرگتر را فراهم میکند.

به دفترچه ژوپیتر در مخزن GitHub برای راه حل کامل.

- LangChain را گسترش دهید

SageMakerEndpointEmbeddingsکلاس برای ایجاد یک تابع embeddings سفارشی که از نقطه پایانی gpt-j-6b-fp16 SageMaker که قبلاً ایجاد کردهاید (به عنوان بخشی از استفاده از مدل embeddings) استفاده میکند: - شی embeddings را ایجاد کنید و به صورت دسته ای ایجاد جاسازی های سند را ایجاد کنید:

- این تعبیهها در موتور برداری با استفاده از LangChain ذخیره میشوند

OpenSearchVectorSearch. این تعبیهها را در بخش بعدی ذخیره میکنید. سند تعبیه شده را در OpenSearch Serverless ذخیره کنید. اکنون میتوانید روی اسناد تکهشده تکرار کنید، جاسازیها را ایجاد کنید و این جاسازیها را در فهرست برداری OpenSearch Serverless ایجاد شده در مجموعههای جستجوی برداری ذخیره کنید. کد زیر را ببینید:

پرسش و پاسخ بر مدارک

تا کنون، شما یک سند بزرگ را به اسناد کوچکتر تقسیم کرده اید، جاسازی های برداری ایجاد کرده اید و آنها را در یک موتور برداری ذخیره کرده اید. اکنون می توانید به سوالات مربوط به داده های این سند پاسخ دهید. از آنجا که شما یک نمایه روی داده ایجاد کرده اید، می توانید یک جستجوی معنایی انجام دهید. به این ترتیب، تنها مرتبط ترین مدارک مورد نیاز برای پاسخ به سوال از طریق اعلان به LLM ارسال می شود. این به شما امکان می دهد فقط با ارسال اسناد مربوطه به LLM در زمان و هزینه خود صرفه جویی کنید. برای جزئیات بیشتر در مورد استفاده از زنجیره های سند، مراجعه کنید اسناد.

برای پاسخ دادن به سوالات با استفاده از مدارک مراحل زیر را کامل کنید:

- برای استفاده از نقطه پایانی SageMaker LLM با LangChain، از آن استفاده می کنید

langchain.llms.sagemaker_endpoint.SagemakerEndpoint، که نقطه پایانی SageMaker LLM را خلاصه می کند. همانطور که در کد زیر برای ادغام LangChain SageMaker نشان داده شده است، یک تبدیل برای بار درخواست و پاسخ انجام می دهید. توجه داشته باشید که ممکن است لازم باشد کد را در ContentHandler بر اساس content_type و قالب مدل LLM که برای استفاده انتخاب میکنید، تنظیم کنید.

اکنون آماده تعامل با سند مالی هستید.

- از پرس و جو و الگوی سریع زیر برای پرسیدن سؤالات در مورد سند استفاده کنید:

پاک کردن

برای جلوگیری از متحمل شدن هزینههای آتی، نقاط پایانی استنتاج SageMaker را که در این دفترچه ایجاد کردهاید حذف کنید. با اجرای موارد زیر در نوت بوک SageMaker Studio خود می توانید این کار را انجام دهید:

اگر یک مجموعه OpenSearch Serverless برای این مثال ایجاد کرده اید و دیگر به آن نیاز ندارید، می توانید آن را از طریق کنسول OpenSearch Serverless حذف کنید.

نتیجه

در این پست، استفاده از RAG را به عنوان رویکردی برای ارائه زمینه خاص دامنه به LLMها مورد بحث قرار دادیم. ما نشان دادیم که چگونه از SageMaker JumpStart برای ساختن یک ربات گفتگوی متنی مبتنی بر RAG برای یک سازمان خدمات مالی با استفاده از Llama 2 و OpenSearch Serverless با موتور برداری به عنوان ذخیره داده های برداری استفاده کنیم. این روش تولید متن را با استفاده از Llama 2 با منبعیابی پویا زمینه مرتبط اصلاح میکند. ما خوشحالیم که میبینیم دادههای سفارشی خود را آورده و با این استراتژی مبتنی بر RAG در SageMaker JumpStart نوآوری میکنید!

درباره نویسندگان

سونیل پادمانابهان یک معمار راه حل های استارتاپی در AWS است. او بهعنوان یک بنیانگذار سابق استارتآپ و مدیر ارشد فناوری، علاقهمند به یادگیری ماشینی است و بر کمک به استارتآپها در استفاده از AI/ML برای نتایج کسبوکارشان و طراحی و استقرار راهحلهای ML/AI در مقیاس تمرکز میکند.

سونیل پادمانابهان یک معمار راه حل های استارتاپی در AWS است. او بهعنوان یک بنیانگذار سابق استارتآپ و مدیر ارشد فناوری، علاقهمند به یادگیری ماشینی است و بر کمک به استارتآپها در استفاده از AI/ML برای نتایج کسبوکارشان و طراحی و استقرار راهحلهای ML/AI در مقیاس تمرکز میکند.

سلیمان پاتل یک معمار ارشد راه حل در خدمات وب آمازون (AWS) با تمرکز ویژه بر یادگیری ماشین و مدرنیزاسیون است. سلمان با استفاده از تخصص خود در کسب و کار و فناوری، به مشتریان کمک می کند تا راه حل هایی را طراحی و بسازند که با مشکلات تجاری دنیای واقعی مقابله کند. زمانی که سلیمان در کار خود غوطه ور نیست، عاشق کاوش در فضای باز، سفرهای جاده ای و پختن غذاهای خوشمزه در آشپزخانه است.

سلیمان پاتل یک معمار ارشد راه حل در خدمات وب آمازون (AWS) با تمرکز ویژه بر یادگیری ماشین و مدرنیزاسیون است. سلمان با استفاده از تخصص خود در کسب و کار و فناوری، به مشتریان کمک می کند تا راه حل هایی را طراحی و بسازند که با مشکلات تجاری دنیای واقعی مقابله کند. زمانی که سلیمان در کار خود غوطه ور نیست، عاشق کاوش در فضای باز، سفرهای جاده ای و پختن غذاهای خوشمزه در آشپزخانه است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/build-a-contextual-chatbot-for-financial-services-using-amazon-sagemaker-jumpstart-llama-2-and-amazon-opensearch-serverless-with-vector-engine/

- : دارد

- :است

- :نه

- $UP

- 1

- 100

- 13

- 2020

- ٪۱۰۰

- 30

- 7

- 8

- 9

- a

- توانایی

- درباره ما

- چکیده ها

- فراوان

- قبول می کند

- دسترسی

- قابل دسترسی است

- دقت

- به دست آوردن

- انطباق

- اضافه

- عاملان

- AI

- موارد استفاده ai

- AI / ML

- AL

- تراز کردن

- هم ترازی

- اجازه دادن

- اجازه می دهد تا

- در امتداد

- همچنین

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- خدمات وب آمازون (AWS)

- در میان

- an

- و

- پاسخ

- پاسخ

- رابط های برنامه کاربردی

- کاربرد

- برنامه های کاربردی

- روش

- تقریبی

- معماری

- هستند

- AS

- پرسیدن

- At

- تقویت کردن

- افزوده شده

- در دسترس

- اجتناب از

- AWS

- پایه

- مستقر

- BE

- زیرا

- بوده

- معیار

- میان

- تقویت کنید

- تقویت می کند

- ربات

- هر دو

- به ارمغان بیاورد

- پهن

- ساختن

- بنا

- کسب و کار

- اما

- by

- تماس ها

- CAN

- قابلیت

- مورد

- موارد

- زنجیر

- زنجیر

- chatbot

- انتخاب

- را انتخاب کنید

- کلاس

- طبقه بندی

- رمز

- مجموعه

- مجموعه

- ترکیب شده

- ترکیب

- مقایسه

- مقایسه

- مقایسه

- کامل

- انطباق

- جامع

- محاسبه

- مفاهیم

- مفهومی

- همواره

- کنسول

- محدودیت ها

- محتوا

- نوشتن مطالب

- زمینه

- متنی

- کنترل

- گروه شاهد

- copywriting است

- هسته

- متناظر

- مقرون به صرفه

- هزینه

- ایجاد

- ایجاد شده

- ایجاد

- CTO

- جاری

- در حال حاضر

- سفارشی

- مشتریان

- سفارشی

- سفارشی سازی

- سفارشی

- داده ها

- امنیت داده ها

- پایگاه های داده

- اختصاصی

- تعریف می کند

- به تاخیر افتاده

- نشان دادن

- بستگی دارد

- گسترش

- گسترش

- اعزام ها

- طرح

- طراحی

- دقیق

- جزئیات

- توسعه دهنده

- DICT

- بحث کردیم

- do

- سند

- اسناد و مدارک

- دامنه

- قرعه کشی

- دو

- در طی

- پویا

- بطور پویا

- E&T

- هر

- پیش از آن

- درامد

- درآمد گزارش

- موثر

- اثر

- بهره وری

- دیگر

- جاسازی کردن

- جاسازی شده

- تعبیه کردن

- استخدام

- پایان

- نقطه پایانی

- موتور

- افزایش

- غنی شده

- غنی سازی

- اطمینان حاصل شود

- تضمین می کند

- حصول اطمینان از

- محیط

- ماهیت

- ضروری است

- مثال

- مثال ها

- اکسل

- برانگیخته

- وجود داشته باشد

- تخصص

- اکتشاف

- بررسی

- گسترش

- خارجی

- چهره

- تسهیل کردن

- عوامل

- بسیار

- ویژگی

- امکانات

- تغذیه

- مالی

- بخش مالی

- خدمات مالی

- خدمات مالی

- FinServ

- شرکت

- نام خانوادگی

- مناسب

- شناور

- جریان

- تمرکز

- تمرکز

- به دنبال

- پیروی

- برای

- قالب

- سابق

- به جلو

- پایه

- موسس

- چارچوب

- از جانب

- تابع

- بعلاوه

- ادغام

- آینده

- سوالات عمومی

- تولید می کنند

- تولید

- نسل

- مولد

- هوش مصنوعی مولد

- GitHub

- کردم

- راهنمایی

- آیا

- he

- کمک

- کمک

- کمک می کند

- خود را

- میزبان

- چگونه

- چگونه

- اما

- HTTP

- HTTPS

- قطب

- i

- ایده آل

- شناسایی

- شناسایی

- if

- تصویر

- غوطه ور شدن

- واردات

- بهبود

- را بهبود می بخشد

- بهبود

- in

- در عمق

- شامل

- از جمله

- گنجاندن

- افزایش

- افزایش

- افزایش

- شاخص

- فهرستها

- فرد

- صنعت

- اطلاعات

- نوآوری

- ورودی

- ورودی

- نمونه

- دستورالعمل

- ادغام

- ادغام

- تعامل

- رابط

- داخلی

- به

- معرفی

- جدا شده

- انزوا

- IT

- ITS

- JPG

- json

- دانش

- چشم انداز

- زبان

- بزرگ

- بزرگتر

- آخرین

- برجسته

- یادگیری

- طول

- قدرت نفوذ

- بهره برداری

- لوئیس

- کتابخانه

- پسندیدن

- محدودیت

- محدود شده

- فهرست

- پشم لاما

- LLM

- ورود به سیستم

- دیگر

- به دنبال

- دوست دارد

- دستگاه

- فراگیری ماشین

- ساخت

- مدیریت

- بسیاری

- ممکن است..

- ملاقات

- حافظه

- ذکر شده

- روش

- روش

- قدرت

- ML

- مدل

- مدل

- پول

- بیش

- علاوه بر این

- اکثر

- چندگانه

- لازم

- نیاز

- شبکه

- عصبی

- بعد

- نه

- هیچ

- دفتر یادداشت

- اکنون

- هدف

- of

- ارائه

- پیشنهادات

- آنلاین نیست.

- on

- ONE

- آنهایی که

- فقط

- عمل می کند

- بهینه سازی می کند

- or

- کدام سازمان ها

- سازمان های

- اصلی

- ما

- نتایج

- خارج از منزل

- تولید

- خروجی

- روی

- جفت

- پارامترهای

- برترین

- بخش

- ویژه

- گذشت

- عبور

- احساساتی

- انجام

- اصرار

- افلاطون

- هوش داده افلاطون

- PlatoData

- محبوب

- احتمالا

- پست

- پست ها

- قوی

- صفحه اصلی

- دقیق

- غالباً

- ترجیح می دهند

- پیش نیازها

- در حال حاضر

- شایع

- پیش نمایش

- قبلا

- خصوصی

- مشکلات

- روند

- تولید می کند

- امید بخش

- ارائه

- فراهم می کند

- تدارک

- پرسش و پاسخ

- کیفیت

- سوال

- سوالات

- رتبه بندی

- اماده

- دنیای واقعی

- زمان واقعی

- مراجعه

- مرجع

- با توجه

- تنظیم کننده

- چشم انداز نظارتی

- مربوط

- ربط

- مربوط

- اعتماد

- ماندن

- ارائه

- گزارش

- درخواست

- نیاز

- ضروری

- مورد نیاز

- منابع فشرده

- منابع

- پاسخ

- پاسخ

- نتایج

- برگشت

- بازده

- دقیق

- جاده

- نقش

- قوانین

- در حال اجرا

- حکیم ساز

- استنباط SageMaker

- همان

- ذخیره

- مقیاس

- بدون درز

- جستجو

- بخش

- بخش

- تیم امنیت لاتاری

- دیدن

- را انتخاب کنید

- انتخاب شد

- انتخاب

- خود

- ارشد

- بدون سرور

- سرویس

- خدمات

- تنظیم

- نشان داد

- نشان داده شده

- نشان می دهد

- ساده

- اندازه

- اندازه

- کوچکتر

- So

- راه حل

- مزایا

- منبع

- منابع

- سپارش

- فضا

- ویژه

- تخصصی

- خاص

- به طور خاص

- مشخص شده

- استانداردهای

- شروع

- نوپا

- دولت

- وضعیت هنر

- گام

- مراحل

- ذخیره سازی

- opbevare

- ذخیره شده

- استراتژی

- ساده سازی

- استودیو

- چنین

- مناسب

- خلاصه کردن

- سیستم

- برخورد با

- مصرف

- وظایف

- تکنیک

- پیشرفته

- قالب

- قالب

- متن

- متن

- که

- La

- شان

- آنها

- سپس

- در نتیجه

- اینها

- آنها

- این

- سه

- از طریق

- زمان

- بموقع

- به

- با هم

- بالا

- سخت

- طرف

- آموزش دیده

- آموزش

- دگرگونی

- مبدل

- درست

- دور زدن

- نوع

- افراطی

- درک

- منحصر به فرد

- جهانی

- در جریان روز

- به روز شده

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- استفاده

- با استفاده از

- استفاده کنید

- متنوع

- تنوع

- مختلف

- وسیع

- از طريق

- جلد

- خرید

- مسیر..

- we

- وب

- خدمات وب

- چی

- چه زمانی

- که

- در حین

- ویکیپدیا

- اراده

- پنجره

- با

- در داخل

- مهاجرت کاری

- نوشته

- سال

- شما

- شما

- زفیرنت