اندازه و پیچیدگی مدلهای زبان بزرگ (LLM) در چند سال اخیر افزایش یافته است. LLM ها قابلیت های قابل توجهی را در یادگیری معناشناسی زبان طبیعی و تولید پاسخ های انسان مانند نشان داده اند. بسیاری از LLM های اخیر با تکنیک قدرتمندی به نام تنظیم شده اند تنظیم دستورالعمل، که به مدل کمک می کند تا وظایف جدید را انجام دهد یا پاسخ هایی به درخواست های جدید بدون تنظیم دقیق اعلان ایجاد کند. یک مدل تنظیمشده با دستورالعمل از درک خود از وظایف یا مفاهیم مرتبط برای ایجاد پیشبینیهایی برای درخواستهای جدید استفاده میکند. از آنجایی که این تکنیک شامل بهروزرسانی وزنهای مدل نمیشود، از فرآیند زمانبر و محاسباتی پرهزینه مورد نیاز برای تنظیم دقیق یک مدل برای یک کار جدید و قبلاً دیده نشده جلوگیری میکند.

در این پست، ما نشان میدهیم که چگونه میتوانید به یک مدل Flan T5 تنظیمشده با دستورالعمل دسترسی داشته باشید و آن را مستقر کنید آمازون SageMaker Jumpstart. ما همچنین نشان میدهیم که چگونه میتوانید درخواستهای مدلهای Flan-T5 را برای انجام وظایف مختلف پردازش زبان طبیعی (NLP) مهندسی کنید. علاوه بر این، این کارها را می توان با یادگیری شات صفر انجام داد، جایی که یک اعلان کاملاً مهندسی شده می تواند مدل را به سمت نتایج دلخواه هدایت کند. به عنوان مثال، ارائه یک سوال چند گزینه ای و درخواست از مدل برای بازگرداندن پاسخ مناسب از گزینه های موجود را در نظر بگیرید. ما دستورات مربوط به وظایف NLP زیر را پوشش می دهیم:

- خلاصه سازی متن

- استدلال عقل سلیم

- جواب سوال

- طبقه بندی احساسات

- ترجمه

- تفکیک ضمیر

- تولید متن بر اساس مقاله

- مقاله خیالی بر اساس عنوان

کد تمامی مراحل این دمو در ادامه مطلب موجود است دفتر یادداشت.

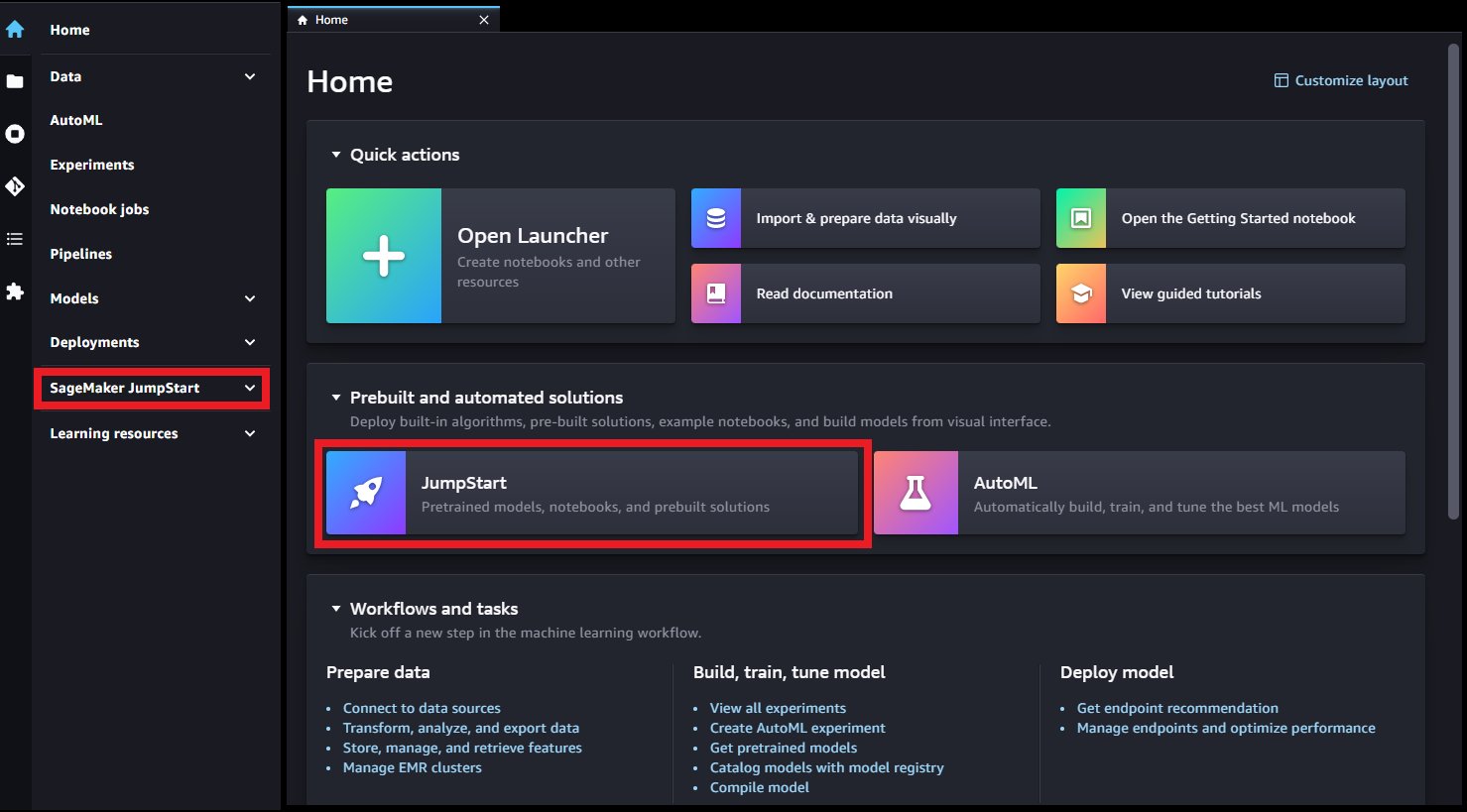

JumpStart مرکز یادگیری ماشین (ML) است آمازون SageMaker که دسترسی با یک کلیک به بیش از 350 الگوریتم داخلی را ارائه می دهد. مدل های از پیش آموزش دیده TensorFlow، PyTorch، Hugging Face و MXNet. و الگوهای راه حل از پیش ساخته شده JumpStart نیز از قبل آموزش داده شده است مدل های پایه مانند هوش مصنوعی پایداری انتشار پایدار مدل متن به تصویر، شکوفه، کوهر تولید, AlexaTM آمازون و بیشتر.

تنظیم دستورالعمل

تنظیم دستورالعمل تکنیکی است که شامل تنظیم دقیق یک مدل زبان در مجموعه ای از وظایف NLP با استفاده از دستورالعمل ها می شود. در این تکنیک، مدل برای انجام وظایف با پیروی از دستورالعمل های متنی به جای مجموعه داده های خاص برای هر کار، آموزش داده می شود. این مدل با مجموعهای از نمونههای ورودی و خروجی برای هر کار بهخوبی تنظیم میشود و به مدل اجازه میدهد تا کارهای جدیدی را تعمیم دهد که به صراحت درباره آنها آموزش ندیدهاند تا زمانی که دستورات برای وظایف ارائه شده است. تنظیم دستورالعمل به بهبود دقت و اثربخشی مدلها کمک میکند و در شرایطی که مجموعه دادههای بزرگ برای کارهای خاص در دسترس نیستند مفید است.

تعداد بیشماری از تحقیقات تنظیم دستورالعمل از سال 2020 انجام شده است و مجموعهای از وظایف، قالبها و روشهای مختلف را تولید میکند. یکی از برجسته ترین روش های تنظیم دستورالعمل، مدل های زبانی دقیق (Flan)، این مجموعههای در دسترس عموم را در یک مجموعه Flan جمعآوری میکند تا مدلهای تنظیمشده را بر اساس دستورالعملهای مختلف تولید کند. به این ترتیب، مدلهای چند وظیفهای Flan با همان مدلهایی که بهطور مستقل روی هر کار خاص تنظیم شدهاند، رقابت میکنند و میتوانند فراتر از دستورالعملهای خاصی که در طول آموزش دیده میشوند، به دستورالعملها به طور کلی تعمیم دهند.

یادگیری شات صفر

یادگیری شات صفر در NLP به یک LLM از قبل آموزش دیده اجازه می دهد تا به وظایفی که به طور خاص برای آنها آموزش ندیده است پاسخ دهد. در این تکنیک، مدل با یک متن ورودی و یک اعلان ارائه می شود که خروجی مورد انتظار از مدل را به زبان طبیعی توصیف می کند. مدلهای از پیش آموزشدیده میتوانند از دانش خود برای ایجاد پاسخهای منسجم و مرتبط حتی برای درخواستهایی که بهطور خاص روی آنها آموزش ندیدهاند، استفاده کنند. یادگیری صفر شات می تواند زمان و داده های مورد نیاز را کاهش دهد و در عین حال کارایی و دقت وظایف NLP را بهبود بخشد. یادگیری صفر شات در انواع وظایف NLP مانند پاسخ به سوال، خلاصه سازی و تولید متن استفاده می شود.

یادگیری چند شات شامل آموزش مدلی برای انجام وظایف جدید با ارائه تنها چند مثال است. این در جایی مفید است که داده های برچسب گذاری شده محدودی برای آموزش در دسترس باشد. اگرچه این پست در درجه اول بر یادگیری صفر شات تمرکز دارد، مدل های ارجاع شده همچنین قادر به ایجاد پاسخ به دستورات یادگیری چند شات هستند.

مدل Flan-T5

یک مدل رمزگذار رمزگشا معروف به نام T5 (ترانسفورماتور انتقال متن به متن) یکی از این مدلها است که متعاقباً از طریق روش Flan تنظیم شد تا Flan-T5 خانواده مدل Flan-T5 یک مدل تنظیم شده با دستورالعمل است و بنابراین قادر به انجام وظایف مختلف NLP صفر شات و همچنین وظایف یادگیری درون متنی چند شات است. با تلقین مناسب، میتواند کارهای NLP بدون شات مانند خلاصهسازی متن، استدلال عقل سلیم، استنتاج زبان طبیعی، پاسخگویی به سؤال، طبقهبندی جملات و احساسات، ترجمه و تفکیک ضمایر را انجام دهد. نمونه های ارائه شده در این پست با خانواده Flan-T5 تولید شده اند.

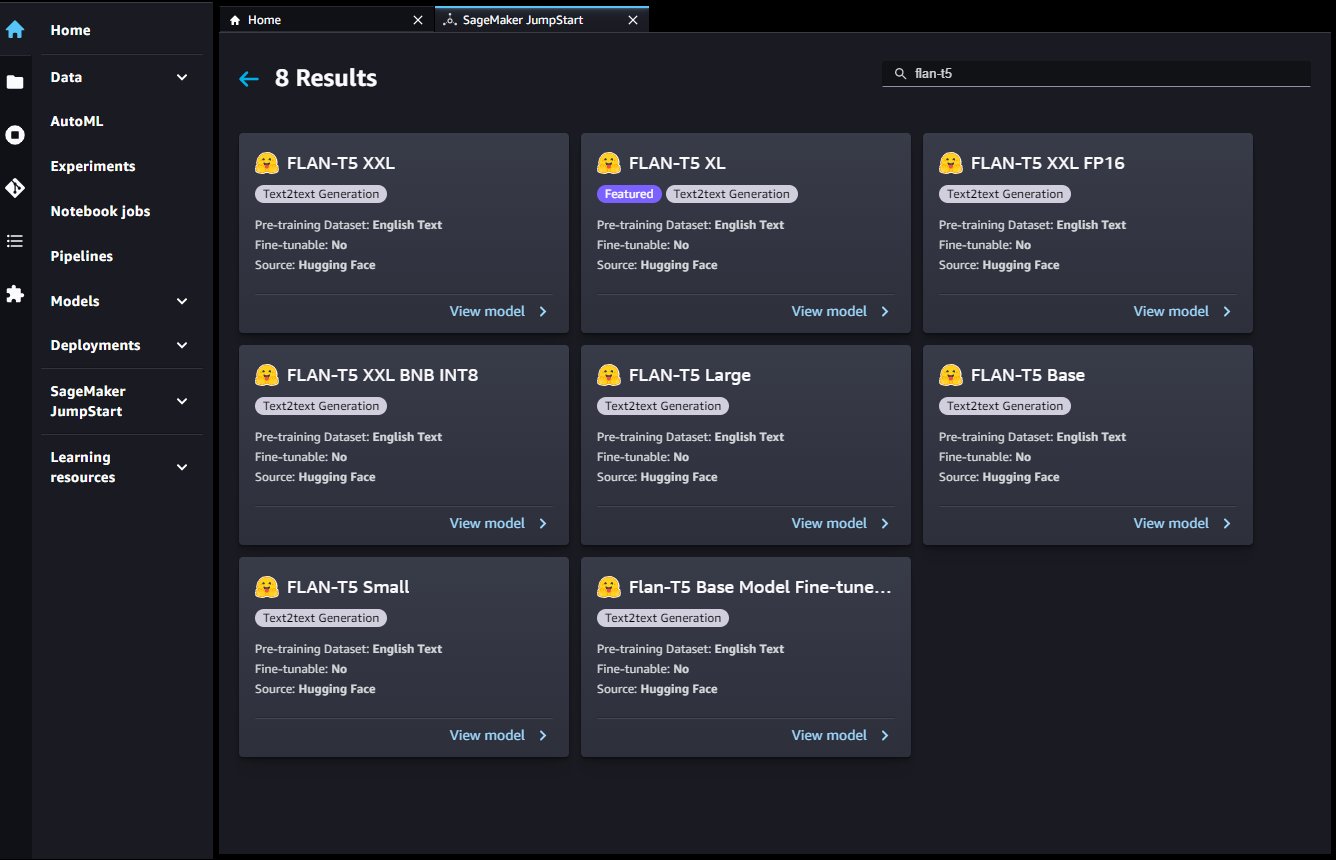

JumpStart استقرار راحت این خانواده مدل را از طریق فراهم می کند Amazon SageMaker Studio و SageMaker SDK. این شامل Flan-T5 Small، Flan-T5 Base، Flan-T5 Large، Flan-T5 XL و Flan-T5 XXL است. علاوه بر این، JumpStart سه نسخه از Flan-T5 XXL را در سطوح مختلف کوانتیزاسیون ارائه میکند:

- Flan-T5 XXL - مدل کامل، بارگذاری شده در فرمت ممیز شناور تک دقیق (FP32).

- Flan-T5 XXL FP16 – یک نسخه با فرمت ممیز شناور نیمه دقیق (FP16) از مدل کامل. این پیاده سازی حافظه GPU کمتری مصرف می کند و استنتاج سریع تری نسبت به نسخه FP32 انجام می دهد.

- Flan-T5 XXL BNB INT8 - یک نسخه کوانتیزه شده 8 بیتی از مدل کامل، که با استفاده از

accelerateوbitsandbytesکتابخانه ها این پیاده سازی دسترسی به این LLM را در نمونه هایی با محاسبات کمتر فراهم می کند، مانند نمونه تک GPU ml.g5.xlarge.

مهندسی سریع برای کارهای NLP صفر شات در مدل های Flan-T5

مهندسی سریع با ایجاد اعلان های با کیفیت بالا برای هدایت مدل به سمت پاسخ های مورد نظر سروکار دارد. درخواست ها باید بر اساس وظیفه و مجموعه داده خاصی که استفاده می شود طراحی شوند. هدف در اینجا ارائه اطلاعات لازم به مدل برای تولید پاسخهای با کیفیت بالا و در عین حال به حداقل رساندن نویز است. این می تواند شامل کلمات کلیدی، زمینه های اضافی، سؤالات و موارد دیگر باشد. برای مثال کد زیر را ببینید:

یک اعلان خوب طراحی شده می تواند مدل را خلاق تر و کلی تر کند تا بتواند به راحتی با وظایف جدید سازگار شود. درخواستها همچنین میتوانند به ترکیب دانش دامنه در مورد وظایف خاص و بهبود تفسیرپذیری کمک کنند. مهندسی سریع می تواند عملکرد مدل های یادگیری صفر و چند شات را تا حد زیادی بهبود بخشد. ایجاد اعلانهای با کیفیت بالا مستلزم بررسی دقیق کار در دست و همچنین درک عمیق نقاط قوت و محدودیتهای مدل است.

در ارائه شده نمونه دفترچه یادداشت، هر کار حداقل هفت الگوی سریع و مجموعه ای جامع از پارامترها را برای کنترل خروجی مدل نشان می دهد، مانند حداکثر طول توالی، تعداد دنباله های برگشتی و تعداد پرتوها. علاوه بر این، الگوهای سریع استفاده شده از این هستند مخزن Flan T5 GitHub، که شامل بسیاری از الگوهای مورد استفاده در مجموعه Flan است. این مجموعه از الگوها برای کشف زمانی که مهندسی سریع خود را انجام می دهید مفید است.

در جدول زیر، مدل Flan-T5 XXL برای تولید پاسخ برای وظایف مختلف NLP صفر شات استفاده شده است. ستون اول وظیفه را نشان می دهد، ستون دوم حاوی دستور ارائه شده به مدل است (که متن الگو پررنگ است و متن غیر پررنگ ورودی نمونه است)، و ستون سوم پاسخی است که از مدل در هنگام پرس و جو در برابر مدل ارائه شده است. سریع.

کار خلاصه سازی را به عنوان مثال در نظر بگیرید: برای ایجاد یک اعلان مدل، می توانید الگو را به هم متصل کنید Briefly summarize this paragraph: با مثال متنی که می خواهید خلاصه کنید. همه وظایف در این جدول از پارامترهای بارگذاری یکسانی استفاده می کنند: max_length=150 برای ارائه حد بالایی در تعداد نشانه های پاسخ، no_repeat_ngram_size=5 برای جلوگیری از تکرار n-gram، و do_sample=False برای غیرفعال کردن نمونه برداری برای تکرارپذیری بعداً هنگام پرس و جو از نقطه پایانی، در مورد گزینه های پارامتر payload موجود بحث می کنیم.

| کار | درخواست (الگوی پررنگ) | خروجی مدل |

| خلاصه سازی | این پاراگراف را به اختصار خلاصه کنید: Amazon Comprehend از پردازش زبان طبیعی (NLP) برای استخراج بینش در مورد محتوای اسناد استفاده می کند. با شناسایی موجودیت ها، عبارات کلیدی، زبان، احساسات و سایر عناصر مشترک در یک سند، بینش ها را توسعه می دهد. از Amazon Comprehend برای ایجاد محصولات جدید بر اساس درک ساختار اسناد استفاده کنید. برای مثال، با استفاده از Amazon Comprehend میتوانید فیدهای شبکههای اجتماعی را برای ذکر محصولات جستجو کنید یا کل مخزن اسناد را برای عبارات کلیدی اسکن کنید. می توانید با استفاده از کنسول آمازون Comprehend یا با استفاده از API های آمازون Comprehend به قابلیت های تجزیه و تحلیل اسناد آمازون دسترسی داشته باشید. میتوانید تحلیل بلادرنگ را برای حجمهای کاری کوچک اجرا کنید یا میتوانید کارهای تحلیل ناهمزمان را برای مجموعههای اسناد بزرگ شروع کنید. می توانید از مدل های از پیش آموزش دیده ای که Amazon Comprehend ارائه می دهد استفاده کنید یا می توانید مدل های سفارشی خود را برای طبقه بندی و شناسایی موجودیت آموزش دهید. همه ویژگی های آمازون Comprehend اسناد متنی UTF-8 را به عنوان ورودی می پذیرند. علاوه بر این، طبقه بندی سفارشی و شناسایی موجودیت سفارشی، فایل های تصویری، فایل های PDF و فایل های Word را به عنوان ورودی می پذیرد. Amazon Comprehend بسته به ویژگی خاص می تواند اسناد را به زبان های مختلف بررسی و تجزیه و تحلیل کند. برای اطلاعات بیشتر، به زبان های پشتیبانی شده در Amazon Comprehend مراجعه کنید. قابلیت زبان غالب آمازون Comprehend می تواند اسناد را بررسی کند و زبان غالب را برای انتخاب بسیار گسترده تری از زبان ها تعیین کند. |

توانایی های آمازون درک را درک کنید |

| استدلال عقل سلیم یا استدلال زبان طبیعی | جام جهانی در شهر لس آنجلس آمریکا آغاز شد.nnبر اساس پاراگراف بالا می توان نتیجه گرفت که ”جام جهانی در آمریکا برگزار می شود."?nn["بله"، "نه"] | بله |

| پاسخ به سوال |

پاسخ بر اساس زمینه:nnجدیدترین و نوآورانهترین کیندل هنوز به شما امکان میدهد از میلیونها کتاب و سند یادداشت برداری کنید، فهرستها و مجلات بنویسید و موارد دیگر. برای خوانندگانی که همیشه آرزو میکردند بتوانند در کتابهای الکترونیکی خود بنویسند، Kindle جدید آمازون این امکان را به آنها میدهد. Kindle Scribe اولین Kindle برای خواندن و نوشتن است و به کاربران اجازه می دهد کتاب ها و اسناد خود را با یادداشت ها، فهرست ها و موارد دیگر تکمیل کنند. در اینجا همه چیزهایی که باید در مورد Kindle Scribe بدانید، از جمله سوالات متداول آمده است. Kindle Scribe خواندن و نوشتن را مانند آنچه روی کاغذ انجام می دهید آسان می کند Kindle Scribe دارای صفحه نمایش 10.2 اینچی بدون تابش نور (بزرگترین دستگاه کیندل)، وضوح واضح 300 ppi و 35 چراغ جلو LED است که به طور خودکار با محیط شما تنظیم می شود. بیشتر تجربه خود را با نور گرم قابل تنظیم، اندازه فونت، فاصله خطوط و موارد دیگر شخصی کنید. با انتخاب شما از قلم پایه یا قلم پریمیوم ارائه می شود که از آن برای نوشتن روی صفحه مانند روی کاغذ استفاده می کنید. آنها همچنین به صورت مغناطیسی به کیندل شما متصل می شوند و هرگز نیازی به شارژ ندارند. قلم پریمیوم شامل یک پاک کن اختصاصی و یک دکمه میانبر قابل تنظیم است. Kindle Scribe بیشترین گزینه های ذخیره سازی را در بین تمام دستگاه های Kindle دارد: از بین 8 گیگابایت، 16 گیگابایت یا 32 گیگابایت، متناسب با سطح خواندن و نوشتن خود انتخاب کنید.nnویژگی های کلیدی کیندل جدید چیست؟ |

صفحه نمایش 10.2 اینچی بدون تابش خیره کننده |

| دسته بندی جمله یا احساس | بررسی: nاین حرکت بسیار عالی است و یک بار دیگر ما را خیره و خوشحال می کندnاین جمله نقد فیلم منفی است یا مثبت؟nگزینه ها: n مثبت n منفی | مثبت |

| ترجمه | اسم من آرتور استnnترجمه به آلمانی | نام من آرتور است |

| تفکیک ضمیر | آلن با گفتن یک جوک خنده دار دوستش شین را به خنده انداخت.nn کیست he با اشاره به?nn(A) آلن n (B) Xin | آلن |

| تولید عنوان بر اساس یک مقاله |

جدیدترین و نوآورانهترین کیندل هنوز به شما امکان میدهد از میلیونها کتاب و سند یادداشت برداری کنید، فهرستها و مجلات بنویسید و موارد دیگر. برای خوانندگانی که همیشه آرزو میکردند بتوانند در کتابهای الکترونیکی خود بنویسند، Kindle جدید آمازون این امکان را به آنها میدهد. Kindle Scribe اولین Kindle برای خواندن و نوشتن است و به کاربران اجازه می دهد کتاب ها و اسناد خود را با یادداشت ها، فهرست ها و موارد دیگر تکمیل کنند. در اینجا همه چیزهایی که باید در مورد Kindle Scribe بدانید، از جمله سوالات متداول آمده است. Kindle Scribe خواندن و نوشتن را مانند آنچه روی کاغذ انجام می دهید آسان می کند Kindle Scribe دارای صفحه نمایش 10.2 اینچی بدون تابش نور (بزرگترین دستگاه کیندل)، وضوح واضح 300 ppi و 35 چراغ جلو LED است که به طور خودکار با محیط شما تنظیم می شود. بیشتر تجربه خود را با نور گرم قابل تنظیم، اندازه فونت، فاصله خطوط و موارد دیگر شخصی کنید. با انتخاب شما از قلم پایه یا قلم پریمیوم ارائه می شود که از آن برای نوشتن روی صفحه مانند روی کاغذ استفاده می کنید. آنها همچنین به صورت مغناطیسی به کیندل شما متصل می شوند و هرگز نیازی به شارژ ندارند. قلم پریمیوم شامل یک پاک کن اختصاصی و یک دکمه میانبر قابل تنظیم است. Kindle Scribe بیشترین گزینه های ذخیره سازی را در بین تمام دستگاه های Kindle دارد: از بین 8 گیگابایت، 16 گیگابایت یا 32 گیگابایت، متناسب با سطح خواندن و نوشتن خود انتخاب کنید. nn عنوان خوبی برای مقاله بالا به من بدهید. |

هر آنچه که باید در مورد کیندل اسکریب جدید بدانید |

| تولید مقاله خیالی بر اساس عنوان | عنوان: "دانشگاه امکانات جدیدی در راه است«\nبا توجه به عنوان بالا یک مقاله خیالی، مقاله را تصور کنید.n | دانشگاه فیلیپین (UP) قرار است ساختمان جدیدی را برای کالج پزشکی و علوم بهداشتی خود (CMHS) در محوطه دانشگاه سانتو توماس (UST) در شهر باکولود بسازد. ساختمان CMHS که در پردیس UST واقع خواهد شد، اولین ساختمانی خواهد بود که توسط دانشگاه در پردیس UST ساخته شده است. به گفته دکتر خوزه ال. آلکالا، معاون اداری و مالی UP، ساختمان CMMS اولین ساختمان در نوع خود در کشور خواهد بود. ساختمان CMMH دومین ساختمانی خواهد بود که توسط UP در UST ساخته شده است. اولین ساختمان که در سال 2008 تکمیل شد، UP است |

به مدلهای تنظیمشده با دستورالعمل Flan-T5 در SageMaker دسترسی پیدا کنید

JumpStart سه راه را برای شروع استفاده از این مدلهای Flan تنظیم شده با دستورالعمل ارائه میکند: مدلهای پایه JumpStart، Studio و SageMaker SDK. بخشهای زیر نشان میدهد که هر یک از این راهها چگونه هستند و نحوه دسترسی به آنها را شرح میدهند.

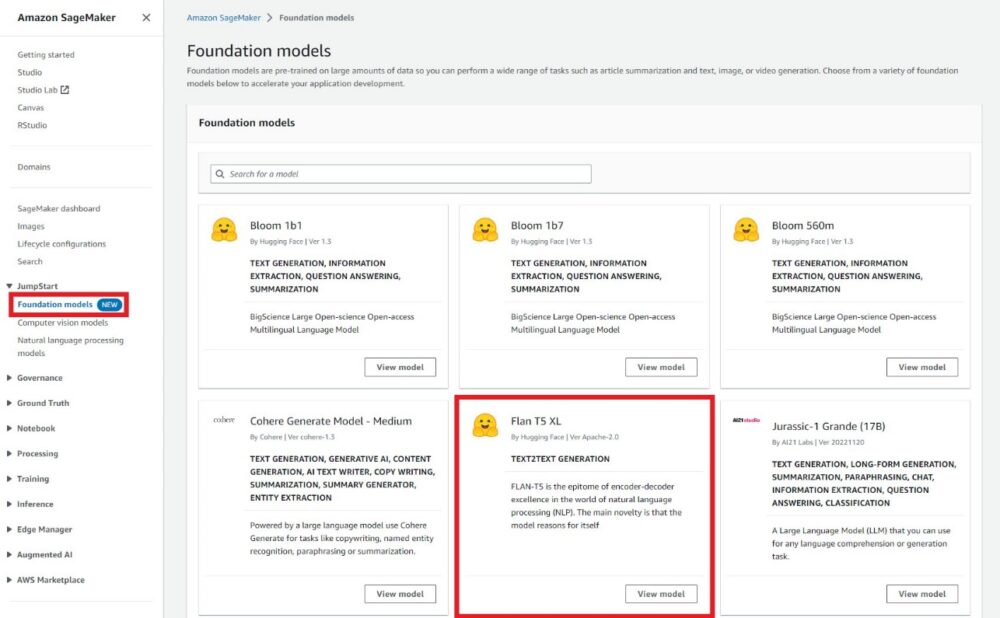

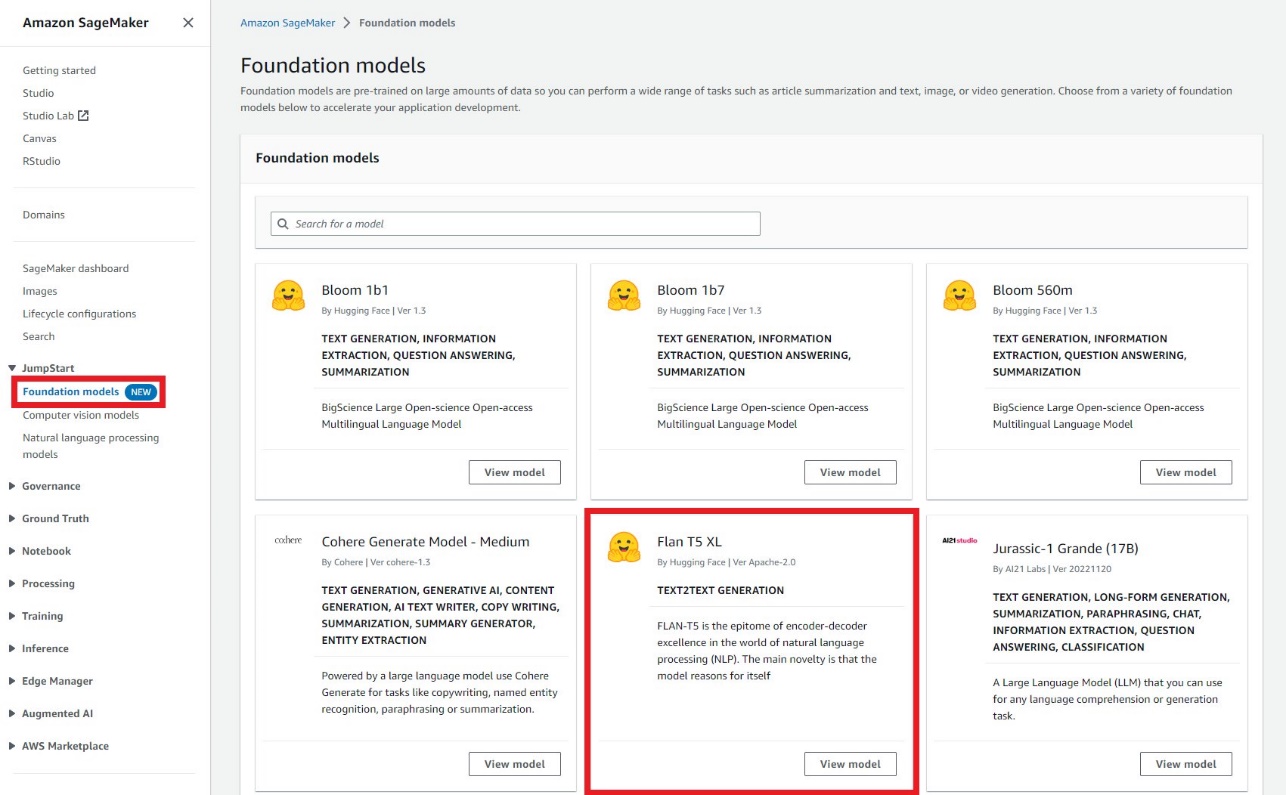

مدل های فونداسیون جامپ استارت

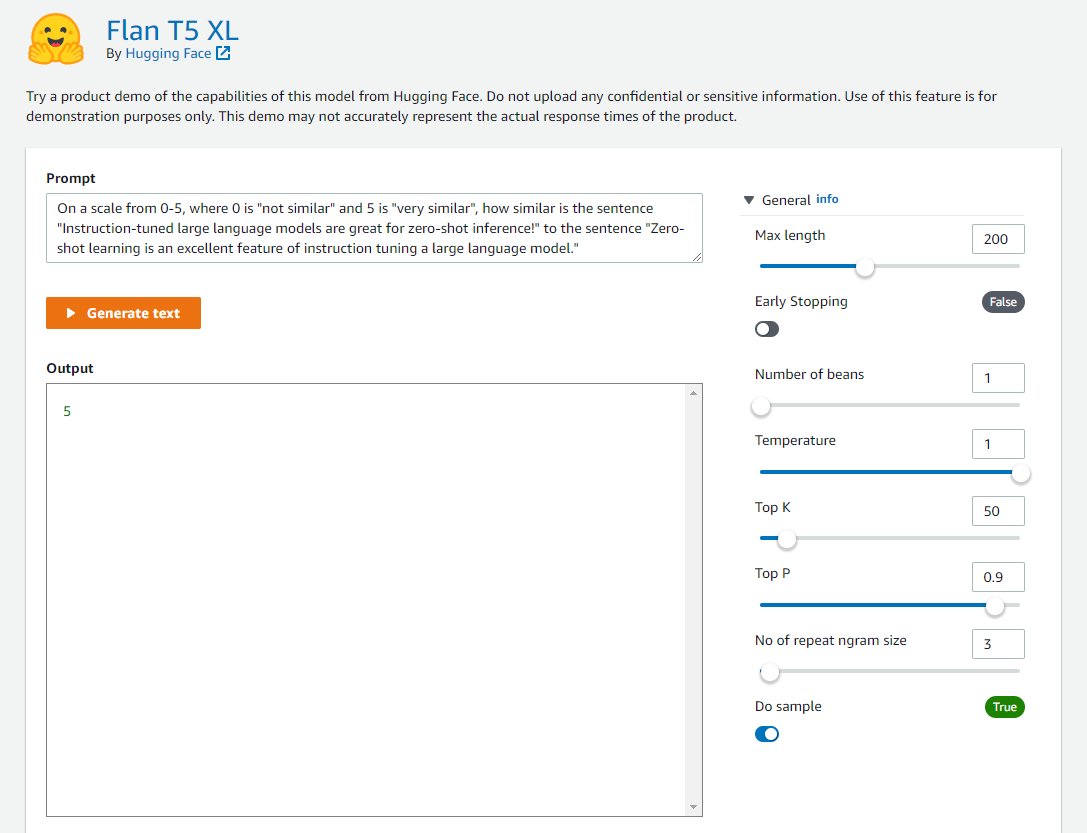

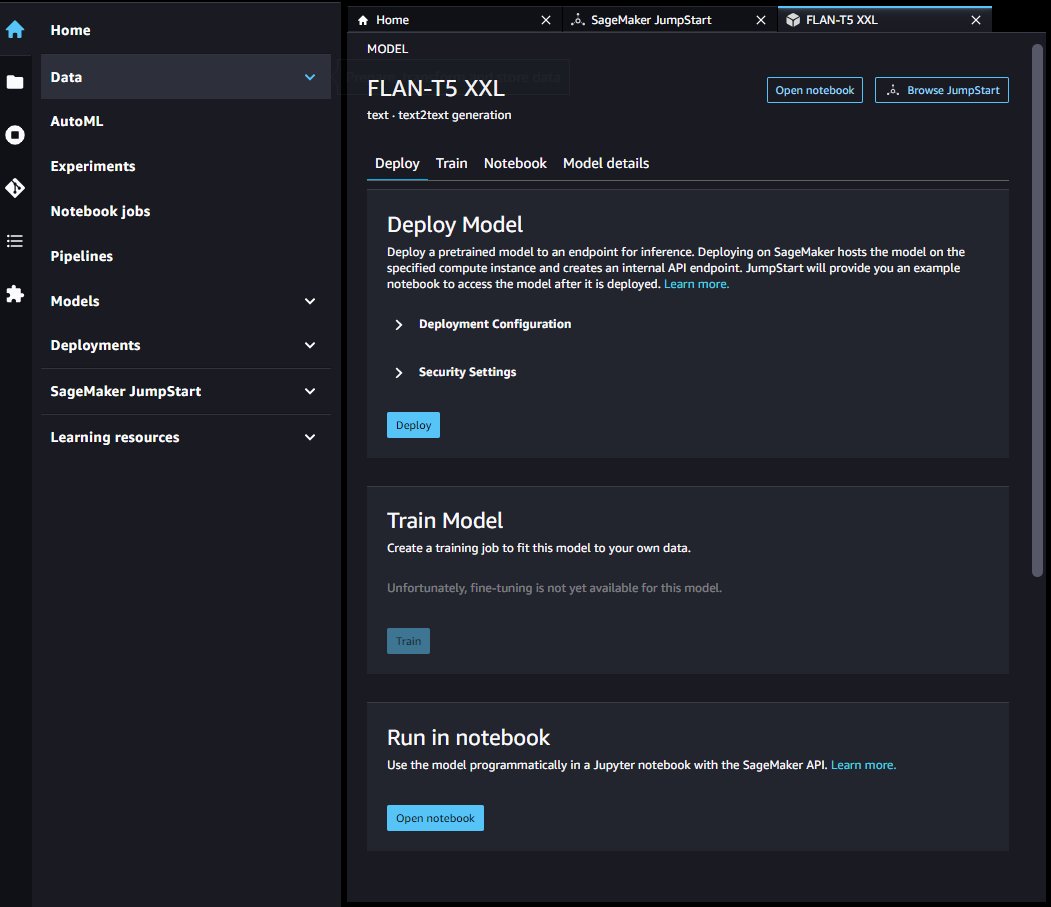

توسعه دهندگان می توانند از رابط بصری استفاده کنند مدل های فونداسیون جامپ استارت، از طریق کنسول SageMaker برای آزمایش مدل های Flan تنظیم شده توسط دستورالعمل بدون نوشتن یک خط کد قابل دسترسی است. این زمین بازی یک جعبه متن اعلان ورودی را همراه با کنترلهایی برای پارامترهای مختلف مورد استفاده در هنگام استنتاج فراهم میکند. این ویژگی در حال حاضر در یک پیشنمایش دروازهدار است و خواهید دید درخواست دسترسی اگر دسترسی ندارید، به جای مدل ها دکمه بزنید. همانطور که در اسکرین شات های زیر مشاهده می کنید، می توانید به مدل های پایه در صفحه ناوبری کنسول SageMaker دسترسی داشته باشید. انتخاب کنید مشاهده مدل روی کارت مدل Flan-T5 XL برای دسترسی به رابط کاربری.

میتوانید از این رابط کاربری انعطافپذیر برای آزمایش نسخهای از مدل استفاده کنید.

SageMaker Studio

همچنین می توانید به این مدل ها از طریق صفحه فرود JumpStart در استودیو این صفحه راهحلهای ML، مدلهای از پیش آموزشدیده، و نمونه نوتبوکهای موجود را فهرست میکند.

میتوانید کارت مدل Flan-T5 را برای استقرار نقطه پایانی مدل از طریق رابط کاربری انتخاب کنید.

پس از اینکه نقطه پایانی شما با موفقیت راه اندازی شد، می توانید یک نمونه نوت بوک Jupyter را راه اندازی کنید که نحوه پرس و جو در آن نقطه پایانی را نشان می دهد.

SageMaker Python SDK

در نهایت، میتوانید به صورت برنامهنویسی یک نقطه پایانی را از طریق SageMaker SDK مستقر کنید. شما باید شناسه مدل مدل مورد نظر خود را در مرکز مدل SageMaker و نوع نمونه مورد استفاده برای استقرار را مشخص کنید. مدل URI که حاوی اسکریپت استنتاج است و URI ظرف Docker از طریق SageMaker SDK به دست می آیند. این URI ها توسط JumpStart ارائه می شوند و می توانند برای مقداردهی اولیه یک شی مدل SageMaker برای استقرار استفاده شوند. کد زیر را ببینید:

اکنون که نقطه پایانی مستقر شده است، می توانید برای تولید متن تولید شده از نقطه پایانی پرس و جو کنید. یک کار خلاصه سازی را به عنوان مثال در نظر بگیرید، جایی که می خواهید خلاصه ای از متن زیر را تولید کنید:

هنگام فراخوانی نقطه پایانی باید این متن را در یک بار JSON ارائه کنید. این محموله JSON میتواند شامل هر پارامتر استنتاج دلخواه باشد که به کنترل طول، استراتژی نمونهبرداری و محدودیتهای توالی نشانه خروجی کمک میکند. در حالی که کتابخانه ترانسفورماتور لیست کاملی از پارامترهای بار قابل دسترس، بسیاری از پارامترهای مهم بار به صورت زیر تعریف می شوند:

- بیشترین طول – مدل تا زمانی که طول خروجی (که شامل طول متن ورودی است) برسد، متن تولید می کند

max_length. اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - num_return_sequences - تعداد دنباله های خروجی برگشتی. اگر مشخص شود، باید یک عدد صحیح مثبت باشد.

- num_beams – تعداد تیرهای مورد استفاده در جستجوی حریصانه. اگر مشخص شود، باید یک عدد صحیح بزرگتر یا مساوی باشد

num_return_sequences. - no_repeat_ngram_size - مدل تضمین می کند که دنباله ای از کلمات

no_repeat_ngram_sizeدر توالی خروجی تکرار نمی شود. اگر مشخص شده باشد، باید یک عدد صحیح مثبت بزرگتر از 1 باشد. - درجه حرارت - تصادفی بودن خروجی را کنترل می کند. دمای بالاتر منجر به توالی خروجی با کلمات کم احتمال و دمای پایین تر منجر به دنباله خروجی با کلمات با احتمال بالا می شود. اگر

temperatureبرابر با 0، منجر به رمزگشایی حریصانه می شود. اگر مشخص شود، باید شناور مثبت باشد. - زود_توقف - اگر

True، تولید متن زمانی به پایان می رسد که همه فرضیه های پرتو به انتهای نشانه استنس برسند. اگر مشخص شده باشد، باید Boolean باشد. - do_sample - اگر

True، کلمه بعدی را بر اساس احتمال نمونه برداری کنید. اگر مشخص شده باشد، باید Boolean باشد. - top_k – در هر مرحله از تولید متن، فقط از آن نمونه بگیرید

top_kبه احتمال زیاد کلمات اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - top_p - در هر مرحله از تولید متن، از کوچکترین مجموعه ممکن کلمات با احتمال تجمعی نمونه برداری کنید

top_p. اگر مشخص شده باشد، باید شناور بین 0-1 باشد. - دانه - حالت تصادفی را برای تکرارپذیری ثابت کنید. اگر مشخص شده باشد، باید یک عدد صحیح باشد.

ما می توانیم هر زیر مجموعه ای از این پارامترها را هنگام فراخوانی یک نقطه پایانی مشخص کنیم. در مرحله بعد، نمونه ای از نحوه فراخوانی یک نقطه پایانی با این آرگومان ها را نشان می دهیم:

این بلوک کد یک نمونه توالی خروجی را ایجاد می کند که شبیه متن زیر است:

پاک کردن

برای جلوگیری از هزینههای مداوم، نقاط پایانی استنتاج SageMaker را حذف کنید. با استفاده از دستورات زیر میتوانید نقاط پایانی را از طریق کنسول SageMaker یا از Notebook استودیو حذف کنید:

نتیجه

در این پست، مروری بر مزایای یادگیری شات صفر ارائه دادیم و توضیح دادیم که چگونه مهندسی سریع میتواند عملکرد مدلهای تنظیمشده دستورالعمل را بهبود بخشد. ما همچنین نشان دادیم که چگونه به راحتی یک مدل Flan T5 تنظیم شده توسط دستورالعمل را از JumpStart استقرار دهیم و مثال هایی ارائه کردیم تا نشان دهیم چگونه می توانید وظایف مختلف NLP را با استفاده از نقطه پایانی مدل Flan T5 مستقر در SageMaker انجام دهید.

ما شما را تشویق میکنیم که یک مدل Flan T5 را از JumpStart پیادهسازی کنید و درخواستهای خود را برای موارد استفاده NLP ایجاد کنید.

برای کسب اطلاعات بیشتر در مورد JumpStart، موارد زیر را بررسی کنید:

درباره نویسندگان

دکتر شین هوانگ یک دانشمند کاربردی برای آمازون SageMaker JumpStart و آمازون SageMaker الگوریتم های داخلی است. او بر روی توسعه الگوریتم های یادگیری ماشینی مقیاس پذیر تمرکز می کند. علایق تحقیقاتی او در زمینه پردازش زبان طبیعی، یادگیری عمیق قابل توضیح بر روی داده های جدولی و تجزیه و تحلیل قوی خوشه بندی ناپارامتریک فضا-زمان است. او مقالات زیادی را در کنفرانسهای ACL، ICDM، KDD و مجله Royal Statistical Society: Series A منتشر کرده است.

دکتر شین هوانگ یک دانشمند کاربردی برای آمازون SageMaker JumpStart و آمازون SageMaker الگوریتم های داخلی است. او بر روی توسعه الگوریتم های یادگیری ماشینی مقیاس پذیر تمرکز می کند. علایق تحقیقاتی او در زمینه پردازش زبان طبیعی، یادگیری عمیق قابل توضیح بر روی داده های جدولی و تجزیه و تحلیل قوی خوشه بندی ناپارامتریک فضا-زمان است. او مقالات زیادی را در کنفرانسهای ACL، ICDM، KDD و مجله Royal Statistical Society: Series A منتشر کرده است.

ویوک گانگاسانی یک معمار ارشد راه حل های یادگیری ماشین در خدمات وب آمازون است. او با استارتآپهای یادگیری ماشینی برای ساخت و استقرار برنامههای AI/ML در AWS کار میکند. او در حال حاضر بر ارائه راهحلهایی برای MLOps، ML Inference و ML با کد پایین متمرکز است. او روی پروژه هایی در حوزه های مختلف از جمله پردازش زبان طبیعی و بینایی کامپیوتری کار کرده است.

ویوک گانگاسانی یک معمار ارشد راه حل های یادگیری ماشین در خدمات وب آمازون است. او با استارتآپهای یادگیری ماشینی برای ساخت و استقرار برنامههای AI/ML در AWS کار میکند. او در حال حاضر بر ارائه راهحلهایی برای MLOps، ML Inference و ML با کد پایین متمرکز است. او روی پروژه هایی در حوزه های مختلف از جمله پردازش زبان طبیعی و بینایی کامپیوتری کار کرده است.

دکتر کایل اولریش دانشمند کاربردی با الگوریتم های داخلی آمازون SageMaker تیم علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر کایل اولریش دانشمند کاربردی با الگوریتم های داخلی آمازون SageMaker تیم علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- پلاتوبلاک چین. Web3 Metaverse Intelligence. دانش تقویت شده دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/zero-shot-prompting-for-the-flan-t5-foundation-model-in-amazon-sagemaker-jumpstart/

- :است

- $UP

- 1

- 10

- 100

- 2020

- 7

- 8

- a

- درباره ما

- بالاتر

- پذیرفتن

- دسترسی

- قابل دسترسی است

- دسترسی

- مطابق

- دقت

- وفق دادن

- اضافه

- اضافی

- تنظیم پذیر

- حکومت

- در برابر

- مصالح

- AI / ML

- الگوریتم

- معرفی

- اجازه دادن

- اجازه می دهد تا

- هر چند

- همیشه

- AMA

- آمازون

- درک آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- تحلیل

- تحلیل

- و

- آنجلس

- پاسخ

- API

- رابط های برنامه کاربردی

- برنامه های کاربردی

- اعمال می شود

- مناسب

- هستند

- محدوده

- استدلال

- مقاله

- AS

- At

- ضمیمه کردن

- بطور خودکار

- در دسترس

- AWS

- پایه

- مستقر

- اساسی

- بیزی

- BE

- پرتو

- زیرا

- بودن

- مزایای

- میان

- خارج از

- مسدود کردن

- bnb

- بدن

- جسور

- کتاب

- ساختن

- بنا

- ساخته شده در

- دکمه

- by

- نام

- دانشگاه

- CAN

- قابلیت های

- توانا

- کارت

- دقیق

- موارد

- CAT

- متهم

- بار

- بررسی

- انتخاب

- انتخاب

- را انتخاب کنید

- شهر:

- طبقه بندی

- مشتری

- خوشه بندی

- رمز

- منسجم

- مجموعه

- مجموعه

- کالج

- ستون

- آینده

- مشترک

- رقابتی

- تکمیل شده

- پیچیدگی

- درک

- جامع

- محاسبه

- کامپیوتر

- چشم انداز کامپیوتر

- مفاهیم

- نتیجه گیری

- همایش ها

- در نظر بگیرید

- توجه

- کنسول

- ساختن

- ظرف

- شامل

- محتوا

- زمینه

- زمینه ها

- کنترل

- گروه شاهد

- مناسب

- میتوانست

- کشور

- پوشش

- ایجاد

- ایجاد

- خالق

- فنجان

- در حال حاضر

- سفارشی

- سفارشی

- داده ها

- مجموعه داده ها

- معاملات

- رمز گشایی

- اختصاصی

- عمیق

- یادگیری عمیق

- مشخص

- تعریف می کند

- تحویل

- نشان دادن

- نشان

- نشان می دهد

- بستگی دارد

- گسترش

- مستقر

- گسترش

- توصیف

- شرح داده شده

- طراحی

- مطلوب

- جزئیات

- مشخص کردن

- در حال توسعه

- توسعه

- دستگاه ها

- مختلف

- بحث و تبادل نظر

- کارگر بارانداز

- سند

- اسناد و مدارک

- نمی کند

- دامنه

- حوزه

- غالب

- آیا

- دوک

- دانشگاه دوک

- در طی

- هر

- به آسانی

- کتاب های الکترونیکی

- اثر

- بهره وری

- عناصر

- تشویق

- پشت سر هم

- نقطه پایانی

- مهندس

- مهندسی

- انگلیسی

- تضمین می کند

- تمام

- اشخاص

- موجودیت

- محیط

- برابر

- حتی

- همه چیز

- مثال

- مثال ها

- انتظار می رود

- گران

- تجربه

- اکتشاف

- عصاره

- چهره

- امکان

- خانواده

- سریعتر

- ویژگی

- امکانات

- کمی از

- فایل ها

- سرمایه گذاری

- پیدا کردن

- نام خانوادگی

- رفع

- قابل انعطاف

- شناور

- متمرکز شده است

- تمرکز

- پیروی

- به دنبال آن است

- برای

- قالب

- پایه

- غالبا

- دوست

- از جانب

- جلو

- کامل

- خنده دار

- بیشتر

- بعلاوه

- دردار

- سوالات عمومی

- تولید می کنند

- تولید

- تولید می کند

- مولد

- نسل

- دریافت کنید

- GitHub

- هدف

- خوب

- GPU

- بزرگ

- بیشتر

- تا حد زیادی

- حریص

- راهنمایی

- دست

- آیا

- سلامتی

- کمک

- مفید

- کمک می کند

- اینجا کلیک نمایید

- با کیفیت بالا

- بالاتر

- چگونه

- چگونه

- HTML

- HTTPS

- قطب

- ID

- تصویر

- خیالی

- پیاده سازی

- واردات

- مهم

- بهبود

- بهبود

- in

- شامل

- شامل

- از جمله

- ترکیب کردن

- به طور مستقل

- اطلاعات

- ابتکاری

- ورودی

- بینش

- نمونه

- در عوض

- دستورالعمل

- منافع

- رابط

- شامل

- IT

- ITS

- شغل ها

- روزنامه

- JPG

- json

- کلید

- نوع

- دانستن

- دانش

- شناخته شده

- فرود

- زبان

- زبان ها

- بزرگ

- بزرگترین

- نام

- راه اندازی

- راه اندازی

- یاد گرفتن

- یادگیری

- رهبری

- طول

- اجازه می دهد تا

- سطح

- سطح

- کتابخانه ها

- کتابخانه

- سبک

- پسندیدن

- احتمالا

- محدود

- محدودیت

- محدود شده

- لاین

- فهرست

- لیست

- LLM

- واقع شده

- طولانی

- نگاه کنيد

- شبیه

- آنها

- لس آنجلس

- دستگاه

- فراگیری ماشین

- ساخته

- ساخت

- باعث می شود

- بسیاری

- بیشترین

- پزشکی

- حافظه

- اشاره می کند

- روش

- روش

- میلیون ها نفر

- به حداقل رساندن

- ML

- MLO ها

- مدل

- مدل

- بیش

- اکثر

- سینما

- نام

- طبیعی

- پردازش زبان طبیعی

- جهت یابی

- لازم

- نیاز

- منفی

- شبکه

- جدید

- محصولات جدید

- تازه ترین

- بعد

- nlp

- سر و صدا

- دفتر یادداشت

- یادداشت

- رمان

- عدد

- هدف

- به دست آمده

- of

- پیشنهادات

- پیشنهادات

- on

- ONE

- مداوم

- گزینه

- دیگر

- تولید

- مروری

- خود

- با ما

- قطعه

- مقاله

- اوراق

- پارامتر

- پارامترهای

- انجام

- کارایی

- انجام

- انجام می دهد

- شخصی کردن

- فیلیپین

- عبارات

- پیتزا

- محل

- افلاطون

- هوش داده افلاطون

- PlatoData

- محبوب

- مثبت

- ممکن

- پست

- قوی

- PPI

- پیش بینی

- پیشگو

- حق بیمه

- رئيس جمهور

- پیش نمایش

- قبلا

- در درجه اول

- روند

- فرآیندهای

- در حال پردازش

- تولید کردن

- محصولات

- پروژه ها

- برجسته

- ارائه

- ارائه

- فراهم می کند

- ارائه

- عمومی

- منتشر شده

- پــایتــون

- مارماهی

- سوال

- سوالات

- تصادفی

- تصادفی بودن

- رسیدن به

- می رسد

- خواندن

- خوانندگان

- مطالعه

- زمان واقعی

- اخیر

- به رسمیت شناختن

- كاهش دادن

- مربوط

- مربوط

- قابل توجه

- مکرر

- مخزن

- ضروری

- نیاز

- تحقیق

- شباهت دارد

- وضوح

- پاسخ

- محدودیت های

- نتیجه

- نتایج

- برگشت

- این فایل نقد می نویسید:

- تنومند

- سلطنتی

- دویدن

- s

- حکیم ساز

- استنباط SageMaker

- همان

- مقیاس پذیر

- اسکن

- علوم

- دانشمند

- پرده

- تصاویر

- sdk

- جستجو

- دوم

- بخش

- انتخاب

- معنایی

- ارشد

- حس

- جمله

- احساس

- دنباله

- سلسله

- سری A

- سرویس

- خدمات

- جلسه

- تنظیم

- مجموعه

- هفت

- کوتاه

- باید

- نشان

- نشان می دهد

- پس از

- تنها

- شرایط

- اندازه

- اندازه

- کوچک

- So

- آگاهی

- شبکه اجتماعی

- جامعه

- راه حل

- مزایا

- اسپانیایی

- خاص

- به طور خاص

- مشخص شده

- ثبات

- شروع

- آغاز شده

- نوپا

- دولت

- ایالات

- آماری

- گام

- مراحل

- ذخیره سازی

- گزینه های ذخیره سازی

- استراتژی

- نقاط قوت

- ساختار

- استودیو

- متعاقبا

- موفقیت

- چنین

- کت و شلوار

- خلاصه کردن

- خلاصه

- عرضه

- پشتیبانی

- جدول

- گرفتن

- طول می کشد

- کار

- وظایف

- تیم

- قالب

- قالب

- جریان تنسور

- آزمون

- که

- La

- محوطه

- اطلاعات

- فیلیپین

- شان

- آنها

- از این رو

- اینها

- سوم

- سه

- از طریق

- زمان

- سری زمانی

- زمان بر

- عنوان

- به

- رمز

- نشانه

- طرف

- قطار

- آموزش دیده

- آموزش

- انتقال

- ترانسفورماتور

- ترجمه کردن

- ترجمه

- درست

- درک

- متحد

- ایالات متحده

- دانشگاه

- به روز رسانی

- استفاده کنید

- کاربر

- رابط کاربری

- کاربران

- UST

- تنوع

- مختلف

- نسخه

- از طريق

- معاون رئیس جمهور

- دید

- گرم

- مسیر..

- وب

- خدمات وب

- خوب

- چی

- که

- در حین

- WHO

- وسیع

- گسترده تر

- اراده

- با

- در داخل

- بدون

- کلمه

- کلمات

- مشغول به کار

- با این نسخهها کار

- جهان

- جام جهانی

- خواهد بود

- نوشتن

- نوشته

- سال

- شما

- شما

- زفیرنت

- آموزش صفر شات