همانطور که سازمانهای بیشتری از فناوریهای هوش مصنوعی مولد استفاده میکنند - برای ایجاد طرحها، تکمیل درخواستهای کمک مالی و نوشتن کد دیگ بخار - تیمهای امنیتی نیاز به پرداختن به یک سوال جدید را درک میکنند: چگونه ابزارهای هوش مصنوعی را ایمن میکنید؟

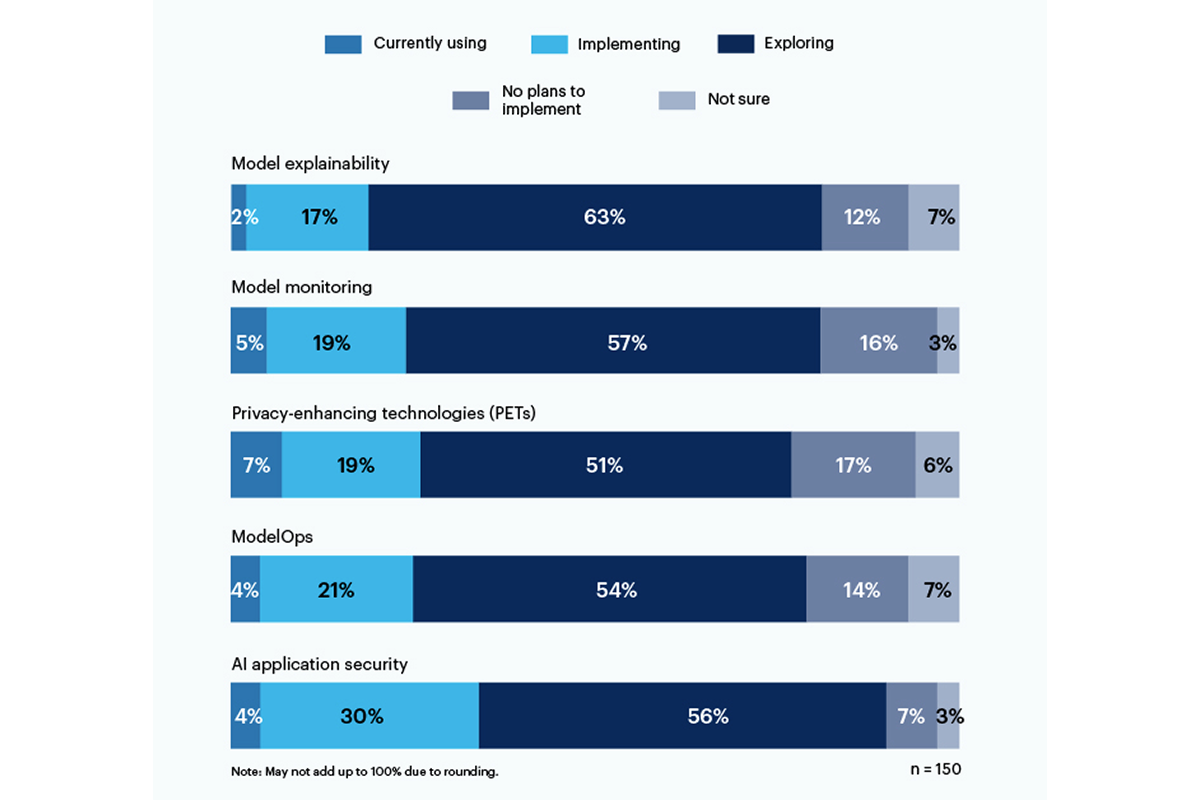

یک سوم از پاسخ دهندگان در یک نظرسنجی اخیر از گارتنر گزارش دادند استفاده یا پیاده سازی ابزارهای امنیتی برنامه مبتنی بر هوش مصنوعی برای رسیدگی به خطرات ناشی از استفاده از هوش مصنوعی مولد در سازمان خود.

فناوریهای تقویتکننده حریم خصوصی (PET) با 7 درصد پاسخدهندگان، با 19 درصد از شرکتها که آن را پیادهسازی میکنند، بیشترین استفاده کنونی را نشان دادند. این دسته شامل راه هایی برای محافظت از داده های شخصی، مانند رمزنگاری هامومورفیک, داده های مصنوعی تولید شده توسط هوش مصنوعی, محاسبات چند جانبه امن, یادگیری فدراسیونو حریم خصوصی دیفرانسیل. با این حال، 17 درصد از آنها هیچ برنامه ای برای به کار انداختن PET ها در محیط خود ندارند.

تنها 19 درصد از ابزارهایی برای توضیح مدل استفاده می کنند یا پیاده می کنند، اما علاقه قابل توجهی (56 درصد) در میان پاسخ دهندگان به کاوش و درک این ابزارها برای پرداختن به ریسک هوش مصنوعی مولد وجود دارد. به گفته گارتنر، قابلیت توضیح، نظارت بر مدل، و ابزارهای امنیتی برنامه هوش مصنوعی همگی می توانند در مدل های منبع باز یا اختصاصی برای دستیابی به قابلیت اطمینان و قابلیت اطمینان مورد نیاز کاربران سازمانی مورد استفاده قرار گیرند.

خطراتی که پاسخ دهندگان بیشتر نگران آن هستند شامل خروجی های نادرست یا مغرضانه (58٪) و آسیب پذیری ها یا اسرار افشا شده در کدهای تولید شده توسط هوش مصنوعی (57٪) است. به طور قابل توجهی، 43٪ موارد بالقوه حق نسخه برداری یا مجوز را ناشی از محتوای تولید شده توسط هوش مصنوعی به عنوان خطرات اصلی برای سازمان خود ذکر کردند.

یکی از مدیران C-suite در پاسخ به نظرسنجی گارتنر نوشت: «هنوز هیچ شفافیتی در مورد مدلهای دادهای که در حال آموزش هستند وجود ندارد، بنابراین درک و برآورد خطر مرتبط با سوگیری و حریم خصوصی بسیار دشوار است.

در ماه ژوئن، موسسه ملی استاندارد و فناوری (NIST) یک گروه کاری عمومی راه اندازی کرد برای کمک به حل این سوال، بر اساس چارچوب مدیریت ریسک هوش مصنوعی از ژانویه. همانطور که داده های گارتنر نشان می دهد، شرکت ها منتظر نیستند برای دستورالعمل های NIST

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :است

- :نه

- 7

- a

- درباره ما

- مطابق

- رسیدن

- نشانی

- اتخاذ

- AI

- معرفی

- در میان

- و

- کاربرد

- امنیت نرم افزار

- برنامه های کاربردی

- هستند

- AS

- مرتبط است

- At

- مستقر

- BE

- تعصب

- جانبدارانه

- اما

- by

- C- مجموعه

- CAN

- دسته بندی

- اشاره

- رمز

- شرکت

- کامل

- علاقمند

- محتوا

- حق چاپ

- سادگی

- جاری

- داده ها

- مشکل

- دستورات

- do

- هر دو

- سرمایه گذاری

- محیط

- تخمین زدن

- اجرایی

- بررسی

- برای

- چارچوب

- از جانب

- گارتنر

- مولد

- هوش مصنوعی مولد

- اعطا کردن

- بزرگترین

- آیا

- کمک

- چگونه

- اما

- HTTPS

- اجرای

- in

- شامل

- شامل

- موسسه

- علاقه

- مسائل

- IT

- ITS

- ژانویه

- ژوئن

- راه اندازی

- صدور مجوز

- مدیریت

- روش

- مدل

- مدل

- نظارت بر

- بیش

- اکثر

- چندگانه

- ملی

- نیاز

- جدید

- نیست

- نه

- of

- on

- باز کن

- منبع باز

- or

- کدام سازمان ها

- سازمان های

- شخصی

- اطلاعات شخصی

- حیوانات خانگی

- زمین

- برنامه

- افلاطون

- هوش داده افلاطون

- PlatoData

- مطرح

- پتانسیل

- خلوت

- اختصاصی

- محافظت از

- عمومی

- سوال

- تحقق

- اخیر

- قابلیت اطمینان

- تکیه

- گزارش

- پاسخ دهندگان

- پاسخ

- خطر

- مدیریت ریسک

- خطرات

- اسرار

- امن

- تیم امنیت لاتاری

- نشان داد

- نشان می دهد

- قابل توجه

- به طور قابل توجهی

- So

- جامد

- منبع

- استانداردهای

- هنوز

- چنین

- بررسی

- ترکیبی

- تیم ها

- فن آوری

- پیشرفته

- که

- La

- شان

- آنجا.

- اینها

- این

- به

- ابزار

- بالا

- آموزش

- شفافیت

- امانت

- فهمیدن

- درک

- استفاده کنید

- استفاده

- کاربران

- با استفاده از

- بسیار

- آسیب پذیری ها

- راه

- با

- کارگر

- نوشتن

- نوشت

- شما

- زفیرنت