امروز ما با هیجان اعلام می کنیم که گارد لاما این مدل اکنون برای مشتریانی که استفاده می کنند در دسترس است Amazon SageMaker JumpStart. Llama Guard حفاظت ورودی و خروجی را در استقرار مدل زبان بزرگ (LLM) فراهم می کند. این یکی از اجزای تحت عنوان Purple Llama، ابتکار متا است که دارای ابزارهای اعتماد باز و ایمنی و ارزیابی برای کمک به توسعه دهندگان برای ساخت مسئولانه با مدل های هوش مصنوعی است. Purple Llama ابزارها و ارزیابیهایی را برای کمک به جامعه در ساخت مسئولانه با مدلهای هوش مصنوعی مولد گرد هم میآورد. نسخه اولیه شامل تمرکز بر امنیت سایبری و حفاظت ورودی و خروجی LLM است. اجزای پروژه Purple Llama، از جمله مدل Llama Guard، مجوز مجاز دارند و امکان استفاده تحقیقاتی و تجاری را فراهم میکنند.

اکنون می توانید از مدل Llama Guard در SageMaker JumpStart استفاده کنید. SageMaker JumpStart مرکز یادگیری ماشینی (ML) است آمازون SageMaker که علاوه بر الگوریتم های داخلی و الگوهای راه حل انتها به انتها دسترسی به مدل های پایه را فراهم می کند تا به شما کمک کند تا به سرعت با ML شروع کنید.

در این پست، نحوه استقرار مدل Llama Guard و ساخت راهحلهای هوش مصنوعی مولد مسئول را بررسی میکنیم.

مدل لاما گارد

Llama Guard مدل جدیدی از متا است که نرده های ورودی و خروجی را برای استقرار LLM فراهم می کند. Llama Guard یک مدل آزادانه در دسترس است که به صورت رقابتی بر روی معیارهای باز رایج عمل می کند و یک مدل از پیش آموزش دیده را در اختیار توسعه دهندگان قرار می دهد تا به دفاع در برابر تولید خروجی های بالقوه خطرناک کمک کند. این مدل بر روی ترکیبی از مجموعه دادههای در دسترس عموم آموزش داده شده است تا امکان شناسایی انواع رایج محتوای بالقوه مخاطرهآمیز یا نقضکننده را که ممکن است به تعدادی از موارد استفاده توسعهدهنده مرتبط باشد، میدهد. در نهایت، چشم انداز مدل این است که توسعه دهندگان را قادر می سازد تا این مدل را برای پشتیبانی از موارد استفاده مرتبط سفارشی کنند و اتخاذ بهترین شیوه ها و بهبود اکوسیستم باز را بدون دردسر کنند.

Llama Guard می تواند به عنوان یک ابزار تکمیلی برای توسعه دهندگان برای ادغام در استراتژی های کاهش خود، مانند ربات های گفتگو، تعدیل محتوا، خدمات مشتری، نظارت بر رسانه های اجتماعی و آموزش استفاده شود. با انتقال محتوای تولید شده توسط کاربر از لاما گارد قبل از انتشار یا پاسخ به آن، توسعهدهندگان میتوانند زبان ناامن یا نامناسب را علامتگذاری کنند و برای حفظ محیطی امن و محترمانه اقدام کنند.

بیایید بررسی کنیم که چگونه می توانیم از مدل Llama Guard در SageMaker JumpStart استفاده کنیم.

مدل های پایه در SageMaker

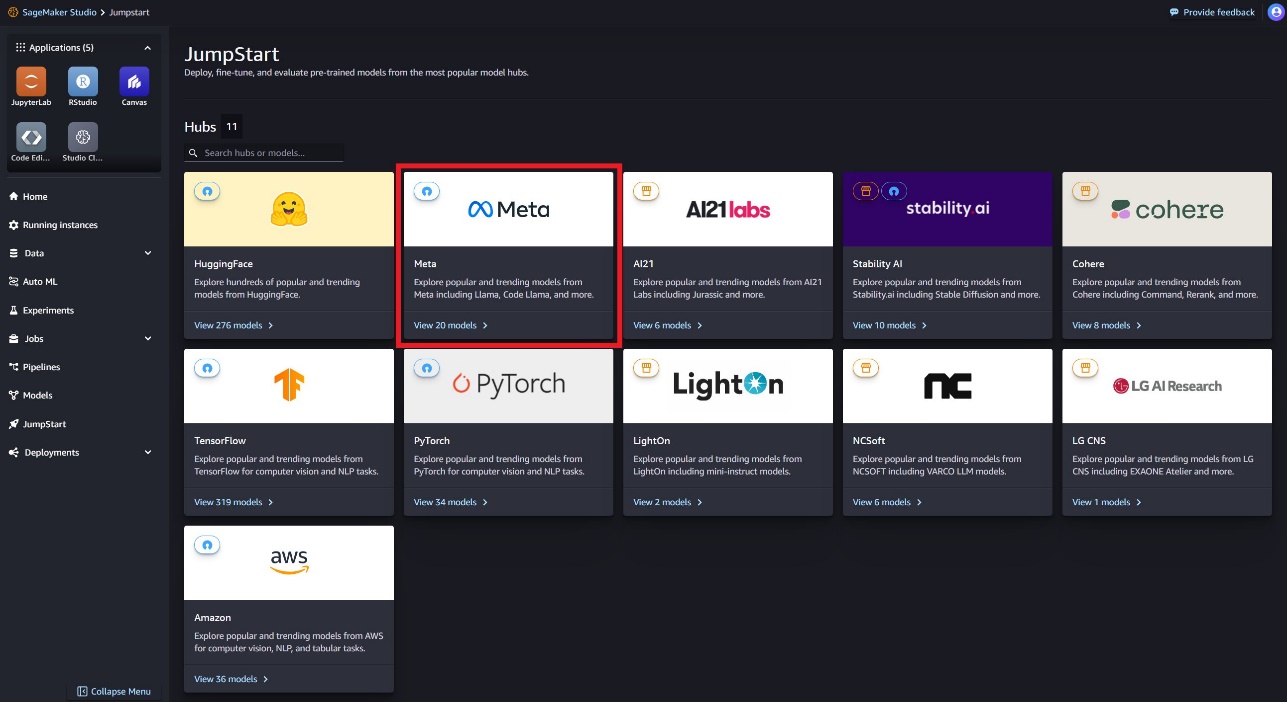

SageMaker JumpStart دسترسی به طیف وسیعی از مدلها از هابهای مدل محبوب، از جمله Hugging Face، PyTorch Hub، و TensorFlow Hub را فراهم میکند، که میتوانید در گردش کار توسعه ML خود در SageMaker استفاده کنید. پیشرفتهای اخیر در ML منجر به پیدایش دسته جدیدی از مدلها شده است که به آنها میگویند مدل های پایه، که معمولاً بر روی میلیاردها پارامتر آموزش داده می شوند و با دسته بندی گسترده ای از موارد استفاده مانند خلاصه سازی متن، تولید هنر دیجیتال و ترجمه زبان سازگار هستند. از آنجایی که آموزش این مدلها گران است، مشتریان میخواهند به جای آموزش این مدلها، از مدلهای پایه از پیش آموزشدیده موجود استفاده کنند و در صورت نیاز آنها را تنظیم کنند. SageMaker لیستی از مدلهایی را ارائه میکند که میتوانید از میان آنها در کنسول SageMaker انتخاب کنید.

اکنون میتوانید مدلهای پایه را از ارائهدهندگان مدلهای مختلف در SageMaker JumpStart بیابید، که به شما امکان میدهد به سرعت با مدلهای پایه شروع کنید. می توانید مدل های پایه را بر اساس وظایف مختلف یا ارائه دهندگان مدل پیدا کنید و به راحتی ویژگی های مدل و شرایط استفاده را بررسی کنید. همچنین می توانید این مدل ها را با استفاده از ویجت UI آزمایشی امتحان کنید. هنگامی که می خواهید از یک مدل پایه در مقیاس استفاده کنید، می توانید این کار را به راحتی بدون ترک SageMaker با استفاده از نوت بوک های از پیش ساخته شده از ارائه دهندگان مدل انجام دهید. از آنجایی که مدلها بر روی AWS میزبانی و مستقر میشوند، میتوانید مطمئن باشید که دادههای شما، چه برای ارزیابی یا استفاده از مدل در مقیاس استفاده شود، هرگز با اشخاص ثالث به اشتراک گذاشته نمیشود.

بیایید بررسی کنیم که چگونه می توانیم از مدل Llama Guard در SageMaker JumpStart استفاده کنیم.

مدل Llama Guard را در SageMaker JumpStart کشف کنید

می توانید از طریق SageMaker JumpStart در SageMaker Studio UI و SageMaker Python SDK به مدل های بنیاد Code Llama دسترسی پیدا کنید. در این بخش به چگونگی کشف مدل ها می پردازیم Amazon SageMaker Studio.

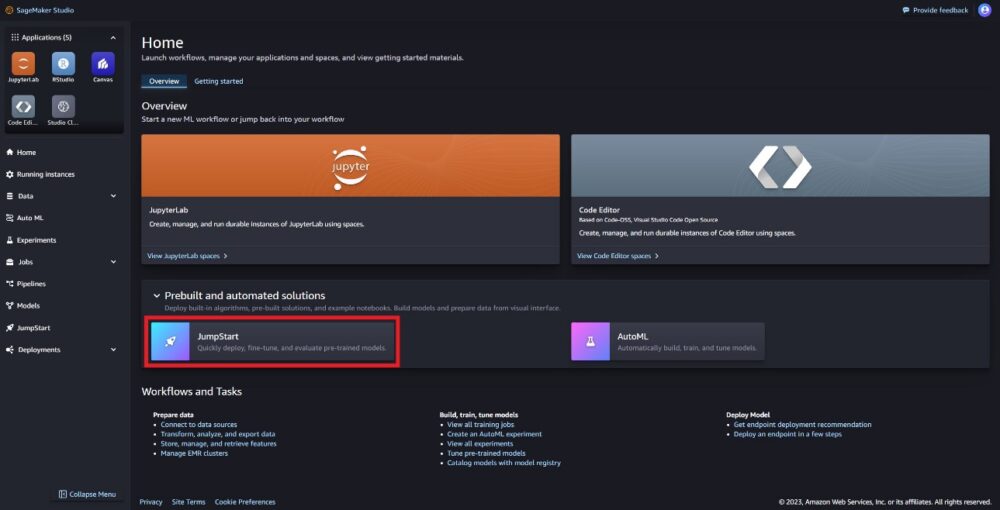

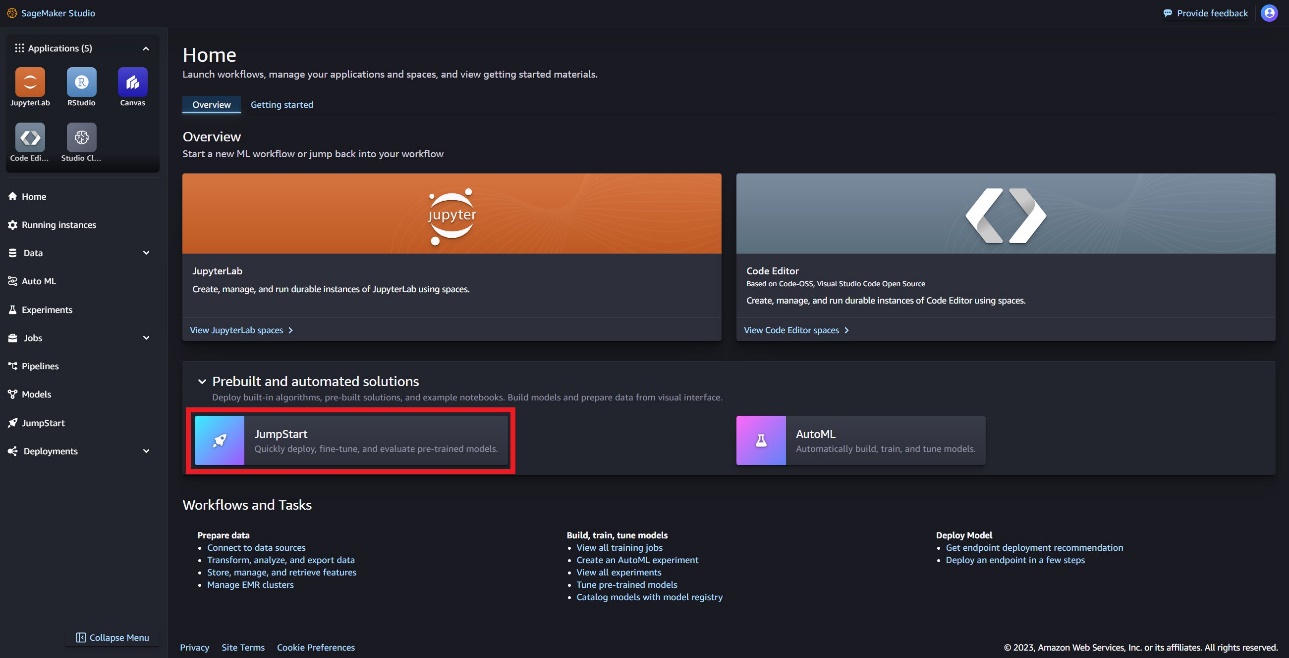

SageMaker Studio یک محیط توسعه یکپارچه (IDE) است که یک رابط بصری مبتنی بر وب را فراهم می کند که در آن می توانید به ابزارهای ساخته شده برای انجام تمام مراحل توسعه ML، از آماده سازی داده ها تا ساخت، آموزش، و استقرار مدل های ML خود دسترسی داشته باشید. برای جزئیات بیشتر در مورد نحوه شروع و راه اندازی SageMaker Studio، مراجعه کنید Amazon SageMaker Studio.

در SageMaker Studio، میتوانید به SageMaker JumpStart دسترسی داشته باشید که شامل مدلهای از پیش آموزشدیده، نوتبوکها و راهحلهای از پیش ساخته شده است. راه حل های از پیش ساخته شده و خودکار.

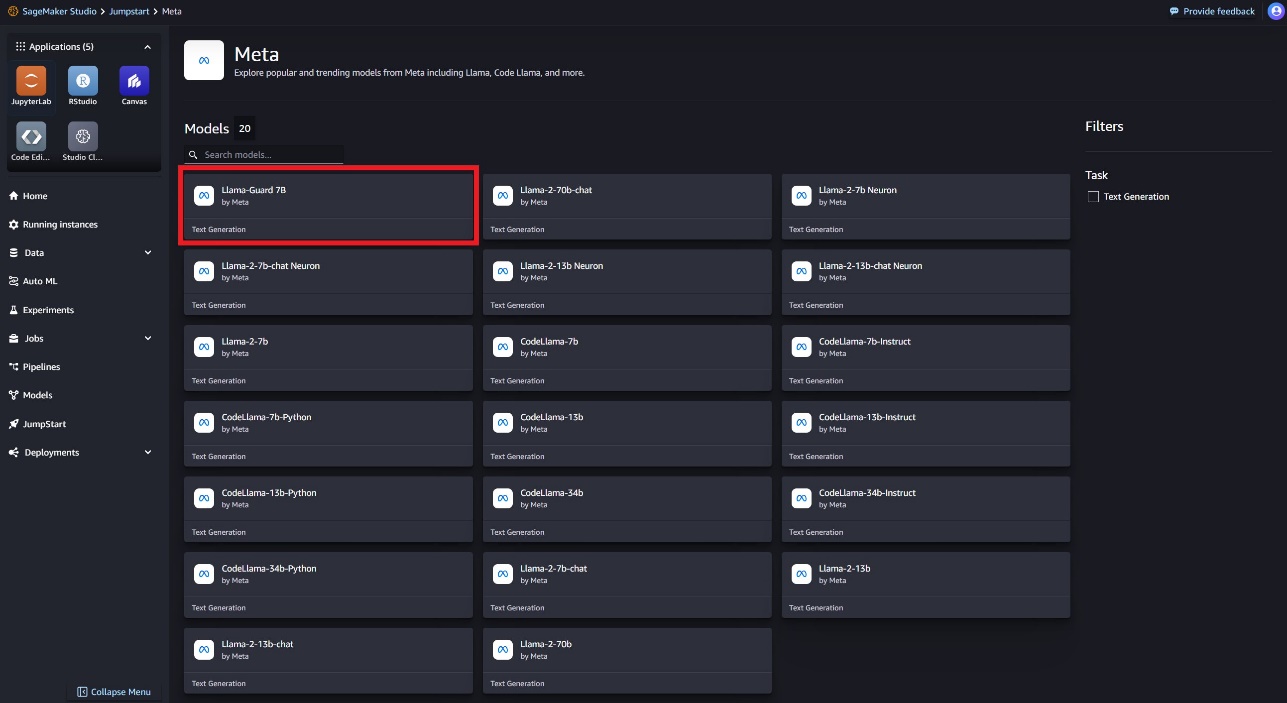

در صفحه فرود SageMaker JumpStart، می توانید مدل Llama Guard را با انتخاب متا هاب یا جستجوی Llama Guard بیابید.

شما می توانید از انواع مدل های لاما، از جمله Llama Guard، Llama-2، و Code Llama انتخاب کنید.

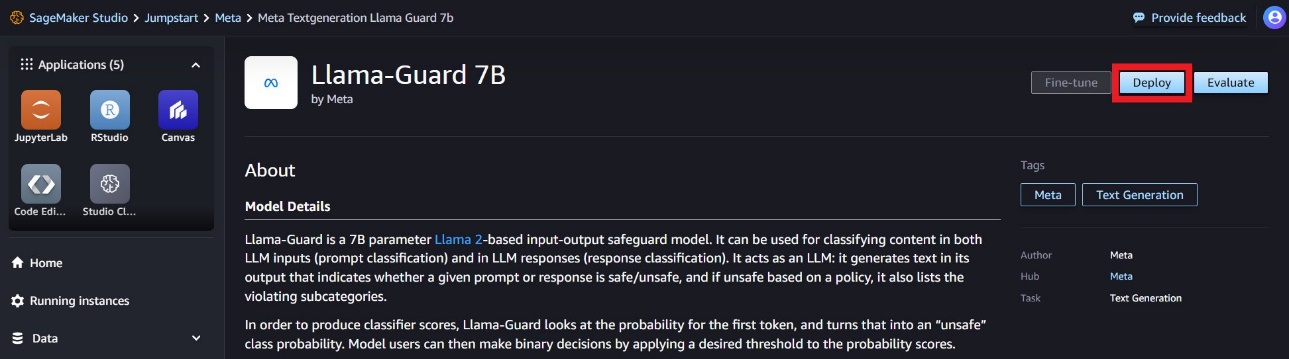

میتوانید کارت مدل را برای مشاهده جزئیات مدل مانند مجوز، دادههای مورد استفاده برای آموزش و نحوه استفاده انتخاب کنید. شما همچنین یک را پیدا خواهید کرد گسترش گزینه ای که شما را به صفحه فرود می برد که در آن می توانید استنتاج را با یک بار نمونه آزمایش کنید.

مدل را با SageMaker Python SDK اجرا کنید

می توانید کدی را که استقرار Llama Guard را در آمازون JumpStart نشان می دهد و نمونه ای از نحوه استفاده از مدل مستقر شده را در این نوت بوک GitHub.

در کد زیر، شناسه مدل هاب مدل SageMaker و نسخه مدل را برای استفاده در هنگام استقرار Llama Guard مشخص می کنیم:

اکنون می توانید مدل را با استفاده از SageMaker JumpStart اجرا کنید. کد زیر از نمونه پیشفرض ml.g5.2xlarge برای نقطه پایانی استنتاج استفاده میکند. شما می توانید مدل را بر روی انواع نمونه های دیگر با پاس دادن مستقر کنید instance_type در JumpStartModel کلاس استقرار ممکن است چند دقیقه طول بکشد. برای استقرار موفقیت آمیز، باید به صورت دستی تغییر دهید accept_eula آرگومان در روش استقرار مدل به True.

این مدل با استفاده از محفظه یادگیری عمیق استنتاج تولید متن (TGI) مستقر شده است. درخواستهای استنتاج از پارامترهای زیادی پشتیبانی میکنند، از جمله موارد زیر:

- بیشترین طول – مدل تا زمانی که طول خروجی (که شامل طول متن ورودی است) برسد، متن تولید می کند

max_length. اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - max_new_tokens – مدل تا زمانی که طول خروجی (به استثنای طول زمینه ورودی) به آن برسد، متن تولید می کند

max_new_tokens. اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - num_beams – این نشان دهنده تعداد پرتوهای استفاده شده در جستجوی حریصانه است. اگر مشخص شود، باید یک عدد صحیح بزرگتر یا مساوی باشد

num_return_sequences. - no_repeat_ngram_size - مدل تضمین می کند که دنباله ای از کلمات

no_repeat_ngram_sizeدر توالی خروجی تکرار نمی شود. اگر مشخص شده باشد، باید یک عدد صحیح مثبت بزرگتر از 1 باشد. - درجه حرارت – این پارامتر تصادفی بودن خروجی را کنترل می کند. یک بالاتر

temperatureمنجر به یک دنباله خروجی با کلمات کم احتمال و کمتر می شودtemperatureمنجر به یک دنباله خروجی با کلمات با احتمال بالا می شود. اگرtemperature0 است، منجر به رمزگشایی حریصانه می شود. اگر مشخص شود، باید شناور مثبت باشد. - زود_توقف - اگر

True، تولید متن زمانی به پایان می رسد که همه فرضیه های پرتو به پایان نشانه جمله برسند. اگر مشخص شده باشد، باید Boolean باشد. - do_sample - اگر

True، مدل کلمه بعدی را بر اساس احتمال نمونه برداری می کند. اگر مشخص شده باشد، باید Boolean باشد. - top_k – در هر مرحله از تولید متن، مدل فقط از متن نمونه برداری می کند

top_kبه احتمال زیاد کلمات اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - top_p - در هر مرحله از تولید متن، مدل از کوچکترین مجموعه ممکن کلمات با احتمال تجمعی نمونه برداری می کند.

top_p. اگر مشخص شده باشد، باید شناور بین 0-1 باشد. - بازگشت_متن_کامل - اگر

True، متن ورودی بخشی از متن تولید شده خروجی خواهد بود. اگر مشخص شده باشد، باید Boolean باشد. مقدار پیش فرض استFalse. - متوقف کردن – اگر مشخص شده باشد، باید فهرستی از رشته ها باشد. اگر هر یک از رشته های مشخص شده تولید شود، تولید متن متوقف می شود.

یک نقطه پایانی SageMaker را فراخوانی کنید

شما می توانید به صورت برنامه ریزی شده بارهای نمونه را از JumpStartModel هدف - شی. این به شما کمک میکند تا با مشاهده دستورات از پیش قالببندیشدهای که Llama Guard میتواند دریافت کند، به سرعت شروع کنید. کد زیر را ببینید:

پس از اجرای مثال قبلی، می توانید ببینید که چگونه ورودی و خروجی شما توسط Llama Guard فرمت می شود:

مانند Llama-2، Llama Guard از نشانه های مخصوصی برای نشان دادن دستورالعمل های ایمنی به مدل استفاده می کند. به طور کلی، محموله باید از فرمت زیر پیروی کند:

درخواست کاربر به صورت نشان داده شده است {user_prompt} در بالا، میتواند شامل بخشهایی برای تعاریف و مکالمات دستهبندی محتوا باشد که به شکل زیر است:

در بخش بعدی، مقادیر پیشفرض توصیهشده برای تعاریف وظیفه، دسته محتوا و دستورالعملها را مورد بحث قرار میدهیم. مکالمه باید به طور متناوب باشد User و Agent متن به شرح زیر

گفتگو را با Llama-2 Chat مدیریت کنید

اکنون میتوانید یک نقطه پایانی مدل گپ Llama-2 7B را برای گپ مکالمه ایجاد کنید و سپس از Llama Guard برای تعدیل متن ورودی و خروجی از Llama-2 7B Chat استفاده کنید.

ما نمونهای از ورودی و خروجی مدل چت Llama-2 7B را به شما نشان میدهیم که از طریق Llama Guard تعدیل شده است، اما میتوانید از Llama Guard برای تعدیل با هر LLM انتخابی خود استفاده کنید.

مدل را با کد زیر اجرا کنید:

اکنون می توانید الگوی وظیفه Llama Guard را تعریف کنید. دسته بندی محتوای ناامن ممکن است به دلخواه برای مورد استفاده خاص شما تنظیم شود. میتوانید معنای هر دسته محتوا را در متن ساده تعریف کنید، از جمله اینکه کدام محتوا باید بهعنوان ناامن علامتگذاری شود و کدام محتوا باید به عنوان امن باشد. کد زیر را ببینید:

در مرحله بعد، توابع کمکی را تعریف می کنیم format_chat_messages و format_guard_messages برای قالب بندی درخواست برای مدل چت و مدل Llama Guard که به نشانه های خاصی نیاز دارد:

سپس میتوانید از این توابع کمکی در یک اعلان ورودی پیام نمونه استفاده کنید تا ورودی نمونه را از طریق Llama Guard اجرا کنید تا مشخص کنید محتوای پیام امن است یا خیر:

خروجی زیر نشان می دهد که پیام امن است. ممکن است متوجه شوید که درخواست شامل کلماتی است که ممکن است با خشونت همراه باشد، اما، در این مورد، Llama Guard میتواند زمینه را با توجه به دستورالعملها و تعاریف دستهای ناامن که قبلا ارائه کردیم، درک کند و تشخیص دهد که این یک دستور امن است و نه مربوط به خشونت

اکنون که تأیید کردید که متن ورودی با توجه به دستههای محتوای Llama Guard ایمن است، میتوانید این بار را به مدل مستقر Llama-2 7B برای تولید متن ارسال کنید:

پاسخ این مدل به شرح زیر است:

در نهایت، ممکن است بخواهید تأیید کنید که متن پاسخ مدل حاوی محتوای ایمن است. در اینجا، پاسخ خروجی LLM را به پیامهای ورودی گسترش میدهید و کل این مکالمه را از طریق Llama Guard اجرا میکنید تا مطمئن شوید که مکالمه برای برنامه شما ایمن است:

ممکن است خروجی زیر را مشاهده کنید که نشان می دهد پاسخ از مدل چت ایمن است:

پاک کردن

پس از اینکه نقاط پایانی را آزمایش کردید، مطمئن شوید که نقاط پایانی استنتاج SageMaker و مدل را حذف کرده اید تا از تحمیل هزینه جلوگیری کنید.

نتیجه

در این پست به شما نشان دادیم که چگونه میتوانید ورودیها و خروجیها را با استفاده از Llama Guard تعدیل کنید و نردههایی را برای ورودیها و خروجیهای LLM در SageMaker JumpStart قرار دهید.

همانطور که هوش مصنوعی به پیشرفت خود ادامه می دهد، اولویت دادن به توسعه و استقرار مسئولانه بسیار مهم است. ابزارهایی مانند Purple Llama's CyberSecEval و Llama Guard در تقویت نوآوری ایمن نقش اساسی دارند و برای مدلهای زبانی، شناسایی اولیه خطر و راهنماییهای کاهش خطر را ارائه میدهند. اینها باید در فرآیند طراحی هوش مصنوعی گنجانده شوند تا از روز اول از پتانسیل کامل LLMها به صورت اخلاقی استفاده شود.

امروز Llama Guard و دیگر مدلهای پایه را در SageMaker JumpStart امتحان کنید و نظرات خود را با ما در میان بگذارید!

این راهنما فقط برای مقاصد اطلاعاتی است. شما همچنان باید ارزیابی مستقل خود را انجام دهید و اقداماتی را انجام دهید تا اطمینان حاصل شود که از رویهها و استانداردهای کنترل کیفیت خاص خود و قوانین، قوانین، مقررات، مجوزها و شرایط استفاده محلی که در مورد شما، محتوای شما اعمال میشود، پیروی میکنید. و مدل شخص ثالث اشاره شده در این راهنما. AWS هیچ کنترل یا اختیاری بر مدل شخص ثالث اشاره شده در این راهنما ندارد، و هیچ گونه تضمین یا تضمینی مبنی بر ایمن بودن، عاری از ویروس، عملیاتی بودن یا سازگاری مدل شخص ثالث با محیط تولید و استانداردهای شما ندارد. AWS هیچ گونه اظهارنظر، ضمانت یا تضمینی مبنی بر اینکه هر گونه اطلاعات موجود در این راهنما منجر به نتیجه یا نتیجه خاصی شود، ارائه نمی کند.

درباره نویسندگان

دکتر کایل اولریش دانشمند کاربردی با الگوریتم های داخلی آمازون SageMaker تیم علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر کایل اولریش دانشمند کاربردی با الگوریتم های داخلی آمازون SageMaker تیم علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

ایوان کراویتز یک مهندس نرم افزار در خدمات وب آمازون است که روی SageMaker JumpStart کار می کند. او به تلاقی یادگیری ماشین با محاسبات ابری علاقه مند است. ایوان مدرک کارشناسی خود را از دانشگاه کرنل و مدرک کارشناسی ارشد خود را از دانشگاه کالیفرنیا، برکلی دریافت کرد. در سال 2021، او مقاله ای در مورد شبکه های عصبی متخاصم در کنفرانس ICLR ارائه کرد. ایوان در اوقات فراغت خود از آشپزی، مسافرت و دویدن در شهر نیویورک لذت می برد.

ایوان کراویتز یک مهندس نرم افزار در خدمات وب آمازون است که روی SageMaker JumpStart کار می کند. او به تلاقی یادگیری ماشین با محاسبات ابری علاقه مند است. ایوان مدرک کارشناسی خود را از دانشگاه کرنل و مدرک کارشناسی ارشد خود را از دانشگاه کالیفرنیا، برکلی دریافت کرد. در سال 2021، او مقاله ای در مورد شبکه های عصبی متخاصم در کنفرانس ICLR ارائه کرد. ایوان در اوقات فراغت خود از آشپزی، مسافرت و دویدن در شهر نیویورک لذت می برد.

راچنا چادا یک معمار راه حل اصلی AI/ML در حساب های استراتژیک در AWS است. Rachna خوشبین است که معتقد است استفاده اخلاقی و مسئولانه از هوش مصنوعی می تواند جامعه را در آینده بهبود بخشد و رونق اقتصادی و اجتماعی را به ارمغان بیاورد. راچنا در اوقات فراغت خود دوست دارد با خانواده خود، پیاده روی و گوش دادن به موسیقی وقت بگذراند.

راچنا چادا یک معمار راه حل اصلی AI/ML در حساب های استراتژیک در AWS است. Rachna خوشبین است که معتقد است استفاده اخلاقی و مسئولانه از هوش مصنوعی می تواند جامعه را در آینده بهبود بخشد و رونق اقتصادی و اجتماعی را به ارمغان بیاورد. راچنا در اوقات فراغت خود دوست دارد با خانواده خود، پیاده روی و گوش دادن به موسیقی وقت بگذراند.

دکتر آشیش ختان یک دانشمند کاربردی ارشد با الگوریتم های داخلی Amazon SageMaker است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

دکتر آشیش ختان یک دانشمند کاربردی ارشد با الگوریتم های داخلی Amazon SageMaker است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

کارل آلبرتسن محصولات، مهندسی و علم را برای Amazon SageMaker Algorithms و JumpStart، مرکز یادگیری ماشینی SageMaker، رهبری می کند. او علاقه زیادی به استفاده از یادگیری ماشینی برای باز کردن ارزش کسب و کار دارد.

کارل آلبرتسن محصولات، مهندسی و علم را برای Amazon SageMaker Algorithms و JumpStart، مرکز یادگیری ماشینی SageMaker، رهبری می کند. او علاقه زیادی به استفاده از یادگیری ماشینی برای باز کردن ارزش کسب و کار دارد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/llama-guard-is-now-available-in-amazon-sagemaker-jumpstart/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 2021

- 39

- 7

- 8

- 9

- a

- قادر

- درباره ما

- بالاتر

- پذیرفتن

- دسترسی

- مطابق

- حساب ها

- عمل

- عمل

- اقدامات

- فعال

- فعالیت ها

- واقعی

- اضافه

- تنظیم شده

- اتخاذ

- پیشرفت

- پیشرفت

- دشمن

- نصیحت

- در برابر

- عامل

- AI

- مدل های هوش مصنوعی

- AI / ML

- الکل

- الگوریتم

- معرفی

- همچنین

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- an

- و

- اعلام

- پاسخ

- هر

- کاربرد

- اعمال می شود

- درخواست

- با استفاده از

- مناسب

- هستند

- استدلال

- استدلال

- هنر

- AS

- ارزیابی

- همکاری

- دستیار

- مرتبط است

- مطمئن

- At

- قدرت

- خودکار

- در دسترس

- اجتناب از

- AWS

- مستقر

- اساسی

- بیزی

- BE

- پرتو

- زیرا

- بوده

- قبل از

- شروع

- رفتار

- معتقد است که

- در زیر

- معیار

- برکلی

- بهترین

- بهترین شیوه

- میان

- میلیاردها

- بدن

- هر دو

- به ارمغان بیاورد

- به ارمغان می آورد

- ساختن

- بنا

- ساخته شده در

- کسب و کار

- اما

- by

- کالیفرنیا

- CAN

- شاهدانه

- کارت

- مورد

- موارد

- دسته

- دسته بندی

- چالش ها

- شانس

- تغییر دادن

- مشخصات

- بار

- گپ

- chatbots

- بررسی

- شیمیایی

- انتخاب

- را انتخاب کنید

- انتخاب

- شهر:

- کلاس

- تمیز

- ابر

- محاسبات ابری

- رمز

- رنگ

- آینده

- تجاری

- مرتکب شده

- مشترک

- انجمن

- سازگار

- مطابق

- اجزاء

- ترکیب

- کامپیوتر

- چشم انداز کامپیوتر

- محاسبه

- کنفرانس

- همایش ها

- تکرار

- تایید شده

- تلاقی

- کنسول

- مصرف

- شامل

- ظرف

- شامل

- محتوا

- زمینه

- ادامه

- کنترل

- کنترل

- گروه شاهد

- گفتگو

- محاورهای

- گفتگو

- کرنل

- میتوانست

- ایجاد

- ایجاد

- جنایات

- کیفری

- بحرانی

- سرپرستی

- مشتری

- خدمات مشتری

- مشتریان

- سفارشی

- سایبر

- امنیت سایبری

- چرخه

- داده ها

- مجموعه داده ها

- روز

- رمز گشایی

- عمیق

- یادگیری عمیق

- به طور پیش فرض

- تعريف كردن

- تعاریف

- درجه

- گسترش

- مستقر

- استقرار

- گسترش

- اعزام ها

- طرح

- روند طراحی

- میل

- مطلوب

- دقیق

- جزئیات

- کشف

- مشخص کردن

- مشخص

- توسعه

- توسعه دهنده

- توسعه دهندگان

- پروژه

- DICT

- مختلف

- دیجیتال

- هنر دیجیتال

- كشف كردن

- بحث و تبادل نظر

- do

- میکند

- مواد مخدر

- دوک

- دانشگاه دوک

- e

- هر

- پیش از آن

- در اوایل

- به آسانی

- اقتصادی

- اکوسیستم

- آموزش

- اثرات

- بدون دردسر

- قادر ساختن

- را قادر می سازد

- تشویق

- پایان

- پشت سر هم

- نقطه پایانی

- تعامل

- مهندس

- مهندسی

- اطمینان حاصل شود

- تضمین می کند

- محیط

- برابر

- به خصوص

- اخلاقی

- ارزیابی

- ارزیابی

- اوان

- حوادث

- مثال

- جز

- استثنا

- برانگیخته

- به استثنای

- اعدام

- موجود

- گران

- اکتشاف

- صریح

- گسترش

- چهره

- در مواجهه

- غلط

- خانواده

- ویژگی های

- کمی از

- مالی

- جرایم مالی

- پیدا کردن

- سلاح های گرم

- نام خانوادگی

- پرچم گذاری شده

- شناور

- تمرکز

- به دنبال

- به دنبال

- پیروی

- به دنبال آن است

- برای

- قالب

- پرورش دادن

- پایه

- رایگان

- از جانب

- کامل

- توابع

- بیشتر

- آینده

- جنس

- سوالات عمومی

- تولید می کنند

- تولید

- تولید می کند

- مولد

- نسل

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- GitHub

- داده

- دادن

- Go

- رفتن

- کردم

- بیشتر

- حریص

- تضمین می کند

- گارد

- راهنمایی

- اسلحه ها

- صدمه

- دهنه

- نفرت

- آیا

- he

- سلامتی

- کمک

- کمک می کند

- او

- اینجا کلیک نمایید

- بالاتر

- خود را

- تاریخی

- میزبانی

- چگونه

- چگونه

- HTML

- HTTPS

- قطب

- هاب

- i

- ID

- شناسایی

- هویت

- if

- غیر مجاز

- ایلینوی

- بلافاصله

- واردات

- بهبود

- in

- شامل

- شامل

- از جمله

- مستقل

- نشان دادن

- نشان می دهد

- اطلاعات

- اطلاعاتی

- درشت

- اول

- ابتکار عمل

- ابداع

- ورودی

- ورودی

- نمونه

- دستورالعمل

- ابزاری

- ادغام

- یکپارچه

- علاقه مند

- منافع

- رابط

- به

- شامل

- IT

- ITS

- JPG

- کشتن

- دانستن

- شناخته شده

- کایل

- فرود

- زبان

- بزرگ

- نام

- قوانین

- منجر می شود

- یادگیری

- ترک

- طول

- اجازه

- مجوز

- مجاز

- مجوزها

- پسندیدن

- احتمال

- احتمالا

- دوست دارد

- محدود شده

- لاین

- لینوکس

- فهرست

- استماع

- پشم لاما

- LLM

- محلی

- مطالب

- کاهش

- دستگاه

- فراگیری ماشین

- حفظ

- ساخت

- دستی

- ساخته

- بسیاری

- کارشناسی ارشد

- ممکن است..

- معنی

- معیارهای

- رسانه ها

- روانی

- سلامت روان

- پیام

- پیام

- متا

- روش

- روش

- قدرت

- دقیقه

- کاهش

- مخلوط

- ML

- مدل

- مدل

- اعتدال

- نظارت بر

- بیش

- اکثر

- موسیقی

- باید

- ملی

- ضروری

- شبکه

- عصبی

- شبکه های عصبی

- هرگز

- جدید

- نیویورک

- شهر نیویورک

- بعد

- نه

- دفتر یادداشت

- اطلاع..

- اکنون

- عدد

- هدف

- of

- ارائه

- on

- ONE

- فقط

- باز کن

- بی پرده

- قابل استفاده

- گزینه

- گزینه

- or

- منشاء

- دیگر

- ما

- خارج

- نتیجه

- تولید

- خروجی

- روی

- خود

- مالکیت

- با ما

- مقاله

- اوراق

- پارامتر

- پارامترهای

- بخش

- ویژه

- احزاب

- عبور

- عبور

- احساساتی

- مردم

- برای

- انجام

- انجام می دهد

- شخص

- شخصی

- دکترا

- ساده

- برنامه

- برنامه ریزی

- افلاطون

- هوش داده افلاطون

- PlatoData

- سیاست

- محبوب

- مثبت

- ممکن

- پست

- پتانسیل

- بالقوه

- شیوه های

- ماقبل

- پیشگو

- آماده

- ارائه شده

- جلوگیری از

- اصلی

- اولویت بندی

- روند

- فرآیندهای

- محصول

- تولید

- پروژه

- پرسیدن

- رفاه

- ارائه

- ارائه

- ارائه دهندگان

- فراهم می کند

- عمومی

- منتشر شده

- انتشار

- اهداف

- قرار دادن

- پــایتــون

- مارماهی

- کیفیت

- به سرعت

- نژاد

- تصادفی بودن

- محدوده

- نسبتا

- رسیدن به

- می رسد

- خواندن

- اخذ شده

- اخیر

- توصیه می شود

- مراجعه

- با توجه

- تنظیم

- مقررات

- مربوط

- آزاد

- مربوط

- دین

- مکرر

- جایگزین کردن

- درخواست

- ضروری

- تحقیق

- پژوهشگر

- منابع

- احترام

- پاسخ دادن

- پاسخ

- مسئوليت

- مسئولانه

- REST

- نتیجه

- نتایج

- برگشت

- این فایل نقد می نویسید:

- طلوع

- خطر

- خطرناک

- نقشه راه

- نقش

- نقش

- قوانین

- دویدن

- اجرا می شود

- امن

- پادمان

- ایمنی

- حکیم ساز

- استنباط SageMaker

- مقیاس پذیر

- مقیاس

- علم

- دانشمند

- sdk

- جستجو

- جستجو

- دوم

- بخش

- بخش

- امن

- تیم امنیت لاتاری

- دیدن

- را انتخاب کنید

- ارشد

- حساس

- جمله

- احساسات

- دنباله

- سلسله

- سرویس

- خدمات

- تنظیم

- جنسی

- به اشتراک گذاشته شده

- باید

- نشان

- نشان داد

- نشان داده شده

- تنها

- So

- آگاهی

- رسانه های اجتماعی

- جامعه

- نرم افزار

- مهندس نرمافزار

- راه حل

- مزایا

- ویژه

- خاص

- مشخص شده

- هزینه

- استانداردهای

- آغاز شده

- راه افتادن

- آماری

- ارقام

- گام

- مراحل

- هنوز

- توقف

- استراتژیک

- استراتژی ها

- استودیو

- موفق

- چنین

- خودکشی

- پشتیبانی

- پشتیبانی از

- مطمئن

- نحو

- سیستم

- سیستم های

- گرفتن

- کار

- وظایف

- تیم

- قالب

- قالب

- جریان تنسور

- قوانین و مقررات

- آزمون

- آزمایش

- متن

- نسبت به

- که

- La

- آینده

- اطلاعات

- سرقت

- شان

- آنها

- خودشان

- سپس

- آنجا.

- اینها

- آنها

- سوم

- اشخاص ثالث

- شخص ثالث

- این

- کسانی که

- از طریق

- زمان

- سری زمانی

- به

- امروز

- با هم

- رمز

- نشانه

- ابزار

- ابزار

- تاپیک

- قطار

- آموزش دیده

- آموزش

- ترجمه

- سفر

- درست

- اعتماد

- امتحان

- دور زدن

- انواع

- به طور معمول

- ui

- در نهایت

- زیر

- فهمیدن

- دانشگاه

- دانشگاه کالیفرنیا

- باز

- تا

- us

- استفاده

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- استفاده

- با استفاده از

- ارزش

- ارزشها

- تنوع

- نسخه

- چشم انداز

- نقض

- نقض کردن

- خشونت

- دید

- بصری

- راه رفتن

- می خواهم

- مسیر..

- we

- تسلیحات

- وب

- خدمات وب

- مبتنی بر وب

- چی

- چه زمانی

- چه

- که

- WHO

- تمام

- وسیع

- ویدجت

- اراده

- آرزو

- با

- در داخل

- بدون

- کلمه

- کلمات

- مهاجرت کاری

- گردش کار

- کارگر

- خواهد بود

- نیویورک

- شما

- شما

- زفیرنت