امروز، ما با هیجان اعلام می کنیم که مدل های پایه Code Llama، توسعه یافته توسط Meta، برای مشتریان در دسترس هستند. Amazon SageMaker JumpStart برای استقرار با یک کلیک برای اجرای استنتاج. Code Llama یک مدل زبان بزرگ پیشرفته (LLM) است که قادر به تولید کد و زبان طبیعی در مورد کد از هر دو درخواست کد و زبان طبیعی است. کد لاما برای تحقیقات و استفاده تجاری رایگان است. میتوانید این مدل را با SageMaker JumpStart امتحان کنید، یک مرکز یادگیری ماشین (ML) که دسترسی به الگوریتمها، مدلها و راهحلهای ML را فراهم میکند تا بتوانید به سرعت با ML شروع کنید. در این پست، نحوه کشف و استقرار مدل Code Llama از طریق SageMaker JumpStart را بررسی می کنیم.

کد لاما چیست؟

Code Llama مدلی است که توسط متا که در بالای Llama 2 ساخته شده است و یک مدل پیشرفته است که برای بهبود بهره وری برای کارهای برنامه نویسی برای توسعه دهندگان با کمک به آنها در ایجاد کد با کیفیت بالا و مستند طراحی شده است. این مدلها عملکرد پیشرفتهای را در Python، C++، Java، PHP، C#، TypeScript و Bash نشان میدهند و این پتانسیل را دارند که در زمان توسعهدهندگان صرفهجویی کنند و گردش کار نرمافزار را کارآمدتر کنند. این در سه نوع ارائه می شود که برای پوشش طیف گسترده ای از کاربردها مهندسی شده است: مدل پایه (Code Llama)، یک مدل تخصصی پایتون (Code Llama-Python) و یک مدل مطابق دستورالعمل برای درک دستورالعمل های زبان طبیعی (Code Llama-Instruct). ). همه انواع Code Llama در سه اندازه ارائه می شوند: پارامترهای 7B، 13B و 34B. انواع پایه و دستورالعمل 7B و 13B از پر کردن بر اساس محتوای اطراف پشتیبانی می کنند و آنها را برای برنامه های دستیار کد ایده آل می کند.

این مدلها با استفاده از Llama 2 بهعنوان پایه طراحی شدند و سپس بر روی 500 میلیارد توکن دادههای کد آموزش دیدند، با نسخه تخصصی پایتون که با افزایش 100 میلیارد توکن آموزش داده شد. مدلهای Code Llama نسلهای پایداری را با حداکثر 100,000 توکن زمینه ارائه میکنند. همه مدلها بر روی دنبالههای 16,000 توکن آموزش داده شدهاند و بهبودهایی را در ورودیها با حداکثر 100,000 توکن نشان میدهند.

مدل تحت همین موجود در دسترس است مجوز انجمن به عنوان Llama 2.

SageMaker JumpStart چیست؟

با SageMaker JumpStart، پزشکان ML میتوانند از بین فهرست رو به رشدی از بهترین مدلهای فونداسیون انتخاب کنند. پزشکان ML می توانند مدل های پایه را به صورت اختصاصی به کار گیرند آمازون SageMaker نمونه هایی در یک محیط ایزوله شبکه و سفارشی کردن مدل ها با استفاده از SageMaker برای آموزش و استقرار مدل.

اکنون میتوانید مدلهای Code Llama را با چند کلیک کشف و اجرا کنید Amazon SageMaker Studio یا به صورت برنامه نویسی از طریق SageMaker Python SDK، به شما امکان می دهد عملکرد مدل و کنترل های MLOps را با ویژگی های SageMaker مانند خطوط لوله آمازون SageMaker, دیباگر Amazon SageMaker، یا سیاهههای مربوط به کانتینر. این مدل در یک محیط امن AWS و تحت کنترل های VPC شما مستقر شده است و به اطمینان از امنیت داده ها کمک می کند. مدل های کد لاما قابل کشف هستند و می توانند در مناطق شرقی ایالات متحده (شمال ویرجینیا)، غرب ایالات متحده (اورگان) و اروپا (ایرلند) مستقر شوند.

مشتریان برای استقرار مدل ویزا SageMaker SDK باید EULA را بپذیرند.

مدل ها را کشف کنید

می توانید از طریق SageMaker JumpStart در SageMaker Studio UI و SageMaker Python SDK به مدل های بنیاد Code Llama دسترسی پیدا کنید. در این بخش به نحوه کشف مدل ها در SageMaker Studio می پردازیم.

SageMaker Studio یک محیط توسعه یکپارچه (IDE) است که یک رابط بصری مبتنی بر وب را فراهم می کند که در آن می توانید به ابزارهای ساخته شده برای انجام تمام مراحل توسعه ML، از آماده سازی داده ها تا ساخت، آموزش، و استقرار مدل های ML خود دسترسی داشته باشید. برای جزئیات بیشتر در مورد نحوه شروع و راه اندازی SageMaker Studio، مراجعه کنید Amazon SageMaker Studio.

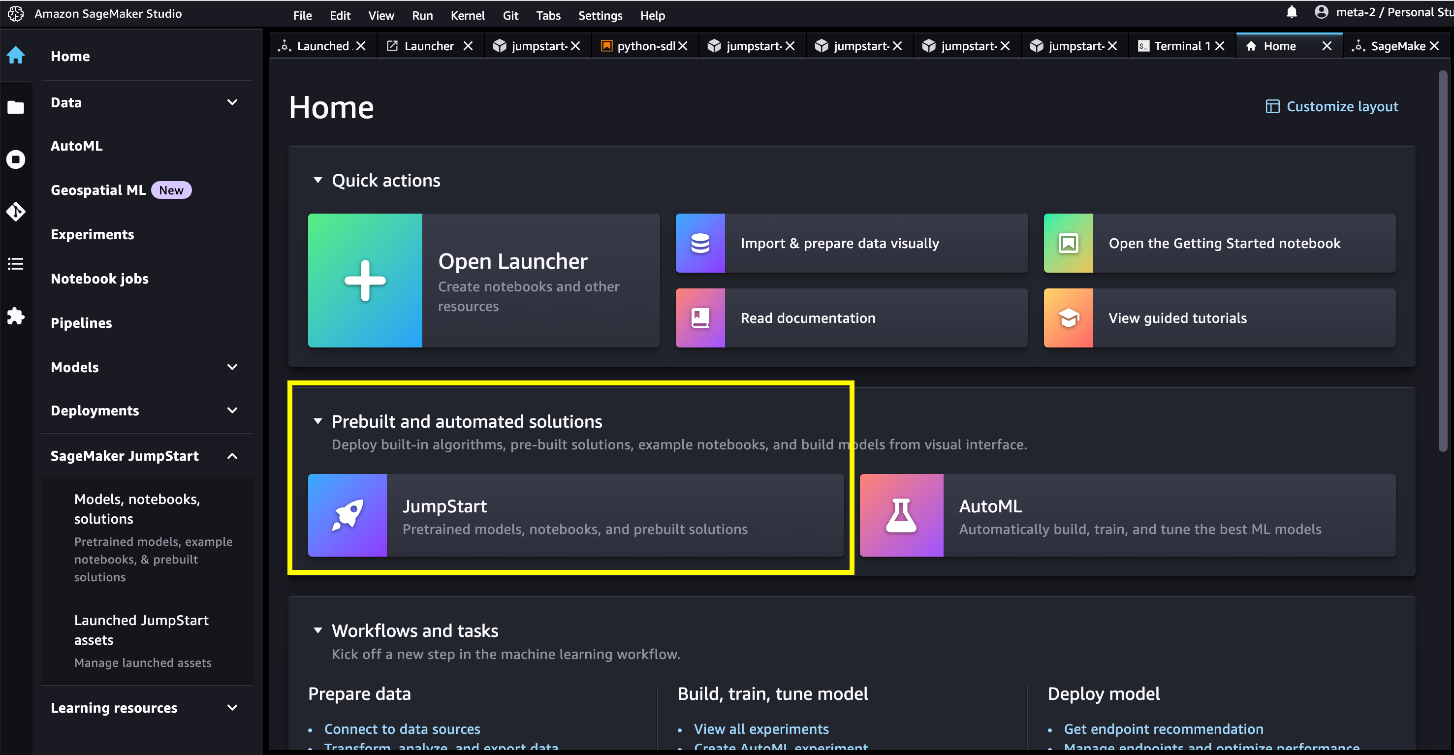

در SageMaker Studio، میتوانید به SageMaker JumpStart دسترسی داشته باشید که شامل مدلهای از پیش آموزشدیده، نوتبوکها و راهحلهای از پیش ساخته شده است. راه حل های از پیش ساخته شده و خودکار.

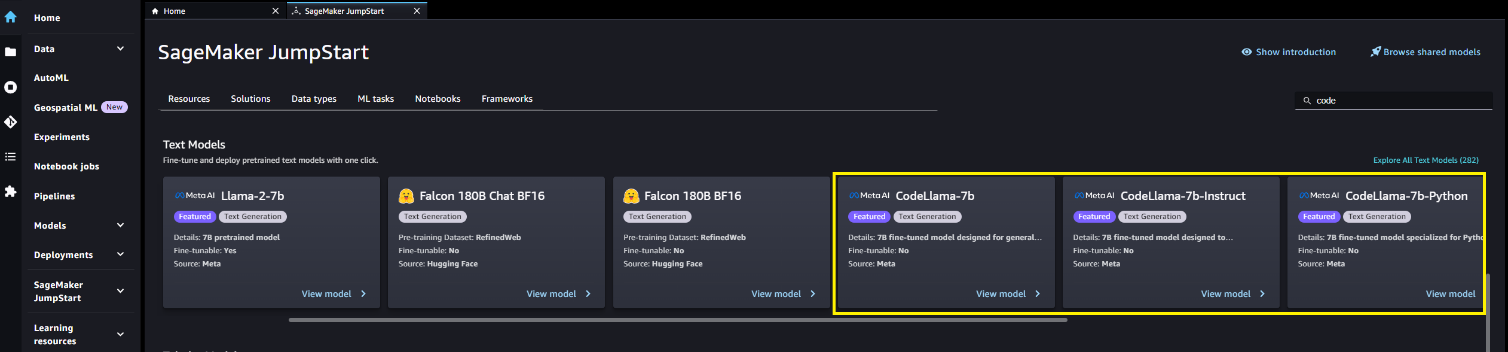

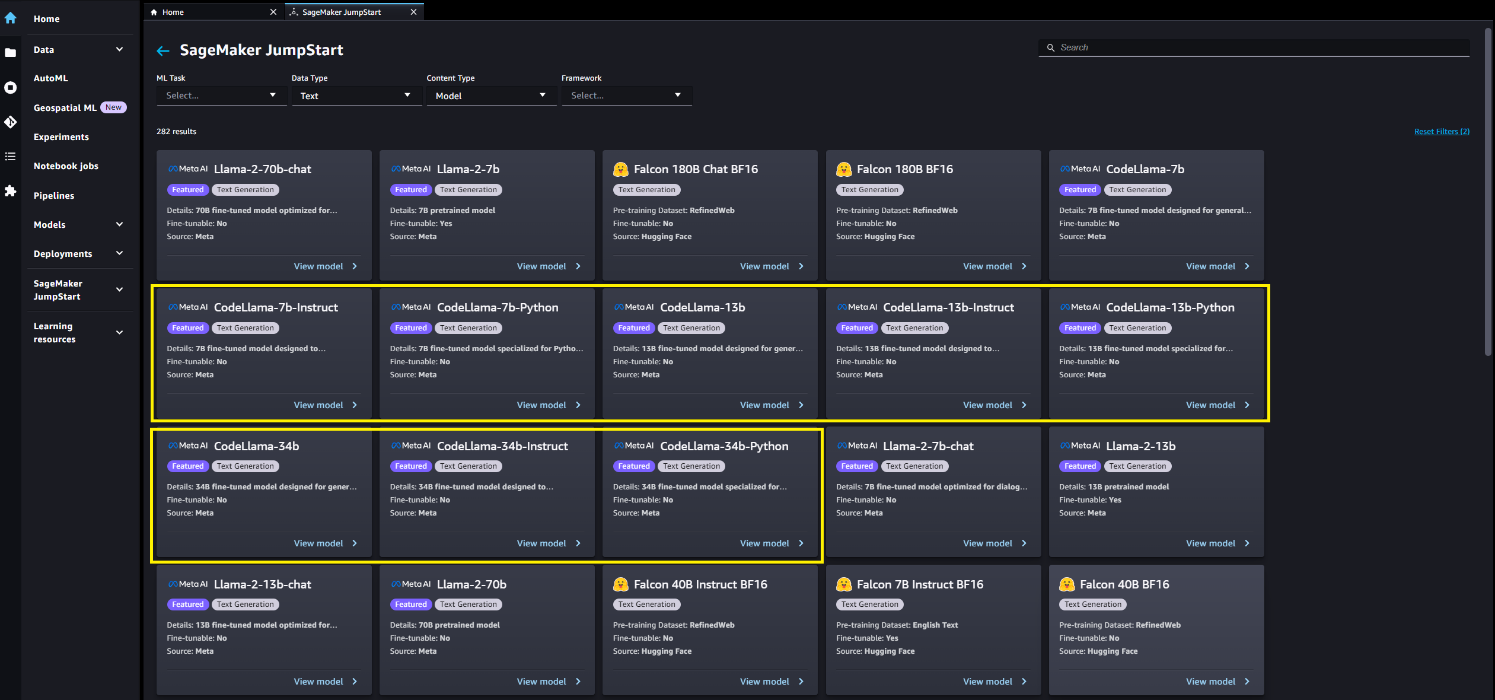

در صفحه فرود SageMaker JumpStart، می توانید راه حل ها، مدل ها، نوت بوک ها و منابع دیگر را جستجو کنید. می توانید مدل های Code Llama را در قسمت پیدا کنید مدل های بنیاد: تولید متن چرخ فلک.

شما همچنین می توانید مدل های دیگر را با انتخاب پیدا کنید تمام مدل های تولید متن را کاوش کنید یا جستجوی کد لاما.

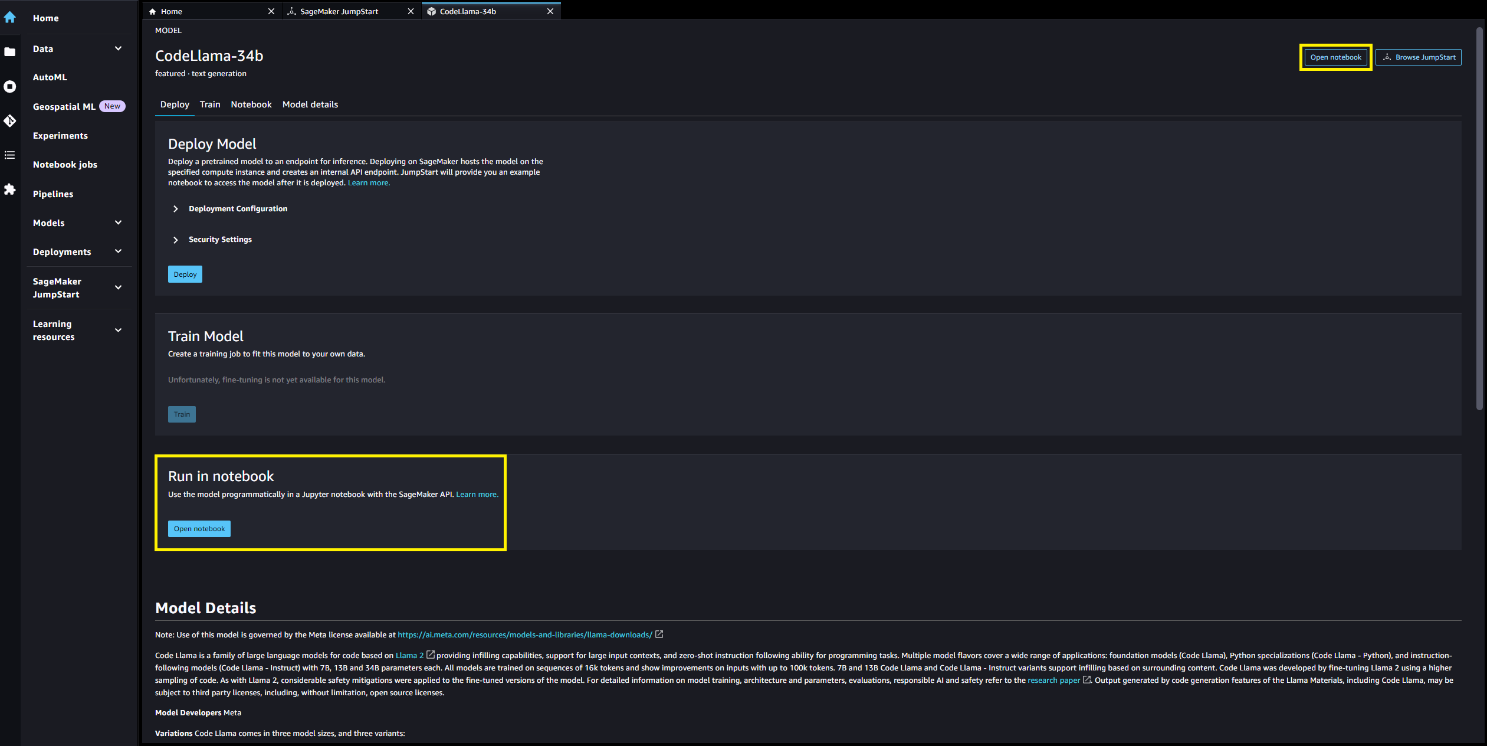

میتوانید کارت مدل را برای مشاهده جزئیات مدل مانند مجوز، دادههای مورد استفاده برای آموزش و نحوه استفاده انتخاب کنید. همچنین دو دکمه پیدا خواهید کرد، گسترش و نوت بوک را باز کنید، که به شما در استفاده از مدل کمک می کند.

گسترش

وقتی انتخاب کردید گسترش و با پذیرش شرایط، استقرار آغاز خواهد شد. از طرف دیگر، می توانید با انتخاب از طریق دفترچه یادداشت نمونه مستقر شوید نوت بوک را باز کنید. دفترچه یادداشت نمونه ای که راهنمایی سرتاسری در مورد نحوه استقرار مدل برای استنتاج و پاکسازی منابع ارائه می دهد.

برای استقرار با استفاده از نوت بوک، با انتخاب یک مدل مناسب شروع می کنیم، مشخص شده توسط model_id. می توانید هر یک از مدل های انتخاب شده را با کد زیر در SageMaker مستقر کنید:

این مدل را در SageMaker با تنظیمات پیشفرض، از جمله نوع نمونه پیشفرض و تنظیمات پیشفرض VPC، مستقر میکند. شما می توانید این تنظیمات را با تعیین مقادیر غیر پیش فرض در آن تغییر دهید JumpStartModel. پس از استقرار، می توانید استنتاج را در برابر نقطه پایانی مستقر شده از طریق پیش بینی SageMaker اجرا کنید:

توجه داشته باشید که به طور پیش فرض، accept_eula تنظیم شده است false. باید تنظیم کنید accept_eula=true برای فراخوانی موفقیت آمیز نقطه پایانی با انجام این کار، موافقت نامه مجوز کاربر و خط مشی استفاده قابل قبول را همانطور که قبلا ذکر شد می پذیرید. شما همچنین می توانید دانلود قرارداد مجوز

Custom_attributes برای عبور EULA جفت های کلید/مقدار استفاده می شود. کلید و مقدار با = و جفت ها با ; از هم جدا می شوند. اگر کاربر یک کلید را بیش از یک بار ارسال کند، آخرین مقدار نگه داشته شده و به کنترل کننده اسکریپت ارسال می شود (در این مورد، برای منطق شرطی استفاده می شود). به عنوان مثال، اگر accept_eula=false; accept_eula=true سپس به سرور ارسال می شود accept_eula=true نگه داشته می شود و به کنترل کننده اسکریپت منتقل می شود.

پارامترهای استنتاج فرآیند تولید متن را در نقطه پایانی کنترل می کنند. حداکثر کنترل توکن های جدید به اندازه خروجی تولید شده توسط مدل اشاره دارد. توجه داشته باشید که این عدد با تعداد کلمات یکسان نیست زیرا واژگان مدل با واژگان زبان انگلیسی یکسان نیست و هر نشانه ممکن است یک کلمه زبان انگلیسی نباشد. دما تصادفی بودن خروجی را کنترل می کند. دمای بالاتر منجر به خروجیهای خلاقانهتر و توهمآمیزتر میشود. تمام پارامترهای استنتاج اختیاری هستند.

جدول زیر تمام مدلهای Code Llama موجود در SageMaker JumpStart را به همراه شناسههای مدل، انواع نمونههای پیشفرض و حداکثر توکنهای پشتیبانی شده (مجموع تعداد نشانههای ورودی و تعداد توکنهای تولید شده برای همه درخواستهای همزمان) ارائه میکند. این مدل ها

| نام مدل | شناسه مدل | نوع نمونه پیش فرض | حداکثر توکن های پشتیبانی شده |

| CodeLlama-7b | meta-textgeneration-llama-codellama-7b | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Instruct | meta-textgeneration-llama-codellama-7b-instruct | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xlarge | 10000 |

| CodeLlama-13b | meta-textgeneration-llama-codellama-13b | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Instruct | meta-textgeneration-llama-codellama-13b-instruct | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xlarge | 32000 |

| CodeLlama-34b | meta-textgeneration-llama-codellama-34b | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Instruct | meta-textgeneration-llama-codellama-34b-instruct | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xlarge | 48000 |

در حالی که مدلهای Code Llama بر روی طول زمینه 16,000 توکن آموزش داده شدهاند، مدلها عملکرد خوبی را در پنجرههای زمینه بزرگتر گزارش کردهاند. حداکثر ستون نشانه های پشتیبانی شده در جدول قبل، حد بالایی در پنجره زمینه پشتیبانی شده در نوع نمونه پیش فرض است. از آنجایی که مدل Code Llama 7B تنها میتواند از 10,000 توکن در نمونه ml.g5.2xlarge پشتیبانی کند، توصیه میکنیم در صورتی که زمینههای بزرگتری برای برنامه شما نیاز است، نسخه مدل 13B یا 34B را اجرا کنید.

به طور پیش فرض، همه مدل ها برای وظایف تولید کد کار می کنند. مدل پایه و دستورالعمل هر دو به وظایف تکمیلی پاسخ می دهند، اگرچه مدل پایه خروجی با کیفیت بهتری برای اکثر پرس و جوهای نمونه داشت. در نهایت، فقط مدلهای دستورالعمل روی وظایف دستور کار میکنند. جدول زیر نشان میدهد که کدام مدلها عملکرد خوب (خوب) و عملکرد متوسط (متوسط) را در پرسوجوهای نمونه در نوتبوکهای آزمایشی داشتند.

| . | تولید کد | تکمیل کد | دستورالعمل کد |

| CodeLlama-7b | خوب | خوب | N / A |

| CodeLlama-7b-Instruct | خوب | در حد متوسط | خوب |

| CodeLlama-7b-Python | خوب | N / A | N / A |

| CodeLlama-13b | خوب | خوب | N / A |

| CodeLlama-13b-Instruct | خوب | در حد متوسط | خوب |

| CodeLlama-13b-Python | خوب | N / A | N / A |

| CodeLlama-34b | خوب | N / A | N / A |

| CodeLlama-34b-Instruct | خوب | N / A | خوب |

| CodeLlama-34b-Python | خوب | N / A | N / A |

تولید کد

نمونههای زیر بر روی مدل CodeLlama-34b-Instruct با پارامترهای بارگذاری اجرا شدند "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

پر کردن کد

پر کردن کد شامل برگرداندن کد تولید شده با توجه به زمینه اطراف است. این با وظیفه تولید کد متفاوت است زیرا، علاوه بر یک بخش کد پیشوند، مدل با پسوند قطعه کد نیز ارائه می شود. در هنگام تنظیم دقیق از نشانه های ویژه برای علامت گذاری ابتدای پیشوند استفاده شد (<PRE>، ابتدای پسوند (<SUF>و ابتدای وسط (<MID>). دنباله های ورودی به مدل باید در یکی از قالب های زیر باشد:

- پیشوند-پسوند-وسط -

<PRE> {prefix} <SUF>{suffix} <MID> - پسوند-پیشوند-وسط -

<PRE> <SUF>{suffix} <MID> {prefix}

نمونههای زیر از فرمت پیشوند-پسوند-وسط در مدل CodeLlama-7b با بار استفاده میکنند. parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

دستورالعمل کد

متا همچنین یک نوع تنظیم شده با دستورالعمل Code Llama را ارائه کرد. پرس و جوهای نمونه در این بخش فقط می توانند برای این مدل های Code Llama تنظیم شده توسط دستورالعمل اعمال شوند، که مدل هایی با پسوند دستورالعمل ID مدل هستند. فرمت Code Llama برای دستورالعمل ها مانند قالب درخواست Llama-2-chat است که در ادامه به تفصیل آن می پردازیم. مدل های فونداسیون Llama 2 اکنون در SageMaker JumpStart در دسترس هستند

یک فرمان ساده کاربر ممکن است به شکل زیر باشد:

همچنین می توانید یک دستور سیستم با دستور زیر اضافه کنید:

در نهایت، میتوانید با قرار دادن تمام درخواستهای قبلی کاربر و پاسخهای دستیار در ورودی، با مدل تعامل مکالمهای داشته باشید:

این نمونهها بر روی مدل CodeLlama-13b-Instruct با پارامترهای بارگذاری «پارامترها» اجرا شدند: {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

پاک کردن

پس از اتمام اجرای نوت بوک، مطمئن شوید که تمام منابعی را که در این فرآیند ایجاد کرده اید حذف کرده اید تا صورتحساب شما متوقف شود. از کد زیر استفاده کنید:

نتیجه

در این پست، ما به شما نشان دادیم که چگونه با مدلهای Code Llama در SageMaker Studio شروع کنید و مدلی را برای تولید کد و زبان طبیعی در مورد کد از هر دو درخواست کد و زبان طبیعی به کار بگیرید. از آنجایی که مدل های فونداسیون از قبل آموزش دیده اند، می توانند به کاهش هزینه های آموزش و زیرساخت کمک کنند و سفارشی سازی را برای موارد استفاده شما امکان پذیر کنند. اکنون برای شروع به SageMaker JumpStart در SageMaker Studio مراجعه کنید.

منابع

درباره نویسندگان

گابریل سینایو یک مدیر تحقیقاتی در تیم تحقیقات هوش مصنوعی فیس بوک (FAIR) در متا است. قبل از متا، گابریل در تیم Emmanuel Dupoux در École Normale Supérieure در پاریس عضو فوق دکترا بود و بر روی مهندسی معکوس یادگیری زبان در نوزادان کار می کرد. گابریل دکترای خود را در مدل سازی بیزی که برای بازی های استراتژیک بلادرنگ استفاده می شود، از دانشگاه گرنوبل دریافت کرد.

گابریل سینایو یک مدیر تحقیقاتی در تیم تحقیقات هوش مصنوعی فیس بوک (FAIR) در متا است. قبل از متا، گابریل در تیم Emmanuel Dupoux در École Normale Supérieure در پاریس عضو فوق دکترا بود و بر روی مهندسی معکوس یادگیری زبان در نوزادان کار می کرد. گابریل دکترای خود را در مدل سازی بیزی که برای بازی های استراتژیک بلادرنگ استفاده می شود، از دانشگاه گرنوبل دریافت کرد.

عیسی جمیل یک مهندس شریک RL، هوش مصنوعی مولد در متا است.

عیسی جمیل یک مهندس شریک RL، هوش مصنوعی مولد در متا است.

دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

ویوک سینگ یک مدیر محصول با SageMaker JumpStart است. او بر روی توانمند ساختن مشتریان به SageMaker JumpStart تمرکز می کند تا سفر ML خود را برای ساختن برنامه های کاربردی هوش مصنوعی ساده و تسریع کنند.

ویوک سینگ یک مدیر محصول با SageMaker JumpStart است. او بر روی توانمند ساختن مشتریان به SageMaker JumpStart تمرکز می کند تا سفر ML خود را برای ساختن برنامه های کاربردی هوش مصنوعی ساده و تسریع کنند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/

- : دارد

- :است

- :نه

- :جایی که

- ][پ

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- ٪۱۰۰

- 16

- 24

- 28

- 30

- 36

- 500

- 7

- 700

- 8

- 9

- a

- درباره ما

- شتاب دادن

- پذیرفتن

- قابل قبول

- دسترسی

- اذعان

- اکتساب

- فعال

- اضافه کردن

- اضافه

- پس از

- در برابر

- توافق

- AI

- تحقیق ai

- الگوریتم

- معرفی

- در امتداد

- همچنین

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- an

- و

- و زیرساخت

- اعلام

- پاسخ

- هر

- کاربرد

- برنامه های کاربردی

- اعمال می شود

- مناسب

- هستند

- AS

- دستیار

- At

- خودکار

- در دسترس

- AWS

- پایه

- مستقر

- بر هم زدن

- بیزی

- BE

- زیرا

- بوده

- قبل از

- شروع

- شروع

- بهتر

- میان

- صدور صورت حساب

- بیلیون

- میلیارد توکن

- هر دو

- تفکیک

- ساختن

- بنا

- ساخته

- اما

- by

- ++C

- CAN

- توانا

- کارت

- چرخ فلک

- مورد

- CD

- تغییر دادن

- کاراکتر

- فرزندان

- را انتخاب کنید

- انتخاب

- کلاس

- کلیک

- رمز

- ستون

- بیا

- می آید

- تجاری

- کامپیوتر

- چشم انداز کامپیوتر

- رقیب

- همایش ها

- کنسول

- ظرف

- شامل

- محتوا

- زمینه

- زمینه ها

- کنترل

- گروه شاهد

- محاورهای

- هزینه

- پوشش

- ایجاد

- ایجاد شده

- خالق

- جاری

- مشتریان

- سفارشی سازی

- سفارشی

- داده ها

- امنیت داده ها

- روز

- اختصاصی

- به طور پیش فرض

- نسخه ی نمایشی

- گسترش

- مستقر

- استقرار

- گسترش

- مستقر می کند

- طراحی

- جزئیات

- جزئیات

- توسعه

- توسعه

- توسعه دهندگان

- پروژه

- تفاوت

- مختلف

- مدیر

- دایرکتوری

- كشف كردن

- do

- عمل

- انجام شده

- دانلود

- دوک

- دانشگاه دوک

- در طی

- هر

- پیش از آن

- شرق

- موثر

- قادر ساختن

- را قادر می سازد

- پایان

- پشت سر هم

- نقطه پایانی

- مهندس

- مهندسی

- انگلیسی

- اطمینان حاصل شود

- محیط

- اروپا

- حتی

- مثال

- مثال ها

- جز

- برانگیخته

- به استثنای

- نمایی

- گسترش

- فیس بوک

- کارخانه

- منصفانه

- غلط

- امکانات

- همکار

- کمی از

- فایل ها

- سرانجام

- پیدا کردن

- نام خانوادگی

- تمرکز

- به دنبال

- پیروی

- برای

- قالب

- پایه

- رایگان

- از جانب

- تابع

- بازیها

- تولید

- مولد

- نسل

- نسل ها

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- رفتن

- دادن

- داده

- Go

- خوب

- کردم

- در حال رشد

- راهنمایی

- بود

- دست

- آیا

- he

- کمک

- کمک

- کمک می کند

- اینجا کلیک نمایید

- زیاد

- بالاتر

- خود را

- میزبان

- چگونه

- چگونه

- HTML

- HTTPS

- قطب

- i

- ID

- دلخواه

- شناسه

- if

- ایلینوی

- نشان می دهد

- واردات

- بهبود

- ارتقاء

- in

- شامل

- از جمله

- شالوده

- ورودی

- ورودی

- نصب

- نصب و راه اندازی

- نمونه

- دستورالعمل

- یکپارچه

- اثر متقابل

- منافع

- رابط

- ایرلند

- جدا شده

- IT

- ITS

- جاوه

- جاوا اسکریپت

- سفر

- نگه داشته شد

- کلید

- کلید

- کایل

- فرود

- زبان

- بزرگ

- بزرگتر

- بزرگترین

- نام

- یادگیری

- ترک کرد

- طول

- اجازه

- مجوز

- پسندیدن

- محدود

- فهرست

- لیست

- پشم لاما

- LLM

- محلی

- منطق

- نگاه کنيد

- شبیه

- کاهش

- دستگاه

- فراگیری ماشین

- ساخته

- اکثریت

- ساخت

- ساخت

- مدیر

- مدیران

- بسیاری

- علامت

- بیشترین

- ممکن است..

- به معنی

- ذکر شده

- متا

- متوسط

- ML

- MLO ها

- مدل

- مدل سازی

- مدل

- اصلاح شده

- ماه

- بیش

- کارآمدتر

- باید

- طبیعی

- نیاز

- شبکه

- جدید

- گره

- گره

- هیچ

- دفتر یادداشت

- اکنون

- عدد

- of

- on

- پردازنده

- یک بار

- ONE

- فقط

- or

- سفارش

- اورگان

- دیگر

- خارج

- تولید

- روی

- بسته

- با ما

- جفت

- اوراق

- پارامترهای

- پاریس

- شریک

- عبور

- گذشت

- عبور می کند

- انجام

- کارایی

- دکترا

- پی اچ پی

- پینگ

- افلاطون

- هوش داده افلاطون

- PlatoData

- سیاست

- پست

- پتانسیل

- پیشگو

- آماده

- قبلی

- قبلا

- روند

- فرآیندهای

- محصول

- مدیر تولید

- بهره وری

- برنامه نويسي

- ارائه

- ارائه

- فراهم می کند

- منتشر شده

- پــایتــون

- کیفیت

- نمایش ها

- به سرعت

- تصادفی بودن

- زمان واقعی

- اخذ شده

- توصیه

- مراجعه

- اشاره دارد

- مناطق

- منتشر شد

- برداشتن

- حذف شده

- گزارش

- مخزن

- درخواست

- ضروری

- تحقیق

- پژوهشگر

- منابع

- پاسخ

- پاسخ

- نتیجه

- نتایج

- برگشت

- عودت

- بازده

- راست

- ریشه

- دویدن

- در حال اجرا

- s

- حکیم ساز

- همان

- ذخیره

- مقیاس پذیر

- دانشمند

- خط

- sdk

- جستجو

- جستجو

- ثانیه

- بخش

- امن

- تیم امنیت لاتاری

- بخش

- انتخاب شد

- انتخاب

- خود

- ارشد

- سلسله

- سرور

- خدمات

- تنظیم

- باید

- نشان

- نشان داد

- ساده

- ساده کردن

- پس از

- تنها

- اندازه

- اندازه

- So

- نرم افزار

- مزایا

- ویژه

- تخصصی

- خاص

- مشخص شده

- انشعاب

- پایدار

- شروع

- آغاز شده

- وضعیت هنر

- آماری

- مراحل

- متوقف شد

- استراتژی

- رشته

- استودیو

- موفقیت

- چنین

- مبالغ

- پشتیبانی

- پشتیبانی

- مطمئن

- اطراف

- نحو

- سیستم

- جدول

- کار

- وظایف

- تیم

- می گوید

- قوانین و مقررات

- متن

- نسبت به

- که

- La

- شان

- آنها

- سپس

- اینها

- آنها

- این

- اگر چه؟

- سه

- از طریق

- زمان

- سری زمانی

- به

- رمز

- نشانه

- ابزار

- بالا

- قطار

- آموزش دیده

- آموزش

- درخت

- درست

- امتحان

- دو

- نوع

- انواع

- حروفچینی

- ui

- زیر

- درک

- دانشگاه

- us

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- با استفاده از

- ارزش

- ارزشها

- نوع دیگر

- تنوع

- نسخه

- از طريق

- چشم انداز

- ویرجینیا

- ویزا

- دید

- بازدید

- بازدید

- راه رفتن

- بود

- مسیر..

- راه

- we

- وب

- خدمات وب

- مبتنی بر وب

- بود

- غرب

- چی

- چه شده است

- که

- وسیع

- اراده

- پنجره

- پنجره

- با

- در داخل

- کلمه

- کلمات

- مهاجرت کاری

- گردش کار

- کارگر

- نوشتن

- شما

- شما

- زفیرنت