امروز، ما مشتاقیم اعلام کنیم که مدل های فونداسیون Llama 2 که توسط متا توسعه داده شده اند، از طریق آن برای مشتریان در دسترس هستند. Amazon SageMaker JumpStart. خانواده مدلهای زبان بزرگ Llama 2 (LLMs) مجموعهای از مدلهای متنی تولیدی از پیش آموزشدیده و تنظیمشده است که در مقیاسی از ۷ میلیارد تا ۷۰ میلیارد پارامتر متغیر است. LLM های تنظیم شده به نام Llama-7-chat، برای موارد استفاده از گفتگو بهینه شده اند. میتوانید به راحتی این مدلها را امتحان کنید و با SageMaker JumpStart، که یک هاب یادگیری ماشین (ML) است که دسترسی به الگوریتمها، مدلها و راهحلهای ML را فراهم میکند، استفاده کنید تا بتوانید به سرعت با ML شروع کنید.

در این پست نحوه استفاده از مدل های Llama 2 از طریق SageMaker JumpStart را توضیح می دهیم.

لاما 2 چیست؟

Llama 2 یک مدل زبان رگرسیون خودکار است که از معماری ترانسفورماتور بهینه شده استفاده می کند. Llama 2 برای استفاده تجاری و تحقیقاتی به زبان انگلیسی در نظر گرفته شده است. این در طیف وسیعی از اندازههای پارامتر - 7 میلیارد، 13 میلیارد و 70 میلیارد - و همچنین تغییرات از پیش آموزشدیده و تنظیمشده است. به گفته متا، نسخههای تنظیمشده از تنظیم دقیق نظارت شده (SFT) و یادگیری تقویتی با بازخورد انسانی (RLHF) استفاده میکنند تا با ترجیحات انسان برای مفید بودن و ایمنی هماهنگ شوند. Llama 2 بر روی 2 تریلیون توکن داده از منابع در دسترس عموم از قبل آموزش داده شده بود. مدلهای تنظیمشده برای چت دستیار در نظر گرفته شدهاند، در حالی که مدلهای از پیش آموزشدیده را میتوان برای انواع وظایف تولید زبان طبیعی تطبیق داد. صرف نظر از اینکه توسعهدهنده از چه نسخهای از مدل استفاده میکند، راهنمای استفاده مسئولانه از متا می تواند به هدایت تنظیمات دقیق اضافی که ممکن است برای سفارشی سازی و بهینه سازی مدل ها با کاهش ایمنی مناسب لازم باشد کمک کند.

SageMaker JumpStart چیست؟

با SageMaker JumpStart، پزشکان ML میتوانند از میان مجموعه وسیعی از مدلهای پایه منبع باز انتخاب کنند. پزشکان ML می توانند مدل های پایه را به صورت اختصاصی به کار گیرند آمازون SageMaker نمونه هایی از یک محیط جدا شده از شبکه و سفارشی کردن مدل ها با استفاده از SageMaker برای آموزش و استقرار مدل.

اکنون میتوانید Llama 2 را با چند کلیک کشف و اجرا کنید Amazon SageMaker Studio یا به صورت برنامه نویسی از طریق SageMaker Python SDK، به شما امکان می دهد عملکرد مدل و کنترل های MLOps را با ویژگی های SageMaker مانند خطوط لوله آمازون SageMaker, دیباگر Amazon SageMaker، یا سیاهههای مربوط به کانتینر. این مدل در یک محیط امن AWS و تحت کنترل های VPC شما مستقر شده است و به اطمینان از امنیت داده ها کمک می کند. مدلهای Llama 2 امروز در Amazon SageMaker Studio، در ابتدا در دسترس هستند us-east 1 و us-west 2 مناطق.

مدل ها را کشف کنید

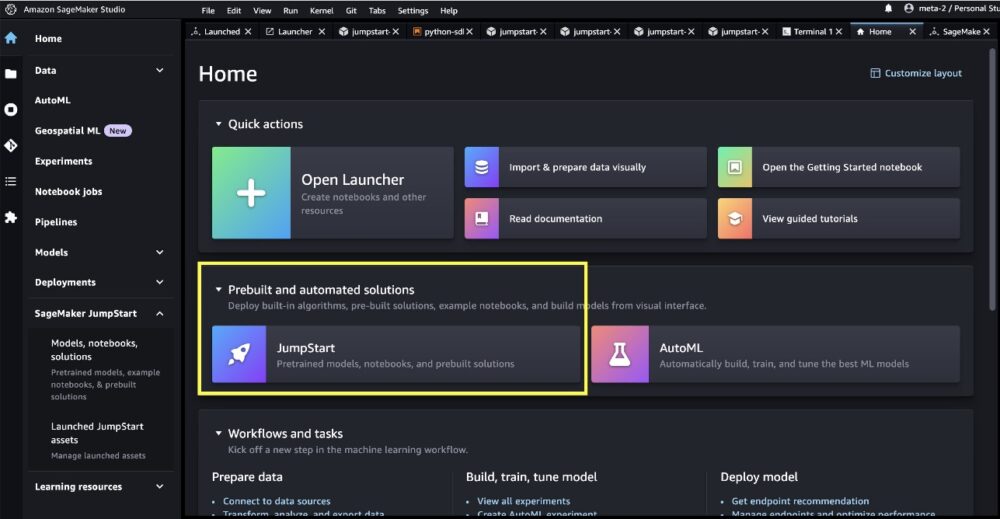

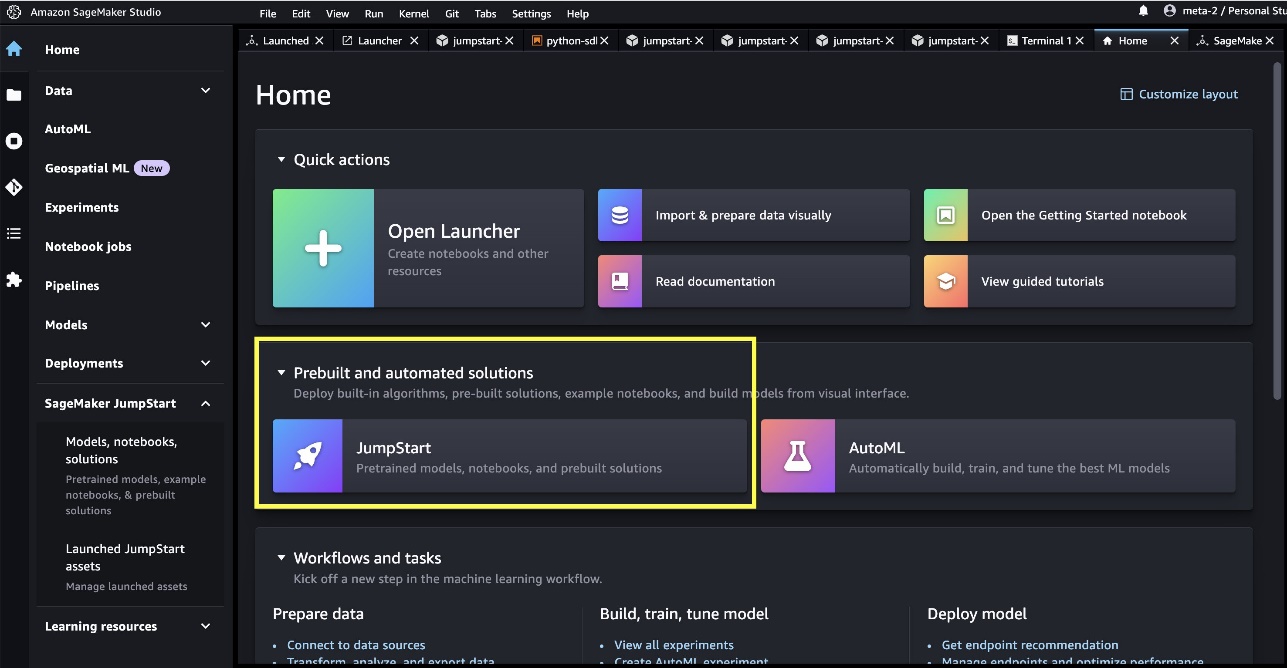

می توانید از طریق SageMaker JumpStart در SageMaker Studio UI و SageMaker Python SDK به مدل های پایه دسترسی داشته باشید. در این بخش به نحوه کشف مدل ها در SageMaker Studio می پردازیم.

SageMaker Studio یک محیط توسعه یکپارچه (IDE) است که یک رابط بصری مبتنی بر وب را فراهم می کند که در آن می توانید به ابزارهای ساخته شده برای انجام تمام مراحل توسعه ML، از آماده سازی داده ها تا ساخت، آموزش، و استقرار مدل های ML خود دسترسی داشته باشید. برای جزئیات بیشتر در مورد نحوه شروع و راه اندازی SageMaker Studio، مراجعه کنید Amazon SageMaker Studio.

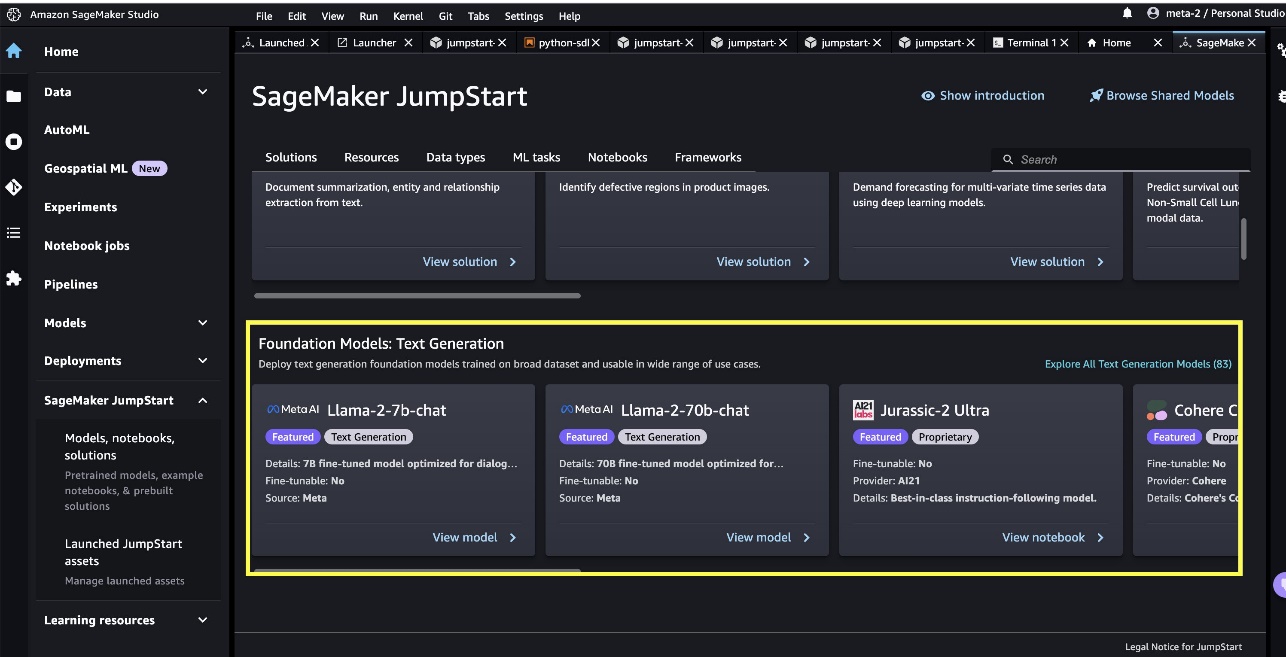

هنگامی که در استودیوی SageMaker هستید، می توانید به SageMaker JumpStart که شامل مدل های از پیش آموزش دیده، نوت بوک ها و راه حل های از پیش ساخته شده است، دسترسی پیدا کنید. راه حل های از پیش ساخته شده و خودکار.

از صفحه فرود SageMaker JumpStart، می توانید راه حل ها، مدل ها، نوت بوک ها و منابع دیگر را جستجو کنید. شما می توانید دو مدل پرچمدار Llama 2 را در آن بیابید مدل های پایه: تولید متن چرخ فلک. اگر مدلهای Llama 2 را نمیبینید، نسخه SageMaker Studio خود را با خاموش کردن و راهاندازی مجدد بهروزرسانی کنید. برای اطلاعات بیشتر در مورد به روز رسانی نسخه، مراجعه کنید برنامه های استودیو را خاموش و به روز کنید.

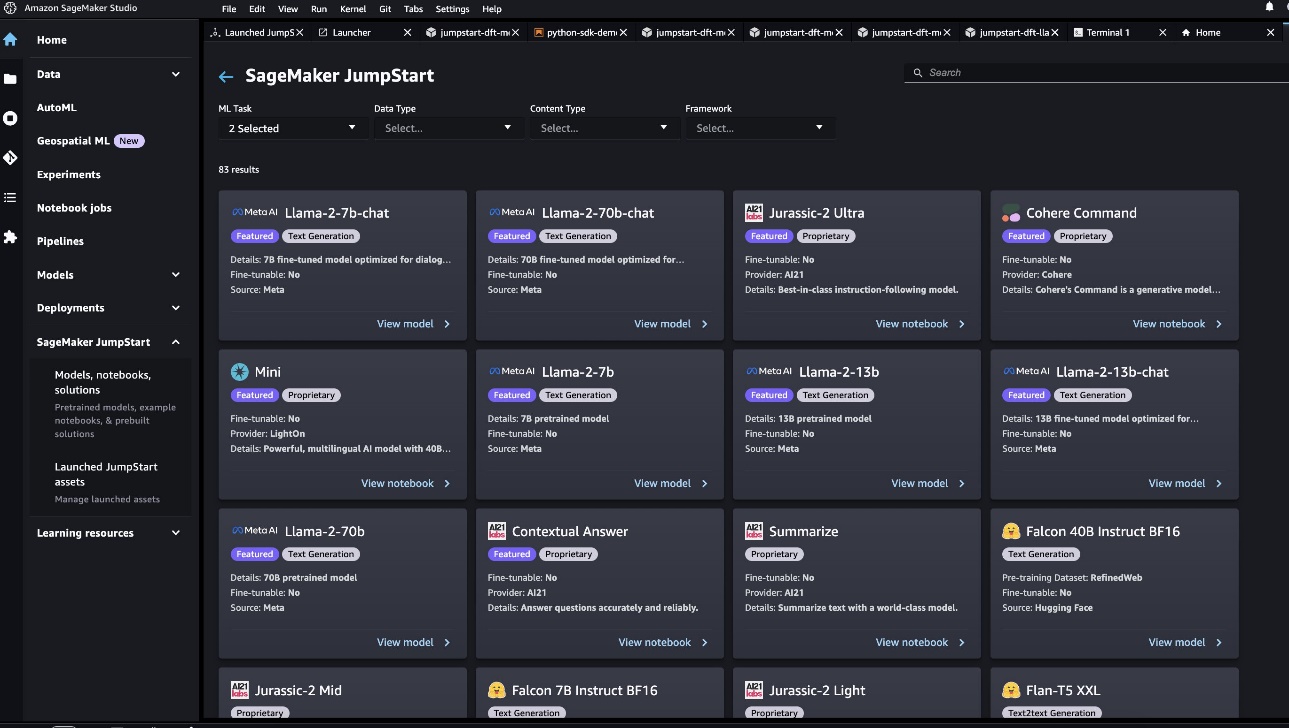

همچنین می توانید با انتخاب چهار مدل دیگر را بیابید تمام مدل های تولید متن را کاوش کنید یا جستجو برای llama در جعبه جستجو

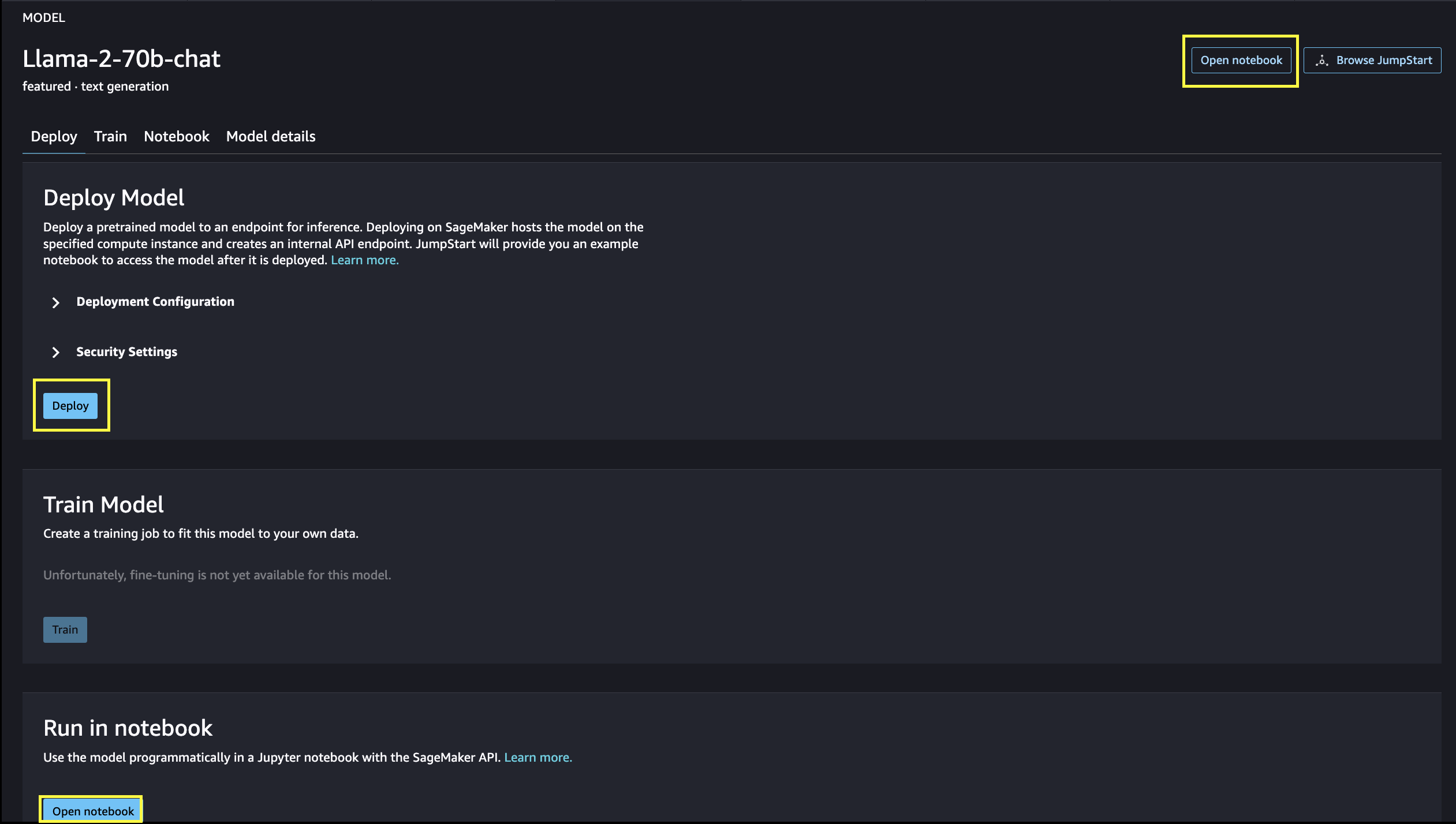

میتوانید کارت مدل را برای مشاهده جزئیات مدل مانند مجوز، دادههای مورد استفاده برای آموزش و نحوه استفاده انتخاب کنید. همچنین می توانید دو دکمه را پیدا کنید، گسترش و نوت بوک را باز کنید، که به شما در استفاده از مدل کمک می کند.

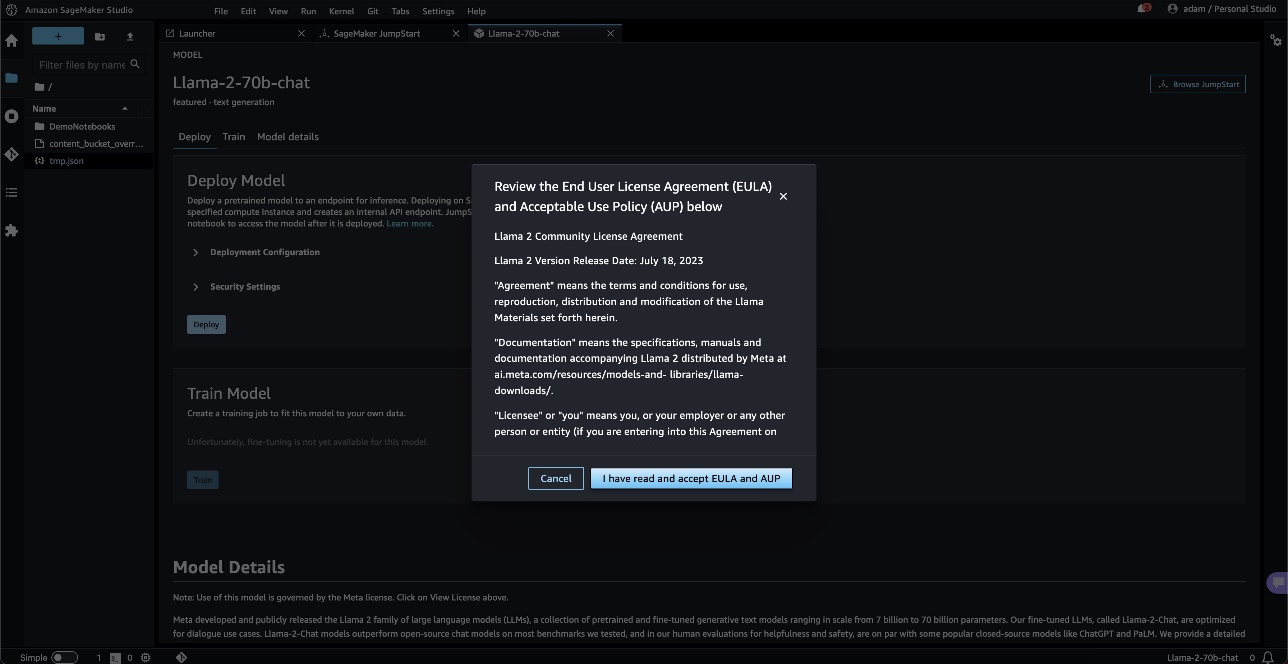

وقتی یکی از دکمهها را انتخاب میکنید، یک پنجره بازشو توافقنامه مجوز کاربر نهایی و خطمشی استفاده قابل قبول را برای تأیید شما نشان میدهد.

پس از تایید، برای استفاده از مدل به مرحله بعدی خواهید رفت.

یک مدل مستقر کنید

وقتی انتخاب کردید گسترش و شرایط را بپذیرید، استقرار مدل آغاز خواهد شد. همچنین، میتوانید از طریق دفترچه یادداشتی که با انتخاب نشان داده میشود، استفاده کنید نوت بوک را باز کنید. دفترچه یادداشت نمونه راهنمایی سرتاسری در مورد نحوه استقرار مدل برای استنتاج و پاکسازی منابع ارائه می دهد.

برای استقرار با استفاده از یک نوت بوک، با انتخاب یک مدل مناسب شروع می کنیم، مشخص شده توسط model_id. می توانید هر یک از مدل های انتخاب شده را با کد زیر در SageMaker مستقر کنید:

این مدل را در SageMaker با تنظیمات پیشفرض، از جمله نوع نمونه پیشفرض و تنظیمات پیشفرض VPC، مستقر میکند. شما می توانید این تنظیمات را با تعیین مقادیر غیر پیش فرض در آن تغییر دهید JumpStartModel. پس از استقرار، می توانید استنتاج را در برابر نقطه پایانی مستقر شده از طریق پیش بینی SageMaker اجرا کنید:

مدلهای چت با تنظیم دقیق (Llama-2-7b-chat، Llama-2-13b-chat، Llama-2-70b-chat) سابقه چت بین کاربر و دستیار چت را میپذیرند و گپ بعدی را ایجاد میکنند. مدلهای از پیش آموزشدیده شده (Llama-2-7b، Llama-2-13b، Llama-2-70b) به یک اعلان رشته نیاز دارند و تکمیل متن را در اعلان ارائه شده انجام میدهند. کد زیر را ببینید:

توجه داشته باشید که به طور پیش فرض، accept_eula روی false تنظیم شده است. باید تنظیم کنید accept_eula=true برای فراخوانی موفقیت آمیز نقطه پایانی با انجام این کار، موافقت نامه مجوز کاربر و خط مشی استفاده قابل قبول را همانطور که قبلا ذکر شد می پذیرید. شما همچنین می توانید دانلود قرارداد مجوز

Custom_attributes برای عبور EULA جفت های کلید/مقدار استفاده می شود. کلید و مقدار با جدا شده اند = و جفت ها توسط جدا می شوند ;. اگر کاربر یک کلید را بیش از یک بار ارسال کند، آخرین مقدار نگه داشته شده و به کنترل کننده اسکریپت ارسال می شود (یعنی در این مورد برای منطق شرطی استفاده می شود). به عنوان مثال، اگر accept_eula=false; accept_eula=true سپس به سرور ارسال می شود accept_eula=true نگه داشته می شود و به کنترل کننده اسکریپت منتقل می شود.

پارامترهای استنتاج فرآیند تولید متن را در نقطه پایانی کنترل می کنند. حداکثر کنترل توکن های جدید به اندازه خروجی تولید شده توسط مدل اشاره دارد. توجه داشته باشید که این عدد با تعداد کلمات یکسان نیست زیرا واژگان مدل با واژگان زبان انگلیسی یکسان نیست و هر نشانه ممکن است یک کلمه زبان انگلیسی نباشد. دما تصادفی بودن خروجی را کنترل می کند. دمای بالاتر منجر به خروجیهای خلاقانهتر و توهمآمیزتر میشود. تمام پارامترهای استنتاج اختیاری هستند.

جدول زیر تمام مدلهای Llama موجود در SageMaker JumpStart را به همراه مدلهای Llama فهرست میکند model_ids، انواع نمونه های پیش فرض و حداکثر تعداد توکن های کل (مجموع تعداد نشانه های ورودی و تعداد توکن های تولید شده) پشتیبانی شده برای هر یک از این مدل ها.

| نام مدل | شناسه مدل | حداکثر توکن ها | نوع نمونه پیش فرض |

| لاما-2-7b | meta-textgeneration-llama-2-7b | 4096 | ml.g5.2xlarge |

| Llama-2-7b-chat | meta-textgeneration-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| لاما-2-13b | meta-textgeneration-llama-2-13b | 4096 | ml.g5.12xlarge |

| Llama-2-13b-chat | meta-textgeneration-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| لاما-2-70b | meta-textgeneration-llama-2-70b | 4096 | ml.g5.48xlarge |

| Llama-2-70b-chat | meta-textgeneration-llama-2-70b-f | 4096 | ml.g5.48xlarge |

توجه داشته باشید که نقاط پایانی SageMaker دارای محدودیت زمانی 60 ثانیه هستند. بنابراین، حتی اگر مدل بتواند 4096 توکن تولید کند، اگر تولید متن بیش از 60 ثانیه طول بکشد، درخواست با شکست مواجه خواهد شد. برای مدلهای 7B، 13B و 70B، توصیه میکنیم تنظیم کنید max_new_tokens به ترتیب از 1500، 1000 و 500 بیشتر نباشد، در حالی که تعداد کل توکن ها کمتر از 4K باشد.

استنباط و دستورهای مثال برای Llama-2-70b

می توانید از مدل های Llama برای تکمیل متن برای هر قطعه متنی استفاده کنید. از طریق تولید متن، می توانید وظایف مختلفی مانند پاسخ به سؤالات، ترجمه زبان، تجزیه و تحلیل احساسات و بسیاری موارد دیگر را انجام دهید. بار ورودی به نقطه پایانی شبیه کد زیر است:

در زیر چند نمونه از دستورات و متن تولید شده توسط مدل آمده است. تمام خروجی ها با پارامترهای استنتاج تولید می شوند {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

در مثال بعدی، نحوه استفاده از مدلهای Llama را با یادگیری درون متنی چند شات نشان میدهیم، جایی که نمونههای آموزشی در دسترس مدل را ارائه میکنیم. توجه داشته باشید که ما فقط روی مدل مستقر شده استنباط می کنیم و در طول این فرآیند وزن مدل تغییر نمی کند.

استنباط و درخواست های مثال برای Llama-2-70b-chat

با مدلهای Llama-2-Chat، که برای موارد استفاده از گفتگو بهینه شدهاند، ورودی به نقاط پایانی مدل چت، سابقه قبلی بین دستیار چت و کاربر است. شما می توانید سوالاتی را در زمینه مکالمه ای که تاکنون اتفاق افتاده است بپرسید. همچنین میتوانید پیکربندی سیستم را ارائه دهید، مانند شخصیتهایی که رفتار دستیار چت را تعریف میکنند. بار ورودی به نقطه پایانی شبیه کد زیر است:

در زیر چند نمونه از دستورات و متن تولید شده توسط مدل آمده است. همه خروجی ها با پارامترهای استنتاج تولید می شوند {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

در مثال زیر، کاربر با دستیار در مورد مکان های گردشگری در پاریس گفتگو کرده است. در مرحله بعد، کاربر در مورد اولین گزینه توصیه شده توسط دستیار چت پرس و جو می کند.

در مثال های زیر، پیکربندی سیستم را تنظیم می کنیم:

پاک کردن

پس از اتمام اجرای نوت بوک، مطمئن شوید که همه منابع را حذف کرده اید تا همه منابعی که در این فرآیند ایجاد کرده اید حذف شده و صورتحساب شما متوقف شود:

نتیجه

در این پست نحوه شروع کار با مدل های Llama 2 را در استودیو SageMaker به شما نشان دادیم. با این کار، شما به شش مدل فونداسیون Llama 2 که حاوی میلیاردها پارامتر هستند دسترسی دارید. از آنجایی که مدل های فونداسیون از قبل آموزش دیده اند، می توانند به کاهش هزینه های آموزش و زیرساخت نیز کمک کنند و سفارشی سازی را برای موارد استفاده شما امکان پذیر کنند. برای شروع کار با SageMaker JumpStart، از منابع زیر دیدن کنید:

درباره نویسندگان

ژوئن برد یک مدیر محصول با SageMaker JumpStart است. او بر روی ساخت مدل های پایه به راحتی قابل کشف و استفاده برای کمک به مشتریان در ساخت برنامه های کاربردی هوش مصنوعی تمرکز دارد. تجربه او در آمازون همچنین شامل اپلیکیشن خرید موبایلی و تحویل آخرین مایل است.

ژوئن برد یک مدیر محصول با SageMaker JumpStart است. او بر روی ساخت مدل های پایه به راحتی قابل کشف و استفاده برای کمک به مشتریان در ساخت برنامه های کاربردی هوش مصنوعی تمرکز دارد. تجربه او در آمازون همچنین شامل اپلیکیشن خرید موبایلی و تحویل آخرین مایل است.

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.  دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.  دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.  ساندار رانگاناتان رئیس جهانی متخصصان GenAI/Frameworks GTM در AWS است. او بر توسعه استراتژی GTM برای مدلهای زبان بزرگ، GenAI و بارهای کاری ML در مقیاس بزرگ در سرویسهای AWS مانند Amazon EC2، EKS، EFA، AWS Batch و Amazon SageMaker تمرکز میکند. تجربه او شامل نقش های رهبری در مدیریت محصول و توسعه محصول در NetApp، Micron Technology، Qualcomm و Mentor Graphics است.

ساندار رانگاناتان رئیس جهانی متخصصان GenAI/Frameworks GTM در AWS است. او بر توسعه استراتژی GTM برای مدلهای زبان بزرگ، GenAI و بارهای کاری ML در مقیاس بزرگ در سرویسهای AWS مانند Amazon EC2، EKS، EFA، AWS Batch و Amazon SageMaker تمرکز میکند. تجربه او شامل نقش های رهبری در مدیریت محصول و توسعه محصول در NetApp، Micron Technology، Qualcomm و Mentor Graphics است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 10

- 100

- 11

- 13

- ٪۱۰۰

- 17

- 19

- 20

- 30

- 31

- 33

- 360 درجه

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- قادر

- درباره ما

- پذیرفتن

- قابل قبول

- دسترسی

- دسترسی

- در دسترس

- مطابق

- اذعان

- در میان

- فعال

- اضافه کردن

- اضافه کردن

- اضافی

- نشانی

- پس از

- از نو

- در برابر

- توافق

- AI

- الگوریتم

- الگوریتم

- تراز

- معرفی

- اجازه دادن

- در امتداد

- همچنین

- همیشه

- am

- آمازون

- آمازون EC2

- آمازون SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- آمازون خدمات وب

- امریکایی

- an

- تحلیل

- و

- و زیرساخت

- اعلام

- دیگر

- پاسخ

- هر

- هر کس

- کاربرد

- برنامه های کاربردی

- اعمال می شود

- قدردانی

- مناسب

- کمان

- معماری

- هستند

- هنر

- AS

- همکاری

- دستیار

- At

- جو

- جاذبه

- خودکار

- در دسترس

- AWS

- موز

- اساسی

- نبرد

- بیزی

- BE

- خوشگل

- زیبایی

- شد

- زیرا

- شدن

- بوده

- آبجو

- قبل از

- رفتار

- پکن

- باور

- اعتقاد بر این

- بهترین

- میان

- صدور صورت حساب

- بیلیون

- میلیاردها

- سیاه پوست

- جعبه

- شکستن

- نفس گیر

- پهن

- ساختن

- بنا

- ساخته

- اما

- دکمه

- by

- نام

- CAN

- سرمایه

- ماشین

- کارت

- چرخ فلک

- مورد

- موارد

- CAT

- تغییر دادن

- شکلات

- را انتخاب کنید

- انتخاب

- شهر:

- کلاسیک

- رمز

- مجموعه

- ترکیب شده

- ترکیب

- می آید

- آینده

- تجاری

- شرکت

- اتمام

- کامپیوتر

- چشم انداز کامپیوتر

- همایش ها

- مطمئن

- پیکر بندی

- در نظر گرفته

- ثابت

- ساخت و ساز

- شامل

- ظرف

- شامل

- محتوا

- متنی

- ادامه دادن

- به طور مداوم

- کنترل

- گروه شاهد

- مناسب

- گفتگو

- هزینه

- کشور

- شجاعت

- پوشش

- ایجاد

- ایجاد شده

- خالق

- فرهنگی

- فرهنگ

- فنجان

- مشتریان

- سفارشی سازی

- سفارشی

- داده ها

- امنیت داده ها

- اختصاصی

- فداکاری

- به طور پیش فرض

- تعريف كردن

- تحویل

- گسترش

- مستقر

- استقرار

- گسترش

- مستقر می کند

- طرح

- طراحی

- مطلوب

- مقصد

- مقصدهای

- جزئیات

- توسعه

- توسعه

- توسعه دهنده

- در حال توسعه

- پروژه

- گفتگو

- تفاوت

- مختلف

- مشکل

- كشف كردن

- متمایز

- do

- فیلم های مستند

- عمل

- انجام شده

- آیا

- مضاعف

- پایین

- دوک

- دانشگاه دوک

- در طی

- e

- هر

- پیش از آن

- به آسانی

- ساده

- ادوارد

- انیشتین

- هر دو

- پست الکترونیک

- قادر ساختن

- را قادر می سازد

- پایان

- پشت سر هم

- نقطه پایانی

- مهندسی

- انگلیسی

- لذت بردن

- کافی

- اطمینان حاصل شود

- محیط

- تجهیزات

- اتر

- حتی

- حوادث

- هر کس

- مثال

- مثال ها

- برانگیخته

- تجربه

- تجربه

- آزمایش

- صریح

- FAIL

- ناموفق

- منصفانه

- غلط

- خانواده

- معروف

- بسیار

- شاهکار

- ویژه

- امکانات

- باز خورد

- پا

- کمی از

- فیلم

- نهایی

- سرانجام

- پیدا کردن

- نام خانوادگی

- کشتی دریادار

- شناور

- جریانها

- تمرکز

- پیروی

- برای

- به جلو

- یافت

- پایه

- چهار

- فرانسه

- فرانسوی

- از جانب

- کاملا

- بیشتر

- آینده

- سوالات عمومی

- تولید می کنند

- تولید

- نسل

- مولد

- هوش مصنوعی مولد

- گرجستان

- دریافت کنید

- دادن

- شیشه

- جهانی

- Go

- رفتن

- گرافیک

- بزرگ

- بیشتر

- پیشگامانه

- شدن

- راهنمایی

- راهنمایی

- بود

- دستگیره

- اتفاق افتاده است

- خوشحال

- سخت

- کار سخت

- آیا

- داشتن

- he

- سر

- کمک

- کمک

- کمک می کند

- اینجا کلیک نمایید

- hi

- زیاد

- بالاتر

- خود را

- تاریخی

- تاریخ

- مسکن

- چگونه

- چگونه

- HTML

- HTTPS

- قطب

- انسان

- i

- یاد

- اندیشه

- if

- ii

- ایلینوی

- تأثیر

- واردات

- مهم

- موثر

- in

- شامل

- شامل

- از جمله

- ادغام شده

- اطلاعات

- شالوده

- در ابتدا

- ورودی

- الهام بخش

- الهام بخش

- نمونه

- فورا

- دستورالعمل

- یکپارچه

- مورد نظر

- منافع

- رابط

- به

- جدا شده

- IT

- ITS

- سفر

- JPG

- تنها

- نگهداری

- نگه داشته شد

- کلید

- نوع

- دانستن

- شناخته شده

- فرود

- نقطه ی عطف بود

- زبان

- بزرگ

- در مقیاس بزرگ

- بزرگترین

- نام

- دیر

- راه اندازی

- قوانین

- رهبری

- یاد گرفتن

- یاد بگیرید و رشد کنید

- یادگیری

- کمترین

- کمتر

- سطح

- مجوز

- زندگی

- سبک

- پسندیدن

- محدود

- لیست

- ادبیات

- ll

- پشم لاما

- منطق

- طولانی

- مدت زمان طولانی

- به دنبال

- مطالب

- عشق

- محبوب

- کاهش

- دستگاه

- فراگیری ماشین

- ساخته

- ساخت

- باعث می شود

- ساخت

- مدیریت

- مدیر

- بسیاری

- تعجب

- ماده

- بیشترین

- ممکن است..

- معنی

- اندازه

- رسانه ها

- متوسط

- ذکر شده

- پیام

- متا

- میکرون

- دقیقه

- دقیقه

- مخلوط

- ML

- MLO ها

- موبایل

- مدل

- مدل

- لحظه

- ماه

- بیش

- اکثر

- محبوبترین

- حرکت

- سینما

- بسیار

- موزه

- موزه ها

- موسیقی

- نام

- طبیعی

- لازم

- نیاز

- ضروری

- شبکه

- جدید

- نیویورک

- بعد

- نه

- دفتر یادداشت

- اکنون

- عدد

- متعدد

- NY

- of

- ارائه

- ارائه

- پیشنهادات

- نفت

- on

- یک بار

- ONE

- فقط

- باز کن

- منبع باز

- بهینه سازی

- بهینه

- گزینه

- or

- دیگر

- دیگران

- در غیر این صورت

- ما

- خارج

- تولید

- روی

- به طور کلی

- با ما

- جفت

- مقاله

- اوراق

- پارامتر

- پارامترهای

- پاریس

- بخش

- عبور

- گذشت

- عبور می کند

- گذشته

- صلح

- انجام

- کارایی

- دائمي

- تلفن

- عکس

- فیزیک

- قطعه

- پیتزا

- پلاستیک

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- سیاست

- پاپ آپ

- محبوب

- پست

- پست الکترونیکی

- پیشگو

- تنظیمات

- آماده

- در حال حاضر

- قبلی

- روند

- فرآیندهای

- محصول

- توسعه محصول

- مدیریت تولید

- مدیر تولید

- پیشنهادات

- مغرور

- ارائه

- ارائه

- فراهم می کند

- ارائه

- عمومی

- حمل و نقل عمومی

- عمومی

- منتشر شده

- هدف

- قرار دادن

- پــایتــون

- کوالکام

- سوالات

- سریع

- به سرعت

- رمپ

- تصادفی بودن

- محدوده

- اعم

- اماده

- دلایل

- گرفتن

- دستور العمل

- توصیه

- توصیه می شود

- اشاره دارد

- بدون در نظر گرفتن

- مناطق

- نسبی

- نسبیت

- مکرر

- نشان دادن

- درخواست

- نیاز

- تحقیق

- پژوهشگر

- منابع

- به ترتیب

- پاسخ

- REST

- نتیجه

- نتایج

- رودخانه

- نقش

- نقش

- دویدن

- در حال اجرا

- s

- ایمنی

- حکیم ساز

- نمک

- همان

- مقیاس پذیر

- مقیاس

- دانشمند

- دانشمندان

- sdk

- SEA

- جستجو

- جستجو

- بخش

- امن

- تیم امنیت لاتاری

- دیدن

- مشاهده

- به نظر می رسید

- انتخاب شد

- انتخاب

- انتخاب

- ارسال

- ارشد

- احساس

- سلسله

- خدمات

- خدمت

- تنظیم

- محیط

- شکل

- کوسه ماهی

- خريد كردن

- باید

- نشان

- نشان داد

- نشان می دهد

- بستن

- اهمیت

- قابل توجه

- ساده

- به سادگی

- تنها

- سایت

- سایت

- شش

- اندازه

- به آرامی

- کوچک

- So

- تا حالا

- آگاهی

- رسانه های اجتماعی

- مزایا

- برخی از

- منبع

- منابع

- ویژه

- متخصصان

- مشخص شده

- سرعت

- می ایستد

- شروع

- آغاز شده

- دولت

- ایالات

- آماری

- گام

- مراحل

- متوقف شد

- استراتژی

- رشته

- ساختار

- استودیو

- خیره کننده

- موضوع

- متعاقب

- موفقیت

- موفقیت

- چنین

- پشتیبانی

- مطمئن

- نماد

- سیستم

- جدول

- گرفتن

- طول می کشد

- وظایف

- طعم

- تیم

- فن آوری

- پیشرفته

- موقت

- قوانین و مقررات

- نسبت به

- با تشکر

- که

- La

- پایتخت

- آینده

- منبع

- جهان

- شان

- آنها

- نظریه

- آنجا.

- اینها

- آنها

- اشیاء

- فکر می کنم

- این

- اگر چه؟

- از طریق

- ببر

- زمان

- سری زمانی

- بار

- عنوان

- به

- امروز

- با هم

- رمز

- نشانه

- ابزار

- بالا

- جمع

- برج

- قطار

- آموزش

- ترانسفورماتور

- ترجمه کردن

- ترجمه

- حمل و نقل

- تریلیون

- امتحان

- دو

- نوع

- انواع

- ui

- زیر

- فراموش نشدنی

- منحصر به فرد

- دانشگاه

- تا

- بروزرسانی

- به روز رسانی

- قابل استفاده

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- کاربران

- استفاده

- با استفاده از

- ارزش

- ارزشها

- تنوع

- نسخه

- نسخه

- بسیار

- از طريق

- چشم انداز

- نمایش ها

- دید

- بازدید

- بازدید کنندگان

- حجم

- خواسته

- جنگ

- بود

- we

- وب

- خدمات وب

- مبتنی بر وب

- سایت اینترنتی

- خوب

- نهنگ

- چی

- چه شده است

- چه زمانی

- در حالیکه

- که

- در حین

- چرا

- اراده

- پنجره

- با

- کلمه

- کلمات

- مهاجرت کاری

- با این نسخهها کار

- جهان

- مشهور جهان

- بسته بندی کردن

- سال

- نیویورک

- شما

- شما

- خودت

- زفیرنت

- زیپ