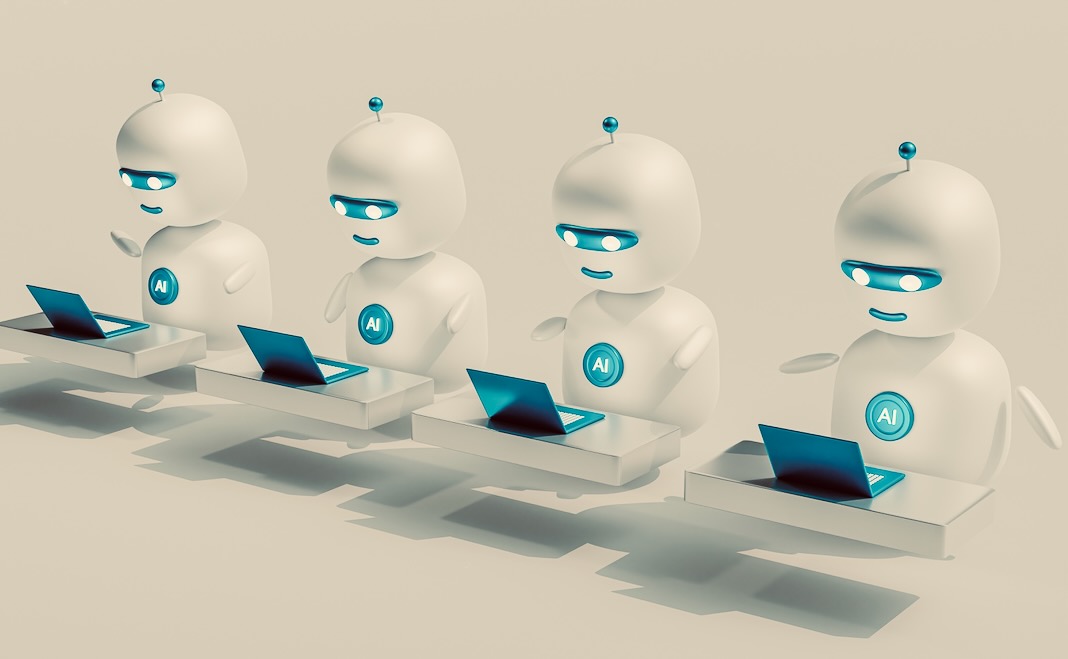

هوش مصنوعی به سرعت در حال توسعه است. ChatGPT تبدیل شده است سریعترین رشد سرویس آنلاین در تاریخ. گوگل و مایکروسافت در حال ادغام هوش مصنوعی مولد در محصولات خود هستند. و رهبران جهان با هیجان از هوش مصنوعی به عنوان ابزاری برای رشد اقتصادی استقبال می کنند.

همانطور که از ChatGPT و Bard فراتر می رویم، احتمالاً شاهد خواهیم بود که چت ربات های هوش مصنوعی کمتر عمومی و تخصصی تر می شوند. هوش مصنوعی توسط دادههایی که در معرض آنها قرار میگیرند محدود میشوند تا آنها را در کاری که انجام میدهند بهتر کنند - در این مورد، تقلید از گفتار انسان و ارائه پاسخهای مفید به کاربران.

آموزش اغلب شبکه را پهن می کند، با سیستم های هوش مصنوعی که هزاران کتاب و صفحه وب را جذب می کند. اما مجموعه ای انتخابی تر و متمرکزتر از داده های آموزشی می تواند چت ربات های هوش مصنوعی را برای افرادی که در صنایع خاصی کار می کنند یا در مناطق خاصی زندگی می کنند مفیدتر کند.

ارزش داده ها

یک عامل مهم در این تکامل، هزینههای فزاینده جمعآوری دادههای آموزشی برای مدلهای پیشرفته زبان بزرگ (LLM) خواهد بود، نوع هوش مصنوعی که ChatGPT را تقویت میکند. شرکتها میدانند دادهها ارزشمند هستند: متا و گوگل میلیاردها دلار از فروش تبلیغاتی که با دادههای کاربر هدفگذاری شدهاند به دست میآورند. اما ارزش داده ها اکنون است متغیر. متا و گوگل اطلاعات «بینش» را می فروشند. آنها در تجزیه و تحلیل سرمایه گذاری می کنند تا بسیاری از نقاط داده را به پیش بینی در مورد کاربران تبدیل کنند.

دادهها برای OpenAI - توسعهدهنده ChatGPT - به روشی کاملاً متفاوت ارزشمند هستند. یک توییت را تصور کنید: "گربه روی تشک نشست." این توییت برای تبلیغ کنندگان هدف ارزشی ندارد. در مورد یک کاربر یا علایق آنها اطلاعات کمی دارد. شاید با یک فشار، علاقه به غذای گربه و دکتر سوس را نشان دهد.

اما برای OpenAI، که در حال ساخت LLM برای تولید زبانی شبیه انسان است، این توییت به عنوان نمونه ای از نحوه عملکرد زبان انسانی ارزشمند است. یک توییت نمیتواند به هوش مصنوعی جملات را بیاموزد، اما میلیاردها توییت، پست وبلاگ، مدخلهای ویکیپدیا و غیره مطمئناً میتوانند. به عنوان مثال، LLM GPT-4 پیشرفته احتمالاً با استفاده از داده های خراشیده شده از X (توئیتر سابق)، Reddit، ویکی پدیا و موارد دیگر ساخته شده است.

انقلاب هوش مصنوعی در حال تغییر مدل کسب و کار برای سازمان های غنی از داده است. شرکت هایی مانند متا و گوگل بوده اند سرمایه گذاری در تحقیق و توسعه هوش مصنوعی چندین سال است که آنها سعی می کنند از منابع داده خود بهره برداری کنند.

شرکتها و سازمانها مثل X و ق شروع به دریافت هزینه از اشخاص ثالث برای دسترسی به API کرده اند، سیستمی که برای حذف داده ها از این وب سایت ها استفاده می شود. خراش داده ها برای شرکت هایی مانند X هزینه دارد باید برای توان محاسباتی بیشتر هزینه کرد برای انجام پرس و جوهای داده

با حرکت رو به جلو، از آنجایی که سازمانهایی مانند OpenAI به دنبال ساخت نسخههای قدرتمندتر از مدلهای GPT خود هستند، با هزینههای بیشتری برای دستیابی به دادهها مواجه خواهند شد. یک راه حل برای این مشکل ممکن است داده های مصنوعی باشد.

رفتن مصنوعی

داده های مصنوعی است از ابتدا توسط سیستم های هوش مصنوعی ایجاد شده است برای آموزش سیستمهای هوش مصنوعی پیشرفتهتر - به طوری که آنها بهبود پیدا کنند. آنها برای انجام وظایف مشابه داده های آموزشی واقعی طراحی شده اند، اما توسط هوش مصنوعی تولید می شوند.

این یک ایده جدید است، اما با مشکلات زیادی روبرو است. داده های مصنوعی خوب باید باشد به اندازه کافی با داده های اصلی متفاوت است بر اساس این است که به مدل چیز جدیدی بگوید، در حالی که به اندازه کافی شبیه به آن است که چیزی دقیق به آن بگوید. دستیابی به این امر می تواند دشوار باشد. جایی که داده های مصنوعی هستند فقط کپی های قانع کننده از داده های دنیای واقعی، مدل های هوش مصنوعی حاصل ممکن است با خلاقیت دست و پنجه نرم کنند و تعصبات موجود را تقویت کنند.

مشکل دیگر این است که مشکل هاپسبورگ AI. این نشان میدهد که آموزش هوش مصنوعی بر روی دادههای مصنوعی باعث کاهش اثربخشی این سیستمها میشود - از این رو این قیاس با استفاده از همخونی بدنام خانواده سلطنتی هاپسبورگ انجام میشود. برخی مطالعات نشان می دهد که این در حال حاضر با سیستم هایی مانند ChatGPT اتفاق می افتد.

یکی از دلایل خوب بودن ChatGPT این است که از آن استفاده می کند یادگیری تقویتی با بازخورد انسانی (RLHF)، که در آن افراد خروجی های آن را از نظر دقت ارزیابی می کنند. اگر داده های مصنوعی تولید شده توسط یک هوش مصنوعی نادرست باشد، مدل های هوش مصنوعی آموزش داده شده بر روی این داده ها خود نادرست خواهند بود. بنابراین تقاضا برای بازخورد انسانی برای اصلاح این نادرستی ها احتمالا افزایش می یابد.

با این حال، در حالی که بیشتر مردم میتوانند بگویند که آیا یک جمله از نظر گرامری دقیق است یا خیر، تعداد کمتری میتوانند درباره صحت واقعی آن اظهار نظر کنند - بهویژه زمانی که خروجی آن فنی یا تخصصی باشد. خروجی های نادرست در مورد موضوعات تخصصی کمتر توسط RLHF دستگیر می شوند. اگر داده های مصنوعی به این معنی باشد که نادرستی های بیشتری برای گرفتن وجود دارد، کیفیت LLM های همه منظوره ممکن است متوقف شود یا کاهش یابد، حتی اگر این مدل ها بیشتر یاد بگیرند.

مدل های زبان کوچک

این مشکلات به توضیح برخی از روندهای نوظهور در هوش مصنوعی کمک می کند. مهندسان گوگل فاش کردهاند که افراد ثالث مانع از این کار نمیشوند بازآفرینی LLM ها مانند GPT-3 یا هوش مصنوعی LaMDA گوگل. بسیاری از سازمان ها می توانند سیستم های هوش مصنوعی داخلی خود را با استفاده از داده های تخصصی خود برای اهداف خود بسازند. اینها احتمالاً در دراز مدت برای این سازمان ها از ChatGPT ارزشمندتر خواهند بود.

اخیراً، دولت ژاپن خاطرنشان کرد که در حال توسعه a نسخه ژاپن محور ChatGPT به طور بالقوه برای استراتژی هوش مصنوعی آنها ارزشمند است، زیرا ChatGPT به اندازه کافی نماینده ژاپن نیست. شرکت نرم افزار SAP اخیرا "نقشه راه" هوش مصنوعی خود را راه اندازی کرده است. ارائه قابلیت های توسعه هوش مصنوعی به سازمان های حرفه ای. این کار ساختن نسخههای سفارشی ChatGPT را برای شرکتها آسانتر میکند.

مشاوره هایی مانند مک کینزی و KPMG در حال کاوش در آموزش مدل های هوش مصنوعی برای "مقادیر خاص" هستند. راهنمایی در مورد چگونگی نسخه های خصوصی و شخصی ChatGPT را ایجاد کنید را می توان به راحتی آنلاین پیدا کرد. سیستم های متن باز، مانند GPT4All، از قبل موجود است.

از آنجایی که چالشهای توسعه - همراه با موانع نظارتی بالقوه - برای LLMهای عمومی افزایش مییابد، این امکان وجود دارد که آینده هوش مصنوعی بسیاری از مدلهای زبان کوچک و نه بزرگ باشد. اگر مدلهای زبانی کوچک با دادههای کمتری نسبت به سیستمهایی مانند GPT-4 آموزش ببینند، ممکن است مشکل داشته باشند.

اما ممکن است از نظر RLHF نیز مزیتی داشته باشند، زیرا احتمالاً مدلهای زبان کمی برای اهداف خاص توسعه مییابند. کارمندانی که دانش تخصصی از سازمان خود و اهداف آن دارند، ممکن است در مقایسه با بازخورد عمومی برای یک سیستم هوش مصنوعی عمومی، بازخورد بسیار ارزشمندتری برای چنین سیستمهای هوش مصنوعی ارائه دهند. این ممکن است بر معایب داده های کمتر غلبه کند.

این مقاله از مجله منتشر شده است گفتگو تحت مجوز Creative Commons دفعات بازدید: مقاله.

تصویر های اعتباری: محمد نوحسی / می Unsplash

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://singularityhub.com/2023/10/01/why-well-see-fewer-generic-ai-chatbots-like-chatgpt-in-the-future/

- : دارد

- :است

- :نه

- :جایی که

- a

- قادر

- درباره ما

- بالاتر

- AC

- دسترسی

- دقت

- دقیق

- رسیدن

- کسب

- پیشرفته

- مزیت - فایده - سود - منفعت

- تبلیغ

- پس از

- AI

- مدل های هوش مصنوعی

- تحقیق ai

- استراتژی AI

- سیستم های هوش مصنوعی

- قبلا

- همچنین

- جمع کردن

- an

- علم تجزیه و تحلیل

- و

- پاسخ

- هر

- API

- دسترسی به API

- هستند

- مناطق

- مقاله

- AS

- At

- Axios

- مستقر

- BE

- زیرا

- شدن

- بوده

- شروع شد

- در زیر

- دزدگیر

- بهتر

- خارج از

- تعصبات

- میلیاردها

- کتاب

- ساختن

- بنا

- ساخته

- کسب و کار

- مدل کسب و کار

- اما

- دکمه

- by

- CAN

- نمی توان

- قابلیت های

- مورد

- CAT

- کشتی

- گرفتار

- علت

- معین

- قطعا

- متغیر

- بار

- chatbots

- GPT چت

- کلیک

- CNBC

- CO

- رمز

- جمع آوری

- COM

- توضیح

- مردم عادی

- شرکت

- شرکت

- مقایسه

- محاسبه

- ساختن

- گفتگو

- اصلاح

- هزینه

- میتوانست

- مقابله با

- خالق

- خلاقیت

- اعتبار

- داده ها

- نقاط داده

- کاهش

- تقاضا

- طراحی

- توسعه

- توسعه دهنده

- در حال توسعه

- پروژه

- مختلف

- مشکل

- do

- میکند

- دان

- dr

- آسان تر

- اقتصادی

- رشد اقتصادی

- اثر

- در آغوش گرفتن

- سنگ سنباده

- کارکنان

- پایان

- مورد تأیید

- کافی

- حتی

- تکامل

- مثال

- وجود داشته باشد

- موجود

- کارشناس

- توضیح دهید

- بهره برداری

- بررسی

- قرار گرفتن در معرض

- چهره

- چهره ها

- عامل

- خانواده

- باز خورد

- کمتر

- متمرکز شده است

- غذا

- برای

- فوربس

- سابق

- به جلو

- یافت

- از جانب

- FT

- تکمیل کنید

- آینده

- همه منظوره

- تولید

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- غول

- خوب

- گوگل

- گوگل

- دولت

- بیشتر

- در حال رشد

- رشد

- راهنما

- اتفاق می افتد

- آیا

- کمک

- تاریخ

- چگونه

- چگونه

- HTML

- HTTPS

- انسان

- اندیشه

- if

- تصور کنید

- مهم

- بهبود

- in

- نادرست

- افزایش

- لوازم

- ننگین

- اطلاعات

- نمونه

- ادغام

- علاقه

- منافع

- داخلی

- به

- سرمایه گذاری

- IT

- ITS

- ژاپن

- ژاپنی

- دولت ژاپن

- دانستن

- دانش

- زبان

- بزرگ

- راه اندازی

- رهبران

- یادگیری

- کمتر

- مجوز

- پسندیدن

- احتمالا

- محدود شده

- کوچک

- زندگی

- LLM

- طولانی

- نگاه کنيد

- ساخت

- بسیاری

- ممکن است..

- شاید

- مک کینزی

- به معنی

- متا

- مایکروسافت

- قدرت

- MIT

- مدل

- مدل

- پول

- بیش

- اکثر

- حرکت

- بسیار

- نیازهای

- خالص

- جدید

- اشاره کرد

- اکنون

- اهداف

- of

- ارائه

- غالبا

- on

- ONE

- آنلاین

- باز کن

- منبع باز

- OpenAI

- or

- سفارش

- کدام سازمان ها

- سازمان های

- اصلی

- تولید

- غلبه بر

- خود

- با ما

- ویژه

- احزاب

- مردم

- انجام

- شخصی

- اطلاعات شخصی

- افلاطون

- هوش داده افلاطون

- PlatoData

- لطفا

- نقطه

- ممکن

- پتانسیل

- بالقوه

- قوی

- قدرت

- پیش بینی

- جلوگیری

- خصوصی

- شاید

- مشکل

- مشکلات

- تولید کردن

- محصولات

- حرفه ای

- ارائه

- ارائه

- اهداف

- فشار

- کیفیت

- نمایش ها

- سریعا

- نرخ

- خواندن

- به راحتی

- واقعی

- دنیای واقعی

- دلیل

- تازه

- ق

- تنظیم کننده

- برداشتن

- نماینده

- تحقیق

- منابع

- نتیجه

- نشان داد

- انقلاب

- سلطنتی

- خانواده سلطنتی

- دویدن

- s

- همان

- شیره

- گفتن

- می گوید:

- خراش

- دیدن

- فروش

- فروش

- جمله

- تنظیم

- چند

- مشابه

- تنها

- So

- نرم افزار

- راه حل

- برخی از

- چیزی

- منبع

- متخصص

- تخصصی

- خاص

- سخنرانی - گفتار

- خرج کردن

- استراتژی

- مبارزه

- چنین

- نشان می دهد

- حاکی از

- ترکیبی

- داده های مصنوعی

- سیستم

- سیستم های

- TAG

- هدف قرار

- کار

- فنی

- گفتن

- قوانین و مقررات

- نسبت به

- که

- La

- آینده

- شان

- آنها

- خودشان

- آنجا.

- اینها

- آنها

- سوم

- اشخاص ثالث

- این

- هزاران نفر

- به

- ابزار

- تاپیک

- قطار

- آموزش دیده

- آموزش

- دگرگون کردن

- روند

- امتحان

- صدای جیر جیر

- توییت

- توییتر

- نوع

- زیر

- استفاده

- کاربر

- کاربران

- استفاده

- با استفاده از

- ارزشمند

- ارزش

- نسخه

- نسخه

- بود

- مسیر..

- we

- وب

- وب سایت

- چی

- چه زمانی

- چه

- که

- در حین

- WHO

- وسیع

- ویکیپدیا

- اراده

- با

- کارگر

- با این نسخهها کار

- جهان

- ارزشمند

- خواهد بود

- X

- سال

- شما

- زفیرنت