از آنجایی که سازمانها مدلها را برای تولید مستقر میکنند، دائماً به دنبال راههایی برای بهینهسازی عملکرد مدلهای پایه خود (FM) هستند که بر روی جدیدترین شتابدهندهها، مانند استنتاج AWS و پردازندههای گرافیکی، بنابراین میتوانند هزینههای خود را کاهش داده و تأخیر پاسخ را کاهش دهند تا بهترین تجربه را برای کاربران نهایی فراهم کنند. با این حال، برخی از FM ها به طور کامل از شتاب دهنده های موجود با نمونه هایی که در آنها مستقر هستند استفاده نمی کنند، که منجر به استفاده ناکارآمد از منابع سخت افزاری می شود. برخی از سازمانها برای استفاده بهتر از همه شتابدهندههای موجود، چندین FM را در یک نمونه مستقر میکنند، اما این نیاز به هماهنگی زیرساخت پیچیدهای دارد که زمانبر و مدیریت آن دشوار است. وقتی چندین FM نمونه مشابهی را به اشتراک میگذارند، هر FM نیازهای مقیاسبندی و الگوهای استفاده خاص خود را دارد که پیشبینی زمان نیاز به افزودن یا حذف نمونهها را دشوار میکند. به عنوان مثال، یک مدل ممکن است برای تقویت یک برنامه کاربری استفاده شود که در آن استفاده در ساعات خاصی افزایش پیدا کند، در حالی که مدل دیگری ممکن است الگوی استفاده سازگارتری داشته باشد. علاوه بر بهینه سازی هزینه ها، مشتریان می خواهند با کاهش تأخیر، بهترین تجربه کاربر نهایی را ارائه دهند. برای انجام این کار، آنها اغلب چندین نسخه از یک FM را برای فیلد کردن درخواست های کاربران به صورت موازی مستقر می کنند. از آنجایی که خروجی های FM می تواند از یک جمله تا چند پاراگراف متغیر باشد، زمان لازم برای تکمیل درخواست استنتاج به طور قابل توجهی متفاوت است و در صورتی که درخواست ها به طور تصادفی بین نمونه ها هدایت شوند منجر به افزایش غیرقابل پیش بینی تاخیر می شود. آمازون SageMaker اکنون از قابلیت های استنتاج جدید پشتیبانی می کند که به شما کمک می کند هزینه های استقرار و تأخیر را کاهش دهید.

اکنون میتوانید نقاط پایانی مبتنی بر مؤلفههای استنتاج ایجاد کنید و مدلهای یادگیری ماشین (ML) را در یک نقطه پایانی SageMaker مستقر کنید. یک جزء استنتاج (IC) مدل ML شما را انتزاعی می کند و به شما امکان می دهد CPU، GPU یا نورون AWS شتاب دهنده ها و سیاست های مقیاس بندی در هر مدل. اجزای استنتاج مزایای زیر را ارائه می دهند:

- SageMaker به طور بهینه مدلها را در نمونههای ML قرار داده و بستهبندی میکند تا استفاده را به حداکثر برساند و منجر به صرفهجویی در هزینه شود.

- SageMaker هر مدل را بر اساس پیکربندی شما برای برآورده کردن نیازهای برنامه ML شما، کوچک و بزرگ می کند.

- SageMaker برای افزودن و حذف نمونهها به صورت پویا مقیاس میگیرد تا از در دسترس بودن ظرفیت اطمینان حاصل کند و در عین حال محاسبه بیحرکت را به حداقل برساند.

- برای آزاد کردن منابع برای مدلهای دیگر، میتوانید کپیهای یک مدل را به صفر کاهش دهید. همچنین می توانید تعیین کنید که مدل های مهم همیشه بارگذاری شده و آماده سرویس دهی به ترافیک باشند.

با این قابلیت ها می توانید هزینه های استقرار مدل را به طور متوسط تا 50 درصد کاهش دهید. صرفه جویی در هزینه بسته به حجم کار و الگوهای ترافیک شما متفاوت خواهد بود. بیایید یک مثال ساده بیاوریم تا نشان دهیم چگونه بستهبندی چندین مدل در یک نقطه پایانی واحد میتواند استفاده را به حداکثر برساند و در هزینهها صرفهجویی کند. فرض کنید یک برنامه چت دارید که به گردشگران کمک میکند آداب و رسوم محلی و بهترین شیوهها را درک کنند که با استفاده از دو نوع Llama 2 ساخته شده است: یکی برای بازدیدکنندگان اروپایی و دیگری تنظیم دقیق برای بازدیدکنندگان آمریکایی. ما انتظار داریم که برای مدل اروپایی بین ساعت 00:01 تا 11:59 UTC و مدل آمریکایی بین ساعت 12:00 تا 23:59 UTC ترافیک داشته باشد. بهجای استقرار این مدلها در نمونههای اختصاصی خودشان که در آن نیمی از زمان بیکار میمانند، اکنون میتوانید آنها را در یک نقطه پایانی برای صرفهجویی در هزینهها مستقر کنید. زمانی که برای آزاد کردن ظرفیت مدل اروپایی لازم نیست، میتوانید مدل آمریکایی را به صفر کاهش دهید و بالعکس. این به شما امکان می دهد از سخت افزار خود به طور موثر استفاده کنید و از هدر رفتن جلوگیری کنید. این یک مثال ساده با استفاده از دو مدل است، اما شما به راحتی می توانید این ایده را گسترش دهید تا صدها مدل را در یک نقطه پایانی واحد قرار دهید که به طور خودکار با حجم کاری شما کاهش می یابد.

در این پست، قابلیتهای جدید نقاط پایانی SageMaker مبتنی بر IC را به شما نشان میدهیم. همچنین شما را با استقرار چندین مدل با استفاده از مؤلفههای استنتاج و API راهنمایی میکنیم. در نهایت، برخی از قابلیتهای مشاهدهپذیری جدید و نحوه تنظیم خطمشیهای مقیاسبندی خودکار برای مدلهای خود و مدیریت مقیاسبندی نمونه برای نقاط پایانی را شرح میدهیم. همچنین میتوانید مدلها را از طریق تجربه کاربری جدید و سادهشده و تعاملی ما مستقر کنید. ما همچنین از قابلیت های مسیریابی پیشرفته برای بهینه سازی تأخیر و عملکرد بارهای کاری استنتاج شما پشتیبانی می کنیم.

بلوک های ساختمان

بیایید نگاهی عمیقتر بیندازیم و درک کنیم که این قابلیتهای جدید چگونه کار میکنند. در زیر برخی از اصطلاحات جدید برای میزبانی SageMaker آمده است:

- جزء استنتاج – یک شی میزبان SageMaker که می توانید از آن برای استقرار یک مدل در نقطه پایانی استفاده کنید. با ارائه موارد زیر می توانید یک جزء استنتاج ایجاد کنید:

- مدل SageMaker یا مشخصات یک تصویر و مصنوعات مدل سازگار با SageMaker.

- نیازهای منابع را محاسبه کنید، که نیازهای هر کپی از مدل شما، از جمله هسته های CPU، حافظه میزبان و تعداد شتاب دهنده ها را مشخص می کند.

- کپی مدل - یک کپی در زمان اجرا از یک جزء استنتاج که قادر به ارائه درخواست ها است.

- مقیاس خودکار نمونه مدیریت شده – قابلیت میزبانی SageMaker برای افزایش یا کاهش تعداد نمونه های محاسبه استفاده شده برای یک نقطه پایانی. مقیاس بندی نمونه به مقیاس بندی اجزای استنتاج واکنش نشان می دهد.

برای ایجاد یک جزء استنتاج جدید، می توانید یک تصویر ظرف و یک مصنوع مدل را مشخص کنید، یا می توانید از مدل های SageMaker که ممکن است قبلا ایجاد کرده اید استفاده کنید. همچنین باید منابع محاسباتی مورد نیاز مانند تعداد هستههای CPU میزبان، حافظه میزبان یا تعداد شتابدهندههایی که مدل شما برای اجرا نیاز دارد را مشخص کنید.

هنگامی که یک جزء استنتاج را مستقر می کنید، می توانید آن را مشخص کنید MinCopies برای اطمینان از اینکه مدل قبلاً به مقدار مورد نیاز شما بارگذاری شده است و آماده ارائه درخواست ها است.

همچنین میتوانید خطمشیهای خود را طوری تنظیم کنید که کپیهای مؤلفه استنتاج به صفر برسد. به عنوان مثال، اگر هیچ باری در برابر آی سی اجرا نشود، کپی مدل تخلیه می شود. این می تواند منابعی را آزاد کند که می توانند با بارهای کاری فعال جایگزین شوند تا استفاده و کارایی نقطه پایانی شما بهینه شود.

با افزایش یا کاهش درخواستهای استنتاج، تعداد کپیهای ICهای شما نیز میتواند بر اساس خطمشیهای مقیاسبندی خودکار شما افزایش یا کاهش یابد. SageMaker قرار دادن را انجام می دهد تا بسته بندی مدل های شما را از نظر در دسترس بودن و هزینه بهینه کند.

علاوه بر این، اگر مقیاس خودکار نمونه مدیریتشده را فعال کنید، SageMaker نمونههای محاسبهشده را با توجه به تعداد مؤلفههای استنتاجی که باید در یک زمان معین برای ارائه به ترافیک بارگیری شوند، مقیاسبندی میکند. SageMaker نمونه ها را بزرگ می کند و نمونه ها و اجزای استنتاج شما را برای بهینه سازی هزینه و در عین حال حفظ عملکرد مدل، بسته بندی می کند. اگرچه ما استفاده از مقیاسسازی نمونه مدیریتشده را توصیه میکنیم، اما در صورت تمایل، از طریق مقیاسبندی خودکار برنامه، این گزینه را نیز دارید که مقیاسگذاری را خودتان مدیریت کنید.

SageMaker اجزای استنتاج را مجدداً متعادل میکند و در صورت عدم نیاز به مؤلفههای استنتاج نمونهها را کاهش میدهد و در هزینههای شما صرفهجویی میکند.

بررسی APIها

SageMaker موجودیت جدیدی به نام the را معرفی کرده است InferenceComponent. این جزئیات میزبانی مدل ML را از خود نقطه پایانی جدا می کند. این InferenceComponent به شما اجازه می دهد تا ویژگی های کلیدی را برای میزبانی مدل مشخص کنید، مانند مدل SageMaker که می خواهید استفاده کنید یا جزئیات کانتینر و مصنوعات مدل. همچنین تعداد کپیهای خود مؤلفهها برای استقرار، و تعداد شتابدهندهها (GPU، Inf، یا Trn) یا CPU (vCPU) مورد نیاز را مشخص میکنید. این انعطاف پذیری بیشتری را برای شما فراهم می کند تا از یک نقطه پایانی واحد برای هر تعداد مدلی که قصد دارید در آینده در آن استقرار دهید استفاده کنید.

بیایید به فراخوانی های Boto3 API برای ایجاد یک نقطه پایانی با یک جزء استنتاج نگاه کنیم. توجه داشته باشید که برخی از پارامترها وجود دارد که در ادامه این پست به آنها خواهیم پرداخت.

کد زیر نمونه ای برای CreateEndpointConfig:

کد زیر نمونه ای برای CreateEndpoint:

کد زیر نمونه ای برای CreateInferenceComponent:

این جدا شدن از InferenceComponent به نقطه پایانی انعطاف پذیری را فراهم می کند. میتوانید چندین مدل را روی یک زیرساخت میزبانی کنید و با تغییر نیازهایتان آنها را اضافه یا حذف کنید. هر مدل می تواند به طور مستقل در صورت نیاز به روز شود. علاوه بر این، می توانید مدل ها را بر اساس نیازهای کسب و کار خود مقیاس کنید. InferenceComponent همچنین به شما امکان می دهد ظرفیت هر مدل را کنترل کنید. به عبارت دیگر، شما می توانید تعیین کنید که چند نسخه از هر مدل میزبانی کنید. این مقیاسبندی قابل پیشبینی به شما کمک میکند تا نیازهای تاخیر خاص هر مدل را برآورده کنید. به طور کلی، InferenceComponent به شما کنترل بسیار بیشتری بر روی مدل های میزبانی شده خود می دهد.

در جدول زیر، ما یک مقایسه جانبی از رویکرد سطح بالا برای ایجاد و فراخوانی یک نقطه پایانی بدون InferenceComponent و با InferenceComponent. توجه داشته باشید که CreateModel() اکنون برای نقاط پایانی مبتنی بر IC اختیاری است.

| گام | نقاط پایانی مبتنی بر مدل | نقاط پایانی مبتنی بر مؤلفه استنتاج |

| 1 | CreateModel (…) | CreateEndpointConfig (…) |

| 2 | CreateEndpointConfig (…) | CreateEndpoint (…) |

| 3 | CreateEndpoint (…) | CreateInferenceComponent (…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName='value'…) |

مقدمه ای از InferenceComponent به شما امکان می دهد در سطح مدل مقیاس بندی کنید. دیدن به نمونهها و مقیاسبندی خودکار آی سی بپردازید برای جزئیات بیشتر در مورد چگونگی InferenceComponent با مقیاس خودکار کار می کند.

هنگام فراخوانی نقطه پایانی SageMaker، اکنون می توانید پارامتر جدید را مشخص کنید InferenceComponentName مورد نظر را بزند InferenceComponentName. SageMaker مسیریابی درخواست را به نمونه ای که میزبان درخواست شده است رسیدگی می کند InferenceComponentName. کد زیر را ببینید:

بهطور پیشفرض، SageMaker از مسیریابی تصادفی درخواستها به نمونههای پشتیبان نقطه پایانی شما استفاده میکند. اگر میخواهید مسیریابی کمترین درخواستهای برجسته را فعال کنید، میتوانید استراتژی مسیریابی را در پیکربندی نقطه پایانی تنظیم کنید. RoutingConfig:

کمترین درخواست های معوق، مسیرهایی را به نمونه های خاصی که ظرفیت بیشتری برای پردازش درخواست ها دارند، هدایت می کند. این باعث تعادل بار و استفاده از منابع یکنواخت تر می شود.

علاوه بر CreateInferenceComponent، API های زیر اکنون در دسترس هستند:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

گزارشها و معیارهای InferenceComponent

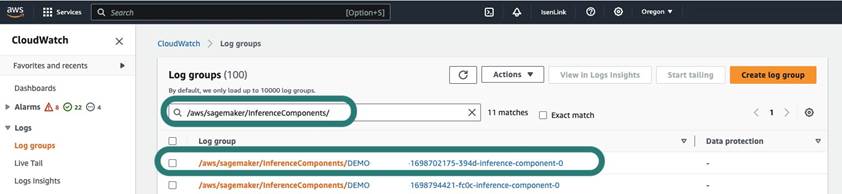

InferenceComponent سیاهههای مربوط در واقع شده اند /aws/sagemaker/InferenceComponents/<InferenceComponentName>. تمام گزارشهای ارسال شده به stderr و stdout در کانتینر به این لاگها ارسال میشوند CloudWatch آمازون.

با معرفی نقاط پایانی مبتنی بر IC، اکنون میتوانید معیارهای نمونه اضافی، معیارهای اجزای استنتاج و معیارهای فراخوانی را مشاهده کنید.

برای نمونه های SageMaker، اکنون می توانید آن را ردیابی کنید GPUReservation و CPUReservation معیارها برای مشاهده منابع رزرو شده برای یک نقطه پایانی بر اساس مؤلفههای استنتاجی که شما مستقر کردهاید. این معیارها میتوانند به شما کمک کنند خطمشیهای نقطه پایانی و مقیاس خودکار خود را اندازهگیری کنید. همچنین میتوانید معیارهای انبوه مرتبط با همه مدلهای مستقر در یک نقطه پایانی را مشاهده کنید.

SageMaker همچنین معیارها را در سطح مؤلفه استنتاج نشان میدهد، که میتواند نمای دقیقتری از استفاده از منابع برای مؤلفههای استنتاجی که شما به کار گرفتهاید نشان دهد. این به شما این امکان را میدهد تا دیدی از میزان استفاده از منابع کل مانند GPUUtilizationNormalized و GPUMemoryUtilizationNormalized برای هر مؤلفه استنتاجی که مستقر کرده اید که ممکن است صفر یا تعداد زیادی کپی داشته باشد.

در نهایت، SageMaker معیارهای فراخوانی را ارائه میکند، که اکنون فراخوانها را برای اجزای استنتاج به طور کلی ردیابی میکند (Invocations) یا به ازای هر نسخه نمونه سازی شده (InvocationsPerCopy)

برای یک لیست جامع از معیارها، مراجعه کنید معیارهای فراخوانی نقطه پایانی SageMaker.

مقیاس بندی خودکار در سطح مدل

برای اجرای رفتار مقیاسبندی خودکار که توضیح دادیم، هنگام ایجاد پیکربندی نقطه پایانی SageMaker و جزء استنتاج، به ترتیب تعداد نمونه اولیه و تعداد کپی مدل اولیه را تعریف میکنید. پس از ایجاد نقطه پایانی و آی سی های مربوطه، برای اعمال مقیاس خودکار در سطح آی سی، ابتدا باید هدف مقیاس بندی را ثبت کنید و سپس خط مشی مقیاس بندی را به آی سی مرتبط کنید.

هنگام اجرای خط مشی مقیاس بندی، استفاده می کنیم SageMakerInferenceComponentInvocationsPerCopy، که معیار جدیدی است که توسط SageMaker معرفی شده است. میانگین تعداد فراخوان در هر کپی مدل را در دقیقه ثبت می کند.

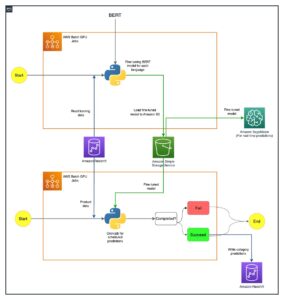

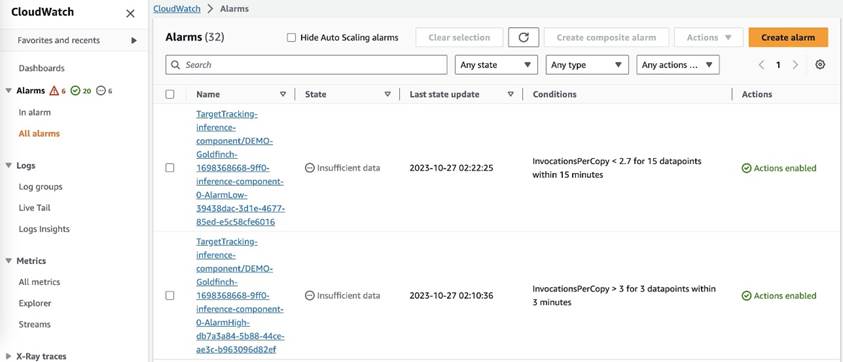

پس از تنظیم خطمشی مقیاسبندی، SageMaker دو زنگ CloudWatch را برای هر هدف مقیاسپذیر خودکار ایجاد میکند: یکی برای فعال کردن مقیاسبندی در صورت زنگ هشدار به مدت 3 دقیقه (سه نقطه داده 1 دقیقهای) و دیگری برای فعال کردن مقیاس در صورت زنگ هشدار به مدت 15 دقیقه. (15 نقطه داده 1 دقیقه ای)، همانطور که در تصویر زیر نشان داده شده است. زمان شروع عمل مقیاسگذاری معمولاً 1 تا 2 دقیقه بیشتر از آن دقیقه است، زیرا برای انتشار معیارهای نقطه پایانی در CloudWatch زمان میبرد، و همچنین زمان میبرد. AutoScaling واکنش نشان دادن. دوره سرد کردن مقدار زمانی است که بر حسب ثانیه، پس از اتمام یک فعالیت کوچکسازی یا کوچکسازی قبل از شروع یک فعالیت کوچکسازی دیگر، به پایان میرسد. اگر کاهش مقیاس کوچکتر از زمان بهروزرسانی نقطه پایانی باشد، تأثیری نخواهد داشت، زیرا امکان بهروزرسانی یک نقطه پایانی SageMaker زمانی که در داخل است وجود ندارد. به روز رسانی وضعیت.

توجه داشته باشید که هنگام تنظیم مقیاس خودکار در سطح IC، باید مطمئن شوید MaxInstanceCount پارامتر برابر یا کوچکتر از حداکثر تعداد IC هایی است که این نقطه پایانی می تواند انجام دهد. به عنوان مثال، اگر نقطه پایانی شما فقط برای داشتن یک نمونه در پیکربندی نقطه پایانی پیکربندی شده باشد و این نمونه فقط می تواند حداکثر چهار نسخه از مدل را میزبانی کند، آنگاه MaxInstanceCount باید مساوی یا کوچکتر از 4 باشد. با این حال، می توانید از قابلیت مقیاس خودکار مدیریت شده ارائه شده توسط SageMaker نیز استفاده کنید تا به طور خودکار تعداد نمونه ها را بر اساس شماره مدل مورد نیاز کپی کنید تا نیاز به منابع محاسباتی بیشتر برآورده شود. قطعه کد زیر نحوه تنظیم مقیاس نمونه مدیریت شده را در طول ایجاد پیکربندی نقطه پایانی نشان می دهد. به این ترتیب، زمانی که مقیاس خودکار سطح IC به تعداد نمونههای بیشتری برای میزبانی کپیهای مدل نیاز دارد، SageMaker بهطور خودکار شماره نمونه را کوچک میکند تا مقیاسگذاری در سطح IC موفقیتآمیز باشد.

میتوانید چندین خطمشی مقیاسبندی خودکار را در برابر یک نقطه پایانی اعمال کنید، به این معنی که میتوانید خطمشی مقیاسگذاری خودکار سنتی را در نقاط پایانی ایجاد شده با ICها اعمال کنید و بر اساس معیارهای دیگر نقطه پایانی، مقیاسبندی را بالا و پایین کنید. برای اطلاعات بیشتر مراجعه کنید استقرار یادگیری ماشین خود را با مقیاس خودکار در Amazon SageMaker بهینه کنید. با این حال، اگرچه این امکان وجود دارد، ما همچنان توصیه میکنیم از مقیاسبندی نمونه مدیریتشده به جای مدیریت مقیاسگذاری توسط خودتان استفاده کنید.

نتیجه

در این پست، ویژگی جدیدی را در استنتاج SageMaker معرفی کردیم که به شما کمک میکند تا استفاده از نمونههای محاسباتی را به حداکثر برسانید، به صدها مدل مقیاس دهید و هزینهها را بهینه کنید و در عین حال عملکرد قابل پیشبینی را ارائه دهید. علاوه بر این، ما توضیحی از APIها ارائه کردیم و به شما نشان دادیم که چگونه اجزای استنتاج را برای بارهای کاری خود پیکربندی و استقرار دهید.

ما هم حمایت می کنیم قابلیت های مسیریابی پیشرفته تا تأخیر و عملکرد بارهای کاری استنتاج خود را بهینه کنید. SageMaker می تواند به شما کمک کند تا حجم کار استنتاج خود را برای هزینه و عملکرد بهینه کنید و به شما جزئیاتی در سطح مدل برای مدیریت بدهد. ما ایجاد کرده ایم مجموعه ای از نوت بوک که به شما نشان می دهد که چگونه سه مدل مختلف را با استفاده از کانتینرهای مختلف و اعمال سیاست های مقیاس بندی خودکار در GitHub استقرار دهید. ما شما را تشویق می کنیم که با نوت بوک 1 شروع کنید و از امروز با قابلیت های میزبانی جدید SageMaker دست به کار شوید!

درباره نویسندگان

جیمز پارک یک معمار راه حل در خدمات وب آمازون است. او با Amazon.com برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند و علاقه خاصی به هوش مصنوعی و یادگیری ماشین دارد. در اوقات فراغت او از جستجوی فرهنگ های جدید، تجربیات جدید و به روز ماندن با آخرین روندهای فناوری لذت می برد. می توانید او را در آن پیدا کنید لینک.

جیمز پارک یک معمار راه حل در خدمات وب آمازون است. او با Amazon.com برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند و علاقه خاصی به هوش مصنوعی و یادگیری ماشین دارد. در اوقات فراغت او از جستجوی فرهنگ های جدید، تجربیات جدید و به روز ماندن با آخرین روندهای فناوری لذت می برد. می توانید او را در آن پیدا کنید لینک.

ملانی لیدکترا، یک متخصص ارشد AI/ML TAM در AWS مستقر در سیدنی، استرالیا است. او به مشتریان سازمانی کمک می کند تا راه حل هایی را با استفاده از ابزارهای پیشرفته AI/ML در AWS بسازند و راهنمایی هایی را در مورد معماری و اجرای راه حل های ML با بهترین شیوه ها ارائه می دهد. او در اوقات فراغت خود عاشق کشف طبیعت و گذراندن وقت با خانواده و دوستان است.

ملانی لیدکترا، یک متخصص ارشد AI/ML TAM در AWS مستقر در سیدنی، استرالیا است. او به مشتریان سازمانی کمک می کند تا راه حل هایی را با استفاده از ابزارهای پیشرفته AI/ML در AWS بسازند و راهنمایی هایی را در مورد معماری و اجرای راه حل های ML با بهترین شیوه ها ارائه می دهد. او در اوقات فراغت خود عاشق کشف طبیعت و گذراندن وقت با خانواده و دوستان است.

مارک کارپ یک معمار ML با تیم Amazon SageMaker Service است. او بر کمک به مشتریان در طراحی، استقرار و مدیریت حجم کاری ML در مقیاس تمرکز دارد. او در اوقات فراغت خود از سفر و کاوش در مکان های جدید لذت می برد.

مارک کارپ یک معمار ML با تیم Amazon SageMaker Service است. او بر کمک به مشتریان در طراحی، استقرار و مدیریت حجم کاری ML در مقیاس تمرکز دارد. او در اوقات فراغت خود از سفر و کاوش در مکان های جدید لذت می برد.

آلن تان یک مدیر ارشد محصول با SageMaker است که تلاشها را برای استنتاج مدلهای بزرگ رهبری میکند. او علاقه زیادی به استفاده از یادگیری ماشینی در حوزه تجزیه و تحلیل دارد. خارج از محل کار، او از فضای باز لذت می برد.

آلن تان یک مدیر ارشد محصول با SageMaker است که تلاشها را برای استنتاج مدلهای بزرگ رهبری میکند. او علاقه زیادی به استفاده از یادگیری ماشینی در حوزه تجزیه و تحلیل دارد. خارج از محل کار، او از فضای باز لذت می برد.

راغو رامشا یک معمار ارشد راه حل های ML با تیم خدمات آمازون SageMaker است. او بر کمک به مشتریان در ساخت، استقرار و انتقال بارهای کاری تولید ML به SageMaker در مقیاس متمرکز است. او در زمینه های یادگیری ماشین، هوش مصنوعی و بینایی کامپیوتر تخصص دارد و دارای مدرک کارشناسی ارشد در علوم کامپیوتر از UT Dallas است. در اوقات فراغت از مسافرت و عکاسی لذت می برد.

راغو رامشا یک معمار ارشد راه حل های ML با تیم خدمات آمازون SageMaker است. او بر کمک به مشتریان در ساخت، استقرار و انتقال بارهای کاری تولید ML به SageMaker در مقیاس متمرکز است. او در زمینه های یادگیری ماشین، هوش مصنوعی و بینایی کامپیوتر تخصص دارد و دارای مدرک کارشناسی ارشد در علوم کامپیوتر از UT Dallas است. در اوقات فراغت از مسافرت و عکاسی لذت می برد.

روپیند گروال یک معمار راه حل های تخصصی Sr Ai/ML با AWS است. او در حال حاضر روی ارائه مدل ها و MLO ها در SageMaker تمرکز دارد. قبل از این نقش، او به عنوان مهندس یادگیری ماشین، مدلهای ساخت و میزبانی کار کرده است. خارج از محل کار او از بازی تنیس و دوچرخه سواری در مسیرهای کوهستانی لذت می برد.

روپیند گروال یک معمار راه حل های تخصصی Sr Ai/ML با AWS است. او در حال حاضر روی ارائه مدل ها و MLO ها در SageMaker تمرکز دارد. قبل از این نقش، او به عنوان مهندس یادگیری ماشین، مدلهای ساخت و میزبانی کار کرده است. خارج از محل کار او از بازی تنیس و دوچرخه سواری در مسیرهای کوهستانی لذت می برد.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

ساوراب تریکاند مدیر محصول ارشد Amazon SageMaker Inference است. او مشتاق کار با مشتریان است و هدفش دموکراتیک کردن یادگیری ماشین است. او بر چالشهای اصلی مربوط به استقرار برنامههای کاربردی پیچیده ML، مدلهای ML چند مستاجر، بهینهسازی هزینهها و در دسترستر کردن استقرار مدلهای یادگیری عمیق تمرکز میکند. Saurabh در اوقات فراغت خود از پیاده روی، یادگیری در مورد فن آوری های نوآورانه، دنبال کردن TechCrunch و گذراندن وقت با خانواده خود لذت می برد.

ساوراب تریکاند مدیر محصول ارشد Amazon SageMaker Inference است. او مشتاق کار با مشتریان است و هدفش دموکراتیک کردن یادگیری ماشین است. او بر چالشهای اصلی مربوط به استقرار برنامههای کاربردی پیچیده ML، مدلهای ML چند مستاجر، بهینهسازی هزینهها و در دسترستر کردن استقرار مدلهای یادگیری عمیق تمرکز میکند. Saurabh در اوقات فراغت خود از پیاده روی، یادگیری در مورد فن آوری های نوآورانه، دنبال کردن TechCrunch و گذراندن وقت با خانواده خود لذت می برد.

لاکشمی راماکریشنان یک مهندس اصلی در تیم پلت فرم یادگیری ماشین آمازون SageMaker (ML) در AWS است که رهبری فنی را برای محصول ارائه می دهد. او بیش از 9 سال در چندین نقش مهندسی در آمازون کار کرده است. او دارای مدرک لیسانس مهندسی در فناوری اطلاعات از مؤسسه ملی فناوری، کارناتاکا، هند و مدرک کارشناسی ارشد در علوم کامپیوتر از دانشگاه شهرهای دوقلوی مینه سوتا است.

لاکشمی راماکریشنان یک مهندس اصلی در تیم پلت فرم یادگیری ماشین آمازون SageMaker (ML) در AWS است که رهبری فنی را برای محصول ارائه می دهد. او بیش از 9 سال در چندین نقش مهندسی در آمازون کار کرده است. او دارای مدرک لیسانس مهندسی در فناوری اطلاعات از مؤسسه ملی فناوری، کارناتاکا، هند و مدرک کارشناسی ارشد در علوم کامپیوتر از دانشگاه شهرهای دوقلوی مینه سوتا است.

دیوید نیگندا یک مهندس ارشد توسعه نرم افزار در تیم آمازون SageMaker است که در حال حاضر روی بهبود گردش کار یادگیری ماشین تولید و همچنین راه اندازی ویژگی های استنتاج جدید کار می کند. در اوقات فراغت خود سعی می کند با بچه هایش همگام باشد.

دیوید نیگندا یک مهندس ارشد توسعه نرم افزار در تیم آمازون SageMaker است که در حال حاضر روی بهبود گردش کار یادگیری ماشین تولید و همچنین راه اندازی ویژگی های استنتاج جدید کار می کند. در اوقات فراغت خود سعی می کند با بچه هایش همگام باشد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- ٪۱۰۰

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- توانایی

- قادر

- درباره ما

- چکیده ها

- شتاب دهنده ها

- در دسترس

- مطابق

- رسیدن

- عمل

- فعال

- فعالیت

- اضافه کردن

- اضافه کردن

- اضافه

- اضافی

- علاوه بر این

- نشانی

- پیشرفته

- پس از

- در برابر

- تجمیع

- AI

- AI / ML

- آلن

- هشدار

- معرفی

- اجازه دادن

- اجازه می دهد تا

- قبلا

- همچنین

- هر چند

- همیشه

- آمازون

- آمازون SageMaker

- آمازون خدمات وب

- Amazon.com

- امریکایی

- مقدار

- an

- علم تجزیه و تحلیل

- و

- دیگر

- هر

- API

- رابط های برنامه کاربردی

- کاربرد

- برنامه های کاربردی

- درخواست

- با استفاده از

- روش

- هستند

- محدوده

- مصنوعی

- هوش مصنوعی

- AS

- وابسته

- مرتبط است

- At

- استرالیا

- خودکار

- بطور خودکار

- دسترس پذیری

- در دسترس

- میانگین

- اجتناب از

- AWS

- حمایت

- مستقر

- BE

- زیرا

- قبل از

- رفتار

- مزایای

- بهترین

- بهترین شیوه

- بهتر

- میان

- ساختن

- بنا

- ساخته

- کسب و کار

- اما

- by

- نام

- تماس ها

- CAN

- قابلیت های

- قابلیت

- توانا

- ظرفیت

- جلب

- معین

- چالش ها

- به چالش کشیدن

- تغییر دادن

- را انتخاب کنید

- شهرستانها

- رمز

- COM

- مقایسه

- کامل

- تکمیل شده

- پیچیده

- جزء

- اجزاء

- جامع

- محاسبه

- کامپیوتر

- علم کامپیوتر

- چشم انداز کامپیوتر

- محاسبه

- پیکر بندی

- پیکربندی

- استوار

- به طور مداوم

- مصرف کننده

- ظرف

- ظروف

- کنترل

- هسته

- متناظر

- هزینه

- صرفه جویی در هزینه

- هزینه

- میتوانست

- ایجاد

- ایجاد شده

- ایجاد

- ایجاد

- ایجاد

- در حال حاضر

- مشتریان

- گمرک

- دالاس

- داده ها

- نقاط داده

- تاریخ

- کاهش

- اختصاصی

- عمیق

- یادگیری عمیق

- عمیق تر

- به طور پیش فرض

- تعريف كردن

- درجه

- غرق کردن

- دموکراتیک کردن

- نشان می دهد

- بستگی دارد

- گسترش

- مستقر

- استقرار

- گسترش

- اعزام ها

- شرح داده شده

- طرح

- مطلوب

- جزئیات

- جزئیات

- مشخص کردن

- پروژه

- مختلف

- مشکل

- توزیع شده

- محاسبات توزیع شده

- do

- حوزه

- آیا

- پایین

- در طی

- بطور پویا

- هر

- به آسانی

- اثر

- بهره وری

- موثر

- تلاش

- قادر ساختن

- فعال

- را قادر می سازد

- تشویق

- نقطه پایانی

- مهندس

- مهندسی

- اطمینان حاصل شود

- سرمایه گذاری

- شرکت

- موجودیت

- برابر

- اروپایی

- مثال

- انتظار

- تجربه

- تجارب

- اکتشاف

- بررسی

- گسترش

- خانواده

- ویژگی

- امکانات

- رشته

- پیدا کردن

- نام خانوادگی

- انعطاف پذیری

- تمرکز

- پیروی

- برای

- پایه

- چهار

- رایگان

- دوستان

- از جانب

- کاملا

- بعلاوه

- آینده

- دریافت کنید

- GIF

- GitHub

- دادن

- داده

- می دهد

- هدف

- GPU

- GPU ها

- دانه ای

- راهنمایی

- نیم

- دسته

- دست ها

- سخت افزار

- آیا

- he

- کمک

- کمک

- کمک می کند

- او

- زیاد

- در سطح بالا

- او را

- خود را

- اصابت

- دارای

- میزبان

- میزبانی

- میزبانی وب

- ساعت ها

- چگونه

- چگونه

- اما

- HTTP

- HTTPS

- صدها نفر

- اندیشه

- آرام

- if

- نشان دادن

- تصویر

- انجام

- اجرای

- مهم

- بهبود

- in

- در دیگر

- از جمله

- افزایش

- به طور مستقل

- هندوستان

- ناکارآمد

- اطلاعات

- فن آوری اطلاعات

- شالوده

- اول

- ابتکاری

- فن آوری های نوآورانه

- نمونه

- در عوض

- موسسه

- اطلاعات

- تعاملی

- علاقه

- به

- معرفی

- معرفی

- IT

- ITS

- خود

- JPG

- نگاه داشتن

- نگهداری

- کلید

- بچه ها

- بزرگ

- شرکت های بزرگ

- در آخر

- تاخیر

- بعد

- آخرین

- راه اندازی

- رهبری

- برجسته

- یادگیری

- کمترین

- سطح

- پسندیدن

- لینک

- فهرست

- پشم لاما

- بار

- محلی

- واقع شده

- دیگر

- نگاه کنيد

- به دنبال

- دوست دارد

- دستگاه

- فراگیری ماشین

- ساخت

- ساخت

- مدیریت

- اداره می شود

- مدیریت

- مدیر

- مدیریت

- بسیاری

- استاد

- کارشناسی ارشد

- بیشینه ساختن

- بیشترین

- ممکن است..

- به معنی

- دیدار

- حافظه

- متری

- متریک

- مهاجرت

- حد اقل

- دقیقه

- دقیقه

- ML

- MLO ها

- مدل

- مدل

- بیش

- انگیزه

- کوه

- بسیار

- چندگانه

- ملی

- طبیعت

- نیاز

- ضروری

- نیازهای

- جدید

- nlp

- نه

- توجه داشته باشید

- دفتر یادداشت

- اکنون

- عدد

- هدف

- of

- ارائه

- غالبا

- on

- ONE

- فقط

- به سوی

- بهینه سازی

- بهینه سازی

- گزینه

- or

- تنظیم و ارکستراسیون

- سازمان های

- دیگر

- ما

- خارج

- خارج از منزل

- خروجی

- خارج از

- برجسته

- روی

- به طور کلی

- خود

- بسته

- موازی

- پارامتر

- پارامترهای

- ویژه

- احساساتی

- الگو

- الگوهای

- برای

- کارایی

- دوره

- دکترا

- عکاسی

- محل

- کاریابی

- اماکن

- برنامه

- سکو

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- نقطه

- سیاست

- سیاست

- ممکن

- پست

- قدرت

- شیوه های

- پیش بینی

- قابل پیش بینی

- حفظ کردن

- اصلی

- قبلا

- مشکلات

- روند

- محصول

- مدیر تولید

- تولید

- املاک

- ارائه

- ارائه

- فراهم می کند

- ارائه

- منتشر کردن

- مقدار

- تصادفی

- محدوده

- اعم

- واکنش نشان می دهند

- واکنش نشان می دهد

- اماده

- تعادل دوباره

- توصیه

- كاهش دادن

- کاهش

- مراجعه

- ثبت نام

- مربوط

- برداشتن

- از بین بردن

- جایگزین

- درخواست

- درخواست

- نیاز

- ضروری

- مورد نیاز

- نیاز

- محفوظ می باشد

- منابع

- منابع

- به ترتیب

- پاسخ

- نقش

- نقش

- مسیرها

- مسیریابی

- دویدن

- در حال اجرا

- زمان اجرا

- حکیم ساز

- استنباط SageMaker

- همان

- ذخیره

- پس انداز

- گفتن

- مقیاس

- مقیاس ها

- مقیاس گذاری

- علم

- ثانیه

- دیدن

- به دنبال

- ارشد

- فرستاده

- جمله

- خدمت

- سرویس

- خدمات

- خدمت

- تنظیم

- محیط

- چند

- اشتراک گذاری

- او

- باید

- نشان

- نشان داد

- نشان داده شده

- به طور قابل توجهی

- ساده

- ساده شده

- تنها

- نشستن

- اندازه

- کوچکتر

- قطعه

- So

- نرم افزار

- توسعه نرم افزار

- مزایا

- برخی از

- متخصص

- تخصص دارد

- خاص

- مشخصات

- خرج کردن

- هزینه

- سنبله

- سنبله ها

- شروع

- نوپا

- وضعیت هنر

- وضعیت

- اقامت

- هنوز

- استراتژی

- موفق

- چنین

- تهیه

- پشتیبانی

- پشتیبانی از

- مطمئن

- سیدنی

- جدول

- گرفتن

- طول می کشد

- هدف

- تیم

- TechCrunch

- فنی

- فن آوری

- پیشرفته

- تنیس

- واژه شناسی

- نسبت به

- که

- La

- محوطه

- آینده

- شان

- آنها

- سپس

- آنجا.

- اینها

- آنها

- این

- کسانی که

- سه

- از طریق

- زمان

- به

- ابزار

- مسیر

- سنتی

- ترافیک

- سفر

- روند

- ماشه

- دوقلو

- دو

- فهمیدن

- دانشگاه

- غیرقابل پیش بینی

- بروزرسانی

- به روز شده

- استفاده

- استفاده کنید

- استفاده

- کاربر

- سابقه کاربر

- کاربران

- استفاده

- با استفاده از

- معمولا

- ساعت محلی UTC تنظیم شده اند

- استفاده کنید

- معاون

- چشم انداز

- دید

- بازدید کنندگان

- راه رفتن

- خرید

- می خواهم

- ضایعات

- مسیر..

- راه

- we

- وب

- خدمات وب

- خوب

- چه زمانی

- در حالیکه

- که

- در حین

- اراده

- با

- بدون

- کلمات

- مهاجرت کاری

- مشغول به کار

- گردش کار

- کارگر

- با این نسخهها کار

- سال

- شما

- شما

- خودت

- زفیرنت

- صفر