این پست توسط Shibangi Saha، دانشمند داده، و Graciela Kravtzov، یکی از بنیانگذاران و CTO، Equilibrium Point نوشته شده است.

بسیاری از افراد علائم جدیدی از بیماری روانی مانند استرس، اضطراب، افسردگی، مصرف مواد و اختلال استرس پس از سانحه (PTSD) را تجربه می کنند. مطابق با بنیاد خانواده کایزرحدود نیمی از بزرگسالان (47٪) در سراسر کشور اثرات منفی بر سلامت روان در طول همه گیری گزارش کرده اند که افزایش قابل توجهی نسبت به سطوح قبل از همه گیری است. همچنین، برخی از جنسها و گروههای سنی از جمله افرادی هستند که بیشتر از سایرین استرس و نگرانی را گزارش میکنند. بهعلاوه، چند گروه قومی خاص بیشتر از دیگران «تاثیر عمده» را بر سلامت روان خود گزارش میدهند.

چندین نظرسنجی، از جمله آنهایی که توسط مراکز کنترل بیماری (CDC) جمع آوری شده است، افزایش قابل توجهی در علائم سلامت رفتاری گزارش شده توسط خود نشان داده اند. بر اساس یک گزارش CDC که در اواخر ژوئن 2020 از بزرگسالان در سراسر ایالات متحده مورد بررسی قرار گرفت، 31٪ از پاسخ دهندگان علائم اضطراب یا افسردگی را گزارش کردند، 13٪ شروع یا افزایش مصرف مواد، 26٪ علائم مربوط به استرس و 11٪ را گزارش کردند. گزارش شده است که در 30 روز گذشته افکار جدی خودکشی داشته است.

دادههای گزارششده توسط خود، در حالی که در تشخیص اختلالات سلامت روان کاملاً حیاتی هستند، میتوانند در معرض تأثیرات مربوط به ننگ مداوم پیرامون سلامت روان و درمان سلامت روان باشند. به جای تکیه بر دادههای خود گزارششده، میتوانیم پریشانی روانی را با استفاده از دادههای سوابق بهداشتی و دادههای ادعاها برآورد و پیشبینی کنیم تا به یک سؤال اساسی پاسخ دهیم: آیا میتوانیم پیشبینی کنیم که چه کسی احتمالاً قبل از نیاز به کمک سلامت روان نیاز دارد؟ اگر بتوان این افراد را شناسایی کرد، میتوان برنامهها و منابع مداخله زودهنگام را برای پاسخ به هر گونه علائم جدید یا افزایش علائم زمینهای برای کاهش اثرات و هزینههای اختلالات روانی توسعه داد و به کار برد.

برای کسانی که با مدیریت و پردازش حجم زیادی از دادههای ادعاهای پیچیده و پر از شکاف دست و پنجه نرم کردهاند، گفتنش آسانتر از انجام آن است! در این پست نحوه انجام آن را به اشتراک می گذاریم نقطه تعادل اینترنت اشیا استفاده Amazon SageMaker Data Rangler برای سادهسازی آمادهسازی دادههای ادعاها برای موارد استفاده از سلامت روان، در حالی که کیفیت دادهها را در هر مرحله از فرآیند تضمین میکنیم.

بررسی اجمالی راه حل

آمادهسازی دادهها یا مهندسی ویژگیها فرآیندی خستهکننده است که به دانشمندان و مهندسان داده با تجربه نیاز دارد که زمان و انرژی زیادی را برای فرمولبندی دستور العملهای تغییرات (مراحل) مختلف مورد نیاز برای تبدیل دادهها به شکل درست خود صرف کنند. در واقع، تحقیقات نشان می دهد که آماده سازی داده ها برای یادگیری ماشین (ML) تا 80 درصد از زمان دانشمندان داده را مصرف می کند. به طور معمول، دانشمندان و مهندسان از چارچوبهای مختلف پردازش دادهها مانند Pandas، PySpark و SQL برای کدگذاری تحولات خود و ایجاد مشاغل پردازش توزیع شده استفاده میکنند. با Data Wrangler می توانید این فرآیند را خودکار کنید. Data Wrangler یک جزء است Amazon SageMaker Studio که یک راه حل سرتاسر برای وارد کردن، آماده سازی، تبدیل، مشخص کردن و تجزیه و تحلیل داده ها ارائه می دهد. می توانید Data Wrangler را ادغام کنید گردش داده ها به جریان های کاری ML موجود خود بپردازید تا پردازش داده ها و مهندسی ویژگی ها را با استفاده از برنامه نویسی کم یا بدون نیاز به ساده سازی و ساده سازی کنید.

در این پست، مراحل تبدیل مجموعه دادههای خام اصلی را به ویژگیهای آماده ML برای استفاده برای ساخت مدلهای پیشبینی در مرحله بعد طی میکنیم. ابتدا، ماهیت مجموعههای داده مختلف مورد استفاده برای مورد استفاده خود و نحوه پیوستن ما به این مجموعه دادهها از طریق Data Wrangler را بررسی میکنیم. پس از اتصال و ادغام مجموعه داده، تبدیلهای فردی را که روی مجموعه داده اعمال میکنیم، مانند re-duplication، مدیریت مقادیر گمشده، و فرمولهای سفارشی توصیف میکنیم، و سپس نحوه استفاده از تحلیل مدل سریع داخلی برای اعتبارسنجی وضعیت فعلی تبدیلها را توضیح میدهیم. برای پیش بینی ها

مجموعه داده ها

برای آزمایش خود، ابتدا داده های بیمار را از مشتری سلامت رفتاری خود دانلود کردیم. این داده ها شامل موارد زیر است:

- داده های ادعاها

- تعداد بازدید از اورژانس

- تعداد ویزیت بیماران بستری

- شمارش داروهای تجویز شده مرتبط با سلامت روان

- کدگذاری وضعیت سلسله مراتبی (HCC) شمارش های مربوط به سلامت روان را تشخیص می دهد

هدف، پیوستن به این مجموعه دادههای جداگانه بر اساس شناسه بیمار و استفاده از دادهها برای پیشبینی تشخیص سلامت روان بود. ما از Data Wrangler برای ایجاد یک مجموعه داده عظیم از چندین میلیون ردیف داده استفاده کردیم که ترکیبی از پنج مجموعه داده جداگانه است. ما همچنین از Data Wrangler برای انجام چندین تبدیل استفاده کردیم تا بتوانیم محاسبات ستونی را انجام دهیم. در بخشهای بعدی، تبدیلهای مختلف آمادهسازی دادهها را که اعمال کردیم، توضیح میدهیم.

ستون های تکراری را پس از پیوستن رها کنید

Amazon SageMaker Data Wrangler تبدیلهای دادههای ML متعددی را برای سادهسازی تمیز کردن، تبدیل، و ویژگی دادههای شما فراهم میکند. هنگامی که یک تبدیل اضافه می کنید، یک مرحله به جریان داده اضافه می کند. هر تبدیلی که اضافه می کنید مجموعه داده شما را اصلاح می کند و یک دیتافریم جدید تولید می کند. تمام تبدیلهای بعدی برای چارچوب دادهای اعمال میشود. Data Wrangler شامل تبدیل های داخلی است که می توانید از آنها برای تبدیل ستون ها بدون هیچ کدی استفاده کنید. همچنین میتوانید با استفاده از PySpark، Pandas و PySpark SQL تبدیلهای سفارشی اضافه کنید. برخی از تبدیل ها در جای خود عمل می کنند، در حالی که برخی دیگر یک ستون خروجی جدید در مجموعه داده شما ایجاد می کنند.

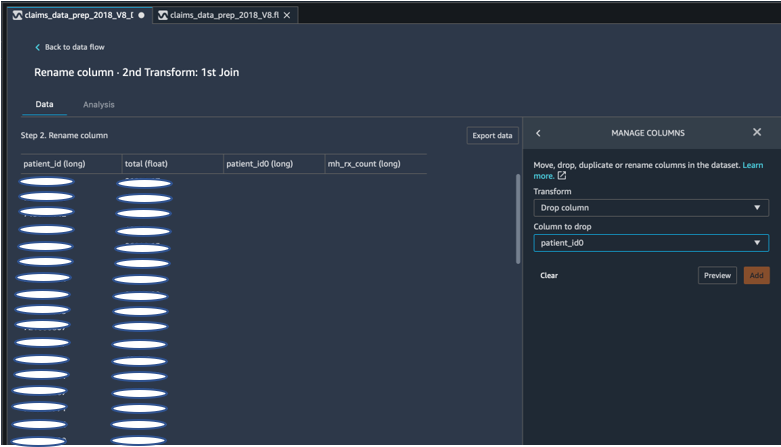

برای آزمایشهای ما، از آنجایی که پس از هر عضویت در شناسه بیمار، ستونهای شناسه بیمار تکراری باقی میماند. ما باید این ستون ها را رها کنیم. همانطور که در تصویر زیر با استفاده از از پیش ساخته شده نشان داده شده است، ستون ID بیمار سمت راست را رها کردیم مدیریت ستون ها ->رها کردن ستون تبدیل، برای حفظ تنها یک ستون ID بیمار (patient_id در مجموعه داده نهایی).

یک مجموعه داده را با استفاده از پانداها محور کنید

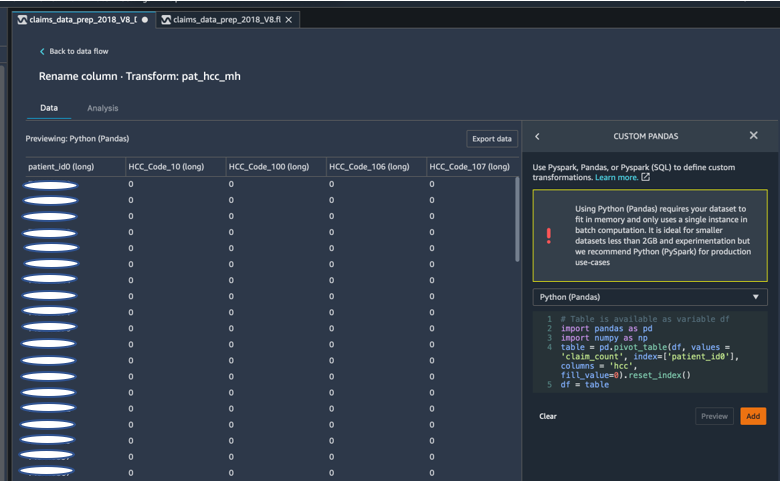

مجموعه دادههای ادعاها در سطح بیمار با ویزیت اضطراری (ER)، بستری (IP)، تعداد نسخهها و دادههای تشخیصی بود که قبلاً براساس کدهای HCC مربوطه آنها (تقریباً 189 کد) گروهبندی شده بودند. برای ایجاد یک دیتامارکت بیمار، کدهای HCC ادعاها را بر اساس بیمار جمع میکنیم و کد HCC را از ردیفها به ستونها میچرخانیم. ما از پانداها برای چرخش مجموعه داده، شمارش تعداد کدهای HCC توسط بیمار و سپس پیوستن به مجموعه داده اولیه در شناسه بیمار استفاده کردیم. ما از گزینه تبدیل سفارشی در Data Wrangler استفاده کردیم که پایتون (Pandas) را به عنوان چارچوب انتخابی انتخاب کرد.

قطعه کد زیر منطق تبدیل برای چرخاندن جدول را نشان می دهد:

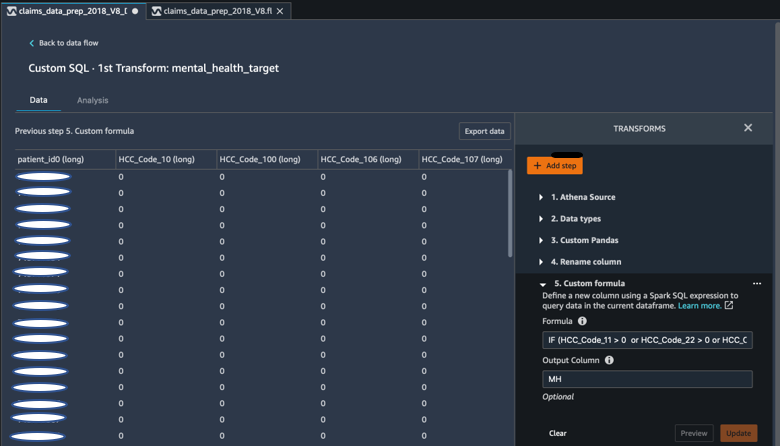

با استفاده از فرمول های سفارشی ستون های جدید ایجاد کنید

ما ادبیات تحقیقاتی را مطالعه کردیم تا مشخص کنیم کدام کدهای HCC در تشخیص سلامت روان قطعی هستند. سپس این منطق را با استفاده از تبدیل فرمول سفارشی Data Wrangler نوشتیم که از عبارت Spark SQL برای محاسبه ستون هدف تشخیص سلامت روان (MH) استفاده میکند، که آن را به انتهای DataFrame اضافه کردیم.

ما از منطق تبدیل زیر استفاده کردیم:

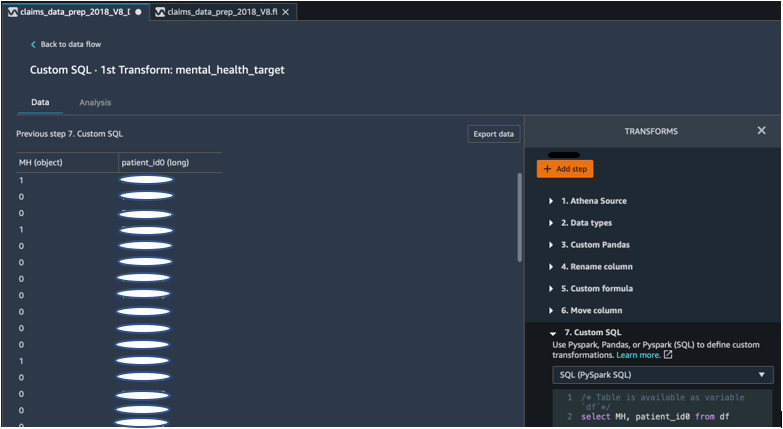

با استفاده از PySpark، ستون ها را از DataFrame رها کنید

پس از محاسبه ستون هدف (MH)، تمام ستون های تکراری غیر ضروری را حذف کردیم. ما شناسه بیمار و ستون MH را برای پیوستن به مجموعه داده اولیه خود حفظ کردیم. این توسط یک تبدیل SQL سفارشی که از PySpark SQL به عنوان چارچوب انتخابی ما استفاده میکند، تسهیل شد.

ما از منطق زیر استفاده کردیم:

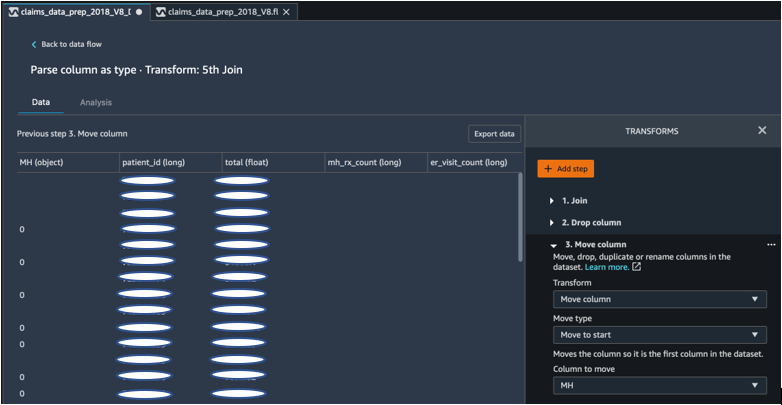

ستون MH را برای شروع حرکت دهید

الگوریتم ML ما نیاز دارد که ورودی برچسبگذاری شده در ستون اول باشد. بنابراین، ستون محاسبه شده MH را به ابتدای DataFrame منتقل کردیم تا برای صادرات آماده شود.

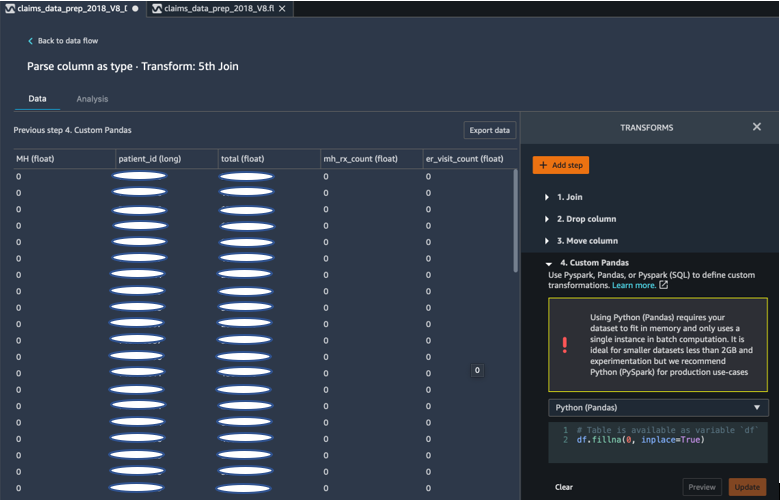

با استفاده از پاندا جاهای خالی را با 0 پر کنید

الگوریتم ML ما همچنین مستلزم این است که داده ورودی هیچ فیلد خالی نداشته باشد. بنابراین، فیلدهای خالی مجموعه داده نهایی را با 0 پر کردیم. ما به راحتی می توانیم این کار را از طریق تبدیل سفارشی (Pandas) در Data Wrangler انجام دهیم.

ما از منطق زیر استفاده کردیم:

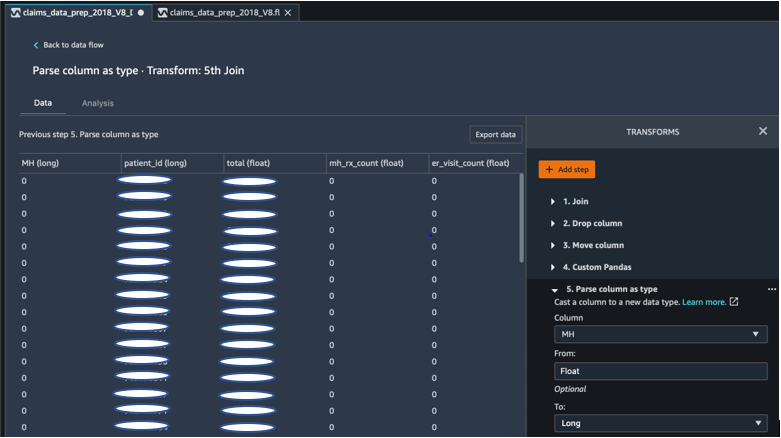

ستون ریخته گری از شناور به طولانی

همچنین می توانید به راحتی در Data Wrangler یک ستون را به هر نوع داده جدیدی تجزیه و ارسال کنید. برای اهداف بهینه سازی حافظه، ما ستون ورودی برچسب سلامت روان خود را به صورت شناور قرار می دهیم.

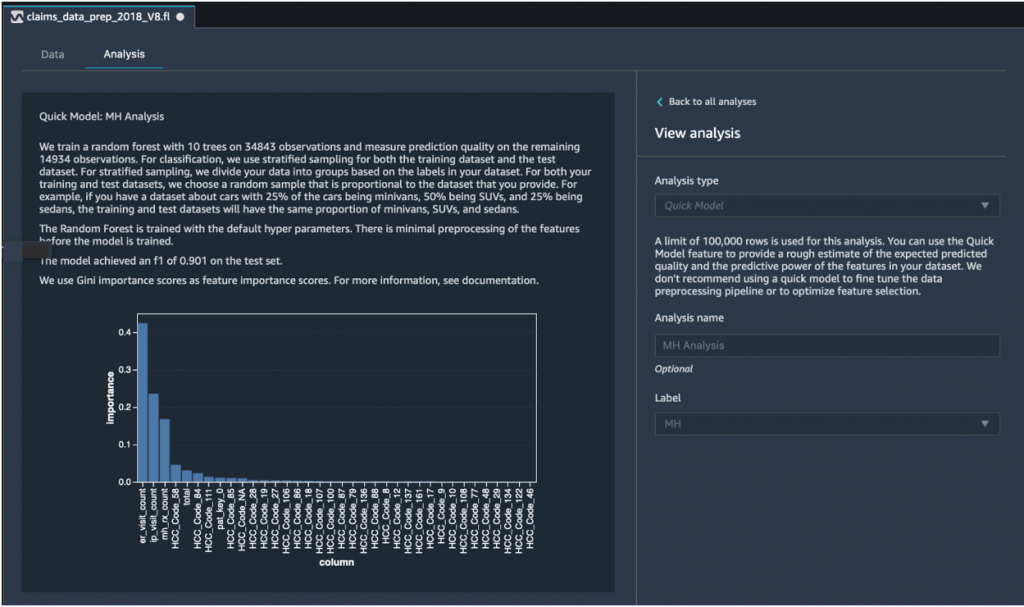

تجزیه و تحلیل سریع مدل: نمودار اهمیت ویژگی

پس از ایجاد مجموعه داده نهایی، از نوع تحلیل مدل سریع در Data Wrangler برای شناسایی سریع ناهماهنگیهای دادهها و اینکه آیا دقت مدل ما در محدوده مورد انتظار بود یا اگر قبل از صرف زمان برای آموزش مدل نیاز به ادامه مهندسی ویژگیها داشتیم، استفاده کردیم. این مدل امتیاز F1 0.901 را به دست آورد که 1 بالاترین امتیاز را داشت. امتیاز F1 روشی برای ترکیب دقت و یادآوری مدل است و به عنوان میانگین هارمونیک این دو تعریف می شود. پس از بررسی این نتایج مثبت اولیه، ما آماده بودیم که داده ها را صادر کنیم و آموزش مدل را با استفاده از مجموعه داده صادر شده ادامه دهیم.

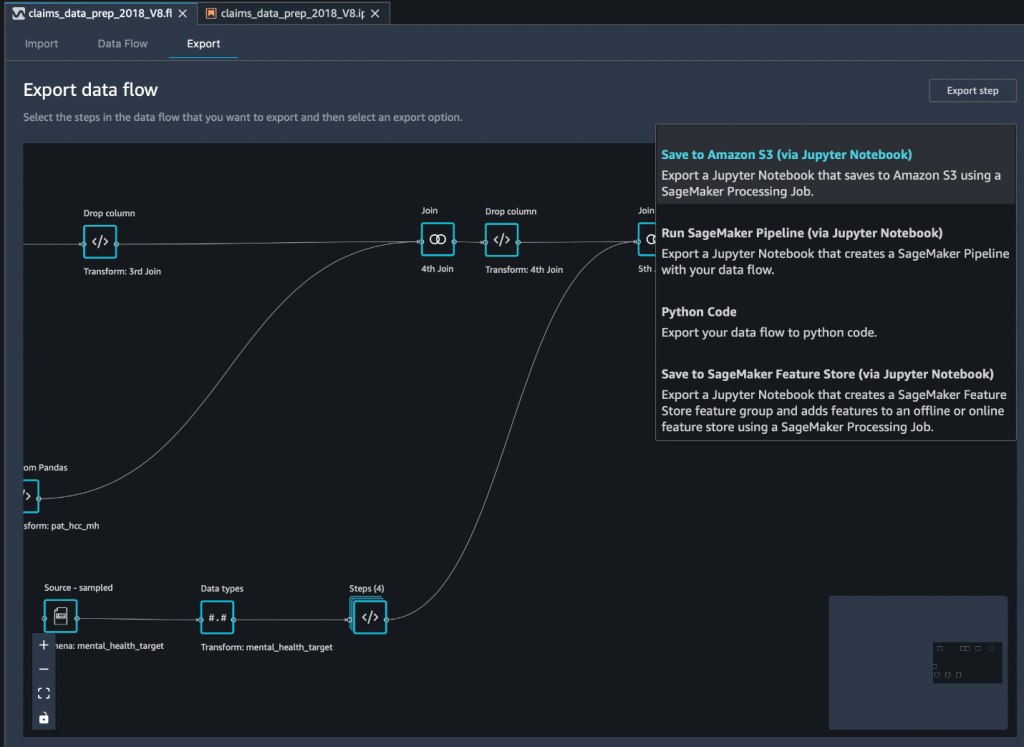

داده نهایی را از طریق یک نوت بوک Jupyter به Amazon S3 صادر کنید

به عنوان آخرین مرحله، صادرات مجموعه داده به شکل فعلی (تبدیل شده) به سرویس ذخیره سازی ساده آمازون (Amazon S3) برای استفاده در آینده در آموزش مدل، از ذخیره در Amazon S3 (از طریق Jupyter Notebook) گزینه صادرات این نوت بوک توزیع شده و مقیاس پذیر را شروع می کند پردازش آمازون SageMaker شغلی که دستور ایجاد شده (جریان داده) را در ورودی های مشخص (معمولا مجموعه داده های بزرگتر) اعمال می کند و نتایج را در Amazon S3 ذخیره می کند. همچنین میتوانید ستونهای (ویژگیهای) تبدیلشده خود را به آن صادر کنید فروشگاه ویژگی آمازون SageMaker یا با استفاده از تبدیل ها را به عنوان خط لوله صادر کنید خطوط لوله آمازون SageMaker، یا به سادگی تبدیل ها را به عنوان کد پایتون صادر کنید.

برای صادرات داده به آمازون S3، سه گزینه دارید:

- داده های تبدیل شده را مستقیماً از طریق رابط کاربری Data Wrangler به Amazon S3 صادر کنید

- تبدیل ها را به عنوان یک کار پردازش SageMaker از طریق یک نوت بوک Jupyter صادر کنید (همانطور که برای این پست انجام می دهیم).

- تبدیل ها را از طریق یک گره مقصد به آمازون S3 صادر کنید. یک گره مقصد به Data Wrangler میگوید که پس از پردازش دادهها را کجا ذخیره کند. پس از ایجاد یک گره مقصد، یک کار پردازشی برای خروجی داده ایجاد می کنید.

نتیجه

در این پست، ما نشان دادیم که چگونه Equilibrium Point IoT از Data Wrangler برای سرعت بخشیدن به فرآیند بارگیری مقادیر زیادی از داده های ادعاهای ما برای تمیز کردن و تبدیل داده ها در آماده سازی برای ML استفاده می کند. ما همچنین نشان دادیم که چگونه میتوان مهندسی ویژگی را با تبدیلهای سفارشی با استفاده از Pandas و PySpark در Data Wrangler ترکیب کرد و به ما اجازه داد که دادهها را مرحله به مرحله (پس از هر عضویت) برای اهداف تضمین کیفیت صادر کنیم. استفاده از این تبدیلهای آسان برای استفاده در Data Wrangler زمان صرف شده برای تبدیل دادههای انتها به انتها را نزدیک به 50% کاهش میدهد. همچنین، ویژگی تحلیل مدل سریع در Data Wrangler به ما این امکان را میدهد که به راحتی وضعیت تبدیلها را در حین چرخه فرآیند آمادهسازی دادهها و مهندسی ویژگیها تأیید کنیم.

اکنون که دادهها را برای مورد استفاده از مدلسازی خطر سلامت روان آماده کردهایم، به عنوان گام بعدی، قصد داریم یک مدل ML با استفاده از SageMaker و الگوریتمهای داخلی ارائهشده توسط آن بسازیم و از مجموعه دادههای ادعاهای خود برای شناسایی اعضایی که باید به دنبال سلامت روان باشند، استفاده کنیم. خدمات قبل از رسیدن به نقطه ای که به آن نیاز دارند. گوش به زنگ باشید!

درباره نویسنده

شیبانگی سها دانشمند داده در Equilibrium Point است. او تخصص خود را در دادههای ادعای پرداختکنندگان مراقبتهای بهداشتی و یادگیری ماشینی برای طراحی، پیادهسازی، خودکارسازی و مستندسازی خطوط لوله دادههای سلامت، گزارشدهی و فرآیندهای تحلیلی که بینشها و پیشرفتهای عملی در سیستم ارائه مراقبتهای بهداشتی را هدایت میکنند، ترکیب میکند. شیبانگی کارشناسی ارشد خود را در بیوانفورماتیک از کالج علوم دانشگاه نورث ایسترن و لیسانس علوم زیست شناسی و علوم کامپیوتر را از دانشکده علوم کامپیوتر و علوم اطلاعات خوری دریافت کرد.

شیبانگی سها دانشمند داده در Equilibrium Point است. او تخصص خود را در دادههای ادعای پرداختکنندگان مراقبتهای بهداشتی و یادگیری ماشینی برای طراحی، پیادهسازی، خودکارسازی و مستندسازی خطوط لوله دادههای سلامت، گزارشدهی و فرآیندهای تحلیلی که بینشها و پیشرفتهای عملی در سیستم ارائه مراقبتهای بهداشتی را هدایت میکنند، ترکیب میکند. شیبانگی کارشناسی ارشد خود را در بیوانفورماتیک از کالج علوم دانشگاه نورث ایسترن و لیسانس علوم زیست شناسی و علوم کامپیوتر را از دانشکده علوم کامپیوتر و علوم اطلاعات خوری دریافت کرد.

گراسیلا کراتزوف بنیانگذار و مدیر ارشد فناوری Equilibrium Point است. گریس سمتهای رهبری سطح C/VP را در مهندسی، عملیات و کیفیت داشته است و بهعنوان مشاور اجرایی برای استراتژی کسبوکار و توسعه محصول در صنایع بهداشت و درمان و آموزش و فضای صنعتی IoT خدمت کرده است. گریس مدرک کارشناسی ارشد در رشته مهندسی الکترومکانیک از دانشگاه بوئنوس آیرس و مدرک کارشناسی ارشد در علوم کامپیوتر از دانشگاه بوستون دریافت کرد.

گراسیلا کراتزوف بنیانگذار و مدیر ارشد فناوری Equilibrium Point است. گریس سمتهای رهبری سطح C/VP را در مهندسی، عملیات و کیفیت داشته است و بهعنوان مشاور اجرایی برای استراتژی کسبوکار و توسعه محصول در صنایع بهداشت و درمان و آموزش و فضای صنعتی IoT خدمت کرده است. گریس مدرک کارشناسی ارشد در رشته مهندسی الکترومکانیک از دانشگاه بوئنوس آیرس و مدرک کارشناسی ارشد در علوم کامپیوتر از دانشگاه بوستون دریافت کرد.

آرونپراسات شانکار یک معمار راه حل های تخصصی هوش مصنوعی و یادگیری ماشین (AI/ML) با AWS است که به مشتریان جهانی کمک می کند راه حل های هوش مصنوعی خود را به طور موثر و کارآمد در فضای ابری مقیاس کنند. آرون در اوقات فراغت خود از تماشای فیلم های علمی تخیلی و گوش دادن به موسیقی کلاسیک لذت می برد.

آرونپراسات شانکار یک معمار راه حل های تخصصی هوش مصنوعی و یادگیری ماشین (AI/ML) با AWS است که به مشتریان جهانی کمک می کند راه حل های هوش مصنوعی خود را به طور موثر و کارآمد در فضای ابری مقیاس کنند. آرون در اوقات فراغت خود از تماشای فیلم های علمی تخیلی و گوش دادن به موسیقی کلاسیک لذت می برد.

آجای شارما مدیر محصول ارشد آمازون SageMaker است که در آن بر SageMaker Data Wrangler، یک ابزار آماده سازی داده های بصری برای دانشمندان داده تمرکز می کند. قبل از AWS، Ajai کارشناس علوم داده در McKinsey and Company بود که در آنجا فعالیتهای متمرکز بر ML را برای شرکتهای مالی و بیمه پیشرو در سراسر جهان رهبری میکرد. Ajai علاقه زیادی به علم داده دارد و دوست دارد جدیدترین الگوریتم ها و تکنیک های یادگیری ماشین را کشف کند.

آجای شارما مدیر محصول ارشد آمازون SageMaker است که در آن بر SageMaker Data Wrangler، یک ابزار آماده سازی داده های بصری برای دانشمندان داده تمرکز می کند. قبل از AWS، Ajai کارشناس علوم داده در McKinsey and Company بود که در آنجا فعالیتهای متمرکز بر ML را برای شرکتهای مالی و بیمه پیشرو در سراسر جهان رهبری میکرد. Ajai علاقه زیادی به علم داده دارد و دوست دارد جدیدترین الگوریتم ها و تکنیک های یادگیری ماشین را کشف کند.

- Coinsmart. بهترین صرافی بیت کوین و کریپتو اروپا.

- پلاتوبلاک چین. Web3 Metaverse Intelligence. دانش تقویت شده دسترسی رایگان.

- CryptoHawk. رادار آلت کوین امتحان رایگان.

- منبع: https://aws.amazon.com/blogs/machine-learning/build-a-mental-mental-machine-learning-risk-model-using-amazon-sagemaker-data-wrangler/

- "

- 100

- 2020

- درباره ما

- مطابق

- در میان

- AI

- الگوریتم

- الگوریتم

- معرفی

- اجازه دادن

- قبلا

- آمازون

- در میان

- مقدار

- تحلیل

- علم تجزیه و تحلیل

- اضطراب

- کاربرد

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی و یادگیری ماشین

- در دسترس

- AWS

- بودن

- زیست شناسی

- مرز

- بوستون

- ساختن

- بنا

- ساخته شده در

- کسب و کار

- ادعای

- تمیز کاری

- ابر

- بنیانگذاران

- رمز

- برنامه نویسی

- کالج

- ستون

- شرکت

- پیچیده

- جزء

- علم کامپیوتر

- شرط

- تثبیت

- مشاور

- ادامه دادن

- کنترل

- هزینه

- ایجاد

- بحرانی

- CTO

- جاری

- وضعیت فعلی

- سفارشی

- مشتریان

- داده ها

- پردازش داده ها

- علم اطلاعات

- دانشمند داده

- تحویل

- نشان

- افسردگی

- طرح

- توسعه

- پروژه

- مرض

- توزیع شده

- پایین

- راندن

- قطره

- کاهش یافته است

- در اوایل

- به آسانی

- آموزش

- اثرات

- انرژی

- مهندس

- مهندسی

- مورد تأیید

- حصول اطمینان از

- تخمین زدن

- اجرایی

- انتظار می رود

- با تجربه

- تجربه

- تخصص

- اکتشاف

- خانواده

- ویژگی

- امکانات

- زمینه

- سرمایه گذاری

- نام خانوادگی

- جریان

- تمرکز

- پیروی

- فرم

- چارچوب

- آینده

- جهانی

- هدف

- اداره

- داشتن

- سلامتی

- بهداشت و درمان

- کمک

- بالاتر

- چگونه

- چگونه

- HTTPS

- شناسایی

- بیماری

- انجام

- اهمیت

- از جمله

- افزایش

- افزایش

- فرد

- صنعتی

- لوازم

- اطلاعات

- بینش

- بیمه

- ادغام

- اطلاعات

- اینترنت اشیا

- IP

- IT

- کار

- شغل ها

- پیوستن

- پیوست

- می پیوندد

- بزرگ

- بزرگتر

- آخرین

- رهبری

- برجسته

- یادگیری

- رهبری

- سطح

- استماع

- ادبیات

- کوچک

- دستگاه

- فراگیری ماشین

- حفظ

- مدیر

- مدیریت

- عظیم

- اعضا

- حافظه

- سلامت روان

- میلیون

- ML

- مدل

- مدل

- بیش

- اکثر

- فیلم ها

- موسیقی

- طبیعت

- دفتر یادداشت

- عدد

- متعدد

- پیشنهادات

- عملیات

- بهینه سازی

- گزینه

- گزینه

- بیماری همه گیر

- محور

- نقطه

- مثبت

- پیش بینی

- پیش گویی

- پیش بینی

- نسخه

- اصلی

- روند

- فرآیندهای

- محصول

- برنامه ها

- فراهم می کند

- اهداف

- کیفیت

- سوال

- به سرعت

- محدوده

- نرخ

- خام

- سوابق

- گزارش

- تحقیق

- منابع

- نتایج

- خطر

- سعید

- مقیاس پذیر

- مقیاس

- علم

- علوم

- دانشمند

- دانشمندان

- خدمات

- اشتراک گذاری

- قابل توجه

- ساده

- راه حل

- مزایا

- فضا

- سرعت

- هزینه

- صحنه

- شروع

- آغاز شده

- شروع می شود

- دولت

- ماندن

- ذخیره سازی

- opbevare

- داده ها را ذخیره کنید

- استراتژی

- فشار

- ماده

- قابل توجه

- سیستم

- هدف

- تکنیک

- می گوید

- از طریق

- سراسر

- زمان

- ابزار

- آموزش

- دگرگون کردن

- دگرگونی

- تبدیل شدن

- رفتار

- به طور معمول

- دانشگاه

- us

- استفاده کنید

- معمولا

- استفاده کنید

- مختلف

- WHO

- در داخل

- بدون

- در سرتاسر جهان