هوش مصنوعی مولد به ابزاری رایج برای تقویت و تسریع فرآیند خلاقیت در صنایع مختلف از جمله سرگرمی، تبلیغات و طراحی گرافیک تبدیل شده است. این تجربههای شخصیسازیشدهتری را برای مخاطبان فراهم میکند و کیفیت کلی محصولات نهایی را بهبود میبخشد.

یکی از مزایای قابل توجه هوش مصنوعی مولد ایجاد تجربیات منحصر به فرد و شخصی برای کاربران است. به عنوان مثال، هوش مصنوعی مولد توسط سرویسهای پخش برای تولید عناوین فیلم و تصاویر شخصیسازی شده برای افزایش تعامل بیننده و ساخت تصاویر بصری برای عناوین بر اساس تاریخچه مشاهده و ترجیحات کاربر استفاده میشود. سپس این سیستم هزاران تنوع از آثار هنری یک عنوان را تولید می کند و آنها را آزمایش می کند تا مشخص کند کدام نسخه بیشتر توجه کاربر را به خود جلب می کند. در برخی موارد، آثار هنری شخصیسازیشده برای مجموعههای تلویزیونی به طور قابلتوجهی نرخ کلیک و نرخ بازدید را در مقایسه با نمایشهای بدون آثار هنری شخصیشده افزایش میدهد.

در این پست، نشان میدهیم که چگونه میتوانید از مدلهای هوش مصنوعی مانند Stable Diffusion برای ایجاد یک راهحل آواتار شخصیسازی شده استفاده کنید. آمازون SageMaker و همزمان با استفاده از نقاط پایانی چند مدلی (MME) در هزینه استنتاج صرفه جویی کنید. راه حل نشان می دهد که چگونه، با آپلود 10 تا 12 تصویر از خود، می توانید یک مدل شخصی سازی شده را تنظیم کنید که سپس می تواند آواتارها را بر اساس هر پیام متنی، همانطور که در تصاویر زیر نشان داده شده است، ایجاد کند. اگرچه این مثال آواتارهای شخصی سازی شده را تولید می کند، اما می توانید با تنظیم دقیق اشیاء یا سبک های خاص، این تکنیک را برای هر نسل هنری خلاقانه اعمال کنید.

بررسی اجمالی راه حل

نمودار معماری زیر راه حل انتها به انتها برای مولد آواتار ما را تشریح می کند.

![]()

محدوده این پست و مثال کد GitHub ما فقط بر روی آموزش مدل و ارکستراسیون استنتاج تمرکز می کنیم (بخش سبز در نمودار قبل). میتوانید به معماری راهحل کامل اشاره کنید و بر روی نمونهای که ما ارائه میدهیم، بسازید.

آموزش مدل و استنتاج را می توان به چهار مرحله تقسیم کرد:

- آپلود تصاویر به سرویس ذخیره سازی ساده آمازون (Amazon S3). در این مرحله از شما می خواهیم حداقل 10 تصویر با وضوح بالا از خود ارائه دهید. هرچه تعداد تصاویر بیشتر باشد، نتیجه بهتری حاصل می شود، اما زمان بیشتری برای آموزش لازم است.

- یک مدل پایه Stable Diffusion 2.1 را با استفاده از استنتاج ناهمزمان SageMaker تنظیم کنید. در ادامه این پست دلیل استفاده از نقطه پایانی استنتاج برای آموزش را توضیح می دهیم. فرآیند تنظیم دقیق با آماده سازی تصاویر، از جمله برش چهره، تغییر پس زمینه و تغییر اندازه برای مدل شروع می شود. سپس ما از تطبیق با رتبه پایین (LoRA)، یک تکنیک تنظیم دقیق پارامترهای کارآمد برای مدلهای زبان بزرگ (LLM) برای تنظیم دقیق مدل استفاده میکنیم. در نهایت، در پس پردازش، وزنهای LoRA تنظیمشده را با اسکریپت استنتاج و فایلهای پیکربندی (tar.gz) بستهبندی میکنیم و آنها را در یک مکان سطل S3 برای MMEهای SageMaker آپلود میکنیم.

- با استفاده از SageMaker MME با GPU، مدلهای تنظیمشده را میزبانی کنید. SageMaker به صورت پویا مدل را از محل آمازون S3 بر اساس ترافیک استنتاج به هر مدل بارگیری و ذخیره می کند.

- برای استنباط از مدل دقیق تنظیم شده استفاده کنید. بعد از سرویس اطلاع رسانی ساده آمازون اعلان (Amazon SNS) که نشان می دهد تنظیم دقیق ارسال شده است، می توانید بلافاصله با ارائه یک مدل از آن استفاده کنید.

target_modelپارامتر هنگام فراخوانی MME برای ایجاد آواتار شما.

هر مرحله را با جزئیات بیشتری در بخشهای بعدی توضیح میدهیم و برخی از نمونههای کد کد را مرور میکنیم.

تصاویر را آماده کنید

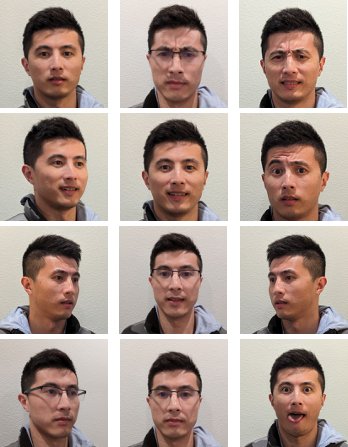

برای دستیابی به بهترین نتایج از تنظیم دقیق Stable Diffusion برای ایجاد تصاویری از خود، معمولاً باید تعداد و تنوع زیادی از عکسهای خود را از زوایای مختلف، با عبارات مختلف و در پسزمینههای مختلف تهیه کنید. با این حال، با پیاده سازی ما، اکنون می توانید با حداقل 10 تصویر ورودی به نتیجه ای با کیفیت بالا برسید. ما همچنین پیش پردازش خودکار را برای استخراج چهره شما از هر عکس اضافه کرده ایم. تنها چیزی که نیاز دارید این است که ماهیت ظاهر خود را به وضوح از منظرهای مختلف به تصویر بکشید. شامل یک عکس از جلو، یک نمایه عکس از هر طرف، و عکسهایی از زوایای بین آنها باشید. همچنین باید عکس هایی با حالات صورت مختلف مانند لبخند زدن، اخم کردن و حالت خنثی قرار دهید. ترکیبی از عبارات به مدل اجازه می دهد تا ویژگی های منحصر به فرد صورت شما را بهتر بازتولید کند. تصاویر ورودی کیفیت آواتاری را که میتوانید تولید کنید، تعیین میکند. برای اطمینان از اینکه این کار به درستی انجام می شود، یک تجربه رابط کاربری بصری جلویی را برای راهنمایی کاربر در فرآیند ضبط و آپلود تصویر توصیه می کنیم.

تصاویر زیر نمونه ای از تصاویر سلفی در زوایای مختلف با حالات چهره متفاوت هستند.

![]()

یک مدل انتشار پایدار را تنظیم دقیق کنید

پس از آپلود تصاویر در آمازون S3، میتوانیم آن را فراخوانی کنیم استنتاج ناهمزمان SageMaker نقطه پایانی برای شروع فرآیند آموزشی ما. نقاط پایانی ناهمزمان برای موارد استفاده استنتاج با بارهای بزرگ (تا 1 گیگابایت) و زمان پردازش طولانی (تا 1 ساعت) در نظر گرفته شده است. همچنین یک مکانیسم صف داخلی برای قرار دادن درخواستها در صف و یک مکانیسم اعلان تکمیل کار از طریق Amazon SNS، علاوه بر سایر ویژگیهای بومی میزبانی SageMaker مانند مقیاسبندی خودکار، ارائه میکند.

اگرچه تنظیم دقیق یک مورد استفاده از استنتاج نیست، ما به دلیل مکانیسمهای صف و اعلان داخلی آن، به جای مشاغل آموزشی SageMaker از آن استفاده کردیم. مقیاس خودکار مدیریت شده، از جمله توانایی کوچک کردن تا 0 مواردی که از سرویس استفاده نمی شود. این به ما اجازه می دهد تا به راحتی سرویس تنظیم دقیق را برای تعداد زیادی از کاربران همزمان مقیاس کنیم و نیاز به پیاده سازی و مدیریت اجزای اضافی را از بین می برد. با این حال، این مشکل با ظرفیت 1 گیگابایتی و حداکثر زمان پردازش 1 ساعت است. در آزمایش ما متوجه شدیم که 20 دقیقه زمان کافی برای به دست آوردن نتایج نسبتا خوب با تقریباً 10 تصویر ورودی در یک نمونه ml.g5.2xlarge است. با این حال، آموزش SageMaker رویکرد توصیه شده برای کارهای تنظیم دقیق مقیاس بزرگتر خواهد بود.

برای میزبانی نقطه پایانی ناهمزمان، باید چندین مرحله را انجام دهیم. اولین مورد این است که سرور مدل خود را تعریف کنیم. برای این پست از ظرف استنتاج مدل بزرگ (LMI). LMI توسط DJL Serving، که یک راه حل ارائه مدل زبان برنامه نویسی با عملکرد بالا است، ارائه می شود. ما این گزینه را انتخاب کردیم زیرا محفظه استنتاج مدیریت شده SageMaker در حال حاضر بسیاری از کتابخانه های آموزشی مورد نیاز ما را دارد، مانند Hugging Face پخش کننده و شتاب دادن. این مقدار کار مورد نیاز برای سفارشی کردن ظرف برای کار تنظیم دقیق ما را تا حد زیادی کاهش می دهد.

قطعه کد زیر نسخه کانتینر LMI را نشان می دهد که در مثال خود استفاده کرده ایم:

علاوه بر آن، ما باید یک serving.properties فایلی که ویژگیهای سرویس، از جمله موتور استنتاج مورد استفاده، مکان آرتیفکت مدل و دستهبندی پویا را پیکربندی میکند. در نهایت، ما باید یک model.py فایلی که مدل را در موتور استنتاج بارگذاری می کند و ورودی و خروجی داده را از مدل آماده می کند. در مثال ما از model.py فایل برای چرخش کار تنظیم دقیق، که در بخش بعدی با جزئیات بیشتر توضیح خواهیم داد. هر دو serving.properties و model.py فایل ها در training_service پوشه.

گام بعدی پس از تعریف سرور مدل ما، ایجاد یک پیکربندی نقطه پایانی است که نحوه ارائه استنتاج ناهمزمان ما را مشخص می کند. برای مثال، ما فقط حداکثر حد فراخوانی همزمان و محل خروجی S3 را تعریف می کنیم. با ml.g5.2xlarge به عنوان مثال، ما دریافتیم که میتوانیم تا دو مدل را به طور همزمان تنظیم کنیم، بدون اینکه با یک استثنای خارج از حافظه (OOM) مواجه شویم، و بنابراین تنظیم کردیم max_concurrent_invocations_per_instance به 2. اگر از مجموعه پارامترهای تنظیم متفاوت یا نوع نمونه کوچکتری استفاده می کنیم، ممکن است این عدد نیاز به تنظیم داشته باشد. توصیه می کنیم ابتدا این را روی 1 تنظیم کنید و میزان استفاده از حافظه GPU را در آن نظارت کنید CloudWatch آمازون.

در نهایت یک مدل SageMaker ایجاد می کنیم که اطلاعات کانتینر، فایل های مدل و هویت AWS و مدیریت دسترسی (IAM) نقش یک شیء واحد. مدل با استفاده از پیکربندی نقطه پایانی که قبلا تعریف کردیم مستقر می شود:

وقتی نقطه پایانی آماده شد، از کد نمونه زیر برای فراخوانی نقطه پایانی ناهمزمان و شروع فرآیند تنظیم دقیق استفاده میکنیم:

برای جزئیات بیشتر در مورد LMI در SageMaker، مراجعه کنید استقرار مدل های بزرگ در Amazon SageMaker با استفاده از استنتاج موازی مدل DJLServing و DeepSpeed.

پس از فراخوانی، نقطه پایانی ناهمزمان شروع به صفبندی کار تنظیم دقیق ما میکند. هر کار مراحل زیر را طی میکند: آمادهسازی تصاویر، تنظیم دقیق Dreambooth و LoRA، و آمادهسازی آرتیفکتهای مدل. بیایید عمیق تر به فرآیند تنظیم دقیق شیرجه بزنیم.

تصاویر را آماده کنید

همانطور که قبلاً اشاره کردیم، کیفیت تصاویر ورودی مستقیماً بر کیفیت مدل تنظیم شده تأثیر می گذارد. برای مورد استفاده از آواتار، ما می خواهیم مدل روی ویژگی های صورت تمرکز کند. به جای اینکه از کاربران بخواهیم تصاویری با اندازه و محتوای دقیق ارائه دهند، ما یک مرحله پیش پردازش را با استفاده از تکنیک های بینایی کامپیوتری برای کاهش این بار اجرا می کنیم. در مرحله پیش پردازش، ابتدا از یک مدل تشخیص چهره برای جداسازی بزرگترین چهره در هر تصویر استفاده می کنیم. سپس تصویر را به اندازه مورد نیاز 512×512 پیکسل برای مدل خود برش و پد می زنیم. در نهایت، صورت را از پس زمینه جدا می کنیم و تغییرات پس زمینه تصادفی را اضافه می کنیم. این به برجسته کردن ویژگیهای صورت کمک میکند و به مدل ما اجازه میدهد تا از خود چهره به جای پسزمینه یاد بگیرد. تصاویر زیر سه مرحله این فرآیند را نشان می دهد.

| مرحله 1: تشخیص چهره با استفاده از بینایی کامپیوتری | مرحله 2: تصویر را برش داده و به اندازه ۵۱۲ در ۵۱۲ پیکسل قرار دهید | مرحله 3 (اختیاری): تقسیم بندی و تنوع پس زمینه اضافه کنید |

تنظیم دقیق Dreambooth و LoRA

برای تنظیم دقیق، تکنیکهای Dreambooth و LoRA را با هم ترکیب کردیم. Dreambooth به شما این امکان را می دهد که مدل Stable Diffusion خود را شخصی کنید، یک موضوع را با استفاده از یک شناسه منحصر به فرد در دامنه خروجی مدل جاسازی کنید و فرهنگ لغت بینایی زبان مدل را گسترش دهید. از روشی به نام استفاده می کند نگهداری قبلی برای حفظ دانش معنایی مدل از کلاس موضوع، در این مورد یک شخص، و استفاده از اشیاء دیگر در کلاس برای بهبود خروجی تصویر نهایی. بدین ترتیب Dreambooth می تواند تنها با چند عکس ورودی از سوژه به نتایج باکیفیتی دست یابد.

قطعه کد زیر ورودی های ما را نشان می دهد trainer.py کلاس برای راه حل آواتار ما. توجه کنید که ما انتخاب کردیم <<TOK>> به عنوان شناسه منحصر به فرد این کار عمداً برای جلوگیری از انتخاب نامی که ممکن است قبلاً در فرهنگ لغت مدل وجود داشته باشد انجام می شود. اگر نام از قبل وجود داشته باشد، مدل باید موضوع را حذف کند و سپس دوباره یاد بگیرد، که ممکن است منجر به نتایج تنظیم دقیق ضعیف شود. کلاس موضوعی تنظیم شده است “a photo of person”، که با ایجاد اولین عکس از افراد برای تغذیه به عنوان ورودی های اضافی در طول فرآیند تنظیم دقیق، امکان حفظ قبلی را فراهم می کند. این به کاهش بیش از حد برازش کمک می کند زیرا مدل سعی می کند دانش قبلی فرد را با استفاده از روش حفظ قبلی حفظ کند.

تعدادی از گزینه های ذخیره حافظه در پیکربندی فعال شده اند، از جمله fp16, use_8bit_adam، و تجمع گرادیان. این کار باعث کاهش حافظه به کمتر از 12 گیگابایت می شود که امکان تنظیم دقیق حداکثر دو مدل را به طور همزمان در یک ml.g5.2xlarge نمونه.

LoRA یک تکنیک تنظیم دقیق کارآمد برای LLM ها است که بیشتر وزنه ها را منجمد می کند و یک شبکه آداپتور کوچک را به لایه های خاصی از LLM از پیش آموزش دیده متصل می کند و امکان آموزش سریعتر و ذخیره سازی بهینه را فراهم می کند. برای انتشار پایدار، آداپتور به رمزگذار متن و اجزای U-Net خط لوله استنتاج متصل است. رمزگذار متن، اعلان ورودی را به فضای پنهانی تبدیل میکند که توسط مدل U-Net قابل درک است، و مدل U-Net از معنای پنهان برای تولید تصویر در فرآیند انتشار بعدی استفاده میکند. خروجی تنظیم دقیق فقط text_encoder و وزن آداپتور U-Net. در زمان استنتاج، این وزن ها را می توان مجدداً به مدل پایه انتشار پایدار وصل کرد تا نتایج تنظیم دقیق را بازتولید کند.

شکل های زیر نمودار جزئیات تنظیم دقیق LoRA است که توسط نویسنده اصلی ارائه شده است: چنگ هان چیانگ، یونگ سونگ چوانگ، هونگ یی لی، «AACL_2022_tutorial_PLMs»، 2022

با ترکیب هر دو روش، ما توانستیم یک مدل شخصی سازی شده ایجاد کنیم و در عین حال پارامترهای مرتبهای کمتری را تنظیم کنیم. این منجر به زمان آموزش بسیار سریعتر و کاهش استفاده از GPU شد. علاوه بر این، فضای ذخیره سازی با وزن آداپتور تنها 70 مگابایت در مقایسه با 6 گیگابایت برای یک مدل پخش پایدار کامل بهینه شده است که نشان دهنده کاهش 99 درصدی اندازه است.

مصنوعات مدل را آماده کنید

پس از تکمیل تنظیم دقیق، مرحله پس پردازش وزنهای LoRA را با بقیه فایلهای ارائهشده مدل برای NVIDIA Triton TAR میکند. ما از یک Backend پایتون استفاده می کنیم، به این معنی که فایل پیکربندی تریتون و اسکریپت پایتون مورد استفاده برای استنتاج مورد نیاز است. توجه داشته باشید که اسکریپت پایتون باید نامگذاری شود model.py. فایل TAR مدل نهایی باید ساختار فایل زیر را داشته باشد:

با استفاده از SageMaker MME با GPU، مدلهای تنظیمشده را میزبانی کنید

پس از تنظیم دقیق مدلها، مدلهای شخصیسازی شده Stable Diffusion را با استفاده از SageMaker MME میزبانی میکنیم. SageMaker MME یک ویژگی استقرار قدرتمند است که امکان میزبانی چندین مدل را در یک ظرف واحد در پشت یک نقطه پایانی واحد فراهم می کند. این به طور خودکار ترافیک و مسیریابی به مدل های شما را برای بهینه سازی استفاده از منابع، صرفه جویی در هزینه ها و به حداقل رساندن بار عملیاتی مدیریت هزاران نقطه پایانی مدیریت می کند. در مثال ما، ما روی نمونههای GPU اجرا میکنیم و SageMaker MME از GPU با استفاده از سرور Triton پشتیبانی میکند. این به شما امکان می دهد چندین مدل را بر روی یک دستگاه GPU اجرا کنید و از محاسبات تسریع شده بهره ببرید. برای جزئیات بیشتر در مورد نحوه میزبانی Stable Diffusion در SageMaker MME، مراجعه کنید با مدلهای Stable Diffusion تصاویری با کیفیت بالا ایجاد کنید و آنها را با هزینه مقرون به صرفه با Amazon SageMaker اجرا کنید..

برای مثال، ما بهینهسازی بیشتری انجام دادیم تا مدلهای تنظیمشده سریعتر در شرایط شروع سرد بارگذاری شوند. این به دلیل طراحی آداپتور LoRA امکان پذیر است. از آنجایی که وزنهای مدل پایه و محیطهای Conda برای همه مدلهای تنظیمشده یکسان است، میتوانیم این منابع مشترک را با بارگذاری اولیه آنها در کانتینر میزبان به اشتراک بگذاریم. این فقط فایل پیکربندی تریتون، باطن پایتون (model.pyو وزنهای آداپتور LoRA به صورت پویا از Amazon S3 پس از اولین فراخوانی بارگیری میشوند. نمودار زیر یک مقایسه کنار هم ارائه می دهد.

![]()

این به طور قابل توجهی فایل مدل TAR را از تقریباً 6 گیگابایت به 70 مگابایت کاهش می دهد و بنابراین بارگذاری و بازکردن آن بسیار سریعتر است. برای انجام پیش بارگذاری در مثال ما، یک مدل باطن پایتون ابزاری ایجاد کردیم models/model_setup. این اسکریپت به سادگی مدل پایه Stable Diffusion و محیط Conda را از Amazon S3 در یک مکان مشترک کپی می کند تا در تمام مدل های تنظیم شده به اشتراک گذاشته شود. در زیر قطعه کدی است که وظیفه را انجام می دهد:

سپس هر مدل تنظیم شده به مکان مشترک روی ظرف اشاره می کند. به محیط Conda اشاره شده است config.pbtxt.

مدل پایه انتشار پایدار از بارگذاری می شود initialize() عملکرد هر کدام model.py فایل. سپس وزنهای LoRA شخصیشده را به unet و اعمال میکنیم text_encoder مدلی برای بازتولید هر مدل با تنظیم دقیق:

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 10

- 100

- 12

- 13

- ٪۱۰۰

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- توانایی

- قادر

- درباره ما

- تسریع شد

- تسریع

- دسترسی

- در دسترس

- تجمع

- رسیدن

- در میان

- انطباق

- اضافه کردن

- اضافه

- اضافه

- اضافی

- علاوه بر این

- تنظیم شده

- مزیت - فایده - سود - منفعت

- تبلیغات

- پس از

- AI

- مدل های هوش مصنوعی

- خدمات هوش مصنوعی

- AI / ML

- معرفی

- کم کردن

- اجازه دادن

- اجازه دادن

- اجازه می دهد تا

- قبلا

- همچنین

- هر چند

- اماتور

- آمازون

- آمازون SageMaker

- آمازون خدمات وب

- محیط

- مقدار

- an

- تشریح

- و

- هر

- برنامه های کاربردی

- درخواست

- روش

- تقریبا

- معماری

- هستند

- هنر

- آثار هنری

- AS

- دارایی

- کمک کردن

- At

- توجه

- جاذبه ها

- جلسات

- نویسنده

- خودکار

- خودکار

- بطور خودکار

- در دسترس

- نماد

- آواتار ها

- اجتناب از

- AWS

- بخش مدیریت

- زمینه

- پس زمینه

- بد

- پایه

- مستقر

- اساسی

- BE

- زیرا

- شدن

- بوده

- پشت سر

- بودن

- در زیر

- سود

- بهترین

- بهتر

- میان

- بدن

- هر دو

- شکسته

- ساختن

- ساخته شده در

- بار

- کسب و کار

- اما

- by

- مخزن

- نام

- CAN

- قابلیت های

- گرفتن

- Осторожно

- مورد

- موارد

- گرفتار

- چالش ها

- بار

- را انتخاب

- سینمایی

- منظره شهر

- کلاس

- به وضوح

- رمز

- سرد

- ترکیب شده

- ترکیب

- بیا

- مشترک

- مقایسه

- مقایسه

- کامل

- اتمام

- پیچیده

- اجزاء

- ترکیب

- محاسبه

- کامپیوتر

- چشم انداز کامپیوتر

- مفهوم

- رقیب

- پیکر بندی

- ظرف

- محتوا

- تبدیل

- هسته

- هزینه

- هزینه

- را پوشش می دهد

- ایجاد

- ایجاد شده

- ایجاد

- خلاقیت

- خالق

- محصول

- سرپرستی

- در حال حاضر

- مشتریان

- سفارشی

- سفارشی

- برش

- داده ها

- روز

- اختصاصی

- عمیق

- یادگیری عمیق

- عمیق تر

- تعريف كردن

- مشخص

- تعریف می کند

- تعریف کردن

- دموکراتیک کردن

- نشان دادن

- نشان

- نشان می دهد

- گسترش

- مستقر

- استقرار

- گسترش

- طرح

- جزئیات

- دقیق

- جزئیات

- کشف

- مشخص کردن

- توسعه دهنده

- دستگاه

- مختلف

- انتشار

- مستقیما

- مختلف

- DIY

- do

- میکند

- دامنه

- انجام شده

- پایین

- پیش نویس

- کشیده شده

- دو

- در طی

- پویا

- بطور پویا

- e

- تجارت الکترونیک

- هر

- پیش از آن

- به آسانی

- موثر

- حذف می شود

- تعبیه کردن

- فعال

- را قادر می سازد

- روبرو شدن

- تشویق

- پشت سر هم

- بی پایان

- نقطه پایانی

- نامزدی

- موتور

- مهندسی

- بالا بردن

- افزایش

- سرمایه گذاری

- سرگرمی

- محیط

- محیط

- EPIC

- ماهیت

- مثال

- مثال ها

- جز

- استثنا

- وجود دارد

- گسترش

- تجربه

- تجارب

- تجربه

- تخصص

- توضیح دهید

- اکتشاف

- قرار گرفتن در معرض

- بیان

- اصطلاحات

- اضافی

- عصاره

- چهره

- چهره

- شکست

- خانواده

- سریعتر

- ویژگی

- امکانات

- پا

- کمی از

- کمتر

- آمار و ارقام

- پرونده

- فایل ها

- نهایی

- سرانجام

- مالی

- نام خانوادگی

- تمرکز

- متمرکز شده است

- تمرکز

- پیروی

- رد پا

- برای

- یافت

- چهار

- FRAME

- از جانب

- کامل

- تابع

- بازیها

- بازی

- تولید می کنند

- تولید می کند

- مولد

- نسل

- مولد

- هوش مصنوعی مولد

- ژنراتور

- دریافت کنید

- GIF

- GitHub

- هدف

- رفتن

- خوب

- GPU

- گرافیک

- بیشتر

- تا حد زیادی

- سبز

- درشت

- راهنمایی

- دست ها

- آیا

- داشتن

- he

- کمک

- کمک

- کمک می کند

- او

- اینجا کلیک نمایید

- عملکرد بالا

- با کیفیت بالا

- کیفیت بالا

- نماد

- خیلی

- خود را

- تاریخ

- امید

- میزبان

- میزبانی وب

- ساعت

- خانه

- چگونه

- چگونه

- اما

- HTML

- HTTP

- HTTPS

- شناسه

- هویت

- if

- تصویر

- تصاویر

- بلافاصله

- اثرات

- انجام

- پیاده سازی

- بهبود

- in

- شامل

- از جمله

- افزایش

- افزایش

- فردیت

- لوازم

- صنعت

- اطلاعات

- حاوی اطلاعات مفید

- در ابتدا

- ابتکاری

- فن آوری های نوآورانه

- ورودی

- ورودی

- الهام بخش

- نمونه

- در عوض

- دستورالعمل

- بیمه

- مورد نظر

- علاقه

- به

- حسی

- IT

- ITS

- خود

- جیمز

- کار

- شغل ها

- پیوستن

- JPG

- json

- تنها

- فقط یکی

- کلید

- دانش

- برچسب

- زبان

- بزرگ

- بزرگترین

- بعد

- لایه

- رهبری

- رهبر

- رهبری

- یاد گرفتن

- یادگیری

- انسوی کشتی که از باد در پناه است

- کتابخانه ها

- روشنایی

- پسندیدن

- محدود

- LLM

- بار

- بارهای

- محل

- طولانی

- دیگر

- نگاه کنيد

- عشق

- کم

- دستگاه

- فراگیری ماشین

- ساخته

- اصلی

- ساخت

- ساخت

- مدیریت

- اداره می شود

- مدیر

- مدیریت می کند

- مدیریت

- بسیاری

- بازار یابی (Marketing)

- بازاریابی و تبلیغات

- بیشترین

- ممکن است..

- معنی

- به معنی

- مکانیزم

- مکانیسم

- رسانه ها

- حافظه

- ذکر شده

- پیام

- روش

- روش

- حد اقل

- دقیقه

- مخلوط

- ML

- مدل

- مدل

- اعتدال

- نظارت بر

- بیش

- اکثر

- انگیزه

- سینما

- بسیار

- چندگانه

- باید

- نام

- تحت عنوان

- بومی

- طبیعی

- پردازش زبان طبیعی

- نیاز

- شبکه

- خنثی

- بعد

- هیچ

- دفتر یادداشت

- اطلاع..

- اخطار

- اکنون

- عدد

- کارت گرافیک Nvidia

- هدف

- اشیاء

- of

- خاموش

- نفت

- on

- ONE

- فقط

- به سوی

- قابل استفاده

- بهینه سازی

- بهینه سازی

- بهینه

- گزینه

- گزینه

- or

- تنظیم و ارکستراسیون

- اصلی

- OS

- دیگر

- ما

- خارج

- نمای کلی

- تولید

- روی

- به طور کلی

- بسته

- بسته

- لایی

- موازی

- پارامتر

- پارامترهای

- بخش

- گذشت

- احساساتی

- مسیر

- مردم

- کامل

- انجام

- انجام می دهد

- شخص

- شخصیت

- شخصی کردن

- شخصی

- دیدگاه

- عکس

- عکس

- تصویر

- لوله

- خط لوله

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- فقیر

- تصویر

- فرصت

- ممکن

- پست

- پتانسیل

- صفحه اصلی

- قوی

- پیشگو

- تنظیمات

- آماده

- آماده می کند

- آماده

- حفظ

- قبلی

- اصلی

- چاپ

- قبلا

- روند

- در حال پردازش

- محصول

- مدیر تولید

- محصولات

- مشخصات

- برنامه نويسي

- پروژه ها

- ترویج

- به درستی

- املاک

- ارائه

- ارائه

- فراهم می کند

- پــایتــون

- کیفیت

- مقدار

- تصادفی

- محدوده

- نرخ

- نسبتا

- منطق

- مطالعه

- اماده

- توصیه

- توصیه می شود

- كاهش دادن

- کاهش

- را کاهش می دهد

- کاهش

- بازتاب

- با توجه

- مربوط

- نمایندگی

- درخواست

- درخواست

- ضروری

- منابع

- منابع

- پاسخ

- مسئوليت

- REST

- نتیجه

- نتایج

- راک استار بشم

- نقش

- تقریبا

- مسیریابی

- دویدن

- اجرا می شود

- حکیم ساز

- استنباط SageMaker

- همان

- ذخیره

- مقیاس

- مقیاس گذاری

- Sci-Fi حجم

- حوزه

- تصاویر

- بخش

- بخش

- دیدن

- دانه

- بخش

- خود

- Selfie

- ارشد

- فرستاده

- سلسله

- سرویس

- خدمات

- خدمت

- تنظیم

- محیط

- برپایی

- چند

- شکل

- اشتراک گذاری

- به اشتراک گذاشته شده

- تیز

- او

- عکس

- باید

- نشان داده شده

- نشان می دهد

- طرف

- قابل توجه

- به طور قابل توجهی

- شمعون

- ساده

- به سادگی

- تنها

- شرایط

- اندازه

- کوچک

- کوچکتر

- قطعه

- آگاهی

- رسانه های اجتماعی

- بسترهای اجتماعی

- راه حل

- مزایا

- برخی از

- فضا

- متخصص

- متخصص

- خاص

- هزینه

- چرخش

- پایدار

- شروع

- آغاز شده

- شروع می شود

- گام

- مراحل

- ذخیره سازی

- ذخیره شده

- جریان

- خدمات جریان

- رشته

- ساختار

- موضوع

- متعاقب

- موفق

- چنین

- کافی

- تهیه

- پشتیبانی

- مطمئن

- سیستم

- گرفتن

- کار

- تیم

- TechCrunch

- تکنیک

- فن آوری

- پیشرفته

- تست

- تست

- نسبت به

- که

- La

- شان

- آنها

- سپس

- از این رو

- اینها

- این

- اگر چه؟

- فکر

- رهبری فکر

- هزاران نفر

- سه

- از طریق

- زمان

- بار

- عناوین

- به

- ابزار

- بالا

- ترافیک

- قطار

- آموزش

- تبدیل شدن

- سفر

- تریتون

- امتحان

- tv

- دو

- نوع

- به طور معمول

- ui

- زیر

- فهمید

- منحصر به فرد

- غیر ضروری

- آپلود شده

- آپلود

- us

- ایالات متحده

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- کاربران

- استفاده

- با استفاده از

- سودمندی

- استفاده کنید

- ارزش

- تنوع

- مختلف

- نسخه

- از طريق

- چشم انداز

- تماشا

- ویرجینیا

- دید

- تصاویر

- می خواهم

- بود

- علامت گذاری به عنوان

- we

- وب

- خدمات وب

- وزن

- بود

- چی

- چه زمانی

- که

- در حین

- که

- وسیع

- دامنه گسترده

- اراده

- با

- بدون

- مهاجرت کاری

- کارگر

- بدترین

- خواهد بود

- X

- سال

- شما

- شما

- خودت

- زفیرنت