با اجرایی شدن مقررات جدید حفظ حریم خصوصی داده ها مانند GDPR (مقررات عمومی حفاظت از داده ها، 2017)، مشتریان تحت فشار فزاینده ای برای کسب درآمد از دارایی های رسانه ای هستند و در عین حال از قوانین جدید تبعیت می کنند. کسب درآمد از رسانه با رعایت مقررات حفظ حریم خصوصی مستلزم توانایی استخراج خودکار فراداده های گرانول از دارایی هایی مانند متن، تصاویر، ویدئو و فایل های صوتی در مقیاس اینترنت است. همچنین نیاز به روشی مقیاسپذیر برای نگاشت داراییهای رسانه به طبقهبندیهای صنعتی دارد که کشف و کسب درآمد از محتوا را تسهیل میکند. این مورد استفاده بهویژه برای صنعت تبلیغات مهم است زیرا قوانین حفظ حریم خصوصی دادهها باعث تغییر هدفگیری رفتاری با استفاده از کوکیهای شخص ثالث میشود.

کوکی های شخص ثالث به فعال کردن تبلیغات شخصی برای کاربران وب کمک می کند و به تبلیغ کنندگان اجازه می دهد به مخاطبان مورد نظر خود دسترسی پیدا کنند. یک راه حل سنتی برای ارائه تبلیغات بدون کوکی های شخص ثالث، تبلیغات متنی است که تبلیغات را بر اساس محتوای منتشر شده در صفحات در صفحات وب قرار می دهد. با این حال، تبلیغات متنی چالش استخراج زمینه از دارایی های رسانه در مقیاس، و همچنین استفاده از آن زمینه برای کسب درآمد از دارایی ها را ایجاد می کند.

در این پست، در مورد اینکه چگونه میتوانید یک راهحل یادگیری ماشینی (ML) بسازید که ما آن را به نام Contextual Intelligence Taxonomy Mapper (CITM) مینامیم تا زمینه را از محتوای دیجیتال استخراج کرده و آن را به طبقهبندی استاندارد به منظور ایجاد ارزش ترسیم کنید. اگرچه ما این راه حل را برای تبلیغات متنی اعمال می کنیم، اما شما می توانید از آن برای حل سایر موارد استفاده استفاده کنید. برای مثال، شرکتهای فناوری آموزشی میتوانند از آن برای ترسیم محتوای خود به طبقهبندیهای صنعت استفاده کنند تا یادگیری تطبیقی را تسهیل کنند که تجربیات یادگیری شخصیشده را بر اساس نیازهای فردی دانشآموزان ارائه میدهد.

بررسی اجمالی راه حل

راه حل شامل دو جزء است: هوش رسانه ای AWS قابلیتهای (AWS MI) برای استخراج زمینه از محتوا در صفحات وب و CITM برای نگاشت هوشمند محتوا به طبقهبندی صنعت. می توانید به راه حل ها دسترسی داشته باشید مخزن کد برای مشاهده دقیق نحوه اجرای اجزای آن.

هوش رسانه ای AWS

قابلیتهای AWS MI استخراج خودکار متادیتا را امکانپذیر میسازد که درک متنی محتوای صفحه وب را فراهم میکند. میتوانید تکنیکهای ML مانند بینایی رایانه، گفتار به متن، و پردازش زبان طبیعی (NLP) را ترکیب کنید تا بهطور خودکار متادیتا را از متن، ویدیو، تصاویر و فایلهای صوتی برای استفاده در پردازش پاییندست تولید کنید. خدمات هوش مصنوعی مدیریت شده مانند شناسایی آمازون, آمازون رونوشت, درک آمازونو متن آمازون این تکنیک های ML را با استفاده از فراخوانی های API در دسترس قرار دهید. این امر سربار مورد نیاز برای آموزش و ساخت مدل های ML را از ابتدا حذف می کند. در این پست، می بینید که چگونه استفاده از Amazon Comprehend و Amazon Rekognition برای هوش رسانه ای استخراج ابرداده را در مقیاس ممکن می کند.

نقشهبردار طبقهبندی هوش زمینهای

پس از استخراج فراداده از محتوای رسانهای، به راهی برای نگاشت آن ابرداده به طبقهبندی صنعت نیاز دارید تا هدفگیری متنی را تسهیل کنید. برای انجام این کار، نقشهبردار طبقهبندی هوش متنی (CITM) را میسازید که توسط یک ترانسفورماتور جمله BERT از Hugging Face تغذیه میشود.

مبدل جمله BERT CITM را قادر می سازد تا محتوای وب را با کلمات کلیدی مرتبط با زمینه طبقه بندی کند. به عنوان مثال، می تواند یک مقاله وب در مورد زندگی سالم را با کلمات کلیدی از طبقه بندی صنعت، مانند «آشپزی و غذا خوردن سالم»، «دویدن و دویدن» و موارد دیگر، بر اساس متن نوشته شده و تصاویر استفاده شده در مقاله، دسته بندی کند. CITM همچنین امکان انتخاب شرایط طبقه بندی نقشه برداری شده را برای استفاده در فرآیند مناقصه تبلیغاتی بر اساس معیارهای شما فراهم می کند.

نمودار زیر نمای مفهومی معماری با CITM را نشان می دهد.

طبقه بندی محتوای IAB (اداره تبلیغات تعاملی).

برای این پست از طبقه بندی محتوای آزمایشگاه فناوری IAB به عنوان طبقه بندی استاندارد صنعت برای مورد استفاده از تبلیغات متنی. با طراحی، طبقه بندی IAB به سازندگان محتوا کمک می کند تا محتوای خود را با دقت بیشتری توصیف کنند و زبان مشترکی را برای همه طرفین در فرآیند تبلیغات برنامه ای فراهم می کند. استفاده از یک اصطلاح رایج بسیار مهم است زیرا انتخاب تبلیغات برای صفحه وب که کاربر از آن بازدید می کند باید در چند میلی ثانیه انجام شود. طبقه بندی IAB به عنوان یک روش استاندارد برای طبقه بندی محتوا از منابع مختلف عمل می کند و در عین حال یک پروتکل صنعتی است که پلتفرم های پیشنهادی بلادرنگ برای انتخاب آگهی از آن استفاده می کنند. این یک ساختار سلسله مراتبی دارد که جزئیاتی از اصطلاحات طبقه بندی و زمینه بهبود یافته را برای تبلیغ کنندگان فراهم می کند.

گردش کار راه حل

نمودار زیر گردش کار راه حل را نشان می دهد.

مراحل زیر است:

- سرویس ذخیره سازی ساده آمازون (Amazon S3) طبقه بندی محتوای IAB و محتوای وب استخراج شده را ذخیره می کند.

- Amazon Comprehend مدل سازی موضوع را برای استخراج مضامین رایج از مجموعه مقالات انجام می دهد.

- شناخت آمازون API برچسب شی برچسب ها را در تصاویر تشخیص می دهد.

- CITM محتوا را به یک طبقه بندی استاندارد نگاشت می کند.

- به صورت اختیاری، می توانید محتوا را برای نگاشت طبقه بندی در یک فروشگاه ابرداده ذخیره کنید.

در بخشهای بعدی، هر مرحله را با جزئیات مرور میکنیم.

آمازون S3 طبقه بندی محتوای IAB و محتوای وب استخراج شده را ذخیره می کند

ما متن و تصاویر استخراج شده از مجموعه ای از مقالات وب را در یک سطل S3 ذخیره می کنیم. ما همچنین طبقه بندی محتوای IAB را ذخیره می کنیم. به عنوان اولین قدم، ما لایههای مختلف را در طبقهبندی برای ایجاد اصطلاحات طبقهبندی ترکیبی به هم متصل میکنیم. این رویکرد به حفظ ساختار سلسله مراتبی تاکسونومی کمک می کند زمانی که ترانسفورماتور جمله BERT جاسازی هایی را برای هر کلمه کلیدی ایجاد می کند. کد زیر را ببینید:

نمودار زیر طبقه بندی بافت IAB را با لایه های ترکیبی نشان می دهد.

Amazon Comprehend مدل سازی موضوع را برای استخراج مضامین رایج از مجموعه مقالات انجام می دهد

با استفاده از API مدلسازی موضوع آمازون Comprehend، تمام متون مقاله را با استفاده از مدل تخصیص دیریکله پنهان (LDA) تجزیه و تحلیل میکنید. این مدل هر مقاله را در مجموعه بررسی میکند و کلمات کلیدی را بر اساس زمینه و فراوانی که در کل مجموعه مقالات ظاهر میشوند در یک موضوع گروهبندی میکند. برای اطمینان از اینکه مدل LDA موضوعات بسیار منسجم را تشخیص می دهد، قبل از فراخوانی Amazon Comprehend API یک مرحله پیش پردازش را انجام می دهید. می توانید استفاده کنید کتابخانه جنسیم CoherenceModel برای تعیین تعداد بهینه موضوعات برای شناسایی از مجموعه مقالات یا فایل های متنی. کد زیر را ببینید:

پس از به دست آوردن تعداد بهینه موضوعات، از آن مقدار برای کار مدل سازی موضوع آمازون Comprehend استفاده می کنید. ارائه مقادیر مختلف برای پارامتر NumberOfTopics در آمازون Comprehend عملیات StartTopicsDetectionJob منجر به تغییر در توزیع کلمات کلیدی قرار داده شده در هر گروه موضوعی می شود. یک مقدار بهینه برای پارامتر NumberOfTopics تعداد موضوعاتی را نشان میدهد که منسجمترین گروهبندی کلمات کلیدی را با ارتباط متنی بالاتر ارائه میکنند. میتوانید خروجی مدلسازی موضوع از Amazon Comprehend را در قالب خام آن در Amazon S3 ذخیره کنید.

API برچسب شی آمازون Rekognition برچسب ها را در تصاویر تشخیص می دهد

شما هر تصویر استخراج شده از تمام صفحات وب را با استفاده از عملکرد آمازون Rekognition DetectLabels. برای هر تصویر، این عملیات یک پاسخ JSON با تمام برچسب های شناسایی شده در تصویر، همراه با یک امتیاز اطمینان برای هر یک ارائه می دهد. برای مورد استفاده خود، امتیاز اطمینان 60% یا بالاتر را بهعنوان آستانه برای استفاده از برچسبهای شی در مرحله بعد انتخاب میکنیم. شما برچسب های اشیاء را در قالب خام آنها در آمازون S3 ذخیره می کنید. کد زیر را ببینید:

CITM محتوا را به یک طبقه بندی استاندارد نگاشت می کند

CITM فراداده های محتوای استخراج شده (موضوعات از متن و برچسب ها از تصاویر) را با کلمات کلیدی در طبقه بندی IAB مقایسه می کند، و سپس ابرداده محتوا را به کلمات کلیدی از طبقه بندی که از نظر معنایی مرتبط هستند نگاشت می کند. برای این کار، CITM سه مرحله زیر را تکمیل می کند:

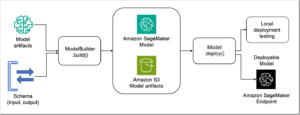

- با استفاده از ترانسفورماتور جمله BERT Hugging Face، جاسازیهای عصبی را برای طبقهبندی محتوا، کلمات کلیدی موضوع و برچسبهای تصویر ایجاد کنید. ما به مدل ترانسفورماتور جمله از آمازون SageMaker. در این پست از ترجمه-MiniLM-L6-v2 مدلی که کلمات کلیدی و برچسب ها را به یک فضای برداری متراکم 384 بعدی نگاشت می کند.

- امتیاز شباهت کسینوس بین کلمات کلیدی طبقه بندی و کلیدواژه های موضوعی را با استفاده از جاسازی آنها محاسبه کنید. همچنین شباهت کسینوس بین کلمات کلیدی طبقه بندی و برچسب های شیء تصویر را محاسبه می کند. ما از شباهت کسینوس به عنوان مکانیزم امتیازدهی برای یافتن تطابق معنایی مشابه بین ابرداده محتوا و طبقه بندی استفاده می کنیم. کد زیر را ببینید:

- جفتهایی را با امتیاز شباهت که بالاتر از آستانه تعریفشده توسط کاربر هستند شناسایی کنید و از آنها برای نگاشت محتوا به کلمات کلیدی مرتبط معنایی در طبقهبندی محتوا استفاده کنید. در آزمون ما، همه کلمات کلیدی را از جفت هایی که دارای امتیاز شباهت کسینوس 0.5 یا بالاتر هستند، انتخاب می کنیم. کد زیر را ببینید:

یک چالش رایج هنگام کار با نمایش زبان در مقیاس اینترنت (مانند این مورد استفاده) این است که شما به مدلی نیاز دارید که بتواند بیشتر محتوا را در نظر بگیرد - در این مورد، کلمات در زبان انگلیسی. ترانسفورماتور BERT Hugging Face با استفاده از مجموعه بزرگی از پستهای ویکیپدیا به زبان انگلیسی برای نشان دادن معنای معنایی کلمات در رابطه با یکدیگر از قبل آموزش داده شده است. شما مدل از پیش آموزشدیدهشده را با استفاده از مجموعه دادههای خاص خود از کلمات کلیدی موضوع، برچسبهای تصویر، و کلمات کلیدی طبقهبندی بهخوبی تنظیم میکنید. وقتی همه جاسازی ها را در یک فضای ویژگی قرار می دهید و آنها را تجسم می کنید، می بینید که BERT به طور منطقی شباهت معنایی بین اصطلاحات را نشان می دهد.

مثال زیر کلمات کلیدی طبقه بندی محتوای IAB را برای کلاس Automotive که به صورت بردار با استفاده از BERT نشان داده شده اند را به تصویر می کشد. BERT کلمات کلیدی Automotive را از طبقه بندی به اصطلاحات معنایی مشابه نزدیک می کند.

بردارهای ویژگی به CITM اجازه میدهند تا برچسبهای ابرداده و کلمات کلیدی طبقهبندی را در همان فضای ویژگی مقایسه کند. در این فضای ویژگی، CITM شباهت کسینوس بین هر بردار ویژگی برای کلمات کلیدی طبقه بندی و هر بردار ویژگی برای کلمات کلیدی موضوعی را محاسبه می کند. در یک مرحله جداگانه، CITM بردارهای ویژگی طبقه بندی و بردارهای ویژگی را برای برچسب های تصویر مقایسه می کند. جفتهایی با امتیاز کسینوس نزدیک به 1 از نظر معنایی مشابه هستند. توجه داشته باشید که یک جفت می تواند یک کلمه کلیدی موضوعی و یک کلمه کلیدی طبقه بندی یا یک برچسب شی و یک کلمه کلیدی طبقه بندی باشد.

اسکرین شات زیر جفتهای مثالی از کلیدواژههای موضوعی و کلیدواژههای طبقهبندی را با استفاده از شباهت کسینوس محاسبهشده با تعبیههای BERT نشان میدهد.

برای نگاشت محتوا به کلمات کلیدی طبقه بندی، CITM کلمات کلیدی را از جفت شدن با امتیاز کسینوس انتخاب می کند که یک آستانه تعریف شده توسط کاربر را برآورده می کند. اینها کلمات کلیدی هستند که در پلتفرم های مناقصه بلادرنگ برای انتخاب تبلیغات موجودی صفحه وب استفاده می شوند. نتیجه یک نقشه برداری غنی از محتوای آنلاین به طبقه بندی است.

به صورت اختیاری محتوا را برای نگاشت طبقه بندی در یک فروشگاه ابرداده ذخیره کنید

پس از اینکه اصطلاحات طبقه بندی مشابه متنی را از CITM شناسایی کردید، به راهی برای دسترسی APIهای کم تاخیر به این اطلاعات نیاز دارید. در مناقصه برنامهریزی شده برای تبلیغات، زمان پاسخدهی کم و همزمانی بالا نقش مهمی در کسب درآمد از محتوا دارد. طرح ذخیره داده باید انعطاف پذیر باشد تا در صورت نیاز برای غنی سازی درخواست های پیشنهادی، ابرداده های اضافی را در خود جای دهد. آمازون DynamoDB می تواند با الگوهای دسترسی به داده ها و الزامات عملیاتی چنین سرویسی مطابقت داشته باشد.

نتیجه

در این پست، نحوه ایجاد یک راه حل هدفیابی متنی مبتنی بر طبقهبندی را با استفاده از نقشهبردار طبقهبندی هوش زمینهای (CITM) یاد گرفتید. شما یاد گرفتید که چگونه از Amazon Comprehend و Amazon Rekognition برای استخراج ابرداده های گرانول از دارایی های رسانه خود استفاده کنید. سپس، با استفاده از CITM، داراییها را به یک طبقهبندی استاندارد صنعتی نگاشت کردید تا مناقصه تبلیغات برنامهریزی شده برای تبلیغات مرتبط با زمینه را تسهیل کنید. شما می توانید این چارچوب را برای موارد استفاده دیگر که نیاز به استفاده از طبقه بندی استاندارد برای افزایش ارزش دارایی های رسانه ای موجود دارند، اعمال کنید.

برای آزمایش CITM، می توانید به آن دسترسی داشته باشید مخزن کد و از آن با مجموعه داده متنی و تصویری مورد نظر خود استفاده کنید.

توصیه می کنیم در مورد اجزای راه حل معرفی شده در این پست بیشتر بدانید. بیشتر در مورد کشف کنید هوش رسانه ای AWS برای استخراج ابرداده از محتوای رسانه. همچنین، در مورد نحوه استفاده بیشتر بیاموزید مدلهای صورت در آغوش گرفتن برای NLP با استفاده از Amazon SageMaker.

درباره نویسنده

آرامیده کهنده یک معمار راه حل شریک در AWS در یادگیری ماشین و هوش مصنوعی است. سفر شغلی او حوزههای هوش تجاری و تجزیه و تحلیل پیشرفته در صنایع مختلف را در برگرفته است. او تلاش می کند تا شرکای خود را قادر سازد راه حل هایی با خدمات AWS AI/ML بسازند که نیازهای مشتریان را برای نوآوری برآورده کند. او همچنین از ساختن محل تقاطع هوش مصنوعی و عرصه های خلاقانه و گذراندن وقت با خانواده اش لذت می برد.

آرامیده کهنده یک معمار راه حل شریک در AWS در یادگیری ماشین و هوش مصنوعی است. سفر شغلی او حوزههای هوش تجاری و تجزیه و تحلیل پیشرفته در صنایع مختلف را در برگرفته است. او تلاش می کند تا شرکای خود را قادر سازد راه حل هایی با خدمات AWS AI/ML بسازند که نیازهای مشتریان را برای نوآوری برآورده کند. او همچنین از ساختن محل تقاطع هوش مصنوعی و عرصه های خلاقانه و گذراندن وقت با خانواده اش لذت می برد.

آنوج گوپتا یک معمار راه حل اصلی است که با شرکت های با رشد بیش از حد در سفر بومی ابر خود کار می کند. او علاقه زیادی به استفاده از فناوری برای حل مشکلات چالش برانگیز دارد و با مشتریان برای ساخت برنامه های کاربردی بسیار توزیع شده و تاخیر کم کار کرده است. او به راهحلهای بدون سرور و یادگیری ماشین منبع باز کمک میکند. خارج از کار، او عاشق سفر با خانواده و نوشتن شعر و وبلاگ های فلسفی است.

آنوج گوپتا یک معمار راه حل اصلی است که با شرکت های با رشد بیش از حد در سفر بومی ابر خود کار می کند. او علاقه زیادی به استفاده از فناوری برای حل مشکلات چالش برانگیز دارد و با مشتریان برای ساخت برنامه های کاربردی بسیار توزیع شده و تاخیر کم کار کرده است. او به راهحلهای بدون سرور و یادگیری ماشین منبع باز کمک میکند. خارج از کار، او عاشق سفر با خانواده و نوشتن شعر و وبلاگ های فلسفی است.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- درک آمازون

- شناسایی آمازون

- آمازون SageMaker

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- بازاریابی و تبلیغات

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- نحوه فنی

- رهبری فکر

- زفیرنت