افزایش اندازه مدلهای زبان یکی از بزرگترین روندها در پردازش زبان طبیعی (NLP) در سالهای اخیر بوده است. از سال 2018، ما شاهد توسعه و استقرار بیسابقه مدلهای زبانی بزرگتر، از جمله BERT و انواع آن، GPT-2، T-NLG و GPT-3 (175 میلیارد پارامتر) بودهایم.

این مدل ها مرزهای نوآوری های معماری ممکن را جابجا کرده اند. ما هنگام آموزش مدل های یادگیری عمیق در مقیاس بزرگ، به ویژه موج جدید ترانسفورماتورهای از پیش آموزش دیده مولد، با چالش های متعددی روبرو هستیم. این چالش ها شامل محدودیت های سخت افزاری و معاوضه با محاسبات و کارایی است. برای غلبه بر این چالشهای موازی مدل و داده، AWS طیف وسیعی از قابلیتها را ارائه میدهد.

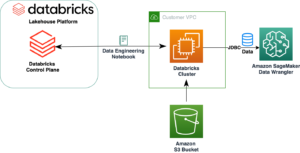

در این پست دو رویکرد اصلی را معرفی می کنیم: موازی سازی داده ها و موازی سازی مدل ها با استفاده از آمازون SageMaker، و در مورد جوانب مثبت و منفی آنها صحبت کنید.

مدل

برای مدل زبان، از ترانسفورماتورهای معرفی شده در مقاله استفاده می کنیم توجه تنها چیزی است که نیاز دارید. ترانسفورماتورها مدلهای یادگیری عمیقی هستند که برای اجتناب عمدی از دامهای RNN با تکیه بر مکانیزم توجه به خود برای ایجاد وابستگی جهانی بین ورودی و خروجی طراحی شدهاند. معماری مدل ترانسفورماتور امکان موازی سازی بسیار بهتری را فراهم می کند و می تواند در زمان آموزش نسبتاً کوتاه به عملکرد بالایی دست یابد. ساخته شده بر اساس موفقیت ترانسفورماتور، BERT، معرفی شده در مقاله BERT: پیش آموزش ترانسفورماتورهای دو جهته عمیق برای درک زبان، پیش آموزش دو طرفه برای بازنمایی زبان اضافه شد. با الهام از کار Cloze، BERT با مدل سازی زبان ماسک شده (MLM) از قبل آموزش دیده است، که در آن مدل یاد می گیرد کلمات اصلی را برای نشانه های ماسک شده تصادفی بازیابی کند. مدل BERT همچنین در کار پیشبینی جمله بعدی (NSP) برای پیشبینی اینکه آیا دو جمله در ترتیب خواندن صحیح هستند، از قبل آموزش داده شده است. از زمان ظهور آن در سال 2018، BERT و تغییرات آن به طور گسترده ای در مدل های زبان مورد استفاده قرار گرفته است.

ما با ایجاد دو لایه تعبیه برای توکن و جاسازی موقعیتی شروع می کنیم. تعبیههای ورودی مجموع جاسازیهای نشانه و جاسازیهای موقعیت هستند.

سپس یک بلوک رمزگشای ترانسفورماتور را با دو لایه فرعی تعریف می کنیم: یک لایه خودتوجهی چند سر، و یک شبکه فید فوروارد ساده کاملا متصل و به دنبال آن عادی سازی لایه و خروج از آن:

در نهایت، مدل زبان خود را با لایه های تعبیه شده قبلی و بلوک های ترانسفورماتور ایجاد می کنیم:

بسته به فراپارامترهای خود، می توانید این مدل را از هزاران پارامتر به میلیاردها پارامتر مقیاس کنید. چالش اصلی با مدلهای میلیارد پارامتری این است که شما نمیتوانید مدل را در یک نمونه میزبانی کنید و برای آموزش و استنتاج باید مدل را در چندین گره توزیع کنید.

مجموعه داده

در آزمایشات خود از مجموعه داده شمع. Pile یک مجموعه داده متنی انگلیسی 800 گیگابایتی است که برای آموزش مدل های زبانی در مقیاس بزرگ طراحی شده است. این مجموعه از 22 مجموعه داده متنوع و با کیفیت بالا، از جمله مجموعه داده های NLP ایجاد شده و آنهایی که به تازگی معرفی شده اند، ایجاد شده است.

مجموعه داده از منابع مختلف داده، از جمله کتاب، ایجاد شده است. مخازن GitHub؛ صفحات وب؛ سیاهههای مربوط به چت؛ و مقالات پزشکی، فیزیک، ریاضی، علوم کامپیوتر و فلسفه. به طور خاص، از منابع زیر استفاده می کند: Pile-CC، PubMed Central، ArXiv، GitHub، پروژه FreeLaw، Stack Exchange، اداره ثبت اختراع و علائم تجاری ایالات متحده، PubMed، Ubuntu، IRC، HackerNews، YouTube، PhilPapers، Books3، Project Gutenberg ( PG-19)، OpenSubtitles، Wikipedia انگلیسی، DM Mathematics، EuroParl، Enron Emails Corpus و NIH ExPorter. همچنین شامل OpenWebText2 و BookCorpus2 است که به ترتیب پسوند مجموعه داده های OpenWebText و BookCorpus اصلی هستند. تنوع در منابع داده می تواند دانش عمومی بین دامنه ای را بهبود بخشد و در نتیجه قابلیت های تعمیم پایین دستی را بهبود بخشد.

چالش اصلی با این مجموعه داده اندازه خالص است. مجموعه داده دارای 825 گیگابایت متن است که به 4.2 TiB از نقاط داده از پیش پردازش شده و فشرده تبدیل می شود. مشابه چالشهایی که در آموزش و میزبانی مدلها با آن روبرو هستیم، آموزش یک مدل با این مجموعه داده در یک نمونه زمان زیادی میبرد و عملی نیست.

راه حل ما این است که مجموعه داده را به تکه های تقریباً 1 گیگابایتی از داده ها تقسیم کنیم، ویژگی ها را بارگیری و پیش پردازش کنیم. مجموعه داده TensorFlow اشیاء و ذخیره آنها در سرویس فایل الاستیک آمازون (Amazon EFS). مجموعه داده های TensorFlow یک خط لوله داده با کاربری آسان و با کارایی بالا را ارائه می دهد که به خوبی با مدل های ما ادغام می شود. Amazon EFS یک سرویس آسان برای استفاده است که ما را قادر می سازد یک سیستم فایل مشترک بسازیم که با اضافه شدن و حذف فایل ها به طور خودکار مقیاس می شود. علاوه بر این، آمازون EFS قادر است در صورت نیاز به سطوح توان بالاتری برسد، که در خط لوله آموزش دادهها و مدلهای ما حیاتی است.

در مرحله بعد، ما به استراتژی های آموزشی توزیع شده برای مقابله با این چالش ها نگاه می کنیم.

آموزش توزیع شده

در این پروژه با دو چالش مواجه شدیم: مقیاس بندی اندازه مدل و حجم داده. افزایش اندازه مدل و تعداد پارامترهای قابل آموزش ممکن است منجر به دقت بهتر شود، اما محدودیتی برای مدل وجود دارد که میتوانید آن را در یک حافظه واحد گرافیکی یا حتی چندین GPU در یک نمونه قرار دهید. علاوه بر این، اندازههای مدل بزرگتر برای آموزش زمان بیشتری میطلبد.

شما می توانید با این چالش ها به دو روش مختلف مقابله کنید: موازی سازی داده ها و موازی سازی مدل. با موازی سازی داده ها، ما نزول گرادیان تصادفی (SGD) را با توزیع رکوردهای یک دسته کوچک روی دستگاه های مختلف انجام می دهیم تا سرعت آموزش را افزایش دهیم. با این حال، آموزش دادههای موازی با پیچیدگی اضافی محاسبه میانگین گرادیان دستهای کوچک با گرادیانهای همه دستگاهها همراه است، مرحلهای به نام AllReduce، که با بزرگ شدن خوشه آموزشی سخت تر می شود. در حالی که از موازی سازی داده ها استفاده می کنیم، باید بتوانیم مدل و یک نقطه داده را در یک دستگاه (CPU یا GPU) جای دهیم، که این یک عامل محدود کننده در آزمایشات ما است زیرا اندازه چنین مدل بزرگی بسیار بزرگتر از حافظه GPU واحد است. اندازه.

راه حل دیگر استفاده از موازی سازی مدل است که مدل را بر روی چندین دستگاه تقسیم می کند. موازی سازی مدل، فرآیند تقسیم یک مدل بین چندین دستگاه یا گره (مانند نمونه های مجهز به GPU) و ایجاد یک خط لوله کارآمد برای آموزش مدل در سراسر این دستگاه ها برای به حداکثر رساندن استفاده از GPU است.

موازی سازی داده ها

موازی کردن داده ها رایج ترین رویکرد برای چندین GPU یا آموزش توزیع شده است. میتوانید دادههای خود را دستهبندی کنید، آنها را به چندین دستگاه ارسال کنید (هر کدام یک مدل تکراری را میزبانی میکنند)، سپس نتایج را جمعآوری کنید. ما با دو بسته برای موازی سازی داده ها آزمایش کردیم: Horovod و the SageMaker کتابخانه موازی داده را توزیع کرد.

Horovod یک چارچوب آموزشی یادگیری عمیق توزیع شده برای TensorFlow، Keras، PyTorch و Apache MXNet است. برای استفاده از هوروود مراحل زیر را طی کردیم:

- با اجرا کردن اولیه کنید

hvd.init(). - هر دستگاه را با یک فرآیند واحد مرتبط کنید. فرآیند یا کارگر اول با دستگاه اول، فرآیند دوم با دستگاه دوم و غیره مرتبط است.

- نرخ یادگیری را بر اساس تعداد دستگاه ها تنظیم کنید.

- بهینه ساز را در آن بپیچید

hvd.DistributedOptimizer. - حالت های متغیر اولیه را از اولین کارگر با رتبه 0 به همه فرآیندهای دیگر پخش کنید. هنگامی که آموزش با وزنههای تصادفی شروع میشود یا از یک پست بازرسی بازیابی میشود، این امر برای اطمینان از شروع اولیه ثابت همه کارگران ضروری است.

- مطمئن شوید که فقط دستگاه 0 می تواند پست های بازرسی را ذخیره کند تا از خراب کردن سایر کارگران جلوگیری شود.

اسکریپت آموزشی زیر است:

کتابخانه موازی داده SageMaker ما را قادر میسازد تا آموزش خود را با کارایی تقریباً خطی مقیاسبندی کنیم و با حداقل تغییرات کد سرعت آموزش خود را افزایش دهیم. کتابخانه یک سفارشی را انجام می دهد AllReduce عملیات و بهینه سازی ارتباط دستگاه به دستگاه با استفاده کامل از زیرساخت شبکه AWS و ابر محاسبه الاستیک آمازون توپولوژی نمونه (Amazon EC2). برای استفاده از کتابخانه موازی داده SageMaker، مراحل زیر را طی کردیم:

- واردات و مقداردهی اولیه

sdp.init(). - هر دستگاه را با یک دستگاه مرتبط کنید

smdistributed.dataparallelپردازش باlocal_rank.sdp.tensorflow.local_rank()رتبه محلی دستگاه ها را به ما می دهد. رهبر رتبه 0 و کارگران رتبه های 1، 2، 3 و غیره هستند. - نرخ یادگیری را بر اساس تعداد دستگاه ها تنظیم کنید.

- قرار دادن

tf.GradientTapeباDistributedGradientTapeاجرا كردنAllReduce. - متغیرهای مدل اولیه را از گره رهبر به تمام گره های کارگر پخش کنید.

- مطمئن شوید که فقط دستگاه 0 می تواند نقاط بازرسی را ذخیره کند.

موازی سازی مدل

میتوانیم ابرپارامترها را طوری تنظیم کنیم که مدل به اندازهای کوچک باشد که با استفاده از یک GPU آموزش ببیند، یا میتوانیم از موازیسازی مدل برای تقسیم مدل بین چندین GPU در چندین نمونه استفاده کنیم. افزایش تعداد پارامترهای قابل آموزش یک مدل می تواند منجر به دقت بهتر شود، اما حداکثر اندازه مدلی که می توانید در یک حافظه GPU قرار دهید محدودیتی وجود دارد. ما از کتابخانه موازی مدل توزیع شده SageMaker برای آموزش مدل های بزرگتر خود استفاده کردیم. مراحل به شرح زیر است:

- وارد کردن و مقداردهی اولیه کتابخانه با

smp.init(). - مدل Keras به جای کلاس Keras Model باید از smp.DistributedModel به ارث ببرد.

- تنظیم

drop_remainder=Trueدرtf.Dataset.batch()روشی برای اطمینان از اینکه اندازه دسته همیشه بر تعداد میکروبچ ها تقسیم می شود. - عملیات تصادفی در خط لوله داده همگی باید از یک دانه استفاده کنند:

smp.dp_rank()، به عنوان مثال،shuffle(ds, seed=smp.dp_rank()). این یکپارچگی نمونههای داده را در دستگاههایی که پارتیشنهای مدل متفاوتی را نگهداری میکنند، تضمین میکند. - منطق رو به جلو و عقب باید در یک تابع گام با

smp.stepتزیین. - انجام پس پردازش بر روی خروجی ها در میکروبچ با استفاده از روش های StepOutput مانند

reduce_mean.smp.stepتابع باید مقدار بازگشتی داشته باشد که به خروجی آن بستگی داردsmp.DistributedModel.

اسکریپت آموزشی به شرح زیر است:

برای راهنمایی دقیق برای فعال کردن اسکریپت آموزشی TensorFlow برای کتابخانه موازی مدل توزیع شده SageMaker، به یک اسکریپت آموزشی TensorFlow را اصلاح کنید. برای PyTorch مراجعه کنید یک اسکریپت آموزشی PyTorch را تغییر دهید.

SageMaker Debugger

در بخش های قبلی، نحوه بهینه سازی آموزش با استفاده از تکنیک های موازی سازی مدل و داده ها را مورد بحث قرار دادیم. با دیباگر Amazon SageMaker، اکنون میتوانیم اطلاعات نمایه عملکرد را از دورههای آموزشی خود دریافت کنیم تا تعیین کنیم که آموزش چقدر بهبود یافته است. بهطور پیشفرض، Debugger معیارهای سیستم را برای هر کار آموزشی SageMaker مانند GPU، استفاده از CPU، حافظه، شبکه و I/O در فاصله نمونهگیری 500 میلیثانیه ثبت میکند. به صورت زیر می توانیم به داده ها دسترسی پیدا کنیم:

Debugger ابزارهای کمکی را برای تجسم داده های پروفایل به روش های مختلف در مثال زیر، کل استفاده از GPU و CPU و همچنین زمان انتظار I/O برای کار آموزش چند GPU با استفاده از Horovod را می بینیم. برای تولید این نمودارها کد زیر را اجرا می کنیم:

استفاده از GPU اغلب بین 0 تا 100% در نوسان است و زمان انتظار I/O بالا با استفاده کم GPU نشانگر تنگنای I/O است. علاوه بر این، کل استفاده از CPU هرگز از 70٪ تجاوز نمی کند، به این معنی که ما می توانیم پیش پردازش داده ها را با افزایش تعداد فرآیندهای کارگر بهبود دهیم.

ما می توانیم با تغییر از Horovod به کتابخانه موازی داده توزیع شده SageMaker عملکرد را بهبود ببخشیم. در نمودارهای زیر می بینیم که GPU ها کارآمدتر استفاده می شوند و فقط برای مدت زمان کوتاهی به میزان کم استفاده می شوند.

زیرساخت های آموزشی

برای آموزش مدل ها، ما از 10 نمونه میلی لیتر.p3.16xlarge با استفاده از کار آموزشی SageMaker استفاده کردیم. SageMaker زمان و هزینه آموزش و تنظیم مدلهای یادگیری ماشین (ML) را بدون نیاز به مدیریت زیرساخت کاهش میدهد. با SageMaker، میتوانید به راحتی مدلهای ML را با استفاده از ابزارهای داخلی برای مدیریت و ردیابی آزمایشهای آموزشی آموزش دهید و تنظیم کنید، به طور خودکار ابرپارامترهای بهینه را انتخاب کنید، کارهای آموزشی اشکالزدایی را انجام دهید، و استفاده از منابع سیستم مانند GPU، CPU و پهنای باند شبکه را نظارت کنید. دادهها در آمازون EFS میزبانی میشد، که ما را قادر میسازد تا با افزودن و حذف فایلها بدون نیاز به مدیریت یا تهیه، رشد کرده و کوچک شویم. هدف اصلی ما بهبود سرعت تمرین و کاهش هزینه ها بود.

مقیاس پذیری مدل

اگرچه این زیرساخت عمدتاً برای تولید زبان استفاده میشود، اما با معماری GPT و مجموعه داده Pile، میتوانید از این تکنیکها برای آموزش مدلهای ترانسفورماتور در مقیاس بزرگ استفاده کنید که در بسیاری از حوزههای فراتر از NLP مفید است. در خود یادگیری ماشینی، بسیاری از وظایف بینایی کامپیوتری اکنون با معماریهای با پارامترهای بزرگ (ترانسفورماتور) حل میشوند، جایی که نشان داده شده است که در کارهایی مانند یادگیری بازنمایی، از CNNهای سنتی (شبکه عصبی کانولوشنال) بهتر عمل میکنند. ارتقای وضعیت هنر در بینایی کامپیوتر با ترانسفورماتورهای خود نظارت و آموزش 10 برابر کارآمدتر) و نگاشت در مقیاس بزرگ تصاویر به متن (مانند کلیپ). مدلهای با پارامترهای بزرگ نیز در حال گشودن زمینهای جدیدی در علوم زیستی در زمینههایی مانند این هستند تجزیه و تحلیل ساختار پروتئین و تجزیه و تحلیل داده های تصویر پزشکی.

راه حل هایی که در این پست برای آموزش توزیع شده و مدیریت مدل های بزرگ توضیح می دهیم باید برای مدل های هر یک از این حوزه ها نیز اعمال شود.

مبادلات

در مورد خطرات آموزش مدلهای زبانی در مقیاس بزرگ، بحثهای مداومی در جامعه پژوهشی وجود داشته است، و اینکه آیا فکر کافی در مورد خطرات احتمالی مرتبط با توسعه آنها و استراتژیهایی برای کاهش این خطرات، که برخی از آنها شامل مسائل مالی و هزینه های زیست محیطی با توجه به الف مقاله که در ACM منتشر شده است، آموزش یک مدل پایه تک BERT (بدون تنظیم فراپارامتر) بر روی پردازندههای گرافیکی به اندازه یک پرواز ترانس آمریکایی به انرژی نیاز دارد. اثرات زیست محیطی با اندازه مدل مقیاس می شود و توانایی تنظیم دقیق چنین مدل هایی به طور بالقوه می تواند انتشار گازهای گلخانه ای را به میزان قابل توجهی کاهش دهد. AWS اخیراً یک محصول جدید راه اندازی کرده است ابزار ردپای کربن مشتریبه عنوان بخشی از تلاشهای آمازون برای افزایش پایداری و کاهش انتشار کربن، در دسترس همه مشتریان AWS بدون هیچ هزینهای است. اجرای برنامه های کاربردی در AWS Cloud به طور بالقوه می تواند ردپای کربن را کاهش دهد (در مقایسه با مراکز داده سازمانی که در یک گزارش 2019).

نتیجه

این پست راه حلی را نشان می دهد که تنظیم دقیق مدل های زبان را با یک میلیارد پارامتر در AWS Cloud با استفاده از SageMaker تسهیل می کند.

برای اطلاعات بیشتر در مورد موازی سازی مدل با SageMaker، مراجعه کنید آموزش بیش از 175 میلیارد مدل NLP با پارامترهای اضافه شده به موازات مدل و صورت در آغوش گرفتن در Amazon SageMaker و چگونه فضای پنهان از کتابخانه موازی مدل آمازون SageMaker برای فشار دادن مرزهای ترانسفورماتورهای مقیاس بزرگ استفاده کرد.

اگر برای تسریع استفاده از ML در محصولات و فرآیندهای خود کمک میخواهید، لطفاً با آن تماس بگیرید آزمایشگاه راه حل های آمازون ام ال.

درباره نویسنده

سیا غلامی یک دانشمند ارشد داده در آزمایشگاه راه حل های آمازون ML است، جایی که راه حل های AI/ML را برای مشتریان در صنایع مختلف می سازد. او مشتاق پردازش زبان طبیعی (NLP) و یادگیری عمیق است. سیا خارج از محل کار از گذراندن وقت در طبیعت و بازی تنیس لذت می برد.

سیا غلامی یک دانشمند ارشد داده در آزمایشگاه راه حل های آمازون ML است، جایی که راه حل های AI/ML را برای مشتریان در صنایع مختلف می سازد. او مشتاق پردازش زبان طبیعی (NLP) و یادگیری عمیق است. سیا خارج از محل کار از گذراندن وقت در طبیعت و بازی تنیس لذت می برد.

مهدی نورییک مدیر و یک دانشمند ارشد کاربردی در آزمایشگاه راه حل های آمازون ML است، جایی که با مشتریان در صنایع مختلف کار می کند و به آنها کمک می کند تا سفر مهاجرت ابری خود را تسریع کنند و مشکلات ML خود را با استفاده از راه حل های پیشرفته و پیشرفته حل کنند. فن آوری ها

مهدی نورییک مدیر و یک دانشمند ارشد کاربردی در آزمایشگاه راه حل های آمازون ML است، جایی که با مشتریان در صنایع مختلف کار می کند و به آنها کمک می کند تا سفر مهاجرت ابری خود را تسریع کنند و مشکلات ML خود را با استفاده از راه حل های پیشرفته و پیشرفته حل کنند. فن آوری ها

موهیون کیم دانشمند داده در آزمایشگاه راه حل های یادگیری ماشین آمازون است. او مشکلات مختلف تجاری مشتریان را با استفاده از یادگیری ماشینی و یادگیری عمیق حل می کند و همچنین به آنها کمک می کند تا مهارت پیدا کنند.

موهیون کیم دانشمند داده در آزمایشگاه راه حل های یادگیری ماشین آمازون است. او مشکلات مختلف تجاری مشتریان را با استفاده از یادگیری ماشینی و یادگیری عمیق حل می کند و همچنین به آنها کمک می کند تا مهارت پیدا کنند.

دنی برد یک دانشمند کاربردی در آزمایشگاه راه حل های آمازون ML است. او در آزمایشگاه به مشتریان کمک کرد تا راهحلهای پیشرفته ML را توسعه دهند، در تخصصهای ML از بینایی رایانه تا یادگیری تقویتی. او مشتاق پیشبرد فناوری و کشف پتانسیل جدید از محصولات AWS در طول مسیر است.

دنی برد یک دانشمند کاربردی در آزمایشگاه راه حل های آمازون ML است. او در آزمایشگاه به مشتریان کمک کرد تا راهحلهای پیشرفته ML را توسعه دهند، در تخصصهای ML از بینایی رایانه تا یادگیری تقویتی. او مشتاق پیشبرد فناوری و کشف پتانسیل جدید از محصولات AWS در طول مسیر است.

فرانسیسکو کالدرون رودریگز یک دانشمند داده در آزمایشگاه راه حل های آمازون ML است. او به عنوان یکی از اعضای آزمایشگاه راه حل های ML، با استفاده از یادگیری عمیق به حل مشکلات مهم تجاری برای مشتریان AWS کمک می کند. فرانسیسکو در اوقات فراغت خود دوست دارد موسیقی و گیتار بزند، با دخترانش فوتبال بازی کند و از اوقات فراغت با خانواده اش لذت ببرد.

فرانسیسکو کالدرون رودریگز یک دانشمند داده در آزمایشگاه راه حل های آمازون ML است. او به عنوان یکی از اعضای آزمایشگاه راه حل های ML، با استفاده از یادگیری عمیق به حل مشکلات مهم تجاری برای مشتریان AWS کمک می کند. فرانسیسکو در اوقات فراغت خود دوست دارد موسیقی و گیتار بزند، با دخترانش فوتبال بازی کند و از اوقات فراغت با خانواده اش لذت ببرد.

یوهی ناکایاما یک معمار یادگیری عمیق در آزمایشگاه راه حل های آمازون ML است. او با مشتریان در بخشهای مختلف کار میکند تا استفاده آنها از هوش مصنوعی و خدمات ابری AWS را برای حل چالشهای تجاری آنها تسریع بخشد. او علاقه مند به استفاده از فناوری های ML/AI در صنعت فضایی است.

یوهی ناکایاما یک معمار یادگیری عمیق در آزمایشگاه راه حل های آمازون ML است. او با مشتریان در بخشهای مختلف کار میکند تا استفاده آنها از هوش مصنوعی و خدمات ابری AWS را برای حل چالشهای تجاری آنها تسریع بخشد. او علاقه مند به استفاده از فناوری های ML/AI در صنعت فضایی است.

ناتالی راوشمایر یک دانشمند ارشد کاربردی در AWS است، جایی که به مشتریان کمک می کند تا برنامه های یادگیری عمیق را توسعه دهند.

ناتالی راوشمایر یک دانشمند ارشد کاربردی در AWS است، جایی که به مشتریان کمک می کند تا برنامه های یادگیری عمیق را توسعه دهند.

- Coinsmart. بهترین صرافی بیت کوین و کریپتو اروپا.

- پلاتوبلاک چین. Web3 Metaverse Intelligence. دانش تقویت شده دسترسی رایگان.

- CryptoHawk. رادار آلت کوین امتحان رایگان.

- منبع: https://aws.amazon.com/blogs/machine-learning/create-train-and-deploy-a-billion-parameter-language-model-on-terabytes-of-data-with-tensorflow-and- حکیم ساز آمازون/

- "

- 10

- 100

- 2019

- a

- درباره ما

- شتاب دادن

- تسریع

- دسترسی

- مطابق

- رسیدن

- در میان

- اضافه

- اضافه

- پیشرفته

- معرفی

- اجازه می دهد تا

- همیشه

- آمازون

- تحلیل

- API

- برنامه های کاربردی

- اعمال می شود

- درخواست

- با استفاده از

- روش

- رویکردها

- تقریبا

- معماری

- معماری

- هنر

- مصنوعی

- هوش مصنوعی

- مرتبط است

- توجه

- بطور خودکار

- در دسترس

- میانگین

- AWS

- زیرا

- بودن

- میان

- خارج از

- بزرگتر

- بزرگترین

- بیلیون

- میلیاردها

- مسدود کردن

- کتاب

- ساختن

- می سازد

- ساخته شده در

- کسب و کار

- قابلیت های

- توانا

- گرفتن

- جلب

- کربن

- انتشار کربن

- مرکزی

- به چالش

- چالش ها

- را انتخاب کنید

- کلاس

- ابر

- خدمات ابر

- رمز

- مشترک

- ارتباط

- انجمن

- مقایسه

- محاسبه

- محاسبه

- کامپیوتر

- علم کامپیوتر

- محاسبه

- متصل

- منفی

- استوار

- تماس

- هزینه

- ایجاد

- ایجاد شده

- ایجاد

- ایجاد

- بحرانی

- سفارشی

- مشتریان

- داده ها

- مرکز دادهها

- دانشمند داده

- عمیق

- نشان

- بستگی دارد

- گسترش

- گسترش

- طراحی

- جزئیات

- دقیق

- مشخص کردن

- توسعه

- در حال توسعه

- پروژه

- دستگاه

- دستگاه ها

- مختلف

- بحث و تبادل نظر

- توزیع شده

- توزیع

- تنوع

- DM

- حوزه

- پایین

- به آسانی

- آسان برای استفاده

- بهره وری

- موثر

- موثر

- تلاش

- تولید گازهای گلخانه ای

- قادر ساختن

- را قادر می سازد

- انرژی

- انگلیسی

- سرمایه گذاری

- محیطی

- به خصوص

- تاسیس

- برآورد

- مثال

- بیش از

- تبادل

- ضمیمهها

- چهره

- فیس بوک

- در مواجهه

- خانواده

- امکانات

- زمینه

- مالی

- نام خانوادگی

- مناسب

- پرواز

- پیروی

- به دنبال آن است

- رد پا

- به جلو

- چارچوب

- فرانسیسکو

- از جانب

- تابع

- بعلاوه

- سوالات عمومی

- تولید می کنند

- نسل

- مولد

- گرفتن

- GitHub

- جهانی

- GPU

- GPU ها

- شدن

- راهنمایی

- سخت افزار

- کمک

- کمک می کند

- زیاد

- با کیفیت بالا

- بالاتر

- نگه داشتن

- میزبانی

- میزبانی وب

- چگونه

- چگونه

- اما

- HTTPS

- تصویر

- تصاویر

- بهبود

- بهبود یافته

- شامل

- شامل

- از جمله

- افزایش

- افزایش

- شاخص

- لوازم

- صنعت

- اطلاعات

- شالوده

- نوآوری

- ورودی

- الهام بخش

- نمونه

- اطلاعات

- علاقه مند

- IT

- خود

- کار

- شغل ها

- سفر

- نگاه داشتن

- دانش

- آزمایشگاه

- برچسب

- برچسب ها

- زبان

- بزرگ

- بزرگتر

- راه اندازی

- لایه

- رهبر

- یادگیری

- سطح

- کتابخانه

- علوم زندگی

- بار

- محلی

- نگاه کنيد

- دستگاه

- فراگیری ماشین

- مدیریت

- مدیریت

- مدیر

- مدیریت

- نقشه برداری

- ماسک

- ریاضی

- ریاضیات

- به معنی

- پزشکی

- عضو

- حافظه

- روش

- متریک

- ML

- مدل

- مدل

- مانیتور

- بیش

- اکثر

- چندگانه

- موسیقی

- طبیعی

- طبیعت

- لازم

- نیازهای

- شبکه

- NIH

- گره

- عدد

- اهداف

- پیشنهادات

- دفتر

- مداوم

- عمل

- عملیات

- بهینه سازی

- سفارش

- دیگر

- مقاله

- بخش

- احساساتی

- حق ثبت اختراع

- کارایی

- دوره ها

- فلسفه

- فیزیک

- بازی

- بازی

- موقعیت

- ممکن

- پتانسیل

- پیش بینی

- پیش گویی

- پیش بینی

- قبلی

- اصلی

- مشکلات

- روند

- فرآیندهای

- در حال پردازش

- محصولات

- پروفایل

- پروژه

- مثبت

- ارائه

- فراهم می کند

- تحت فشار قرار دادند

- محدوده

- مطالعه

- اخیر

- تازه

- سوابق

- بهبود یافتن

- كاهش دادن

- با توجه

- نمایندگی

- نمایندگی

- نیاز

- تحقیق

- منابع

- نتایج

- برگشت

- خطرات

- دویدن

- در حال اجرا

- همان

- مقیاس

- مقیاس گذاری

- علم

- علوم

- دانشمند

- دانه

- سرویس

- خدمات

- چند

- SGD

- شکل

- به اشتراک گذاشته شده

- کوتاه

- نشان داده شده

- مشابه

- ساده

- پس از

- تنها

- اندازه

- کوچک

- So

- فوتبال

- راه حل

- مزایا

- حل

- حل می کند

- برخی از

- فضا

- به طور خاص

- سرعت

- هزینه

- انشعاب

- تقسیم می کند

- پشته

- آغاز شده

- دولت

- وضعیت هنر

- ایالات

- opbevare

- استراتژی ها

- موفقیت

- پایداری

- سیستم

- وظایف

- تکنیک

- فن آوری

- پیشرفته

- La

- هزاران نفر

- از طریق

- توان

- زمان

- بار

- رمز

- نشانه

- ابزار

- مسیر

- علامت تجارتی

- سنتی

- آموزش

- روند

- اوبونتو

- بی سابقه

- us

- استفاده کنید

- آب و برق

- با استفاده از

- ارزش

- تنوع

- مختلف

- عمودی

- دید

- حجم

- صبر کنيد

- موج

- راه

- چه

- در حین

- ویکیپدیا

- بدون

- کلمات

- مهاجرت کاری

- کارگر

- کارگران

- با این نسخهها کار

- X

- سال

- شما

- یوتیوب