همانطور که یادگیری ماشین (ML) به جریان اصلی تبدیل می شود و پذیرش گسترده تری پیدا می کند، برنامه های کاربردی مبتنی بر ML به طور فزاینده ای برای حل طیف وسیعی از مشکلات تجاری پیچیده رایج می شوند. راه حل این مشکلات پیچیده تجاری اغلب مستلزم استفاده از چندین مدل ML است. این مدل ها را می توان به صورت متوالی برای انجام وظایف مختلف مانند پیش پردازش، تبدیل داده ها، انتخاب مدل، تولید استنتاج، تلفیق استنتاج و پس پردازش ترکیب کرد. سازمانها به گزینههای انعطافپذیری نیاز دارند تا این گردشهای کاری پیچیده ML را تنظیم کنند. خطوط لوله استنتاج سریالی یکی از این الگوهای طراحی برای مرتب کردن این گردشها به یک سری مراحل است که هر مرحله خروجی تولید شده توسط مراحل قبلی را غنیسازی یا پردازش میکند و خروجی را به مرحله بعدی در خط لوله منتقل میکند.

علاوه بر این، این خطوط لوله استنتاج سریال باید موارد زیر را ارائه دهند:

- پیاده سازی انعطاف پذیر و سفارشی (وابستگی ها، الگوریتم ها، منطق تجاری و غیره)

- تکراری و سازگار برای اجرای تولید

- بلند کردن اجسام متمایز نشده با به حداقل رساندن مدیریت زیرساخت

در این پست، ما به برخی از موارد استفاده رایج برای خطوط لوله استنتاج سریال نگاه می کنیم و برخی از گزینه های پیاده سازی را برای هر یک از این موارد استفاده با استفاده از آمازون SageMaker. ما همچنین ملاحظاتی را برای هر یک از این گزینه های اجرایی مورد بحث قرار می دهیم.

جدول زیر موارد مختلف استفاده برای استنتاج سریال، ملاحظات پیاده سازی و گزینه ها را خلاصه می کند. در این پست به این موارد پرداخته شده است.

| استفاده از مورد | از شرح مورد استفاده کنید | ملاحظات اولیه | پیچیدگی اجرای کلی | گزینه های پیاده سازی توصیه شده | نمونه کد مصنوعات و نوت بوک |

| خط لوله استنتاج سریال (با مراحل پیش پردازش و پس پردازش شامل) | خط لوله استنتاج باید قبل از فراخوانی یک مدل آموزش دیده برای تولید استنتاج، داده های دریافتی را از قبل پردازش کند، و سپس استنتاج های تولید شده پس از پردازش، به گونه ای که بتوانند به راحتی توسط برنامه های کاربردی پایین دست مصرف شوند. | سهولت اجرای | کم | ظرف استنتاج با استفاده از SageMaker Inference Toolkit | یک مدل PyTorch آموزش دیده را مستقر کنید |

| خط لوله استنتاج سریال (با مراحل پیش پردازش و پس پردازش شامل) | خط لوله استنتاج باید قبل از فراخوانی یک مدل آموزش دیده برای تولید استنتاج، داده های دریافتی را از قبل پردازش کند، و سپس استنتاج های تولید شده پس از پردازش، به گونه ای که بتوانند به راحتی توسط برنامه های کاربردی پایین دست مصرف شوند. | جداسازی، استقرار ساده و ارتقاء | متوسط | خط لوله استنتاج SageMaker | خط لوله استنتاج با ظروف سفارشی و xgBoost |

| مجموعه مدل سریال | خط لوله استنتاج باید چندین مدل را به صورت متوالی میزبان و مرتب کند، به طوری که هر مدل استنتاج تولید شده توسط مدل قبلی را قبل از ایجاد استنتاج نهایی افزایش دهد. | جداسازی، استقرار و ارتقاء ساده، انعطاف پذیری در انتخاب چارچوب مدل | متوسط | خط لوله استنتاج SageMaker | خط لوله استنتاج با Scikit-learn و Linear Learner |

| خط لوله استنتاج سریال (با فراخوانی مدل هدفمند از یک گروه) | خط لوله استنتاج علاوه بر انجام وظایف پیش پردازش و پس پردازش، نیاز به فراخوانی یک مدل سفارشی خاص از گروهی از مدل های مستقر، بر اساس ویژگی های درخواست یا برای بهینه سازی هزینه دارد. | بهینه سازی هزینه و سفارشی سازی | زیاد | خط لوله استنتاج SageMaker با نقاط پایانی چند مدلی (MME) | Amazon SageMaker چند مدل پایانی با استفاده از Linear Learner |

در بخشهای بعدی، هر مورد استفاده را با جزئیات بیشتری مورد بحث قرار میدهیم.

خط لوله استنتاج سریالی با استفاده از ظروف استنتاج

موارد استفاده از خط لوله استنتاج سریالی الزاماتی برای پیش پردازش داده های دریافتی قبل از فراخوانی یک مدل ML از پیش آموزش دیده برای تولید استنتاج دارند. علاوه بر این، در برخی موارد، استنتاج های تولید شده ممکن است نیاز به پردازش بیشتر داشته باشند، به طوری که بتوانند به راحتی توسط برنامه های کاربردی پایین دست مصرف شوند. این یک سناریوی رایج برای موارد استفاده است که در آن یک منبع داده جریانی باید در زمان واقعی پردازش شود قبل از اینکه یک مدل بر روی آن نصب شود. با این حال، این مورد استفاده می تواند برای استنتاج دسته ای نیز آشکار شود.

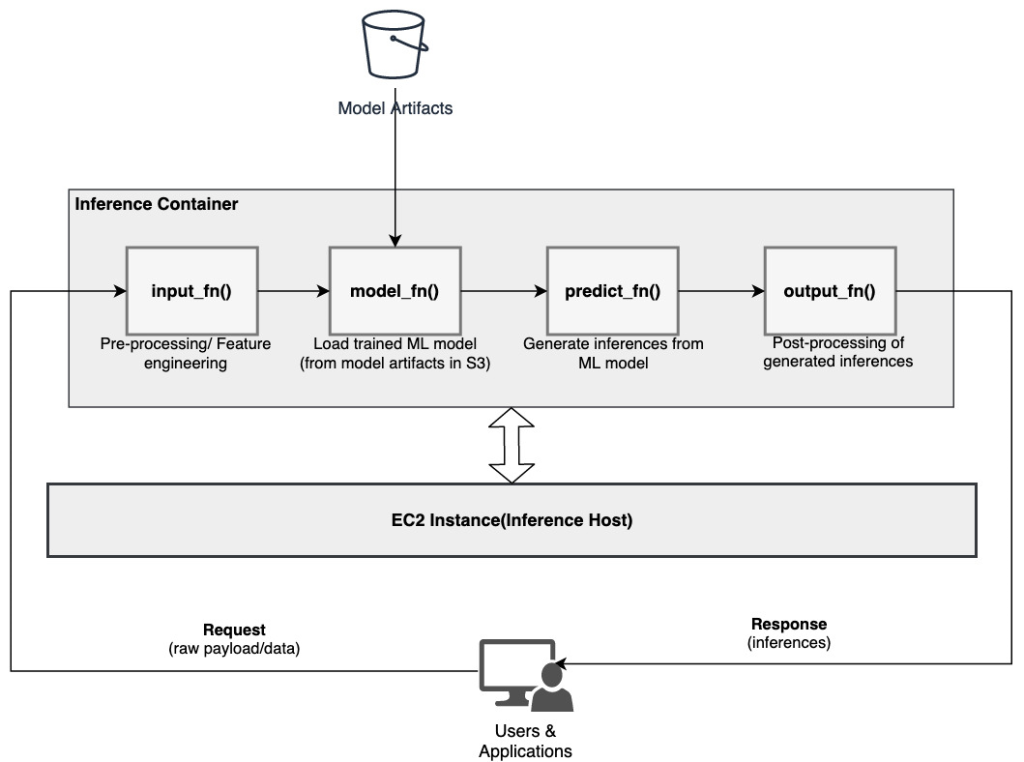

SageMaker گزینه ای برای سفارشی کردن کانتینرهای استنتاج و استفاده از آنها برای ساخت خط لوله استنتاج سریال ارائه می دهد. ظروف استنتاج از SageMaker Inference Toolkit و بر روی ساخته شده اند سرور چند مدل SageMaker (MMS)، که مکانیزمی انعطاف پذیر برای ارائه مدل های ML فراهم می کند. نمودار زیر یک الگوی مرجع از نحوه اجرای خط لوله استنتاج سریالی با استفاده از کانتینرهای استنتاج را نشان می دهد.

SageMaker MMS از یک اسکریپت پایتون انتظار دارد که توابع زیر را برای بارگذاری مدل، پیش پردازش داده های ورودی، دریافت پیش بینی از مدل و پس پردازش داده های خروجی پیاده سازی کند:

- input_fn() - مسئول جداسازی و پیش پردازش داده های ورودی

- model_fn() - مسئول بارگیری مدل آموزش دیده از مصنوعات در سرویس ذخیره سازی ساده آمازون (آمازون S3)

- predict_fn() - مسئول استنتاج از مدل است

- output_fn() - مسئول سریال سازی و پس پردازش داده های خروجی (استنتاج)

برای مراحل دقیق برای سفارشی کردن ظرف استنتاج، به تطبیق ظرف استنتاج خودتان.

ظروف استنتاج یک الگوی طراحی ایده آل برای موارد استفاده از خط لوله استنتاج سریال با ملاحظات اولیه زیر است:

- انسجام بالا - منطق پردازش و مدل متناظر، عملکرد واحد تجاری را هدایت می کند و نیاز به مکان یابی مشترک دارد

- تاخیر کلی پایین - زمان سپری شده بین درخواست استنباط تا دریافت پاسخ

در خط لوله استنتاج سریالی، منطق و مدل پردازش در یک ظرف واحد محصور میشوند، بنابراین بسیاری از فراخوانیهای فراخوانی درون ظرف باقی میمانند. این به کاهش تعداد کلی هاپ کمک می کند و در نتیجه تاخیر کلی و پاسخگویی بهتر خط لوله ایجاد می کند.

همچنین، برای موارد استفاده که سهولت اجرا یک معیار مهم است، کانتینرهای استنتاج می توانند کمک کنند، با مراحل مختلف پردازش خط لوله در یک کانتینر مشترک قرار می گیرند.

خط لوله استنتاج سریالی با استفاده از خط لوله استنتاج SageMaker

یکی دیگر از موارد استفاده از خط لوله استنتاج سریال، مستلزم جداسازی واضح تر بین مراحل مختلف در خط لوله است (مانند پیش پردازش داده، تولید استنتاج، پس پردازش داده، و قالب بندی و سریال سازی). این می تواند به دلایل مختلفی باشد:

- جدایی - مراحل مختلف خط لوله دارای هدف مشخص و مشخصی هستند و به دلیل وابستگی های اساسی درگیر باید در کانتینرهای جداگانه اجرا شوند. این همچنین به حفظ ساختار لوله کمک می کند.

- چارچوب - مراحل مختلف خط لوله از چارچوبهای مناسب برای هدف خاص (مانند scikit یا Spark ML) استفاده میکنند و بنابراین باید روی کانتینرهای جداگانه اجرا شوند.

- جداسازی منابع - مراحل مختلف خط لوله نیازهای مصرف منابع متفاوتی دارند و بنابراین برای انعطاف و کنترل بیشتر باید روی کانتینرهای جداگانه اجرا شوند.

علاوه بر این، برای خطوط لوله استنتاج سریالی کمی پیچیده تر، ممکن است چندین مرحله برای پردازش یک درخواست و تولید یک استنتاج درگیر شود. بنابراین، از نقطه نظر عملیاتی، میزبانی این مراحل در کانتینرهای جداگانه برای جداسازی عملکردی بهتر، و تسهیل ارتقاء و بهبود آسانتر (تغییر یک مرحله بدون تأثیر بر سایر مدلها یا مراحل پردازش) ممکن است مفید باشد.

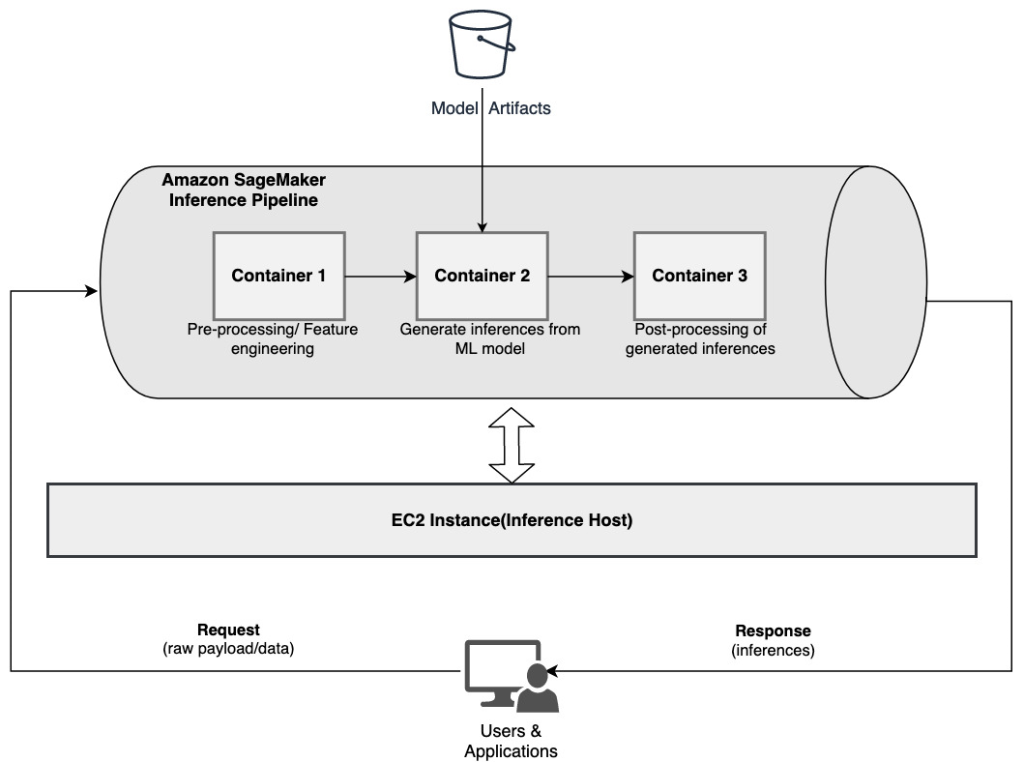

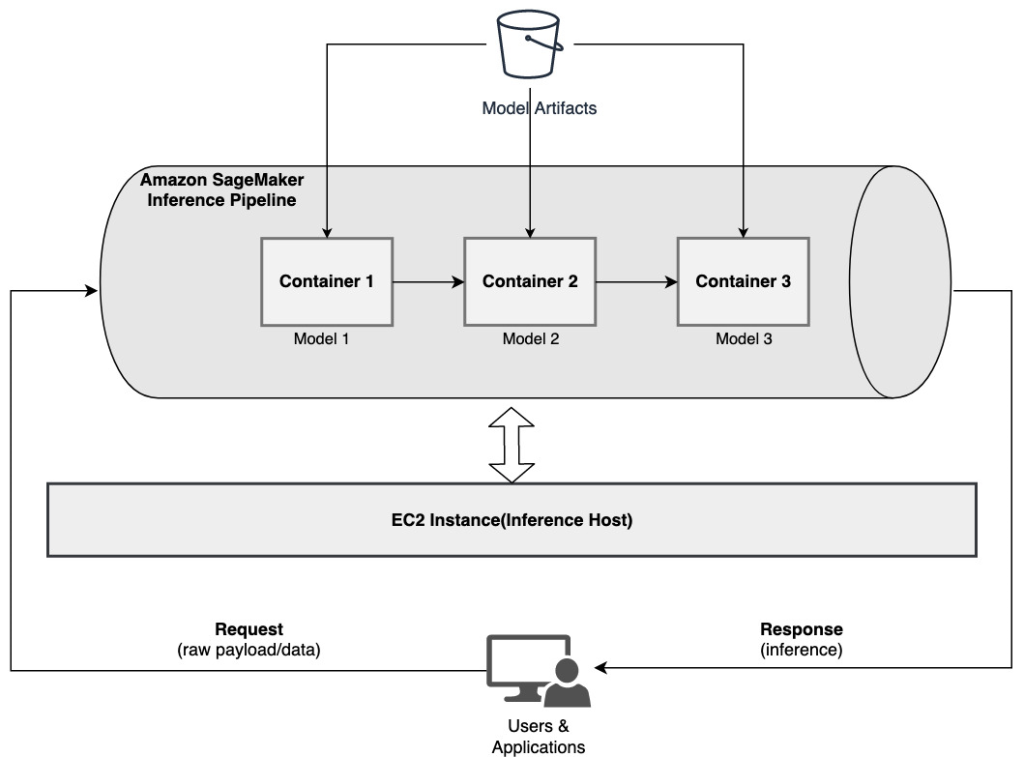

اگر مورد استفاده شما با برخی از این ملاحظات مطابقت دارد، الف خط لوله استنتاج SageMaker گزینه ای آسان و انعطاف پذیر برای ساخت خط لوله استنتاج سریالی فراهم می کند. نمودار زیر یک الگوی مرجع از نحوه اجرای یک خط لوله استنتاج سریالی با استفاده از چندین مرحله میزبانی شده روی کانتینرهای اختصاصی با استفاده از خط لوله استنتاج SageMaker را نشان می دهد.

خط لوله استنتاج SageMaker از یک توالی خطی از 2 تا 15 کانتینر تشکیل شده است که درخواست های استنتاج روی داده ها را پردازش می کند. خط لوله استنتاج گزینه ای را برای استفاده از الگوریتم های داخلی SageMaker از پیش آموزش دیده یا الگوریتم های سفارشی بسته بندی شده در ظروف Docker فراهم می کند. کانتینرها بر روی یک نمونه اصلی میزبانی می شوند، که به کاهش تاخیر کلی و به حداقل رساندن هزینه کمک می کند.

قطعه کد زیر نشان می دهد که چگونه مراحل و مدل های متعدد پردازش را می توان برای ایجاد یک خط لوله استنتاج سریال ترکیب کرد.

ما با ساخت و تعیین مدلهای مبتنی بر Spark ML و XGBoost که قصد داریم به عنوان بخشی از خط لوله استفاده کنیم، شروع میکنیم:

سپس مدل ها به صورت متوالی در تعریف مدل خط لوله مرتب می شوند:

سپس خط لوله استنتاج در پشت یک نقطه پایانی برای استنتاج بلادرنگ با مشخص کردن نوع و تعداد نمونه های میزبان ML مستقر می شود:

کل خط لوله استنتاج مونتاژ شده را می توان یک مدل SageMaker در نظر گرفت که می توانید از آن برای پیش بینی های بلادرنگ یا تبدیل های دسته ای پردازش به طور مستقیم و بدون هیچ گونه پیش پردازش خارجی استفاده کنید. در یک مدل خط لوله استنتاج، SageMaker فراخوانها را به عنوان دنبالهای از درخواستهای HTTP که از یک برنامه کاربردی خارجی سرچشمه میگیرد، مدیریت میکند. اولین کانتینر در خط لوله، درخواست اولیه را رسیدگی می کند، برخی از پردازش ها را انجام می دهد، و سپس پاسخ میانی را به عنوان یک درخواست به ظرف دوم در خط لوله ارسال می کند. این اتفاق برای هر کانتینر در خط لوله رخ می دهد و در نهایت پاسخ نهایی را به برنامه کلاینت فراخوان برمی گرداند.

خطوط لوله استنتاج SageMaker به طور کامل مدیریت می شوند. هنگامی که خط لوله مستقر می شود، SageMaker همه کانتینرهای تعریف شده را روی هر یک از آنها نصب و اجرا می کند. ابر محاسبه الاستیک آمازون نمونه های (Amazon EC2) به عنوان بخشی از کار تبدیل نقطه پایانی یا دسته ای ارائه شده است. علاوه بر این، به دلیل اینکه کانتینرها در یک نمونه EC2 قرار گرفته و میزبانی می شوند، تاخیر کلی خط لوله کاهش می یابد.

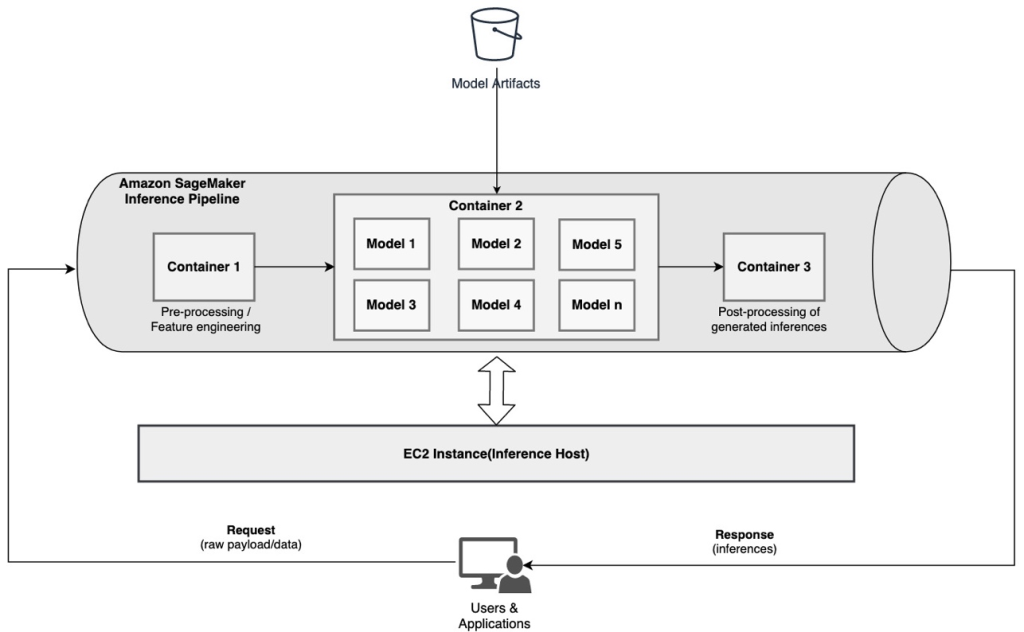

مجموعه مدل سریال با استفاده از خط لوله استنتاج SageMaker

یک مدل مجموعه رویکردی در ML است که در آن چندین مدل ML ترکیب شده و به عنوان بخشی از فرآیند استنتاج برای تولید استنتاج نهایی استفاده می شود. انگیزههای مدلهای گروهی میتواند شامل بهبود دقت، کاهش حساسیت مدل به ویژگیهای ورودی خاص، و کاهش سوگیری مدل تکی باشد. در این پست، ما روی موارد استفاده مربوط به یک مجموعه مدل سریال تمرکز می کنیم، که در آن چندین مدل ML به صورت متوالی به عنوان بخشی از خط لوله استنتاج سریال ترکیب می شوند.

بیایید یک مثال خاص مربوط به یک مجموعه مدل سریال را در نظر بگیریم که در آن باید تصاویر آپلود شده کاربر را بر اساس مضامین یا موضوعات خاص گروه بندی کنیم. این خط لوله می تواند از سه مدل ML تشکیل شود:

- مدل 1 - یک تصویر را به عنوان ورودی می پذیرد و کیفیت تصویر را بر اساس وضوح تصویر، جهت گیری و موارد دیگر ارزیابی می کند. سپس این مدل سعی می کند کیفیت تصویر را ارتقا دهد و تصاویر پردازش شده را که آستانه کیفیت مشخصی را برآورده می کنند به مدل بعدی (مدل 2) ارسال می کند.

- مدل 2 – تصاویر تایید شده از طریق مدل 1 را می پذیرد و اجرا می کند تشخیص تصویر برای شناسایی اشیاء، مکان ها، افراد، متن و سایر اعمال و مفاهیم سفارشی در تصاویر. خروجی مدل 2 که حاوی اشیاء شناسایی شده است به مدل 3 ارسال می شود.

- مدل 3 – خروجی مدل 2 را می پذیرد و وظایف پردازش زبان طبیعی (NLP) مانند مدل سازی موضوع را برای گروه بندی تصاویر با هم بر اساس مضامین انجام می دهد. به عنوان مثال، تصاویر را می توان بر اساس مکان یا افراد شناسایی شده گروه بندی کرد. خروجی (گروه بندی) به برنامه مشتری بازگردانده می شود.

نمودار زیر یک الگوی مرجع از نحوه پیاده سازی چندین مدل ML را نشان می دهد که بر روی یک مجموعه مدل سریال با استفاده از خط لوله استنتاج SageMaker میزبانی می شود.

همانطور که قبلاً بحث شد، خط لوله استنتاج SageMaker مدیریت میشود، که به شما امکان میدهد روی انتخاب و توسعه مدل ML تمرکز کنید، در حالی که بار سنگین غیرمتمایز مرتبط با ساخت خط لوله مجموعه سریال را کاهش میدهد.

علاوه بر این، برخی از ملاحظاتی که قبلاً در مورد جداسازی، انتخاب الگوریتم و چارچوب برای توسعه مدل و استقرار بحث شد، در اینجا نیز مرتبط هستند. به عنوان مثال، از آنجا که هر مدل در یک ظرف جداگانه میزبانی می شود، شما در انتخاب چارچوب ML که به بهترین وجه با هر مدل و مورد استفاده کلی شما مطابقت دارد، انعطاف پذیری دارید. علاوه بر این، از منظر جداسازی و عملیاتی، میتوانید به ارتقا یا اصلاح مراحل جداگانه ادامه دهید، بدون اینکه روی مدلهای دیگر تأثیری داشته باشید.

خط لوله استنتاج SageMaker نیز با ادغام شده است رجیستری مدل SageMaker برای فهرستنویسی مدل، نسخهسازی، مدیریت ابرداده و استقرار تحت کنترل در محیطهای تولید برای پشتیبانی از بهترین شیوههای عملیاتی. خط لوله استنتاج SageMaker نیز با آن یکپارچه شده است CloudWatch آمازون برای فعال کردن نظارت بر مدل های چند کانتینری در خطوط لوله استنتاج. شما همچنین می توانید دید را وارد کنید معیارهای زمان واقعی برای درک بهتر فراخوان ها و تأخیر برای هر ظرف در خط لوله، که به عیب یابی و بهینه سازی منابع کمک می کند.

خط لوله استنتاج سریال (با فراخوانی مدل هدفمند از یک گروه) با استفاده از خط لوله استنتاج SageMaker

نقاط پایانی چند مدل SageMaker (MME) یک راه حل مقرون به صرفه برای استقرار تعداد زیادی مدل ML در پشت یک نقطه پایانی ارائه می دهد. انگیزههای استفاده از نقاط پایانی چند مدلی میتواند شامل فراخوانی یک مدل سفارشیشده خاص بر اساس ویژگیهای درخواست (مانند مبدأ، موقعیت جغرافیایی، شخصیسازی کاربر و غیره) یا به سادگی میزبانی چندین مدل در پشت نقطه پایانی یکسان برای دستیابی به بهینهسازی هزینه باشد.

وقتی چندین مدل را روی یک نقطه پایانی فعال چند مدلی مستقر میکنید، همه مدلها منابع محاسباتی و ظرف سرویسدهی مدل را به اشتراک میگذارند. خط لوله استنتاج SageMaker را می توان در یک MME مستقر کرد، جایی که یکی از کانتینرهای موجود در خط لوله می تواند به صورت پویا درخواست ها را بر اساس مدل خاصی که فراخوانی می شود ارائه دهد. از منظر خط لوله، مدلها نیازمندیهای پیشپردازش یکسانی دارند و انتظار دارند مجموعه ویژگیهای یکسانی داشته باشند، اما برای همسویی با یک رفتار خاص آموزش دیدهاند. نمودار زیر یک الگوی مرجع از نحوه عملکرد این خط لوله یکپارچه را نشان می دهد.

با MMEها، درخواست استنتاج که از برنامه مشتری منشا می گیرد باید مدل هدفی را که باید فراخوانی شود مشخص کند. اولین کانتینر در خط لوله، درخواست اولیه را رسیدگی می کند، برخی از پردازش ها را انجام می دهد، و سپس پاسخ میانی را به عنوان یک درخواست به کانتینر دوم در خط لوله، که میزبان مدل های متعدد است، ارسال می کند. بر اساس مدل هدف مشخص شده در درخواست استنتاج، مدل برای ایجاد یک استنتاج فراخوانی می شود. استنتاج تولید شده برای پردازش بیشتر به ظرف بعدی در خط لوله ارسال می شود. این اتفاق برای هر کانتینر بعدی در خط لوله میافتد و در نهایت SageMaker پاسخ نهایی را به برنامه کلاینت فراخوان برمیگرداند.

مصنوعات چند مدل در یک سطل S3 باقی می مانند. هنگامی که یک مدل خاص فراخوانی می شود، SageMaker به صورت پویا آن را بر روی ظرف میزبان نقطه پایان بارگذاری می کند. اگر مدل قبلاً در حافظه کانتینر بارگذاری شده باشد، فراخوانی سریعتر است زیرا SageMaker نیازی به دانلود مدل از Amazon S3 ندارد. اگر استفاده از حافظه نمونه زیاد باشد و مدل جدیدی فراخوانی شود و بنابراین نیاز به بارگذاری داشته باشد، مدل های استفاده نشده از حافظه تخلیه می شوند. با این حال، مدلهای تخلیهنشده در حجم ذخیرهسازی نمونه باقی میمانند و میتوانند بعداً دوباره در حافظه ظرف بارگیری شوند، بدون اینکه دوباره از سطل S3 بارگیری شوند.

یکی از ملاحظات کلیدی هنگام استفاده از MMEها، درک رفتار تأخیر فراخوانی مدل است. همانطور که قبلاً بحث شد، مدل ها به صورت پویا در حافظه کانتینر نمونه میزبان نقطه پایانی هنگام فراخوانی بارگذاری می شوند. بنابراین، فراخوانی مدل ممکن است زمانی که برای اولین بار فراخوانی می شود بیشتر طول بکشد. وقتی مدل از قبل در حافظه کانتینر نمونه باشد، فراخوانیهای بعدی سریعتر هستند. اگر استفاده از حافظه نمونه زیاد باشد و یک مدل جدید نیاز به بارگیری داشته باشد، مدل های استفاده نشده تخلیه می شوند. اگر حجم ذخیره سازی نمونه پر باشد، مدل های استفاده نشده از حجم ذخیره حذف می شوند. SageMaker بارگیری و تخلیه مدل ها را به طور کامل مدیریت می کند، بدون اینکه شما هیچ اقدام خاصی انجام دهید. با این حال، درک این رفتار مهم است، زیرا پیامدهایی بر تأخیر فراخوانی مدل و بنابراین تأخیر کلی انتها به انتها دارد.

گزینه های میزبانی خط لوله

SageMaker چندین مورد را ارائه می دهد نوع نمونه گزینه هایی برای استقرار مدل های ML و ایجاد خطوط لوله استنتاج، بر اساس مورد استفاده، توان عملیاتی و هزینه مورد نیاز شما، انتخاب کنید. برای مثال، میتوانید نمونههای بهینهشده CPU یا GPU را برای ساخت خطوط لوله استنتاج سریال، روی یک کانتینر یا در چندین کانتینر انتخاب کنید. با این حال، گاهی اوقات الزاماتی وجود دارد که برای انعطافپذیری بیشتر، نیاز به انعطافپذیری و پشتیبانی برای اجرای مدلها بر روی نمونههای مبتنی بر CPU یا GPU در همان خط لوله وجود دارد.

اکنون می توانید از NVIDIA Triton Inference Server برای ارائه مدل ها برای استنتاج در SageMaker برای نیازهای محاسباتی ناهمگن استفاده کنید. وارسی هوش مصنوعی سریع و مقیاسپذیر را با NVIDIA Triton Inference Server در Amazon SageMaker مستقر کنید برای جزئیات بیشتر

نتیجه

از آنجایی که سازمانها راهحلهای جدیدی را کشف میکنند و میسازند که توسط ML پشتیبانی میشوند، ابزارهای مورد نیاز برای هماهنگسازی این خطوط لوله باید به اندازه کافی انعطافپذیر باشند تا بر اساس یک مورد خاص پشتیبانی کنند، در حالی که هزینههای عملیاتی جاری را ساده و کاهش میدهند. SageMaker گزینههای متعددی را برای طراحی و ساخت این گردشهای کاری استنتاج سریال بر اساس نیازهای شما ارائه میکند.

ما مشتاقانه منتظر شنیدن نظرات شما در مورد موارد استفاده شما با استفاده از خطوط لوله استنتاج سریال هستیم. اگر سؤال یا بازخوردی دارید، لطفاً آنها را در نظرات به اشتراک بگذارید.

درباره نویسندگان

رهول شرما یک معمار ارشد راه حل در آزمایشگاه داده AWS است که به مشتریان AWS در طراحی و ساخت راه حل های AI/ML کمک می کند. قبل از پیوستن به AWS، راهول چندین سال را در بخش مالی و بیمه سپری کرده است و به مشتریان در ساخت پلتفرم های داده و تحلیلی کمک می کند.

رهول شرما یک معمار ارشد راه حل در آزمایشگاه داده AWS است که به مشتریان AWS در طراحی و ساخت راه حل های AI/ML کمک می کند. قبل از پیوستن به AWS، راهول چندین سال را در بخش مالی و بیمه سپری کرده است و به مشتریان در ساخت پلتفرم های داده و تحلیلی کمک می کند.

آناند پراکاش یک معمار ارشد راه حل در آزمایشگاه داده AWS است. Anand بر کمک به مشتریان در طراحی و ساخت AI/ML، تجزیه و تحلیل داده ها و راه حل های پایگاه داده برای تسریع در مسیر تولید تمرکز دارد.

آناند پراکاش یک معمار ارشد راه حل در آزمایشگاه داده AWS است. Anand بر کمک به مشتریان در طراحی و ساخت AI/ML، تجزیه و تحلیل داده ها و راه حل های پایگاه داده برای تسریع در مسیر تولید تمرکز دارد.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

ساوراب تریکاند یک مدیر ارشد محصول برای Amazon SageMaker Inference است. او مشتاق کار با مشتریان و در دسترستر کردن یادگیری ماشینی است. Saurabh در اوقات فراغت خود از پیاده روی، یادگیری در مورد فن آوری های نوآورانه، دنبال کردن TechCrunch و گذراندن وقت با خانواده خود لذت می برد.

ساوراب تریکاند یک مدیر ارشد محصول برای Amazon SageMaker Inference است. او مشتاق کار با مشتریان و در دسترستر کردن یادگیری ماشینی است. Saurabh در اوقات فراغت خود از پیاده روی، یادگیری در مورد فن آوری های نوآورانه، دنبال کردن TechCrunch و گذراندن وقت با خانواده خود لذت می برد.

- پیشرفته (300)

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آموزش ماشین آمازون

- آمازون SageMaker

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- زفیرنت