In قسمت 1 در این مجموعه، پردازش هوشمند اسناد (IDP) و اینکه چگونه IDP میتواند موارد استفاده از رسیدگی به خسارت را در صنعت بیمه تسریع بخشد، مورد بحث قرار دادیم. ما در مورد اینکه چگونه میتوانیم از خدمات هوش مصنوعی AWS برای دستهبندی دقیق اسناد ادعایی همراه با اسناد پشتیبانی استفاده کنیم، بحث کردیم. همچنین نحوه استخراج انواع اسناد در بسته خسارت بیمه مانند فرم ها، جداول یا اسناد تخصصی مانند فاکتور، رسید یا مدارک شناسایی را مورد بحث قرار دادیم. ما چالشهای موجود در فرآیندهای سند قدیمی را بررسی کردیم، که زمانبر، مستعد خطا، گرانقیمت و پردازش در مقیاس دشوار است، و اینکه چگونه میتوانید از خدمات هوش مصنوعی AWS برای کمک به پیادهسازی خط لوله IDP خود استفاده کنید.

در این پست، شما را با ویژگی های پیشرفته IDP برای استخراج اسناد، پرس و جو و غنی سازی آشنا می کنیم. ما همچنین نحوه استفاده بیشتر از اطلاعات ساختاریافته استخراج شده از داده های ادعاها را برای به دست آوردن بینش با استفاده از AWS Analytics و خدمات تجسم بررسی می کنیم. ما به این موضوع اشاره می کنیم که چگونه داده های ساختار یافته استخراج شده از IDP می تواند در برابر ادعاهای جعلی با استفاده از خدمات AWS Analytics کمک کند.

بررسی اجمالی راه حل

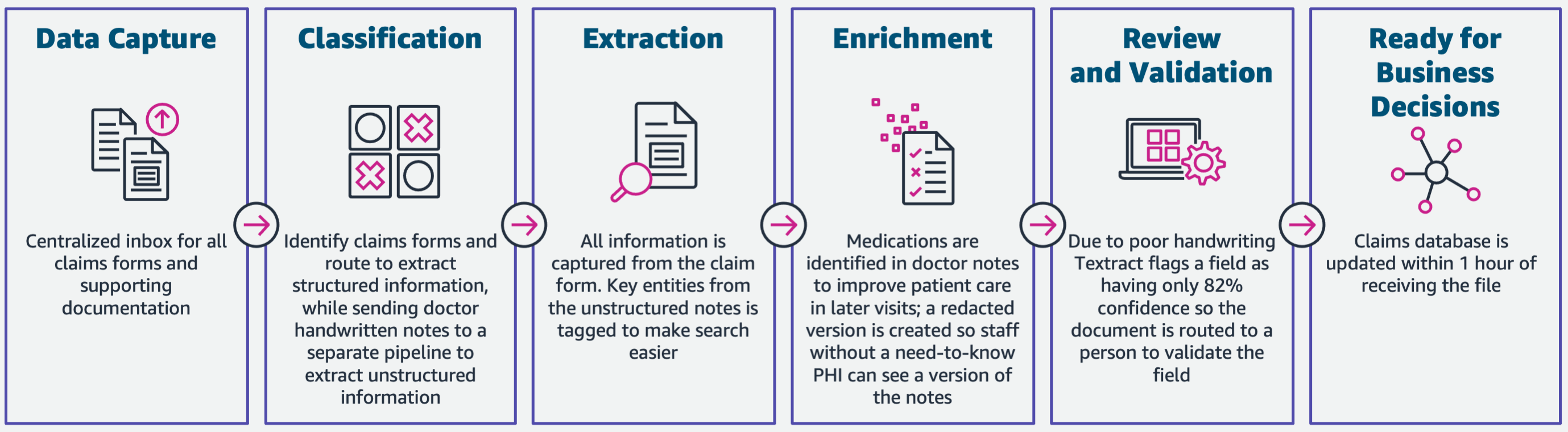

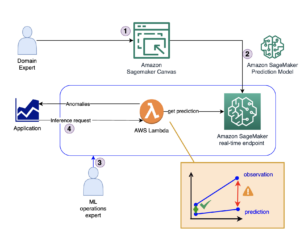

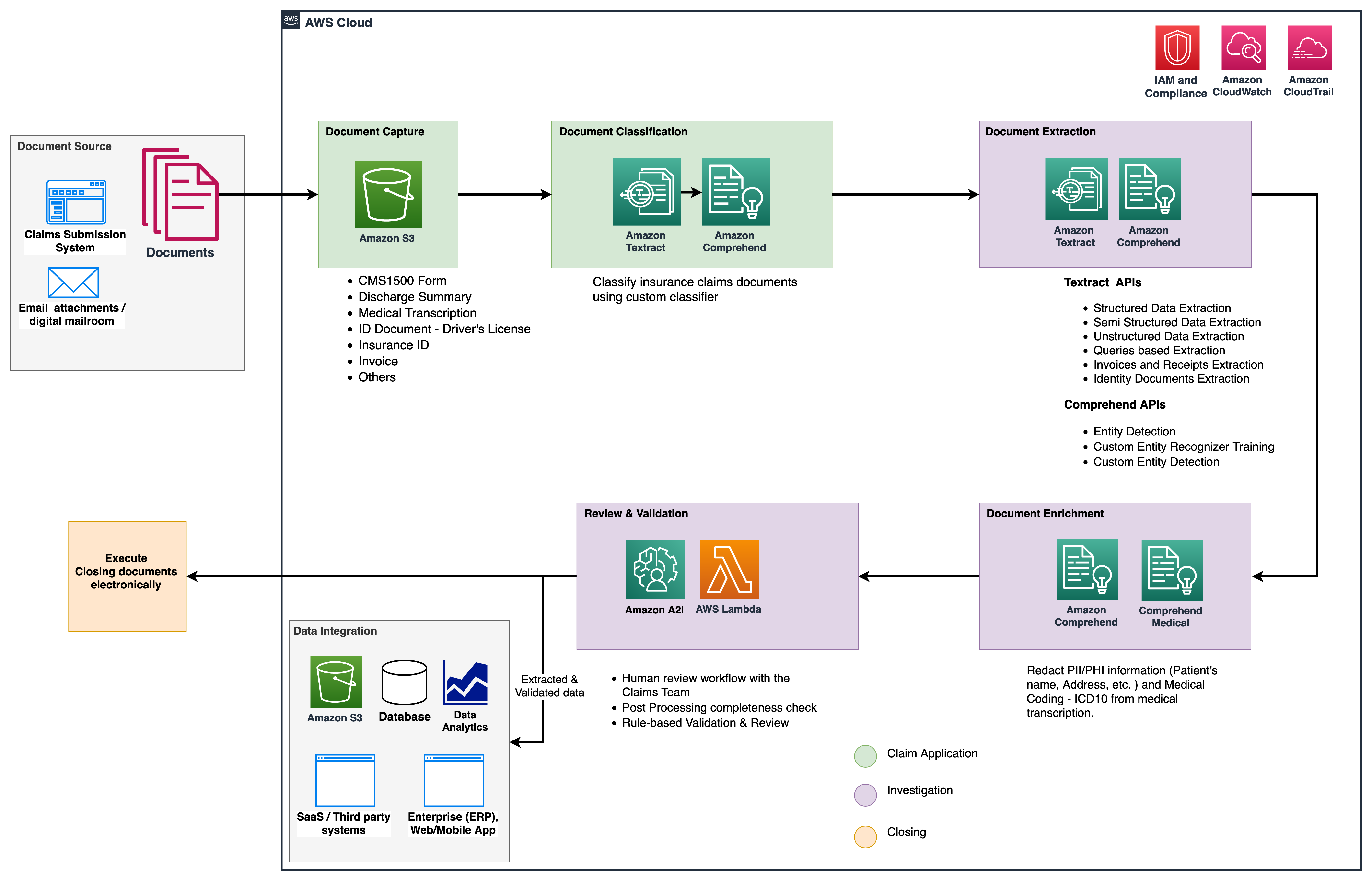

نمودار زیر مراحل استفاده IDP از خدمات AWS AI را نشان می دهد. در قسمت 1، سه مرحله اول گردش کار IDP را مورد بحث قرار دادیم. در این پست، مرحله استخراج و مراحل باقیمانده را که شامل ادغام IDP با خدمات AWS Analytics میشود، توضیح میدهیم.

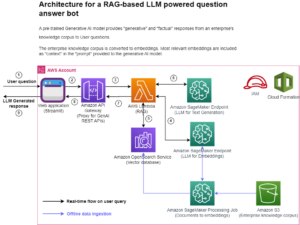

ما از این سرویسهای تحلیلی برای بینشها و تجسمهای بیشتر و شناسایی ادعاهای تقلبی با استفاده از دادههای ساختاریافته و عادی از IDP استفاده میکنیم. نمودار زیر معماری راه حل را نشان می دهد.

مراحلی که در این پست به آنها اشاره می کنیم از خدمات کلیدی زیر استفاده می کنند:

- آمازون Comprehend Medical یک سرویس پردازش زبان طبیعی (NLP) واجد شرایط HIPAA است که از مدلهای یادگیری ماشینی (ML) استفاده میکند که برای درک و استخراج دادههای سلامت از متن پزشکی، مانند نسخهها، رویهها یا تشخیصها، از قبل آموزش دیدهاند.

- چسب AWS بخشی از پشته سرویس های AWS Analytics است و یک سرویس یکپارچه سازی داده بدون سرور است که کشف، آماده سازی و ترکیب داده ها را برای تجزیه و تحلیل، ML و توسعه برنامه آسان می کند.

- آمازون Redshift سرویس دیگری در پشته Analytics است. Amazon Redshift یک سرویس انبار داده کاملاً مدیریت شده در مقیاس پتابایت در فضای ابری است.

پیش نیازها

قبل از شروع، مراجعه کنید قسمت 1 برای یک نمای کلی در سطح بالا از مورد استفاده از بیمه با IDP و جزئیات مربوط به مراحل جمع آوری و طبقه بندی داده ها.

برای اطلاعات بیشتر در مورد نمونه کدها به سایت ما مراجعه کنید مخزن GitHub.

فاز استخراج

در قسمت اول، نحوه استفاده از APIهای متنی آمازون برای استخراج اطلاعاتی مانند فرمها و جداول از اسناد و نحوه تجزیه و تحلیل فاکتورها و اسناد هویتی را دیدیم. در این پست، مرحله استخراج را با آمازون Comprehend بهبود میدهیم تا موجودیتهای پیشفرض و سفارشی مخصوص موارد استفاده سفارشی را استخراج کنیم.

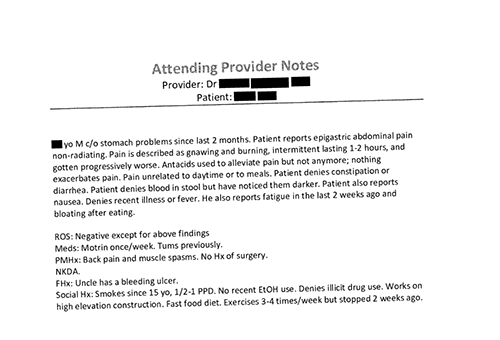

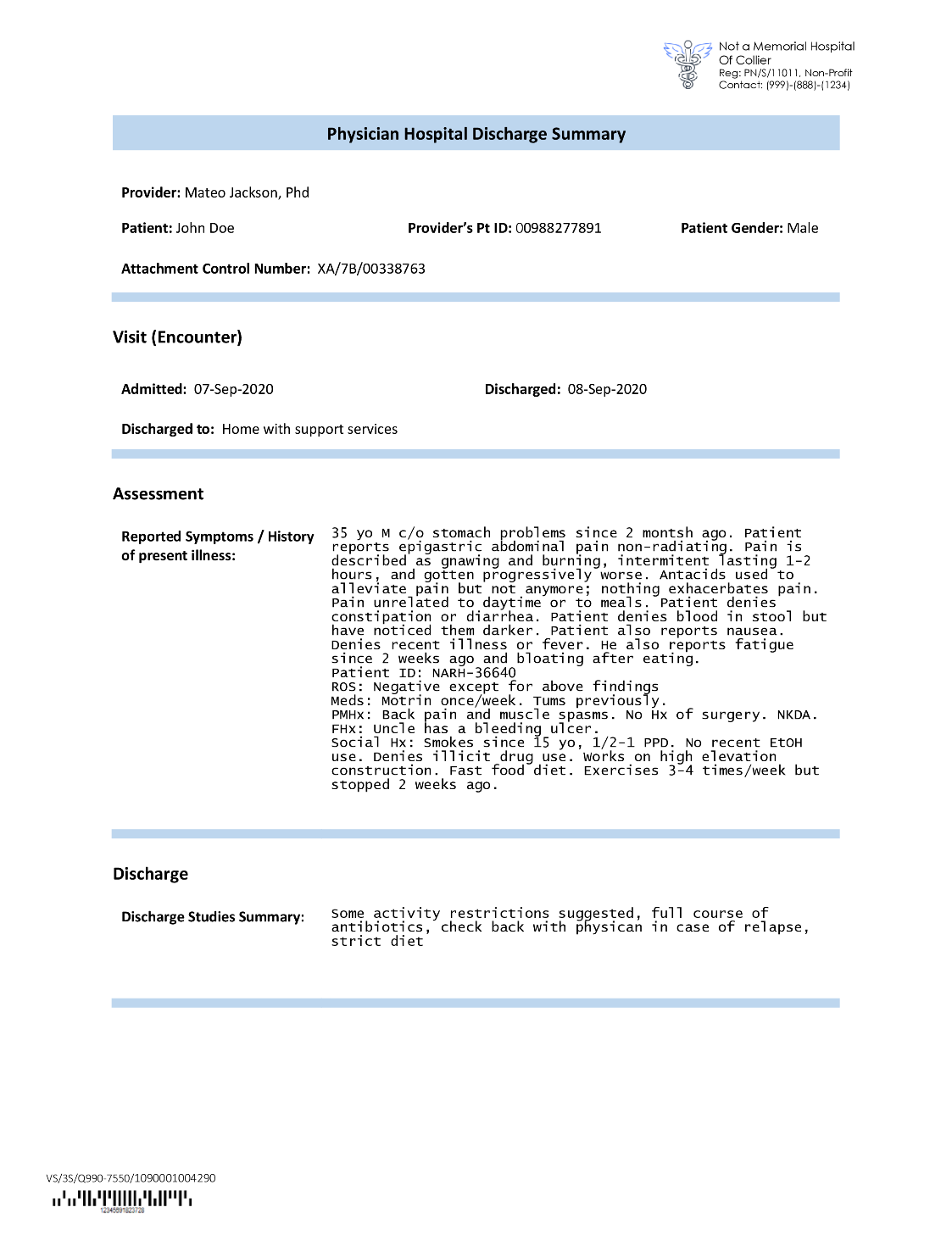

متصدیان بیمه اغلب در برنامههای ادعاهای بیمه با متن فشرده مواجه میشوند، مانند خلاصه نامه ترخیص بیمار (تصویر مثال زیر را ببینید). استخراج خودکار اطلاعات از چنین اسنادی در جایی که ساختار مشخصی وجود ندارد دشوار است. برای رفع این مشکل، میتوانیم از روشهای زیر برای استخراج اطلاعات تجاری کلیدی از سند استفاده کنیم:

موجودیت های پیش فرض را با آمازون Comprehend DetectEntities API استخراج کنید

ما کد زیر را روی نمونه سند رونویسی پزشکی اجرا می کنیم:

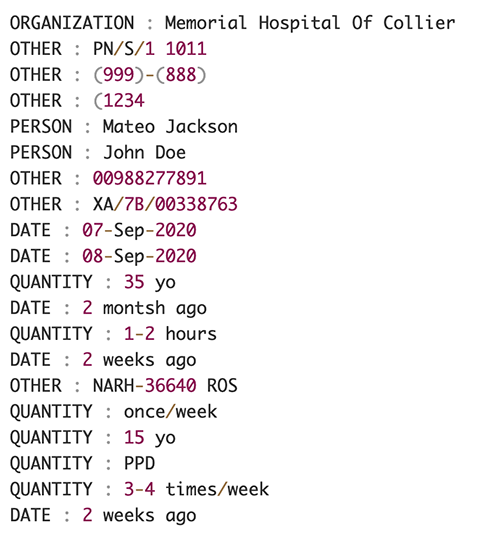

تصویر زیر مجموعه ای از موجودیت های شناسایی شده در متن ورودی را نشان می دهد. خروجی برای اهداف این پست کوتاه شده است. رجوع به GitHub repo برای یک لیست دقیق از نهادها

موجودیتهای سفارشی را با شناسایی موجودیت سفارشی Amazon Comprehend استخراج کنید

پاسخ از DetectEntities API شامل موجودیت های پیش فرض است. با این حال، ما علاقه مند به دانستن مقادیر موجودیت خاص هستیم، مانند نام بیمار (که با موجودیت پیش فرض مشخص می شود PERSON، یا شناسه بیمار (که با موجودیت پیش فرض مشخص شده است OTHER). برای تشخیص این موجودیتهای سفارشی، ما یک مدل شناسایی موجودیت سفارشی آمازون Comprehend را آموزش میدهیم. توصیه می کنیم مراحل جامع نحوه آموزش و استقرار یک مدل شناسایی موجودیت سفارشی را دنبال کنید مخزن GitHub.

پس از استقرار مدل سفارشی، می توانیم از تابع helper استفاده کنیم get_entities() برای بازیابی موجودیت های سفارشی مانند PATIENT_NAME و PATIENT_D از پاسخ API:

تصویر زیر نتایج ما را نشان می دهد.

مرحله غنی سازی

در مرحله غنیسازی اسناد، ما عملکردهای غنیسازی را بر روی اسناد مربوط به مراقبتهای بهداشتی انجام میدهیم تا بینشهای ارزشمندی را به دست آوریم. ما به انواع غنی سازی زیر نگاه می کنیم:

- زبان مخصوص دامنه را استخراج کنید - ما از Amazon Comprehend Medical برای استخراج هستی شناسی های خاص پزشکی مانند ICD-10-CM، RxNorm و SNOMED CT استفاده می کنیم.

- ویرایش اطلاعات حساس - ما از Amazon Comprehend برای ویرایش اطلاعات شناسایی شخصی (PII) و Amazon Comprehend Medical برای ویرایش اطلاعات بهداشتی محافظت شده (PHI) استفاده می کنیم.

استخراج اطلاعات پزشکی از متن پزشکی بدون ساختار

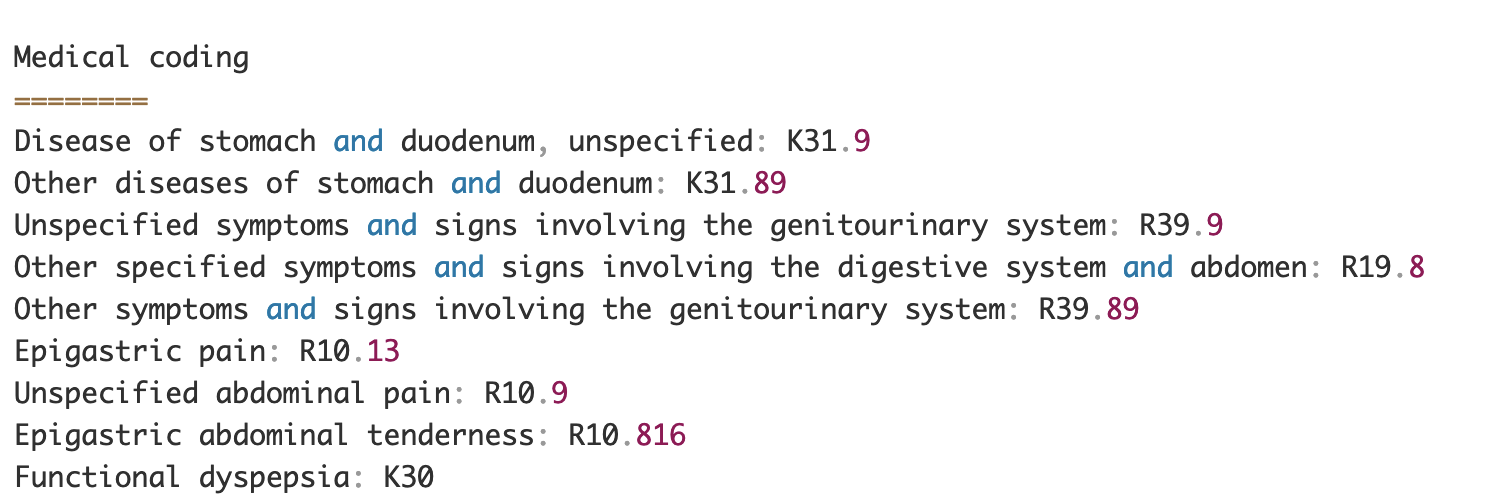

اسنادی مانند یادداشت های ارائه دهندگان پزشکی و گزارش های کارآزمایی بالینی شامل متن پزشکی متراکم است. حاملان ادعاهای بیمه باید روابط بین اطلاعات سلامت استخراج شده از این متن متراکم را شناسایی کرده و آنها را به هستی شناسی های پزشکی مانند کدهای ICD-10-CM، RxNorm و SNOMED CT پیوند دهند. این امر در خودکارسازی گردشهای کاری ثبت، تأیید و تأیید خسارت برای شرکتهای بیمه برای تسریع و سادهسازی پردازش خسارت بسیار ارزشمند است. بیایید ببینیم چگونه می توانیم از آمازون Comprehend Medical استفاده کنیم InferICD10CM API برای شناسایی شرایط پزشکی احتمالی به عنوان موجودیت و پیوند آنها به کدهای آنها:

برای متن ورودی، که میتوانیم آن را از متن آمازون منتقل کنیم DetectDocumentText API، InferICD10CM API خروجی زیر را برمی گرداند (خروجی به اختصار مخفف شده است).

به طور مشابه، ما می توانیم از آمازون Comprehend Medical استفاده کنیم InferRxNorm API برای شناسایی داروها و InferSNOMEDCT API برای شناسایی نهادهای پزشکی در اسناد بیمه مربوط به مراقبت های بهداشتی.

ویرایش PII و PHI را انجام دهید

بستههای ادعاهای بیمهای نیازمند رعایت حریم خصوصی و مقررات زیادی هستند زیرا حاوی دادههای PII و PHI هستند. شرکتهای بیمه میتوانند با ویرایش اطلاعاتی مانند شماره بیمه نامه یا نام بیمار، خطر انطباق را کاهش دهند.

بیایید نمونه ای از خلاصه ترخیص یک بیمار را بررسی کنیم. ما از آمازون Comprehend استفاده می کنیم DetectPiiEntities API برای شناسایی موجودیت های PII در سند و محافظت از حریم خصوصی بیمار با ویرایش این موجودیت ها:

ما موجودیت های PII زیر را در پاسخ از طرف دریافت می کنیم detect_pii_entities() API:

سپس میتوانیم موجودیتهای PII را که از اسناد شناسایی شدهاند، با استفاده از هندسه جعبه مرزی موجودیتها از سند، ویرایش کنیم. برای این کار از ابزار کمکی به نام استفاده می کنیم amazon-textract-overlayer. برای اطلاعات بیشتر مراجعه کنید متن-روی لایه. اسکرین شات های زیر یک سند را قبل و بعد از ویرایش مقایسه می کنند.

مشابه آمازون Comprehend DetectPiiEntities API، ما همچنین می توانیم از DetectPHI API برای تشخیص داده های PHI در متن بالینی مورد بررسی. برای اطلاعات بیشتر مراجعه کنید تشخیص PHI

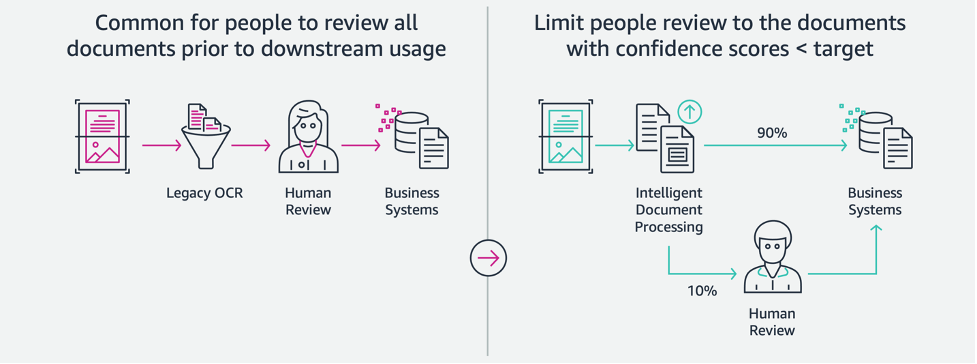

مرحله بررسی و اعتبارسنجی

در مرحله بررسی و اعتبارسنجی اسناد، اکنون میتوانیم بررسی کنیم که آیا بسته ادعایی الزامات کسبوکار را برآورده میکند، زیرا ما تمام اطلاعات جمعآوریشده از اسناد موجود در بسته را از مراحل قبلی در اختیار داریم. ما میتوانیم این کار را با معرفی یک انسان در حلقه انجام دهیم که میتواند همه فیلدها را بررسی و تأیید کند یا فقط یک فرآیند تأیید خودکار برای ادعاهای دلار پایین قبل از ارسال بسته به برنامههای پاییندستی. ما میتوانیم استفاده کنیم هوش مصنوعی آمازون افزوده شده است (Amazon A2I) برای خودکارسازی فرآیند بررسی انسانی برای رسیدگی به خسارت بیمه.

اکنون که همه دادههای مورد نیاز از پردازش ادعاها با استفاده از خدمات هوش مصنوعی برای IDP استخراج و عادی شدهایم، میتوانیم راهحل را برای ادغام با سرویسهای AWS Analytics مانند AWS Glue و Amazon Redshift برای حل موارد استفاده اضافی و ارائه تجزیه و تحلیل و تجسم بیشتر گسترش دهیم.

کشف ادعاهای تقلبی بیمه

در این پست، ما یک معماری بدون سرور را پیادهسازی میکنیم که در آن دادههای استخراجشده و پردازش شده در یک دریاچه داده ذخیره میشود و برای شناسایی ادعاهای جعلی بیمه با استفاده از ML استفاده میشود. ما استفاده می کنیم سرویس ذخیره سازی ساده آمازون (Amazon S3) برای ذخیره داده های پردازش شده. سپس می توانیم استفاده کنیم چسب AWS or آمازون EMR برای پاک کردن داده ها و اضافه کردن فیلدهای اضافی برای قابل مصرف کردن برای گزارش و ML. پس از آن استفاده می کنیم Amazon Redshift ML برای ساخت یک مدل ML تشخیص تقلب. در نهایت، با استفاده از گزارشها میسازیم آمازون QuickSight برای دریافت بینش در مورد داده ها

طرحواره خارجی Amazon Redshift را تنظیم کنید

به منظور این مثال، ما یک را ایجاد کرده ایم مجموعه داده نمونه خروجی یک فرآیند ETL (استخراج، تبدیل و بارگذاری) را شبیه سازی می کند و از کاتالوگ داده چسب AWS به عنوان کاتالوگ ابرداده استفاده می کند. ابتدا یک پایگاه داده به نام ایجاد می کنیم idp_demo در کاتالوگ داده و یک طرحواره خارجی در آمازون Redshift نامیده می شود idp_insurance_demo (به کد زیر مراجعه کنید). ما از یک استفاده می کنیم هویت AWS و مدیریت دسترسی نقش (IAM) برای اعطای مجوز به خوشه آمازون Redshift برای دسترسی به Amazon S3 و آمازون SageMaker. برای اطلاعات بیشتر در مورد نحوه راه اندازی این نقش IAM با کمترین امتیاز، مراجعه کنید دسته بندی و پیکربندی راه اندازی برای مدیریت Amazon Redshift ML.

جدول خارجی Amazon Redshift ایجاد کنید

مرحله بعدی ایجاد یک جدول خارجی در Amazon Redshift است که به مکان S3 که فایل در آن قرار دارد ارجاع می دهد. در این حالت فایل ما یک فایل متنی جدا شده با کاما است. همچنین میخواهیم ردیف سرصفحه را از فایل پرش کنیم، که میتوان آن را در قسمت خصوصیات جدول پیکربندی کرد. کد زیر را ببینید:

مجموعه داده های آموزشی و آزمایشی ایجاد کنید

پس از ایجاد جدول خارجی، مجموعه داده های خود را برای ML با تقسیم آن به مجموعه آموزشی و مجموعه تست آماده می کنیم. یک جدول خارجی جدید به نام ایجاد می کنیم claim_train، که شامل تمام رکوردهای با شناسه <= 85000 از جدول ادعاها است. این مجموعه آموزشی است که ما مدل ML خود را بر روی آن آموزش می دهیم.

جدول خارجی دیگری به نام می سازیم claim_test که شامل تمام رکوردهای با شناسه > 85000 به عنوان مجموعه آزمایشی است که مدل ML را روی آن آزمایش می کنیم:

یک مدل ML با Amazon Redshift ML ایجاد کنید

اکنون مدل را با استفاده از ایجاد مدل دستور (به کد زیر مراجعه کنید). ستون های مربوطه را از بین انتخاب می کنیم claims_train جدولی که می تواند یک معامله متقلبانه را تعیین کند. هدف این مدل پیشبینی ارزش است fraud ستون از این رو، fraud به عنوان هدف پیش بینی اضافه می شود. پس از آموزش مدل، تابعی به نام ایجاد می کند insurance_fraud_model. این تابع برای استنتاج در حین اجرای دستورات SQL برای پیش بینی مقدار استفاده می شود fraud ستون برای رکوردهای جدید

معیارهای مدل ML را ارزیابی کنید

پس از ایجاد مدل، میتوانیم کوئریهایی را برای بررسی صحت مدل اجرا کنیم. ما استفاده می کنیم insurance_fraud_model تابع برای پیش بینی مقدار fraud ستون برای رکوردهای جدید پرس و جوی زیر را روی claims_test جدول برای ایجاد یک ماتریس سردرگمی:

کشف تقلب با استفاده از مدل ML

پس از ایجاد مدل جدید، زمانی که دادههای ادعاهای جدید در انبار داده یا دریاچه داده درج میشوند، میتوانیم از insurance_fraud_model عملکرد محاسبه تراکنش های تقلبی ما این کار را با بارگذاری داده های جدید در یک جدول موقت انجام می دهیم. سپس از insurance_fraud_model تابع برای محاسبه fraud برای هر تراکنش جدید پرچم گذاری کنید و داده ها را به همراه پرچم در جدول نهایی وارد کنید، که در این مورد این است claims جدول.

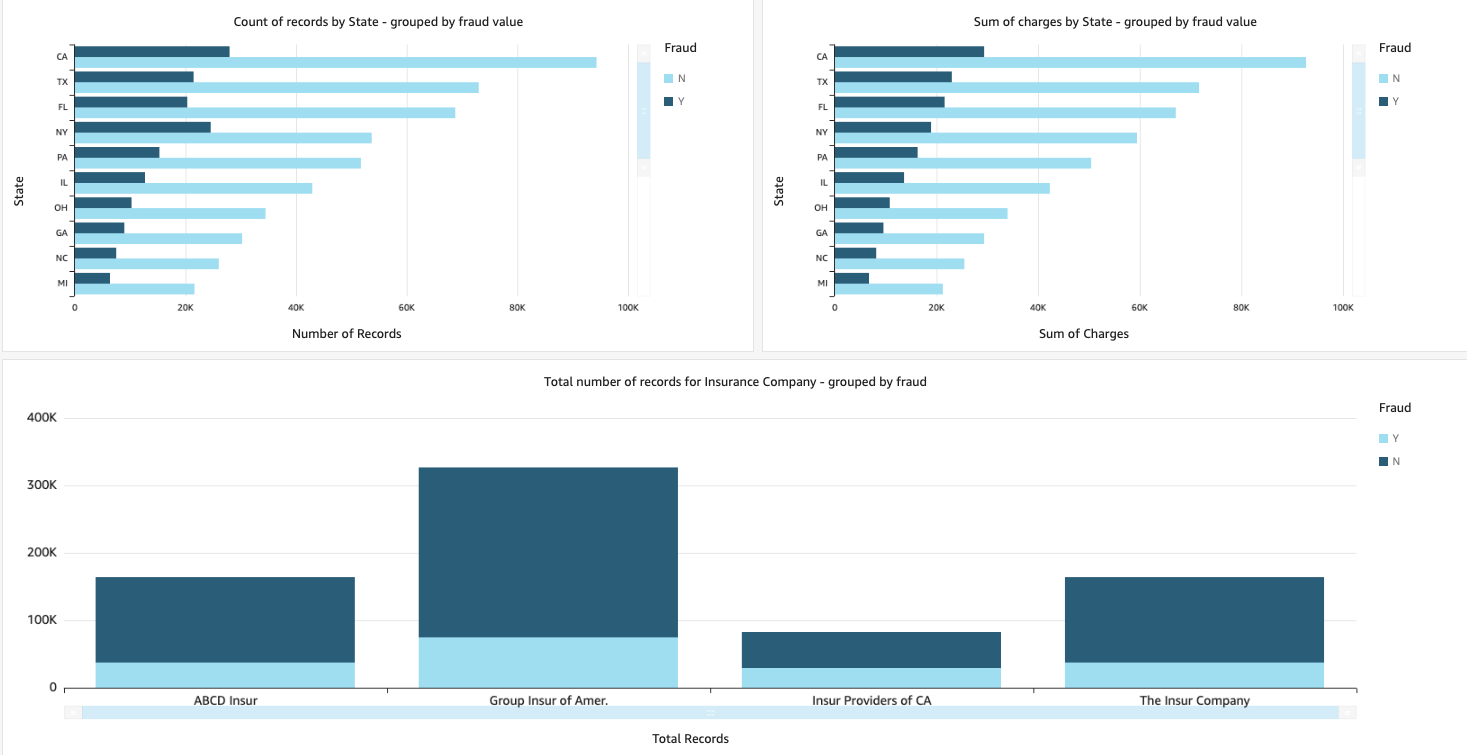

داده های ادعاها را تجسم کنید

هنگامی که داده ها در Amazon Redshift در دسترس هستند، می توانیم با استفاده از QuickSight تجسم ایجاد کنیم. سپس می توانیم داشبوردهای QuickSight را با کاربران تجاری و تحلیلگران به اشتراک بگذاریم. برای ایجاد داشبورد QuickSight، ابتدا باید مجموعه داده Amazon Redshift را در QuickSight ایجاد کنید. برای دستورالعمل، مراجعه کنید ایجاد مجموعه داده از پایگاه داده.

پس از ایجاد مجموعه داده، می توانید یک تحلیل جدید در QuickSight با استفاده از مجموعه داده ایجاد کنید. در زیر چند نمونه از گزارشات ایجاد شده است:

- تعداد کل ادعاها بر اساس ایالت، گروه بندی شده بر اساس

fraudرشته – این نمودار نسبت تراکنش های جعلی را در مقایسه با تعداد کل تراکنش ها در یک ایالت خاص به ما نشان می دهد. - مجموع کل ارزش دلاری ادعاها، گروه بندی شده توسط

fraudرشته - این نمودار نسبت مبلغ دلاری تراکنش های جعلی را در مقایسه با کل مبلغ دلاری تراکنش ها در یک ایالت خاص به ما نشان می دهد. - تعداد کل معاملات هر شرکت بیمه، گروه بندی شده بر اساس

fraudرشته – این نمودار به ما نشان می دهد که برای هر شرکت بیمه چه تعداد خسارت ثبت شده و چه تعداد از آنها تقلبی است.

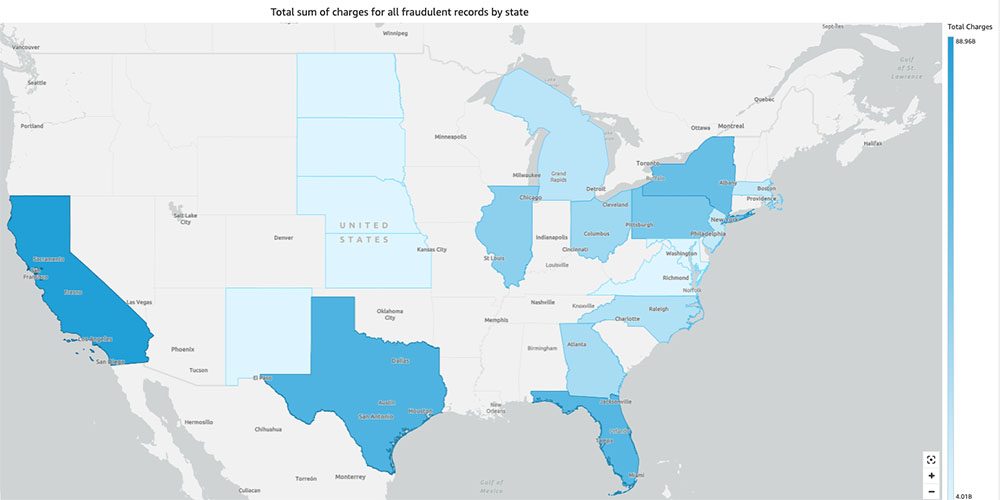

- مجموع کل تراکنش های تقلبی بر اساس ایالت که روی نقشه ایالات متحده نمایش داده شده است - این نمودار فقط تراکنش های تقلبی را نشان می دهد و کل هزینه های آن تراکنش ها را بر اساس ایالت بر روی نقشه نمایش می دهد. سایه تیرهتر آبی نشاندهنده شارژ کل بالاتر است. ما میتوانیم این را بر اساس شهر در آن ایالت و کد پستی با شهر تجزیه و تحلیل کنیم تا روندها را بهتر درک کنیم.

پاک کردن

برای جلوگیری از تحمیل هزینههای آتی به حساب AWS خود، منابعی را که در راهاندازی تهیه کردهاید با پیروی از دستورالعملهای موجود در بخش حذف کنید. بخش پاکسازی در مخزن ما

نتیجه

در این مجموعه دو قسمتی، دیدیم که چگونه می توان یک خط لوله IDP با تجربه کم یا بدون تجربه ML ساخت. ما یک مورد استفاده از پردازش خسارت در صنعت بیمه را بررسی کردیم و اینکه چگونه IDP می تواند به خودکارسازی این مورد استفاده با استفاده از خدماتی مانند Amazon Textract، Amazon Comprehend، Amazon Comprehend Medical و Amazon A2I کمک کند. در قسمت 1، نحوه استفاده از خدمات هوش مصنوعی AWS برای استخراج اسناد را نشان دادیم. در قسمت 2، مرحله استخراج را گسترش دادیم و غنی سازی داده ها را انجام دادیم. در نهایت، ما دادههای ساختاریافته استخراجشده از IDP را برای تجزیه و تحلیل بیشتر گسترش دادیم و تصاویری را برای شناسایی ادعاهای جعلی با استفاده از خدمات AWS Analytics ایجاد کردیم.

توصیه می کنیم بخش های امنیتی را مرور کنید متن آمازون, درک آمازونو آمازون A2I مستندات و پیروی از دستورالعمل های ارائه شده. برای کسب اطلاعات بیشتر در مورد قیمت راه حل، جزئیات قیمت گذاری را بررسی کنید متن آمازون, درک آمازونو آمازون A2I.

درباره نویسنده

چینمائی رین یک معمار راه حل های تخصصی AI/ML در خدمات وب آمازون است. او علاقه زیادی به ریاضیات کاربردی و یادگیری ماشین دارد. او بر روی طراحی راه حل های پردازش اسناد هوشمند برای مشتریان AWS تمرکز دارد. خارج از محل کار، او از رقص سالسا و باچاتا لذت می برد.

چینمائی رین یک معمار راه حل های تخصصی AI/ML در خدمات وب آمازون است. او علاقه زیادی به ریاضیات کاربردی و یادگیری ماشین دارد. او بر روی طراحی راه حل های پردازش اسناد هوشمند برای مشتریان AWS تمرکز دارد. خارج از محل کار، او از رقص سالسا و باچاتا لذت می برد.

عدی نارایانان یک معمار راه حل های متخصص تجزیه و تحلیل در AWS است. او از کمک به مشتریان برای یافتن راه حل های نوآورانه برای چالش های پیچیده تجاری لذت می برد. حوزه های اصلی تمرکز او تجزیه و تحلیل داده ها، سیستم های کلان داده و یادگیری ماشین است. او در اوقات فراغت خود از ورزش، تماشای برنامه های تلویزیونی و مسافرت لذت می برد.

عدی نارایانان یک معمار راه حل های متخصص تجزیه و تحلیل در AWS است. او از کمک به مشتریان برای یافتن راه حل های نوآورانه برای چالش های پیچیده تجاری لذت می برد. حوزه های اصلی تمرکز او تجزیه و تحلیل داده ها، سیستم های کلان داده و یادگیری ماشین است. او در اوقات فراغت خود از ورزش، تماشای برنامه های تلویزیونی و مسافرت لذت می برد.

سونالی سهو تیم معمار راه حل های AI/ML پردازش اسناد هوشمند را در خدمات وب آمازون رهبری می کند. او یک فن دوست پرشور است و از کار با مشتریان برای حل مشکلات پیچیده با استفاده از نوآوری لذت می برد. حوزه اصلی تمرکز او هوش مصنوعی و یادگیری ماشین برای پردازش هوشمند اسناد است.

سونالی سهو تیم معمار راه حل های AI/ML پردازش اسناد هوشمند را در خدمات وب آمازون رهبری می کند. او یک فن دوست پرشور است و از کار با مشتریان برای حل مشکلات پیچیده با استفاده از نوآوری لذت می برد. حوزه اصلی تمرکز او هوش مصنوعی و یادگیری ماشین برای پردازش هوشمند اسناد است.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- درک آمازون

- آمازون Comprehend Medical

- آموزش ماشین آمازون

- متن آمازون

- علم تجزیه و تحلیل

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- دسته بندی نشده

- زفیرنت