سازمانها از یادگیری ماشین (ML) و خدمات هوش مصنوعی برای بهبود تجربه مشتری، کاهش هزینه عملیاتی و باز کردن امکانات جدید برای بهبود نتایج کسبوکار استفاده میکنند. داده ها زیربنای موارد استفاده از ML و AI است و یک دارایی استراتژیک برای یک سازمان است. از آنجایی که داده ها با سرعتی تصاعدی در حال رشد هستند، سازمان ها به دنبال راه اندازی یک پلت فرم داده یکپارچه، مقرون به صرفه و کارآمد هستند تا بتوانند داده ها را پیش پردازش کنند، مهندسی ویژگی ها را انجام دهند و مدل های ML را در مقیاس بسازند، آموزش دهند و عملیاتی کنند. برای دستیابی به آن، AWS یک پلت فرم داده مدرن یکپارچه ارائه می دهد که توسط آن پشتیبانی می شود سرویس ذخیره سازی ساده آمازون (Amazon S3) به عنوان دریاچه داده با ابزارهای هدفمند و موتورهای پردازشی برای پشتیبانی از حجم کاری تحلیلی و ML. برای یک تجربه ML یکپارچه، می توانید استفاده کنید Amazon SageMaker Studio، ارائه می دهد ادغام بومی با جلسات تعاملی AWS Glue برای انجام مهندسی ویژگی در مقیاس با حفاظت از داده های حساس. در این پست نحوه پیاده سازی این راه حل را نشان می دهیم.

آمازون SageMaker یک سرویس ML کاملاً مدیریت شده است که شما را قادر می سازد تا مدل هایی را در مقیاس برای طیف گسترده ای از موارد استفاده کنید. برای آموزش مدل می توانید از هر کدام از آنها استفاده کنید الگوریتم های داخلی در SageMaker برای شروع آموزش و استقرار سریع مدلهای ML.

یکی از اجزای کلیدی فرآیند ساخت و توسعه مدل، مهندسی ویژگی است. چسب AWS یکی از گزینه های پیشنهادی برای دستیابی به مهندسی ویژگی در مقیاس است. چسب AWS شما را قادر می سازد تا یکپارچه سازی و تبدیل داده ها را به صورت توزیع شده در زیرساخت بدون سرور آپاچی Spark اجرا کنید و استفاده از کتابخانه محبوب Spark ML را برای مهندسی ویژگی و توسعه مدل آسان می کند. علاوه بر این، میتوانید از چسب AWS برای پردازش اطلاعات افزایشی استفاده کنید نشانک های شغلی، داده ها را از بیش از 100 منبع با استفاده از اتصال دهنده ها، و با استفاده از بارهای کاری پراکنده یا غیرقابل پیش بینی اجرا کنید مقیاس بندی خودکار.

یکی دیگر از نیازهای مهم برای برنامه های کاربردی مبتنی بر ML، امنیت داده ها و کنترل دسترسی است. این یک تقاضای رایج است که با پیروی از اصول حداقل دسترسی، کنترل دقیقتری بر روی افرادی که میتوانند به حساسترین دادهها به عنوان بخشی از فرآیند مهندسی ویژگی و ساخت مدل دسترسی داشته باشند، داشته باشیم. برای رسیدن به این هدف، می توانید از ادغام AWS Glue با استفاده کنید سازند دریاچه AWS برای افزایش حکمرانی و مدیریت داراییهای دریاچه داده. با Lake Formation، میتوانید کنترل دسترسی به دادهها و سیاستهای امنیتی دقیق را در بالای دریاچه داده Amazon S3 خود پیکربندی کنید. خطمشیها در یک مکان مرکزی تعریف میشوند و به چندین سرویس تجزیه و تحلیل و ML اجازه میدهند، مانند چسب AWS، آمازون آتناو SageMaker، برای تعامل با داده های ذخیره شده در Amazon S3.

چسب AWS شامل یک شناسایی اطلاعات شخصی (PII) تبدیلی که توانایی شناسایی، پوشاندن یا حذف موجودیت ها را در صورت لزوم برای افزایش انطباق و حاکمیت فراهم می کند. با تبدیل PII، میتوانید دادههای PII را در مجموعههای داده شناسایی کنید و به طور خودکار کنترل دسترسی ریزدانه را با استفاده از Lake Formation اعمال کنید تا دادههای حساس را برای گروههای مختلف کاربر محدود کنید.

مورد استفاده

ما بر روی یک مورد استفاده از مدل تمایل تمرکز می کنیم که شامل مجموعه داده بازاریابی مشتری است و شامل دو شخصیت کاربر است: یک مهندس داده و دانشمند داده. مجموعه داده شامل اطلاعات هر مشتری، از جمله منبع سرنخ، یادداشتهای تماس، نقش شغلی، برخی از پرچمها، بازدید از صفحه در هر بازدید و غیره است. مجموعه داده همچنین شامل اطلاعات حساس مانند شماره تلفن های شخصی است.

مهندس داده مسئول ساخت خط لوله پردازش داده ها از جمله آماده سازی داده ها، پیش پردازش و کنترل دسترسی است. دانشمند داده مسئول مهندسی ویژگی ها و آموزش و استقرار مدل ML است. توجه داشته باشید که دانشمند داده مجاز به دسترسی به داده های حساس PII برای مهندسی ویژگی یا آموزش مدل ML نیست.

به عنوان بخشی از این مورد استفاده، مهندس داده یک خط لوله داده برای پیش پردازش مجموعه داده ایجاد می کند، مجموعه داده را برای هر گونه اطلاعات PII اسکن می کند و دسترسی به ستون PII را برای کاربر دانشمند داده محدود می کند. در نتیجه، وقتی یک دانشمند داده از مجموعه داده برای انجام مهندسی ویژگی و ساخت مدلهای ML استفاده میکند، به ستون حساس PII (در این مورد شماره تلفن) دسترسی ندارد. فرآیند مهندسی ویژگی شامل تبدیل ستون هایی از نوع رشته به فرمتی است که برای مدل های ML بهینه است. به عنوان یک مورد استفاده پیشرفته، می توانید این الگوی دسترسی را برای پیاده سازی امنیت در سطح ردیف و سطح سلول با استفاده از Lake Formation گسترش دهید.

بررسی اجمالی راه حل

راه حل شامل مراحل سطح بالا زیر است:

- راه اندازی منابع با AWS CloudFormation.

- پیش پردازش مجموعه داده، از جمله تشخیص PII و کنترل دسترسی دقیق، در یک جلسه تعاملی AWS Glue.

- مهندسی ویژگی را در جلسه تعاملی AWS Glue انجام دهید.

- با استفاده از الگوریتم XGBoost داخلی SageMaker، یک مدل ML را آموزش و استقرار دهید.

- مدل ML را ارزیابی کنید.

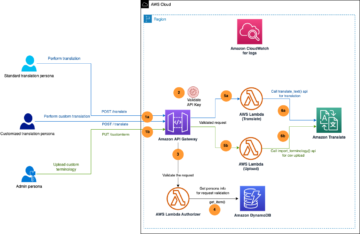

نمودار زیر معماری راه حل را نشان می دهد.

پیش نیازها

برای تکمیل این آموزش، باید پیش نیازهای زیر را داشته باشید:

منابع را با AWS CloudFormation تنظیم کنید

این پست شامل یک الگوی CloudFormation برای راه اندازی سریع است. شما می توانید آن را مطابق با نیاز خود بررسی و سفارشی کنید. اگر ترجیح می دهید منابع را بر روی آن تنظیم کنید کنسول مدیریت AWS و AWS CLI به جای AWS CloudFormation، دستورالعملهای پیوست را در انتهای این پست ببینید.

قالب CloudFormation منابع زیر را تولید می کند:

- سطل های S3 با مجموعه داده نمونه

- An AWS لامبدا تابع برای بارگذاری مجموعه داده

- هویت AWS و مدیریت دسترسی گروه (IAM)، کاربران، نقشها و خطمشیها

- تنظیمات و مجوزهای دریاچه دادههای Lake Formation

- پروفایل های کاربر SageMaker

برای ایجاد منابع خود، مراحل زیر را انجام دهید:

- وارد کنسول شوید.

- را انتخاب کنید Stack را راه اندازی کنید:

- را انتخاب کنید بعدی.

- برای DataEngineerPwd و DataScientistPwd، رمز عبور خود را برای کاربران مهندس داده و دانشمند داده وارد کنید.

- برای GlueDatabaseName، وارد

demo. - برای GlueTableName، وارد

web_marketing. - برای S3BucketNameForInput، وارد

blog-studio-pii-dataset-. - برای S3BucketNameForOutput، وارد

blog-studio-output-. - برای SageMakerDomainId، شناسه دامنه SageMaker خود را که در مراحل پیش نیاز آماده کرده اید وارد کنید.

- را انتخاب کنید بعدی.

- در صفحه بعد انتخاب کنید بعدی.

- جزئیات صفحه آخر را بررسی کرده و انتخاب کنید من تصدیق می کنم که AWS CloudFormation ممکن است منابع IAM را ایجاد کند.

- را انتخاب کنید ساختن.

ایجاد پشته می تواند تا 10 دقیقه طول بکشد. پشته نقش های IAM و پروفایل های کاربری SageMaker را برای دو شخصیت ایجاد می کند: مهندس داده و دانشمند داده. همچنین یک نسخه نمایشی و جدول پایگاه داده ایجاد می کند web_marketing با یک مجموعه داده نمونه

در زمان ایجاد پشته، پرسونای مهندس داده دسترسی کامل به جدول دارد، اما پرسونای دانشمند داده هنوز به جدول دسترسی ندارد.

مجموعه داده را از قبل پردازش کنید

بیایید پیش پردازش داده ها را در یک جلسه تعاملی AWS Glue شروع کنیم. شخصیت مهندس داده میخواهد دادهها را تأیید کند تا ببیند دادههای حساسی وجود دارد یا خیر، و حداقل مجوز دسترسی را به شخصیت دانشمند داده اعطا کند. می توانید نوت بوک را از این مکان.

- با استفاده از کاربر مهندسی داده وارد کنسول شوید.

- در کنسول SageMaker، را انتخاب کنید کاربران.

- کاربر مهندس داده را انتخاب کنید و انتخاب کنید استودیو باز.

- یک نوت بوک جدید بسازید و انتخاب کنید SparkAnalytics 1.0 برای تصویر و چسب PySpark برای هسته.

- برای نصب نسخه جدیدتر Boto3 یک جلسه تعاملی با جادوی زیر شروع کنید (این برای استفاده از

create_data_cells_filterروش): - شروع جلسه:

- از جدول جدید ایجاد شده یک AWS Glue DynamicFrame ایجاد کنید و حل انواع انتخاب بر اساس طرح کاتالوگ، زیرا می خواهیم از طرحی که در کاتالوگ تعریف شده است، به جای طرحواره استنتاج خودکار بر اساس داده ها استفاده کنیم:

- در جدول اعتبار سنجی کنید که آیا داده های PII با استفاده از تشخیص PII چسب AWS وجود دارد یا خیر:

- بررسی کنید که آیا ستونهای طبقهبندیشده به عنوان PII حاوی دادههای حساس هستند یا نه (اگر نه، classified_map را بهروزرسانی کنید تا ستونهای غیر حساس حذف شوند):

- مجوزهای Lake Formation را با استفاده از فیلتر سلول داده برای ستون های شناسایی شده خودکار تنظیم کنید و ستون ها را به شخصیت دانشمند داده محدود کنید:

- به عنوان دانشمند داده وارد استودیو شوید تا ببینید که ستون های PII قابل مشاهده نیستند. می توانید نوت بوک را از این مکان.

- یک نوت بوک جدید بسازید و انتخاب کنید SparkAnalytics 1.0 برای تصویر و چسب PySpark برای هسته:

مهندسی ویژگی را انجام دهید

ما از کتابخانه Apache Spark ML برای انجام مهندسی ویژگی به عنوان کاربر دانشمند داده استفاده می کنیم و سپس خروجی را در Amazon S3 بازنویسی می کنیم.

- در سلول زیر، ویژگی هایی را از the اعمال می کنیم کتابخانه Apache Spark ML:

StringIndexerیک ستون رشته ای از برچسب ها را به ستونی از فهرست های برچسب نگاشت می کند.OneHotEncoderیک ویژگی طبقهبندی را که بهعنوان یک شاخص برچسب نشان داده میشود، به یک بردار باینری با حداکثر یک مقدار منفرد نگاشت میکند که نشاندهنده وجود یک ویژگی طبقهبندی خاص است. این تبدیل برای الگوریتم های ML استفاده می شود که انتظار ویژگی های پیوسته را دارند.VectorAssemblerیک ترانسفورماتور است که لیست معینی از ستونها را در یک ستون بردار ترکیب میکند، که سپس در آموزش مدلهای ML برای الگوریتمهایی مانند رگرسیون لجستیک و درختهای تصمیم استفاده میشود.

- DataFrame نهایی تبدیل شده را می توان با استفاده از کتابخانه Pipeline ایجاد کرد. خط لوله به عنوان دنباله ای از مراحل مشخص می شود. این مراحل به ترتیب اجرا می شوند و DataFrame ورودی با عبور از هر مرحله تبدیل می شود.

- سپس، مجموعه داده را به Train تقسیم میکنیم، DataFrame را اعتبارسنجی و آزمایش میکنیم و آن را در سطل S3 ذخیره میکنیم تا مدل ML را آموزش دهیم (شناسه حساب AWS خود را در کد زیر ارائه کنید):

آموزش و استقرار یک مدل ML

در بخش قبل، مهندسی ویژگی را تکمیل کردیم که شامل تبدیل ستون های رشته ای مانند region, jobroleو usedpromo به فرمتی که برای مدل های ML بهینه است. ما همچنین ستون هایی مانند pageviewspervisit و totalwebvisits، که به ما در پیش بینی تمایل مشتری به خرید یک محصول کمک می کند.

ما اکنون یک مدل ML را با خواندن مجموعه داده های قطار و اعتبارسنجی با استفاده از الگوریتم XGBoost داخلی SageMaker آموزش می دهیم. سپس مدل را مستقر کرده و یک بررسی دقت اجرا می کنیم. می توانید نوت بوک را از این مکان.

در سلول زیر، دادههای سطل دوم S3 را میخوانیم که شامل خروجی عملیات مهندسی ویژگیهای ما است. سپس از الگوریتم داخلی XGBoost برای آموزش مدل استفاده می کنیم.

- یک نوت بوک جدید باز کنید. انتخاب کنید علم اطلاعات برای تصویر و پایتون 3 برای هسته (شناسه حساب AWS خود را در کد زیر وارد کنید):

- وقتی آموزش کامل شد، میتوانیم مدل را با استفاده از خدمات میزبانی SageMaker اجرا کنیم:

مدل ML را ارزیابی کنید

ما از مجموعه داده آزمایشی برای ارزیابی مدل استفاده میکنیم و پس از اتمام کار، نقطه پایان استنتاج را حذف میکنیم تا از هزینههای مداوم جلوگیری کنیم.

- مدل را با کد زیر ارزیابی کنید:

نتیجه دقت برای اجرای نمونه 84.6٪ بود. به دلیل تقسیم تصادفی مجموعه داده، این ممکن است برای اجرای شما کمی متفاوت باشد.

- می توانیم نقطه پایانی استنتاج را با کد زیر حذف کنیم:

پاک کردن

اکنون به مرحله نهایی، پاکسازی منابع می رویم.

- دو سطل ایجاد شده از طریق پشته CloudFormation را خالی کنید.

- برنامه های مرتبط با کاربر را حذف کنید

profiles data-scientistوdata-engineerدر استودیو - پشته CloudFormation را حذف کنید.

نتیجه

در این پست، راه حلی را نشان دادیم که به اشخاصی مانند مهندسان داده و دانشمندان داده امکان می دهد مهندسی ویژگی را در مقیاس انجام دهند. با جلسات تعاملی AWS Glue، میتوانید با تشخیص خودکار PII و کنترل دسترسی دقیق و بدون نیاز به مدیریت زیرساختهای اساسی، به راحتی به مهندسی ویژگیها در مقیاس دست یابید. با استفاده از Studio بهعنوان نقطه ورودی واحد، میتوانید یک تجربه ساده و یکپارچه برای ایجاد یک گردش کار ML سرتاسر به دست آورید: از آمادهسازی و ایمن کردن دادهها تا ساخت، آموزش، تنظیم، و استقرار مدلهای ML. برای کسب اطلاعات بیشتر، مراجعه کنید شروع به کار با جلسات تعاملی AWS Glue و Amazon SageMaker Studio.

ما در مورد این قابلیت جدید بسیار هیجانزده هستیم و مشتاقیم ببینیم که شما با آن چه خواهید ساخت!

پیوست: منابع را از طریق کنسول و AWS CLI تنظیم کنید

دستورالعمل های این بخش را تکمیل کنید تا منابع را با استفاده از کنسول و AWS CLI به جای الگوی CloudFormation تنظیم کنید.

پیش نیازها

برای تکمیل این آموزش، باید به AWS CLI دسترسی داشته باشید (نگاه کنید به شروع کار با AWS CLI) یا از دسترسی خط فرمان استفاده کنید AWS CloudShell.

گروه IAM، کاربران، نقشها و خطمشیها را پیکربندی کنید

در این بخش، دو کاربر IAM ایجاد می کنیم: data-engineer و data-scientist که متعلق به گروه داده-پلتفرم-گروه IAM هستند. سپس یک خط مشی واحد IAM را به گروه IAM اضافه می کنیم.

- در کنسول IAM، یک خط مشی در برگه JSON ایجاد کنید برای ایجاد یک سیاست مدیریت شده جدید IAM به نام

DataPlatformGroupPolicy. این خطمشی به کاربران گروه اجازه میدهد به Studio دسترسی داشته باشند، اما فقط با استفاده از نمایه کاربر SageMaker با برچسبی که با نام کاربری IAM آنها مطابقت دارد. از سند خط مشی JSON زیر برای ارائه مجوز استفاده کنید: - یک گروه IAM ایجاد کنید نام

data-platform-group. - خط مشی مدیریت شده AWS با نام DataPlatformGroupPolicy را جستجو و به گروه پیوست کنید.

- کاربران IAM را ایجاد کنید به نام مهندس داده و دانشمند داده تحت گروه پلتفرم داده گروه IAM.

- یک خط مشی مدیریت شده جدید ایجاد کنید با نام SageMakerExecutionPolicy (شناسه منطقه و حساب خود را در کد زیر وارد کنید):

- یک خط مشی مدیریت شده جدید ایجاد کنید تحت عنوان

SageMakerAdminPolicy: - یک نقش IAM ایجاد کنید برای SageMaker برای مهندس داده (مهندس داده)، که به عنوان نقش اجرایی پروفایل کاربر مربوطه استفاده می شود. در خط مشی مجوزها را پیوست کنید صفحه، AmazonSageMakerFullAccess (خط مشی مدیریت شده AWS) به طور پیش فرض پیوست شده است. برای حفظ حداقل امتیاز، بعداً این خطمشی را حذف میکنید.

- برای نام نقش، از قرارداد نامگذاری معرفی شده در ابتدای این بخش برای نامگذاری نقش SageMakerStudioExecutionRole_data-engineer استفاده کنید.

- برای گزينه ها، نام پروفایل کاربری کلیدی و مقدار داده-مهندس را اضافه کنید.

- را انتخاب کنید نقش ایجاد کنید.

- برای افزودن خط مشی های باقی مانده، در نقش صفحه، نام نقشی را که ایجاد کردید انتخاب کنید.

- تحت ویرایش، سیاست AmazonSageMakerFullAccess را حذف کنید.

- بر خط مشی مجوزها را پیوست کنید در صفحه، خطمشی مدیریتشده AWS AwsGlueSessionUserRestrictedServiceRole و خطمشیهای مدیریت شده توسط مشتری SageMakerExecutionPolicy و SageMakerAdminPolicy را که ایجاد کردید انتخاب کنید.

- را انتخاب کنید خط مشی ها را ضمیمه کنید.

- تغییر دادن رابطه اعتماد نقش شما:

- یک نقش IAM ایجاد کنید برای SageMaker برای دانشمند داده (دانشمند داده)، که به عنوان نقش اجرایی پروفایل کاربر مربوطه استفاده می شود.

- برای نام نقش، نقش SageMakerStudioExecutionRole_data-scientist را نام ببرید.

- برای گزينه ها، نام پروفایل کاربری کلیدی و value data-scientist را اضافه کنید.

- را انتخاب کنید نقش ایجاد کنید.

- برای افزودن خط مشی های باقی مانده، در نقش صفحه، نام نقشی را که ایجاد کردید انتخاب کنید.

- تحت ویرایش، سیاست AmazonSageMakerFullAccess را حذف کنید.

- بر خط مشی مجوزها را پیوست کنید صفحه، خط مشی مدیریت شده AWS AwsGlueSessionUserRestrictedServiceRole و خط مشی مدیریت شده توسط مشتری SageMakerExecutionPolicy را که ایجاد کردید انتخاب کنید.

- را انتخاب کنید خط مشی ها را ضمیمه کنید.

- تغییر دادن رابطه اعتماد نقش شما:

پروفایل های کاربر SageMaker را پیکربندی کنید

برای ایجاد پروفایل های کاربری SageMaker خود با studiouserid تگ کنید، مراحل زیر را انجام دهید:

- از AWS CLI یا CloudShell برای ایجاد نمایه کاربری استودیو برای مهندس داده استفاده کنید (شناسه حساب و شناسه دامنه استودیو خود را در کد زیر وارد کنید):

- مرحله ایجاد نمایه کاربری برای دانشمند داده و جایگزینی شناسه حساب و شناسه دامنه استودیو را تکرار کنید:

سطل های S3 ایجاد کنید و مجموعه داده نمونه را آپلود کنید

در این قسمت شما دو سطل S3 ایجاد می کنید. سطل اول یک مجموعه داده نمونه مربوط به بازاریابی وب دارد. سطل دوم توسط دانشمند داده برای ذخیره خروجی از وظایف مهندسی ویژگی استفاده می شود و این مجموعه داده خروجی برای آموزش مدل ML استفاده می شود.

ابتدا سطل S3 را برای داده های ورودی ایجاد کنید:

- دانلود مجموعه داده.

- در کنسول آمازون S3، را انتخاب کنید سطل در صفحه ناوبری

- را انتخاب کنید سطل ایجاد کنید.

- برای منطقه، منطقه ای را با دامنه SageMaker انتخاب کنید که شامل نمایه های کاربری است که ایجاد کرده اید.

- برای نام سطل، وارد

blog-studio-pii-dataset-. - را انتخاب کنید سطل ایجاد کنید.

- سطلی که ایجاد کردید را انتخاب کنید و انتخاب کنید بارگذاری.

- در فایل را انتخاب کنید بخش، را انتخاب کنید اضافه کردن فایل و مجموعه داده ای را که دانلود کرده اید آپلود کنید.

اکنون سطلی برای داده های خروجی ایجاد می کنید: - بر سطل صفحه ، انتخاب کنید سطل ایجاد کنید.

- برای منطقه، منطقه ای را با دامنه SageMaker انتخاب کنید که شامل نمایه های کاربری است که ایجاد کرده اید.

- برای نام سطل، وارد

blog-studio-output-. - را انتخاب کنید سطل ایجاد کنید.

یک پایگاه داده و جدول AWS Glue ایجاد کنید

در این بخش، یک پایگاه داده و جدول AWS Glue برای مجموعه داده ایجاد می کنید.

- در کنسول Lake Formation، زیر کاتالوگ داده در قسمت ناوبری، را انتخاب کنید پایگاه داده ها.

- را انتخاب کنید افزودن پایگاه داده.

- برای نام، دمو را وارد کنید.

- را انتخاب کنید پایگاه داده ایجاد کنید.

- تحت کاتالوگ داده، انتخاب کنید جداول.

- برای نام، وارد

web_marketing. - برای پایگاه داده، انتخاب کنید

demo. - برای شامل مسیر، مسیر سطل S3 خود را برای داده های ورودی وارد کنید.

- برای طبقه بندی، انتخاب کنید CSV.

- تحت طرح، انتخاب کنید آپلود طرحواره.

- آرایه JSON زیر را در کادر متن وارد کنید:

- را انتخاب کنید بارگذاری.

- را انتخاب کنید ارسال.

- تحت جزئیات جدول، انتخاب کنید ویرایش جدول.

- تحت خواص جدول، انتخاب کنید اضافه کردن.

- برای کلید، وارد

skip.header.line.count، و برای ارزش، 1 را وارد کنید. - را انتخاب کنید ذخیره.

مجوزهای Lake Formation را پیکربندی کنید

در این بخش، مجوزهای Lake Formation را تنظیم می کنید تا به نقش IAM اجازه دهید SageMakerStudioExecutionRole_data-engineer برای ایجاد یک پایگاه داده و ثبت مکان S3 در Lake Formation.

ابتدا، مکان دریاچه داده را برای مدیریت جداول زیر مکان در مجوزهای Lake Formation ثبت کنید:

- را انتخاب کنید مکان های دریاچه داده.

- را انتخاب کنید ثبت مکان.

- برای مسیر آمازون S3، وارد

s3://blog-studio-pii-dataset-/(سطلی که شامل مجموعه داده است). - را انتخاب کنید ثبت مکان.

اکنون به نقش های IAM مجوز پایگاه داده و جدول Lake Formation را می دهیدSageMakerStudioExecutionRole_data-engineerوSageMakerStudioExecutionRole_data-scientistاول، اجازه پایگاه داده برایSageMakerStudioExecutionRole_data-engineer: - تحت ویرایش، انتخاب کنید مجوزهای دریاچه داده.

- تحت مجوز داده، انتخاب کنید گرانت.

- برای اصولگرایان، انتخاب کنید کاربران و نقش های IAMو نقش را انتخاب کنید

SageMakerStudioExecutionRole_data-engineer. - برای برچسب های خط مشی یا منابع کاتالوگ، انتخاب کنید منابع کاتالوگ داده نامگذاری شده.

- برای پایگاه داده ها، نسخه ی نمایشی را انتخاب کنید.

- برای مجوزهای پایگاه داده، را انتخاب کنید فوق العاده.

- را انتخاب کنید گرانت.

در مرحله بعد، مجوز جدول را برایSageMakerStudioExecutionRole_data-engineer: - تحت مجوز داده، انتخاب کنید گرانت.

- برای اصولگرایان، انتخاب کنید کاربران و نقش های IAMو نقش را انتخاب کنید

SageMakerStudioExecutionRole_data-engineer. - برای برچسب های خط مشی یا منابع کاتالوگ، انتخاب کنید منابع کاتالوگ داده نامگذاری شده.

- برای پایگاه داده ها، انتخاب کنید

demo. - برای جداول، انتخاب کنید

web_marketing. - برای جدول مجوزها ، را انتخاب کنید فوق العاده.

- برای قابل اعطا مجوزها ، را انتخاب کنید فوق العاده.

- را انتخاب کنید گرانت.

در نهایت، مجوز پایگاه داده را برایSageMakerStudioExecutionRole_data-scientist: - تحت مجوز داده، انتخاب کنید گرانت.

- برای اصولگرایان، انتخاب کنید کاربران و نقش های IAMو نقش را انتخاب کنید

SageMakerStudioExecutionRole_data-scientist. - برای برچسب های خط مشی یا منابع کاتالوگ، انتخاب کنید منابع کاتالوگ داده نامگذاری شده.

- برای پایگاه داده ها، انتخاب کنید

demo. - برای مجوزهای پایگاه داده، را انتخاب کنید شرح.

- را انتخاب کنید گرانت.

درباره نویسنده

Praveen Kumar یک معمار راه حل تجزیه و تحلیل در AWS است که در طراحی، ساخت، و پیاده سازی پلتفرم های داده و تجزیه و تحلیل مدرن با استفاده از خدمات بومی ابری تخصص دارد. حوزه های مورد علاقه او فناوری بدون سرور، انبارهای داده ابری مدرن، استریمینگ و برنامه های کاربردی ML است.

نوریتاکا سکیاما یک معمار اصلی داده های بزرگ در تیم AWS Glue است. او از همکاری با تیم های مختلف برای ارائه نتایجی مانند این پست لذت می برد. او در اوقات فراغت خود از بازی های ویدیویی با خانواده لذت می برد.

- پیشرفته (300)

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آمازون SageMaker

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- داده های بزرگ AWS

- چسب AWS

- سازند دریاچه AWS

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- رهبری فکر

- زفیرنت