تشخیص نوری کاراکتر (OCR) وظیفه تبدیل متن چاپ شده یا دست نویس به متن کدگذاری شده توسط ماشین است. OCR به طور گسترده در سناریوهای مختلف مانند الکترونیکی کردن اسناد و احراز هویت استفاده شده است. از آنجایی که OCR می تواند تلاش دستی برای ثبت اطلاعات کلیدی را تا حد زیادی کاهش دهد و به عنوان گام ورودی برای درک حجم زیادی از اسناد عمل کند، یک سیستم OCR دقیق نقش مهمی در عصر تحول دیجیتال ایفا می کند.

جامعه منبع باز و محققان بر روی چگونگی بهبود دقت OCR، سهولت استفاده، ادغام با مدل های از پیش آموزش دیده، توسعه و انعطاف پذیری تمرکز کرده اند. در میان بسیاری از چارچوبهای پیشنهادی، PaddleOCR اخیراً مورد توجه قرار گرفته است. چارچوب پیشنهادی بر دستیابی به دقت بالا در حین متعادل کردن کارایی محاسباتی متمرکز است. علاوه بر این، مدل های از پیش آموزش دیده برای چینی و انگلیسی آن را در بازار مبتنی بر زبان چینی محبوب کرده است. را ببینید مخزن PaddleOCR GitHub برای جزئیات بیشتر.

در AWS، ما همچنین خدمات هوش مصنوعی یکپارچهای را پیشنهاد کردهایم که بدون تخصص یادگیری ماشین (ML) آماده استفاده هستند. برای استخراج متن و داده های ساختار یافته مانند جداول و فرم ها از اسناد، می توانید استفاده کنید متن آمازون. از تکنیک های ML برای خواندن و پردازش هر نوع سند، استخراج دقیق متن، دست خط، جداول و سایر داده ها بدون تلاش دستی استفاده می کند.

برای دانشمندان داده که خواهان انعطاف پذیری استفاده از چارچوب متن باز برای توسعه مدل OCR خود هستند، ما همچنین سرویس ML کاملاً مدیریت شده را ارائه می دهیم. آمازون SageMaker. SageMaker شما را قادر میسازد تا بهترین شیوههای MLOps را در طول چرخه عمر ML پیادهسازی کنید، و قالبها و مجموعههای ابزاری را برای کاهش وزنه برداری غیرمتمایز برای قرار دادن پروژههای ML در تولید فراهم میکند.

در این پست، ما بر روی توسعه مدل های سفارشی شده در چارچوب PaddleOCR در SageMaker تمرکز می کنیم. ما در چرخه عمر توسعه ML قدم می زنیم تا نشان دهیم که چگونه SageMaker می تواند به شما در ساخت و آموزش یک مدل کمک کند و در نهایت مدل را به عنوان یک وب سرویس استقرار دهد. اگرچه ما این راهحل را با PaddleOCR نشان میدهیم، دستورالعمل کلی برای چارچوبهای دلخواه مورد استفاده در SageMaker صادق است. برای همراهی این پست، نمونه کد را نیز در قسمت ارائه می دهیم مخزن GitHub.

چارچوب PaddleOCR

به عنوان یک چارچوب OCR به طور گسترده پذیرفته شده، PaddleOCR شامل تشخیص متن غنی، تشخیص متن و الگوریتمهای انتها به انتها است. دوتایی متمایز (DB) و شبکه عصبی بازگشتی کانولوشنال (CRNN) را به عنوان مدلهای تشخیص و تشخیص پایه انتخاب میکند و پس از یک سری استراتژیهای بهینهسازی، یک سری مدل به نام PP-OCR را برای کاربردهای صنعتی پیشنهاد میکند.

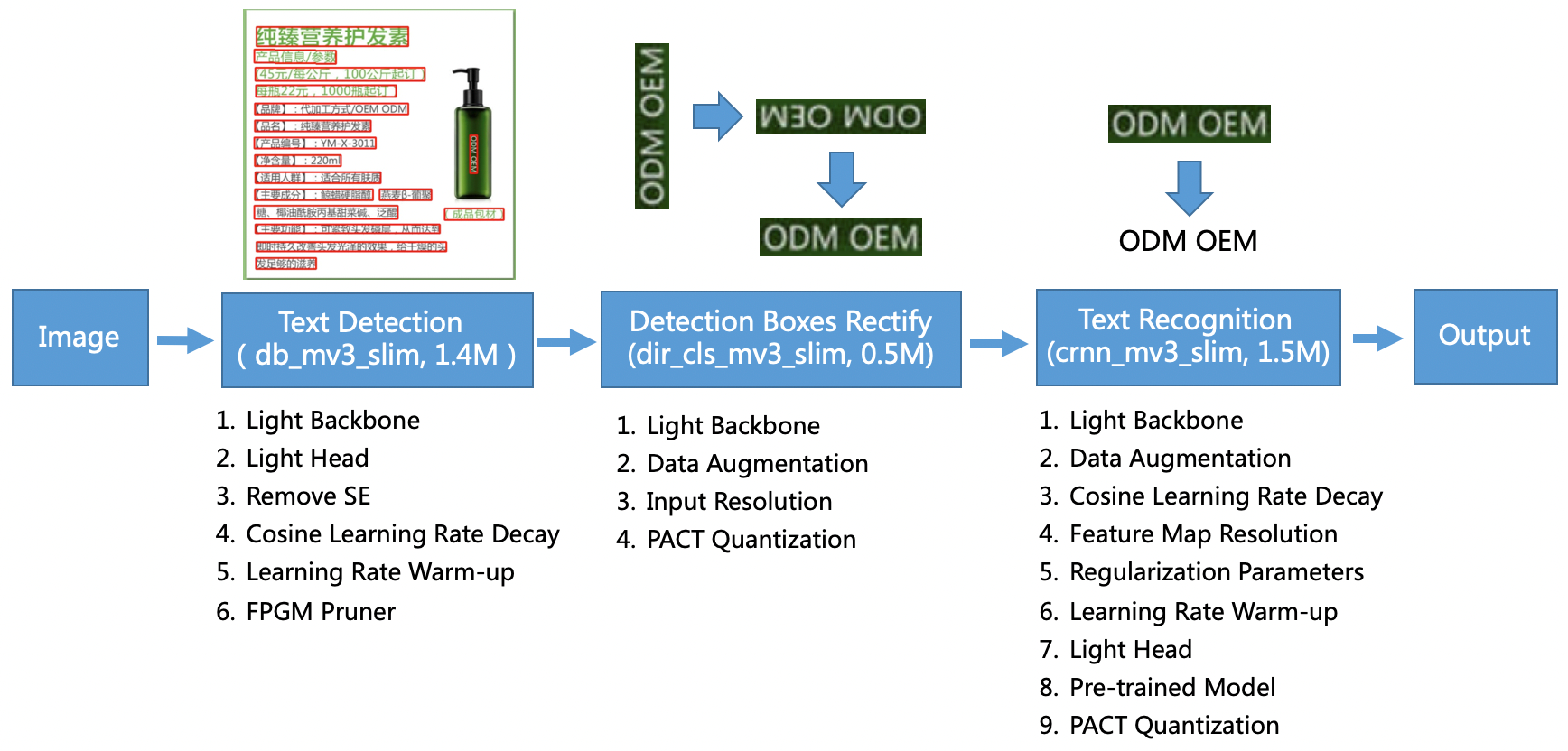

مدل PP-OCR سناریوهای کلی را هدف قرار می دهد و یک کتابخانه مدل از زبان های مختلف را تشکیل می دهد. این شامل سه بخش است: تشخیص متن، تشخیص و تصحیح جعبه، و تشخیص متن، که در شکل زیر در PaddleOCR نشان داده شده است. مخزن رسمی GitHub. همچنین می توانید به مقاله تحقیق مراجعه کنید PP-OCR: یک سیستم OCR بسیار سبک و کاربردی برای اطلاعات بیشتر.

برای دقیق تر، PaddleOCR از سه کار متوالی تشکیل شده است:

- تشخیص متن - هدف از تشخیص متن، مکان یابی ناحیه متن در تصویر است. چنین وظایفی می تواند بر اساس یک شبکه تقسیم بندی ساده باشد.

- تشخیص و اصلاح جعبه - هر کادر متنی باید به یک کادر مستطیل افقی برای تشخیص متن بعدی تبدیل شود. برای انجام این کار، PaddleOCR آموزش یک طبقهبندیکننده جهت متن (کار طبقهبندی تصویر) را برای تعیین جهت متن پیشنهاد میکند.

- تشخیص متن – پس از شناسایی جعبه متن، مدل شناسایی متن استنتاج را بر روی هر جعبه متن انجام می دهد و نتایج را با توجه به موقعیت جعبه متن خروجی می دهد. PaddleOCR روش پرکاربرد CRNN را اتخاذ می کند.

PaddleOCR مدل های از پیش آموزش دیده با کیفیتی را ارائه می دهد که با جلوه های تجاری قابل مقایسه هستند. میتوانید از مدل از پیش آموزشدیدهشده برای یک مدل تشخیص، طبقهبندیکننده جهت، یا مدل شناسایی استفاده کنید، یا میتوانید هر مدل جداگانه را بهخوبی تنظیم کنید و دوباره آموزش دهید. برای افزایش کارایی و اثربخشی تشخیص چینی و انگلیسی سنتی، نحوه تنظیم دقیق مدل تشخیص متن را نشان میدهیم. مدل از پیش آموزش دیده ای که انتخاب می کنیم این است ch_ppocr_mobile_v2.0_rec_train، که یک مدل سبک وزن است و از تشخیص چینی، انگلیسی و اعداد پشتیبانی می کند. در زیر نمونه ای از نتیجه استنتاج با استفاده از کارت شناسایی هنگ کنگ است.

در بخشهای بعدی، نحوه تنظیم دقیق مدل از پیش آموزشدیده با استفاده از SageMaker را شرح میدهیم.

بهترین روش های MLO با SageMaker

SageMaker یک سرویس ML کاملاً مدیریت شده است. با SageMaker، دانشمندان و توسعه دهندگان داده می توانند به سرعت و به راحتی مدل های ML را بسازند و آموزش دهند و سپس مستقیماً آنها را در یک محیط مدیریت شده آماده تولید مستقر کنند.

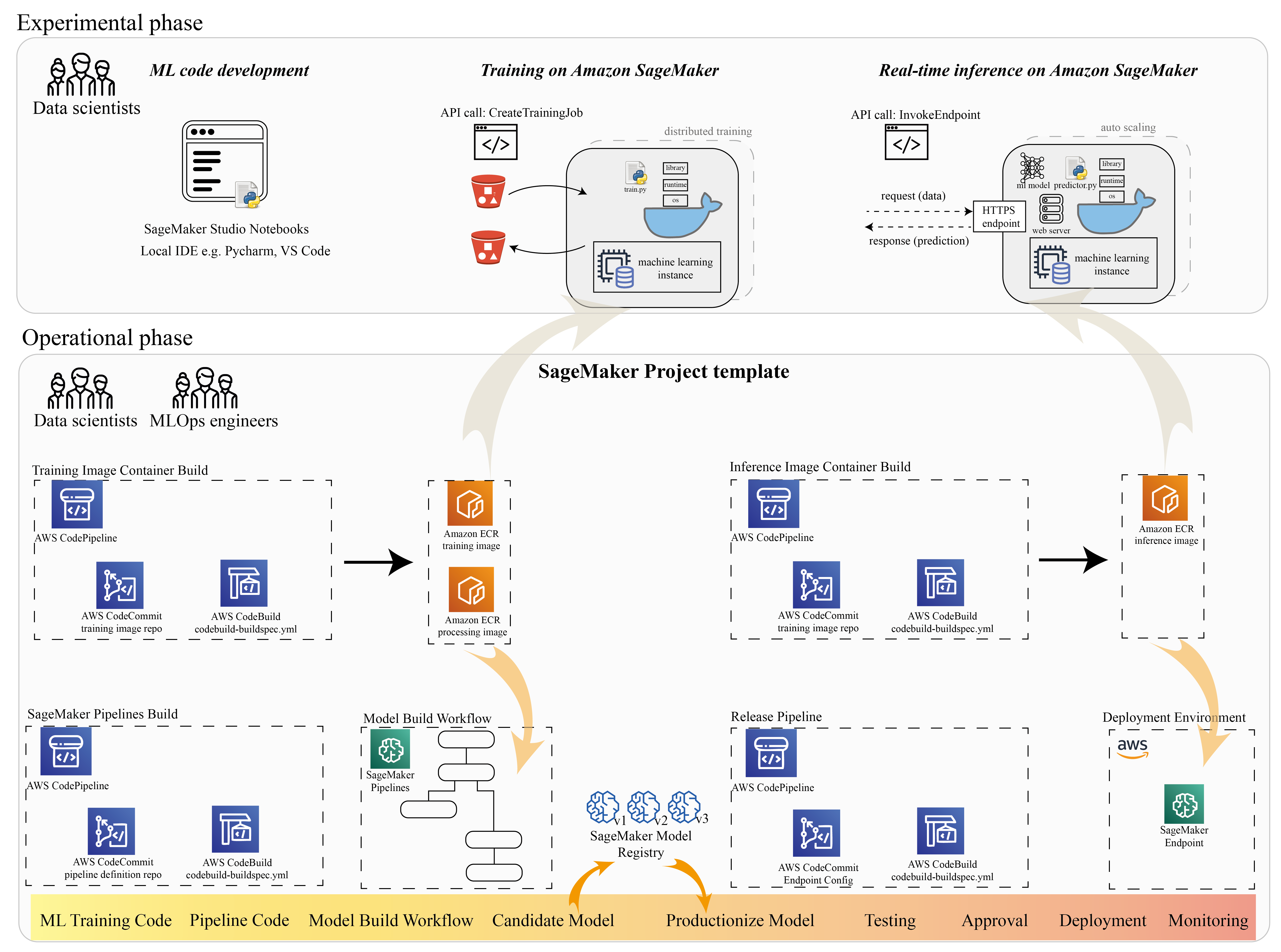

بسیاری از دانشمندان داده از SageMaker برای تسریع چرخه حیات ML استفاده می کنند. در این بخش، نشان میدهیم که چگونه SageMaker میتواند به شما از آزمایش تا تولید ML کمک کند. SageMaker با پیروی از مراحل استاندارد یک پروژه ML، از عبارت آزمایشی (توسعه کد و آزمایشها)، تا عبارت عملیاتی (اتوماتیک سازی جریان کار ساخت مدل و خطوط لوله استقرار)، میتواند کارایی را در مراحل زیر به ارمغان بیاورد:

- داده ها را کاوش کنید و کد ML را با آن بسازید Amazon SageMaker Studio دفترچه یادداشت

- با یک کار آموزشی SageMaker مدل را آموزش دهید و کوک کنید.

- مدل را با یک نقطه پایانی SageMaker برای ارائه مدل مستقر کنید.

- گردش کار را با خطوط لوله آمازون SageMaker.

نمودار زیر این معماری و گردش کار را نشان می دهد.

توجه به این نکته ضروری است که می توانید از SageMaker به صورت ماژولار استفاده کنید. به عنوان مثال، میتوانید کد خود را با یک محیط توسعه یکپارچه محلی (IDE) بسازید و مدل خود را در SageMaker آموزش و استقرار دهید، یا میتوانید مدل خود را در منابع محاسباتی خوشهای خود توسعه داده و آموزش دهید، و از خط لوله SageMaker برای هماهنگسازی گردش کار استفاده کنید. استقرار در نقطه پایانی SageMaker. این بدان معناست که SageMaker یک پلتفرم باز برای انطباق با نیازهای شما فراهم می کند.

کد را در ما ببینید مخزن GitHub و README برای درک ساختار کد.

ارائه یک پروژه SageMaker

شما می توانید پروژه های آمازون SageMaker برای شروع سفر با پروژه SageMaker، میتوانید نسخههای مخازن Git خود را مدیریت کنید تا بتوانید کارآمدتر با تیمها همکاری کنید، از سازگاری کد اطمینان حاصل کنید و یکپارچهسازی مداوم و تحویل مداوم (CI/CD) را فعال کنید. اگرچه نوتبوکها برای ساخت مدل و آزمایش مفید هستند، اما وقتی تیمی از دانشمندان داده و مهندسان ML دارید که روی یک مشکل ML کار میکنند، به روشی مقیاسپذیرتر برای حفظ سازگاری کد و کنترل نسخه سختتر نیاز دارید.

پروژه های SageMaker یک الگوی MLOps از پیش پیکربندی شده ایجاد می کنند که شامل اجزای ضروری برای ساده سازی یکپارچه سازی PaddleOCR است:

- یک مخزن کد برای ساخت تصاویر کانتینر سفارشی برای پردازش، آموزش و استنتاج، یکپارچه با ابزارهای CI/CD. این به ما امکان می دهد تا تصویر Docker سفارشی خود را پیکربندی کنیم و به آن فشار دهیم رجیستری ظروف الاستیک آمازون (Amazon ECR) آماده استفاده باشد.

- خط لوله SageMaker که مراحل آماده سازی داده ها، آموزش، ارزیابی مدل و ثبت مدل را تعریف می کند. این ما را آماده می کند تا زمانی که پروژه ML به مرحله تولید می رسد آماده MLOps باشیم.

- منابع مفید دیگر، مانند یک مخزن Git برای کنترل نسخه کد، گروه مدل که شامل نسخه های مدل است، ماشه تغییر کد برای خط لوله ساخت مدل، و ماشه مبتنی بر رویداد برای خط لوله استقرار مدل.

می توانید از کد اولیه SageMaker برای ایجاد پروژه های استاندارد SageMaker یا یک الگوی خاص که سازمان شما برای اعضای تیم ایجاد کرده است استفاده کنید. در این پست از استاندارد استفاده می کنیم قالب MLOps برای ساخت تصویر، ساخت مدل و استقرار مدل. برای اطلاعات بیشتر در مورد ایجاد پروژه در استودیو به ادامه مطلب مراجعه کنید با استفاده از Amazon SageMaker Studio یک پروژه MLOps ایجاد کنید.

داده ها را کاوش کنید و کد ML را با نوت بوک های SageMaker Studio بسازید

نوتبوکهای SageMaker Studio، نوتبوکهای مشترکی هستند که میتوانید به سرعت راهاندازی کنید، زیرا نیازی به تنظیم نمونههای محاسباتی و ذخیرهسازی فایلها از قبل ندارید. بسیاری از دانشمندان داده ترجیح می دهند از این IDE مبتنی بر وب برای توسعه کد ML، اشکال زدایی سریع API کتابخانه، و اجرای کارها با نمونه کوچکی از داده ها برای تأیید اعتبار اسکریپت آموزشی استفاده کنند.

در نوت بوک های استودیو، می توانید از یک محیط از پیش ساخته شده برای فریمورک های رایج مانند TensorFlow، PyTorch، Pandas و Scikit-Learn استفاده کنید. می توانید وابستگی ها را روی هسته از پیش ساخته شده نصب کنید یا تصویر هسته دائمی خود را بسازید. برای اطلاعات بیشتر مراجعه کنید کتابخانه های خارجی و هسته ها را در Amazon SageMaker Studio نصب کنید. نوتبوکهای استودیویی همچنین یک محیط پایتون را برای راهاندازی مشاغل آموزشی SageMaker، استقرار یا سایر خدمات AWS فراهم میکنند. در بخشهای بعدی، نحوه استفاده از نوتبوکهای استودیو را بهعنوان محیطی برای راهاندازی مشاغل آموزشی و استقرار نشان میدهیم.

SageMaker یک IDE قدرتمند ارائه می دهد. این یک پلت فرم باز ML است که در آن دانشمندان داده انعطاف پذیری برای استفاده از محیط توسعه ترجیحی خود را دارند. برای دانشمندان داده که IDE محلی مانند PyCharm یا Visual Studio Code را ترجیح می دهند، می توانید از محیط محلی Python برای توسعه کد ML خود استفاده کنید و از SageMaker برای آموزش در یک محیط مقیاس پذیر مدیریت شده استفاده کنید. برای اطلاعات بیشتر ببین کار TensorFlow خود را در Amazon SageMaker با PyCharm IDE اجرا کنید. پس از داشتن یک مدل قوی، میتوانید بهترین روشهای MLOps را با SageMaker اتخاذ کنید.

در حال حاضر SageMaker نیز ارائه می دهد نمونه های نوت بوک SageMaker به عنوان راه حل قدیمی ما برای محیط نوت بوک Jupyter. شما انعطاف پذیری برای اجرای دستور ساخت داکر و از حالت محلی SageMaker برای آموزش در نمونه نوت بوک خود استفاده کنید. ما همچنین کد نمونه ای را برای PaddleOCR در مخزن کد خود ارائه می دهیم: ./train_and_deploy/notebook.ipynb.

با یک الگوی پروژه SageMaker یک تصویر سفارشی بسازید

SageMaker از کانتینرهای Docker برای کارهای ساخت و زمان اجرا استفاده گسترده ای می کند. شما می توانید ظرف خود را با SageMaker به راحتی اجرا کنید. جزئیات فنی بیشتر را در از الگوریتم های آموزشی خود استفاده کنید.

با این حال، به عنوان یک دانشمند داده، ساختن یک ظرف ممکن است ساده نباشد. پروژههای SageMaker یک راه ساده برای مدیریت وابستگیهای سفارشی از طریق خط لوله CI/CD ساخت تصویر فراهم میکنند. هنگامی که از پروژه SageMaker استفاده می کنید، می توانید با Dockerfile کانتینر سفارشی خود، تصویر آموزشی را به روز رسانی کنید. برای دستورالعمل های گام به گام، مراجعه کنید پروژه های Amazon SageMaker را با خطوط لوله CI/CD ساخت تصویر ایجاد کنید. با ساختار ارائه شده در قالب، می توانید کد ارائه شده در این مخزن را برای ساخت کانتینر آموزشی PaddleOCR تغییر دهید.

برای این پست، ما سادگی ساخت یک تصویر سفارشی برای پردازش، آموزش و استنتاج را به نمایش می گذاریم. مخزن GitHub شامل سه پوشه است:

این پروژه ها از ساختار مشابهی پیروی می کنند. تصویر ظرف آموزشی را به عنوان مثال در نظر بگیرید. را image-build-train/ مخزن شامل فایل های زیر است:

- فایل codebuild-buildspec.yml که برای پیکربندی استفاده می شود AWS CodeBuild به طوری که می توان تصویر را ساخت و به Amazon ECR فرستاد.

- Dockerfile مورد استفاده برای ساخت Docker، که شامل تمام وابستگی ها و کد آموزشی است.

- نقطه ورود train.py برای اسکریپت آموزشی، با تمام پارامترها (مانند نرخ یادگیری و اندازه دسته) که می تواند به عنوان یک آرگومان پیکربندی شود. این آرگومان ها زمانی که کار آموزشی را شروع می کنید مشخص می شوند.

- وابستگی ها

وقتی کد را به مخزن مربوطه فشار می دهید، فعال می شود AWS CodePipeline تا یک ظرف آموزشی برای شما بسازم. همانطور که در شکل قبل نشان داده شده است، تصویر کانتینر سفارشی در یک مخزن آمازون ECR ذخیره می شود. یک روش مشابه برای تولید تصویر استنتاج اتخاذ شده است.

مدل را با SageMaker آموزش SDK آموزش دهید

پس از اینکه کد الگوریتم شما اعتبارسنجی شد و در یک ظرف بسته بندی شد، می توانید از یک کار آموزشی SageMaker برای ارائه یک محیط مدیریت شده برای آموزش مدل استفاده کنید. این محیط زودگذر است، به این معنی که شما می توانید منابع محاسباتی جداگانه و ایمن (مانند GPU) یا یک محیط توزیع شده با چند GPU برای اجرای کد خود داشته باشید. هنگامی که آموزش کامل شد، SageMaker مصنوعات مدل به دست آمده را در یک ذخیره می کند سرویس ذخیره سازی ساده آمازون (Amazon S3) مکانی که شما مشخص می کنید. همه دادههای گزارش و ابردادهها روی آن باقی میمانند کنسول مدیریت AWS، استودیو و CloudWatch آمازون.

کار آموزشی شامل چندین اطلاعات مهم است:

- URL سطل S3 که داده های آموزشی را در آن ذخیره کرده اید

- URL سطل S3 که میخواهید خروجی کار را در آن ذخیره کنید

- منابع محاسباتی مدیریت شده ای که می خواهید SageMaker برای آموزش مدل استفاده کند

- مسیر آمازون ECR که در آن ظرف آموزشی ذخیره می شود

برای اطلاعات بیشتر در مورد مشاغل آموزشی، رجوع کنید مدل های قطار. کد نمونه کار آموزشی در این آدرس موجود است experiments-train-notebook.ipynb.

SageMaker هایپرپارامترها را در a می سازد CreateTrainingJob درخواست موجود در ظرف Docker در /opt/ml/input/config/hyperparameters.json فایل.

ما از کانتینر آموزشی سفارشی به عنوان نقطه ورود استفاده می کنیم و یک محیط GPU را برای زیرساخت مشخص می کنیم. همه هایپرپارامترهای مربوطه به عنوان پارامترها به تفصیل ارائه می شوند، که به ما امکان می دهد پیکربندی هر کار جداگانه را ردیابی کنیم و آنها را با ردیابی آزمایش مقایسه کنیم.

از آنجایی که فرآیند علم داده بسیار پژوهش محور است، معمولاً چندین آزمایش به صورت موازی در حال اجرا هستند. این امر مستلزم رویکردی است که تمام آزمایشهای مختلف، الگوریتمهای مختلف، و مجموعه دادهها و فراپارامترهای بالقوه متفاوتی را که تلاش شده است، حفظ کند. Amazon SageMaker Experiments به شما امکان می دهد آزمایش های ML خود را سازماندهی، پیگیری، مقایسه و ارزیابی کنید. ما این را در نیز نشان می دهیم experiments-train-notebook.ipynb. برای جزئیات بیشتر مراجعه کنید مدیریت یادگیری ماشینی با آمازون SageMaker Experiments.

استقرار مدل برای ارائه مدل

در مورد استقرار، بهویژه برای سرویسدهی مدل بلادرنگ، ممکن است بسیاری از دانشمندان داده بدون کمک تیمهای عملیاتی انجامش دهند. SageMaker به کارگیری مدل آموزش دیده خود را برای تولید با استفاده از آن ساده می کند SageMaker Python SDK. می توانید مدل خود را در سرویس های میزبانی SageMaker مستقر کنید و یک نقطه پایانی برای استنتاج بلادرنگ دریافت کنید.

در بسیاری از سازمان ها، دانشمندان داده ممکن است مسئول حفظ زیرساخت نقطه پایانی نباشند. با این حال، آزمایش مدل شما به عنوان نقطه پایانی و تضمین رفتارهای پیشبینی صحیح در واقع بر عهده دانشمندان داده است. بنابراین، SageMaker با افزودن مجموعه ای از ابزارها و SDK برای این کار، وظایف استقرار را ساده کرد.

برای موارد استفاده در پست، میخواهیم قابلیتهای بیدرنگ، تعاملی و با تاخیر کم داشته باشیم. استنتاج بلادرنگ برای این حجم کار استنتاج ایده آل است. با این حال، گزینه های زیادی وجود دارد که با هر نیاز خاص سازگار است. برای اطلاعات بیشتر مراجعه کنید استقرار مدل ها برای استنتاج.

برای استقرار تصویر سفارشی، دانشمندان داده می توانند از SageMaker SDK استفاده کنند که در نشان داده شده در

experiments-deploy-notebook.ipynb.

در create_model درخواست، تعریف ظرف شامل ModelDataUrl پارامتر، که مکان آمازون S3 را که در آن مصنوعات مدل ذخیره می شود، شناسایی می کند. SageMaker از این اطلاعات برای تعیین محل کپی کردن مصنوعات مدل استفاده می کند. این مصنوعات را به کپی می کند /opt/ml/model دایرکتوری برای استفاده توسط کد استنتاج شما. این serve و predictor.py نقطه ورود برای سرویس است، با مصنوع مدل که هنگام شروع استقرار بارگیری می شود. برای اطلاعات بیشتر ببین از کد استنتاج خود با خدمات میزبانی استفاده کنید.

گردش کار خود را با SageMaker Pipelines هماهنگ کنید

آخرین مرحله این است که کد خود را بهعنوان جریانهای کاری ML سرتاسر بسته بندی کنید و بهترین شیوههای MLOps را اعمال کنید. در SageMaker، حجم کار ساختمان مدل، یک گراف غیر چرخه ای جهت دار (DAG)، توسط SageMaker Pipelines مدیریت می شود. Pipelines یک سرویس کاملاً مدیریت شده است که از ارکستراسیون و ردیابی نسب داده پشتیبانی می کند. علاوه بر این، از آنجایی که Pipelines با SageMaker Python SDK یکپارچه شده است، می توانید خطوط لوله خود را به صورت برنامه نویسی با استفاده از یک رابط سطح بالا پایتون که قبلاً در مرحله آموزش استفاده کرده بودیم ایجاد کنید.

ما نمونه ای از کد خط لوله را برای نشان دادن پیاده سازی در آن ارائه می دهیم pipeline.py.

خط لوله شامل یک مرحله پیش پردازش برای تولید مجموعه داده، مرحله آموزش، مرحله شرط و مرحله ثبت مدل است. در پایان هر اجرای خط لوله، دانشمندان داده ممکن است بخواهند مدل خود را برای کنترل های نسخه ثبت کنند و بهترین عملکرد را به کار گیرند. رجیستری مدل SageMaker مکانی مرکزی برای مدیریت نسخههای مدل، مدلهای کاتالوگ و راهاندازی استقرار خودکار مدل با وضعیت تأیید یک مدل خاص فراهم میکند. برای جزئیات بیشتر مراجعه کنید ثبت و استقرار مدل ها با رجیستری مدل.

در یک سیستم ML، هماهنگسازی خودکار جریان کار به جلوگیری از کاهش عملکرد مدل، به عبارت دیگر از تغییر مدل کمک میکند. تشخیص زودهنگام و پیشگیرانه انحراف داده ها شما را قادر می سازد تا اقدامات اصلاحی مانند مدل های بازآموزی را انجام دهید. شما می توانید خط لوله SageMaker را برای آموزش مجدد نسخه جدیدی از مدل پس از شناسایی انحرافات راه اندازی کنید. ماشه یک خط لوله نیز می تواند توسط مانیتور مدل آمازون SageMaker، که به طور مستمر بر کیفیت مدل های تولیدی نظارت دارد. با قابلیت جمعآوری دادهها برای ثبت اطلاعات، مدل مانیتور از نظارت بر کیفیت دادهها و مدل، بایاس و نظارت بر رانش انتساب ویژگی پشتیبانی میکند. برای جزئیات بیشتر، نگاه کنید مدلها را برای دادهها و کیفیت مدل، سوگیری و توضیحپذیری پایش کنید.

نتیجه

در این پست، نحوه اجرای چارچوب PaddleOCR در SageMaker برای وظایف OCR را نشان دادیم. برای کمک به دانشمندان داده به راحتی در SageMaker، ما در چرخه عمر توسعه ML، از ساخت الگوریتم ها، آموزش، تا میزبانی مدل به عنوان یک سرویس وب برای استنتاج بلادرنگ قدم زدیم. میتوانید از کد الگوی ارائه شده برای انتقال یک چارچوب دلخواه به پلتفرم SageMaker استفاده کنید. آن را برای پروژه ML خود امتحان کنید و داستان موفقیت خود را به ما بگویید.

درباره نویسنده

جونی (جکی) لیو دانشمند ارشد کاربردی در AWS است. او سالها تجربه کاری در زمینه یادگیری ماشینی دارد. او دارای تجربه عملی غنی در توسعه و اجرای راهحلها در ساخت مدلهای یادگیری ماشینی در الگوریتمهای پیشبینی زنجیره تامین، سیستمهای توصیه تبلیغات، حوزه OCR و NLP است.

جونی (جکی) لیو دانشمند ارشد کاربردی در AWS است. او سالها تجربه کاری در زمینه یادگیری ماشینی دارد. او دارای تجربه عملی غنی در توسعه و اجرای راهحلها در ساخت مدلهای یادگیری ماشینی در الگوریتمهای پیشبینی زنجیره تامین، سیستمهای توصیه تبلیغات، حوزه OCR و NLP است.

یانوی کویدکترا، معمار راه حل های متخصص یادگیری ماشین در AWS است. او تحقیقات یادگیری ماشین را در IRISA (موسسه تحقیقات علوم کامپیوتر و سیستمهای تصادفی) آغاز کرد و چندین سال تجربه در ساخت برنامههای صنعتی مبتنی بر هوش مصنوعی در بینایی کامپیوتر، پردازش زبان طبیعی و پیشبینی رفتار کاربر آنلاین دارد. در AWS، او تخصص دامنه را به اشتراک میگذارد و به مشتریان کمک میکند تا پتانسیلهای کسبوکار را باز کنند و با یادگیری ماشینی در مقیاس، نتایج عملی را به دست آورند. در خارج از محل کار از مطالعه و مسافرت لذت می برد.

یانوی کویدکترا، معمار راه حل های متخصص یادگیری ماشین در AWS است. او تحقیقات یادگیری ماشین را در IRISA (موسسه تحقیقات علوم کامپیوتر و سیستمهای تصادفی) آغاز کرد و چندین سال تجربه در ساخت برنامههای صنعتی مبتنی بر هوش مصنوعی در بینایی کامپیوتر، پردازش زبان طبیعی و پیشبینی رفتار کاربر آنلاین دارد. در AWS، او تخصص دامنه را به اشتراک میگذارد و به مشتریان کمک میکند تا پتانسیلهای کسبوکار را باز کنند و با یادگیری ماشینی در مقیاس، نتایج عملی را به دست آورند. در خارج از محل کار از مطالعه و مسافرت لذت می برد.

یی-آن چن او یک توسعهدهنده نرمافزار در Amazon Lab 126 است. او بیش از 10 سال تجربه در توسعه محصولات مبتنی بر یادگیری ماشین در رشتههای مختلف، از جمله شخصیسازی، پردازش زبان طبیعی و بینایی رایانه دارد. خارج از محل کار، او دوست دارد دویدن طولانی و دوچرخه سواری انجام دهد.

یی-آن چن او یک توسعهدهنده نرمافزار در Amazon Lab 126 است. او بیش از 10 سال تجربه در توسعه محصولات مبتنی بر یادگیری ماشین در رشتههای مختلف، از جمله شخصیسازی، پردازش زبان طبیعی و بینایی رایانه دارد. خارج از محل کار، او دوست دارد دویدن طولانی و دوچرخه سواری انجام دهد.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آمازون SageMaker

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- زفیرنت