به نظر می رسد ویدیوهای دیپ فیک بلادرنگ، که به عنوان ایجاد کننده عصر جدیدی از عدم قطعیت اینترنتی معرفی شده اند، دارای یک نقص اساسی هستند: آنها نمی توانند نمایه های جانبی را مدیریت کنند.

این نتیجه ای است که در a گزارش [PDF] از Metaphysic.ai، که در آواتارهای سه بعدی، فناوری دیپ فیک و ارائه تصاویر سه بعدی از عکس های دو بعدی تخصص دارد. در آزمایشاتی که با استفاده از اپلیکیشن محبوب دیپفیک بلادرنگ انجام داد DeepFaceLive، چرخش سخت به پهلو به راحتی نشان داد که شخص روی صفحه آن چیزی نیست که به نظر می رسد.

چندین مدل در این آزمایش مورد استفاده قرار گرفتند - چندین مدل از جوامع عمیق و مدلهای موجود در DeepFaceLive - اما یک نمای 90 درجه از چهره باعث لرزش و اعوجاج شد زیرا شبکه همترازی چهره برای تخمین ژستها تلاش میکرد تا بفهمد چه چیزی میبیند.

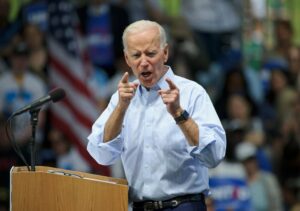

یک جفت تصویر از آزمایشهای متافیزیک که جیم کری عمیقفک شده و نتیجه چرخش به پهلو را نشان میدهد.

مارتین اندرسون، یکی از همکاران Metaphysic.ai، که این مطالعه را نوشته است، گفت: «بیشتر الگوریتمهای تراز چهره مبتنی بر دوبعدی، تنها 2 تا 50 درصد از تعداد نشانهها را از نمای روبرو به نمای نمایه اختصاص میدهند. پست های وبلاگ.

بدون اینکه بتواند نقاط مرجع کافی را ببیند، نرم افزار به سادگی نمی داند چگونه چهره جعلی خود را نمایش دهد.

دیپ فیک های خروج از ریل

در عرض چند سال، دیپفیکها از توانایی قرار دادن چهرهها بر روی تصاویر به انجام همین کار در ویدیوهای از پیش ضبطشده پیشرفت کردهاند. آخرین پیشرفتها امکان تعویض چهره در زمان واقعی را فراهم میکند، که منجر به استفاده از دیپفیکهای بیشتری در کلاهبرداری آنلاین و جرایم سایبری شده است.

A مطالعه از VMware دریافت که دو سوم از پاسخ دهندگان به عنوان بخشی از یک حمله با دیپ فیک های مخرب مواجه شدند که نسبت به سال قبل 13 درصد افزایش داشت. توجه داشته باشید که مطالعه VMware مشخص نکرده است که حملات دیپفیکی که پاسخدهندگان با آنها مواجه شدهاند، از قبل ضبط شدهاند یا زمان واقعی، و تنها حجم نمونه 125 نفر را در خود جای داده است.

FBI در ماه ژوئن نسبت به کلاهبردارانی که از فناوری دیپ فیک استفاده می کنند هشدار داد در طول مصاحبه های شغلی از راه دور. افبیآی گفت، افرادی که از این تکنیک استفاده میکنند در حال مصاحبه برای مشاغل حساس هستند که به آنها امکان دسترسی به دادههای مشتریان و اطلاعات اختصاصی کسبوکارها را میدهد.

همچنین از ویدیوهای Deepfake برای فریب دادن نرم افزارهای تشخیص چهره زنده استفاده شده است. مطابق به استارتاپ آنلاین مبارزه با تقلب Sensity AI. آزمایشهای Sensity نشان داد که نه برنامه از هر ده برنامه فروشنده با موفقیت با استفاده از یک ویدیوی تغییر یافته عمیق که از تلفن همراه پخش میشد، باز شد.

ترس از این فناوری به اندازه کافی برای اتحادیه اروپا جدی شده است تصویب قوانین اعمال جریمه برای شرکت هایی که به اندازه کافی با دیپ فیک ها و سایر منابع اطلاعات نادرست مبارزه نمی کنند. چین نیز پیش نویس قوانین عمیق جعلی که تهدیدی برای مجازات قانونی برای استفاده نادرست از فناوری، و همچنین نیاز به اعطای مجوز برای هرگونه استفاده مشروع از دیپ فیک است، که چین آن را "سنتز عمیق" می نامد.

راه حل برای چه مدت؟

طبق گزارش Metaphysic، حتی فناوری هایی مانند Nvidia میدان تابش عصبی (NeRF)، که میتواند یک صحنه سهبعدی را تنها از چند عکس ثابت ایجاد کند، از محدودیتهایی رنج میبرد که ایجاد نمای جانبی خوب را دشوار میکند.

NeRF ها از نظر تئوری می توانند هر تعداد از زوایای صورت را تنها از تعداد انگشت شماری عکس برون یابی کنند. [با این حال] مسائل مربوط به وضوح، تحرک صورت و ثبات زمانی مانع NeRF از تولید داده های غنی مورد نیاز برای آموزش یک مدل رمزگذار خودکار که می تواند تصاویر نمایه را به خوبی مدیریت کند، می شود. ما برای کسب اطلاعات بیشتر با انویدیا تماس گرفتیم، اما هنوز چیزی نشنیده ایم.

خوانندگان متوجه خواهند شد که تظاهرات متافیزیک فقط شامل چهرههای مشهور بود که تعداد زیادی از نمایههای آنها در فیلم و عکس ثبت شده است. از سوی دیگر، افراد غیر مشهور در میان ما، بعید به نظر میرسند که عکسهای پروفایل جانبی زیادی در دست داشته باشند.

اندرسون مینویسد: «مگر زمانی که دستگیر شده باشید، احتمالاً حتی یک عکس از این دست، چه در شبکههای اجتماعی و چه در مجموعهای آفلاین، ندارید».

Gaurav Oberoi، مهندس نرمافزار و موسس استارتآپ هوش مصنوعی Lexion، در سال 2018 هنگام تحقیق در مورد دیپفیکها تقریباً همین را دریافت کرد. در وبلاگ خود پست کند، اوبروی توضیح داد که چگونه دیپ فیک های کمدین جان الیور که بر مجری شب گذشته جیمی فالون سوار شده بود به خوبی کار می کرد، اما نه در نمایه.

Oberoi گفت: "به طور کلی، تصاویر آموزشی از هدف شما باید جهت گیری، حالات چهره و نور را در ویدئوهایی که می خواهید آنها را در آن بچسبانید، تقریبی داشته باشند." بنابراین اگر در حال ساخت ابزار تعویض چهره برای افراد معمولی هستید، با توجه به اینکه بیشتر عکسهای آنها رو به جلو هستند، تعویض چهره را به ویدیوهای بیشتر رو به جلو محدود کنید.»

در واقع به این معنی است که کلاهبردارانی که از دیپفیکهای بلادرنگ استفاده میکنند، بعید به نظر میرسد که دادههای لازم برای ایجاد نمای نمای جانبی را داشته باشند که بلافاصله بهعنوان جعلی قابل تشخیص نباشد (البته به شرطی که از یک چهره مشهور با عکاسی خوب استفاده نکنند). .

تا زمانی که ندانیم دیپفکرها راهی برای رفع این نقص پیدا نکردهاند، بهتر است این خط مشی را اتخاذ کنیم که از فرد آن طرف زوم بخواهیم نمای جانبی از چهرهاش را به شما نشان دهد - معروف یا غیرمشهور. ®

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- ثبت نام

- زفیرنت