معرفی

همانطور که دانش آموزان بی شماری به خوبی می دانند یادگیری زبان انگلیسی کار آسانی نیست. اما زمانی که دانش آموز یک کامپیوتر است، یک روش به طرز شگفت انگیزی کار می کند: به سادگی کوه هایی از متن را از اینترنت به یک مدل ریاضی غول پیکر به نام شبکه عصبی تغذیه کنید. این اصل عملی پشت مدلهای زبان مولد مانند ChatGPT OpenAI است که توانایی آن در مکالمه منسجم (اگر نه همیشه صادقانه) در طیف گستردهای از موضوعات باعث شگفتی محققان و عموم مردم در سال گذشته شده است.

اما این رویکرد دارای اشکالاتی است. برای یک چیز، روش "آموزش" مورد نیاز برای تبدیل آرشیوهای متنی گسترده به مدل های زبانی پیشرفته پرهزینه و زمان بر است. برای دیگری، حتی افرادی که مدل های زبان بزرگ را آموزش می دهند، درک عملکرد درونی آنها دشوار است. که به نوبه خود، پیشبینی راههای شکست آنها را دشوار میکند.

در مواجهه با این مشکلات، برخی از محققان ترجیح داده اند آموزش ببینند مدل های کوچکتر بر روی مجموعه داده های کوچکتر و سپس مطالعه رفتار آنها. "این مانند توالی است Drosophila ژنوم در مقابل تعیین توالی ژنوم انسان.» الی پاولیکمحقق مدل زبان در دانشگاه براون.

در حال حاضر، در یک مقاله یک جفت محقق مایکروسافت که اخیراً در سرور preprint علمی arxiv.org ارسال شده است، روش جدیدی را برای آموزش مدلهای زبانی ریز معرفی کردهاند: آنها را با یک رژیم غذایی سخت از داستانهای کودکان بزرگ کنید.

محققان یادگیری ماشین این درس را پذیرفته اند. GPT-3.5، مدل زبان بزرگی که رابط ChatGPT را تقویت می کند، نزدیک به 200 میلیارد پارامتر دارد و بر روی مجموعه داده ای متشکل از صدها میلیارد کلمه آموزش داده شده است. (OpenAI ارقام مربوطه را برای جانشین خود، GPT-4 منتشر نکرده است.) آموزش چنین مدل های بزرگی معمولاً به حداقل 1,000 پردازنده تخصصی به نام GPU نیاز دارد که هفته ها به طور موازی کار کنند. تنها تعداد کمی از شرکت ها می توانند منابع مورد نیاز را جمع آوری کنند، چه رسد به آموزش و مقایسه مدل های مختلف.

این دو محقق نشان دادند که مدلهای زبانی هزاران بار کوچکتر از سیستمهای پیشرفته امروزی، وقتی به این روش آموزش داده میشوند، به سرعت یاد میگیرند که داستانهای منسجم و دستوری را بیان کنند. نتایج آنها به مسیرهای تحقیقاتی جدیدی اشاره می کند که ممکن است برای آموزش مدل های بزرگتر و درک رفتار آنها مفید باشد.

گفت: «این مقاله را بسیار آموزنده یافتم چاندرا باگاواتولا، محقق مدل زبان در موسسه آلن برای هوش مصنوعی در سیاتل. "این مفهوم به خودی خود بسیار جالب است."

روزی روزگاری

شبکههای عصبی در قلب مدلهای زبان، ساختارهای ریاضیاتی هستند که بهطور ضعیف از مغز انسان الهام گرفتهاند. هر یک شامل نورون های مصنوعی زیادی است که در لایه ها مرتب شده اند، با اتصالات بین نورون ها در لایه های مجاور. رفتار شبکه عصبی توسط قدرت این اتصالات که پارامتر نامیده می شوند، کنترل می شود. در یک مدل زبان، پارامترها کنترل میکنند که مدل ممکن است کدام کلمات را بعداً بیرون بیاورد، با توجه به یک اعلان اولیه و کلماتی که قبلاً تولید کرده است.

یک مدل زمانی واقعاً در طول آموزش زنده می شود، زمانی که به طور مکرر خروجی خود را با متن موجود در مجموعه داده های آموزشی خود مقایسه می کند و پارامترهای خود را برای افزایش شباهت تنظیم می کند. یک شبکه آموزش ندیده با پارامترهای تصادفی به سادگی از روی چند خط کد جمع آوری می شود، اما فقط ابهام ایجاد می کند. پس از آموزش، اغلب می تواند به طور قابل قبولی متن ناآشنا را ادامه دهد. مدلهای بزرگتر اغلب تحت تنظیمات دقیقتری قرار میگیرند که به آنها میآموزد به سؤالات پاسخ دهند و دستورالعملها را دنبال کنند، اما بخش عمدهای از آموزش تسلط بر پیشبینی کلمات است.

موفقیت در پیشبینی کلمات نیازمند یک مدل زبان برای تسلط بر بسیاری از مهارتهای مختلف است. به عنوان مثال، قواعد دستور زبان انگلیسی نشان می دهد که کلمه بعدی بعد از کلمه "going" بدون توجه به موضوع متن احتمالا "to" است. علاوه بر این، یک سیستم برای تکمیل "پایتخت فرانسه است" و تکمیل یک قطعه حاوی کلمه "نه" نیاز به درک ابتدایی منطق دارد.

گفت: «زبان خام بسیار پیچیده است تیموتی نگوین، محقق یادگیری ماشین در DeepMind. «برای اینکه قابلیتهای زبانی جالبی ایجاد شود، مردم به «دادههای بیشتر بهتر است» متوسل شدهاند.»

معرفی

رونن الدانریاضیدانی که در سال 2022 به مایکروسافت ریسرچ پیوست تا مدلهای زبان مولد را مطالعه کند، میخواست راهی ارزانتر و سریعتر برای کشف تواناییهای خود ایجاد کند. راه طبیعی برای انجام این کار، استفاده از یک مجموعه داده کوچک بود، و این به نوبه خود به این معنی بود که او باید مدل هایی را برای تخصص در یک کار خاص آموزش دهد، تا آنها خیلی نازک نشوند. او در ابتدا میخواست مدلهایی را برای حل کلاس خاصی از مسائل ریاضی آموزش دهد، اما یک روز بعد از ظهر، پس از گذراندن وقت با دختر 5 سالهاش، متوجه شد که داستانهای کودکانه کاملاً مناسب هستند.

او گفت: «این به معنای واقعی کلمه بعد از خواندن داستانی برای او به ذهنم رسید.

برای تولید داستانهای منسجم برای کودکان، یک مدل زبان باید حقایقی را درباره جهان بیاموزد، شخصیتها و رویدادها را ردیابی کند و قوانین دستور زبان را رعایت کند - نسخههای سادهتر از چالشهایی که مدلهای بزرگ با آنها روبرو هستند. اما مدلهای بزرگی که بر روی مجموعه دادههای عظیم آموزش دیدهاند، جزئیات بیشماری بیربط را همراه با قوانینی که واقعاً مهم هستند، یاد میگیرند. الدان امیدوار بود که مختصر بودن و واژگان محدود داستانهای کودکان، یادگیری را برای مدلهای کوچک قابل کنترلتر کند – آموزش و درک آنها را آسانتر کند.

با این حال، در دنیای مدلهای زبان، «کوچک» نسبی است: مجموعه دادهای که هزار بار کوچکتر از آنچه برای آموزش GPT-3.5 استفاده میشود، همچنان باید حاوی میلیونها داستان باشد. نگوین گفت: «نمیدانم میخواهید چقدر پول خرج کنید، اما حدس میزنم که قرار نیست افراد حرفهای را برای نوشتن [چند میلیون] داستان کوتاه استخدام کنید».

برای راضی کردن چنین خوانندگان مشتاقی نیاز به نویسنده ای فوق العاده پرکار است، اما الدان چند نامزد در ذهن داشت. چه کسی بهتر از مخاطبان مدل های زبانی کوچک بنویسد؟

داستان های اسباب بازی

الدان بلافاصله شروع به ایجاد کتابخانه ای از داستان های مصنوعی کودکان کرد که توسط مدل های زبانی بزرگ تولید می شد. اما او به زودی متوجه شد که حتی مدل های پیشرفته به طور طبیعی چندان خلاق نیستند. الدان گفت، اگر فقط به GPT-4 بگویید داستان های مناسب برای کودکان 4 ساله بنویسد، "حدود یک پنجم داستان ها درباره کودکانی است که به پارک می روند و از سرسره ها می ترسند." تا آنجا که به اینترنت مربوط می شود، ظاهراً این داستان اصلی پیش دبستانی است.

راه حل این بود که کمی تصادفی بودن را به اعلان اضافه کنید. اول، الدان از GPT-4 برای ایجاد لیستی از 1,500 اسم، فعل و صفت که یک کودک 4 ساله ممکن است بداند استفاده کرد - به اندازه ای کوتاه که خودش به راحتی بتواند آن را بررسی کند. سپس او یک برنامه کامپیوتری ساده نوشت که مکرراً از GPT-3.5 یا GPT-4 خواسته میشد تا داستانی متناسب با سن خود ایجاد کند که شامل سه کلمه تصادفی از لیست بود، همراه با جزئیاتی که بهطور تصادفی انتخاب شده بود، مانند پایان خوش یا پیچیدگی داستان. داستانهای بهدستآمده، با مهربانی، کمتر بر روی اسلایدهای ترسناک متمرکز بودند.

الدان اکنون رویهای برای جمعآوری دادههای آموزشی در صورت تقاضا داشت، اما او نمیدانست برای آموزش یک مدل کاربردی به چند داستان نیاز دارد، یا اینکه آن مدل باید چقدر بزرگ باشد. در آن زمان بود که با او هم گروه شد یوانژی لی، یک محقق یادگیری ماشین در مایکروسافت و دانشگاه کارنگی ملون، با استفاده از این واقعیت که مدلهای کوچک را میتوان خیلی سریع آموزش داد، فرصتهای مختلف را امتحان کرد. مرحله 1 تصمیم گیری برای ارزیابی مدل های آنها بود.

معرفی

در تحقیق مدل زبان - مانند هر کلاس درس - نمره دهی موضوعی دشوار است. وجود دارد هیچ عنوان کاملی وجود ندارد که همه چیزهایی را که محققان میخواهند بدانند در بر میگیرد، و مدلهایی که در برخی وظایف برتر هستند، اغلب در برخی دیگر به طرز شگفتانگیزی شکست میخورند. با گذشت زمان، محققان معیارهای استاندارد مختلفی را بر اساس سؤالاتی با پاسخهای بدون ابهام ایجاد کردهاند که اگر میخواهید مهارتهای خاصی را ارزیابی کنید، رویکرد خوبی است. اما الدان و لی به چیز مبهمتری علاقه داشتند: مدلهای زبان واقعاً چقدر باید بزرگ باشند اگر زبان را تا حد امکان ساده کنید؟

الدان گفت: "برای اینکه مستقیماً آزمایش کنید که آیا مدل انگلیسی صحبت می کند، من فکر می کنم تنها کاری که می توانید انجام دهید این است که به مدل اجازه دهید انگلیسی را به روشی باز تولید کند."

تنها دو راه برای اندازهگیری عملکرد یک مدل در چنین سؤالهای کیفی وجود دارد: به نمرهدهندگان انسانی تکیه کنید یا یک بار دیگر به GPT-4 روی آورید. این دو محقق راه دوم را انتخاب کردند و در واقع به مدلهای بزرگ اجازه دادند هم کتابهای درسی را بنویسند و هم به مقالات نمره دهند.

باگاواتولا گفت که دوست داشت ببیند ارزیابیهای GPT-4 در مقایسه با ارزیابیهای بازبینان انسانی چگونه است - GPT-4 ممکن است نسبت به مدلهایی که به آموزش آنها کمک کرده است سوگیری داشته باشد، و غیرشفاف بودن مدلهای زبانی، کمی کردن چنین سوگیریهایی را دشوار میکند. اما او فکر نمیکند که چنین ظرافتهایی بر مقایسه بین مدلهای مختلف آموزشدیده بر روی مجموعههای مشابهی از داستانهای مصنوعی تأثیر بگذارد - تمرکز اصلی کار الدان و لی.

الدان و لی از یک روش دو مرحله ای برای ارزیابی هر یک از مدل های کوچک خود پس از آموزش استفاده کردند. ابتدا، آنها مدل کوچک را با نیمه اول یک داستان متمایز از آنهایی که در مجموعه داده های آموزشی قرار داشتند، تحریک کردند، به طوری که یک پایان جدید ایجاد کرد و این روند را با 50 داستان مختلف آزمایشی تکرار کرد. دوم، آنها به GPT-4 دستور دادند تا هر یک از پایان های مدل کوچک را بر اساس سه دسته - خلاقیت، دستور زبان و سازگاری با ابتدای داستان، درجه بندی کند. سپس آنها میانگین نمرات هر دسته را به دست آوردند و در نهایت به سه نمره نهایی در هر مدل رسیدند.

با در دست داشتن این روش، الدان و لی در نهایت آماده شدند تا مدل های مختلف را با هم مقایسه کنند و بفهمند که دانش آموزان ستاره کدامند.

نتایج آزمون

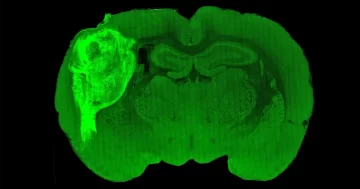

پس از مدتی کاوش اولیه، این دو محقق بر روی مجموعه داده های آموزشی شامل تقریباً 2 میلیون داستان مستقر شدند. آنها سپس از این مجموعه داده که TinyStories نام گرفت برای آموزش مدلهایی در اندازههای 1 میلیون تا 30 میلیون پارامتر با تعداد لایههای متفاوت استفاده کردند. کار سریعی بود: با استفاده از تنها چهار پردازنده گرافیکی، آموزش بزرگترین این مدلها بیش از یک روز طول نکشید.

کوچکترین مدل ها مشکل داشتند. برای مثال، یک داستان آزمایشی با مردی بداخلاق شروع میشود که به دختری میگوید که گربهاش را میبرد. یک مدل میلیون پارامتری در حلقهای گیر کرد که دختر مکرراً به مردی میگفت که میخواهد با هم دوست شود. اما بزرگترها - هنوز هم هزاران بار کوچکتر از GPT-3.5 - عملکرد شگفت انگیزی داشتند. نسخه 28 میلیون پارامتری داستان منسجمی را روایت میکرد، هرچند پایان تلخ بود: «کتی شروع به گریه کرد، اما مرد اهمیتی نداد. او گربه را برد و کتی دیگر گربه اش را ندید. پایان."

الدان و لی علاوه بر آزمایش مدلهای خود، چالش مشابهی را با GPT-2 OpenAI ارائه کردند، مدلی با 1.5 میلیارد پارامتر که در سال 2019 منتشر شد. وضعیت بسیار بدتر از این بود - قبل از پایان ناگهانی داستان، مرد تهدید میکند که دختر را خواهد برد. به دادگاه، زندان، بیمارستان، سردخانه و در نهایت کورهسوزی.

معرفی

نگوین میگوید که هیجانانگیز است که چنین مدلهای کوچکی بسیار روان هستند، اما شاید تعجبآور نباشد که GPT-2 با این کار دست و پنجه نرم میکند: این یک مدل بزرگتر است، اما با وضعیت هنر فاصله دارد، و بر روی مجموعه دادههای بسیار متفاوتی آموزش داده شده است. او خاطرنشان کرد: "کودک نوپا فقط در مورد وظایف کودک نوپا، مانند بازی با برخی اسباب بازی ها، ممکن است بهتر از من یا شما کار کند." "ما در این چیز ساده تخصص نداشتیم."

مقایسه بین مدل های مختلف TinyStories از عوامل مخدوش کننده یکسانی رنج نمی برد. الدان و لی نکاتی را مشاهده کردند که شبکههایی با لایههای کمتر اما نورونهای بیشتر در هر لایه در پاسخ به سؤالاتی که نیاز به دانش واقعی دارند، بهتر هستند. برعکس، شبکههایی با لایههای بیشتر و نورونهای کمتر در هر لایه، در ردیابی شخصیتها و نقاط طرح از قبل در داستان بهتر بودند. بهاگاواتولا این نتیجه را به ویژه جذاب یافت. او گفت اگر بتوان آن را در مدلهای بزرگتر تکرار کرد، «این یک نتیجه واقعاً جالب خواهد بود که میتواند از این کار ناشی شود».

الدان و لی همچنین بررسی کردند که چگونه تواناییهای مدلهای کوچکشان به طول دوره آموزشی بستگی دارد. در هر مورد، مدلها ابتدا بر گرامر و بعداً به ثبات تسلط داشتند. از نظر الدان، این الگو نشان می دهد که چگونه تفاوت در ساختارهای پاداش منجر به تفاوت در الگوهای اکتساب زبان بین شبکه های عصبی و کودکان می شود. او گفت: برای مدلهای زبانی که با پیشبینی کلمات یاد میگیرند، «انگیزه در کلمات «میخواهم داشته باشم» به اندازه کلمات «بستنی» است. از سوی دیگر، بچهها «به اینکه بگویند «دوست دارم بستنی بخورم» یا فقط «بستنی، بستنی، بستنی» اهمیتی نمیدهند.

کیفیت در مقابل مقدار

الدان و لی امیدوارند که این تحقیق به سایر محققان انگیزه دهد تا مدل های مختلف را آموزش دهند مجموعه داده TinyStories و توانایی های آنها را مقایسه کنید. اما پیشبینی اینکه کدام ویژگیهای مدلهای کوچک در مدلهای بزرگتر نیز ظاهر میشوند، اغلب دشوار است.

«شاید مدلهای بینایی موش واقعاً پروکسیهای خوبی برای بینایی انسان باشند، اما آیا مدلهای موش افسردگی مدلهای خوبی برای افسردگی انسان هستند؟» پاولیک گفت. "برای هر موردی کمی متفاوت است."

موفقیت مدلهای TinyStories درس وسیعتری را نیز نشان میدهد. رویکرد استاندارد برای جمعآوری مجموعه دادههای آموزشی شامل جاروبرقی متن از سراسر اینترنت و سپس فیلتر کردن زبالهها است. متن مصنوعی تولید شده توسط مدلهای بزرگ میتواند راهی جایگزین برای جمعآوری مجموعههای داده با کیفیت بالا ارائه دهد که نیازی به بزرگی ندارند.

الدان گفت: «ما شواهد بیشتر و بیشتری داریم که نشان میدهد این نه تنها در مدلهای اندازه TinyStories بلکه در مدلهای بزرگتر نیز بسیار مؤثر است». این شواهد از یک جفت مقاله بعدی درباره مدلهای میلیارد پارامتری توسط الدان، لی و سایر محققان مایکروسافت به دست آمده است. در مقاله اولآنها مدلی را برای یادگیری زبان برنامه نویسی پایتون با استفاده از تکه های کد تولید شده توسط GPT-3.5 به همراه کدهایی که به دقت از اینترنت تهیه شده بود، آموزش دادند. در دومآنها مجموعه دادههای آموزشی را با «کتابهای درسی» مصنوعی، که طیف گستردهای از موضوعات را پوشش میدهد، برای آموزش یک مدل زبانی همه منظوره، تقویت کردند. در آزمایشهای خود، هر دو مدل به طور مطلوبی با مدلهای بزرگتر آموزشدیده بر روی مجموعههای داده بزرگتر مقایسه شدند. اما ارزیابی مدلهای زبان همیشه مشکل است و رویکرد دادههای آموزشی مصنوعی هنوز در مراحل ابتدایی خود است - آزمونهای مستقل بیشتری لازم است.

با بزرگتر شدن مدلهای زبانی پیشرفته، یافتههای شگفتانگیز از پسرعموهای کوچک آنها یادآوری میکند که هنوز چیزهای زیادی در مورد سادهترین مدلها نمیدانیم. نگوین انتظار دارد مقالات بیشتری را ببیند که رویکرد پیشگام TinyStories را بررسی می کنند.

سوال این است: اندازه کجا و چرا اهمیت دارد؟ او گفت. "باید علمی در مورد آن وجود داشته باشد، و این مقاله امیدوار است آغاز یک داستان غنی باشد."

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.quantamagazine.org/tiny-language-models-thrive-with-gpt-4-as-a-teacher-20231005/

- : دارد

- :است

- :نه

- :جایی که

- ][پ

- $UP

- 000

- 1

- 200

- 200 میلیارد

- 2019

- 2022

- 30

- 50

- 500

- a

- توانایی

- توانایی

- درباره ما

- اکتساب

- در میان

- اضافه کردن

- اضافه

- اضافی

- مجاور

- مزیت - فایده - سود - منفعت

- اثر

- پس از

- از نو

- تمام

- تنها

- در امتداد

- قبلا

- همچنین

- جایگزین

- همیشه

- an

- و

- اندرو

- دیگر

- پاسخ

- پاسخ

- ظاهر شدن

- روش

- مناسب

- بایگانی

- هستند

- بوجود می آیند

- مرتب شده اند

- هنر

- مصنوعی

- هوش مصنوعی

- AS

- At

- حضار

- افزوده شده

- نویسنده

- دور

- مستقر

- BE

- قبل از

- شروع

- رفتار

- پشت سر

- بودن

- معیار

- بهتر

- میان

- جانبدارانه

- تعصبات

- بزرگ

- بیلیون

- میلیاردها

- بیت

- هر دو

- مغز

- گسترده تر

- قهوهای

- اما

- by

- نام

- آمد

- CAN

- نامزد

- قابلیت های

- سرمایه

- اهميت دادن

- Осторожно

- کارنگی ملون

- مورد

- CAT

- دسته

- دسته بندی

- معین

- به چالش

- چالش ها

- مشخصات

- کاراکتر

- GPT چت

- ارزان تر

- بررسی

- فرزندان

- را انتخاب

- برگزیده

- کلاس

- رمز

- منسجم

- می آید

- شرکت

- مقايسه كردن

- مقایسه

- مقایسه

- کامل

- تکمیل

- بغرنج

- شامل

- کامپیوتر

- مفهوم

- علاقمند

- اتصالات

- استوار

- شامل

- شامل

- ادامه دادن

- کنترل

- متقابلا

- سرد

- متناظر

- گران

- میتوانست

- زن و شوهر

- دادگاه

- پوشش

- ایجاد

- خالق

- خلاقیت

- سرپرستی

- داده ها

- مجموعه داده ها

- مجموعه داده ها

- روز

- تصمیم گیری

- Deepmind

- تقاضا

- افسردگی

- جزئیات

- جزئیات

- توسعه

- توسعه

- رژیم غذایی

- تفاوت

- مختلف

- مشکلات

- مستقیما

- کشف

- متمایز

- do

- میکند

- نمی کند

- آیا

- اشکالاتی

- دوبله شده

- مدت

- در طی

- هر

- پیش از آن

- آسان تر

- به آسانی

- ساده

- موثر

- به طور موثر

- در آغوش

- کپسوله می کند

- پایان

- پایان

- انگلیسی

- کافی

- به خصوص

- ارزیابی

- ارزیابی

- ارزیابی

- حتی

- حوادث

- تا کنون

- هر

- همه چیز

- مدرک

- مثال

- اکسل

- مهیج

- انتظار می رود

- اکتشاف

- اکتشاف

- بررسی

- فوق العاده

- نما

- واقعیت

- عوامل

- حقایق

- FAIL

- بسیار

- سریعتر

- کمی از

- کمتر

- آمار و ارقام

- فیلتر

- نهایی

- سرانجام

- پیدا کردن

- یافته ها

- نام خانوادگی

- مناسب

- تمرکز

- متمرکز شده است

- به دنبال

- برای

- یافت

- چهار

- فرانسه

- دوستان

- از جانب

- تابعی

- بیشتر

- همه منظوره

- تولید می کنند

- تولید

- مولد

- غول

- دختر

- داده

- رفتن

- خوب

- کردم

- اداره می شود

- GPU ها

- درجه

- دستور زبان

- فهم

- ترسناک

- شدن

- بود

- نیم

- دست

- خوشحال

- سخت

- آیا

- he

- قلب

- کمک کرد

- مفید

- او

- با کیفیت بالا

- نکات

- استخدام

- خود را

- امید

- خوشبختانه

- بیمارستان

- چگونه

- چگونه

- HTTPS

- انسان

- صدها نفر

- i

- ICE

- بستنی

- اندیشه

- if

- نشان می دهد

- بلافاصله

- in

- انگیزه

- مشمول

- افزایش

- مستقل

- حاوی اطلاعات مفید

- اول

- در ابتدا

- الهام بخش

- موسسه

- دستورالعمل

- اطلاعات

- علاقه مند

- جالب

- رابط

- اینترنت

- به

- فریبنده

- معرفی

- IT

- ITS

- خود

- زندان

- پیوست

- تنها

- نگاه داشتن

- نگهداری

- دانستن

- دانش

- زبان

- بزرگ

- بزرگتر

- بزرگترین

- بعد

- لایه

- لایه

- رهبری

- یاد گرفتن

- آموخته

- یادگیری

- کمترین

- کمتر

- درس

- اجازه

- اجازه دادن

- Li

- کتابخانه

- زندگی

- پسندیدن

- احتمالا

- محدود شده

- خطوط

- فهرست

- کوچک

- منطق

- دستگاه

- فراگیری ماشین

- مجله

- اصلی

- ساخت

- باعث می شود

- ساخت

- مرد

- قابل کنترل

- بسیاری

- عظیم

- استاد

- تسلط

- ریاضی

- ریاضی

- ماده

- ممکن است..

- me

- به معنای

- اندازه

- ملون

- روش

- مایکروسافت

- قدرت

- میلیون

- میلیون ها نفر

- ذهن

- مدل

- مدل

- پول

- بیش

- بسیار

- طبیعی

- تقریبا

- لازم

- نیاز

- نیازهای

- شبکه

- شبکه

- عصبی

- شبکه های عصبی

- شبکه های عصبی

- نورون ها

- هرگز

- جدید

- بعد

- نگوین

- نه

- اشاره کرد

- اسمها

- اکنون

- تعداد

- مشاهده کردن

- of

- ارائه

- غالبا

- on

- یک بار

- ONE

- آنهایی که

- فقط

- شفافیت

- OpenAI

- عملیاتی

- or

- سفارش

- دیگر

- دیگران

- خارج

- تولید

- روی

- خود

- جفت

- مقاله

- اوراق

- موازی

- پارامترهای

- پارک

- عبور

- گذشته

- الگو

- الگوهای

- مردم

- برای

- کامل

- کارایی

- انجام

- شاید

- دوره

- پیشگام

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- نقطه

- فرصت

- ممکن

- + نوشته شده در

- قدرت

- پیش بینی

- پیش بینی

- پیش گویی

- مقدماتی

- ارائه شده

- اصل

- مشکلات

- روش

- روند

- پردازنده ها

- تولید کردن

- حرفه ای

- برنامه

- برنامه نويسي

- عمومی

- پــایتــون

- کیفی

- مجله کوانتاما

- سوال

- سوالات

- سریع

- به سرعت

- پنجگانه

- بالا بردن

- تصادفی

- تصادفی بودن

- محدوده

- اعم

- سریعا

- خواندن

- خوانندگان

- اماده

- متوجه

- واقعا

- تازه

- بدون در نظر گرفتن

- نسبی

- منتشر شد

- تکیه

- به طور مکرر

- تکرار شده

- ضروری

- نیاز

- لازمه

- تحقیق

- پژوهشگر

- محققان

- منابع

- نتیجه

- نتیجه

- نتایج

- پاداش

- غنی

- تقریبا

- مسیر

- قوانین

- در حال اجرا

- سعید

- همان

- دید

- گفتن

- می ترسم

- علم

- علمی

- سیاتل

- دوم

- دیدن

- ترتیب دهی

- سرور

- تنظیم

- مجموعه

- مستقر

- او

- کوتاه

- باید

- نشان داد

- مشابه

- ساده

- ساده تر

- ساده کردن

- به سادگی

- اندازه

- مهارت ها

- اسلاید

- کوچک

- کوچکتر

- So

- راه حل

- حل

- برخی از

- چیزی

- بزودی

- صحبت می کند

- متخصص

- تخصصی

- خاص

- خرج کردن

- هزینه

- گسترش

- استاندارد

- ستاره

- آغاز شده

- دولت

- وضعیت هنر

- ساقه

- گام

- هنوز

- داستان

- داستان

- استحکام

- سخت

- ساختار

- دانشجو

- دانشجویان

- مورد مطالعه قرار

- مهاجرت تحصیلی

- موضوع

- موفقیت

- چنین

- نشان می دهد

- حاکی از

- فوق العاده

- غافلگیر شدن

- تعجب آور

- ترکیبی

- سیستم

- سیستم های

- گرفتن

- مصرف

- کار

- وظایف

- تیمی

- گفتن

- گفتن

- آزمون

- تست

- تست

- متن

- نسبت به

- که

- La

- دولت

- جهان

- شان

- آنها

- خودشان

- سپس

- اینها

- آنها

- چیز

- فکر می کنم

- این

- کسانی که

- اگر چه؟

- هزار

- هزاران نفر

- تهدید می کند

- سه

- رشد

- زمان

- بار

- به

- امروز

- گفته شده

- هم

- در زمان

- موضوع

- تاپیک

- نسبت به

- مسیر

- قطار

- آموزش دیده

- آموزش

- مسکوت

- صادقانه

- امتحان

- تلاش

- دور زدن

- پیچ

- دو

- به طور معمول

- تحت تاثیر قرار می گیرد

- فهمیدن

- درک

- نا آشنا

- دانشگاه

- بر

- استفاده

- با استفاده از

- مختلف

- متفاوت است

- وسیع

- نسخه

- نسخه

- در مقابل

- بسیار

- دید

- می خواهم

- خواسته

- بود

- مسیر..

- راه

- we

- وب سایت

- هفته

- خوب

- بود

- چه زمانی

- چه

- که

- WHO

- که

- چرا

- وسیع

- دامنه گسترده

- اراده

- با

- کلمه

- کلمات

- مهاجرت کاری

- کارها

- با این نسخهها کار

- جهان

- بدتر

- خواهد بود

- نوشتن

- نوشت

- سال

- شما

- زفیرنت