از مدل های زبان بزرگ (LLM) می توان برای تجزیه و تحلیل اسناد پیچیده و ارائه خلاصه و پاسخ به سؤالات استفاده کرد. پست تطبیق با دامنه تنظیم دقیق مدلهای بنیاد در Amazon SageMaker JumpStart در دادههای مالی نحوه تنظیم دقیق یک LLM با استفاده از مجموعه داده خود را شرح می دهد. هنگامی که یک LLM جامد دارید، میخواهید آن LLM را در معرض دید کاربران تجاری قرار دهید تا اسناد جدید را پردازش کنند، که ممکن است صدها صفحه باشد. در این پست، نحوه ایجاد یک رابط کاربری بلادرنگ را نشان میدهیم تا به کاربران تجاری اجازه دهیم یک سند PDF با طول دلخواه را پردازش کنند. پس از پردازش فایل، می توانید سند را خلاصه کنید یا در مورد محتوا سؤال بپرسید. راه حل نمونه شرح داده شده در این پست در دسترس است GitHub.

کار با اسناد مالی

صورت های مالی مانند گزارش های سود سه ماهه و گزارش های سالانه به سهامداران اغلب ده ها یا صدها صفحه هستند. این اسناد حاوی بسیاری از زبانها مانند سلب مسئولیت و زبان قانونی است. اگر میخواهید اطلاعات کلیدی را از یکی از این اسناد استخراج کنید، به زمان و آشنایی با زبان دیگ بخار نیاز دارید تا بتوانید حقایق جالب را شناسایی کنید. و البته، شما نمی توانید از یک LLM در مورد مدرکی که هرگز ندیده است سؤال بپرسید.

LLMهایی که برای خلاصهسازی استفاده میشوند محدودیتی در تعداد نشانهها (نویسههای) ارسال شده به مدل دارند و به استثنای برخی موارد، اینها معمولاً بیش از چند هزار توکن نیستند. این معمولاً از توانایی خلاصه کردن اسناد طولانی تر جلوگیری می کند.

راه حل ما اسنادی را مدیریت می کند که از حداکثر طول توکن نشانه LLM بیشتر است و آن سند را برای پاسخگویی به سؤال در اختیار LLM قرار می دهد.

بررسی اجمالی راه حل

طراحی ما دارای سه قطعه مهم است:

- این یک برنامه وب تعاملی برای کاربران تجاری برای آپلود و پردازش PDF دارد

- از کتابخانه langchain برای تقسیم یک PDF بزرگ به تکه های قابل مدیریت تر استفاده می کند

- از تکنیک تولید افزوده بازیابی استفاده می کند تا به کاربران اجازه دهد در مورد داده های جدیدی که LLM قبلاً ندیده سؤال بپرسند.

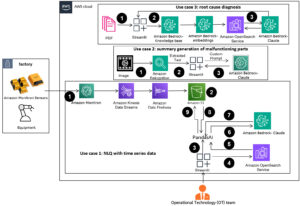

همانطور که در نمودار زیر نشان داده شده است، ما از یک فرانت اند استفاده می کنیم که با جاوا اسکریپت React میزبانی شده است سرویس ذخیره سازی ساده آمازون (Amazon S3) سطل جلو آمازون CloudFront. نرم افزار جلویی به کاربران اجازه می دهد اسناد PDF را در آمازون S3 آپلود کنند. پس از تکمیل آپلود، می توانید یک کار استخراج متن را فعال کنید متن آمازون. به عنوان بخشی از پس پردازش، یک AWS لامبدا تابع نشانگرهای خاصی را در متن وارد می کند که مرزهای صفحه را نشان می دهد. هنگامی که آن کار انجام شد، می توانید یک API را فراخوانی کنید که متن را خلاصه می کند یا به سؤالات مربوط به آن پاسخ می دهد.

از آنجا که برخی از این مراحل ممکن است مدتی طول بکشد، معماری از یک رویکرد ناهمزمان جدا شده استفاده می کند. به عنوان مثال، فراخوانی برای خلاصه کردن یک سند، یک تابع Lambda را فراخوانی می کند که پیامی را به یک ارسال می کند سرویس صف ساده آمازون صف (Amazon SQS). یکی دیگر از تابع های Lambda آن پیام را دریافت می کند و یک را شروع می کند سرویس کانتینر الاستیک آمازون (Amazon ECS) AWS Fargate وظیفه. وظیفه Fargate را فرا می خواند آمازون SageMaker نقطه پایان استنتاج ما در اینجا از یک کار Fargate استفاده می کنیم زیرا خلاصه کردن یک PDF بسیار طولانی ممکن است زمان و حافظه بیشتری نسبت به یک تابع Lambda در دسترس داشته باشد. وقتی خلاصهسازی انجام شد، برنامه front-end میتواند نتایج را از یک برنامه دریافت کند آمازون DynamoDB جدول.

برای خلاصهسازی، از مدل خلاصه AI21، یکی از مدلهای پایه موجود از طریق استفاده میکنیم. Amazon SageMaker JumpStart. اگرچه این مدل اسناد تا 10,000 کلمه (تقریباً 40 صفحه) را مدیریت میکند، ما از تقسیمکننده متن langchain استفاده میکنیم تا مطمئن شویم که هر فراخوانی خلاصهسازی به LLM بیش از 10,000 کلمه نباشد. برای تولید متن، از مدل Cohere's Medium استفاده میکنیم و از GPT-J برای جاسازیها، هر دو از طریق JumpStart استفاده میکنیم.

پردازش خلاصه سازی

هنگام مدیریت اسناد بزرگتر، باید نحوه تقسیم سند را به قطعات کوچکتر تعریف کنیم. هنگامی که نتایج استخراج متن را از Amazon Textract دریافت میکنیم، نشانگرهایی را برای تکههای بزرگتر متن (تعداد صفحات قابل تنظیم)، صفحات جداگانه و شکستگیهای خط درج میکنیم. Langchain بر اساس آن نشانگرها تقسیم میشود و اسناد کوچکتری را که زیر محدودیت توکن هستند جمعآوری میکند. کد زیر را ببینید:

LLM در زنجیره خلاصه سازی یک پوشش نازک در اطراف نقطه پایانی SageMaker ما است:

جواب سوال

در روش تولید افزوده بازیابی، ابتدا سند را به بخش های کوچکتر تقسیم می کنیم. ما تعبیههایی را برای هر بخش ایجاد میکنیم و آنها را در پایگاه داده منبع باز Chroma vector از طریق رابط langchain ذخیره میکنیم. ما پایگاه داده را در یک ذخیره می کنیم سیستم فایل الاستیک آمازون سیستم فایل (Amazon EFS) برای استفاده بعدی. کد زیر را ببینید:

وقتی جاسازی ها آماده شد، کاربر می تواند یک سوال بپرسد. ما در پایگاه داده برداری برای تکه های متنی که بیشتر با این سوال مطابقت دارند جستجو می کنیم:

ما نزدیکترین تکه تطبیق را می گیریم و از آن به عنوان زمینه مدل تولید متن برای پاسخ به این سوال استفاده می کنیم:

تجربه کاربر

اگرچه LLM ها علم داده پیشرفته را نشان می دهند، بیشتر موارد استفاده برای LLM ها در نهایت شامل تعامل با کاربران غیر فنی است. برنامه وب مثال ما یک مورد استفاده تعاملی را مدیریت می کند که در آن کاربران تجاری می توانند یک سند PDF جدید را آپلود و پردازش کنند.

نمودار زیر رابط کاربری را نشان می دهد. کاربر با آپلود یک PDF شروع می کند. پس از ذخیره سند در آمازون S3، کاربر می تواند کار استخراج متن را شروع کند. وقتی این کار کامل شد، کاربر میتواند کار خلاصهسازی را فراخوانی کند یا سؤال بپرسد. رابط کاربری برخی از گزینه های پیشرفته مانند اندازه تکه و همپوشانی تکه را در معرض نمایش قرار می دهد که برای کاربران پیشرفته ای که برنامه را روی اسناد جدید آزمایش می کنند مفید است.

مراحل بعدی

LLM ها قابلیت های قابل توجهی برای بازیابی اطلاعات ارائه می دهند. کاربران تجاری نیاز به دسترسی راحت به این قابلیت ها دارند. دو جهت برای کار آینده وجود دارد که باید در نظر گرفته شود:

- از LLM های قدرتمند موجود در مدل های فونداسیون Jumpstart استفاده کنید. تنها با چند خط کد، برنامه نمونه ما می تواند از LLM های پیشرفته AI21 و Cohere برای خلاصه سازی و تولید متن استفاده کرده و استفاده کند.

- این قابلیت ها را برای کاربران غیر فنی در دسترس قرار دهید. یک پیش نیاز برای پردازش اسناد PDF استخراج متن از سند است و کارهای خلاصه سازی ممکن است چند دقیقه طول بکشد تا اجرا شوند. این نیاز به یک رابط کاربری ساده با قابلیتهای پردازش باطن ناهمزمان دارد که طراحی آن با استفاده از سرویسهای بومی ابری مانند Lambda و Fargate آسان است.

همچنین توجه داشته باشیم که یک سند PDF اطلاعاتی نیمه ساختار یافته است. شناسایی نشانههای مهم مانند سرفصلهای بخش از نظر برنامهریزی دشوار است، زیرا به اندازه فونت و سایر شاخصهای بصری متکی هستند. شناسایی ساختار زیربنایی اطلاعات به LLM کمک می کند تا داده ها را با دقت بیشتری پردازش کند، حداقل تا زمانی که LLM ها بتوانند ورودی با طول نامحدود را مدیریت کنند.

نتیجه

در این پست، نحوه ساخت یک برنامه وب تعاملی را نشان دادیم که به کاربران تجاری اجازه می دهد اسناد PDF را برای خلاصه و پاسخ به سؤالات آپلود و پردازش کنند. ما دیدیم که چگونه می توان از مدل های پایه Jumpstart برای دسترسی به LLM های پیشرفته استفاده کرد و از تکنیک های تقسیم متن و بازیابی تولید افزوده برای پردازش اسناد طولانی تر و در دسترس قرار دادن آنها به عنوان اطلاعات برای LLM استفاده کرد.

در این مقطع زمانی، دلیلی وجود ندارد که این قابلیت های قدرتمند را در اختیار کاربران خود قرار ندهید. ما شما را تشویق می کنیم که استفاده از آن را شروع کنید مدل های فونداسیون جامپ استارت امروز.

درباره نویسنده

رندی دیفاو یک معمار ارشد راه حل در AWS است. او دارای مدرک MSEE از دانشگاه میشیگان است، جایی که روی بینایی کامپیوتری برای وسایل نقلیه خودران کار می کرد. او همچنین دارای مدرک MBA از دانشگاه ایالتی کلرادو است. رندی موقعیت های مختلفی را در فضای فناوری از مهندسی نرم افزار گرفته تا مدیریت محصول داشته است. In در سال 2013 وارد فضای Big Data شد و به کاوش در آن منطقه ادامه می دهد. او به طور فعال روی پروژه هایی در فضای ML کار می کند و در کنفرانس های متعددی از جمله Strata و GlueCon ارائه کرده است.

رندی دیفاو یک معمار ارشد راه حل در AWS است. او دارای مدرک MSEE از دانشگاه میشیگان است، جایی که روی بینایی کامپیوتری برای وسایل نقلیه خودران کار می کرد. او همچنین دارای مدرک MBA از دانشگاه ایالتی کلرادو است. رندی موقعیت های مختلفی را در فضای فناوری از مهندسی نرم افزار گرفته تا مدیریت محصول داشته است. In در سال 2013 وارد فضای Big Data شد و به کاوش در آن منطقه ادامه می دهد. او به طور فعال روی پروژه هایی در فضای ML کار می کند و در کنفرانس های متعددی از جمله Strata و GlueCon ارائه کرده است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/use-a-generative-ai-foundation-model-for-summarization-and-question-answering-using-your-own-data/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 000

- 10

- 100

- 13

- 14

- ٪۱۰۰

- 2013

- 25

- 40

- 500

- 7

- a

- توانایی

- قادر

- درباره ما

- در مورد IT

- دسترسی

- در دسترس

- به درستی

- فعالانه

- پیشرفته

- مزیت - فایده - سود - منفعت

- پس از

- AI

- قبلا

- همچنین

- هر چند

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- متن آمازون

- آمازون خدمات وب

- an

- تحلیل

- و

- سالیانه

- دیگر

- پاسخ

- پاسخ

- API

- کاربرد

- روش

- تقریبا

- معماری

- هستند

- محدوده

- دور و بر

- AS

- At

- افزوده شده

- نویسنده

- خود مختار

- خودروهای خودمختار

- در دسترس

- AWS

- به عقب

- بخش مدیریت

- مستقر

- BE

- زیرا

- بزرگ

- بزرگ داده

- هر دو

- مرز

- می شکند

- ساختن

- کسب و کار

- by

- صدا

- تماس ها

- CAN

- قابلیت های

- مورد

- موارد

- زنجیر

- کاراکتر

- نزدیک

- رمز

- کلرادو

- کامل

- پیچیده

- کامپیوتر

- چشم انداز کامپیوتر

- همایش ها

- در نظر بگیرید

- ساختن

- شامل

- ظرف

- محتوا

- زمینه

- ادامه

- مناسب

- میتوانست

- دوره

- ایجاد

- داده ها

- نقاط داده

- علم اطلاعات

- پایگاه داده

- جداسازی شده

- تعريف كردن

- نشان دادن

- گسترش

- شرح داده شده

- طرح

- مشکل

- سند

- اسناد و مدارک

- انجام شده

- هر

- درامد

- ساده

- تشویق

- پایان

- نقطه پایانی

- مهندسی

- وارد

- مثال

- تجاوز

- اکتشاف

- عصاره

- حقایق

- آشنایی

- کمی از

- پرونده

- مالی

- نام خانوادگی

- پیروی

- برای

- پایه

- از جانب

- جلو

- پایان جلو

- تابع

- آینده

- نسل

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- دسته

- دستگیره

- اداره

- آیا

- he

- برگزار شد

- کمک می کند

- اینجا کلیک نمایید

- دارای

- میزبانی

- چگونه

- چگونه

- HTTP

- HTTPS

- صدها نفر

- شناسایی

- شناسایی

- if

- اجرا

- مهم

- in

- از جمله

- شاخص ها

- فرد

- اطلاعات

- ورودی

- درج می کند

- اثر متقابل

- تعاملی

- جالب

- رابط

- به

- فراخوانی میکند

- شامل

- IT

- جاوا اسکریپت

- کار

- شغل ها

- JPG

- تنها

- کلید

- زبان

- بزرگ

- بزرگتر

- بعد

- کمترین

- قانونی

- طول

- اجازه

- اجازه می دهد تا

- کتابخانه

- پسندیدن

- محدود

- لاین

- خطوط

- LLM

- بارکننده

- طولانی

- دیگر

- خیلی

- ساخت

- قابل کنترل

- مدیریت

- مسابقه

- مطابق

- بیشترین

- ممکن است..

- متوسط

- حافظه

- پیام

- روش

- میشیگان

- دقیقه

- ML

- مدل

- مدل

- بیش

- اکثر

- نیاز

- هرگز

- جدید

- نه

- غیر فنی

- به طور معمول

- عدد

- متعدد

- of

- غالبا

- on

- یک بار

- ONE

- منبع باز

- گزینه

- or

- دیگر

- ما

- خود

- با ما

- صفحات

- بخش

- گذشت

- انتخاب کنید

- کلاهبرداری

- تصویر

- قطعات

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- نقطه

- موقعیت

- پست

- پست ها

- صفحه اصلی

- قوی

- ارائه شده

- اصلی

- روند

- فرآوری شده

- در حال پردازش

- محصول

- مدیریت تولید

- پروژه ها

- ارائه

- سوال

- سوالات

- اعم

- واکنش نشان می دهند

- اماده

- زمان واقعی

- دلیل

- تکیه

- گزارش ها

- نشان دادن

- پاسخ

- پاسخ

- نتایج

- برگشت

- دویدن

- حکیم ساز

- ذخیره

- دید

- علم

- جستجو

- بخش

- دیدن

- مشاهده گردید

- بخش

- بخش ها

- خود

- ارشد

- دنباله

- خدمات

- چند

- سهامداران

- نشان داد

- نشان داده شده

- نشان می دهد

- قابل توجه

- ساده

- اندازه

- اندازه

- کوچکتر

- So

- نرم افزار

- مهندسی نرم افزار

- جامد

- راه حل

- مزایا

- برخی از

- فضا

- ویژه

- انشعاب

- تقسیم می کند

- شروع

- شروع می شود

- دولت

- اظهارات

- مراحل

- توقف

- ذخیره سازی

- opbevare

- ذخیره شده

- ساختار

- چنین

- خلاصه کردن

- خلاصه

- مطمئن

- سیستم

- جدول

- گرفتن

- کار

- تکنیک

- پیشرفته

- ده ها

- تست

- نسبت به

- که

- La

- آنها

- آنجا.

- اینها

- آنها

- این

- کسانی که

- سه

- از طریق

- زمان

- به

- امروز

- رمز

- نشانه

- ماشه

- دو

- به طور معمول

- در نهایت

- زیر

- اساسی

- دانشگاه

- تا

- آپلود

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- رابط کاربری

- کاربران

- استفاده

- با استفاده از

- تنوع

- وسایل نقلیه

- بسیار

- از طريق

- دید

- می خواهم

- we

- وب

- برنامه تحت وب

- خدمات وب

- چه زمانی

- که

- WHO

- اراده

- با

- کلمات

- مهاجرت کاری

- مشغول به کار

- کارگر

- خواهد بود

- شما

- شما

- زفیرنت