Amazon Sage Maker on täysin hallittu palvelu, joka tarjoaa jokaiselle kehittäjälle ja datatieteilijälle mahdollisuuden nopeasti rakentaa, kouluttaa ja ottaa käyttöön koneoppimismalleja (ML) mittakaavassa. ML realisoituu johtopäätöksenä. SageMaker tarjoaa neljä päättelyvaihtoehtoa:

Nämä neljä vaihtoehtoa voidaan luokitella laajasti online- ja eräpäätelmävaihtoehtoihin. Online Inference -sovelluksessa pyyntöjen odotetaan käsiteltävän sitä mukaa, kun ne saapuvat, ja kuluttava sovellus odottaa vastausta jokaisen pyynnön käsittelyn jälkeen. Tämä voi tapahtua joko synkronisesti (reaaliaikainen päättely, palvelimeton) tai asynkronisesti (asynkroninen päättely). Synkronisessa kuviossa kuluttava sovellus on estetty eikä voi jatkaa ennen kuin se saa vastauksen. Nämä työmäärät ovat yleensä reaaliaikaisia sovelluksia, kuten online-luottokorttipetosten havaitseminen, jossa vastauksia odotetaan millisekunneista sekunteihin ja pyyntöjen hyötykuormat ovat pieniä (muutama megatavu). Asynkronisessa mallissa sovelluskokemusta ei estetä (esimerkiksi vakuutuskorvauksen lähettäminen mobiilisovelluksen kautta), ja se vaatii yleensä suurempia hyötykuormia ja/tai pidempiä käsittelyaikoja. Offline-päättelyssä päättelypyyntöjen yhdistelmä (erä) käsitellään yhdessä, ja vastaukset annetaan vasta, kun koko erä on käsitelty. Yleensä nämä työkuormat eivät ole latenssiherkkiä, sisältävät suuria määriä (useita gigatavuja) dataa, ja ne ajoitetaan säännölliseen tahtiin (esimerkiksi suorita objektien tunnistus turvakameran kuvauksissa päivän lopussa tai käsittele palkkatiedot kuun loppu).

Paljailla luilla, SageMakerin reaaliaikainen päättely koostuu malleista, kehyksestä/säilystä, jonka kanssa työskentelet, ja infrastruktuurista/esiintymistä, jotka tukevat käytössä olevaa päätepistettäsi. Tässä viestissä tutkimme, kuinka voit luoda ja kutsua yhden mallin päätepisteen.

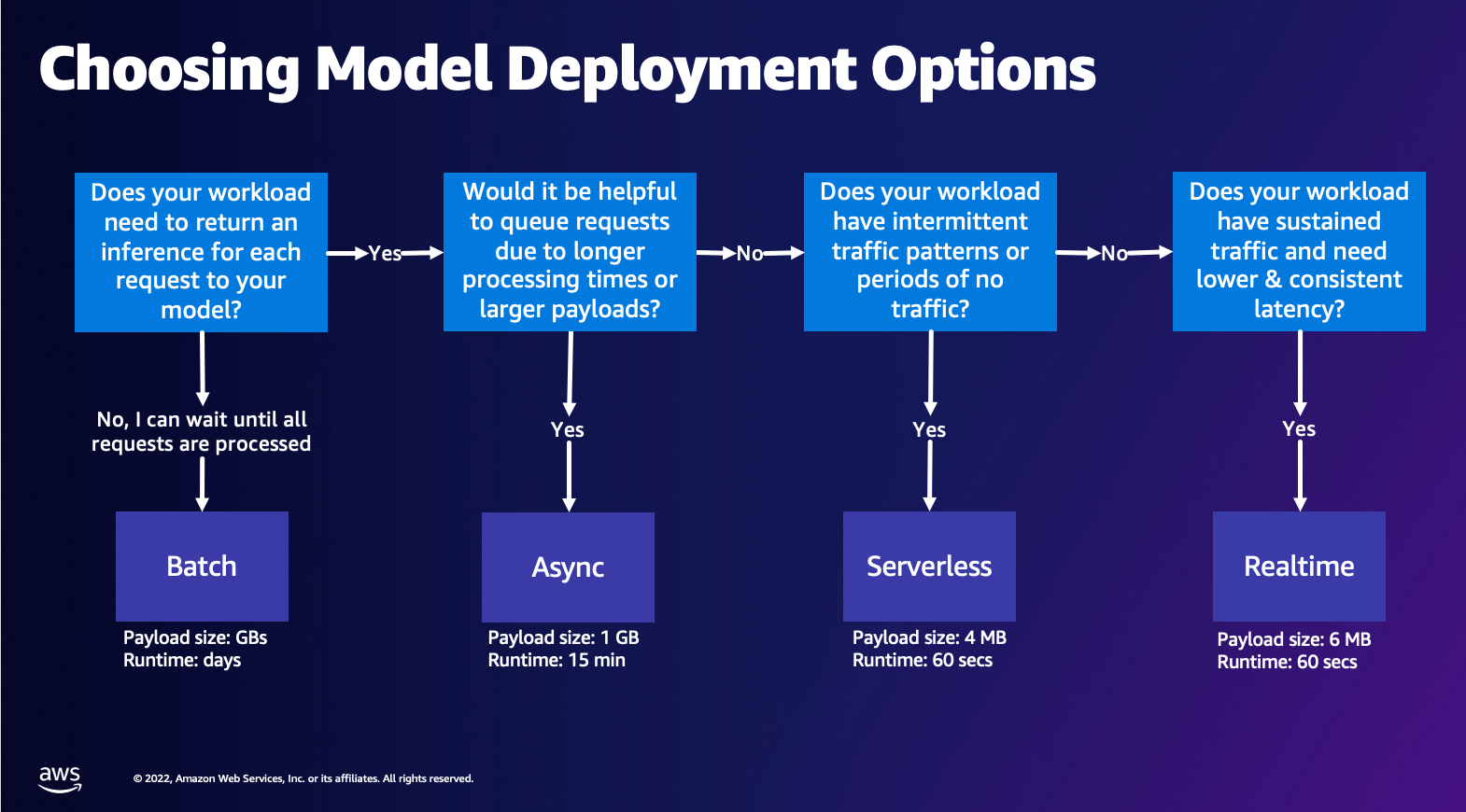

Mallin käyttöönottovaihtoehdon valitseminen

Oikean päättelytyypin valitseminen voi olla vaikeaa, ja seuraava yksinkertainen opas voi auttaa sinua. Se ei ole tiukka vuokaavio, joten jos huomaat toisen vaihtoehdon toimivan sinulle paremmin, voit käyttää niitä. Erityisesti Real-Time Inference on loistava vaihtoehto mallien isännöimiseen, kun sinulla on alhainen ja tasainen latenssi (millisekuntien tai sekuntien luokkaa) ja suorituskyvyn herkkä työkuorma. Voit hallita ilmentymän tyyppiä ja laskea päätepisteesi taakse samalla kun määrität AutoScaling liikenteen hoitamista koskeva politiikka. On myös kaksi muuta SageMaker Inference -vaihtoehtoa, joita voit käyttää myös päätepisteen luomiseen. Asynkroninen päättely on, kun sinulla on suuri hyötykuorma ja lähes reaaliaikainen latenssikaistanleveys. Tämä on hyvä vaihtoehto erityisesti NLP- ja Computer Vision -malleille, joilla on pidemmät esikäsittelyajat. Serverless Inference on loistava vaihtoehto, kun sinulla on ajoittaista liikennettä etkä halua hallita infrastruktuurin skaalausta. Resepti päätepisteen luomiseen pysyy samana riippumatta valitsemastasi päättelytyypistä. Tässä viestissä keskitymme reaaliaikaisen ilmentymäpohjaisen päätepisteen luomiseen, mutta voit helposti mukauttaa sen jompaankumpaan muuhun päättelyvaihtoehtoon käyttötapauksesi perusteella. Lopuksi Eräpäättely tapahtuu offline-tilassa, joten voit antaa joukon tietoja, joista haluat saada johtopäätöksen, ja me suoritamme sen. Tämä on samoin ilmentymäpohjainen, joten voit valita optimaalisen ilmentymän työkuormituksellesi. Koska päätepistettä ei ole käynnissä, maksat vain työn keston. Se sopii gigatavujen datan käsittelyyn ja työn kesto voi olla päiviä. Mukana on sisäänrakennettuja ominaisuuksia, jotka helpottavat jäsenneltyjen tietojen kanssa työskentelyä, ja optimoinnit strukturoidun tiedon automaattiseen jakeluun. Joitakin esimerkkejä käyttötapauksista ovat taipumusmallinnus, ennakoiva ylläpito ja vaihtuvuuden ennustaminen. Kaikki nämä voivat tapahtua offline-tilassa kerralla, koska sen ei tarvitse reagoida tiettyyn tapahtumaan.

Mallin ylläpito SageMaker-päätepisteissä

Pohjimmiltaan SageMakerin reaaliaikaiset päätepisteet koostuvat mallista ja infrastruktuurista, jonka avulla päätät tuettavaksi. SageMaker käyttää säilöjä mallien isännöimiseen, mikä tarkoittaa, että tarvitset säilön, joka määrittää oikein kullekin tarjoamallesi mallille käyttämäsi kehyksen ympäristön. Jos esimerkiksi työskentelet Sklearn-mallin kanssa, sinun on välitettävä mallin skriptit/tiedot säilössä, joka määrittää Sklearnin oikein. Onneksi SageMaker tarjoaa hallittuja kuvia suosituille kehyksille, kuten TensorFlow, PyTorch, Sklearn ja HuggingFace. Voit hakea ja käyttää näitä kuvia korkean tason avulla SageMaker Python SDK ja lisää malliskriptit ja tiedot näihin säilöihin. Jos SageMakerilla ei ole tuettua säilöä, voit myös Rakenna oma konttisi ja työnnä oma mukautettu kuvasi asentamalla mallillesi tarvittavat riippuvuudet.

SageMaker tukee sekä koulutettuja että esikoulutettuja malleja. Edellisessä kappaleessa, kun puhumme malliskripteistä/tiedoista, viittaamme tähän asiaan. Voit joko liittää skriptin säilöön tai jos sinulla on valmiiksi koulutettu malliartefaktti (esim.malli.joblib` SKLearnille), voit toimittaa sen kuvasi kanssa SageMakerille. Ymmärtääksesi SageMaker-päätelmän on kolme pääkokonaisuutta, jotka sinun tulee luoda päätepisteiden luontiprosessissa:

- SageMaker Model Entity – Täällä voit välittää koulutetut mallitietosi/malliskriptit ja kuvasi, jonka kanssa työskentelet riippumatta siitä, onko se AWS:n omistama vai itse rakentama.

- Päätepisteen kokoonpanon luominen – Tässä määrität infrastruktuurisi, mikä tarkoittaa, että valitset ilmentymän tyypin, määrän jne.

- Päätepisteen luominen – Tämä on REST-päätepiste, joka isännöi malliasi, jota kutsut saadaksesi vastauksen. Katsotaanpa, kuinka voit käyttää hallittua SageMaker-kuvaa ja omaa räätälöityä näköistiedostoa päätepisteen käyttöönottamiseksi.

Reaaliaikaiset päätepistevaatimukset

- Ennen kuin luot päätepisteen, sinun on ymmärrettävä, minkä tyyppistä mallia haluat isännöidä. Jos se on Framework-malli, kuten TensorFlow, PyTorch tai MXNet, voit käyttää jotakin valmiiksi rakennetut Framework-kuvat.

Jos se on mukautettu malli tai haluat täyden joustavuuden luotaessa säilöä, jota SageMaker käyttää päätelmien tekemiseen, voit rakentaa oman säilön.

SageMaker-päätepisteet koostuvat a SageMaker malli ja Päätepisteen määritys.

Jos käytät Boto3:a, luot molemmat objektit. Muussa tapauksessa, jos käytät SageMaker Python SDK:ta, päätepisteen määritys luodaan puolestasi, kun käytät .deploy(..) toiminto.

SageMaker-yksiköt:

- SageMaker malli:

- Sisältää päättelykuvan yksityiskohdat, mallin esineiden sijainnin Amazon Simple Storage Service (Amazon S3), verkkoasetukset ja AWS-identiteetin ja käyttöoikeuksien hallinta (IAM) Päätepisteen käytettävä rooli.

- SageMaker edellyttää, että mallin artefaktit pakataan a

.tar.gztiedosto. SageMaker purkaa tämän automaattisesti.tar.gztiedosto tiedostoon/opt/ml/model/hakemistoon säilössäsi. Jos käytät jotakin kehyssäilöistä, kuten TensorFlow, PyTorch tai MXNet, säilö odottaa TAR-rakenteen olevan seuraava:- TensorFlow

- PyTorch

- MX Net

- Sklearn

- TensorFlow

- Framework-kuvaa hyödyntäessämme voimme tarjota mukautetun aloituspisteen skriptin, jossa voimme toteuttaa oman esi- ja jälkikäsittelymme. Meidän tapauksessamme päättelykomentosarja on pakattu model.tar.gz-tiedostoon /code-hakemiston alle.

- SageMaker edellyttää, että mallin artefaktit pakataan a

- Sisältää päättelykuvan yksityiskohdat, mallin esineiden sijainnin Amazon Simple Storage Service (Amazon S3), verkkoasetukset ja AWS-identiteetin ja käyttöoikeuksien hallinta (IAM) Päätepisteen käytettävä rooli.

-

- Päätepisteen määritys

- Sisältää infrastruktuuritiedot, joita tarvitaan SageMaker-mallin käyttöönottoon päätepisteessä.

- Tässä määritetään esimerkiksi luomamme SageMaker-malli sekä ilmentymän tyyppi ja alkuinstanssien määrä.

Frameworks ja BYOC

-

- Haetaan SageMaker-kuvia

- Tämä osa ei aina ole välttämätön, ja SageMaker Python SDK poistaa sen arvioijien avulla. Jos kuitenkin haluat noutaa hallitun SageMaker-kuvan laajentaaksesi sitä, voit hankkia kuvat, jotka ovat saatavilla SDK:n kautta. Seuraavassa on esimerkki TF 2.2 -kuvan hakemisesta päätelmiä varten.

- kehykset

- Jos haluat ottaa käyttöön puitemallin, kuten TensorFlow, PyTorch tai MXNet, tarvitset vain mallin artefaktit.

- Katso dokumentaatiota mallien käyttöönotosta suoraan malliartefakteista TensorFlow, PyTorchtai MX Net.

- Haetaan SageMaker-kuvia

-

- Valinta 1P:n ja BYOC:n välillä

- SageMaker SDK tiivistää myös kuvan käsittelyn, kuten näit edellisessä Frameworks-osiossa. Siinä on valmiit estimaatit Sklearnille, TensorFlow'lle ja PyTorchille, jotka valitsevat automaattisesti kuvan puolestasi valitsemasi version perusteella. Sitten voit antaa koulutus-/päätelmäskriptin läpi Skriptitila näihin arvioijiin.

- SageMaker ei tue kaikkia paketteja ja kuvia, ja tässä tapauksessa sinun täytyy tuo oma kontti (BYOC). Tämä tarkoittaa Docker-tiedoston rakentamista, joka määrittää oikean ympäristön mallin palvelemiseen. Esimerkki tästä on Spacy NLP -moduuli, eikä tälle viitekehykselle ole hallittuja SageMaker-säilöjä. Siksi sinun on toimitettava Docker-tiedosto, joka asentaa Spacen. Säilön sisällä liität myös mallin päättelyskriptit. Keskustellaanpa nopeasti Bring Your Own Container -muodossa toimittamistasi komponenteista, sillä ne pysyvät yhtenäisinä useimmissa esimerkeissä.

- "nginx.conf" on nginx-käyttöliittymän määritystiedosto. Sinun ei tarvitse muokata tätä tiedostoa, ellet halua virittää näitä osia.

- "predictor.py" on ohjelma, joka todella toteuttaa Flask-verkkopalvelimen ja mallikoodin sovelluksellesi. Säilössäsi voi olla muita Python-tiedostoja tai toimintoja, joita voit kutsua tässä tiedostossa.

- "palvella" on ohjelma, joka käynnistetään, kun kontti käynnistetään isännöintiä varten. Se yksinkertaisesti käynnistää gunicorn-palvelimen, joka suorittaa useita Flask-sovelluksen esiintymiä, jotka on määritelty tiedostossa Predictor.py. Kuten nginx.conf, sinun ei tarvitse muokata tätä tiedostoa, ellet halua suorittaa lisäsäätöjä.

- "kouluttaa" on ohjelma, jota kutsutaan, kun säilöä ajetaan harjoittelua varten. Muokatat tätä ohjelmaa harjoitusalgoritmisi toteuttamiseksi. Jos tuot mukanasi valmiiksi koulutetun mallin tai kehyksen, kuten Spacyn, et tarvitse tätä tiedostoa.

- "wsgi.py" on pieni kääre, jota käytetään Flask-sovelluksen käynnistämiseen. Sinun pitäisi pystyä pitämään tämä tiedosto sellaisenaan, ellet ole muuttanut prediktor.py-tiedostosi nimeä. Varmista siinä tapauksessa, että kartat ovat oikein täällä.

- Valinta 1P:n ja BYOC:n välillä

-

- Mukautettu päättelykomentosarja

- SageMaker Framework -säilöt antavat sinulle joustavuuden käsitellä pyynnön esi-/jälkikäsittelyä ja mallin latausta mukautetun aloituspisteen komentosarjan/inference.py avulla.

- Katso dokumentaatio mukautetun inference.py-komentosarjan luomisesta TensorFlow, PyTorch ja MX Net.

- Mukautettu kontti

- Mukautettu päättelykomentosarja

Eri tapoja olla vuorovaikutuksessa SageMaker-päätepisteiden kanssa

On monia vaihtoehtoja käyttää SageMakeria ohjelmallisesti, jotta voit soittaa käyttöönotettuja malleja tehdäksesi päätelmiä. The AWS Command Line Interface (AWS CLI), REST-sovellusliittymät, AWS-pilven muodostuminen, AWS Cloud Development Kit (AWS CDK) ja AWS SDK:t ovat yleisiä työkaluja, joita AWS tarjoaa ja joita muut AWS-palvelut tukevat laajasti. SageMakerille meillä on myös SageMaker Python SDK. Verrataan nyt eri vaihtoehtoja SageMaker-päätepisteiden luomiseen, kutsumiseen ja hallintaan.

Lisäksi SageMaker CLI, voit olla ohjelmallisesti vuorovaikutuksessa SageMakerin päätepisteiden kanssa SDK:iden kautta kahdella tavalla. Katsotaanpa joitain eroja SageMaker Python SDK ja Boto3 Python SDK:

- Korkean tason SageMaker "Python" SDK – Tämä SDK on avoimen lähdekoodin kirjasto, joka tarjoaa korkeamman tason abstraktion, joka on erityisesti tarkoitettu SageMaker-sovellusliittymien kutsumiseen ohjelmallisesti Pythonin avulla. Tämän SDK:n hyvä puoli on, että on erittäin helppo kutsua sagemaker-sovellusliittymiä, paljon raskaita nostoja tehdään jo, kuten sovellusliittymien kutsuminen synkronisesti/asynkronisesti (auttaa välttämään kyselyn), yksinkertaisempi pyyntö/vastausskeema, paljon vähemmän koodia ja paljon muuta. yksinkertaisempi koodi. SageMaker Python SDK tarjoaa useita korkean tason abstraktioita SageMakerin kanssa työskentelyyn. Paketin tarkoituksena on yksinkertaistaa erilaisia ML-prosesseja SageMakerissa.

- Matalan tason AWS SDK (Boto3 SDK) – Tämä SDK toimii alemmalla tasolla sallimalla käyttäjän valita tuetuista ohjelmointikielistä ja kutsua mitä tahansa AWS-palvelua ohjelmallisesti. Tämä ei koske vain SageMakeria, vaan sitä voidaan käyttää yleisesti kaikissa AWS-palveluissa. Matalan tason AWS SDK:t ovat saatavilla useilla ohjelmointikielillä, kuten .NET, Python, Java, Node.js jne. Yksi suosituimmista käytetyistä SDK:ista on boto3 python SDK, joka on suosittu tietotutkijayhteisössä ML:ssä. Tämän SDK:n hyvä puoli on, että se on erittäin kevyt ja saatavana oletuksena asennettuna AWS Lambda Suoritusaika. Lisäksi voit käyttää tätä SDK:ta vuorovaikutukseen minkä tahansa SageMakerin ulkopuolisen AWS-palvelun kanssa.

Molempia SDK:ita voidaan käyttää samoihin tehtäviin, mutta joissain tapauksissa on intuitiivisempaa käyttää toista enemmän kuin toista. SageMaker Python SDK:ta suositellaan testauksen helpottamiseksi, kun taas AWS SDK/Boto3:a suositellaan tuotantokäyttöön suorituskyvyn parantamiseksi. Esimerkiksi SageMaker palveluna tarjoaa valmiiksi rakennettuja ja ylläpidettyjä kuvia suosittuihin kehyksiin, kuten Sklearn, PyTorch ja TensorFlow. Voi olla erityisen hyödyllistä käyttää SageMaker SDK:ta syväoppimiskuvien hakemiseen ja mallien kouluttamiseen estimaattorit, ja ota malli helposti käyttöön yksinkertaisella API-kutsulla. Esimerkki tämän esittelemisestä toiminnassa löytyy tätä.

Toisaalta sinulla on joskus valmiiksi koulutettuja malleja tai erilaisia kehyksiä, joita saatat käyttää. Tämä vaatii enemmän mukauttamista, eikä SageMaker SDK aina tarjoa sitä. Meillä on kolme tärkeää vaihetta ja vastaavat boto3 API -kutsut, jotka meidän on suoritettava ottaaksemme käyttöön päätepisteen: Mallin luominen, Päätepisteen määrityksen luominenja Päätepisteen luominen. Kaksi ensimmäistä entiteettiä otettiin pois SageMaker SDK:lla tuetuilla kehyksillä, mutta näemme nämä yksityiskohdat Boto3 SDK:lla. Löydät kattavan esimerkin Boto3 SDK:n käytön vaiheista päätepisteen luomiseen ja hallintaan. tätä.

SageMaker-isännöintiin liittyviä näkökohtia

SageMaker Real-Time Inference sisältää kaksi pääasiallista optimointia, joita voit harkita: 1/ Suorituskyvyn optimointi ja 2/ Kustannusoptimointi. Katsotaanpa ensin suorituskyvyn optimointi, kuten silloin, kun käsittelemme latenssiherkkiä työkuormia, jokainen millisekunti on ratkaiseva. On olemassa erilaisia nuppeja, joita voit virittää optimoidaksesi latenssisi ja suorituskyvysi. Instanssitasolla voit käyttää Päätelmäsuosittelija, sisäänrakennettu kuormitustestaustyökalumme, joka auttaa sinua valitsemaan oikean ilmentymän tyypin ja laskemaan työmäärääsi. Oikean laskennan yhdistelmän käyttäminen auttaa sinua sekä suorituskyvyssä että kustannuksissa. Voit myös virittää säilön ja kehyksen tasolla.

Kysymyksiä itseltäsi ovat mm.

- Mitä kehystä käytät?

- Onko olemassa ympäristömuuttujia, joita voit säätää säilössäsi?

Esimerkki tästä on maksimointi TensorFlow-suorituskyky SageMaker-säiliöillä. Toinen esimerkki säilötason optimoinnista on käyttämällä gRPC:tä sen sijaan, että LOPAA päätepisteesi takana. Lopuksi voit myös optimoida komentosarjatasolla. Viekö päättelykoodisi ylimääräistä aikaa tietyissä lohkoissa? Skriptin jokaisen rivin ajoitus auttaa sinua vangitsemaan koodisi pullonkaulat.

On kolme tapaa katsoa parantamalla käyttöä reaaliaikaisesta päätepisteestäsi:

- Monen mallin päätepisteet (MME)

- Voit isännöidä tuhansia malleja yhden päätepisteen takana. Tämä on täydellinen käyttötapauksiin, joissa et tarvitse erillistä päätepistettä jokaiselle mallillesi. MME toimii parhaiten, kun mallit ovat samankokoisia ja -viiveisiä ja kuuluvat samaan ML-kehykseen. Näitä voidaan yleensä käyttää, kun sinun ei tarvitse aina soittaa samaa mallia. Voit ladata vastaavan mallin dynaamisesti SageMaker Endpointiin palvelemaan pyyntöäsi. Esimerkki, joka esittelee MME:tä toiminnassa, löytyy tätä. Jos haluat oppia lisää eri varoituksista ja parhaista käytännöistä mallien isännöimiseksi MME:ssä, katso viesti tätä.

- Multi-Container Endpoints (MCE)

- Sen sijaan, että käyttäisit useita päätepisteitä useiden säilöjen isännöimiseen, voit tarkastella jopa 15 säilön isännöintiä yhdessä päätepisteessä. Jokainen näistä säilöistä voidaan kutsua suoraan. Siksi voit tarkastella erilaisten puitteiden erilaisten mallien isännöintiä yhdessä päätepisteessä. Tämä vaihtoehto on paras, kun säiliöillä on samanlaiset käyttö- ja suorituskykyominaisuudet. MCE:tä esittelevä esimerkki löytyy tätä. Jos haluat oppia lisää eri varoituksista ja parhaista käytännöistä mallien isännöimiseksi MCE:ssä, katso viesti tätä.

- SIP (Serial Inference Pipeline)

- Jos päättelylogiikassasi on vaiheiden putki, saatat käyttää SIP (Serial Inference Pipeline) -järjestelmää. SIP:n avulla voit ketjuttaa 2–15 konttia yhteen yhden päätepisteen taakse. SIP toimii hyvin, kun sinulla on esi- ja jälkikäsittelyvaiheita. Jos haluat lisätietoja sarjapäätelmäputkien suunnittelumalleista, katso viestiä tätä.

Toinen tärkein huomioitava optimointi on maksaa. Reaaliaikainen päättely on yksi kolmesta vaihtoehdosta SageMaker-päätepisteiden luomisessa. SageMaker-päätepisteet ovat käynnissä koko ajan, ellei niitä poisteta. Siksi sinun on tarkasteltava päätepisteen käytön parantamista, mikä puolestaan on kustannushyöty.

SageMaker tarjoaa myös Säästösuunnitelmat. Säästösuunnitelmat voivat vähentää kulujasi jopa 64 %. Tämä on 1 tai 3 vuoden sitoumus tasaiseen käyttömäärään ($/tunti). Katso tämä linkkiä Lisätietoja. Ja katso tämä linkkiä optimoidaksesi Inferencen kustannukset Amazon SageMakerissa.

Yhteenveto

Tässä viestissä näytimme sinulle parhaita käytäntöjä, joiden avulla voit valita SageMakerin eri mallien isännöintivaihtoehtojen välillä. Keskustelimme SageMaker Endpoint -vaatimuksista, ja myös vertailimme Framework- ja BYOC-vaatimuksia ja toimintoja. Lisäksi puhuimme erilaisista tavoista, joilla voit hyödyntää reaaliaikaisia päätepisteitä isännöidäksesi ML-mallejasi tuotannossa. kustannustehokkaalla tavalla ja niillä on korkea suorituskyky.

Katso vastaava GitHub-arkisto ja kokeile esimerkkejä.

Tietoja kirjoittajista

Raghu Ramesha on ML Solutions -arkkitehti Amazon SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

Raghu Ramesha on ML Solutions -arkkitehti Amazon SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

Ram Vegiraju on ML-arkkitehti SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan ja optimoimaan AI/ML-ratkaisujaan Amazon SageMakerissa. Vapaa-ajallaan hän rakastaa matkustamista ja kirjoittamista.

Ram Vegiraju on ML-arkkitehti SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan ja optimoimaan AI/ML-ratkaisujaan Amazon SageMakerissa. Vapaa-ajallaan hän rakastaa matkustamista ja kirjoittamista.

Marc Karp on ML-arkkitehti SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita suunnittelemaan, ottamaan käyttöön ja hallitsemaan ML-työkuormia mittakaavassa. Vapaa-ajallaan hän nauttii matkustamisesta ja uusien paikkojen tutkimisesta.

Marc Karp on ML-arkkitehti SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita suunnittelemaan, ottamaan käyttöön ja hallitsemaan ML-työkuormia mittakaavassa. Vapaa-ajallaan hän nauttii matkustamisesta ja uusien paikkojen tutkimisesta.

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvissä ongelmissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja tietokonenäköalueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä Amazon SageMakerissa.

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvissä ongelmissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja tietokonenäköalueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä Amazon SageMakerissa.

Saurabh Trikande on Amazon SageMaker Inferencen -tuotepäällikkö. Hän on intohimoinen asiakkaiden kanssa työskentelyyn, ja häntä motivoi tavoite demokratisoida koneoppimista. Hän keskittyy ydinhaasteisiin, jotka liittyvät monimutkaisten ML-sovellusten käyttöönottoon, usean vuokralaisen ML-malleihin, kustannusten optimointiin ja syvän oppimismallien käyttöönoton helpottamiseen. Vapaa-ajallaan Saurabh nauttii vaelluksesta, innovatiivisten teknologioiden oppimisesta, TechCrunchia seuraamisesta ja perheen kanssa viettämisestä.

Saurabh Trikande on Amazon SageMaker Inferencen -tuotepäällikkö. Hän on intohimoinen asiakkaiden kanssa työskentelyyn, ja häntä motivoi tavoite demokratisoida koneoppimista. Hän keskittyy ydinhaasteisiin, jotka liittyvät monimutkaisten ML-sovellusten käyttöönottoon, usean vuokralaisen ML-malleihin, kustannusten optimointiin ja syvän oppimismallien käyttöönoton helpottamiseen. Vapaa-ajallaan Saurabh nauttii vaelluksesta, innovatiivisten teknologioiden oppimisesta, TechCrunchia seuraamisesta ja perheen kanssa viettämisestä.

- Lisäasetukset (300)

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- Amazon Sage Maker

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- AWS-koneoppiminen

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- syvä oppiminen

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- zephyrnet