Generatiiviset tekoälymallit ovat kasvaneet nopeasti viime kuukausina, koska ne pystyvät luomaan realistista tekstiä, kuvia, koodia ja ääntä. Näistä malleista Stable Diffusion -mallit erottuvat ainutlaatuisesta vahvuudestaan korkealaatuisten kuvien luomisessa tekstikehotteiden perusteella. Vakaa diffuusio voi tuottaa laajan valikoiman korkealaatuisia kuvia, mukaan lukien realistisia muotokuvia, maisemia ja jopa abstraktia taidetta. Ja kuten muutkin generatiiviset tekoälymallit, Stable Diffusion -mallit vaativat tehokkaan tietojenkäsittelyn alhaisen latenssin päättelyn tekemiseksi.

Tässä viestissä näytämme, kuinka voit käyttää Stable Diffusion -malleja ja saavuttaa korkean suorituskyvyn alhaisin kustannuksin Amazonin elastinen laskentapilvi (Amazon EC2) käyttäen Amazon EC2 Inf2 -tapaukset virtansa AWS Inferentia2. Tarkastelemme vakaan diffuusiomallin arkkitehtuuria ja käymme läpi vaiheet vakaan diffuusiomallin laatimiseksi käyttämällä AWS Neuron ja ottaa sen käyttöön Inf2-instanssiin. Keskustelemme myös optimoinneista, joita Neuron SDK tekee automaattisesti suorituskyvyn parantamiseksi. Voit käyttää sekä Stable Diffusion 2.1- että 1.5 -versioita AWS Inferentia2:ssa kustannustehokkaasti. Lopuksi näytämme, kuinka voit ottaa käyttöön Stable Diffusion -mallin Inf2-instanssiin Amazon Sage Maker.

Stable Diffusion 2.1 -mallin koko liukulukussa 32 (FP32) on 5 Gt ja 2.5 Gt bfoat16:ssa (BF16). Yhdellä inf2.xlarge-instanssilla on yksi AWS Inferentia2 -kiihdytin, jossa on 32 Gt HBM-muistia. Stable Diffusion 2.1 -malli mahtuu yhteen inf2.xlarge-instanssiin. Stable Diffusion on tekstistä kuvaksi -malli, jonka avulla voit luoda erilaisia tyylejä ja sisältöjä sisältäviä kuvia yksinkertaisesti antamalla syötteenä tekstikehotteen. Lisätietoja Stable Diffusion -mallin arkkitehtuurista on kohdassa Luo korkealaatuisia kuvia Stable Diffusion -malleilla ja ota ne käyttöön kustannustehokkaasti Amazon SageMakerin avulla.

Kuinka Neuron SDK optimoi vakaan diffuusion suorituskyvyn

Ennen kuin voimme ottaa käyttöön Stable Diffusion 2.1 -mallin AWS Inferentia2 -esiintymissä, meidän on käännettävä mallin komponentit käyttämällä Neuron SDK. Neuron SDK, joka sisältää syväoppimiskääntäjän, suoritusajan ja työkalut, kokoaa ja optimoi automaattisesti syväoppimismalleja, jotta ne voivat toimia tehokkaasti Inf2-esiintymissä ja poimia täyden suorituskyvyn AWS Inferentia2 -kiihdyttimestä. Meillä on esimerkkejä saatavilla Stable Diffusion 2.1 -mallista GitHub repo. Tämä muistikirja tarjoaa kattavan esimerkin vakaan diffuusiomallin kokoamisesta, käännetyn Neuron-mallin tallentamisesta ja sen lataamisesta suoritusaikaan päätelmiä varten.

Käytämme StableDiffusionPipeline Hugging Facesta diffusers kirjasto mallin lataamista ja kääntämistä varten. Sitten kokoamme kaikki mallin komponentit Neuronille käyttämällä torch_neuronx.trace() ja tallenna optimoitu malli TorchScript-muodossa. Käännösprosessit voivat olla melko muistiintensiivisiä ja vaativat huomattavan määrän RAM-muistia. Tämän kiertämiseksi luomme ennen kunkin mallin jäljittämistä a deepcopy putkilinjan jäljitettävästä osasta. Tämän jälkeen poistamme liukuhihnaobjektin muistista käyttämällä del pipe. Tämä tekniikka on erityisen hyödyllinen käännettäessä instansseja, joissa on vähän RAM-muistia.

Lisäksi teemme optimointeja Stable Diffusion -malleille. UNet sisältää päättelyn laskennallisesti intensiivisimmän osan. UNet-komponentti toimii tulotensoreilla, joiden eräkoko on kaksi, ja se tuottaa vastaavan lähtötensorin myös kahden eräkoon kanssa yhden kuvan tuottamiseksi. Näiden erien elementit ovat täysin riippumattomia toisistaan. Voimme hyödyntää tätä käyttäytymistä saadaksemme optimaalisen latenssin suorittamalla yhden erän jokaisessa Neuron-ytimessä. Kokoamme UNetin yhdelle erälle (käyttäen syöttötensoreja yhdellä erällä), käytä sitten torch_neuronx.DataParallel API lataamaan tämän yksittäisen erämallin jokaiseen ytimeen. Tämän API:n tulos on saumaton kahden erän moduuli: voimme välittää UNetille kahden erän syötteet, ja kahden erän lähtö palautetaan, mutta sisäisesti kaksi yhden erän mallia toimivat kahdella Neuron-ytimellä. . Tämä strategia optimoi resurssien käytön ja vähentää latenssia.

Kääntää ja ottaa käyttöön Stable Diffusion -malli Inf2 EC2 -esiintymässä

Jos haluat kääntää ja ottaa käyttöön Stable Diffusion -mallin Inf2 EC2 -esiintymässä, kirjaudu sisään AWS-hallintakonsoli ja luo inf2.8xlarge-instanssi. Huomaa, että inf2.8xlarge-instanssi tarvitaan vain mallin kääntämiseen, koska käännös vaatii suurempaa isäntämuistia. Stable Diffusion -mallia voidaan isännöidä inf2.xlarge-esiintymässä. Löydät uusimman AMI:n Neuron-kirjastoilla käyttämällä seuraavaa AWS-komentoriviliitäntä (AWS CLI) -komento:

Tätä esimerkkiä varten loimme EC2-esiintymän käyttämällä Deep Learning AMI Neuron PyTorch 1.13:a (Ubuntu 20.04). Voit sitten luoda JupyterLab-laboratorioympäristön muodostamalla yhteyden ilmentymään ja suorittamalla seuraavat vaiheet:

Muistikirja, jossa on kaikki mallin kokoamisen ja isännöinnin vaiheet, sijaitsee GitHub.

Katsotaanpa yhden tekstienkooderilohkon käännösvaiheita. Muut lohkot, jotka ovat osa Stable Diffusion -putkilinjaa, voidaan koota samalla tavalla.

Ensimmäinen askel on ladata esikoulutettu malli Hugging Facesta. The StableDiffusionPipeline.from_pretrained menetelmä lataa esiopetetun mallin putkiobjektiin, pipe. Luomme sitten a deepcopy tekstienkooderista putkistamme, kloonaamalla sen tehokkaasti. The del pipe komentoa käytetään sitten poistamaan alkuperäinen liukuhihnaobjekti vapauttaen sen käyttämää muistia. Tässä kvantisoimme mallin BF16-painoihin:

Tämä vaihe sisältää tekstienkooderimme käärimisen NeuronTextEncoder kääre. Käännetty tekstienkooderimoduulin tulos on dict. Muunnamme sen a list kirjoita tällä kääreellä:

Alustamme PyTorch-tensorin emb joillain arvoilla. The emb tensoria käytetään esimerkkisyötteenä torch_neuronx.trace toiminto. Tämä toiminto jäljittää tekstienkooderimme ja kokoaa sen Neuronille optimoituun muotoon. Käännetyn mallin hakemistopolku muodostetaan yhdistämällä COMPILER_WORKDIR_ROOT alihakemiston kanssa text_encoder:

Käytetty tekstienkooderi tallennetaan käyttämällä torch.jit.save. Se on tallennettu tiedostonimellä model.pt tiedostoon text_encoder kääntäjämme työtilan hakemisto:

- muistikirja sisältää samanlaiset vaiheet mallin muiden komponenttien kääntämiseksi: UNet, VAE-dekooderi ja VAE post_quant_conv. Kun olet koonnut kaikki mallit, voit ladata ja suorittaa mallin seuraavasti:

- Määritä polut käännetyille malleille.

- Lataa esikoulutettu

StableDiffusionPipelinemalli, jonka kokoonpano on määritetty käyttämään bfloat16-tietotyyppiä. - Lataa UNet-malli kahteen Neuron-ytimeen käyttämällä

torch_neuronx.DataParallelAPI. Tämä mahdollistaa tietojen rinnakkaisen päättelyn suorittamisen, mikä voi merkittävästi nopeuttaa mallin suorituskykyä. - Lataa mallin loput osat (

text_encoder,decoderjapost_quant_conv) yhdelle neuroniytimelle.

Voit sitten suorittaa liukuhihnan antamalla syöttötekstiä kehotteina. Seuraavassa on joitain kuvia, jotka malli on luonut kehotteita varten:

- Renaud sechanin muotokuva, kynä ja muste, monimutkaisia viivapiirroksia, kirjoittanut Craig mullins, ruan jia, kentaro miura, greg rutkowski, loundraw

- Muotokuva vanhasta hiilikaivostyöntekijästä 19-luvulla, kaunis maalaus, erittäin yksityiskohtainen greg rutkowskin kasvomaalaus

- Linna metsän keskellä

Host Stable Diffusion 2.1 AWS Inferentia2:ssa ja SageMakerissa

Stable Diffusion -mallien isännöinti SageMakerilla edellyttää myös kääntämistä Neuron SDK:lla. Voit viimeistellä kokoamisen etukäteen tai ajon aikana käyttämällä Large Model Inference (LMI) -säiliöitä. Kääntäminen etukäteen mahdollistaa nopeammat mallin latausajat ja on suositeltava vaihtoehto.

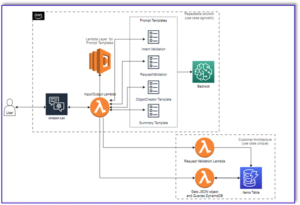

SageMaker LMI -säilöt tarjoavat kaksi tapaa ottaa malli käyttöön:

- Ei-koodivaihtoehto, jossa tarjoamme vain a

serving.propertiestiedosto vaadituilla kokoonpanoilla - Ota mukaan oma päätelmäkäsikirjoitus

Tarkastelemme molempia ratkaisuja ja käymme läpi kokoonpanot ja päättelykomentosarjan (model.py). Tässä viestissä esittelemme käyttöönoton käyttämällä valmiiksi käännettyä mallia, joka on tallennettu an Amazonin yksinkertainen tallennuspalvelu (Amazon S3) ämpäri. Voit käyttää tätä valmiiksi laadittua mallia käyttöönotoksissasi.

Määritä malli toimitetulla komentosarjalla

Tässä osiossa näytämme, kuinka LMI-säilö määritetään isännöimään Stable Diffusion -malleja. SD2.1-kannettava saatavilla osoitteessa GitHub. Ensimmäinen vaihe on luoda mallikonfiguraatiopaketti seuraavan hakemistorakenteen mukaisesti. Tavoitteemme on käyttää mallin isännöimiseen tarvittavia vähimmäismäärityksiä. Tarvittava hakemistorakenne on seuraava:

Seuraavaksi luomme palvelevat.ominaisuudet tiedosto seuraavilla parametreilla:

Parametrit määrittelevät seuraavat:

- option.model_id – LMI-kontit käyttävät s5cmd-komentoa mallin lataamiseen S3-paikasta, ja siksi meidän on määritettävä sijainti, jossa koostetut painomme ovat.

- option.entryPoint – Sisäänrakennettujen ohjaimien käyttöä varten määritämme transformers-neuronx-luokan. Jos sinulla on mukautettu päättelykomentosarja, sinun on annettava se sen sijaan.

- option.dtype – Tämä määrittää painojen lataamisen tietyssä koossa. Tässä viestissä käytämme BF16:ta, mikä vähentää edelleen muistivaatimuksiamme verrattuna FP32:een ja alentaa latenssiamme tästä johtuen.

- option.tensor_parallel_degree – Tämä parametri määrittää tässä mallissa käyttämiemme kiihdyttimien määrän. AWS Inferentia2 -sirukiihdyttimessä on kaksi Neuron-ydintä, joten arvon 2 määrittäminen tarkoittaa, että käytämme yhtä kiihdytintä (kaksi ydintä). Tämä tarkoittaa, että voimme nyt luoda useita työntekijöitä lisätäksemme päätepisteen suorituskykyä.

- vaihtoehto.moottori - Tämä on asetettu Pythonille osoittamaan, että emme käytä muita kääntäjiä, kuten DeepSpeediä tai Faster Transformeria, tähän isännöintiin.

Tuo oma käsikirjoitus

Jos haluat tuoda oman mukautetun johtopäätösskriptin, sinun on poistettava option.entryPoint alkaen serving.properties. Tässä tapauksessa LMI-säiliö etsii a model.py tiedosto samassa paikassa kuin serving.properties ja käytä sitä päättelyn suorittamiseen.

Luo oma päättelyskripti (model.py)

Oman johtopäätösskriptin luominen on suhteellisen yksinkertaista LMI-säilön avulla. Säiliö vaatii sinun model.py tiedostossa on seuraavan menetelmän toteutus:

Tarkastellaanpa joitain kriittisiä alueita liitteenä muistikirja, joka osoittaa oman skriptitoiminnon tuomisen.

Vaihda cross_attention moduuli optimoidulla versiolla:

Nämä ovat käännetyn painotustiedoston nimet, joita käytimme käännöksiä luodessasi. Voit vapaasti muuttaa tiedostonimiä, mutta varmista, että painotiedostojen nimet vastaavat tässä määrittämiäsi.

Sitten meidän on ladattava ne Neuron SDK:lla ja asetettava ne todellisiin mallipainoihin. Kun lataat UNet-optimoituja painoja, huomaa, että määritämme myös niiden Neuron-ytimien määrän, joille ne on ladattava. Tässä lataamme yhteen kiihdytin, jossa on kaksi ydintä:

Päätelmän suorittaminen kehotteen avulla kutsuu pipe-objektin luomaan kuvan.

Luo SageMaker-päätepiste

Käytämme Boto3-sovellusliittymiä SageMaker-päätepisteen luomiseen. Suorita seuraavat vaiheet:

- Luo tarball vain tarjoilulla ja valinnaisella

model.pytiedostot ja lähetä se Amazon S3:een. - Luo malli käyttämällä kuvasäilöä ja aiemmin ladattua mallin tarballia.

- Luo päätepisteen konfiguraatio seuraavilla avainparametreilla:

- Käytä

ml.inf2.xlargeilmentymä. - Asettaa

ContainerStartupHealthCheckTimeoutInSecondsarvoon 240 varmistaaksesi, että kuntotarkastus alkaa mallin käyttöönoton jälkeen. - Asettaa

VolumeInGBsuurempaan arvoon, jotta sitä voidaan käyttää 32 Gt:n kokoisten mallipainojen lataamiseen.

- Käytä

Luo SageMaker-malli

Kun olet luonut model.tar.gz-tiedoston ja ladannut sen Amazon S3:een, meidän on luotava SageMaker-malli. Käytämme LMI-säilöä ja edellisen vaiheen artefaktia SageMaker-mallin luomiseen. SageMakerin avulla voimme mukauttaa ja lisätä erilaisia ympäristömuuttujia. Tässä työnkulussa voimme jättää kaiken oletusarvoksi. Katso seuraava koodi:

Luo malliobjekti, joka luo käytännössä lukitussäiliön, joka ladataan ilmentymään ja jota käytetään päättelyyn:

Luo SageMaker-päätepiste

Tässä esittelyssä käytämme ml.inf2.xlarge-instanssia. Meidän on asetettava VolumeSizeInGB parametrit, jotka tarjoavat tarvittavan levytilan mallin ja painojen lataamiseen. Tämä parametri soveltuu tapauksiin, jotka tukevat Amazonin elastisten lohkojen myymälä (Amazon EBS) volyymikiinnitys. Voimme jättää mallin latauksen aikakatkaisun ja kontin käynnistyksen kuntotarkastuksen korkeampaan arvoon, jolloin kontti saa riittävästi aikaa vetää painot Amazon S3:sta ja latautua AWS Inferentia2 -kiihdyttimiin. Katso lisätietoja osoitteesta LuoEndpointConfig.

Lopuksi luomme SageMaker-päätepisteen:

Kutsu mallin päätepiste

Tämä on generatiivinen malli, joten välitämme kehotteen, jota malli käyttää kuvan luomiseen. Hyötykuorma on tyyppiä JSON:

Stable Diffusion -mallin vertailu Inf2:ssa

Suoritimme muutamia testejä Stable Diffusion -mallin vertaamiseksi BF 16 -tietotyypille Inf2:ssa, ja pystymme johtamaan latenssilukuja, jotka kilpailevat tai ylittävät joitain muita vakaan diffuusion kiihdyttimiä. Tämä yhdessä AWS Inferentia2 -sirujen alhaisempien kustannusten kanssa tekee tästä erittäin arvokkaan ehdotuksen.

Seuraavat numerot ovat Stable Diffusion -mallista, joka on otettu käyttöön inf2.xl-esiintymässä. Lisätietoja kuluista on osoitteessa Amazon EC2 Inf2 -tapahtumat.

| Malli | päätöslauselma | Tietotyyppi | Toistot | P95-viive (ms) | Inf2.xl On-Demand -hinta per tunti | Inf2.xl (Kuvan hinta) |

| Vakaa diffuusio 1.5 | 512 × 512 | bf16 | 50 | 2,427.4 | $0.76 | $0.0005125 |

| Vakaa diffuusio 1.5 | 768 × 768 | bf16 | 50 | 8,235.9 | $0.76 | $0.0017387 |

| Vakaa diffuusio 1.5 | 512 × 512 | bf16 | 30 | 1,456.5 | $0.76 | $0.0003075 |

| Vakaa diffuusio 1.5 | 768 × 768 | bf16 | 30 | 4,941.6 | $0.76 | $0.0010432 |

| Vakaa diffuusio 2.1 | 512 × 512 | bf16 | 50 | 1,976.9 | $0.76 | $0.0004174 |

| Vakaa diffuusio 2.1 | 768 × 768 | bf16 | 50 | 6,836.3 | $0.76 | $0.0014432 |

| Vakaa diffuusio 2.1 | 512 × 512 | bf16 | 30 | 1,186.2 | $0.76 | $0.0002504 |

| Vakaa diffuusio 2.1 | 768 × 768 | bf16 | 30 | 4,101.8 | $0.76 | $0.0008659 |

Yhteenveto

Tässä viestissä perehdymme syvälle Stable Diffusion 2.1 -mallin kokoamiseen, optimointiin ja käyttöönottoon Inf2-instanssien avulla. Esitimme myös Stable Diffusion -mallien käyttöönoton SageMakerin avulla. Inf2-instanssit tarjoavat myös erinomaisen hinta-suorituskyvyn Stable Diffusion 1.5:lle. Saat lisätietoja siitä, miksi Inf2-instanssit ovat hyviä generatiivisille tekoälymalleille ja suurille kielimalleille, katso Amazon EC2 Inf2 -instanssit edullisia ja tehokkaita generatiivisia tekoälypäätelmiä varten ovat nyt yleisesti saatavilla. Katso suoritustiedot kohdasta Inf2-suorituskyky. Katso lisää esimerkkejä aiheesta GitHub repo.

Erityiset kiitokset Matthew McClainille, Beni Hegedukselle, Kamran Khanille, Shruti Koparkarille ja Qing Lanille arvokkaiden palautteiden arvioinnista ja antamisesta.

Tietoja Tekijät

Vivek Gangasani on vanhempi koneoppimisratkaisuarkkitehti Amazon Web Servicesissä. Hän työskentelee koneoppimisyritysten kanssa rakentaakseen ja ottaakseen käyttöön AI/ML-sovelluksia AWS:ssä. Hän keskittyy tällä hetkellä ratkaisujen toimittamiseen MLOps-, ML-päätelmä- ja matalakoodi-ML-ratkaisuihin. Hän on työskennellyt projekteissa eri aloilla, mukaan lukien luonnollisen kielen käsittely ja tietokonenäkö.

Vivek Gangasani on vanhempi koneoppimisratkaisuarkkitehti Amazon Web Servicesissä. Hän työskentelee koneoppimisyritysten kanssa rakentaakseen ja ottaakseen käyttöön AI/ML-sovelluksia AWS:ssä. Hän keskittyy tällä hetkellä ratkaisujen toimittamiseen MLOps-, ML-päätelmä- ja matalakoodi-ML-ratkaisuihin. Hän on työskennellyt projekteissa eri aloilla, mukaan lukien luonnollisen kielen käsittely ja tietokonenäkö.

KC Tung on vanhempi ratkaisuarkkitehti AWS Annapurna Labsissa. Hän on erikoistunut laajaan syväoppimismallien koulutukseen ja mittakaavaan pilvessä. Hän on Ph.D. molekyylibiofysiikassa Texasin yliopiston Southwestern Medical Centeristä Dallasissa. Hän on puhunut AWS Summitsissa ja AWS Reinventissä. Nykyään hän auttaa asiakkaita kouluttamaan ja ottamaan käyttöön suuria PyTorch- ja TensorFlow-malleja AWS-pilvessä. Hän on kirjoittanut kaksi kirjaa: Opi TensorFlow Enterprise ja TensorFlow 2 Pocket Reference.

KC Tung on vanhempi ratkaisuarkkitehti AWS Annapurna Labsissa. Hän on erikoistunut laajaan syväoppimismallien koulutukseen ja mittakaavaan pilvessä. Hän on Ph.D. molekyylibiofysiikassa Texasin yliopiston Southwestern Medical Centeristä Dallasissa. Hän on puhunut AWS Summitsissa ja AWS Reinventissä. Nykyään hän auttaa asiakkaita kouluttamaan ja ottamaan käyttöön suuria PyTorch- ja TensorFlow-malleja AWS-pilvessä. Hän on kirjoittanut kaksi kirjaa: Opi TensorFlow Enterprise ja TensorFlow 2 Pocket Reference.

Rupinder Grewal on AWS:n Sr Ai/ML Specialist Solutions -arkkitehti. Tällä hetkellä hän keskittyy mallien ja MLO:iden tarjoamiseen SageMakerissa. Ennen tätä roolia hän on työskennellyt koneoppimisinsinöörinä mallien rakentamisessa ja isännöinnissa. Työn ulkopuolella hän pelaa tennistä ja pyöräilee vuoristopoluilla.

Rupinder Grewal on AWS:n Sr Ai/ML Specialist Solutions -arkkitehti. Tällä hetkellä hän keskittyy mallien ja MLO:iden tarjoamiseen SageMakerissa. Ennen tätä roolia hän on työskennellyt koneoppimisinsinöörinä mallien rakentamisessa ja isännöinnissa. Työn ulkopuolella hän pelaa tennistä ja pyöräilee vuoristopoluilla.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/maximize-stable-diffusion-performance-and-lower-inference-costs-with-aws-inferentia2/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 32

- 7

- 8

- 9

- a

- pystyy

- Meistä

- TIIVISTELMÄ

- kiihdytin

- kiihdyttimiä

- Saavuttaa

- todellinen

- lisä-

- Etu

- Jälkeen

- eteenpäin

- AI

- AI / ML

- tavoitteena

- Kaikki

- mahdollistaa

- Myös

- Amazon

- Amazon EC2

- Amazon Web Services

- keskuudessa

- määrä

- an

- ja

- api

- API

- sovelletaan

- sovellukset

- arkkitehtuuri

- OVAT

- alueet

- Art

- AS

- ulkomuoto

- At

- audio-

- kirjoittaja

- automaattisesti

- saatavissa

- AWS

- perustua

- BE

- kaunis

- koska

- ollut

- ennen

- käyttäytyminen

- ovat

- benchmark

- Paremmin

- Biofysiikka

- Tukkia

- Blocks

- Kirjat

- sekä

- tuoda

- rakentaa

- Rakentaminen

- sisäänrakennettu

- mutta

- by

- CAN

- kyvyt

- tapaus

- keskus

- Century

- muuttaa

- tarkastaa

- siru

- sirut

- luokka

- pilvi

- Kivihiili

- koodi

- täydellinen

- komponentti

- osat

- Laskea

- tietokone

- Tietokoneen visio

- tietojenkäsittely

- Konfigurointi

- Kytkeminen

- kulutetaan

- Kontti

- Kontit

- pitoisuus

- muuntaa

- Ydin

- vastaava

- Hinta

- kustannukset

- kytketty

- Craig

- luoda

- luotu

- luo

- Luominen

- kriittinen

- Tällä hetkellä

- asiakassuhde

- Asiakkaat

- räätälöidä

- Dallas

- tiedot

- syvä

- syvä oppiminen

- oletusarvo

- toimittaa

- tuottaa

- esittely

- osoittaa

- osoittivat

- osoittaa

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- käyttöönotot

- yksityiskohtainen

- yksityiskohdat

- eri

- Diffuusio

- pohtia

- verkkotunnuksia

- kyyhky

- download

- Piirustukset

- kaksi

- aikana

- kukin

- Aikaisemmin

- tehokkaasti

- tehokkaasti

- elementtejä

- päittäin

- päätepiste

- insinööri

- varmistaa

- täysin

- ympäristö

- olennaisesti

- Jopa

- kaikki

- tutkia

- esimerkki

- Esimerkit

- ylittää

- kokevat

- uute

- erittäin

- Kasvot

- nopeampi

- tuntea

- harvat

- filee

- Asiakirjat

- Löytää

- Etunimi

- sovittaa

- kelluva

- keskityttiin

- keskittyy

- jälkeen

- seuraa

- varten

- muoto

- Ilmainen

- alkaen

- koko

- toiminto

- edelleen

- yleensä

- tuottaa

- syntyy

- tuottaa

- generatiivinen

- Generatiivinen AI

- saada

- Antaa

- Go

- suuri

- Kasvu

- Olla

- he

- terveys

- auttaa

- tätä

- Korkea

- korkea suorituskyky

- korkealaatuisia

- korkeampi

- erittäin

- pitää

- isäntä

- isännöi

- hotellit

- Miten

- Miten

- HTML

- http

- HTTPS

- IDX

- if

- kuva

- kuvien

- täytäntöönpano

- vaikuttava

- parantaa

- in

- sisältää

- Mukaan lukien

- Kasvaa

- itsenäinen

- osoittaa

- tiedot

- pistää

- panos

- tuloa

- asentaa

- esimerkki

- sen sijaan

- sisäisesti

- tulee

- vedotaan

- IT

- SEN

- JIT

- tuloaan

- jpg

- json

- vain

- avain

- laboratorio

- Labs

- Landschaft

- Kieli

- suuri

- suurempi

- Viive

- uusin

- OPPIA

- oppiminen

- jättää

- kirjastot

- Kirjasto

- pitää

- linja

- linux

- kuormitus

- lastaus

- kuormat

- sijaitsevat

- sijainti

- Lockdown

- hakkuu

- katso

- Matala

- edullisia

- alentaa

- alin

- kone

- koneoppiminen

- tehdä

- TEE

- johto

- ottelu

- Matteus

- Maksimoida

- välineet

- lääketieteellinen

- Muisti

- menetelmä

- Keskimmäinen

- kaivosmies

- minimi

- ML

- MLOps

- malli

- mallit

- Moduulit

- molekyyli-

- kk

- lisää

- eniten

- Vuori

- MS

- moninkertainen

- nimi

- nimet

- Luonnollinen

- Luonnollinen kielen käsittely

- välttämätön

- Tarve

- tarvitaan

- muistikirja

- nyt

- numero

- numerot

- Nvidia

- objekti

- of

- Vanha

- on

- Tarpeen vaatiessa

- ONE

- vain

- päälle

- toimii

- optimaalinen

- optimointi

- optimoitu

- Optimismi

- Vaihtoehto

- or

- alkuperäinen

- OS

- Muut

- meidän

- ulos

- ulostulo

- ulkopuolella

- yli

- oma

- paketti

- maalaus

- Parallel

- parametri

- parametrit

- osa

- erityisesti

- osat

- kulkea

- polku

- varten

- Suorittaa

- suorituskyky

- suoritettu

- kuvat

- putki

- putki

- Platon

- Platonin tietotieto

- PlatonData

- pelaa

- Kohta

- muotokuvia

- Kirje

- powered

- voimakas

- Suositut

- lahjat

- edellinen

- hinta

- Aikaisempi

- Prosessit

- käsittely

- tuottaa

- hankkeet

- ominaisuudet

- ehdotus

- toimittaa

- mikäli

- tarjoamalla

- Python

- pytorch

- RAM

- nopea

- realistinen

- äskettäinen

- vähentää

- suhteellisesti

- jäljellä oleva

- poistaa

- korvata

- edellyttää

- tarvitaan

- vaatimukset

- Vaatii

- resurssi

- Tuotto

- tarkistetaan

- Kilpailija

- Rooli

- ajaa

- juoksu

- sagemaker

- sama

- Säästä

- Asteikko

- sdk

- saumaton

- Osa

- nähdä

- vanhempi

- Palvelut

- palvelevat

- setti

- näyttää

- merkki

- merkittävä

- merkittävästi

- samankaltainen

- samalla lailla

- Yksinkertainen

- yksinkertaisesti

- single

- Koko

- So

- ratkaisu

- Ratkaisumme

- jonkin verran

- lähde

- Tila

- asiantuntija

- erikoistunut

- erityinen

- määritelty

- nopeus

- puhuttu

- vakaa

- seistä

- alkaa

- käynnistyksen

- Startups

- Vaihe

- Askeleet

- Levytila

- tallennettu

- suora

- Strategia

- vahvuus

- rakenne

- Huippukokouksissa

- Tukea

- varma

- ottaa

- tensorflow

- testit

- texas

- Kiitos

- että

- -

- heidän

- Niitä

- sitten

- siksi

- Nämä

- ne

- tätä

- Kautta

- suoritusteho

- aika

- kertaa

- että

- tänään

- työkalut

- taskulamppu

- jäljitys

- Juna

- koulutus

- muuntaja

- kaksi

- tyyppi

- Ubuntu

- varten

- unique

- yliopisto

- ladattu

- us

- käyttää

- käytetty

- käyttötarkoituksiin

- käyttämällä

- arvokas

- arvo

- arvot

- lajike

- eri

- versio

- versiot

- visio

- tilavuus

- vs

- haluta

- oli

- tavalla

- we

- verkko

- verkkopalvelut

- Mitä

- kun

- joka

- miksi

- leveä

- tulee

- with

- sisällä

- Referenssit

- työskenteli

- työntekijöitä

- työnkulku

- toimii

- Voit

- Sinun

- zephyrnet