esittely

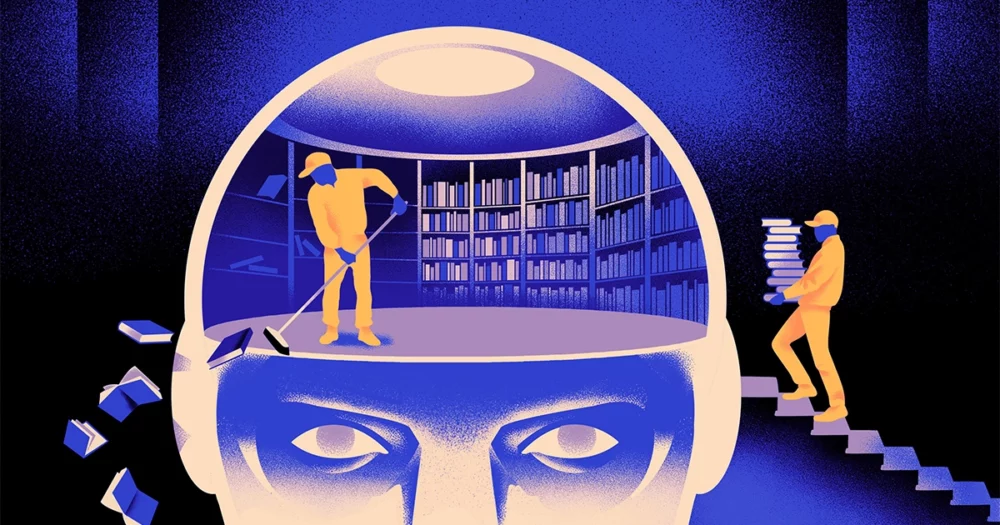

Tietojenkäsittelytieteilijöiden ryhmä on luonut a ketterämpi, joustavampi tyyppi koneoppimismallista. Temppu: Sen täytyy ajoittain unohtaa, mitä se tietää. Ja vaikka tämä uusi lähestymistapa ei syrjäytä suurimpien sovellusten taustalla olevia valtavia malleja, se voi paljastaa enemmän siitä, kuinka nämä ohjelmat ymmärtävät kieltä.

Uusi tutkimus merkitsee "merkittävää edistystä alalla", sanoi Jea Kwon, tekoälyinsinööri Etelä-Korean perustieteen instituutissa.

Nykyään käytössä olevat tekoälyn kielimoottorit saavat enimmäkseen virtansa keinotekoiset hermoverkot. Jokainen "neuroni" verkossa on matemaattinen funktio, joka vastaanottaa signaaleja muilta tällaisilta neuroneilta, suorittaa joitain laskelmia ja lähettää signaaleja useiden neuronikerrosten läpi. Aluksi tiedonkulku on enemmän tai vähemmän satunnaista, mutta koulutuksen myötä neuronien välinen tiedonkulku paranee verkon mukautuessa harjoitustietoihin. Jos tekoälytutkija haluaa luoda esimerkiksi kaksikielisen mallin, hän harjoittaisi malliin suurella kasalla tekstiä molemmista kielistä, mikä säätäisi hermosolujen välisiä yhteyksiä siten, että yhdellä kielellä oleva teksti suhteutetaan vastaavaan. sanat toisessa.

Mutta tämä koulutusprosessi vaatii paljon laskentatehoa. Jos malli ei toimi kovin hyvin tai jos käyttäjän tarpeet myöhemmin muuttuvat, sitä on vaikea mukauttaa. "Sanotaan, että sinulla on malli, jossa on 100 kieltä, mutta kuvittele, että yksi haluamasi kieli ei ole katettu", sanoi Mikel Artetxe, uuden tutkimuksen toinen kirjoittaja ja tekoälystartup Rekan perustaja. "Voit aloittaa alusta, mutta se ei ole ihanteellinen."

Artetxe ja hänen kollegansa ovat yrittäneet kiertää nämä rajoitukset. Muutama vuosi sitten, Artetxe ja muut kouluttivat hermoverkkoa yhdellä kielellä ja poistivat sitten sen, mitä se tiesi sanojen rakennuspalikoista, joita kutsutaan nimikkeiksi. Nämä tallennetaan hermoverkon ensimmäiseen kerrokseen, jota kutsutaan upotuskerrokseksi. He jättivät kaikki muut mallin kerrokset rauhaan. Ensimmäisen kielen tokenien poistamisen jälkeen he kouluttivat mallin uudelleen toiselle kielelle, joka täytti upotuskerroksen uusilla tämän kielen tunnuksilla.

Vaikka malli sisälsi ristiriitaista tietoa, uudelleenkoulutus toimi: Malli pystyi oppimaan ja prosessoimaan uutta kieltä. Tutkijat olettivat, että vaikka upotuskerros tallensi kielessä käytettyjä sanoja koskevia tietoja, verkon syvemmät tasot tallensivat abstraktimpaa tietoa ihmiskielten taustalla olevista käsitteistä, mikä auttoi mallia oppimaan toista kieltä.

"Elämme samassa maailmassa. Käsittelemme samoja asioita eri sanoilla” eri kielillä, sanoi Yihong Chen, tuoreen artikkelin johtava kirjoittaja. ”Siksi sinulla on sama korkeatasoinen päättely mallissa. Omena on jotain makeaa ja mehukasta pelkän sanan sijaan."

esittely

Vaikka tämä unohtaminen oli tehokas tapa lisätä uusi kieli jo koulutettuun malliin, uudelleenkoulutus oli silti vaativaa – se vaati paljon kielidataa ja prosessointitehoa. Chen ehdotti säätöä: Harjoittelun, upotuskerroksen poistamisen ja sitten uudelleenkoulutuksen sijaan heidän tulisi ajoittain nollata upotuskerros ensimmäisen harjoituskierroksen aikana. "Tekemällä tämän, koko malli tottuu nollaukseen", Artetxe sanoi. "Se tarkoittaa, että kun haluat laajentaa mallia toiselle kielelle, se on helpompaa, koska olet tehnyt niin."

Tutkijat ottivat käyttöön yleisesti käytetyn kielimallin nimeltä Roberta, kouluttivat sitä käyttämällä jaksoittaista unohtamista koskevaa tekniikkaansa ja vertasivat sitä saman mallin suorituskykyyn, kun sitä harjoiteltiin tavallisella, unohtamattomalla lähestymistavalla. Unohtamisen malli menestyi hieman huonommin kuin tavanomainen malli, ja se sai pistemäärän 85.1 verrattuna 86.1:een yhdellä yleisellä kielen tarkkuuden mittalaitteella. Sitten he kouluttivat malleja uudelleen muilla kielillä käyttämällä paljon pienempiä tietojoukkoja, joissa oli vain 5 miljoonaa merkkiä ensimmäisessä harjoittelussa käyttämänsä 70 miljardin sijaan. Vakiomallin tarkkuus laski keskimäärin 53.3:een, mutta unohtava malli vain 62.7:ään.

Unohtamisen malli menestyi myös paljon paremmin, jos tiimi asetti laskennallisia rajoituksia uudelleenkoulutuksen aikana. Kun tutkijat leikkasivat harjoittelun pituuden 125,000 5,000 askeleesta vain 57.8 37.2 askeleen, unohdusmallin tarkkuus laski keskimäärin XNUMX:aan, kun taas standardimalli putosi XNUMX:een, mikä ei ole parempi kuin satunnaiset arvaukset.

esittely

Ryhmä päätteli, että säännöllinen unohtaminen näyttää parantavan mallia kielten oppimisessa yleisesti. "Koska [he] unohtavat ja oppivat uudelleen koulutuksen aikana, uuden opettaminen verkostolle on myöhemmin helpompaa", sanoi Jevgeni Nikishin, tutkija Milassa, syvän oppimisen tutkimuskeskuksessa Quebecissä. Se viittaa siihen, että kun kielimallit ymmärtävät kieltä, ne tekevät sen syvemmällä tasolla kuin vain yksittäisten sanojen merkitykset.

Lähestymistapa on samanlainen kuin omat aivomme toimivat. ”Ihmisen muisti ei yleensä ole kovin hyvä tallentamaan tarkasti suuria määriä yksityiskohtaista tietoa. Sen sijaan ihmisillä on taipumus muistaa kokemustemme ydin, abstraktisti ja ekstrapoloida", sanoi Benjamin Levy, San Franciscon yliopiston neurotieteilijä. "Tekoälyn mahdollistaminen inhimillisemmillä prosesseilla, kuten mukautuvalla unohtamisella, on yksi tapa saada ne joustavampaan suorituskykyyn."

Sen lisäksi, mitä se voisi sanoa ymmärtämisen toiminnasta, Artetxe toivoo, että joustavammat unohtamiskielimallit voisivat myös auttaa tuomaan uusimmat tekoälyn läpimurrot useammille kielille. Vaikka tekoälymallit ovat hyviä käsittelemään espanjaa ja englantia, kahta kieltä ja runsaasti koulutusmateriaaleja, mallit eivät ole yhtä hyviä hänen äidinkielensä baskin kanssa, joka on paikallinen Koillis-Espanjalle ominaista kieli. "Useimmat suurten teknologiayritysten mallit eivät tee sitä hyvin", hän sanoi. "Olemassa olevien mallien mukauttaminen baskiin on oikea tapa edetä."

Chen odottaa myös maailmaa, jossa kukkii enemmän tekoälykukkia. ”Ajattelen tilannetta, jossa maailma ei tarvitse yhtä suurta kielimallia. Meillä on niin paljon", hän sanoi. ”Jos tehdas valmistaa kielimalleja, tarvitset tällaista tekniikkaa. Siinä on yksi perusmalli, joka mukautuu nopeasti uusiin verkkotunnuksiin."

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :on

- :On

- :ei

- :missä

- ][s

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Meistä

- TIIVISTELMÄ

- tarkkuus

- tarkasti

- sopeuttaa

- mukautuva

- mukautuu

- lisätä

- Lisäksi

- edistää

- Jälkeen

- AI

- AI-mallit

- Kaikki

- yksin

- jo

- Myös

- määrät

- an

- ja

- Toinen

- omena

- lähestymistapa

- sovellukset

- OVAT

- AS

- At

- kirjoittaja

- keskimäärin

- pohja

- perustiedot

- koska

- tulee

- ollut

- takana

- Paremmin

- välillä

- Iso

- iso tekniikka

- Suurimmat

- Miljardi

- Blocks

- Kukinta

- sekä

- läpimurtoja

- tuoda

- Rakentaminen

- mutta

- by

- laskelmat

- nimeltään

- CAN

- keskus

- muuttaa

- chen

- kiertää

- Yhteiskirjoittaja

- työtovereiden

- Yhteinen

- yleisesti

- Yritykset

- verrattuna

- laskennallinen

- tietokone

- tietojenkäsittely

- laskentateho

- käsitteet

- päätökseen

- Liitännät

- sisälsi

- tavanomainen

- voisi

- katettu

- luoda

- luotu

- Leikkaus

- tiedot

- tietueita

- vähentynyt

- syvä

- syvä oppiminen

- syvempää

- vaativa

- yksityiskohtainen

- DID

- eri

- do

- ei

- tekee

- verkkotunnuksia

- Dont

- putosi

- aikana

- kukin

- helpompaa

- Tehokas

- upottamisen

- insinööri

- Moottorit

- Englanti

- Koko

- Vastaava

- esimerkki

- olemassa

- Elämykset

- laajentaa

- tehdas

- harvat

- ala

- täynnä

- Etunimi

- joustava

- virtaus

- varten

- Eteenpäin

- perustaja

- Francisco

- alkaen

- toiminto

- general

- yleensä

- saada

- GitHub

- Go

- hyvä

- Käsittely

- Kova

- Olla

- he

- auttaa

- auttanut

- korkean tason

- hänen

- toivoo

- Miten

- HTTPS

- valtava

- ihmisen

- ihmisen kaltainen

- Ihmiset

- ihanteellinen

- if

- kuvitella

- määrätty

- parantaa

- in

- henkilökohtainen

- tiedot

- ensimmäinen

- ensin

- sen sijaan

- Instituutti

- IT

- vain

- Pitää

- laji

- tietää

- Korea

- Kieli

- kielet

- suuri

- myöhemmin

- uusin

- kerros

- kerrokset

- johtaa

- OPPIA

- oppiminen

- vasemmalle

- Pituus

- vähemmän

- Taso

- tasot

- pitää

- rajoitukset

- rajat

- elää

- paikallinen

- ulkonäkö

- Erä

- kone

- koneoppiminen

- aikakauslehti

- tehdä

- Tekeminen

- monet

- tarvikkeet

- matemaattinen

- merkityksiä

- välineet

- mitata

- Muisti

- ehkä

- miljoona

- malli

- mallit

- lisää

- enimmäkseen

- paljon

- moninkertainen

- täytyy

- syntyperäinen

- Tarve

- tarpeet

- verkko

- hermo-

- neuroverkkomallien

- neuronien

- Uusi

- Nro

- of

- on

- ONE

- vain

- or

- Muut

- Muuta

- meidän

- yli

- oma

- Paperi

- suorituskyky

- ajoittainen

- Platon

- Platonin tietotieto

- PlatonData

- romahti

- teho

- powered

- prosessi

- Prosessit

- käsittely

- Jalostusteho

- Ohjelmat

- Kvantamagatsiini

- Quebec

- nopeasti

- satunnainen

- pikemminkin

- vastaanottaa

- vastaanottava

- äskettäinen

- muistaa

- tarvitaan

- tutkimus

- tutkija

- Tutkijat

- paljastaa

- kierros

- toimii

- Said

- sama

- San

- San Francisco

- sanoa

- tiede

- tutkijat

- pisteet

- raapia

- Toinen

- näyttää

- valikoiva

- lähettää

- Setit

- hän

- shouldnt

- signaalit

- merkittävä

- samankaltainen

- tilanne

- pienempiä

- So

- jonkin verran

- jotain

- Etelä

- Etelä-Korea

- Espanja

- Espanjan

- erityinen

- standardi

- Alkaa

- käynnistyksen

- Askeleet

- Yhä

- tallennettu

- tallentamiseksi

- niin

- Ehdottaa

- makea

- vie

- Opetus

- joukkue-

- teknologia

- tech-yrityksille

- tekniikka

- Elektroniikka

- taipumus

- teksti

- kuin

- että

- -

- tiedot

- maailma

- heidän

- Niitä

- sitten

- Nämä

- ne

- asiat

- Ajattelu

- tätä

- vaikka?

- Kautta

- että

- tänään

- tokens

- otti

- Juna

- koulutettu

- koulutus

- temppu

- kokeillut

- nipistää

- kaksi

- ymmärtää

- ymmärtäminen

- yliopisto

- käyttää

- käytetty

- käyttämällä

- hyvin

- haluta

- haluaa

- oli

- Tapa..

- we

- WebP

- HYVIN

- Mitä

- kun

- joka

- vaikka

- miksi

- with

- sana

- sanoja

- Referenssit

- työskenteli

- toimii

- maailman-

- huonompi

- olisi

- vuotta

- Voit

- zephyrnet