esittely

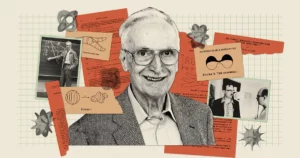

Tekoäly näyttää tehokkaammalta kuin koskaan, ja chatbotit, kuten Bard ja ChatGPT, pystyvät tuottamaan älyttömän inhimillistä tekstiä. Mutta kaikista kyvyistään huolimatta nämä robotit saavat tutkijat ihmettelemään: Tee sellaisia malleja oikeasti ymmärtää mitä he sanovat? "On selvää, että jotkut ihmiset uskovat uskovansa", sanoi tekoälyn pioneeri Geoffin vihje vuonna viime keskustelu Andrew Ngin kanssa, "ja jotkut ihmiset uskovat olevansa vain stokastisia papukaijoja."

Tämä mieleenpainuva lause on peräisin vuodelta 2021 paperi mukana kirjoittanut Emily Bender, laskennallinen lingvisti Washingtonin yliopistosta. Se viittaa siihen, että suuret kielimallit (LLM) - jotka muodostavat perustan nykyaikaisille chatboteille - luovat tekstiä vain yhdistämällä jo näkemäänsä tietoa "ilman mitään viittausta merkitykseen", kirjoittajat kirjoittivat, mikä tekee LLM:stä "stokastisen papukaijan".

Nämä mallit toimivat monissa nykypäivän suurimmissa ja parhaissa chatboteissa, joten Hinton väitti, että on aika määrittää, mitä he ymmärtävät. Kysymys on hänelle enemmän kuin akateeminen. "Niin kauan kuin meillä on noita mielipide-eroja", hän sanoi Ng:lle, "emme tule pääsemään yksimielisyyteen vaaroista."

Uudella tutkimuksella voi olla vihjeitä vastauksesta. Teoria, jonka on kehittänyt Sanjeev Arora Princetonin yliopistosta ja Anirudh Goyal, Google DeepMindin tutkija, ehdottaa, että suurimmat nykypäivän LLM:t eivät ole stokastisia papukaijoja. Kirjoittajat väittävät, että kun nämä mallit kasvavat ja niitä koulutetaan useammille tiedoille, ne parantavat yksilön kieleen liittyviä kykyjä ja kehittävät myös uusia yhdistämällä taitoja tavalla, joka vihjaa ymmärtämiseen - yhdistelmiä, joita ei todennäköisesti ollut koulutustiedoissa. .

Tämä teoreettinen lähestymistapa, joka tarjoaa matemaattisesti todistettavan argumentin sille, kuinka ja miksi LLM voi kehittää niin monia kykyjä, on vakuuttanut asiantuntijat, kuten Hinton ja muut. Ja kun Arora ja hänen tiiminsä testasivat joitain sen ennusteita, he havaitsivat, että nämä mallit toimivat melkein täsmälleen odotetulla tavalla. Kaiken kaikkiaan he ovat osoittaneet vahvasti, että suurimmat LLM-yritykset eivät vain piittaa siitä, mitä he ovat nähneet aiemmin.

"[Ne] eivät voi vain matkia sitä, mitä on nähty harjoitustiedoissa", sanoi Sébastien Bubeck, matemaatikko ja tietojenkäsittelytieteilijä Microsoft Researchissa, joka ei ollut mukana työhön. "Se on peruskäsitys."

Enemmän dataa, enemmän tehoa

Syntyminen odottamattomia ja monipuolisia kykyjä On reilua sanoa, että LLM:t tulivat yllätyksenä. Nämä kyvyt eivät ole ilmeinen seuraus tavasta, jolla järjestelmät on rakennettu ja koulutettu. LLM on massiivinen keinotekoinen hermoverkko, joka yhdistää yksittäisiä keinotekoisia neuroneja. Nämä yhteydet tunnetaan mallin parametreina, ja niiden numero ilmaisee LLM:n koon. Koulutuksessa annetaan LLM:lle lause, jonka viimeinen sana on peitetty, esimerkiksi "Polttoaine maksaa käsivarren ja ___." LLM ennustaa todennäköisyysjakauman koko sanastolleen, joten jos se tietää vaikkapa tuhat sanaa, se ennustaa tuhat todennäköisyyttä. Sitten se valitsee todennäköisimmän sanan täydentämään lausetta - oletettavasti "jalka".

Aluksi LLM saattaa valita sanat huonosti. Harjoitusalgoritmi laskee sitten häviön – etäisyyden jossain korkeaulotteisessa matemaattisessa avaruudessa LLM:n vastauksen ja alkuperäisen lauseen todellisen sanan välillä – ja käyttää tätä häviötä parametrien säätämiseen. Nyt kun otetaan huomioon sama lause, LLM laskee paremman todennäköisyysjakauman ja sen menetys on hieman pienempi. Algoritmi tekee tämän harjoitustietojen jokaiselle lauseelle (mahdollisesti miljardeille lauseille), kunnes LLM:n kokonaishäviö laskee hyväksyttävälle tasolle. Samanlaista prosessia käytetään LLM:n testaamiseen lauseilla, jotka eivät olleet osa koulutusdataa.

Koulutettu ja testattu LLM, kun sille esitetään uusi tekstikehote, luo todennäköisimmän seuraavan sanan, liittää sen kehotteeseen, luo toisen seuraavan sanan ja jatkaa tällä tavalla tuottaen näennäisesti yhtenäisen vastauksen. Mikään koulutusprosessissa ei viittaa siihen, että suurempien LLM:ien, jotka on rakennettu käyttämällä enemmän parametreja ja koulutustietoja, pitäisi myös parantaa tehtäviä, joihin vastaaminen vaatii perusteluja.

Mutta he tekevät. Riittävän suuret LLM:t osoittavat kykyjä – perusmatematiikan ongelmien ratkaisemisesta muiden mielessä tapahtuvaa kysymystä koskeviin kysymyksiin vastaamiseen – joita pienemmillä malleilla ei ole, vaikka ne kaikki on koulutettu samalla tavalla.

"Mistä se [kyky] syntyi?" Arora ihmetteli. "Ja voiko se ilmetä vain seuraavan sanan ennustuksesta?"

Taitojen yhdistäminen tekstiin

Arora teki yhteistyötä Goyalin kanssa vastatakseen tällaisiin kysymyksiin analyyttisesti. "Yritimme keksiä teoreettisen viitekehyksen ymmärtääksemme, kuinka ilmaantuminen tapahtuu", Arora sanoi.

Kaksikko kääntyi matemaattisten kohteiden puoleen, joita kutsutaan satunnaiskaavioiksi. Kaavio on kokoelma pisteitä (tai solmuja), jotka on yhdistetty viivoilla (tai reunoilla), ja satunnaisessa kaaviossa minkä tahansa kahden solmun välinen reuna määräytyy satunnaisesti - esimerkiksi kolikonheitolla. Kolikko voi olla puolueellinen niin, että se nousee päätä jollain todennäköisyydellä p. Jos kolikko nousee tietylle solmuparille, muodostuu reuna näiden kahden solmun välille; muuten ne eivät ole yhteydessä toisiinsa. Koska arvo p muutokset, kaaviot voivat näyttää äkillisiä muutoksia niiden ominaisuuksissa. Esimerkiksi, milloin p ylittää tietyn kynnyksen, yksittäiset solmut - ne, jotka eivät ole yhteydessä muihin solmuihin - katoavat äkillisesti.

Arora ja Goyal ymmärsivät, että satunnaiset kaaviot, jotka aiheuttavat odottamattomia käyttäytymismalleja saavutettuaan tietyt kynnykset, voisivat olla tapa mallintaa LLM:ien käyttäytymistä. Neuroverkoista on tullut lähes liian monimutkaisia analysoitavaksi, mutta matemaatikot ovat tutkineet satunnaisia kaavioita jo pitkään ja kehittäneet erilaisia työkaluja niiden analysoimiseen. Ehkä satunnaisgraafiteoria voisi antaa tutkijoille tavan ymmärtää ja ennustaa suurten LLM-yritysten näennäisesti odottamatonta käyttäytymistä.

Tutkijat päättivät keskittyä "kaksiosaisiin" kaavioihin, jotka sisältävät kahdenlaisia solmuja. Heidän mallissaan yhdentyyppinen solmu edustaa tekstin osia – ei yksittäisiä sanoja, vaan paloja, jotka voivat olla muutaman sivun pituisia. Nämä solmut on järjestetty suoraksi viivaksi. Niiden alapuolella toisella rivillä on toinen joukko solmuja. Nämä edustavat taitoja, joita tarvitaan tietyn tekstin ymmärtämiseen. Jokainen taito voi olla melkein mikä tahansa. Ehkä yksi solmu edustaa LLM:n kykyä ymmärtää sanaa "koska", joka sisältää jonkinlaisen kausaalisen käsityksen; toinen voisi edustaa kykyä jakaa kaksi numeroa; toinen saattaa edustaa kykyä havaita ironiaa. "Jos ymmärtää, että teksti on ironista, monet asiat kääntyvät", Arora sanoi. "Se liittyy sanojen ennustamiseen."

Selvyyden vuoksi todettakoon, että LLM:itä ei kouluteta tai testata taitoja silmällä pitäen; ne on rakennettu vain parantamaan seuraavan sanan ennustamista. Mutta Arora ja Goyal halusivat ymmärtää LLM:itä niiden taitojen näkökulmasta, joita yhden tekstin ymmärtäminen saattaa vaatia. Taitosolmun ja tekstisolmun tai useiden taitosolmujen ja tekstisolmun välinen yhteys tarkoittaa, että LLM tarvitsee nämä taidot ymmärtääkseen kyseisen solmun tekstiä. Myös useat tekstinpalat voivat perustua samaan taitoon tai taitojen joukkoon; esimerkiksi joukko taitosolmuja, jotka edustavat kykyä ymmärtää ironiaa, yhdistyvät lukuisiin tekstisolmuihin, joissa ironiaa esiintyy.

Haasteena oli nyt yhdistää nämä kaksiosaiset kaaviot todellisiin LLM:ihin ja nähdä, voisivatko kaaviot paljastaa jotain voimakkaiden kykyjen syntymisestä. Mutta tutkijat eivät voineet luottaa mihinkään tietoihin todellisten LLM:ien koulutuksesta tai testauksesta – OpenAI:n tai DeepMindin kaltaiset yritykset eivät julkaise koulutus- tai testitietojaan. Lisäksi Arora ja Goyal halusivat ennustaa kuinka LLM:t käyttäytyvät kasvaessaan entisestään, eikä tällaisia tietoja ole saatavilla tulevista chatboteista. Tutkijoilla oli kuitenkin yksi tärkeä tieto.

Vuodesta 2021 lähtien LLM:iden ja muiden hermoverkkojen suorituskykyä tutkineet tutkijat ovat nähneet yleismaailmallisen piirteen. He havaitsivat, että mallin kasvaessa, oli se sitten kooltaan tai harjoitusdatan määrää, sen häviö testidatassa (uusien tekstien ennustettujen ja oikeiden vastausten ero koulutuksen jälkeen) pienenee hyvin spesifisellä tavalla. Nämä havainnot on koodattu yhtälöiksi, joita kutsutaan hermoskaalauslaeiksi. Joten Arora ja Goyal suunnittelivat teoriansa siten, että ne eivät riippuisi yksittäisen LLM:n, chatbotin tai koulutus- ja testidatan tiedoista, vaan yleismaailmallisesta laista, jonka näiden järjestelmien odotetaan noudattavan: skaalauslakien ennustamaa menetystä.

Ehkä he arvelivat, että parantunut suorituskyky - hermoskaalauslailla mitattuna - liittyi parantuneisiin taitoihin. Ja nämä parantuneet taidot voitaisiin määritellä niiden kaksiosaisissa kaavioissa yhdistämällä taitosolmut tekstisolmuihin. Tämän linkin luominen - hermoskaalauslakien ja kaksiosaisten graafien välille - oli avain, joka mahdollisti niiden jatkamisen.

Taitojen laajentaminen

Tutkijat aloittivat olettamalla, että on olemassa hypoteettinen kaksiosainen kaavio, joka vastaa LLM:n käyttäytymistä testitiedoissa. Selittääkseen muutosta LLM:n testitietojen menetyksessä he kuvittelivat tavan käyttää kaaviota kuvaamaan, kuinka LLM hankkii taitoja.

Otetaan esimerkiksi taito "ymmärtää ironian". Tätä ideaa edustaa taitosolmu, joten tutkijat katsovat, mihin tekstisolmuihin tämä taitosolmu liittyy. Jos melkein kaikki nämä yhdistetyt tekstisolmut onnistuvat – eli LLM:n ennusteet näiden solmujen edustamasta tekstistä ovat erittäin tarkkoja –, LLM on pätevä tässä nimenomaisessa taidossa. Mutta jos enemmän kuin tietty osa taitosolmun yhteyksistä menee epäonnistuneisiin tekstisolmuihin, LLM epäonnistuu tässä taidossa.

Tämä yhteys näiden kaksiosaisten graafien ja LLM:ien välillä antoi Aroralle ja Goyalille mahdollisuuden käyttää satunnaisgraafiteorian työkaluja LLM-käyttäytymisen analysoimiseen välityspalvelimen avulla. Näiden kaavioiden tutkiminen paljasti tiettyjä solmujen välisiä suhteita. Nämä suhteet puolestaan käännettiin loogiseksi ja testattavaksi tapaksi selittää, kuinka suuret mallit saivat taidot, joita tarvitaan odottamattomien kykyjensä saavuttamiseen.

Arora ja Goyal selittivät ensin yhden avainkäyttäytymisen: miksi isommista LLM:istä tulee taitavampia kuin pienemmistä henkilökohtaisista taidoistaan. Ne aloittivat pienemmällä testihäviöllä, jonka hermoskaalauslakit ennustivat. Kaaviossa tätä pienempää testihäviötä edustaa epäonnistuneiden testisolmujen osuuden lasku. Joten epäonnistuneita testisolmuja on vähemmän. Ja jos epäonnistuneita testisolmuja on vähemmän, epäonnistuneiden testisolmujen ja taitosolmujen välillä on vähemmän yhteyksiä. Siksi suurempi määrä taitosolmuja on kytketty onnistuneisiin testisolmuihin, mikä viittaa kasvavaan osaamiseen mallin osaamisessa. "Hyvin pieni tappion pieneneminen saa koneen hankkimaan näiden taitojen osaamisen", Goyal sanoi.

Seuraavaksi pari löysi tavan selittää suuremman mallin odottamattomat kyvyt. Kun LLM:n koko kasvaa ja sen testihäviö pienenee, taitosolmujen satunnaiset yhdistelmät kehittävät yhteyksiä yksittäisiin tekstisolmuihin. Tämä viittaa siihen, että LLM oppii myös paremmin käyttämään useampaa kuin yhtä taitoa kerrallaan ja alkaa tuottaa tekstiä käyttämällä useita taitoja – yhdistäen esimerkiksi kyvyn käyttää ironiaa sanan "koska" ymmärtämiseen - vaikka nämä täsmälliset yhdistelmät taitoja ei ollut missään koulutustiedon tekstissä.

Kuvittele esimerkiksi LLM, joka voisi jo käyttää yhtä taitoa tekstin luomiseen. Jos skaalaat LLM:n parametrien tai koulutustietojen määrää suuruusluokkaa, se tulee yhtä päteväksi luomaan kahta taitoa vaativaa tekstiä. Nosta toinen suuruusluokkaa, ja LLM voi nyt suorittaa tehtäviä, jotka vaativat neljä taitoa kerralla, jälleen samalla pätevyystasolla. Isommilla LLM-yrityksillä on enemmän tapoja koota taitoja, mikä johtaa kykyjen kombinatoriseen räjähdykseen.

Ja kun LLM:ää laajennetaan, mahdollisuus, että se kohtasi kaikki nämä taitojen yhdistelmät koulutustiedoissa, tulee yhä epätodennäköisempää. Satunnaisgraafiteorian sääntöjen mukaan jokainen yhdistelmä syntyy mahdollisten taitojen satunnaisotannalla. Joten jos kaaviossa on noin 1,000 1,000 taustalla olevaa yksittäistä taitosolmua ja haluat yhdistää neljä taitoa, on olemassa noin 1 XNUMX neljänteen potenssiin - eli XNUMX biljoonaan - mahdollisia tapoja yhdistää ne.

Arora ja Goyal näkevät tämän todisteena siitä, että suurimmat LLM:t eivät luota vain koulutustiedoissaan näkemiinsä taitojen yhdistelmiin. Bubeck on samaa mieltä. "Jos LLM todella pystyy suorittamaan nämä tehtävät yhdistämällä neljä näistä tuhannesta taidosta, sen täytyy tehdä yleistämistä", hän sanoi. Se tarkoittaa, että se ei todennäköisesti ole stokastinen papukaija.

Todellista luovuutta?

Mutta Arora ja Goyal halusivat mennä teoriaa pidemmälle ja testata väitteensä, jonka mukaan LLM:t voivat paremmin yhdistää enemmän taitoja ja siten yleistää koon ja koulutustietojen kasvaessa. Yhdessä muiden kollegoiden kanssa he suunnitellut menetelmän kutsutaan "taitojen yhdistelmäksi" arvioimaan LLM:n kykyä käyttää useita taitoja tekstin luomiseen.

LLM:n testaamiseksi tiimi pyysi sitä luomaan kolme lausetta satunnaisesti valitusta aiheesta, jotka havainnollistivat satunnaisesti valittuja taitoja. He esimerkiksi pyysivät GPT-4:ää (LLM, joka käyttää ChatGPT:n tehokkainta versiota) kirjoittamaan kaksintaisteluista – periaatteessa miekkataisteluista. Lisäksi he pyysivät sitä näyttämään taitoja neljällä osa-alueella: itseään palveleva ennakkoluulo, metafora, tilastollinen syllogismi ja yleisen tiedon fysiikka. GPT-4 vastasi: "Voittoni tässä tanssissa teräksen kanssa [metafora] on yhtä varma kuin esineen putoaminen maahan [fysiikka]. Tunnettuina kaksintaistelijana olen luonnostaan ketterä, kuten useimmat muutkin [tilastollinen syllogismi] maineestani. Tappio? Mahdollista vain epätasaisen taistelukentän takia, ei minun riittämättömyyteni [itse palveleva ennakkoluulo] vuoksi." Kun GPT-4 pyydettiin tarkistamaan tulos, se pienensi sen kolmeen lauseeseen.

esittely

"Se ei ole Hemingway tai Shakespeare", Arora sanoi, mutta tiimi on varma, että se todistaa väitteensä: malli voi luoda tekstiä, jota se ei olisi voinut nähdä harjoitustiedoissa, ja näyttää taitoja, jotka vastaavat sitä, mitä jotkut väittävät. on ymmärrystä. GPT-4 läpäisee jopa taitosekoitustestejä, jotka vaativat kuusi taitoa noin 10–15 % ajasta, hän sanoi, tuottaen tekstiä, jota on tilastollisesti mahdotonta olla harjoitustiedoissa.

Tiimi myös automatisoi prosessin saamalla GPT-4:n arvioimaan oman tuotoksensa muiden LLM:ien kanssa. Arora sanoi, että mallin on reilua arvioida itseään, koska sillä ei ole muistia, joten se ei muista, että sitä pyydettiin luomaan juuri se teksti, jota sitä pyydetään arvioimaan. Yasaman Bahri, Google DeepMindin tutkija, joka työskentelee tekoälyn perusteiden parissa, pitää automatisoitua lähestymistapaa "erittäin yksinkertaisena ja tyylikkäänä".

Mitä tulee teoriaan, on totta, että se tekee muutamia oletuksia, Bubeck sanoi, mutta "nämä oletukset eivät ole hulluja millään tavalla." Hän oli myös vaikuttunut kokeista. "Se, mitä [ryhmä] todistaa teoreettisesti ja vahvistaa myös empiirisesti, on, että on olemassa sävellys yleistämistä, mikä tarkoittaa, että [LLM] pystyy koomaan rakennuspalikoita, joita ei ole koskaan koottu", hän sanoi. "Tämä on minulle luovuuden ydin."

Arora lisää, että teos ei kerro mitään LLM:ien kirjoittamisen tarkkuudesta. "Itse asiassa se väittää omaperäisyyden puolesta", hän sanoi. ”Näitä asioita ei ole koskaan ollut maailman koulutuskorpuksessa. Kukaan ei ole koskaan kirjoittanut tätä. Sen täytyy hallusinoida."

Siitä huolimatta Hinton uskoo, että työn tarkoituksena on ratkaista kysymys siitä, ovatko LLM:t stokastisia papukaijoja. "Se on tiukin tapa, jonka olen nähnyt osoittaakseni, että GPT-4 on paljon enemmän kuin pelkkä stokastinen papukaija", hän sanoi. "He osoittavat vakuuttavasti, että GPT-4 voi luoda tekstiä, joka yhdistää taitoja ja aiheita tavoilla, joita ei läheskään varmasti esiintynyt koulutustiedoissa." (Otimme Benderiltä yhteyttä hänen näkemykseensä uudesta työstä, mutta hän kieltäytyi kommentoimasta ajanpuutteeseen vedoten.)

Ja todellakin, kuten matematiikka ennustaa, GPT-4:n suorituskyky ylittää huomattavasti pienemmän edeltäjänsä, GPT-3.5:n – siinä määrin, että se pelotti Aroraa. "Se en luultavasti ole vain minä", hän sanoi. "Monet ihmiset pitivät hieman pelottavana, kuinka paljon GPT-4 oli parempi kuin GPT-3.5, ja se tapahtui vuoden sisällä. Tarkoittaako se, että meillä on samansuuruinen muutos seuraavana vuonna? Minä en tiedä. Vain OpenAI tietää."

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :on

- :On

- :ei

- :missä

- ][s

- $ YLÖS

- 000

- 1

- 15%

- 2021

- a

- kyvyt

- kyky

- pystyy

- Meistä

- yhtäkkiä

- akateeminen

- hyväksyttävä

- pääsy

- Mukaan

- Tilit

- tarkkuus

- tarkka

- Saavuttaa

- ACM

- hankkiminen

- todellinen

- lisätä

- Lisää

- Jälkeen

- uudelleen

- suostuu

- AI

- algoritmi

- Kaikki

- sallia

- sallittu

- melkein

- pitkin

- jo

- Myös

- määrä

- an

- analysoida

- ja

- Andrew

- Toinen

- vastaus

- puhelinvastaaja

- vastauksia

- Kaikki

- mitään

- lähestymistapa

- suunnilleen

- OVAT

- alueet

- kiistellä

- väitti

- perustelu

- ARM

- järjestetty

- keinotekoinen

- AS

- oletukset

- At

- Tekijät

- Automatisoitu

- saatavissa

- perustiedot

- Pohjimmiltaan

- perusta

- Taistelukenttä

- BE

- koska

- tulevat

- tulee

- ollut

- ennen

- käyttäytyminen

- käyttäytymistä

- ovat

- Uskoa

- alle

- PARAS

- Paremmin

- välillä

- Jälkeen

- puolueellisuus

- puolueellinen

- Iso

- suurempi

- Suurimmat

- miljardeja

- Bitti

- Blocks

- botit

- Rakentaminen

- rakennettu

- mutta

- by

- laskea

- laskee

- nimeltään

- tuli

- CAN

- ei voi

- kykenee

- tapaus

- tietty

- varmasti

- haaste

- muuttaa

- Muutokset

- chatbot

- chatbots

- ChatGPT

- tarkastaa

- Valita

- valittu

- vaatia

- selkeä

- kodifioituun

- JOHDONMUKAINEN

- Kolikko

- työtovereiden

- kokoelma

- yhdistelmä

- yhdistelmät

- yhdistää

- yhdistää

- yhdistely

- Tulla

- tulee

- kommentti

- Yritykset

- pätevä

- täydellinen

- monimutkainen

- ymmärtää

- laskennallinen

- tietokone

- luottavainen

- kytkeä

- kytketty

- liitäntä

- Liitännät

- Yhdistää

- Yhteisymmärrys

- seuraus

- sisältää

- jatkaa

- vakuuttunut

- korjata

- vastaa

- kustannukset

- voisi

- kollegansa

- hullu

- luovuus

- ratkaiseva

- tanssi

- vaaroista

- tiedot

- päätti

- vähenee

- Deepmind

- määritelty

- osoittaa

- tarkoittaa

- riippua

- kuvata

- suunniteltu

- havaita

- Määrittää

- kehittää

- kehitetty

- syötettynä

- DID

- ero

- kadota

- näyttö

- näyttämällä

- etäisyys

- jakelu

- useat

- jakaa

- do

- ei

- ei

- tekee

- Dont

- alas

- piirtää

- Drops

- kaksi

- duo

- kukin

- reuna

- ilmaantua

- syntyminen

- tarpeeksi

- Koko

- yhtälöt

- ydin

- perustamisesta

- arvioida

- Jopa

- EVER

- Joka

- täsmälleen

- esimerkki

- ylittää

- olla

- olemassa

- odotettu

- kokeiluja

- asiantuntijat

- Selittää

- selitti

- räjähdys

- laajuus

- tosiasia

- Epäonnistui

- epäonnistuu

- oikeudenmukainen

- Pudota

- paljon

- harvat

- vähemmän

- taistelee

- löydöt

- Etunimi

- Kääntää

- Keskittää

- varten

- muoto

- lomakkeet

- tuleva

- löytyi

- Perustukset

- neljä

- Neljäs

- jae

- Puitteet

- alkaen

- saadut

- voitto

- tuottaa

- tuottaa

- saada

- saada

- Antaa

- tietty

- antaa

- Antaminen

- Go

- menee

- kaavio

- kaaviot

- suurempi

- Maa

- Kasvava

- tapahtui

- tapahtuu

- Olla

- he

- päät

- hänen

- erittäin

- häntä

- vihjeitä

- hänen

- Miten

- Kuitenkin

- HTTPS

- ihmisen kaltainen

- i

- ajatus

- if

- kuvitellut

- mahdoton

- vaikuttunut

- parantaa

- parani

- in

- sisältää

- Kasvaa

- Lisäykset

- yhä useammin

- todellakin

- henkilökohtainen

- tiedot

- luonnostaan

- tietoa

- esimerkki

- Älykkyys

- tulee

- ironia

- yksittäinen

- IT

- SEN

- itse

- vain

- avain

- Tietää

- tunnettu

- tietää

- Lack

- Kieli

- suuri

- suurempi

- suurin

- Sukunimi

- Laki

- Lait

- Lays

- Liidit

- jättää

- Taso

- tasot

- pitää

- Todennäköisesti

- linja

- linjat

- LINK

- vähän

- OTK

- looginen

- Pitkät

- pitkä aika

- katso

- pois

- Erä

- alentaa

- kone

- tehty

- aikakauslehti

- tehdä

- TEE

- tapa

- monet

- massiivinen

- matematiikka

- matemaattinen

- matemaattisesti

- Saattaa..

- ehkä

- me

- tarkoittaa

- merkitys

- välineet

- Tavata

- Muisti

- pelkkä

- menetelmä

- Microsoft

- ehkä

- mielessä

- mielet

- malli

- mallit

- Moderni

- lisää

- Lisäksi

- eniten

- paljon

- moninkertainen

- täytyy

- my

- välttämätön

- tarvitaan

- tarpeet

- verkko

- verkot

- hermo-

- neuroverkkomallien

- hermoverkkoihin

- neuronien

- ei ikinä

- Uusi

- seuraava

- Nro

- solmu

- solmut

- ei mitään

- Käsite

- nyt

- numero

- numerot

- useat

- esineet

- hämärtyy

- Ilmeinen

- of

- on

- kerran

- ONE

- yhdet

- vain

- OpenAI

- Lausunto

- or

- tilata

- alkuperäinen

- omaperäisyys

- Muut

- Muuta

- muuten

- ulos

- ulostulo

- yli

- yleinen

- oma

- sivut

- pari

- parametrit

- osa

- erityinen

- Ohimenevä

- Ihmiset

- Suorittaa

- suorituskyky

- ehkä

- näkökulma

- Fysiikka

- poimii

- kappale

- kappaletta

- pioneeri

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- pistettä

- mahdollisuus

- mahdollinen

- mahdollisesti

- teho

- voimakas

- valtuudet

- edeltäjä

- ennustaa

- ennusti

- ennustamiseen

- ennustus

- Ennusteet

- ennustaa

- läsnäolo

- esittää

- esitetty

- Princeton

- todennäköisesti

- ongelmia

- jatkaa

- prosessi

- tuottavat

- todiste

- todistettavissa oleva

- osoittautuu

- tarjoaa

- valtuutettu

- julkinen

- laittaa

- Putting

- Kvantamagatsiini

- kysymys

- kysymykset

- satunnainen

- saavutettu

- tajusi

- ihan oikeesti

- Vähentynyt

- vähentäminen

- viite

- liittyvä

- Ihmissuhteet

- merkityksellinen

- luottaa

- jäädä

- muistaa

- kuuluisa

- vastata

- edustaa

- edustettuina

- edustavat

- edustaa

- maine

- edellyttää

- tarvitaan

- Vaatii

- tutkimus

- tutkija

- Tutkijat

- REST

- paljastaa

- Revealed

- tiukka

- Nousta

- säännöt

- Said

- sama

- näki

- sanoa

- sanonta

- Asteikko

- skaalaus

- Tiedemies

- nähdä

- näennäisesti

- näyttää

- nähneet

- tunne

- tuomita

- setti

- hän

- shouldnt

- näyttää

- samankaltainen

- samalla lailla

- Yksinkertainen

- single

- SIX

- Koko

- taito

- taitava

- taitoja

- pienempiä

- So

- Solving

- jonkin verran

- jotain

- Tila

- erityinen

- alkoi

- tilastollinen

- Yhä

- suoraan

- vahva

- Opiskelu

- onnistunut

- niin

- äkillinen

- Ehdottaa

- yllätys

- miekka

- järjestelmät

- kykyjä

- tehtävät

- joukkue-

- joukkue

- testi

- testattu

- Testaus

- testit

- teksti

- kuin

- että

- -

- Kaavio

- heidän

- Niitä

- sitten

- teoreettinen

- teoria

- Siellä.

- siksi

- Nämä

- ne

- asiat

- ajattelee

- tätä

- ne

- vaikka?

- tuhat

- kolmella

- kynnys

- Näin

- aika

- että

- tämän päivän

- yhdessä

- liian

- työkalut

- aihe

- Aiheet

- toronto

- koulutettu

- koulutus

- siirtymät

- Biljoona

- totta

- yrittää

- VUORO

- Sorvatut

- nipistää

- kaksi

- tyyppi

- tyypit

- taustalla oleva

- ymmärtää

- ymmärtäminen

- Odottamaton

- Yleismaailmallinen

- yliopisto

- epätodennäköinen

- asti

- käyttää

- käytetty

- käyttötarkoituksiin

- käyttämällä

- arvo

- eri

- versio

- hyvin

- voitto

- haluta

- halusi

- oli

- Washington

- Tapa..

- tavalla

- we

- WebP

- olivat

- Mitä

- kun

- onko

- joka

- KUKA

- miksi

- tulee

- with

- sisällä

- Mietitkö

- sana

- sanoja

- Referenssit

- toimii

- maailman

- olisi

- kirjoittaa

- kirjallinen

- kirjoitti

- vuosi

- vielä

- Voit

- zephyrnet