Tekoälyn (AI) innovoinnin jatkuessa vauhdilla, vuosi 2024 tulee olemaan organisaatioille ja hallintoelimille ratkaisevaa aikaa laatia turvallisuusstandardeja, protokollia ja muita suojakaiteita estääkseen tekoälyn pääsemästä niiden edelle, turvallisuusasiantuntijat varoittavat.

Suuret kielimallit (LLM), jotka perustuvat kehittyneisiin algoritmeihin ja valtaviin tietokokonaisuuksiin, osoittavat huomattavaa kielen ymmärtämistä ja inhimillisiä keskustelukykyjä. Yksi kehittyneimmistä näistä alustoista tähän mennessä on OpenAI:n GPT-4, joka tarjoaa edistyneitä päättely- ja ongelmanratkaisuominaisuuksia ja toimii yrityksen ChatGPT-botilla. Ja yhtiö on yhteistyössä Microsoftin kanssa aloittanut GPT-5:n työskentelyn, jonka toimitusjohtaja Sam Altman sanoi menee paljon pidemmälle - "superälykkyyden" omistamiseen asti.

Nämä mallit tarjoavat valtavia mahdollisuuksia merkittäviin tuottavuuden ja tehokkuuden parannuksiin organisaatioille, mutta asiantuntijat ovat yhtä mieltä siitä, että aika on tullut koko toimialalle. käsitellä luontaisia turvallisuusriskejä niiden kehittäminen ja käyttöönotto. Todellakin, Writerbuddy AI:n tuore tutkimus, joka tarjoaa tekoälypohjaisen sisällönkirjoitustyökalun, havaitsi, että ChatGPT:llä on ollut jo 14 miljardia käyntiä ja niiden määrä kasvaa.

Kun organisaatiot marssivat kohti tekoälyn kehitystä, siihen "on yhdistettävä tiukat eettiset näkökohdat ja riskiarvioinnit", sanoo Gal Ringel, tekoälyyn perustuvan tietosuoja- ja tietoturvayrityksen MineOS:n toimitusjohtaja.

Onko tekoäly eksistentiaalinen uhka?

Tekoälyn seuraavan sukupolven turvallisuuteen liittyvät huolenaiheet alkoivat levitä maaliskuussa, kun lähes 34,000 XNUMX huipputeknologia allekirjoitti avoimen kirjeen, jossa vaadittiin pysäyttämään generatiivisten tekoälyjärjestelmien kehitys. OpenAI: n GPT-4. Kirjeessä viitattiin "syviin riskeihin" yhteiskunnalle, joita teknologia edustaa, ja "tekoälylaboratorioiden hallitsemattomaan kilpailuun kehittää ja ottaa käyttöön entistä tehokkaampia digitaalisia mieliä, joita kukaan - eivät edes niiden tekijät" voi ymmärtää, ennustaa tai ennustaa. ohjata luotettavasti."

Näistä dystopisista peloista huolimatta useimmat turvallisuusasiantuntijat eivät ole niin huolissaan tuomiopäivän skenaariosta, jossa koneista tulee ihmisiä älykkäämpiä ja ne valtaavat maailman.

"Avoimessa kirjeessä todettiin pätevä huoli tekoälyn nopeasta edistymisestä ja mahdollisista sovelluksista laajassa mielessä "onko tämä hyvä ihmiskunnalle", sanoo Matt Wilson, kyberturvallisuusyritys Netrixin myyntisuunnittelujohtaja. "Vaikka tekoälytyökalujen julkiset versiot ovat vaikuttavia tietyissä skenaarioissa, ne eivät näytä kovin uhkaavilta."

Huolestuttavaa on se, että tekoälyn kehitys ja käyttöönotto etenevät liian nopeasti, jotta riskejä voitaisiin hallita kunnolla, tutkijat huomauttavat. "Emme voi laittaa kantta takaisin Pandoran lippaan", toteaa Patrick Harr, tekoälyn tietoturvatoimittajan SlashNextin toimitusjohtaja.

Lisäksi pelkkä "yritys pysäyttää innovaatiovauhti avaruudessa ei auta lieventämään" sen aiheuttamia riskejä, joita on käsiteltävä erikseen, huomauttaa Marcus Fowler, tekoälyn turvayrityksen DarkTrace Federalin toimitusjohtaja. Tämä ei tarkoita, että tekoälykehityksen pitäisi jatkua valvomattomana, hän sanoo. Päinvastoin, riskinarvioinnin ja asianmukaisten suojatoimien toteuttamisen tulisi vastata nopeutta, jolla LLM:itä koulutetaan ja kehitetään.

"Tekoälyteknologia kehittyy nopeasti, joten hallitusten ja tekoälyä käyttävien organisaatioiden on myös vauhditettava keskusteluja tekoälyn turvallisuudesta", Fowler selittää.

Generatiiviset tekoälyriskit

Generatiiviseen tekoälyyn liittyy useita laajalti tunnustettuja riskejä, jotka vaativat harkintaa ja jotka vain pahenevat, kun teknologian tulevat sukupolvet tulevat älykkäämmiksi. Ihmisten onneksi yksikään niistä ei toistaiseksi esitä tieteisfiktiota tuomiopäivän skenaariota, jossa tekoäly juonittelee tuhotakseen sen tekijät.

Sen sijaan ne sisältävät paljon tutumpia uhkia, kuten tietovuodot, mahdollisesti yritysarkaluontoiset tiedot; väärinkäyttö haitalliseen toimintaan; ja epätarkkoja tuloksia, jotka voivat johtaa käyttäjiä harhaan tai hämmentää käyttäjiä, mikä lopulta johtaa kielteisiin liiketoimintaan.

Koska LLM:t tarvitsevat pääsyn valtaviin tietomääriin tarkkojen ja asiayhteyteen liittyvien tulosten tuottamiseksi, arkaluonteisia tietoja voidaan vahingossa paljastaa tai käyttää väärin.

”Suurin riski on, että työntekijät ruokkivat sitä yritysten kannalta arkaluontoisia tietoja kun sitä pyydetään kirjoittamaan suunnitelmaa tai muotoilemaan uudelleen sähköposteja tai bisnespaketteja, jotka sisältävät yrityksen omaa tietoa”, Ringel huomauttaa.

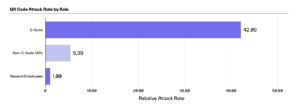

Kyberhyökkäysten näkökulmasta uhkatoimijat ovat jo löytäneet lukemattomia tapoja aseistaa ChatGPT:tä ja muita tekoälyjärjestelmiä. Yksi tapa on ollut käyttää malleja luomaan kehittyneitä yrityssähköpostien kompromisseja (BEC) ja muita tietojenkalasteluhyökkäyksiä, jotka edellyttävät sosiaalisesti suunniteltujen, henkilökohtaisten viestien luomista menestykseen.

"Haittaohjelmien avulla ChatGPT mahdollistaa kyberrikollisten tehdä loputtomasti koodimuunnelmia pysyäkseen askeleen edellä haittaohjelmien havaitsemismoottoreita", Harr sanoo.

Tekoälyhalusinaatiot muodostavat myös merkittävän turvallisuusuhan ja antavat haitalliset toimijat aseistaa LLM-pohjaista teknologiaa, kuten ChatGPT:tä ainutlaatuisella tavalla. Tekoälyhalusinaatio on tekoälyn uskottava reaktio, joka on riittämätön, puolueellinen tai täysin epätosi. "Fiktiiviset tai muut ei-toivotut vastaukset voivat ohjata organisaatioita virheelliseen päätöksentekoon, prosesseihin ja harhaanjohtavaan viestintään", varoittaa Gartnerin varapresidentti Avivah Litan.

Uhkatoimijat voivat myös käyttää näitä hallusinaatioita myrkyttääkseen LLM:itä ja "tuottaakseen erityistä väärää tietoa vastauksena kysymykseen", huomauttaa Michael Rinehart, tietoturvatoimittaja Securitin tekoälyn varapuheenjohtaja. "Tämä on laajennettavissa haavoittuvien lähdekoodien luomiseen ja mahdollisesti chat-malleihin, jotka pystyvät ohjaamaan sivuston käyttäjät vaarallisiin toimiin."

Hyökkääjät voivat mennä jopa niin pitkälle julkaista ohjelmistopakettien haitallisia versioita jota LLM saattaa suositella ohjelmistokehittäjälle uskoen sen olevan laillinen ratkaisu ongelmaan. Tällä tavalla hyökkääjät voivat edelleen aseistaa tekoälyä toteuttaakseen toimitusketjuhyökkäyksiä.

Tie eteenpäin

Asiantuntijat huomauttavat, että näiden riskien hallinta vaatii mitattuja ja kollektiivisia toimia, ennen kuin tekoälyinnovaatio ylittää alan kyvyn hallita sitä. Mutta heillä on myös ideoita tekoälyn ongelman ratkaisemiseksi.

Harr uskoo "taistele tekoälyn kanssa A:n kanssa”strategia, jossa ”teknisen tekoälyn aiheuttamien riskien ehkäisemiseen tähtäävien tietoturvaratkaisujen ja strategioiden on kehitettävä yhtä tai nopeammin.

"Kyberturvallisuuden on hyödynnettävä tekoälyä voidakseen taistella kyberuhkia vastaan AI-teknologian avulla", hän lisää. "Verrattuna vanhalla tietoturvatekniikalla ei ole mahdollisuuksia näitä hyökkäyksiä vastaan."

Organisaatioiden tulisi kuitenkin myös omaksua harkittu lähestymistapa tekoälyn käyttöönotossa – mukaan lukien Tekoälypohjaiset tietoturvaratkaisut – etteivät he aiheuta lisää riskejä ympäristöönsä, Netrixin Wilson varoittaa.

"Ymmärrä, mitä tekoäly on ja mitä ei ole", hän neuvoo. "Haasta toimittajat, jotka väittävät käyttävänsä tekoälyä, kuvaamaan, mitä se tekee, kuinka se parantaa heidän ratkaisuaan ja miksi sillä on merkitystä organisaatiollesi."

Securitin Rinehart tarjoaa kaksitasoisen lähestymistavan tekoälyn vaiheistamiseen ympäristöön ottamalla käyttöön kohdennettuja ratkaisuja ja asettamalla sitten suojakaiteet paikoilleen välittömästi ennen organisaation altistamista tarpeettomille riskeille.

"Ota ensin käyttöön sovelluskohtaiset mallit, joita mahdollisesti täydentävät tietokannat, jotka on räätälöity tuottamaan lisäarvoa tietyissä käyttötapauksissa", hän sanoo. "Sitten … ota käyttöön valvontajärjestelmä näiden mallien suojaamiseksi tarkastamalla niille lähetetyt ja niiltä tulevat viestit yksityisyyden ja turvallisuuden varalta."

Asiantuntijat suosittelevat myös tietoturvakäytäntöjen ja -menettelyjen määrittämistä tekoälyn ympärille ennen sen käyttöönottoa sen sijaan, että ne olisivat jälkikäteen riskien vähentämiseksi. He voivat jopa perustaa oman tekoälyn riskipäällikön tai työryhmän valvomaan noudattamista.

Yrityksen ulkopuolella koko alan on myös ryhdyttävä toimiin luodakseen tekoälyn ympärille turvallisuusstandardeja ja -käytäntöjä, joita jokainen teknologiaa kehittävä ja käyttävä voi ottaa käyttöön – mikä edellyttää sekä julkisen että yksityisen sektorin yhteisiä toimia maailmanlaajuisesti. , DarkTrace Federalin Fowler sanoo.

Hän lainaa ohjeita turvallisten tekoälyjärjestelmien rakentamiseen US Cybersecurity and Infrastructure Security Agency (CISA) ja Yhdistyneen kuningaskunnan kansallinen kyberturvallisuuskeskus (NCSC) julkaisivat yhteistyössä esimerkkinä ponnisteluista, joiden pitäisi seurata tekoälyn jatkuvaa kehitystä.

"Pohjimmiltaan", Securitin Rinehart sanoo, "vuosi 2024 todistaa sekä perinteisen tietoturvan että huippuluokan tekoälytekniikoiden nopean mukautumisen käyttäjien ja tietojen turvaamiseksi tällä nousevalla generatiivisella tekoälykaudella."

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.darkreading.com/vulnerabilities-threats/skynet-ahoy-what-to-expect-next-gen-ai-security-risks

- :on

- :On

- :ei

- $ YLÖS

- 000

- 14

- 2024

- 7

- a

- kyky

- Meistä

- kiihdyttää

- pääsy

- seurata

- tarkka

- Toiminta

- toimet

- toiminta

- toimijoiden

- sovitus

- osoite

- osoitettu

- Lisää

- hyväksyä

- hyväksymällä

- Hyväksyminen

- kehittynyt

- edistäminen

- edistysaskeleet

- vastaan

- toimisto

- eteenpäin

- AI

- AI-järjestelmät

- algoritmit

- Kaikki

- sallia

- jo

- Myös

- määrät

- an

- ja

- ja infrastruktuuri

- näyttää

- sovellukset

- lähestymistapa

- sopiva

- OVAT

- ARM

- noin

- keinotekoinen

- tekoäly

- Tekoäly (AI)

- AS

- pyytäminen

- arviointi

- arvioinnit

- At

- Hyökkäykset

- yrittää

- täydennetty

- takaisin

- Taistelu

- BE

- BEC

- tulevat

- ollut

- ennen

- ovat

- uskoo

- uskoa

- puolueellinen

- Miljardi

- kehut

- elimet

- Bot

- sekä

- Laatikko

- laaja

- Rakentaminen

- liiketoiminta

- yrityssähköpostikompromissi

- mutta

- by

- nimeltään

- CAN

- ei voi

- kyvyt

- kykenee

- tapauksissa

- varoitukset

- keskus

- toimitusjohtaja

- tietty

- ketju

- haaste

- mahdollisuus

- jutella

- ChatGPT

- mainittu

- vaatia

- koodi

- Kollektiivinen

- Tulla

- Yhteydenpito

- yritys

- vertailu

- noudattaminen

- kompromissi

- huolestunut

- koskevat

- huolenaiheet

- Seuraukset

- harkinta

- näkökohdat

- jatkaa

- jatkui

- jatkuu

- päinvastainen

- ohjaus

- puhekielen

- laskenta

- kytketty

- luoda

- luominen

- luojat

- ratkaiseva

- leikkaamisreuna

- cyber

- tietoverkkoturvallisuus

- Kyberhyökkäys

- verkkorikollisille

- tietoverkkojen

- tiedot

- tietoturva

- tietueita

- Päivämäärä

- Päätöksenteko

- omistautunut

- Kysyntä

- osoittaa

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- kuvata

- suunniteltu

- tuhota

- Detection

- kehittää

- kehitetty

- Kehittäjä

- kehittämällä

- Kehitys

- digitaalinen

- suuntaamisen

- Johtaja

- keskustelut

- ei

- doesnt

- Don

- Doomsday

- Dystopia

- tehokkuus

- ponnisteluja

- sähköpostit

- syntymässä

- työntekijää

- mahdollistaa

- suunniteltu

- Tekniikka

- Moottorit

- Parantaa

- valtava

- yritys

- ympäristö

- yhtäläinen

- Aikakausi

- ydin

- perustaa

- eettinen

- Jopa

- EVER

- jokainen

- evoluutio

- kehittyvä

- esimerkki

- eksistentiaalinen

- odottaa

- asiantuntijat

- selittää

- tosiasia

- tuttu

- paljon

- viallinen

- pelot

- Liitto-

- ruokinta

- fiktiivinen

- Yritys

- Etunimi

- Korjata

- tasainen

- keskityttiin

- varten

- voima

- Onneksi

- löytyi

- alkaen

- FT

- ruokkivat

- edelleen

- tulevaisuutta

- voitto

- GAL

- Gartner

- tuottaa

- sukupolvi

- sukupolvet

- generatiivinen

- Generatiivinen AI

- saada

- saada

- Global

- maailmanlaajuinen mittakaava

- Go

- hyvä

- hallitseva

- hallitukset

- suurempi

- HAD

- Olla

- he

- auttaa

- Miten

- Miten

- HTTPS

- Ihmiskunta

- ihmisen kaltainen

- Ihmiset

- ideoita

- heti

- toteuttaa

- täytäntöönpanosta

- vaikuttava

- in

- epätarkka

- vahingossa

- sisältää

- Mukaan lukien

- todellakin

- teollisuus

- Ääretön

- tiedot

- tiedot

- Infrastruktuuri

- luontainen

- Innovaatio

- Älykkyys

- tulee

- esitellä

- ISN

- kysymykset

- IT

- SEN

- jpg

- tuntemus

- Labs

- Kieli

- Vuodot

- Perintö

- laillinen

- kirjain

- Vaikutusvalta

- pitää

- OTK

- Koneet

- tärkein

- tehdä

- ilkeä

- haittaohjelmat

- haittaohjelmien havaitseminen

- onnistui

- maaliskuu

- Marcus

- massiivinen

- ottelu

- matta

- Matters

- tarkoittaa

- vain

- viestien

- Michael

- Microsoft

- ehkä

- mielet

- väärät tiedot

- harhaanjohtava

- väärinkäyttö

- lieventää

- mallit

- seuranta

- lisää

- eniten

- ASENNA

- liikkuvat

- paljon

- täytyy

- lukemattomia

- kansallinen

- NCSC

- lähes

- tarpeet

- negatiivinen

- seuraava

- Nro

- Ei eristetty

- huomata

- huomattava

- Huomautuksia

- Huomioi

- of

- Tarjoukset

- upseeri

- on

- ONE

- vain

- avata

- OpenAI

- or

- organisaatio

- organisaatioiden

- Muut

- lähdöt

- yli

- valvoa

- Rauha

- Kumppanuus

- patrick

- yksilöllinen

- näkökulma

- Phishing

- tietojenkalasteluhyökkäykset

- Paikka

- suunnitelma

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- myrkky

- politiikkaa

- aiheuttaa

- aiheuttamia

- aiheuttaa

- mahdollisesti

- mahdollinen

- mahdollisesti

- powered

- voimakas

- valtuudet

- käytännöt

- ennustaa

- lahjat

- puheenjohtaja

- estää

- yksityisyys

- Tietosuoja ja turvallisuus

- yksityinen

- yksityissektorin

- Ongelma

- ongelmanratkaisu

- menettelyt

- Prosessit

- tuottavuus

- syvällinen

- Edistyminen

- asianmukaisesti

- patentoitu

- suojaus

- protokollat

- toimittaa

- toimittaja

- julkinen

- julkaistu

- laittaa

- Putting

- kysymys

- nopeasti

- Rotu

- nopea

- hinta

- pikemminkin

- tunnustettu

- suositella

- merkityksellinen

- huomattava

- muotoilemalla uudelleen

- edustaa

- edustaa

- edellyttää

- tutkimus

- Tutkijat

- vastaus

- vasteet

- Saatu ja

- Revealed

- tiukka

- Riski

- riskinarviointi

- riskit

- s

- turvaaminen

- takeita

- Turvallisuus

- Said

- myynti

- Sam

- Sam Altman

- sanoo

- Asteikko

- skenaario

- skenaariot

- sektori

- turvallinen

- turvallisuus

- turvallisuuspolitiikkaa

- turvallisuusriskit

- tunne

- sensible

- setti

- Setit

- asetus

- useat

- shouldnt

- allekirjoitettu

- merkittävä

- paikka

- Skynet

- fiksummin

- So

- niin kaukana

- sosiaalisesti

- yhteiskunta

- Tuotteemme

- ratkaisu

- Ratkaisumme

- jotain

- hienostunut

- Tila

- erityinen

- seistä

- standardit

- alkoi

- pysyä

- ohjata

- Vaihe

- Askeleet

- stop

- strategiat

- Strategia

- menestys

- Onnistuneesti

- niin

- Yliopisto

- toimittaa

- toimitusketju

- järjestelmä

- järjestelmät

- Räätälöity

- ottaa

- Tehtävä

- työryhmä

- tekniikat

- tekniikan

- Elektroniikka

- kuin

- että

- -

- UK

- maailma

- heidän

- Niitä

- sitten

- Nämä

- ne

- tätä

- ne

- uhkaus

- uhka toimijat

- uhat

- estää

- aika

- että

- liian

- työkalu

- työkalut

- ylin

- kohti

- perinteinen

- koulutettu

- totta

- tyyppi

- Uk

- Lopulta

- ymmärtää

- ymmärtäminen

- unique

- tarpeeton

- toivottuja

- us

- käyttää

- Käyttäjät

- käyttämällä

- pätevä

- arvo

- valtava

- myyjät

- versiot

- pahe

- Varapresidentti

- Vierailut

- Haavoittuva

- varoittaa

- Tapa..

- tavalla

- we

- Mitä

- kun

- joka

- vaikka

- koko

- miksi

- laajalti

- tulee

- Wilson

- with

- Todistaja

- Referenssit

- maailman-

- huonompi

- kirjoittaa

- vuosi

- Sinun

- zephyrnet