esittely

Koneoppimisessa bias-varianssin kompromissi on peruskäsite, joka vaikuttaa minkä tahansa ennustavan mallin suorituskykyyn. Se viittaa mallin bias-virheen ja varianssivirheen herkkään tasapainoon, koska molempia on mahdotonta minimoida samanaikaisesti. Oikean tasapainon löytäminen on ratkaisevan tärkeää mallin optimaalisen suorituskyvyn saavuttamiseksi.

Tässä lyhyessä artikkelissa määrittelemme harhan ja varianssin, selitämme, kuinka ne vaikuttavat koneoppimismalliin, ja annamme käytännön neuvoja niiden käsittelemiseen käytännössä.

Biasin ja varianssin ymmärtäminen

Ennen kuin sukeltaa harhan ja varianssin väliseen suhteeseen, määritellään, mitä nämä termit edustavat koneoppimisessa.

Bias error viittaa eroon mallin ennusteen ja oikeiden arvojen välillä, joita se yrittää ennustaa (pohjatotuus). Toisin sanoen harha on virhe, jonka malli tekee, koska sen taustalla olevasta datajakaumasta on tehty virheellisiä olettamuksia. High Bias -mallit ovat usein liian yksinkertaisia, eivätkä ne pysty kaappaamaan tietojen monimutkaisuutta, mikä johtaa alisovitukseen.

Varianssivirhe taas viittaa mallin herkkyyteen harjoitustietojen pienille vaihteluille. Suuren varianssin mallit ovat liian monimutkaisia ja yleensä sovittavat datan kohinan taustalla olevan kuvion sijaan, mikä johtaa ylisovitukseen. Tämä johtaa huonoon suorituskykyyn uusilla, näkymättömillä tiedoilla.

Suuri harha voi johtaa alisovitukseen, jolloin malli on liian yksinkertainen sieppaamaan datan monimutkaisuutta. Se tekee vahvoja oletuksia tiedoista eikä pysty sieppaamaan todellista suhdetta tulo- ja lähtömuuttujien välillä. Toisaalta suuri varianssi voi johtaa ylisovitukseen, jossa malli on liian monimutkainen ja oppii datan kohinan tulo- ja lähtömuuttujien välisen taustalla olevan suhteen sijaan. Siten ylisovitusmalleilla on taipumus sovittaa harjoitusdataa liian lähelle eivätkä ne yleisty hyvin uuteen dataan, kun taas alisovitusmallit eivät edes pysty sovittamaan harjoitusdataa tarkasti.

Kuten aiemmin mainittiin, harha ja varianssi liittyvät toisiinsa, ja hyvä malli tasapainottaa harhavirheen ja varianssivirheen välillä. Bias-varianssin kompromissi on prosessi, jolla löydetään optimaalinen tasapaino näiden kahden virhelähteen välillä. Malli, jossa on pieni bias ja pieni varianssi, toimii todennäköisesti hyvin sekä harjoittelussa että uudessa datassa, minimoiden kokonaisvirheen.

Bias-variance-vaihto

Tasapainon saavuttaminen mallin monimutkaisuuden ja sen kyvyn yleistää tuntemattomaan dataan välillä on bias-varianssin kompromissin ydin. Yleensä monimutkaisemmalla mallilla on pienempi poikkeama, mutta suurempi varianssi, kun taas yksinkertaisemmalla mallilla on suurempi poikkeama mutta pienempi varianssi.

Koska harhaa ja varianssia on mahdotonta minimoida samanaikaisesti, niiden välisen optimaalisen tasapainon löytäminen on ratkaisevan tärkeää kestävän koneoppimismallin rakentamisessa. Esimerkiksi kun lisäämme mallin monimutkaisuutta, lisäämme myös varianssia. Tämä johtuu siitä, että monimutkaisempi malli sopii todennäköisemmin kohinan harjoitustietoihin, mikä johtaa ylisovitukseen.

Toisaalta, jos pidämme mallin liian yksinkertaisena, lisäämme harhaa. Tämä johtuu siitä, että yksinkertaisempi malli ei pysty kaappaamaan datan taustalla olevia suhteita, mikä johtaa alisovitukseen.

Tavoitteena on kouluttaa malli, joka on tarpeeksi monimutkainen sieppaamaan harjoitusdatan taustalla olevat suhteet, mutta ei niin monimutkainen, että se sopisi harjoitusdatan kohinaan.

Bias-Variance Trade-off käytännössä

Mallin suorituskyvyn diagnosoimiseksi laskemme ja vertaamme yleensä juna- ja validointivirheet. Hyödyllinen työkalu tämän visualisoimiseen on oppimiskäyrien kuvaaja, joka näyttää mallin suorituskyvyn sekä juna- että validointitiedoissa koko harjoitusprosessin ajan. Näitä käyriä tutkimalla voimme määrittää, onko malli ylisovitettu (suuri varianssi), alisovitus (suuri bias) vai hyvin sopiva (optimaalinen tasapaino harhan ja varianssin välillä).

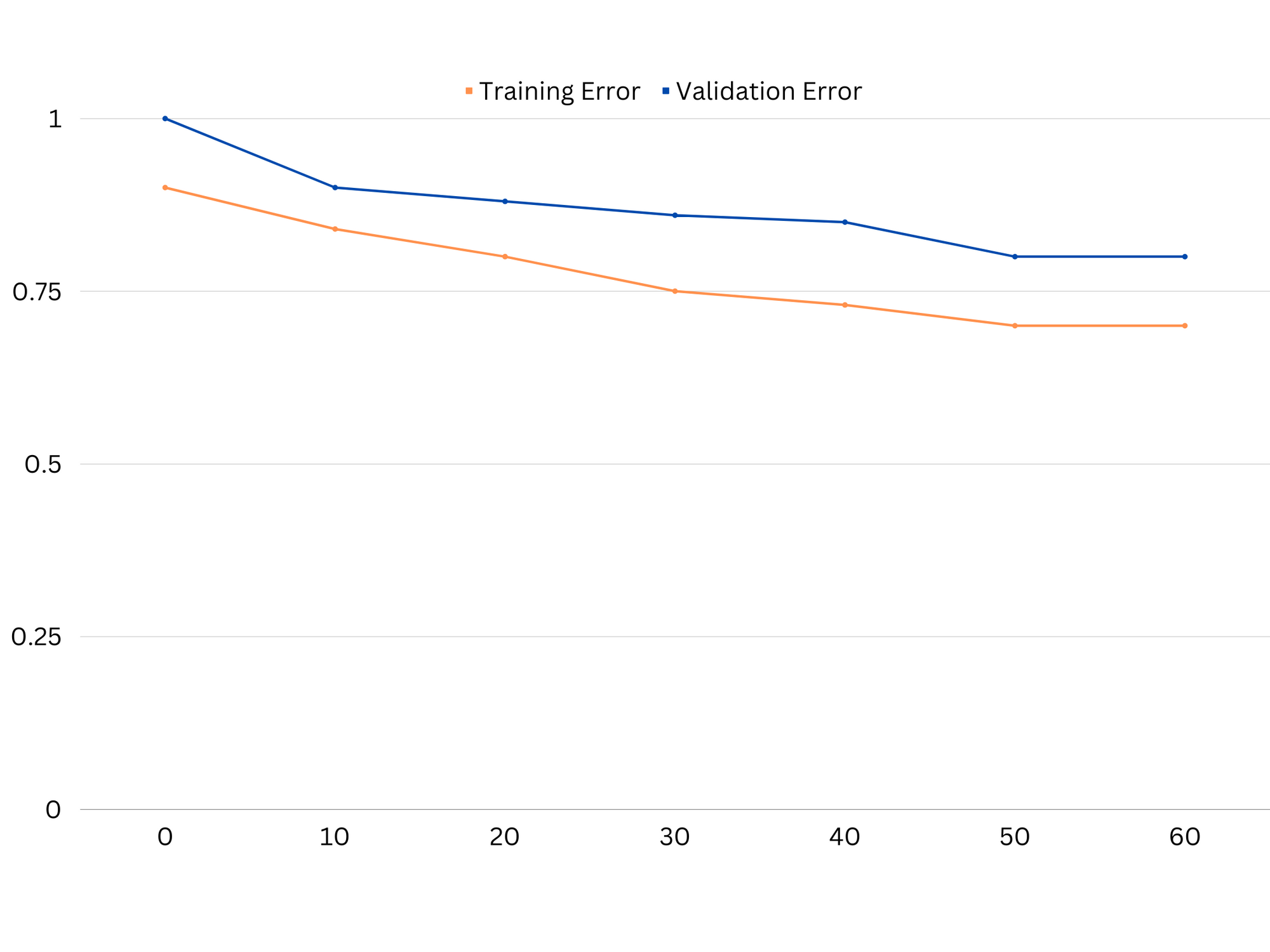

Esimerkki alasovitusmallin oppimiskäyristä. Sekä junavirhe että validointivirhe ovat suuria.

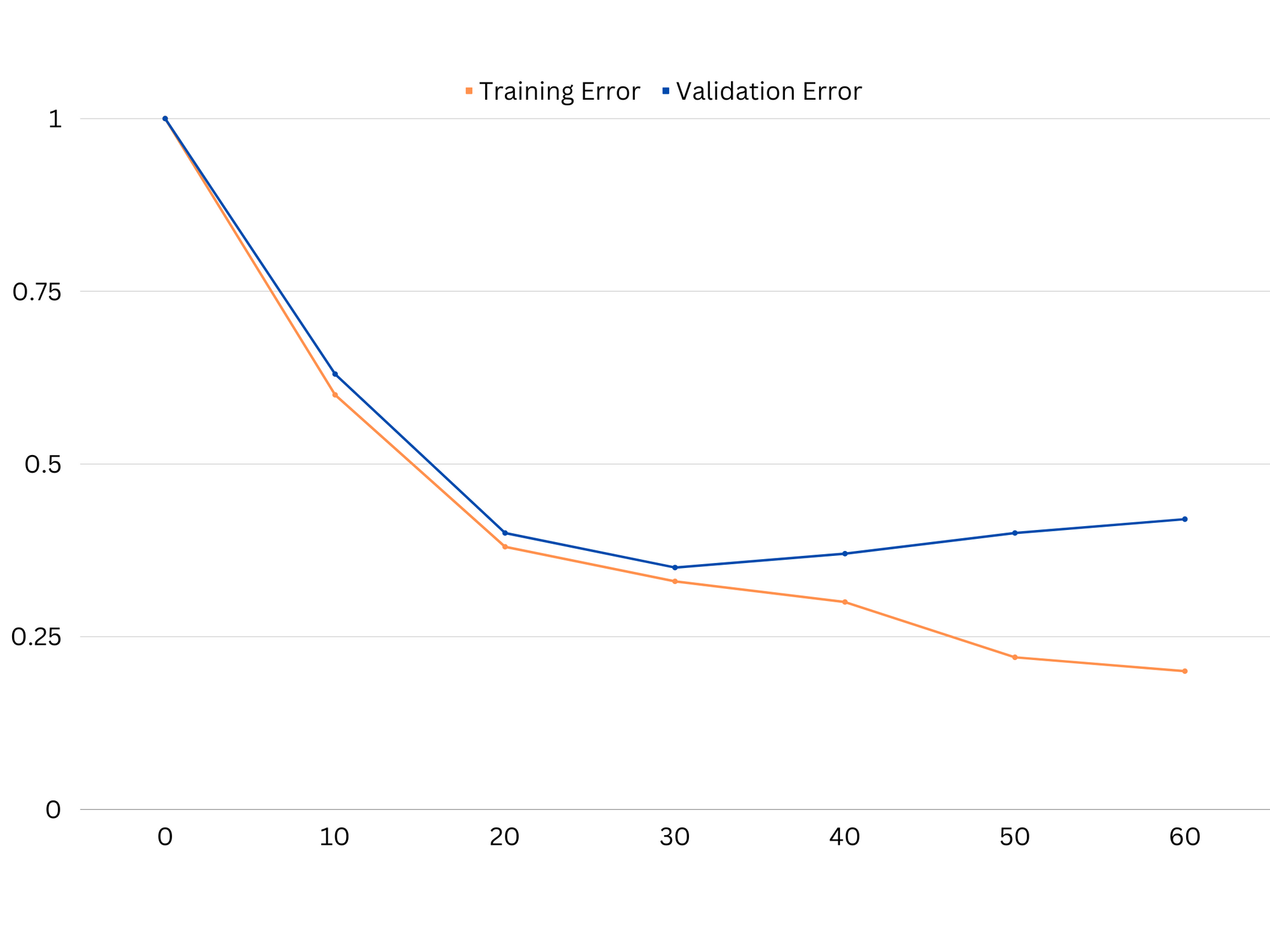

Käytännössä alhainen suorituskyky sekä koulutus- että validointitiedoissa viittaa siihen, että malli on liian yksinkertainen, mikä johtaa aliasennukseen. Toisaalta, jos malli toimii erittäin hyvin harjoitusdatalla, mutta huonosti testidatalla, mallin monimutkaisuus on todennäköisesti liian korkea, mikä johtaa ylisovitukseen. Alassovituksen korjaamiseksi voimme yrittää lisätä mallin monimutkaisuutta lisäämällä ominaisuuksia, muuttamalla oppimisalgoritmia tai valitsemalla erilaisia hyperparametreja. Ylisovituksen tapauksessa meidän tulisi harkita mallin laillistamista tai ristiinvalidoinnin kaltaisten tekniikoiden käyttöä sen yleistyskyvyn parantamiseksi.

Esimerkki ylisovitusmallin oppimiskäyristä. Junavirhe pienenee, kun taas validointivirhe alkaa kasvaa. Malli ei voi yleistää.

Regularisointi on tekniikka, jota voidaan käyttää vähentämään varianssivirhettä koneoppimismalleissa, mikä auttaa ratkaisemaan bias-varianssin kompromissin. On olemassa useita erilaisia regulointitekniikoita, joista jokaisella on omat etunsa ja haittansa. Joitakin suosittuja regularisointitekniikoita ovat harjanteen regressio, lasso-regressio ja elastinen nettregulointi. Kaikki nämä tekniikat auttavat estämään ylisovitusta lisäämällä mallin tavoitefunktioon sakkotermin, mikä estää äärimmäisiä parametriarvoja ja kannustaa yksinkertaisempiin malleihin.

Ridge-regressio, joka tunnetaan myös nimellä L2-regulaatio, lisää sakkotermin, joka on verrannollinen mallin parametrien neliöön. Tällä tekniikalla on taipumus johtaa malleihin, joissa parametriarvot ovat pienemmät, mikä voi johtaa pienempään varianssiin ja parantuneeseen yleistykseen. Se ei kuitenkaan suorita ominaisuuksien valintaa, joten kaikki ominaisuudet jäävät malliin.

Tutustu käytännönläheiseen, käytännölliseen Gitin oppimisoppaaseemme, jossa on parhaat käytännöt, alan hyväksymät standardit ja mukana tuleva huijauslehti. Lopeta Git-komentojen googlailu ja oikeastaan oppia se!

Lasson regressio, tai L1-regulointi, lisää sakkotermin, joka on verrannollinen mallin parametrien itseisarvoon. Tämä tekniikka voi johtaa malleihin, joissa on harvat parametriarvot ja jotka suorittavat ominaisuuksien valinnan tehokkaasti asettamalla jotkin parametrit nollaan. Tämä voi johtaa yksinkertaisempiin malleihin, joita on helpompi tulkita.

Elastinen nettoregulointi on sekä L1- että L2-regulaation yhdistelmä, mikä mahdollistaa tasapainon harjanteen ja lasso-regression välillä. Säätämällä kahden sakkotermin välistä suhdetta joustava verkko voi saavuttaa molempien tekniikoiden edut, kuten paremman yleistyksen ja ominaisuuksien valinnan.

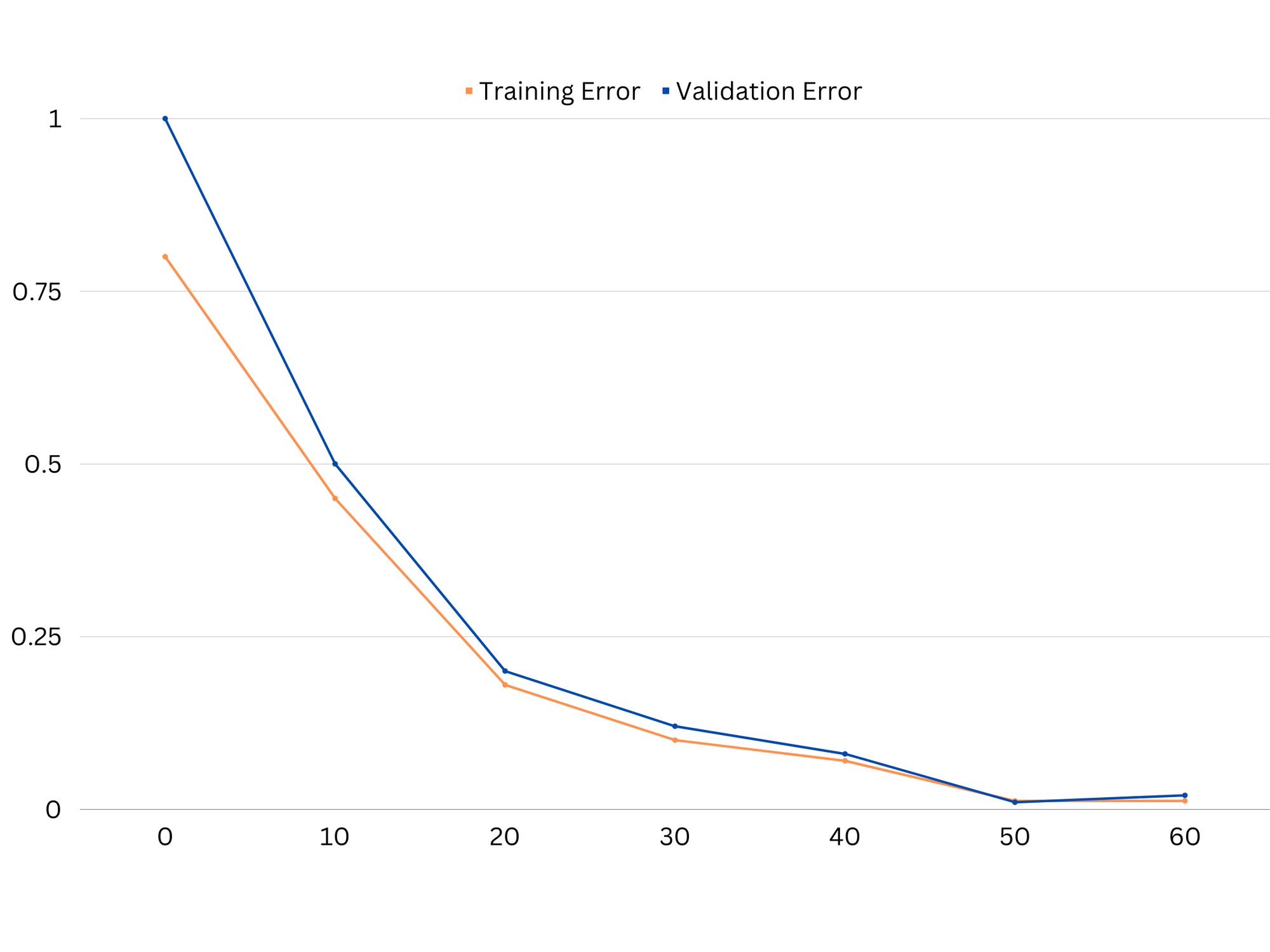

Esimerkki hyvän sovitusmallin oppimiskäyristä.

Päätelmät

Bias-varianssin kompromissi on koneoppimisen keskeinen käsite, joka määrittää mallin tehokkuuden ja hyvyyden. Vaikka suuri harha johtaa alisovitukseen ja suuri varianssi johtaa ylisovitukseen, optimaalisen tasapainon löytäminen näiden kahden välillä on välttämätöntä vankkojen mallien rakentamiseksi, jotka yleistyvät hyvin uuteen dataan.

Oppimiskäyrien avulla voidaan tunnistaa yli- tai alisovitusongelmat ja mallin monimutkaisuutta säätämällä tai ottamalla käyttöön regularisointitekniikoita voidaan parantaa suorituskykyä sekä harjoitus- että validointidatan sekä testidatan osalta.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoAiStream. Web3 Data Intelligence. Tietoa laajennettu. Pääsy tästä.

- Tulevaisuuden lyöminen Adryenn Ashley. Pääsy tästä.

- Osta ja myy osakkeita PRE-IPO-yhtiöissä PREIPO®:lla. Pääsy tästä.

- Lähde: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :On

- :ei

- :missä

- 1

- 12

- 20

- 8

- a

- kyky

- pystyy

- Meistä

- absoluuttinen

- tarkasti

- Saavuttaa

- saavuttamisessa

- todella

- lisää

- osoite

- Lisää

- etuja

- neuvot

- vaikuttaa

- vaikuttavat

- algoritmi

- Kaikki

- Salliminen

- Myös

- an

- ja

- Kaikki

- OVAT

- artikkeli

- AS

- Balance

- saldot

- BE

- koska

- Hyödyt

- välillä

- puolueellisuus

- reunus

- sekä

- Rakentaminen

- mutta

- by

- laskea

- CAN

- kyvyt

- kaapata

- tapaus

- muuttuviin

- valita

- tarkasti

- yhdistelmä

- verrata

- monimutkainen

- monimutkaisuus

- käsite

- Harkita

- valvonta

- Ydin

- korjata

- ratkaiseva

- tiedot

- sopimus

- vähenee

- Määrittää

- määrittää

- ero

- eri

- näytöt

- jakelu

- ei

- kaksi

- kukin

- Aikaisemmin

- helpompaa

- tehokkaasti

- tehokkuuden

- kannustaa

- tarpeeksi

- virhe

- virheet

- Jopa

- tutkii

- esimerkki

- Selittää

- äärimmäinen

- ei ole

- epäonnistuu

- Ominaisuus

- Ominaisuudet

- löytäminen

- sovittaa

- asennus

- vaihtelut

- Keskittää

- varten

- toiminto

- perus-

- general

- mennä

- tavoite

- hyvä

- Maa

- ohjaavat

- käsi

- käytännön

- Olla

- auttaa

- auttaa

- Korkea

- korkeampi

- liihottaa

- Miten

- Miten

- Kuitenkin

- HTTPS

- tunnistaa

- if

- täytäntöönpanosta

- mahdoton

- parantaa

- parani

- in

- Muilla

- sisältää

- mukana

- Kasvaa

- lisää

- panos

- tulee

- esittely

- IT

- SEN

- Pitää

- tunnettu

- L1

- l2

- johtaa

- johtava

- Liidit

- oppiminen

- antaa

- LG

- pitää

- Todennäköisesti

- ll

- Matala

- alentaa

- kone

- koneoppiminen

- TEE

- mainitsi

- minimointia

- malli

- mallit

- lisää

- välttämätön

- netto

- Uusi

- Melu

- numero

- tavoite

- of

- usein

- on

- optimaalinen

- or

- Muut

- meidän

- ulos

- ulostulo

- oma

- parametri

- parametrit

- Kuvio

- Suorittaa

- suorituskyky

- esittävä

- suorittaa

- Platon

- Platonin tietotieto

- PlatonData

- kehno

- Suosittu

- mahdollinen

- Käytännön

- harjoitusta.

- ennustaa

- ennustus

- estää

- ongelmia

- prosessi

- toimittaa

- pikemminkin

- suhde

- vähentää

- Vähentynyt

- viittaa

- liittyvä

- yhteys

- Ihmissuhteet

- jäädä

- edustaa

- johtua

- Saatu ja

- tulokset

- oikein

- Rengas

- luja

- s

- valinta

- Herkkyys

- asetus

- varjo

- arkki

- Lyhyt

- shouldnt

- Yksinkertainen

- samanaikaisesti

- pieni

- pienempiä

- So

- jonkin verran

- Lähteet

- neliö

- Stackabus

- standardit

- stop

- vahva

- niin

- Ehdottaa

- tekniikat

- termi

- ehdot

- testi

- kuin

- että

- -

- heidän

- Niitä

- Siellä.

- Nämä

- ne

- tätä

- kauttaaltaan

- että

- liian

- työkalu

- Yhteensä

- Juna

- koulutus

- siirtyminen

- totta

- Totuus

- yrittää

- kaksi

- tyypillisesti

- kykenemätön

- taustalla oleva

- tuntematon

- käytetty

- käyttämällä

- validointi

- arvo

- arvot

- hyvin

- we

- HYVIN

- Mitä

- onko

- joka

- vaikka

- tulee

- with

- sanoja

- zephyrnet

- nolla-