Datatieteilijät pyrkivät usein ymmärtämään erilaisten tietojen esikäsittelyn ja ominaisuussuunnittelustrategioiden vaikutuksia yhdessä eri malliarkkitehtuurien ja hyperparametrien kanssa. Tämä edellyttää suurten parametritilojen kattamista iteratiivisesti, ja voi olla ylivoimaista pitää kirjaa aiemmin suoritetuista kokoonpanoista ja tuloksista pitäen samalla kokeet toistettavissa.

Tämä viesti opastaa sinut läpi esimerkin siitä, kuinka voit seurata kokeilujasi koodin, datan, artefaktien ja mittareiden välillä käyttämällä Amazon SageMaker -kokeilut yhdessä Datan versionhallinta (DVC). Näytämme, kuinka voit käyttää DVC:tä rinnakkain Amazon Sage Maker käsittely- ja koulutustyöt. Koulutamme erilaisia CatBoost-malleja Kalifornian asuntotietojoukosta StatLib-arkistoja muuttaa pidätysstrategioita samalla kun pidät kirjaa dataversiosta DVC:n avulla. Jokaisessa yksittäisessä kokeilussa seuraamme syötettyjä ja tulostettavia artefakteja, koodia ja mittareita SageMaker Experimentsin avulla.

SageMaker-kokeet

SageMaker Experiments on AWS-palvelu koneoppimiskokeiden (ML) seurantaan. The SageMaker Experiments Python SDK on korkean tason käyttöliittymä tähän palveluun, jonka avulla voit seurata kokeilutietoja Pythonilla.

SageMaker Experimentsin tavoitteena on tehdä kokeiden luomisesta mahdollisimman helppoa, täyttää ne kokeiluilla, lisätä seuranta- ja sukuperätietoja sekä suorittaa analytiikkaa kokeiden ja kokeiden välillä.

Kun keskustelemme SageMaker-kokeista, viittaamme seuraaviin käsitteisiin:

- Kokeilu – Kokoelma asiaan liittyviä kokeita. Lisäät kokeita kokeiluun, joita haluat verrata keskenään.

- Oikeudenkäynti – Kuvaus monivaiheisesta ML-työnkulusta. Jokainen työnkulun vaihe on kuvattu kokeilukomponentilla.

- Kokeilukomponentti – Kuvaus ML-työnkulun yksittäisestä vaiheesta, kuten tietojen puhdistamisesta, ominaisuuksien poimimisesta, mallin harjoittelusta tai mallin arvioinnista.

- Tracker – Python-kontekstinhallinta yksittäisen kokeilukomponentin tietojen (esimerkiksi parametrien, mittareiden tai artefaktien) kirjaamiseen.

Tietojen versionhallinta

Data Version Control (DVC) on uudenlainen tietojen versiointi-, työnkulku- ja kokeiluhallintaohjelmisto, joka perustuu mennä (vaikka se voi toimia itsenäisesti). DVC vähentää kuilua vakiintuneiden suunnittelutyökalusarjojen ja datatieteen tarpeiden välillä, jolloin voit hyödyntää uusia piirteet samalla kun käytetään olemassa olevia taitoja ja intuitiota.

Datatieteen kokeilujen jakaminen ja yhteistyö voidaan tehdä tavallisen Git-virran kautta (sitoumukset, haarautumiset, taggaukset, vetopyynnöt) samalla tavalla kuin ohjelmistosuunnittelijoille. Gitin ja DVC:n avulla datatieteen ja ML-tiimit voivat versioida kokeiluja, hallita suuria tietojoukkoja ja tehdä projekteista toistettavia.

DVC:ssä on seuraavat ominaisuudet:

- DVC on a Ilmainen, avoin lähdekoodi komentoriviltä työkalu.

- DVC toimii Git-varastojen päällä ja sillä on samanlainen komentorivikäyttöliittymä ja -kulku kuin Gitissä. DVC voi toimia myös itsenäisesti, mutta ilman versiointi valmiuksia.

- Tietojen versiointi otetaan käyttöön korvaamalla suuret tiedostot, tietojoukkohakemistot, ML-mallit ja niin edelleen pienillä metatiedostoja (helppo käsitellä Gitillä). Nämä paikkamerkit osoittavat alkuperäiseen tietoon, joka on irrotettu lähdekoodin hallinnasta.

- Voit käyttää paikallista tai pilvitallennustilaa tallentaaksesi projektin tiedot erillään sen koodikannasta. Näin datatieteilijät voivat siirtää suuria tietojoukkoja tai jakaa GPU-koulutetun mallin muiden kanssa.

- DVC tekee datatieteen projekteista toistettavia luomalla kevyitä putkistojen käyttämällä implisiittisiä riippuvuuskaavioita ja koodaamalla siihen liittyvät tiedot ja artefaktit.

- DVC on alustaagnostikko. Se toimii kaikissa yleisimmissä käyttöjärjestelmissä (Linux, macOS ja Windows) ja toimii riippumatta ohjelmointikielistä (Python, R, Julia, shell-skriptit ja niin edelleen) tai ML-kirjastoista (Keras, TensorFlow, PyTorch, Scipy ja niin edelleen) enemmän) käytetään hankkeessa.

- DVC on nopea asentaa eikä se vaadi erityistä infrastruktuuria, eikä se ole riippuvainen sovellusliittymistä tai ulkoisista palveluista. Se on erillinen CLI-työkalu.

SageMaker Experiments ja DVC-näyte

Seuraavat GitHub-näyte näyttää kuinka DVC:tä käytetään SageMaker-ympäristössä. Tarkastelemme erityisesti, kuinka voit luoda mukautetun kuvan DVC-kirjastoilla, jotka on asennettu oletusarvoisesti, jotta voit tarjota johdonmukaisen kehitysympäristön tietotutkijoillesi. Amazon SageMaker Studioja kuinka käyttää DVC:tä yhdessä SageMakerin hallitun infrastruktuurin kanssa käsittelyä ja koulutusta varten. Lisäksi näytämme, kuinka SageMaker-seurantatietoja rikastetaan DVC:n dataversiointitiedoilla ja visualisoidaan ne Studio-konsolissa.

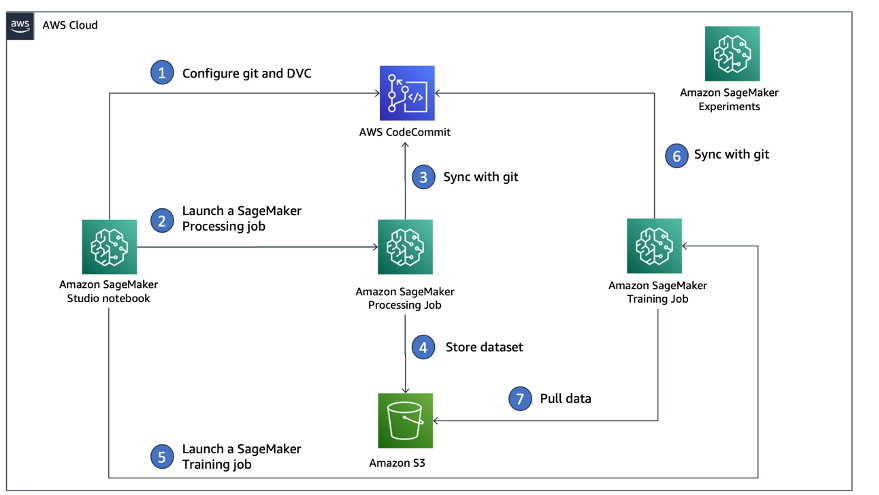

Seuraava kaavio havainnollistaa ratkaisun arkkitehtuuria ja työnkulkua.

Luo mukautettu Studio-kuva, jossa DVC on jo asennettu

Tässä GitHub-arkisto, selitämme kuinka luodaan mukautettu kuva Studiolle, johon on jo asennettu DVC. Kuvan luomisen ja kaikkien Studion käyttäjien saataville asettamisen etuna on, että se luo Studion käyttäjille yhtenäisen ympäristön, jota he voivat myös käyttää paikallisesti. Vaikka näyte perustuu AWS-pilvi9, voit myös rakentaa kontin paikalliselle koneellesi, kunhan Docker on asennettuna ja käynnissä. Tämä näyte perustuu seuraavaan Dockerfile ja ympäristö.yml. Tuloksena oleva Docker-kuva tallennetaan Amazonin elastisten säiliörekisteri (Amazon EMR) AWS-tililläsi. Katso seuraava koodi:

Voit nyt luo uusi Studio-verkkotunnus or päivittää olemassa oleva Studio-verkkotunnus jolla on pääsy äskettäin luotuun Docker-kuvaan.

Käytämme AWS Cloud Development Kit (AWS CDK) luodaksesi seuraavat resurssit kautta AWS-pilven muodostuminen:

- SageMaker-suoritusrooli, jolla on oikeat oikeudet uuteen tai olemassa olevaan Studio-verkkotunnukseesi

- SageMaker-kuva ja SageMaker-kuvaversio Docker-kuvasta

conda-env-dvc-kerneljonka loimme aiemmin - An

AppImageConfigjoka määrittää kuinka ytimen yhdyskäytävä tulee määrittää - Studion käyttäjä (

data-scientist-dvc), jossa on oikea SageMaker-suoritusrooli ja sen käytettävissä oleva mukautettu Studio-kuva

Katso tarkemmat ohjeet osoitteesta Liitä mukautettu kuva SageMaker Studioon.

Suorita laboratorio

Suorita laboratorio suorittamalla seuraavat vaiheet:

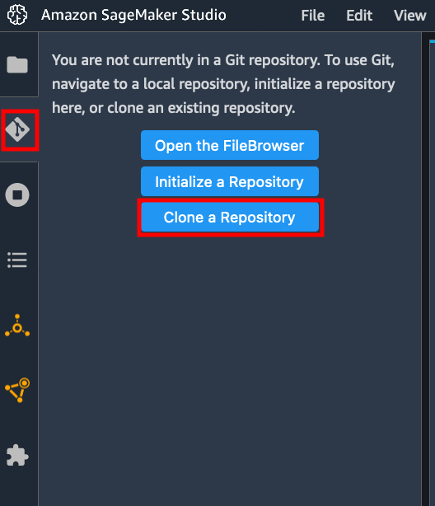

- Käynnistä Studio-verkkotunnuksessa Studio for the

data-scientist-dvckäyttäjälle. - Valitse Git-kuvake ja valitse sitten Kloonaa arkisto.

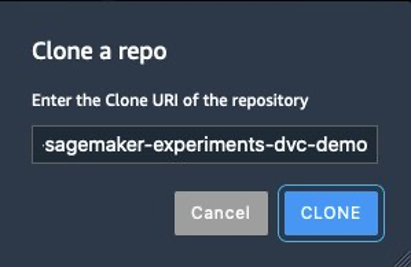

- Anna arkiston URL-osoite (

https://github.com/aws-samples/amazon-sagemaker-experiments-dvc-demo) ja valitse klooni.

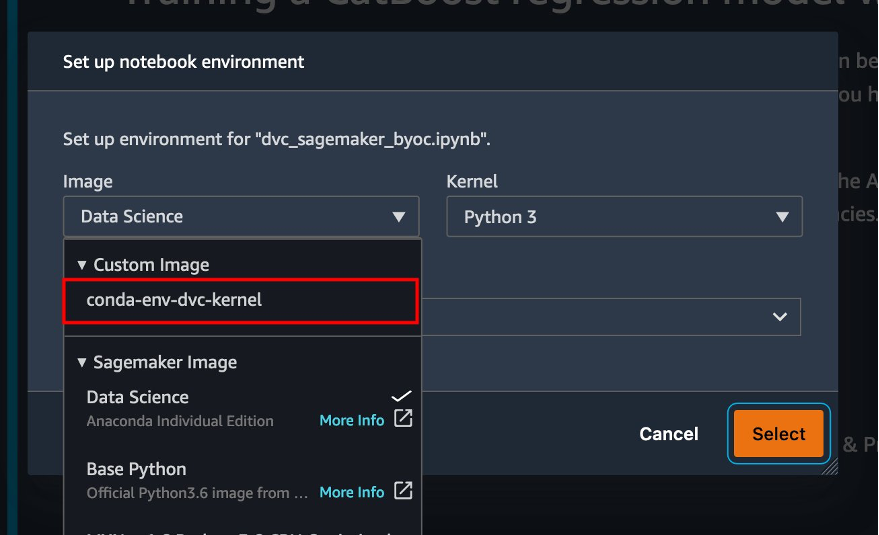

- Valitse tiedostoselaimessa

amazon-sagemaker-experiments-dvc-demoarkistoon. - Avaa

dvc_sagemaker_script_mode.ipynbmuistikirja. - varten Mukautettu kuva, valitse kuva conda-env-dvc-kernel.

- Valita valita.

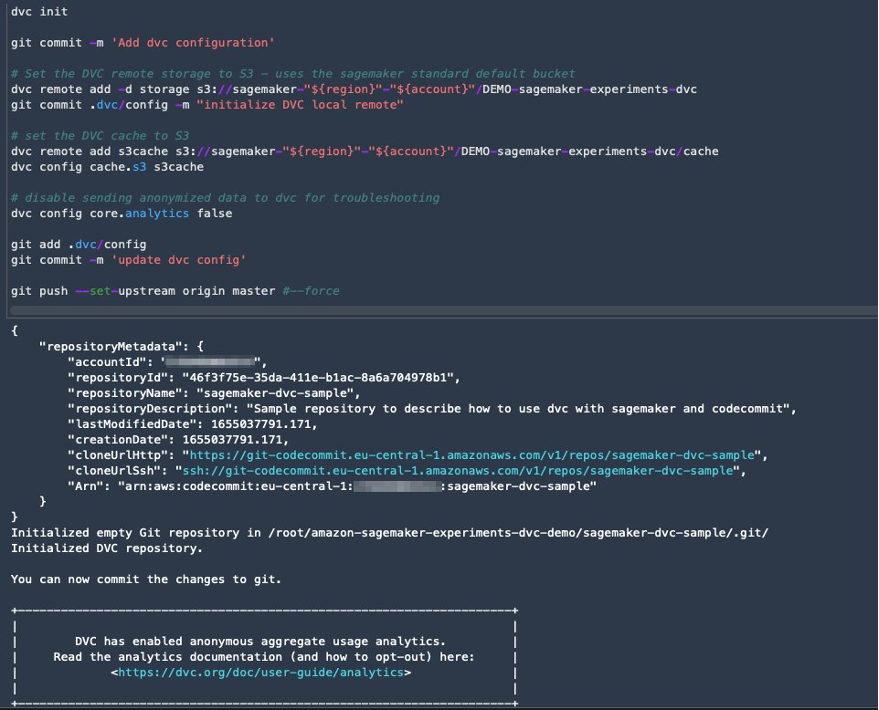

Määritä DVC tietojen versiointia varten

Luomme alihakemiston, jossa valmistelemme tiedot: sagemaker-dvc-sample. Tässä alihakemistossa alustamme uuden Git-arkiston ja asetamme kaukosäätimen arkistoon, jonka luomme AWS CodeCommit. Tavoitteena on saada DVC-määritykset ja tiedostot tietojen seurantaa varten versioituiksi tähän arkistoon. Git tarjoaa kuitenkin alkuperäisiä ominaisuuksia aliprojektien hallintaan esimerkiksi git-alimoduulien ja git-alipuiden kautta, ja voit laajentaa tätä näytettä käyttämään mitä tahansa edellä mainituista työkaluista, jotka sopivat parhaiten työnkulkuusi.

Suurin etu CodeCommitin käyttämisestä SageMakerin kanssa meidän tapauksessamme on sen integrointi AWS-henkilöllisyyden ja käyttöoikeuksien hallinta (IAM) todennusta ja valtuutusta varten, mikä tarkoittaa, että voimme käyttää IAM-rooleja tiedon työntämiseen ja hakemiseen ilman valtuustietojen (tai SSH-avaimien) hakemista. Asettamalla asianmukaiset oikeudet SageMaker-suoritusroolille mahdollistaa myös Studio-muistikirjan ja SageMaker-koulutus- ja käsittelytyön turvallisen vuorovaikutuksen CodeCommitin kanssa.

Vaikka voit korvata CodeCommitin millä tahansa muulla lähteen hallintapalvelulla, kuten GitHubilla, Gitlabilla tai Bitbucketilla, sinun on harkittava, kuinka voit käsitellä järjestelmäsi valtuustietoja. Yksi mahdollisuus on tallentaa nämä tunnistetiedot AWS -salaisuuksien hallinta ja noutaa ne ajon aikana Studio-muistikirjasta sekä SageMaker-käsittely- ja koulutustöistä.

Käsittele ja harjoittele DVC:llä ja SageMakerilla

Tässä osiossa tutkimme kahta erilaista lähestymistapaa ongelmamme ratkaisemiseksi ja sitä, kuinka voimme seurata kahta testiä käyttämällä SageMaker Experiments -kokeita korkean tason käsitteellisen arkkitehtuurin mukaisesti, jonka näytimme sinulle aiemmin.

Määritä SageMaker-kokeilu

Jotta voimme seurata tätä testiä SageMakerissa, meidän on luotava kokeilu. Meidän on myös määriteltävä kokeilu kokeessa. Yksinkertaisuuden vuoksi harkitsemme vain yhtä kokeilua kokeilua varten, mutta kokeilussa voi olla mikä tahansa määrä kokeita, esimerkiksi jos haluat testata erilaisia algoritmeja.

Luomme kokeilun nimeltä DEMO-sagemaker-experiments-dvc kahdella kokeella, dvc-trial-single-file ja dvc-trial-multi-files, joista jokainen edustaa tietojoukon eri versiota.

Luodaan DEMO-sagemaker-experiments-dvc koe:

Testi 1: Luo yksittäisiä tiedostoja koulutusta ja validointia varten

Tässä osiossa luomme käsittelyskriptin, joka hakee raakatiedot suoraan Amazonin yksinkertainen tallennuspalvelu (Amazon S3) tulona; käsittelee sen luodakseen junan, validoinnin ja testauksen tietojoukot; ja tallentaa tulokset takaisin Amazon S3:lle DVC:n avulla. Lisäksi näytämme, kuinka voit seurata DVC:n tuottamia artefakteja SageMakerilla suoritettaessa prosessointi- ja koulutustöitä sekä SageMaker-kokeilujen kautta.

Ensin luomme dvc-trial-single-file kokeiluversio ja lisää se DEMO-sagemaker-experiments-dvc koe. Näin toimimalla pidämme kaikki tähän testiin liittyvät kokeilukomponentit mielekkäällä tavalla järjestettyinä.

Käytä DVC:tä SageMaker-käsittelytyössä yksittäisen tiedoston version luomiseen

Tässä osiossa luomme käsittelykomentosarjan, joka saa raakadatan suoraan Amazon S3:sta syötteenä käyttämällä SageMakerin hallittua tiedonlatausominaisuutta; käsittelee sen luodakseen junan, validoinnin ja testauksen tietojoukot; ja tallentaa tulokset takaisin Amazon S3:lle DVC:n avulla. On erittäin tärkeää ymmärtää, että kun käytämme DVC:tä tietojen tallentamiseen Amazon S3:een (tai tietojen hakemiseen Amazon S3:sta), menetämme SageMakerin hallitun datan latauskyvyn, mikä voi mahdollisesti vaikuttaa käsittely- ja koulutustöiden suorituskykyyn ja kustannuksiin. , varsinkin kun työskentelet erittäin suurten tietojoukkojen kanssa. Lisätietoja SageMakerin natiivitulotilan ominaisuuksista on kohdassa Käytä koulutustietoja.

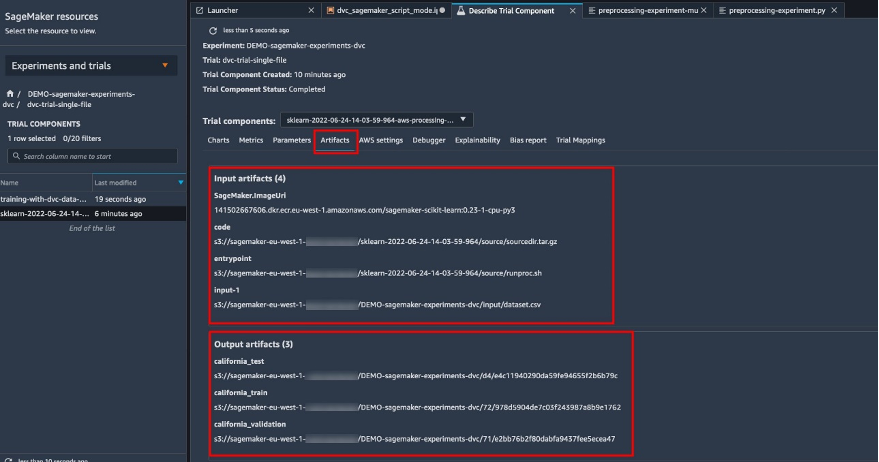

Lopuksi yhdistämme DVC-seurantaominaisuudet SageMaker-seurantaominaisuuksiin, kun suoritamme käsittelytöitä SageMaker Experimentsin kautta.

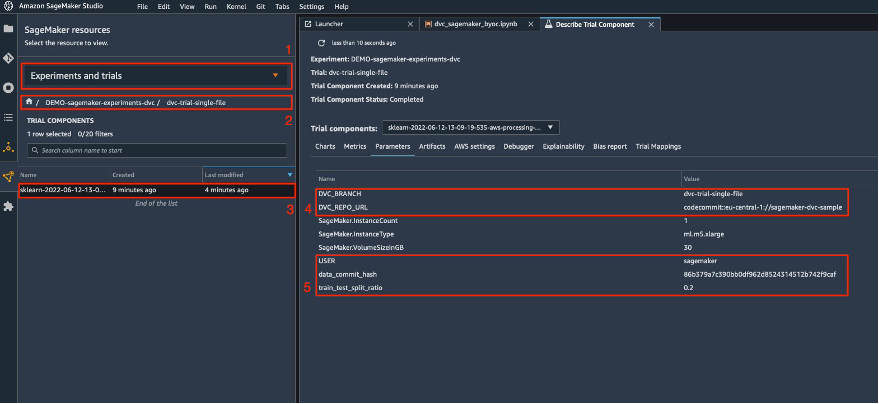

Käsittelyskripti odottaa Git-tietovaraston osoitteen ja luotavan haaran tallentamaan ympäristömuuttujien kautta välitetyt DVC-metatiedot. Itse tietojoukot on tallennettu Amazon S3:een DVC:n toimesta. Vaikka ympäristömuuttujia seurataan automaattisesti SageMaker Experimentsissa ja ne näkyvät kokeilukomponenttiparametreissa, saatamme haluta rikastaa kokeilukomponentteja lisätiedoilla, jotka ovat sitten saatavilla visualisoitaviksi Studion käyttöliittymässä seurantaobjektin avulla. Meidän tapauksessamme kokeilukomponenttien parametrit sisältävät seuraavat:

DVC_REPO_URLDVC_BRANCHUSERdata_commit_hashtrain_test_split_ratio

Esikäsittelykomentosarja kloonaa Git-arkiston; luo juna-, validointi- ja testitietojoukot; ja synkronoi sen DVC:n avulla. Kuten aiemmin mainittiin, DVC:tä käytettäessä emme voi hyödyntää SageMakerin alkuperäisiä tiedonlatausominaisuuksia. Sen lisäksi, että suurista tietojoukoista saatamme kärsiä suoritusrangaistuksia, menetämme myös tulosteartefaktien automaattiset seurantaominaisuudet. Seuraajan ja DVC Python API:n ansiosta voimme kuitenkin kompensoida nämä puutteet, hakea tällaiset tiedot ajon aikana ja tallentaa ne kokeilukomponenttiin pienellä vaivalla. Näin toimimalla saadaan lisäarvoa, että sinulla on yksi näkymä tähän tiettyyn käsittelytyöhön kuuluvista syöttö- ja tulostusartefakteista.

Täysi esikäsittely Python-skripti on saatavilla osoitteessa GitHub repo.

SageMaker antaa meille mahdollisuuden suorittaa käsittelyskriptimme AWS:n hallinnoimissa säilökuvissa, jotka on optimoitu toimimaan AWS-infrastruktuurissa. Jos komentosarjamme vaatii lisäriippuvuuksia, voimme toimittaa a requirements.txt tiedosto. Kun aloitamme käsittelytyön, SageMaker käyttää pip-install asentaaksesi kaikki tarvitsemamme kirjastot (esimerkiksi DVC:hen liittyvät kirjastot). Jos haluat hallita tiukemmin kaikkia kontteihin asennettuja kirjastoja, voit tuoda oman kontin SageMakeriin esim. käsittely ja koulutus.

Meillä on nyt kaikki ainekset SageMaker-käsittelytyömme suorittamiseen:

- Käsittelyskripti, joka voi käsitellä useita argumentteja (

--train-test-split-ratio) ja kaksi ympäristömuuttujaa (DVC_REPO_URLjaDVC_BRANCH) - A

requiremets.txttiedosto - Git-arkisto (CodeCommitissa)

- SageMaker-kokeilu ja kokeilu

Suoritamme sitten käsittelytyön kanssa preprocessing-experiment.py käsikirjoitus, experiment_config, dvc_repo_urlja dvc_branch määritimme aiemmin.

Käsittelytehtävän suorittaminen kestää noin 5 minuuttia. Nyt voit tarkastella yksittäisen tiedoston tietojoukon kokeilun yksityiskohtia.

Seuraava kuvakaappaus näyttää, mistä löydät tallennetut tiedot Studiossa. Huomaa arvot kohteelle dvc-trial-single-file in DVC_BRANCH, DVC_REPO_URLja data_commit_hash på den parametrit Tab.

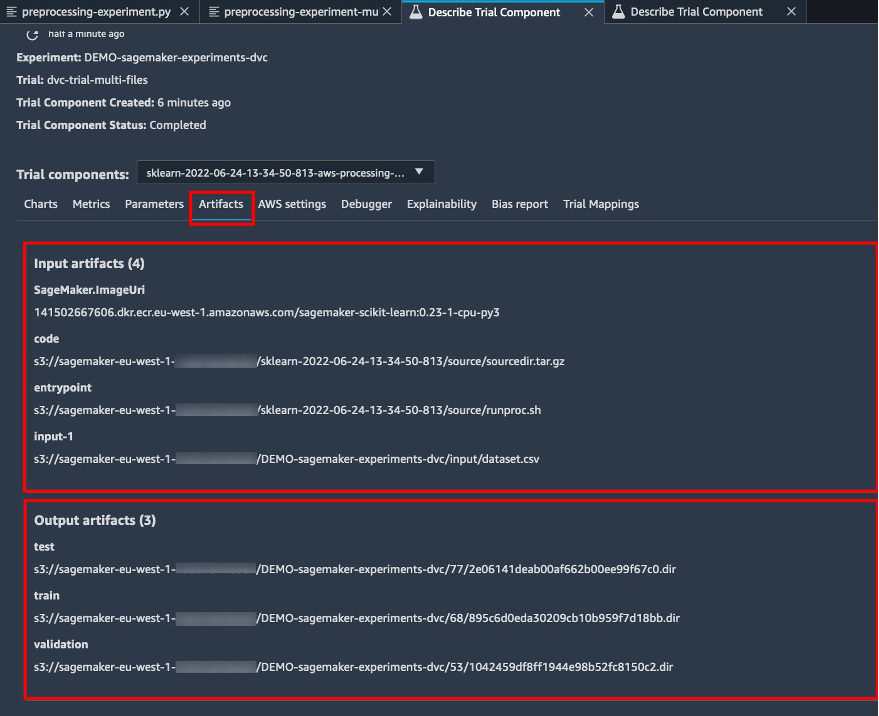

Huomioi myös syöttö- ja lähtötiedot Esineet Tab.

Luo estimaattori ja sovita malli yhden tiedoston dataversiolla

Käyttääksemme DVC-integraatiota SageMaker-harjoitustyön sisällä hyväksymme a dvc_repo_url ja dvc_branch ympäristömuuttujina, kun luot Estimator-objektin.

Harjoittelemme dvc-trial-single-file haara ensin.

Kun haemme tietoja DVC:llä, käytämme seuraavaa tietojoukkorakennetta:

Nyt luomme Scikit-learn Estimatorin käyttämällä SageMaker Python SDK. Tämän avulla voimme määrittää seuraavat:

- Polku Python-lähdetiedostoon, joka tulee suorittaa koulutuksen aloituspisteenä.

- IAM-rooli, joka hallitsee Amazon S3- ja CodeCommit-tietojen käyttöoikeuksia ja SageMaker-toimintojen suorittamista.

- Luettelo sanakirjoista, jotka määrittelevät koulutustöiden arvioinnissa käytetyt tiedot.

- Koulutustapahtumien lukumäärä ja tyyppi. Käytämme yhtä ml.m5.suuria esiintymää.

- Hyperparametrit, joita käytetään harjoitteluun.

- Ympäristömuuttujat, joita käytetään koulutustyön aikana. Käytämme

DVC_REPO_URL,DVC_BRANCHjaUSER.

Kutsumme estimaattorin sovitusmenetelmää aiemmin määrittämämme experiment_config avulla harjoituksen aloittamiseksi.

Koulutustehtävän suorittaminen kestää noin 5 minuuttia. Lokeissa näkyvät nämä rivit, jotka osoittavat DVC:n vetämät tiedostot:

Testi 2: Luo useita tiedostoja koulutusta ja validointia varten

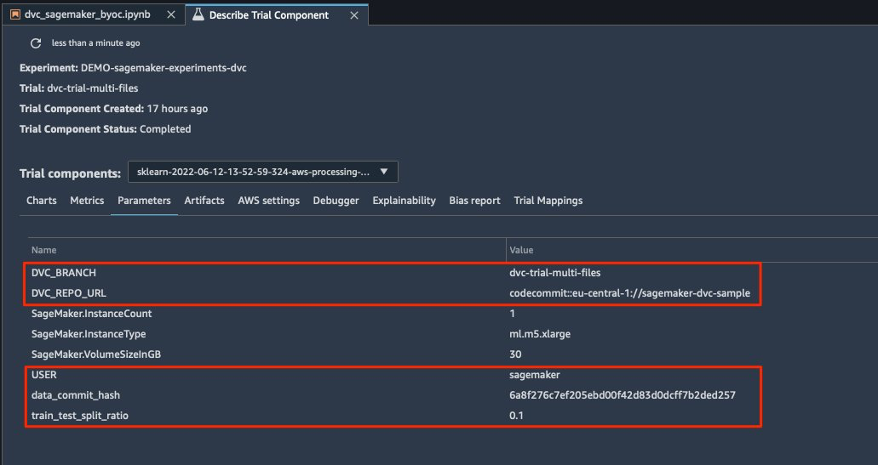

Luomme uuden dvc-trial-multi-files kokeiluversio ja lisää se nykyiseen DEMO-sagemaker-experiments-dvc koe.

Toisin kuin ensimmäisessä käsittelykomentosarjassa, luomme nyt alkuperäisestä tietojoukosta useita tiedostoja koulutusta ja validointia varten ja tallennamme DVC-metatiedot eri haaraan.

Voit tutustua toiseen esikäsittelyyn Python-skriptiin GitHub.

Käsittelytehtävän suorittaminen kestää noin 5 minuuttia. Nyt voit tarkastella monitiedostoisen tietojoukon kokeilujakson tietoja.

Seuraavat kuvakaappaukset näyttävät, mistä löydät tallennetut tiedot SageMaker Experiments -sovelluksessa Koekomponentit -osio Studion käyttöliittymässä. Huomaa arvot kohteelle dvc-trial-multi-files in DVC_BRANCH, DVC_REPO_URLja data_commit_hash på den parametrit Tab.

Voit myös tarkastella tulo- ja tulostietoja Esineet Tab.

Nyt harjoittelemme dvc-trial-multi-files haara. Kun haemme tietoja DVC:llä, käytämme seuraavaa tietojoukkorakennetta:

Kuten aiemminkin, luomme uuden Scikit-learn Estimatorin kokeilun nimellä dvc-trial-multi-files ja aloittaa koulutustyön.

Koulutustehtävän suorittaminen kestää noin 5 minuuttia. Muistikirjaan tulostetuissa koulutustyölokeissa näet nämä rivit, jotka osoittavat DVC:n vetämät tiedostot:

Isännöi mallisi SageMakerissa

Kun olet kouluttanut ML-mallisi, voit ottaa sen käyttöön SageMakerilla. Käytämme jatkuvaa, reaaliaikaista päätepistettä, joka tekee yhden ennusteen kerrallaan, käyttöön SageMakerin reaaliaikaiset isännöintipalvelut.

Ensin saamme uusimman testitietojoukon paikallisesti Studion kehitysmuistikirjaan. Tätä tarkoitusta varten voimme käyttää dvc.api.read() ladataksesi raakadatan, jonka SageMaker-käsittelytyö on tallentanut Amazon S3:een.

Sitten valmistelemme tiedot Pandasin avulla, lataamme testi-CSV-tiedoston ja soitamme predictor.predict kutsua aiemmin luotua SageMaker-päätepistettä tiedoilla ja saada ennusteita.

Poista päätepiste

Sinun tulee poistaa päätepisteet, kun ne eivät ole enää käytössä, koska ne laskutetaan käyttöönoton yhteydessä (lisätietoja on kohdassa Amazon SageMaker -hinnoittelu). Muista poistaa päätepiste odottamattomien kustannusten välttämiseksi.

Puhdistaa

Ennen kuin poistat kaikki luomasi resurssit, varmista, että kaikki sovellukset on poistettu data-scientist-dvc käyttäjä, mukaan lukien kaikki KernelGateway-sovellukset, sekä oletusarvoinen JupiterServer-sovellus.

Sitten voit tuhota AWS CDK -pinon suorittamalla seuraavan komennon:

Jos käytit olemassa olevaa verkkotunnusta, suorita myös seuraavat komennot:

Yhteenveto

Tässä viestissä kävit läpi esimerkin siitä, kuinka voit seurata kokeilujasi koodin, datan, artefaktien ja mittareiden välillä käyttämällä SageMaker Experiments- ja SageMaker-käsittely- ja koulutustöitä yhdessä DVC:n kanssa. Loimme DVC:tä sisältävän Docker-kuvan, joka vaadittiin Studiolle kehitysmuistikirjana, ja osoitimme, kuinka voit käyttää käsittely- ja koulutustöitä DVC:n kanssa. Valmistelimme tiedoista kaksi versiota ja käytimme DVC:tä niiden hallintaan Gitin avulla. Sitten käytit SageMaker Experiments -ohjelmaa tietojen käsittelyn ja harjoittamisen seuraamiseen kahdella dataversiolla, jotta saat yhtenäisen näkymän parametreista, artefakteista ja mittareista yhdessä lasiruudussa. Lopuksi otit mallin käyttöön SageMaker-päätepisteessä ja käytit testaustietojoukkoa toisesta tietojoukkoversiosta kutsuaksesi SageMaker-päätepistettä ja saadaksesi ennusteita.

Seuraavana vaiheena voit laajentaa olemassa olevaa kannettavaa tietokonetta ja ottaa käyttöön oman ominaisuussuunnittelustrategiasi ja käyttää DVC:tä ja SageMakeria kokeilujen suorittamiseen. Lähdetään rakentamaan!

Lue lisää seuraavista lähteistä:

Tietoja Tekijät

Paolo di Francesco on ratkaisuarkkitehti AWS:ssä. Hänellä on kokemusta tietoliikenne- ja ohjelmistosuunnittelusta. Hän on intohimoinen koneoppimisesta ja keskittyy tällä hetkellä käyttämään kokemustaan auttaakseen asiakkaita saavuttamaan tavoitteensa AWS:ssä, erityisesti MLOps-keskusteluissa. Työn ulkopuolella hän nauttii jalkapallon pelaamisesta ja lukemisesta.

Paolo di Francesco on ratkaisuarkkitehti AWS:ssä. Hänellä on kokemusta tietoliikenne- ja ohjelmistosuunnittelusta. Hän on intohimoinen koneoppimisesta ja keskittyy tällä hetkellä käyttämään kokemustaan auttaakseen asiakkaita saavuttamaan tavoitteensa AWS:ssä, erityisesti MLOps-keskusteluissa. Työn ulkopuolella hän nauttii jalkapallon pelaamisesta ja lukemisesta.

Eitan Sela on koneoppimisen asiantuntijaratkaisujen arkkitehti Amazon Web Services -palvelussa. Hän työskentelee AWS-asiakkaiden kanssa tarjotakseen ohjausta ja teknistä tukea, mikä auttaa heitä rakentamaan ja käyttämään koneoppimisratkaisuja AWS:ssä. Vapaa-ajallaan Eitan nauttii lenkkeilystä ja uusimpien koneoppimisartikkelien lukemisesta.

Eitan Sela on koneoppimisen asiantuntijaratkaisujen arkkitehti Amazon Web Services -palvelussa. Hän työskentelee AWS-asiakkaiden kanssa tarjotakseen ohjausta ja teknistä tukea, mikä auttaa heitä rakentamaan ja käyttämään koneoppimisratkaisuja AWS:ssä. Vapaa-ajallaan Eitan nauttii lenkkeilystä ja uusimpien koneoppimisartikkelien lukemisesta.

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- Amazon Sage Maker

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- AWS-koneoppiminen

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- Tietojen versionhallinta

- syvä oppiminen

- DVC

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- Tekniset ohjeet

- zephyrnet