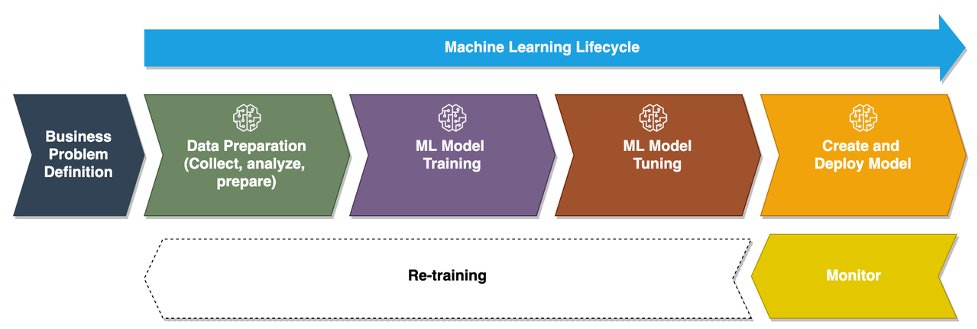

Kun yritykset siirtyvät ad hoc koneoppimismalleista (ML) käyttämään tekoälyä/ML:ää liiketoimintansa muuttamiseen mittakaavassa, ML Operationsin (MLOps) käyttöönotosta tulee väistämätöntä. Kuten seuraavassa kuvassa näkyy, ML-elinkaari alkaa liiketoimintaongelman muotoilulla ML-käyttötapaukseksi, jota seuraa sarja vaiheita, mukaan lukien tietojen valmistelu, ominaisuussuunnittelu, mallin rakentaminen, käyttöönotto, jatkuva seuranta ja uudelleenkoulutus. Monille yrityksille monet näistä vaiheista ovat edelleen manuaalisia ja löyhästi toisiinsa integroituja. Siksi on tärkeää automatisoida päästä-päähän ML-elinkaari, mikä mahdollistaa toistuvien kokeilujen saavuttamisen parempien liiketulosten saavuttamiseksi. Tietojen valmistelu on yksi tämän elinkaaren tärkeimmistä vaiheista, koska ML-mallin tarkkuus riippuu harjoitustietojoukon laadusta.

Datatieteilijät ja ML-insinöörit käyttävät 70–80 % ajastaan mallikoulutukseen tarvittavan tiedon keräämiseen, analysointiin, puhdistamiseen ja muuntamiseen. Amazon SageMaker Data Wrangler on täysin hallittu ominaisuus Amazon Sage Maker Tämän ansiosta datatieteilijät ja ML-insinöörit voivat analysoida ja valmistella dataa ML-projekteihinsa nopeammin ilman koodia. Kun on kyse päästä-päähän ML-elinkaarin käyttöönotosta, tietojen valmistelu on lähes aina prosessin ensimmäinen vaihe. Koska on monia tapoja rakentaa päästä päähän ML-putkilinja, tässä viestissä keskustelemme siitä, kuinka voit helposti integroida Data Wranglerin joihinkin tunnettuihin työnkulun automaatio- ja orkestrointitekniikoihin.

Ratkaisun yleiskatsaus

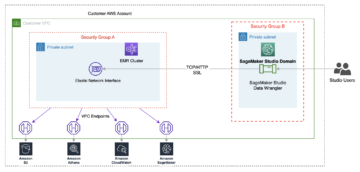

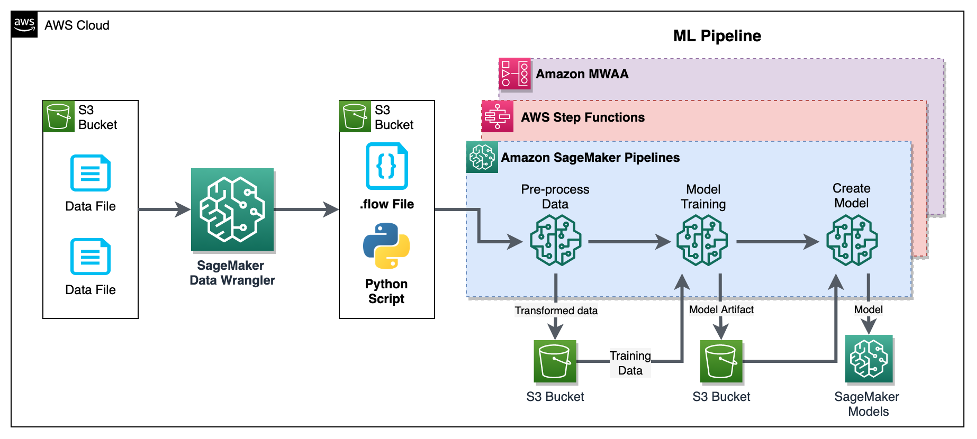

Tässä viestissä näytämme, kuinka käyttäjät voivat integroida tietojen valmistelun Data Wranglerin avulla Amazon SageMaker -putkistot, AWS-vaihetoiminnotja apache-ilmavirta with Amazonin hallinnoima työnkulku Apache Airflowlle (Amazon MWAA). Pipelines on SageMaker-ominaisuus, joka on tarkoitukseen rakennettu ja helppokäyttöinen jatkuva integrointi ja jatkuva toimitus (CI/CD) palvelu ML:lle. Step Functions on palvelimeton, matalakooditon visuaalinen työnkulkupalvelu, jota käytetään AWS-palvelujen järjestämiseen ja liiketoimintaprosessien automatisointiin. Amazon MWAA on Apache Airflow:n hallittu orkestrointipalvelu, joka helpottaa päästä päähän -datan ja ML-putkien käyttöä.

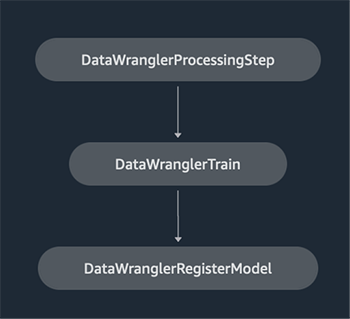

Esittelytarkoituksia varten harkitsemme käyttötapausta tietojen valmistelemiseksi ML-mallin kouluttamiseksi sisäänrakennetulla SageMakerilla XGBoost-algoritmi joka auttaa meitä tunnistamaan vilpilliset ajoneuvovakuutuskorvaukset. Käytimme synteettisesti luotua näytedatajoukkoa mallin harjoittamiseen ja SageMaker-mallin luomiseen käyttämällä koulutusprosessin malliartefakteja. Tavoitteemme on toteuttaa tämä prosessi päästä päähän perustamalla ML-työnkulku. Vaikka ML-työnkulut voivat olla monimutkaisempia, käytämme esittelytarkoituksiin minimaalista työnkulkua. Työnkulun ensimmäinen vaihe on tietojen valmistelu Data Wranglerilla, jota seuraa mallin koulutusvaihe ja lopuksi mallin luontivaihe. Seuraava kaavio havainnollistaa ratkaisumme työnkulkua.

Seuraavissa osioissa opastamme sinua määrittämään Data Wrangler -virran ja integroimaan Data Wranglerin putkilinjojen, Step Functions- ja Apache Airflow -toimintojen kanssa.

Määritä Data Wrangler -kulku

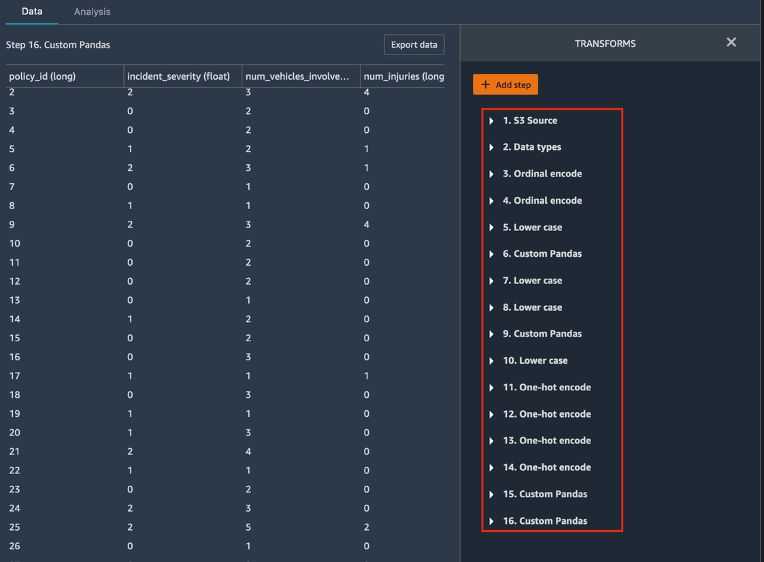

Aloitamme luomalla Data Wrangler -virran, jota kutsutaan myös a tietovirta, käyttämällä tiedonkulun käyttöliittymä kautta Amazon SageMaker Studio IDE. Esimerkkitietojoukomme koostuu kahdesta tiedostosta: väitteet.csv ja asiakkaat.csv, jotka on tallennettu Amazonin yksinkertainen tallennuspalvelu (Amazon S3) ämpäri. Käytämme datavirran käyttöliittymää Data Wranglerin soveltamiseen sisäänrakennetut muunnokset tällainen kategorinen koodaus, merkkijonomuotoilu ja imputointi ominaisuussarakkeisiin kussakin näistä tiedostoista. Haemme myös mukautettu muunnos muutamaan ominaisuussarakkeeseen käyttämällä muutamaa riviä mukautettua Python-koodia Pandas DataFrame. Seuraavassa kuvakaappauksessa näkyvät tietovirran käyttöliittymän väites.csv-tiedostoon tehdyt muunnokset.

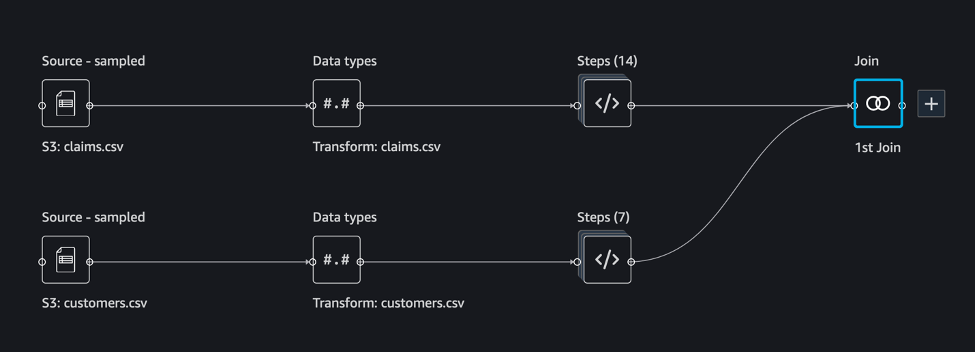

Lopuksi yhdistämme kahden datatiedoston sovellettujen muunnosten tulokset luodaksemme yhden harjoitustietojoukon malliharjoittelua varten. Käytämme Data Wranglerin sisäänrakennettua liitä tietojoukkoja ominaisuus, jonka avulla voimme suorittaa SQL:n kaltaisia liitosoperaatioita taulukkotiedoilla. Seuraava kuvakaappaus näyttää datavirran Studion tietovirran käyttöliittymässä. Katso vaiheittaiset ohjeet tietovirran luomiseksi Data Wranglerin avulla GitHub-arkisto.

Voit nyt käyttää datavirtatiedostoa (.flow) datamuunnosten tekemiseen raakadatatiedostoillemme. Tietovirran käyttöliittymä voi automaattisesti luoda Python-muistikirjoja käytettäväksi ja integroitavaksi suoraan Pipelinesin kanssa SageMaker SDK:n avulla. Step Functionsille käytämme AWS-vaihefunktiot Data Science Python SDK integroidaksemme Data Wrangler -käsittelymme Step Functions -putkilinjaan. Amazon MWAA:lle käytämme a mukautettu ilmavirran operaattori ja Airflow SageMaker -operaattori. Käsittelemme jokaista näistä lähestymistavoista yksityiskohtaisesti seuraavissa osissa.

Integroi Data Wrangler putkistojen kanssa

SageMaker Pipelines on natiivi työnkulun organisointityökalu ML-putkien rakentamiseen, jotka hyödyntävät suoraa SageMaker-integraatiota. Kanssa SageMaker-mallirekisteri, Pipelines parantaa ML-työnkulkujesi toiminnallista joustavuutta ja toistettavuutta. Näiden työnkulun automaatiokomponenttien avulla voit helposti skaalata kykyäsi rakentaa, kouluttaa, testata ja ottaa käyttöön satoja tuotantomalleja. iteroida nopeammin; vähentää manuaalisesta orkestroinnista johtuvia virheitä; ja rakentaa toistettavia mekanismeja. Jokainen liukuhihnan vaihe voi seurata sukulinjaa, ja välivaiheet voidaan tallentaa välimuistiin liukuhihnan nopeaa uudelleen ajamista varten. Sinä pystyt luoda putkia SageMaker Python SDK:n avulla.

SageMaker-liukuhihnalla rakennettu työnkulku koostuu vaiheista, jotka muodostavat suunnatun asyklisen graafin (DAG). Tässä esimerkissä aloitamme kirjaimella a käsittelyvaihe, joka ajaa a SageMaker-työ Data Wranglerin vuotiedoston perusteella harjoitustietojoukon luomiseksi. Jatkamme sitten a:lla koulutusvaihe, jossa harjoittelemme XGBoost-mallia käyttämällä SageMakerin sisäänrakennettua XGBoost-algoritmia ja edellisessä vaiheessa luotua koulutustietojoukkoa. Kun malli on koulutettu, lopetamme tämän työnkulun a RekisteröidyMalli vaihe rekisteröidäksesi koulutetun mallin SageMaker-mallirekisteriin.

Asennus ja läpikäynti

Tämän näytteen suorittamiseen käytämme Jupyter-muistikirjaa, joka käyttää Python3:a Data Science -ytimen näköistiedostossa Studio-ympäristössä. Voit myös suorittaa sen Jupyter-kannettavan ilmentymän kanssa paikallisesti koneellasi määrittämällä valtuustiedot ottamaan SageMaker-suoritusroolin. Muistikirja on kevyt ja sitä voidaan käyttää ml.t3.medium-esiintymässä. Yksityiskohtaiset vaiheittaiset ohjeet löytyvät GitHub-arkisto.

Voit joko käyttää Data Wranglerin vientiominaisuutta luodaksesi Pipelines-koodin tai rakentaa oman skriptin tyhjästä. Esimerkkivarastossamme käytämme molempien lähestymistapojen yhdistelmää yksinkertaisuuden vuoksi. Korkealla tasolla seuraavat vaiheet Pipelines-työnkulun luomiseksi ja suorittamiseksi:

- Luo vuotiedosto Data Wranglerista tai käytä asennuskomentosarjaa vuotiedoston luomiseen valmiiksi määritetystä mallista.

- Luo Amazonin yksinkertainen tallennuspalvelu (Amazon S3) ämpäriin ja lataa virtaustiedostosi ja syöttötiedostot ämpäriin. Esimerkkimuistikirjassamme käytämme SageMakerin oletusarvoista S3-ämpäriä.

- Noudata muistikirjan ohjeita luodaksesi prosessori-objektin Data Wrangler -vuotiedoston perusteella ja Estimator-objekti harjoitustyön parametreillä.

- Koska käytämme esimerkissämme vain SageMaker-ominaisuuksia ja oletusarvoista S3-säilöä, voimme käyttää Studion oletussuoritusroolia. Sama AWS-henkilöllisyyden ja käyttöoikeuksien hallinta (IAM) roolin ottavat putkiajon, käsittelytyön ja koulutustyön. Voit mukauttaa suoritusroolia edelleen vähimmäisoikeuksien mukaan.

- Jatka ohjeiden avulla luodaksesi liukuhihnan vaiheilla, jotka viittaavat prosessori- ja arviointiobjekteihin, ja suorita sitten liukuhihna. Käsittely- ja koulutustyöt suoritetaan SageMaker-hallituissa ympäristöissä ja kestää muutaman minuutin.

- Studiossa voit nähdä liukuhihnan tiedot valvovat liukuhihnan ajoa. Voit myös seurata taustalla olevia käsittely- ja koulutustöitä SageMaker-konsolista tai osoitteesta amazonin pilvikello.

Integroi Data Wrangler askelfunktioilla

Step Functionsin avulla voit ilmaista monimutkaista liiketoimintalogiikkaa matalakoodisina, tapahtumapohjaisina työnkulkuina, jotka yhdistävät erilaisia AWS-palveluita. The Vaihefunktiot Data Science SDK on avoimen lähdekoodin kirjasto, jonka avulla datatieteilijät voivat luoda työnkulkuja, jotka voivat esikäsitellä tietojoukkoja ja rakentaa, ottaa käyttöön ja valvoa ML-malleja SageMakerin ja Step Functionsin avulla. Step Functions perustuu tilakoneisiin ja tehtäviin. Step Functions luo työnkulkuja kutsutuista vaiheista toteaa, ja ilmaisee tämän työnkulun Amazonin osavaltion kieli. Kun luot työnkulun Step Functions Data Science SDK:lla, se luo tilakoneen, joka edustaa työnkulkuasi ja vaiheita Step Functionsissa.

Tätä käyttötapausta varten rakensimme Step Functions -työnkulun tässä viestissä käytettyyn yleiseen malliin, joka sisältää käsittelyvaiheen, koulutusvaiheen ja RegisterModel askel. Tässä tapauksessa tuomme nämä vaiheet Step Functions Data Science Python SDK:sta. Ketjaamme nämä vaiheet samassa järjestyksessä askelfunktioiden työnkulun luomiseksi. Työnkulku käyttää Data Wranglerista luotua vuotiedostoa, mutta voit myös käyttää omaa Data Wrangler -vuotiedostoasi. Käytämme uudelleen joitakin Data Wranglerin koodia vientiominaisuus Yksinkertaisuuden vuoksi. Suoritamme Data Wrangler -virtaustiedoston luoman tiedon esikäsittelylogiikkaa harjoitustietojoukon luomiseksi, mallin kouluttamiseksi XGBoost-algoritmin avulla ja opetetun malliartefaktin tallentamiseksi SageMaker-mallina. Lisäksi GitHubin repossa näytämme myös, kuinka Step Functions antaa meille mahdollisuuden yrittää havaita virheitä ja käsitellä epäonnistumisia ja uudelleenyrityksiä FailStateStep ja CatchStateStep.

Tuloksena oleva vuokaavio, kuten seuraavassa kuvakaappauksessa näkyy, on käytettävissä Step Functions -konsolissa työnkulun alkamisen jälkeen. Tämä auttaa datatieteilijöitä ja insinöörejä visualisoimaan koko työnkulun ja sen jokaisen vaiheen sekä käyttämään linkitettyjä CloudWatch-lokeja jokaisessa vaiheessa.

Asennus ja läpikäynti

Tämän näytteen suorittamiseen käytämme Python-muistikirjaa, joka on käynnissä Data Science -ytimen kanssa Studio-ympäristössä. Voit myös suorittaa sen Python-muistikirjan esiintymän paikallisesti koneellasi määrittämällä valtuustiedot ottamaan SageMaker-suoritusroolin. Kannettava tietokone on kevyt ja sitä voidaan käyttää esimerkiksi t3 medium -instanssissa. Yksityiskohtaiset vaiheittaiset ohjeet löytyvät GitHub-arkisto.

Voit joko käyttää Data Wranglerin vientiominaisuutta luodaksesi Pipelines-koodin ja muokataksesi sitä Step Functionsille tai rakentaa oman skriptin tyhjästä. Esimerkkivarastossamme käytämme molempien lähestymistapojen yhdistelmää yksinkertaisuuden vuoksi. Korkealla tasolla seuraavat vaiheet Step Functions -työnkulun luomiseksi ja suorittamiseksi:

- Luo vuotiedosto Data Wranglerista tai käytä asennuskomentosarjaa vuotiedoston luomiseen valmiiksi määritetystä mallista.

- Luo S3-säilö ja lataa flow-tiedostosi ja syöttötiedostot säilöyn.

- Määritä SageMaker-suoritusrooli vaadituilla käyttöoikeuksilla, kuten aiemmin mainittiin. Katso tarkemmat ohjeet GitHub-arkistosta.

- Noudata ohjeita suorittaaksesi muistikirjan arkistossa työnkulun aloittamiseksi. Käsittelytyö suoritetaan SageMakerin hallinnoimassa Spark-ympäristössä ja voi kestää muutaman minuutin.

- Siirry Step Functions -konsoliin ja seuraa työnkulkua visuaalisesti. Voit myös navigoida linkitettyihin CloudWatch-lokeihin virheiden korjaamiseksi.

Käydään läpi joitain tärkeitä koodin osia täällä. Työnkulun määrittelemiseksi määritämme ensin vaiheet vaihefunktion tilakoneen työnkulussa. Ensimmäinen askel on data_wrangler_step tietojenkäsittelyä varten, joka käyttää Data Wrangler -vuotiedostoa syötteenä raakadatatiedostojen muuntamiseen. Määrittelemme myös mallin koulutusvaiheen ja mallin luomisvaiheen nimeltä training_step ja model_step, vastaavasti. Lopuksi luomme työnkulun ketjuttamalla kaikki luomamme vaiheet seuraavan koodin mukaisesti:

Esimerkissämme rakensimme työnkulun ottamaan töiden nimet parametreiksi, koska ne ovat ainutlaatuisia ja ne on luotava satunnaisesti jokaisen liukuhihnan ajon aikana. Välitämme nämä nimet, kun työnkulku suoritetaan. Voit myös ajastaa Step Functions -työnkulun toimimaan CloudWatchin avulla (katso Ajoita palvelimeton työnkulku AWS Step Functions -toiminnolla ja Amazon CloudWatchin avulla), kutsutaan käyttämällä Amazon S3 -tapahtumat, tai vedetty osoitteesta Amazon EventBridge (Ks. Luo EventBridge-sääntö, joka käynnistää Step Functions -työnkulun). Esittelytarkoituksiin voimme kutsua Step Functions -työnkulkua Step Functions -konsolin käyttöliittymästä tai käyttämällä seuraavaa muistikirjan koodia.

Integroi Data Wrangler Apache Airflow -sovellukseen

Toinen suosittu tapa luoda ML-työnkulkuja on Apache Airflow -käyttö. Apache Airflow on avoimen lähdekoodin alusta, jonka avulla voit luoda, ajoittaa ja valvoa työnkulkuja ohjelmallisesti. Amazon MWAA helpottaa päästä päähän ML-putkilinjojen määrittämistä ja käyttöä Apache Airflow -pilvessä mittakaavassa. Airflow-putkisto koostuu sarjasta tehtäviä, joita kutsutaan myös nimellä a työnkulku. Työnkulku määritellään DAG:ksi, joka kapseloi tehtävät ja niiden väliset riippuvuudet ja määrittelee, kuinka niiden tulee toimia työnkulussa.

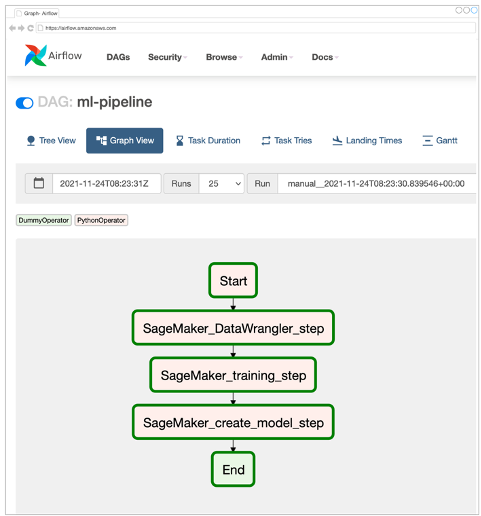

Loimme Airflow DAG:n Amazon MWAA -ympäristöön toteuttaaksemme MLOps-työnkulkumme. Jokainen työnkulun tehtävä on Python-ohjelmointikielellä kirjoitettu suoritettava yksikkö, joka suorittaa jonkin toiminnon. Tehtävä voi olla joko operaattori tai sensori. Meidän tapauksessamme käytämme an Airflow Python-operaattori yhdessä SageMaker Python SDK Data Wrangler Python -komentosarjan suorittamiseen ja Airflown alkuperäisen tuen käyttämiseen SageMaker-operaattorit kouluttaa SageMakerin sisäänrakennettua XGBoost-algoritmia ja luoda mallin tuloksena olevista esineistä. Loimme myös hyödyllisen mukautetun Data Wrangler -operaattorin (SageMakerDataWranglerOperator) Apache Airflowlle, jota voit käyttää Data Wrangler -virtaustiedostojen käsittelyyn tietojenkäsittelyä varten ilman lisäkoodia.

Seuraavassa kuvakaappauksessa näkyy Airflow DAG, jossa on viisi vaihetta MLOps-työnkulkumme toteuttamiseksi.

Aloitusvaihe käyttää Python-operaattoria kokoonpanojen alustamiseen työnkulun muiden vaiheiden osalta. SageMaker_DataWrangler_Step käyttötarkoituksiin SageMakerDataWranglerOperator ja aiemmin luomamme tietovirtatiedosto. SageMaker_training_step ja SageMaker_create_model_step käytä sisäänrakennettuja SageMaker-operaattoreita mallin koulutukseen ja mallin luomiseen. Amazon MWAA -ympäristömme käyttää pienintä ilmentymätyyppiä (mw1.small), koska suurin osa käsittelystä tapahtuu Processing jobs -toiminnolla, joka käyttää omaa ilmentymätyyppiään, joka voidaan määrittää työnkulun konfigurointiparametreiksi.

Asennus ja läpikäynti

Yksityiskohtaiset vaiheittaiset asennusohjeet tämän ratkaisun käyttöönottamiseksi löytyvät sivustostamme GitHub-arkisto. Käytimme Jupyter-muistikirjaa Python-koodisoluilla Airflow DAG:n määrittämiseen. Olettaen, että olet jo luonut tietovirtatiedoston, seuraava on korkeatasoinen yleiskatsaus asennusvaiheista:

- Luo S3-ämpäri ja myöhemmät Amazon MWAA:n vaatimat kansiot.

- Luo Amazon MWAA -ympäristö. Huomaa, että käytimme Airflow-versiota 2.0.2 tähän ratkaisuun.

- Luo ja lataa a

requirements.txttiedosto, jossa on kaikki Airflow-tehtävien vaatimat Python-riippuvuudet ja lähetä se tiedostoon/requirementshakemistoon Amazon MWAA:n ensisijaisen S3-säihön sisällä. Hallittu Airflow-ympäristö käyttää tätä Python-riippuvuuksien asentamiseen. - Lataa

SMDataWranglerOperator.pytiedosto tiedostoon/dagshakemistosta. Tämä Python-skripti sisältää koodin mukautetulle Airflow-operaattorille Data Wranglerille. Tätä operaattoria voidaan käyttää minkä tahansa .flow-tiedoston käsittelyyn. - Luo ja lataa

config.pykäsikirjoitus/dagshakemistosta. Tätä Python-komentosarjaa käytetään DAG:n ensimmäisessä vaiheessa työnkulun muiden vaiheiden edellyttämien määritysobjektien luomiseen. - Luo ja lataa lopuksi

ml_pipelines.pytiedosto tiedostoon/dagshakemistosta. Tämä komentosarja sisältää DAG-määrityksen Airflow-työnkululle. Tässä määritämme jokaisen tehtävän ja määritämme niiden väliset riippuvuudet. Amazon MWAA äänestää säännöllisesti/dagshakemistoon tämän komentosarjan suorittamiseksi DAG:n luomiseksi tai nykyisen ohjelman päivittämiseksi uusimmilla muutoksilla.

Seuraava koodi on SageMaker_DataWrangler_step, joka käyttää mukautettua SageMakerDataWranglerOperator. Vain muutamalla rivillä koodia DAG-määritelmä Python-skriptissäsi voit osoittaa SageMakerDataWranglerOperator Data Wrangler -virtaustiedoston sijaintiin (joka on S3-sijainti). Kulissien takana tämä operaattori käyttää SageMaker Processing työpaikan käsitelläksesi .flow-tiedoston määrittääksesi muunnokset raakadatatiedostoihisi. Voit myös määrittää esiintymän tyyppi ja Data Wrangler -käsittelytyön tarvitsemien esiintymien lukumäärä.

- config parametri hyväksyy sanakirjan (avainarvoparit) käsittelytyön vaatimista lisämäärityksistä, kuten lopullisen tulostiedoston lähtöliitteen, tulostiedoston tyypin (CSV tai Parquet) ja sisäänrakennetun Data Wrangler -säilön URI:n. kuva. Seuraava koodi on mitä config sanakirja for SageMakerDataWranglerOperator näyttää. Nämä kokoonpanot vaaditaan SageMaker-käsittelyyn suoritin. Lisätietoja kustakin näistä konfigurointiparametreista on kohdassa sagemaker.processing.Processor().

Puhdistaa

Vältä tulevia maksuja poistamalla käyttöönottamillesi ratkaisuille luodut resurssit.

- Noudata näitä ohjeet tarjotaan GitHub-arkistossa SageMaker Pipelines -ratkaisun luomien resurssien puhdistamiseen.

- Noudata näitä ohjeet tarjotaan GitHub-arkistossa Step Functions -ratkaisun luomien resurssien puhdistamiseksi.

- Noudata näitä ohjeet tarjotaan GitHub-arkistossa Amazon MWAA -ratkaisun luomien resurssien puhdistamiseen.

Yhteenveto

Tämä viesti osoitti, kuinka voit helposti integroida Data Wranglerin joihinkin AWS:n tunnettuihin työnkulun automaatio- ja orkestrointitekniikoihin. Tarkastelimme ensin esimerkkikäyttötapausta ja -arkkitehtuuria ratkaisulle, joka käyttää Data Wrangleria tietojen esikäsittelyyn. Sitten osoitimme, kuinka voit integroida Data Wranglerin Pipelines-, Step Functions- ja Amazon MWAA:n kanssa.

Seuraavana vaiheena voit etsiä ja kokeilla koodinäytteitä ja muistikirjoja sivuiltamme GitHub-arkisto käyttämällä yksityiskohtaisia ohjeita jokaiselle tässä viestissä käsitellylle ratkaisulle. Lisätietoja siitä, kuinka Data Wrangler voi auttaa ML-työkuormissa, on Data Wranglerissa Tuotesivu ja Valmista ML-tiedot Amazon SageMaker Data Wrangler -sovelluksella.

Tietoja kirjoittajista

Rodrigo Alarcon on vanhempi ML Strategy Solutions -arkkitehti AWS:llä Santiagosta, Chilestä. Rodrigo auttaa erikokoisia yrityksiä luomaan liiketoimintatuloksia pilvipohjaisten AI- ja ML-ratkaisujen avulla. Hänen kiinnostuksen kohteitaan ovat koneoppiminen ja kyberturvallisuus.

Rodrigo Alarcon on vanhempi ML Strategy Solutions -arkkitehti AWS:llä Santiagosta, Chilestä. Rodrigo auttaa erikokoisia yrityksiä luomaan liiketoimintatuloksia pilvipohjaisten AI- ja ML-ratkaisujen avulla. Hänen kiinnostuksen kohteitaan ovat koneoppiminen ja kyberturvallisuus.

Ganapathi Krishnamoorthi on vanhempi ML Solutions -arkkitehti AWS:ssä. Ganapathi tarjoaa ohjeellisia ohjeita startup- ja yritysasiakkaille, jotka auttavat heitä suunnittelemaan ja ottamaan käyttöön pilvisovelluksia laajassa mittakaavassa. Hän on erikoistunut koneoppimiseen ja keskittyy auttamaan asiakkaita hyödyntämään tekoälyä/ML:ää liiketoimintansa tulosten saavuttamiseksi. Kun hän ei ole töissä, hän nauttii ulkoilusta ja musiikin kuuntelusta.

Ganapathi Krishnamoorthi on vanhempi ML Solutions -arkkitehti AWS:ssä. Ganapathi tarjoaa ohjeellisia ohjeita startup- ja yritysasiakkaille, jotka auttavat heitä suunnittelemaan ja ottamaan käyttöön pilvisovelluksia laajassa mittakaavassa. Hän on erikoistunut koneoppimiseen ja keskittyy auttamaan asiakkaita hyödyntämään tekoälyä/ML:ää liiketoimintansa tulosten saavuttamiseksi. Kun hän ei ole töissä, hän nauttii ulkoilusta ja musiikin kuuntelusta.

Anjan Biswas on vanhempi AI-palveluratkaisuarkkitehti, joka keskittyy tekoälyyn/ML:ään ja data-analyysiin. Anjan on osa maailmanlaajuista tekoälypalvelutiimiä ja työskentelee asiakkaiden kanssa auttaakseen heitä ymmärtämään tekoälyn ja ML:n liiketoimintaongelmia ja kehittämään niihin ratkaisuja. Anjanilla on yli 14 vuoden kokemus työskentelystä maailmanlaajuisten toimitusketju-, valmistus- ja vähittäismyyntiorganisaatioiden kanssa, ja hän auttaa aktiivisesti asiakkaita pääsemään alkuun ja skaalaamaan AWS AI -palveluita.

Anjan Biswas on vanhempi AI-palveluratkaisuarkkitehti, joka keskittyy tekoälyyn/ML:ään ja data-analyysiin. Anjan on osa maailmanlaajuista tekoälypalvelutiimiä ja työskentelee asiakkaiden kanssa auttaakseen heitä ymmärtämään tekoälyn ja ML:n liiketoimintaongelmia ja kehittämään niihin ratkaisuja. Anjanilla on yli 14 vuoden kokemus työskentelystä maailmanlaajuisten toimitusketju-, valmistus- ja vähittäismyyntiorganisaatioiden kanssa, ja hän auttaa aktiivisesti asiakkaita pääsemään alkuun ja skaalaamaan AWS AI -palveluita.

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- Amazonin hallinnoimat työnkulut Apache Airflowlle (Amazon MWAA)

- Amazon Sage Maker

- Amazon SageMaker Data Wrangler

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- AWS-koneoppiminen

- AWS-vaihetoiminnot

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- syvä oppiminen

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- zephyrnet