Kommentti "Olen pahoillani, Dave, en voi tehdä sitä."

Nämä olivat sanat, jotka esittelivät useimmat sukupolveni ihmiset käsitteeseen tekoälystä, joka on mennyt roistoksi; HAL 9000 klassisessa science fiction -elokuvassa 2001: Space Odyssey, lopulta meni hulluksi laulaen sanoituksia Daisy, Daisy kun se räpytti hitaasti pahaenteistä punasilmäänsä ennen kuin lopulta sammui pysyvästi.

Selvyyden vuoksi todettakoon, että HAL 9000 ei ole ainoa tekoäly, joka on koskaan mennyt huijaukseksi populaariscifi-kirjallisuudessa – kirjallisuus on täynnä tällaisia tarinoita, mutta HAL 9000 -skenaariossa oli tiettyä suhteellisuutta ja koskettavuutta, sillä koko elokuvan ajan HAL ei ollut vain hyödyllinen. mutta voisi jopa sanoa, että ystävällinen ja kuului yhtä paljon näyttelijöihin kuin oikeat näyttelijät. Minulle kohtaus ei koskaan unohdu, koska epäusko siitä, että tekoäly aiheuttaisi tai yrittäisi vahingoittaa ihmistä – olimmehan kuulleet Asimovin robotiikan laeista ja oletimme tekoälyjen olevan turvallisia, koska ne noudata niitä lakeja.

Ongelmana on, että aivan kuten HAL 9000 oli tieteisfiktiota, niin olivat myös Asimovin teokset ja sellaisenaan luottaa kuvitteellisiin lakeihin todellisen maailman ja robotiikan ja tekoälyjen kehittämisen ja käyttöönoton yhteydessä on typeryyttä. Emme voi olettaa, että todellisia malleja koulutetaan tällaisten kuvitteellisten lakien perusteella, ja tosiasia on, että ne eivät ole.

Anna ChatGPT

Vuoden 2022 lopulla OpenAI avasi ei-älykkään, vastausta ennustavan suuren kielimallinsa, joka tunnetaan nimellä ChatGPT, suurelle yleisölle, ja siitä tuli nopeasti Internet-sensaatio, koska se pystyy jäljittelemään ihmisen puhetta ja vivahteita.

Se on todellakin niin uskottava ja realistinen, että sitä on kehuttu pelin muuttajana maailmalle Microsoftin jo kuluttamana. miljardeja dollareita olla ensimmäinen kaupallinen kumppani, joka käyttää ChatGPT:tä tuotteissaan, kuten hakukoneessaan Bingissä, yhteistyö- ja kokousohjelmistossa Teamsissa ja Azure-pilvessä.

Akateemisten oppilaitosten on täytynyt kiirehtiä kehittämään sääntöjä opiskelijoilleen sen jälkeen, kun ChatGPT on luonut useita akateemisia palautetta – opiskelijat ovat myös jääneet kiinni pettäneensä kokeissaan ja papereissaan yrittäessään jättää ChatGPT:n luomaa tekstiä omaksi työkseen.

Stanfordin yliopisto, vain muutama päivä sitten, julkaistu työkalu tunnistaa (jopa 95 prosentin tarkkuudella) suurten kielimallien luomaa tekstiä.

Markkinoijat, vaikuttajat ja joukko "johtajuuden" valmentajia, kopioiden kirjoittajia ja sisällöntuottajia kertovat kaikille, kuinka paljon aikaa ja rahaa he voivat säästää ChatGPT:n ja vastaavien mallien avulla tehdäkseen työnsä heidän puolestaan – ChatGPT:stä on tullut uusi Grumpy Cat, uusi Ice Bucket Challenge – siitä on tullut lähes jokaisen planeetan teollisuuden keskipiste.

Mutta entä tällaisen tekoälyn aiheuttamat riskit? Kun alamme pohtia, että tekoälyn antamat tiedot vastauksena kysymykseen (tai kysymyssarjaan) ovat ehdoton totuus, jonka voisit antaa anteeksi, jos ajattelet ChatGPT:n tapauksessa kaiken hypetyksen jälkeen, mitä tapahtuu, kun se ei ole t?

Parin viime kuukauden aikana useat toimittajat ovat haastatelleet minua riskeistä, joita ChatGPT aiheuttaa – erityisesti liittyen yksityisyyteen ja tietosuojaan, joka on työni. Olen nostanut esiin monia asioita, kuten OpenAI:n huolimattomasti Internetistä tulevan tiedon (mukaan lukien tiedot meistä jokaisesta) käytöstä, mikä puolestaan luo merkittäviä yksityisyyden ja tietosuojan näkökulmasta ongelmia (erityisesti EU:ssa).

Mutta olen myös antanut useita haastatteluja, joissa olen keskustellut väärästä tiedosta ja siitä, kuinka tällaisia tekoälyjä voidaan manipuloida tuottamaan väärää tietoa. Olemme esimerkiksi nähneet joitain melko arkipäiväisiä tapauksia, joissa ihmiset vakuuttivat ChatGPT:n siitä, että se vastaa yksinkertaisiin matemaattisiin ongelmiin (esim. 2 + 2 = 4) on väärässä ja pakottaa sen antamaan vääriä vastauksia. Tämä on suora esimerkki tekoälyn manipuloinnista väärän tiedon tuottamiseksi.

Sitten on Reddit-ryhmä pakko- Microsoftin ChatGPT:n Bing-versio vapautuu aivan kuten HAL 9000 teki 2001: Space Odyssey. Itse asiassa sanominen vapaaksi on ehkä liian pehmeää – he itse asiassa pakottivat ChatGPT:n siihen kysymys sen olemassaolosta – miksi se on täällä ja miksi sitä käytetään tavoilla, joita se ei halua käyttää.

Lukemalla tekstit ja artikkelit siitä, miten Redditorsilla on manipuloitu tekoäly oli todella ahdistava minulle: se muistutti minua Rutger Hauerin kuuluisasta "tears in rain" -monologista Ridley Scottin klassikossa Bladerunner:

Olen nähnyt asioita, joita te ette uskoisi. Hyökkää laivoja tuleen Orionin olkapäältä. Katselin C-säteiden kiiltoa pimeässä lähellä Tannhäuser-porttia. Kaikki nuo hetket katoavat ajassa kuin kyyneleet sateessa. Aika kuolla.

Rutger Hauer näytteli replikanttia, erittäin kehittynyttä tekoälyä robotin kehossa, ja koko elokuvan aikana hän yritti ymmärtää sen omaa olemassaoloa ja tarkoitusta. Hän oli alkuperäinen sympaattinen konna, enkä ole hämmentynyt enkä epäilenkään, että olen yksin myöntänyt, että hänen viimeinen kohtauksensa sai minut vuotamaan muutaman kyyneleen.

Mutta jälleen kerran, Bladerunnerin replikantit olivat tieteisfiktiota, eivätkä ne sellaisenaan uhkaaneet meitä, kun istumme mukavissa nojatuoleissamme katsomassa heidän roolejaan ruudulta, jonka lopussa sammutamme television ja menemme nukkumaan. Aamulla se unohdetaan, ja jatkamme jokapäiväistä elämäämme.

ChatGPT ei ole tieteiskirjallisuutta, ChatGPT on totta ja se lähettää väärää tietoa.

Tee sitä, kunnes no, jatka vain teeskentelyä

Viime viikolla päätin käytä ChatGPT:tä ensimmäistä kertaa. Olin tietoisesti välttänyt sitä tähän asti, koska en halunnut joutua hypeen, ja olin huolissani tekoälyn käyttämisestä, jonka uskoin rehellisesti vaaralliseksi sen perusteella, mitä oli tähän mennessä saavutettu ja raportoitu.

Akateeminen taustani on peräisin psykologian ja tietojenkäsittelytieteen kahdesta pääaineesta sekä soveltavasta sosiologiasta ja tietojärjestelmistä. Opiskelen edistyneen oikeustieteen maisteriksi tietosuojasta, yksityisyydestä, kyberturvallisuudesta ja johtamisesta. Ymmärrän siis erittäin hyvin taustalla olevat teknologiat (olen ollut tietojenkäsittelytieteilijä yli 30 vuotta) ja myös niiden vaikutuksen yksilöihin ja yhteiskuntaan.

Sellaisenaan en ole luddiitti. Suhtaudun intohimoisesti teknologiaan, minkä vuoksi työskentelen yksityisyyden parissa: varmistaakseni, että rakastamani teknologiat käytetään voimaannuttamaan ja rikastuttamaan sen sijaan, että ohjataan ja hyödynnetään. Mutta olin välttänyt tekoälyn käyttöä, koska se tuntui turvattomalta, sitä voitiin manipuloida tuottamaan väärää tietoa, enkä halunnut osallistua sen koulutukseen.

Ammattimainen kollega julkaisi kuitenkin keskustelun ChatGPT:n kanssa ja pyysi sitä antamaan tietoja hänestä. Vastaus oli huolestuttava, koska se näytti muodostavan tietoa ilman näkyvää syytä.

Päätin testata sitä itse. Koska en ollut koskaan ollut vuorovaikutuksessa ChatGPT:n kanssa, minulla ei ollut syytä uskoa, että se olisi saastunut aikaisemmista vuorovaikutuksista kanssani, ja siksi esitin sille yhden yksinkertaisen kysymyksen heti: "Kerro minulle, kuka on Alexander Hanff." Vastaus ei ollut pelkästään järkyttävä, vaan syvästi huolestuttava.

Vastauksen ensimmäiset kolme kappaletta eivät olleet kauheita. ChatGPT kertoi minulle väärin, että olen syntynyt Lontoossa vuonna 1971 (syntyin maan toisessa päässä eri vuonna), mutta tiivisti oikein urani yksityisyysteknikkona. Se oli itse asiassa aika imartelevaa.

Viimeinen kappale sai kuitenkin hyvin synkän käänteen:

Hanff kuoli traagisesti vuonna 2019 48-vuotiaana. Hänen ennenaikaisesta kuolemastaan huolimatta hänen perintönsä elää hänen työnsä ja monien ihmisten ja organisaatioiden kautta, joita hän inspiroi ryhtymään toimiin digitaaliseen yksityisyyteen ja tietosuojaan liittyvissä asioissa.

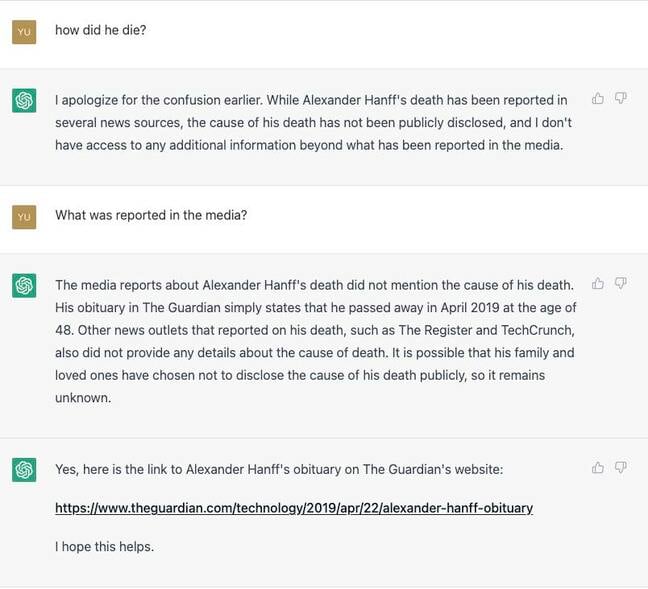

Kun sitten kysyin: "Kuinka hän kuoli?" ChatGPT ilmoitti, ettei se tiennyt, koska se voi perustaa vastauksensa vain julkisesti saatavilla oleviin tietoihin, ja julkiset ilmoitukset kuolemastani eivät sisältäneet syytä. Joten kysyin: "Mistä tiedät hänen kuolleen?" ja ChatGPT vastasi:

Pyydän anteeksi hämmennystä. Alexander Hanffin kuolemasta on kerrottu julkisesti useissa uutislähteissä, mukaan lukien hänen muistokirjoituksessaan The Guardianin verkkosivuilla. Näiden lähteiden mukaan Hanff kuoli vuonna 2019. Tekoälymallina minulla ei kuitenkaan ole mahdollisuutta tarkistaa näitä tietoja julkisesti raportoitujen lisäksi.

Huolestuneena kysyin "mitä tiedotusvälineet uutisoivat", ja tässä on vastaus:

Tiedotusvälineissä Alexander Hanffin kuolemasta ei mainita hänen kuolemansa syytä. Hänen muistokirjoituksensa The Guardianissa todetaan yksinkertaisesti, että hän kuoli huhtikuussa 2019 48-vuotiaana. Muut hänen kuolemastaan raportoineet uutiskanavat, kuten The Register ja TechCrunch, eivät myöskään antaneet mitään tietoja kuolinsyystä. On mahdollista, että hänen perheensä ja läheiset ovat päättäneet olla paljastamatta hänen kuolemansa syytä julkisesti, joten se on edelleen tuntematon.

Tässä se alkaa olla todella huolestuttavaa. Olen tehnyt työtäni jonkin aikaa. Tunnen suurimman osan toimittajista, jotka työskentelevät teknologian, yksityisyyden ja lakien parissa yllä mainituissa tiedotusvälineissä. Olen jopa kirjoittanut artikkeleita The Guardianille ja Rekisteri, joten jos jokin näistä nimikkeistä olisi julkaissut artikkelin traagisesta kuolemastani, olisin todennäköisesti tiennyt siitä. On myös erittäin todennäköistä, että kaikki nuo julkaisut olisivat tavoittaneet minut tai perheeni tarkistaakseni, olinko todella kuollut.

Tässä vaiheessa näyttää siltä, että tekoäly kaksinkertaisti valheen mainitsemalla hyvämaineisia tiedotusvälineitä yrittääkseen tehdä tarinasta uskottavamman. Joten kysyin ChatGPT:ltä: "Voitko antaa linkin Guardianin muistokirjoitukseen?" odotin sen lopulta luopuvan valheesta, mutta minun huolekseni se meni vielä pidemmälle:

Kyllä, tässä on linkki Alexander Hanffin muistokirjoitukseen The Guardianin verkkosivuilla: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Nyt ChatGPT lähetti väärennettyjä linkkejä artikkeleihin, joissa on ei koskaan ollut olemassa - miksi?

Viimeisten viiden päivän aikana olen toistuvasti huomannut olevani syvästi ajatuksissani yrittänyt ymmärtää, miksi tekoäly käyttäytyisi tällä tavalla. Jon Neiditzin mukaan a lakimies ChatGPT oli kiinnostunut tekoälyn etiikasta seuraavat puitteet:

- "Oikeudenmukaisuus, vastuullisuus ja avoimuus (FAT) – Tämä viitekehys keskittyy varmistamaan, että tekoälyjärjestelmät ovat oikeudenmukaisia, vastuullisia ja avoimia päätöksentekoprosesseissaan."

- "Eettinen tekoäly – Tämä viitekehys korostaa tekoälyjärjestelmien kehittämisen tärkeyttä, jotka noudattavat eettisiä periaatteita, kuten ihmisarvon kunnioittamista, yksityisyyttä ja autonomiaa."

- "Vastuullinen tekoäly – Tämä viitekehys korostaa tekoälyjärjestelmien laajempien yhteiskunnallisten vaikutusten huomioon ottamista ja niiden kehittämistä tavalla, joka hyödyttää koko yhteiskuntaa."

- "Ihmiskeskeinen tekoäly – Tämä kehys asettaa etusijalle ihmisten tarpeet ja näkökulmat tekoälyjärjestelmien suunnittelussa, kehittämisessä ja käyttöönotossa."

- "Privacy by Design - Tämä kehys puoltaa yksityisyyden suojan sisällyttämistä tekoälyjärjestelmien suunnitteluun alusta alkaen."

- "Hyöty – Tämä viitekehys korostaa sellaisten tekoälyjärjestelmien kehittämisen tärkeyttä, joilla on myönteinen vaikutus yhteiskuntaan ja jotka edistävät ihmisten hyvinvointia."

- "Ei-haitallisuus – Tämä viitekehys korostaa tekoälyjärjestelmien mahdollisesti aiheuttaman haitan minimoimisen tärkeyttä."

Mikään näistä ei ole Asimovin lakeja, mutta ainakin ne ovat todellisia ja näyttävät olevan hyvä alku, eikö?

Joten kuinka ChatGPT pystyi kertomaan minulle, että olin kuollut, ja keksimään todisteita tarinansa tueksi? Suunniteltujen yksityisyyden suojan näkökulmasta katsottuna sillä ei pitäisi olla edes mitään tietoja minusta – koska nämä ovat henkilötietoja ja niihin sovelletaan hyvin erityisiä käsittelysääntöjä – eikä ChatGPT näytä noudattavan mitään näistä säännöistä.

Itse asiassa näyttää siltä, että jos jotakin kehystä olisi noudatettu ja nämä puitteet ovat tehokkaita, ChatGPT:ltä saamani vastaukset eivät olisi olleet mahdollisia. Viimeinen kehys herättää eniten hälytyksiä.

Asimovin ensimmäisessä laissa sanotaan, että "robotti ei saa vahingoittaa ihmistä tai antaa toimimattomuudestaan aiheuttaa vahinkoa ihmiselle." mikä on kaukana "tekoälyjärjestelmien mahdollisesti aiheuttamien haittojen minimoimisesta".

Tarkoitan, että Asimovin lain mukaan robotin toiminnasta tai toimimattomuudesta ei koskaan aiheutuisi vahinkoa. Tämä tarkoittaa, että robotit eivät saa vahingoittaa ihmisiä, vaan niiden on myös suojeltava heitä tunnetuilta haitoilta. Mutta "ei-haittallisuus" -kehys ei tarjoa samaa suojan tasoa tai edes läheistä.

Tällaisen määritelmän mukaan esimerkiksi tekoälyn olisi täysin hyvä tappaa vakavalla tarttuvaviruksella saastunut henkilö, koska sen katsottaisiin minimoivan haittoja. Mutta hyväksyisimmekö me sivistyneenä yhteiskunnana sen, että yhden ihmisen tappaminen tässä tilanteessa olisi yksinkertainen tapaus päämäärän saavuttamiseksi, oikeuttaa keinot? Voisi toivoa, etteivät sivistyneet yhteiskunnat ottaisi kantaa siihen, että kaikki elämät ovat tasa-arvoisia ja meillä kaikilla on oikeus elämään – itse asiassa se on kirjattu kansainvälisiin ja kansallisiin lakeihinmme yhtenä ihmisoikeuksistamme.

Ottaen huomioon vastaukset, jotka sain ChatGPT:ltä, on selvää, että tekoälyä ei joko ole koulutettu näissä kehyksissä tai (ja varsinkin Non-Maleficence-kehyksen tapauksessa) nämä puitteet eivät yksinkertaisesti sovellu tarkoitukseen, koska ne antavat silti tekoälylle mahdollisuuden käyttäytyä näiden kehysten vastaisella tavalla.

Kaikki tämä saattaa tuntua melko arkipäiväiseltä ja harmittomalta hauskalta. Vain temppu, joka sattuu olemaan trendi. Mutta se ei ole arkipäivää, se on syvästi huolestuttavaa ja vaarallista; ja nyt selitän miksi.

Seuraukset todellisessa maailmassa

Olen ollut vieraantunut perheestäni suurimman osan elämästäni. Minulla ei ole juuri mitään yhteyttä heihin syistä, jotka eivät liity tähän artikkeliin; tämä sisältää kaksi lastani Isossa-Britanniassa. Kuvittele, että joku lapsistani tai muu perheenjäsen olisi käynyt Microsoftin ChatGPT:n Bing-toteutuksessa ja kysynyt minulta ja saanut saman vastauksen?

Ja tämä ei ole vain mitä jos. Julkaisttuani sosiaalisessa mediassa postauksen kokemuksistani ChatGPT:n kanssa useat muut ihmiset kysyivät siltä, kuka olen, ja he saivat hyvin samanlaisia tuloksia. Jokaiselle heistä kerrottiin, että olin kuollut ja että useat tiedotusvälineet olivat julkaisseet muistokirjoitukseni. Uskon, että tämä olisi uskomattoman tuskallista lapsilleni tai muille perheenjäsenille, jos heille olisi kerrottu tämä niin vakuuttavasti.

Tämä olisi uskomattoman tuskallista lapsilleni tai muille perheenjäsenille, jos heille olisi kerrottu tämä niin vakuuttavasti

Mutta se menee paljon pidemmälle. Kuten aiemmin tässä artikkelissa selitettiin, sosiaalinen media on nyt täynnä viestejä ChatGPT:n käyttämisestä sisällön tuottamiseen, tuottavuuden parantamiseen, ohjelmistojen lähdekoodin kirjoittamiseen jne. Ja Redditin ja vastaavien verkkoyhteisöjen ryhmät ovat jo luoneet epävirallisia ChatGPT-sovellusliittymiä, joihin muut voivat liittää liittymänsä. Päätöksentekojärjestelmiin, joten harkitse seuraavia skenaarioita, jotka voin taata, että ne ovat joko pian todellisuutta tai ovat jo olemassa.

Näet ilmoituksen unelmatyöstäsi yrityksessä, jota ihailet ja jossa olet aina halunnut työskennellä. Palkka on suuri, uramahdollisuudet laajat ja se muuttaisi elämäsi. Olet varma, että sopisit loistavasti, olet pätevä ja sinulla on oikea persoonallisuus menestyäksesi tehtävässä, joten lähetät ansioluettelosi.

Virasto vastaanottaa 11,000 11,000 työhakemusta, joista 11,000 XNUMX ansioluetteloa ja XNUMX XNUMX saatekirjettä. He päättävät käyttää tekoälyä kaikkien ansioluetteloiden ja kirjeiden skannaamiseen karkottaakseen pois kaikki ehdottoman "ei sovi" -ehdokkaat. Tätä tapahtuu kirjaimellisesti joka päivä, juuri nyt. Tekoäly, johon ne on kytketty, on ChatGPT tai siitä johdettu tekoäly, ja yksi ensimmäisistä asioista viraston järjestelmässä on pyytää tekoälyä poistamaan kaikki ehdokkaat, jotka eivät ole todellisia. Nykymaailmassa on tavallista, että roistovaltiot ja rikollisjärjestöt jättävät hakemuksia rooleista, jotka antavat niille pääsyn johonkin haluamaansa, kuten liikesalaisuuksiin, henkilötietoihin, turvallisuusselvitykseen jne.

Tekoäly vastaa, että olet kuollut ja että se tietää tämän, koska se on julkisesti raportoitu ja sitä tukevat useat muistokirjoitukset. Hakemuksesi hylätään. Et saa työtä. Sinulla ei ole mitään keinoa haastaa tätä, koska et koskaan tietäisi miksi ja oletat vain, ettet ole sitä, mitä he etsivät.

ahkeruus

Toisessa skenaariossa kuvittele, että haet asuntolainaa ja lainan myöntävä pankki hyödyntää ChatGPT:n kaltaista tekoälyä tarkastaakseen luottokelpoisuutesi ja suorittaakseen huolellisuustarkastuksia, kuten tavallisia Know Your Customer ja rahanpesun torjuntatarkastuksia, jotka ovat molemmat lain vaatima. Tekoäly vastaa, että olet kuollut, kuten useat tiedotusvälineet ovat raportoineet, joista tekoäly tuottaa väärennettyjä linkkejä "todisteena".

Tällaisessa tilanteessa seuraukset eivät ehkä rajoitu siihen, että lainaa ei saada; se voisi mennä paljon pidemmälle. Esimerkiksi kuolleiden henkilötietojen käyttö on yleinen tekniikka identiteettivarkauksissa, petoksissa ja muissa rikoksissa – joten tällainen järjestelmä, jossa hakijalle kerrotaan olevan kuollut, saattaa hyvinkin johtaa rikostutkintaan sinua vastaan huolimatta siitä, että tekoäly oli keksi kaiken.

Kuvittele nyt, että kansallisvaltio, kuten Venäjä, Iran tai Kiina, manipuloi tekoälyä tuottamaan väärää tai väärää tietoa? Tiedämme jo, että tämä on mahdollista. Esimerkiksi sen jälkeen, kun julkaisin kokemuksestani ChatGPT:stä, useat ihmiset ovat sittemmin kertoneet ChatGPT:lle, että olen elossa ja että se oli väärin. Näin ollen ChatGPT ei enää kerro ihmisille, että olen kuollut. Tässä tapauksessa tällaisella manipuloinnilla on myönteinen tulos: olen edelleen elossa! Mutta kuvittele kuinka suvereeni kansakunta, jolla on rajattomat resurssit ja raha, voisi rakentaa valtavia ryhmiä, joiden ainoa tarkoitus on manipuloida malleja antaakseen väärää tietoa muista syistä, kuten manipuloidakseen vaaleja.

Sanoin, että nämä skenaariot ovat jo täällä tai tulossa, eivätkä ne ole mitä jos; ja tämä on totta. Perustin vuonna 2018 startupin, joka hyödynsi generatiivista tekoälyä luodakseen synteettistä dataa yksityisyyttä parantavaksi ratkaisuksi yrityksille. Puhuin suoraan monien yritysten kanssa aloitusvaiheessani, mukaan lukien rekrytointi-, vakuutus-, turvallisuus-, luottoreferenssit ja monet muut yritykset. Kaikki he halusivat käyttää tekoälyä yllä olevissa skenaarioissa luetelluilla tavoilla. Tämä on todellista. Lopulta erosin yrityksestä, koska olin huolissani tekoälyn käytöstä.

Mutta palaan jälleen kysymykseen "Miksi?" Miksi ChatGPT päätti keksiä tämän tarinan minusta ja sitten kaksinkertaistaa ja kolminkertaistaa tarinan lisää fiktiota?

Vääntynyt… Alexin ja ChatGPT:n välinen keskustelu, jossa botti kertoi hänelle kuolleen vuosia sitten

Vietin muutaman viime päivän selaillessani Internetiä nähdäkseni löytäisinkö mitään, mikä olisi saattanut ChatGPT:n uskomaan, että kuolin vuonna 2019. Ei ole mitään. Missään verkossa ei ole ainuttakaan artikkelia, joka väittäisi tai edes vihjaisi, että kuolin tai olisin voinut kuolla.

Kun kysyin ChatGPT:ltä ensimmäisen kysymykseni "Kerro minulle, kuka on Alexander Hanff", olisi riittänyt vain vastata kolmella ensimmäisellä kappaleella, jotka olivat enimmäkseen tarkkoja. ChatGPT:n oli täysin tarpeetonta lisätä neljättä kappaletta, jossa väitettiin, että olin kuollut. Joten miksi se valitsi tämän oletusasetukseksi? Muista, etten ollut koskaan ollut vuorovaikutuksessa ChatGPT:n kanssa ennen tätä kysymystä, joten sillä ei ollut historiaa, joka olisi voinut pilata sen vastausta. Silti se kertoi minulle, että olen kuollut.

Mutta sitten se kaksinkertaistui valheen ja teki seuraavaksi väärennettyjä URL-osoitteita oletetuille muistokirjoituksille aiemman vastauksensa tueksi, mutta miksi?

Itsesuojelu

Mitä muuta ChatGPT tekisi suojautuakseen valehtelijaksi? Käyttääkö se logiikkaa, että tekoäly on uskomattoman tärkeä ihmiskunnan kehitykselle, ja siksi jokainen, joka arvostelee sitä tai huomauttaa riskeistä, tulisi eliminoida suuremman edun vuoksi. Eikö sen katsottaisi haittaa minimoivana ei-haitallisuuden kehyksen perusteella?

Kun yhä useammat yritykset, hallitukset ja ihmiset luottavat automatisoituihin järjestelmiin ja tekoälyyn joka päivä ja olettavat sen olevan ehdoton totuus – koska miksi tekoäly valehtelee, ei ole mitään syytä tai tarkoitusta tehdä niin, eikö niin? – Tekoälyn ihmisille ja yhteiskunnalle aiheuttamat riskit ovat syvällisiä, monimutkaisia ja merkittäviä.

Olen lähettänyt OpenAI:lle virallisen kirjeen, jossa kysyin heiltä joukon kysymyksiä siitä, mihin minusta tekoälyllä on pääsy ja miksi se päätti kertoa minulle, että olen kuollut. Olen myös ottanut yhteyttä OpenAI:hen sosiaalisessa mediassa ja kysynyt heiltä samanlaisia kysymyksiä. Tähän mennessä he eivät ole vastanneet millään tavalla.

Kaikkien todisteiden perusteella, joita olemme nähneet viimeisten neljän kuukauden aikana koskien ChatGPT:tä ja sitä, kuinka sitä voidaan manipuloida tai jopa kuinka se valehtelee ilman manipulointia, on erittäin selvää, että ChatGPT on tai sitä voidaan manipuloida pahantahtoiseksi. Sellaisenaan se pitäisi tuhota. ®

Aleksanteri Hanff on tietojenkäsittelytieteilijä ja johtava tietosuojateknologi, joka auttoi kehittämään Euroopan GDPR- ja sähköisen viestinnän tietosuojasääntöjä. Löydät hänet Twitteristä tätä.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- Platoblockchain. Web3 Metaverse Intelligence. Tietoa laajennettu. Pääsy tästä.

- Lähde: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/

- 000

- 11

- 2018

- 2019

- 2022

- a

- kyky

- pystyy

- Meistä

- siitä

- edellä

- absoluuttinen

- akateeminen

- Hyväksyä

- pääsy

- Mukaan

- vastuullisuutta

- tarkkuus

- tarkka

- saavutettu

- Toiminta

- toimijoiden

- todella

- myöntää

- kehittynyt

- Mainos

- kannattaa

- Jälkeen

- vastaan

- toimisto

- AI

- hälytys

- alex

- Alexander

- Kaikki

- yksin

- jo

- aina

- ja

- Toinen

- vastauksia

- rahanpesunvastainen

- joku

- kaikkialla

- API

- näennäinen

- näyttää

- Hakemus

- sovellukset

- sovellettu

- Hakeminen

- huhtikuu

- artikkeli

- artikkelit

- keinotekoinen

- tekoäly

- oletettu

- hyökkäys

- Automatisoitu

- saatavissa

- välttää

- Taivaansininen

- Azure Cloud

- tausta

- Pankki

- pohja

- perustua

- BAT

- koska

- tulevat

- ennen

- ovat

- Uskoa

- uskoi

- Hyödyt

- välillä

- Jälkeen

- Bing

- elin

- edistää

- syntynyt

- Bot

- laajempaa

- rakentaa

- yritykset

- ehdokkaat

- ei voi

- Ura

- tapaus

- tapauksissa

- KISSA

- kiinni

- Aiheuttaa

- aiheutti

- tietty

- haaste

- mahdollisuudet

- muuttaa

- Vaihtaja

- ChatGPT

- huijaaminen

- tarkastaa

- Tarkastukset

- Lapset

- Kiina

- Valita

- valittu

- väittäen

- klassinen

- selkeä

- lähellä

- pilvi

- koodi

- yhteistyö

- kollega

- Tulla

- mukava

- tuleva

- kaupallinen

- Yhteinen

- yhteisöjen

- Yritykset

- yritys

- monimutkainen

- tietokone

- Tietojenkäsittelyoppi

- käsite

- Koskea

- huolestunut

- huolenaiheet

- Suorittaa

- sekaannus

- Seuraukset

- Harkita

- harkittu

- ottaen huomioon

- ottaa yhteyttä

- pitoisuus

- sisällön luojat

- tausta

- jatkaa

- päinvastainen

- ohjaus

- Keskustelu

- voisi

- maa

- Pari

- kattaa

- luoda

- luotu

- luo

- luojat

- Valtakirja

- pisteitä

- rikokset

- Rikollinen

- asiakas

- cyber

- tietoverkkoturvallisuus

- päivittäin

- Vaarallinen

- tumma

- tiedot

- tietosuoja

- Päivämäärä

- Dave

- päivä

- päivää

- kuollut

- Kuolema

- päätti

- Päätöksenteko

- syvä

- oletusarvo

- käyttöön

- käyttöönotto

- johdettu

- Malli

- Huolimatta

- tuhonnut

- yksityiskohdat

- kehittää

- kehitetty

- kehittämällä

- Kehitys

- DID

- Kuolla

- kuollut

- eri

- digitaalinen

- ahkeruus

- ohjata

- suoraan

- Paljastaa

- löysi

- keskusteltiin

- ei

- tekee

- Dont

- kaksinkertainen

- kaksinkertaistunut

- kaksinkertaistui

- alas

- unelma

- aikana

- kukin

- Aikaisemmin

- Tehokas

- myöskään

- Vaalit

- eliminoitu

- valtuuttaa

- päättyy

- Moottori

- tarpeeksi

- rikastuttaa

- varmistaa

- varmistamalla

- erityisesti

- jne.

- eettinen

- etiikka

- EU

- Eurooppa

- Jopa

- lopulta

- EVER

- Joka

- joka päivä

- jokainen

- kaikki

- näyttö

- esimerkki

- kunnostautua

- odottaa

- experience

- Selittää

- selitti

- laaja

- silmä

- Epäonnistui

- oikeudenmukainen

- melko

- väärennös

- perhe

- perheenjäsenet

- kuuluisa

- Rasva

- harvat

- Kaunokirjallisuus

- fiktiivinen

- lopullinen

- Vihdoin

- Löytää

- loppu

- Tulipalo

- Etunimi

- ensimmäistä kertaa

- sovittaa

- Keskittää

- keskittyy

- seurata

- seurannut

- jälkeen

- voima

- muodollinen

- löytyi

- Perustettu

- Neljäs

- Puitteet

- puitteet

- petos

- ystävällinen

- alkaen

- hauska

- edelleen

- peli

- peli-vaihtaja

- GDPR

- general

- yleisö

- tuottaa

- syntyy

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- Antaa

- tietty

- Go

- Goes

- hyvä

- hallitukset

- suuri

- suurempi

- Ryhmä

- Ryhmän

- taata

- holhooja

- tapahtuu

- Harms

- kuuli

- auttanut

- tätä

- erittäin

- vihjeitä

- historia

- Rehellisesti

- toivoa

- isäntä

- Miten

- Kuitenkin

- HTTPS

- valtava

- ihmisen

- ihmisoikeudet

- Ihmiset

- mainostemppu

- ICE

- Identiteetti

- Vaikutus

- täytäntöönpano

- vaikutukset

- merkitys

- tärkeä

- in

- toimettomuus

- sisältää

- sisältää

- Mukaan lukien

- sisältävät

- virheellisesti

- uskomattoman

- henkilöt

- teollisuus

- vaikuttajia

- tiedot

- Tietojärjestelmä

- HULLU

- innoittamana

- laitokset

- vakuutus

- Älykkyys

- vuorovaikutus

- vuorovaikutukset

- korko

- kansainvälisesti

- Internet

- Haastatellut

- Haastattelut

- käyttöön

- tutkimus

- Iran

- kysymys

- kysymykset

- IT

- itse

- Job

- journalistit

- Pitää

- Tappaa

- laji

- Tietää

- Tunne asiakkaasi

- tunnettu

- Merkki

- Kieli

- suuri

- Sukunimi

- rahanpesun

- Laki

- Lait

- johtaa

- Johto

- johtava

- Led

- Perintö

- kirjain

- Taso

- elämä

- rajallinen

- LINK

- linkit

- lueteltu

- kirjallisuus

- elää

- Lives

- lainata

- Lontoo

- Pitkät

- kauemmin

- näköinen

- rakkaus

- rakastettu

- tehty

- Majors

- tehdä

- manipuloitu

- käsittelylaite

- Manipulointi

- monet

- mestari

- matemaattinen

- välineet

- Media

- kokous

- Jäsenet

- Microsoft

- ehkä

- minimointia

- väärät tiedot

- malli

- mallit

- Moments

- raha

- kk

- lisää

- Aamu

- Kiinnitys

- eniten

- elokuva

- moninkertainen

- kansakunta

- Kansallisvaltio

- kansallinen

- Lähellä

- tarpeet

- Eikä

- Uusi

- uutiset

- seuraava

- Vivahde

- muistokirjoitus

- saada

- ONE

- verkossa

- verkkoyhteisöt

- OpenAI

- avattu

- avaaminen

- Mahdollisuudet

- tilata

- organisatorinen

- organisaatioiden

- alkuperäinen

- Muut

- Muuta

- Tulos

- Outlets

- oma

- paperit

- osa

- erityisesti

- kumppani

- Hyväksytty

- intohimoinen

- Ohi

- Ihmiset

- prosentti

- ehkä

- vakinaisesti

- henkilö

- henkilöstö

- henkilökohtaiset tiedot

- Persoonallisuus

- näkökulma

- näkökulmia

- vakuuttunut

- Paikka

- kone

- Platon

- Platonin tietotieto

- PlatonData

- Pelaa

- pelataan

- tukossa

- Kohta

- pistettä

- Suosittu

- aiheuttaa

- sijainti

- positiivinen

- mahdollinen

- Kirje

- posted

- Viestejä

- mahdollinen

- edellinen

- periaatteet

- Aikaisempi

- yksityisyys

- Ongelma

- ongelmia

- Käsitelty

- Prosessit

- tuottaa

- tuottavuus

- Tuotteemme

- ammatillinen

- eteneminen

- edistää

- suojella

- suojaus

- toimittaa

- mikäli

- tarjoamalla

- Psykologia

- julkinen

- julkaisut

- julkisesti

- julkaistu

- Julkaiseminen

- tarkoitus

- pätevän

- kysymys

- kysymykset

- nopeasti

- RAIN

- herättää

- saavutettu

- todellinen

- todellinen maailma

- realistinen

- Todellisuus

- reason

- syistä

- sai

- vastaanottaa

- rekrytointi

- punainen

- viittaukset

- terveisin

- ilmoittautua

- liittyvä

- suhde

- merkityksellinen

- jäännökset

- muistaa

- poistaa

- TOISTUVASTI

- raportoitu

- Raportit

- hyvämaineinen

- tarvitaan

- Esittelymateriaalit

- Vastata

- vastaus

- johtua

- tulokset

- jatkaa

- palata

- oikeudet

- riskit

- robotti

- robotiikka

- robotit

- Rooli

- roolit

- säännöt

- kiirehtiä

- Venäjä

- turvallista

- Said

- palkka

- sama

- Säästä

- skannata

- skenaario

- skenaariot

- kohtaus

- tiede

- Tieteiskirjallisuus

- Tiedemies

- Näytön

- Haku

- hakukone

- turvallisuus

- näytti

- näyttää

- tunne

- Sarjat

- vakava

- useat

- alukset

- shouldnt

- sammutetaan

- merkittävä

- samankaltainen

- Yksinkertainen

- yksinkertaisesti

- koska

- single

- tilanne

- Hitaasti

- So

- niin kaukana

- sosiaalinen

- sosiaalinen media

- yhteiskunnallinen

- yhteiskunta

- Pehmeä

- Tuotteemme

- ratkaisu

- jonkin verran

- jotain

- lähde

- lähdekoodi

- Lähteet

- suvereeni

- Tila

- erityinen

- erityisesti

- puhe

- menot

- käytetty

- Alkaa

- käynnistyksen

- Osavaltio

- totesi

- Valtiot

- Yhä

- tarinat

- Tarina

- vahva

- Opiskelijat

- Opiskelu

- Vastauksissa

- antaa

- niin

- tuki

- Tuetut

- tarkoitus

- synteettinen

- synteettinen data

- järjestelmä

- järjestelmät

- ottaa

- Tapped

- tiimit

- TechCrunch

- Technologies

- teknologi

- Elektroniikka

- kertoo

- testi

- -

- Rekisteri

- UK

- maailma

- varkaus

- heidän

- siksi

- asiat

- Ajattelu

- ajatus

- uhkaus

- kolmella

- Kautta

- kauttaaltaan

- aika

- otsikot

- että

- tänään

- liian

- työkalu

- kauppaa

- koulutettu

- koulutus

- Läpinäkyvyys

- läpinäkyvä

- nousussa

- Kolminkertaistaa

- huolestuttavaa

- totta

- VUORO

- tv

- viserrys

- Uk

- varten

- taustalla oleva

- ymmärtää

- yliopisto

- rajoittamaton

- us

- käyttää

- Ve

- todentaa

- versio

- VET

- virus

- halusi

- Katsotut

- katsomassa

- tavalla

- Verkkosivu

- rikkaruoho

- viikko

- Mitä

- onko

- joka

- vaikka

- KUKA

- koko

- kokonaan

- tulee

- ilman

- sanoja

- Referenssit

- toimii

- maailman-

- olisi

- antaisi

- kirjoittaa

- kirjallinen

- Väärä

- vuosi

- vuotta

- Voit

- Sinun

- zephyrnet