Grafiikkasuorittimet ovat tehokas työkalu koneoppimistyökuormitukseen, vaikka ne eivät välttämättä ole oikea työkalu jokaiseen tekoälytyöhön, Twitterin graafisen oppimisen tutkimuksen johtajan Michael Bronsteinin mukaan.

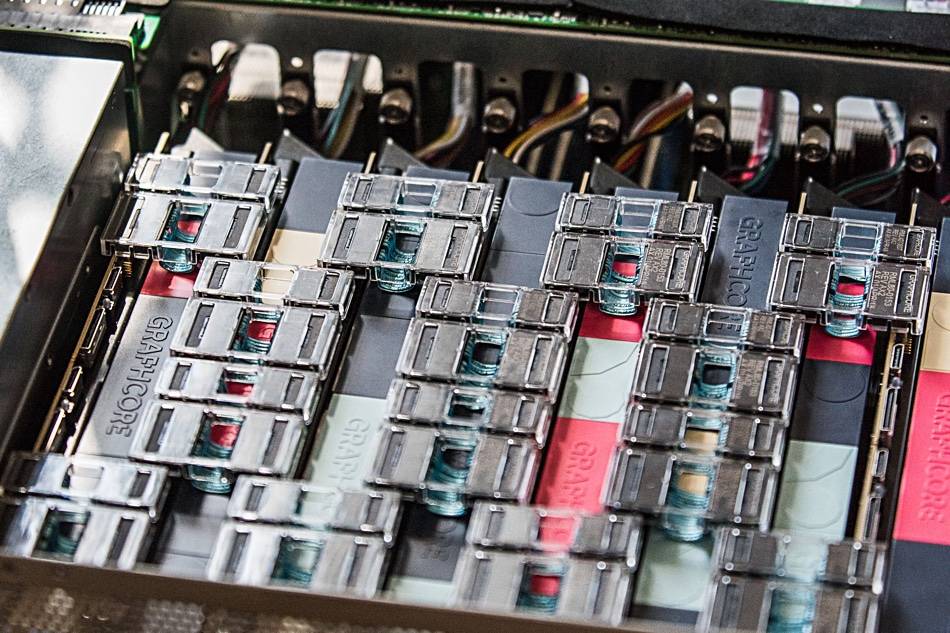

Hänen tiiminsä osoitti äskettäin, että Graphcoren tekoälylaitteisto tarjosi "suuruusluokan nopeutta verrattaessa yhtä IPU-prosessoria Nvidia A100 GPU:hun" temporal graph network (TGN) -malleissa.

"Laitteiston valinta Graph ML -mallien toteuttamiseen on ratkaiseva, mutta usein huomiotta jäävä ongelma", lukee yhteinen artikkeli kirjoittanut Bronstein yhdessä Twitterin ML-tutkijan Emanuele Rossin ja Graphcore-tutkijan Daniel Justuksen kanssa.

Graafihermoverkot tarjoavat keinon löytää järjestystä monimutkaisissa järjestelmissä, ja niitä käytetään yleisesti sosiaalisissa verkostoissa ja suositusjärjestelmissä. Näiden ympäristöjen dynaaminen luonne tekee näistä malleista kuitenkin erityisen haastavia harjoitella, trio selitti.

Ryhmä tutki Graphcoren IPU:iden toimivuutta useiden TGN-mallien käsittelyssä. Alkutestaus tehtiin pienellä TGN-mallilla, joka perustuu JODIE Wikipedia-tietojoukko, joka linkittää käyttäjät sivuille tekemiinsä muokkauksiin. Kaavio koostui 8,227 1,000 käyttäjästä ja 9,227 XNUMX artikkelista yhteensä XNUMX XNUMX solmussa. JODIE on avoimen lähdekoodin ennustejärjestelmä, joka on suunniteltu ymmärtämään ajallisia vuorovaikutusverkostoja.

Trion kokeilu paljasti, että suuret eräkoot johtivat heikentyneeseen validointiin ja johtopäätösten tarkkuuteen verrattuna pienempiin eräkokoihin.

"Solmumuisti ja graafin liitettävyys päivitetään vasta kun täysi erä on käsitelty", trio kirjoitti. "Siksi yhden erän myöhemmät tapahtumat voivat perustua vanhentuneisiin tietoihin, koska he eivät ole tietoisia aiemmista tapahtumista."

Kuitenkin käyttämällä eräkokoa 10, ryhmä pystyi saavuttamaan optimaalisen validoinnin ja päätelmien tarkkuuden, mutta he huomauttavat, että IPU:n suorituskyky oli edelleen GPU:ta parempi, vaikka käytettäisiin suuria eräkokoja.

"Käytettäessä eräpuolta 10, TGN voidaan kouluttaa IPU:lla noin 11 kertaa nopeammin, ja jopa suurella 200 eräkoolla koulutus on silti kolme kertaa nopeampaa IPU:lla", viesti lukee. "Kaikissa toiminnoissa IPU käsittelee pieniä eräkokoja tehokkaammin."

Tiimi uskoo, että Graphcoren suuren prosessorin sisäisen SRAM-välimuistin tarjoama nopea muistin käyttö ja korkea suorituskyky antoivat IPU:lle etulyöntiaseman.

Tämä suorituskyvyn johto ulottui myös kaaviomalleihin, jotka ylittivät IPU:n prosessorin sisäisen muistin – jokaisessa IPU:ssa on 1 Gt:n SRAM-välimuisti – mikä vaatii siruihin liitetyn hitaamman DRAM-muistin käyttöä.

Testattaessa kaaviomallia, joka koostuu 261 miljoonasta seuraajasta 15.5 miljoonan Twitter-käyttäjän välillä, DRAM-muistin käyttö solmumuistiin rajoitti suorituskykyä kaksinkertaiseksi, Bronsteinin tiimi havaitsi.

Kun kuitenkin indusoi useita alikaavioita synteettisen tietojoukon perusteella, joka oli 10X Twitter-graafin kokoa suurempi, tiimi havaitsi suorituskyvyn skaalautuvan kaavion koosta riippumatta. Toisin sanoen suorituskykyhitti johtui hitaamman muistin käytöstä eikä mallin koosta.

"Käyttäen tätä tekniikkaa IPU:ssa, TGN:ää voidaan soveltaa lähes mielivaltaisiin graafikokoihin, joita rajoittaa vain käytettävissä olevan isäntämuistin määrä, mutta säilyttää erittäin korkean suorituskyvyn harjoittelun ja päättelyn aikana", artikkelissa lukee.

Tiimi päätteli, että Graphcoren IPU-arkkitehtuurilla on merkittävä etu verrattuna GPU:ihin työkuormissa, joissa laskenta- ja muistikäyttö ovat heterogeenisiä.

Laajempi esimerkki on kuitenkin se, että ML-tutkijoiden tulee harkita huolellisesti laitteistovalintaansa, eikä heidän pitäisi oletuksena käyttää GPU:ita.

"Pilvipalveluiden saatavuus, jotka poistavat taustalla olevat laitteistot, johtaa tiettyyn laiskuuteen tässä suhteessa", trio kirjoitti. "Toivomme, että tutkimuksemme kiinnittää enemmän huomiota tähän tärkeään aiheeseen ja tasoittaa tietä tuleville, tehokkaammille algoritmeille ja laitteistoarkkitehtuureille Graph ML -sovelluksille." ®

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- syvä oppiminen

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- Rekisteri

- zephyrnet