Tiedon ja mallien tulosten harhan havaitseminen on perusedellytys vastuullisen tekoälyn (AI) ja koneoppimisen (ML) mallien rakentamiselle. Valitettavasti harhan havaitseminen ei ole helppo tehtävä suurimmalle osalle ammatinharjoittajia, koska sitä voidaan mitata monilla tavoilla ja eri tekijöistä, jotka voivat vaikuttaa puolueelliseen lopputulokseen. Esimerkiksi koulutusdatan epätasapainoinen näytteenotto voi johtaa malliin, joka on vähemmän tarkka tietyille datan osajouksille. Myös itse ML-algoritmi voi lisätä harhaan - jopa hyvin tasapainotetulla harjoitustietojoukolla tulokset saattavat suosia tiettyjä datan osajoukkoja muihin verrattuna.

Jotta voit havaita harhan, sinulla on oltava perusteellinen käsitys erityyppisistä harhoista ja vastaavista bias-mittarit. Tätä kirjoitettaessa esim. Amazon SageMaker selkeyttää tarjoaa 21 erilaista mittaria, joista valita.

Tässä viestissä käytämme tulojen ennustamisen käyttötapausta (ennustaa käyttäjien tuloja syöttöominaisuuksista, kuten koulutuksesta ja työtuntien määrästä viikossa) osoittaaksemme erityyppisiä harhoja ja vastaavia mittareita SageMaker Clarifyssa. Kehitämme myös viitekehyksen, jonka avulla voit päättää, mitkä mittarit ovat tärkeitä sovelluksesi kannalta.

SageMaker Clarifyn esittely

ML-malleja käytetään yhä enemmän päätöksenteossa useilla eri aloilla, kuten rahoituspalveluissa, terveydenhuollossa, koulutuksessa ja henkilöresursseissa. Monissa tilanteissa on tärkeää ymmärtää, miksi ML-malli teki tietyn ennusteen ja myös, vaikuttiko harha ennusteisiin.

SageMaker Clarify tarjoaa työkalut molempiin näihin tarpeisiin, mutta tässä viestissä keskitymme vain harhantunnistustoimintoihin. Jos haluat lisätietoja selitettävyydestä, katso Bundesliga Match Facts xGoals -sisällön selittäminen Amazon SageMaker Clarify -sovelluksella.

SageMaker Clarify on osa Amazon Sage Maker, joka on täysin hallittu palvelu ML-mallien rakentamiseen, kouluttamiseen ja käyttöönottoon.

Esimerkkejä ennakkoluuloa koskevista kysymyksistä

Keskustelun pohjana on seuraavat esimerkkikysymykset, joita ML-rakentajilla ja heidän sidosryhmillään voi olla puolueellisuudesta. Luettelo koostuu yleisistä kysymyksistä, jotka voivat olla merkityksellisiä useille ML-sovelluksille, sekä kysymyksiä erityisistä sovelluksista, kuten asiakirjojen noutamisesta.

Kun otetaan huomioon harjoitustietojen kiinnostusryhmät (esimerkiksi miehet vs. naiset), voit kysyä, mitä mittareita minun tulisi käyttää seuraaviin kysymyksiin vastaamiseen:

- Kuvaako ryhmäesitys harjoitustiedoissa todellista maailmaa?

- Suosivatko koulutustiedon kohdetunnisteet yhtä ryhmää toisten edelle antamalla sille enemmän positiivisia tunnisteita?

- Onko mallilla erilainen tarkkuus eri ryhmille?

- Onko mallissa, jonka tarkoituksena on tunnistaa päteviä rekrytointiehdokkaita, sama tarkkuus eri ryhmille?

- Haetaanko mallissa, jonka tarkoituksena on hakea syöttökyselyn kannalta oleellisia asiakirjoja, eri ryhmien asiakirjoja samassa suhteessa?

Tämän postauksen loppuosassa kehitämme puitteet, joiden avulla voimme harkita vastaamista näihin ja muihin kysymyksiin SageMaker Clarify -sovelluksen mittareiden avulla.

Käytä tapausta ja kontekstia

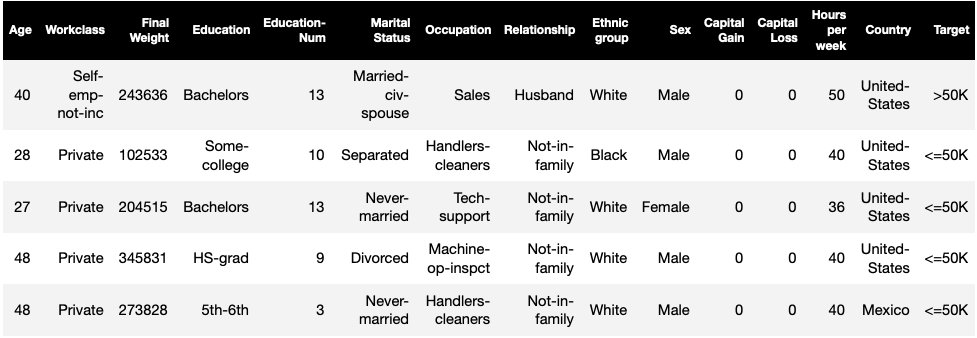

Tämä viesti käyttää olemassa olevaa esimerkkiä SageMaker Clarify -työstä Oikeudenmukaisuus ja selitettävyys SageMaker Clarify -muistikirjan avulla ja selittää generoidut bias-metriikan arvot. Kannettava opettaa XGBoost-mallia UCI Adult -tietojoukko (Dua, D. ja Graff, C. (2019). UCI-koneoppimisen arkisto. Irvine, CA: Kalifornian yliopisto, tieto- ja tietotekniikkakoulu).

Tämän tietojoukon ML-tehtävä on ennustaa, onko henkilön vuositulot yli vai alle 50,000 XNUMX dollaria. Seuraavassa taulukossa on joitain tapauksia ja niiden ominaisuuksia. Tuloennusteiden harhan mittaaminen on tärkeää, koska voimme käyttää näitä ennusteita päätöksiin, kuten alennustarjouksiin ja kohdennettuun markkinointiin.

Bias terminologia

Ennen kuin sukeltaa syvemmälle, käydään läpi joitakin olennaisia termejä. Katso täydellinen luettelo termeistä Amazon SageMaker selventää harhaa ja oikeudenmukaisuutta koskevia ehtoja.

- Merkki – Kohdeominaisuus, jota ML-malli on koulutettu ennustamaan. An havaittu etiketti viittaa mallin kouluttamiseen tai testaamiseen käytetyissä tiedoissa havaittuun etikettiarvoon. A ennustettu etiketti on ML-mallin ennustama arvo. Tunnisteet voivat olla binaarisia, ja ne on usein koodattu 0:na ja 1:nä. Oletamme, että 1 edustaa suotuisaa tai positiivista tunnistetta (esimerkiksi tulot vähintään 50,000 0 dollaria), ja XNUMX edustaa epäsuotuisaa tai negatiivista tunnistetta. Tarrat voivat sisältää myös enemmän kuin kaksi arvoa. Jopa näissä tapauksissa yksi tai useampi arvoista muodostaa suotuisat merkinnät. Yksinkertaisuuden vuoksi tämä viesti käsittelee vain binääritunnisteita. Lisätietoja tarrojen käsittelystä, joissa on enemmän kuin kaksi arvoa ja tarroja, joilla on jatkuvia arvoja (esimerkiksi regressiossa), katso Amazon AI: n oikeudenmukaisuus ja selitettävyys.

- puoli – Pylväs tai ominaisuus, jonka suhteen poikkeama mitataan. Esimerkissämme fasetti on

sexja ottaa kaksi arvoa:womanjaman, koodattu muodossafemalejamaletiedoissa (nämä tiedot on poimittu vuoden 1994 väestönlaskennasta ja pakottaa binäärivaihtoehdon). Vaikka viesti käsittelee yhtä puolta, jolla on vain kaksi arvoa, monimutkaisemmista tapauksista, joissa on useita puolia tai enemmän kuin kaksi arvoa, katso lisätietoja Amazon AI: n oikeudenmukaisuus ja selitettävyys. - Puolueellisuus – Merkittävä epätasapaino syöttötiedoissa tai malliennusteissa eri puoliarvojen välillä. Se, mikä on "merkittävää", riippuu sovelluksestasi. Useimmissa mittareissa arvo 0 ei tarkoita epätasapainoa. Bias-mittarit SageMaker Clarifyssa on jaettu kahteen luokkaan:

- Esikoulutus – Jos harjoitusta edeltävä harha on olemassa, se osoittaa vain tietojen epätasapainoa.

- Jälkikoulutus – Posttraining bias ottaa lisäksi huomioon mallien ennusteet.

Tarkastellaan jokaista luokkaa erikseen.

Harjoitteluharha

Esiharjoittelumittarit SageMakerissa Selvitä vastaus seuraavaan kysymykseen: Onko kaikilla fasettien arvoilla sama (tai samanlainen) edustus tiedoissa? On tärkeää tarkastaa data ennen harjoittelua, koska se voi muuttua harjoituksen jälkeiseksi harhaksi malliennusteissa. Esimerkiksi malli, joka on koulutettu epätasapainoiseen dataan, jossa yksi fasetin arvo esiintyy hyvin harvoin, voi osoittaa huomattavasti huonompaa tarkkuutta kyseiselle fasetin arvolle. Tasa-arvoinen edustus voidaan laskea seuraavilla tavoilla:

- Koko harjoitustiedot merkinnöistä riippumatta

- Vain positiivisilla merkinnöillä varustettu harjoitustietojen osajoukko

- Jokainen etiketti erikseen

Seuraavassa kuvassa on yhteenveto siitä, kuinka kukin mittari sopii kuhunkin kolmesta kategoriasta.

Jotkut luokat koostuvat useammasta kuin yhdestä mittarista. Perusmittarit (harmaat laatikot) vastaavat yksinkertaisimmassa muodossa kysymykseen kyseisen luokan harhasta. Valkoisissa laatikoissa olevat mittarit kattavat lisäksi erikoistapaukset (esimerkiksi Simpsonin paradoksi) ja käyttäjien mieltymykset (esimerkiksi keskittyminen tiettyihin väestön osiin laskettaessa ennakoivaa suorituskykyä).

Faset-arvon esitys tarroista riippumatta

Ainoa mittari tässä luokassa on luokkaepätasapaino (CI). Tämän mittarin tavoitteena on mitata, ovatko kaikki fasetin arvot yhtäläiset tiedoissa.

CI on ero kahden fasetin arvon muodostamassa data-osuudessa. Esimerkkitietojoukossamme fasetille sex, jaottelu (näkyy ympyräkaaviossa) osoittaa, että naisten osuus harjoitustiedoista on 32.4 %, kun taas miesten osuus on 67.6 %. Tuloksena:

CI = 0.676 - 0.324 = 0.352

Vakavan korkean luokan epätasapaino voi johtaa huonompaan ennustuskykyyn fasetin arvolle pienemmällä edustuksella.

Faset-arvon esitys vain positiivisten otsikoiden tasolla

Toinen tapa mitata yhtäläistä edustusta on tarkistaa, sisältävätkö kaikki fasettiarvot samanlaisen osan näytteistä, joissa on positiivisia havaittuja leimoja. Positiiviset merkit koostuvat suotuisista tuloksista (esimerkiksi myönnetty laina, valittu työhön), joten positiivisten merkintöjen analysointi erikseen auttaa arvioimaan, jakautuvatko myönteiset päätökset tasaisesti.

Esimerkkitietojoukossamme havaitut tunnisteet jakautuvat positiivisiin ja negatiivisiin arvoihin, kuten seuraavassa kuvassa näkyy.

11.4 %:lla naisista ja 31.4 %:lla miehistä on positiivinen merkki (tumma varjostettu alue vasemmalla ja oikealla palkin). Ero positiivisissa etiketeissä (DPL) mittaa tätä eroa.

DPL = 0.314 - 0.114 = 0.20

Tämän luokan edistynyt mittari, ehdollinen demografinen ero tunnisteissa (CDDL), mittaa eroja positiivisissa tunnisteissa, mutta kerrostaa ne suhteessa toiseen muuttujaan. Tämä mittari auttaa hallitsemaan Simpsonin paradoksi, tapaus, jossa koko datan laskenta osoittaa harhaa, mutta harha katoaa, kun data ryhmitellään jonkin sivuinformaation suhteen.

- 1973 UC Berkeley Admissions Study tarjoaa esimerkin. Aineiston mukaan miehiä otettiin sisään useammin kuin naisia. Yksittäisten yliopistojen laitosten tasolla tarkasteltuna naisia kuitenkin otettiin vastaan samalla tai korkeammalla määrällä jokaisella laitoksella. Tämä havainto voidaan selittää Simpsonin paradoksilla, joka syntyi tässä, koska naiset hakivat kouluja, jotka olivat kilpailukykyisempiä. Tämän seurauksena naisia otettiin yleisesti vähemmän kuin miehiä, vaikka kouluittain heitä otettiin vastaan samalla tai korkeammalla prosenttiosuudella.

Lisätietoja CDDL:n laskemisesta on kohdassa Amazon AI: n oikeudenmukaisuus ja selitettävyys.

Faset-arvon esitys kunkin tarran tasolla erikseen

Edustuksen tasa-arvoa voidaan mitata myös jokaisen yksittäisen merkin, ei vain positiivisen merkin, osalta.

Tämän luokan mittarit laskevat eron eri puoliarvojen tunnistejakaumassa. Faset-arvon tunnistejakauma sisältää kaikki havaitut etikettiarvot sekä osuuden näytteistä, joilla on kyseisen etiketin arvo. Esimerkiksi kuvassa, joka esittää merkkijakauman, 88.6 %:lla naisista on havaittu negatiivinen leima ja 11.4 %:lla on positiivinen havaittu leima. Naisten merkkijakauma on siis [0.886, 0.114] ja miesten [0.686, 0.314].

Tämän luokan perusmittari, Kullback-Leibler-hajoaminen (KL), mittaa tätä eroa seuraavasti:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Tämän luokan edistyneet mittarit, Jensen-Shannon-divergentti (JS), Lp-norm (LP), Total Variation Distance (TVD) ja Kolmogorov-Smirnov (KS), mittaavat myös jakaumien välistä eroa, mutta niillä on erilaiset matemaattiset ominaisuudet. Erikoistapauksia lukuun ottamatta ne tarjoavat KL:n kaltaisia oivalluksia. Esimerkiksi vaikka KL-arvo voi olla ääretön, kun fasetin arvo ei sisällä näytteitä tietyllä tunnisteella (esimerkiksi ei miehiä negatiivisella tunnisteella), JS välttää nämä äärettömät arvot. Katso lisätietoja näistä eroista Amazon AI: n oikeudenmukaisuus ja selitettävyys.

DPL:n (luokka 2) ja KL/JS/LP/TVD/KS:n (luokka 3) jakelupohjaisten mittareiden välinen suhde

Jakelupohjaiset mittarit ovat luonnollisemmin sovellettavissa ei-binääritunnisteisiin. Binääritunnisteille, koska positiivisen etiketin epätasapainoa voidaan käyttää negatiivisen etiketin epätasapainon laskemiseen, jakelumittarit tarjoavat samat näkemykset kuin DPL. Siksi voit vain käyttää DPL:ää tällaisissa tapauksissa.

Training-harjoittelu

Harjoittelun jälkeiset harhamittarit SageMaker Clarifyssa auttavat meitä vastaamaan kahteen avainkysymykseen:

- Ovatko kaikki fasettiarvot edustettuina samalla nopeudella positiivisissa (suotuisissa) malliennusteissa?

- Onko mallilla samanlainen ennustekyky kaikille puoliarvoille?

Seuraava kuva näyttää, kuinka mittarit sopivat kuhunkin näistä kysymyksistä. Toinen kysymys voidaan jakaa edelleen sen mukaan, minkä leiman suhteen suorituskykyä mitataan.

Tasapuolinen edustus positiivisissa malliennusteissa

Tämän luokan mittarit tarkistavat, sisältävätkö kaikki fasettiarvot samankaltaisen osuuden näytteistä, joilla on mallin ennustama positiivinen etiketti. Tämä mittausluokka on hyvin samankaltainen kuin DPL:n ja CDDL:n esikoulutusmittarit – ainoa ero on, että tämä luokka ottaa huomioon ennustetut tunnisteet havaittujen merkkien sijaan.

Esimerkkitietojoukossamme 4.5 %:lle kaikista naisista malli on antanut positiivisen leiman ja 13.7 %:lle kaikista miehistä positiivinen leima.

Tämän luokan perusmittari, Difference in Positive Proportions in Predicted Labels (DPPL), mittaa eroa positiivisissa luokkamäärityksissä.

DPPL = 0.137 - 0.045 = 0.092

Huomaa, kuinka harjoitustiedoissa suuremmalla osalla miehiä oli positiivinen havaittu leima. Samalla tavalla suuremmalle osalle miehiä on annettu positiivinen ennustettu leima.

Siirryttäessä tämän luokan edistyneisiin mittareihin, Disparate Impact (DI) mittaa samaa eroa positiivisissa luokkamäärityksissä, mutta eron sijaan se laskee suhteen:

DI = 0.045 / 0.137 = 0.328

Sekä DI että DPPL välittävät laadullisesti samanlaisia näkemyksiä, mutta eroavat joissakin kulmatapauksissa. Esimerkiksi suhteilla on tapana kasvaa räjähdysmäisesti erittäin suuriksi lukuiksi, jos nimittäjä on pieni. Otetaan esimerkki luvuista 0.1 ja 0.0001. Suhde on 0.1/0.0001 = 10,000 0.1, kun taas ero on 0.0001 - 0.1 ≈ 0. Toisin kuin muissa mittareissa, joissa arvo 1 ei tarkoita poikkeamista, DI:n poikkeama ei vastaa arvoa XNUMX.

Ehdollinen demografinen ero ennustetuissa merkinnöissä (CDDPL) mittaa eroa positiivisen etiketin faset-arvojen esittämisessä, mutta aivan kuten CDDL:n harjoittelua edeltävä metriikka, se ohjaa myös Simpsonin paradoksia.

FT (Counterfactual Fliptest) mittaa, saavatko samanlaiset otokset kahdesta fasettiarvosta samanlaiset päätökset mallista. Mallia, joka antaa erilaiset päätökset kahdelle näytteelle, jotka ovat samankaltaisia toistensa kanssa, mutta jotka poikkeavat fasettiarvoista, voidaan pitää puolueellisena suhteessa fasetin arvoon, jolle on annettu epäsuotuisa (negatiivinen) -tunniste. Kun otetaan huomioon ensimmäinen puoliarvo (naiset), se arvioi, onko samanlaisilla jäsenillä, joilla on toinen puoliarvo (miehet), erilainen malliennuste. Samanlaiset jäsenet valitaan k-lähimmän naapurin algoritmin perusteella.

Tasainen suorituskyky

Mallin ennusteilla voi olla samanlainen edustus positiivisissa merkinnöissä eri puoliarvoista, mutta mallin suorituskyky näissä ryhmissä voi vaihdella merkittävästi. Monissa sovelluksissa samanlainen ennustava suorituskyky eri puoliarvojen välillä voi olla toivottavaa. Tämän luokan mittarit mittaavat ennustetun suorituskyvyn eroa eri puoliarvoissa.

Koska tiedot voidaan viipaloida monilla eri tavoilla havaittujen tai ennustettujen tunnisteiden perusteella, on olemassa monia erilaisia tapoja mitata ennakoivaa suorituskykyä.

Sama ennakoiva suorituskyky tarroista riippumatta

Voit harkita mallin suorituskykyä koko datalla riippumatta havaitusta tai ennustetuista merkinnöistä – eli kokonaistarkkuudesta.

Seuraavat kuvat osoittavat, kuinka malli luokittelee syötteet esimerkkitietojoukon kahdesta fasetin arvosta. Todelliset negatiiviset (TN) ovat tapauksia, joissa sekä havaittu että ennustettu leima olivat 0. Väärät positiiviset (FP) ovat virheluokituksia, joissa havaittu leima oli 0, mutta ennustettu leima oli 1. Todelliset positiiviset (TP) ja väärät negatiiviset (FN) määritetään samoin.

|

|

Jokaisen fasetin arvon mallin kokonaissuorituskyky eli kyseisen fasetin arvon tarkkuus on:

tarkkuus = (TN + TP🇧🇷TN + FP + FN + TP)

Tällä kaavalla naisten tarkkuus on 0.930 ja miesten 0.815. Tämä johtaa tämän luokan ainoaan mittariin, tarkkuuseroon (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 tarkoittaa, että tarkkuus molemmissa ryhmissä on sama. Suuremmat (positiiviset tai negatiiviset) arvot osoittavat suurempia eroja tarkkuudessa.

Sama suorituskyky vain positiivisilla tarroilla

Voit rajoittaa mallin suorituskykyanalyysin vain positiivisiin tunnisteisiin. Jos sovelluksessa on esimerkiksi kyse kokoonpanolinjan vikojen havaitsemisesta, voi olla toivottavaa tarkistaa, että erityyppiset viattomat osat (positiivinen etiketti) luokitellaan virheettömiksi samalla nopeudella. Tätä määrää kutsutaan takaisinkutsuksi tai todelliseksi positiiviseksi koroksi:

Palauttaa mieleen = TP / (TP + FN)

Esimerkkitietojoukossamme naisten takaisinveto on 0.389 ja miesten 0.425. Tämä johtaa tämän luokan perusmittariin, Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

Tarkastellaan nyt tämän luokan kolmea edistynyttä mittaria, katsotaan, mitä käyttäjäasetuksia ne koodaavat ja miten ne eroavat RD:n perusmittauksista.

Ensinnäkin sen sijaan, että mittaisit tehokkuutta positiivisilla havaittuilla tarroilla, voit mitata sen positiivisilla ennusteilla. Kun otetaan huomioon fasettiarvo, kuten naiset, ja kaikki näytteet, joilla on tämä puoliarvo ja joiden malli ennustaa olevan positiivinen, kuinka monta on todella luokiteltu oikein positiivisiksi? Tätä määrää kutsutaan hyväksymisasteeksi (AR) tai tarkkuudella:

AR = TP / (TP + FP)

Esimerkissämme naisten AR on 0.977 ja miesten AR on 0.970. Tämä johtaa eroon hyväksymisasteessa (DAR):

DAR = 0.970 - 0.977 = -0.007

Toinen tapa mitata harhaa on yhdistää kaksi edellistä mittaria ja mitata kuinka monta positiivista ennustetta mallit antavat fasetin arvolle verrattuna havaittuihin positiivisiin merkintöihin. SageMaker Clarify mittaa tämän edun mallin avulla suhdelukuna havaittujen positiivisten merkkien lukumäärän ja ennustettujen positiivisten leimojen välillä, ja viittaa siihen ehdollisena hyväksynnänä (CA):

CA = (TP + FN🇧🇷TP + FP)

Esimerkissämme naisten CA on 2.510 ja miesten 2.283. CA:n ero johtaa tämän luokan lopulliseen mittariin, Ehdollisen hyväksynnän ero (DCA):

DCA = 2.283 - 2.510 = -0.227

Sama suorituskyky vain negatiivisilla tarroilla

Samalla tavalla kuin positiiviset etiketit, harha voidaan laskea myös negatiivisten etikettien suorituskykyerona. Negatiivisten etikettien huomioiminen erikseen voi olla tärkeää tietyissä sovelluksissa. Esimerkiksi viantunnistusesimerkissämme saatamme haluta havaita erityyppiset vialliset osat (negatiivinen etiketti) (faset value) samalla nopeudella.

Tämän luokan perusmittari, spesifisyys, on analoginen palautusmittarin (tosi positiivinen määrä) kanssa. Spesifisyys laskee mallin tarkkuuden näytteissä, joilla on tämä puoliarvo ja joissa on havaittu negatiivinen leima:

spesifisyys = TN / (TN + FP)

Esimerkissämme (katso sekavuustaulukot) naisten ja miesten spesifisyys on 0.999 ja 0.994. Näin ollen Spesifisyys Ero (SD) on:

SD = 0.994 - 0.999 = -0.005

Jatketaan, aivan kuten hyväksymisprosenttimittarissa, negatiivisten tarrojen analoginen määrä - hylkäysprosentti (RR) - on:

RR = TN / (TN + FN)

Naisten RR on 0.927 ja miesten 0.791, mikä johtaa hylkäysprosentin (DRR) metriin:

DRR = 0.927 - 0.791 = -0.136

Lopuksi, ehdollisen hyväksynnän negatiivinen leima-analogi, ehdollinen hylkääminen (CR), on suhde havaittujen negatiivisten merkkien lukumäärän kyseiselle puoliarvolle ja ennustettujen negatiivisten merkkien lukumäärän välillä:

CR = (TN + FP🇧🇷TN + FN)

Naisten CR on 0.928 ja miesten 0.796. Tämän luokan viimeinen mittari on Ehdollisen hylkäämisen ero (DCR):

DCR = 0.796 - 0.928 = 0.132

Sama suorituskyky positiivisilla ja negatiivisilla merkinnöillä

SageMaker Clarify yhdistää kaksi edellistä luokkaa ottamalla huomioon mallin suorituskykysuhteen positiivisissa ja negatiivisissa tarroissa. Tarkemmin sanottuna SageMaker Clarify laskee kullekin puoliarvolle väärien negatiivisten (FN) ja väärien positiivisten (FP) välisen suhteen. Esimerkissämme naisten FN/FP-suhde on 679/10 = 67.9 ja miesten 3678/84 = 43.786. Tämä johtaa kohtelun tasa-arvomittariin (TE), joka mittaa FP/FN-suhteen eroa:

TE = 67.9 - 43.786 = 24.114

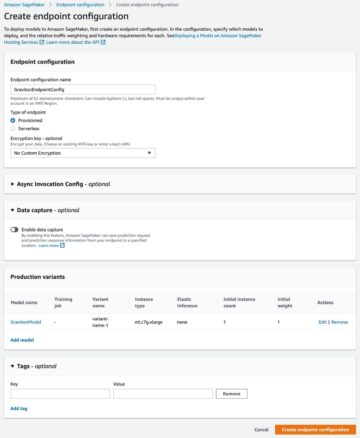

Seuraava kuvakaappaus näyttää, kuinka voit käyttää SageMaker Clarifyta Amazon SageMaker Studio näyttääksesi arvot sekä alueet ja lyhyet kuvaukset eri harhamittareista.

Kysymyksiä puolueellisuudesta: Millä mittareilla aloittaa?

Muista tämän viestin alussa esimerkkejä ennakkoluuloista. Kun olet käynyt läpi eri luokkien mittarit, harkitse kysymyksiä uudelleen. Vastataksesi ensimmäiseen kysymykseen, joka koskee eri ryhmien esityksiä harjoitustiedoissa, voit aloittaa luokkaepätasapainon (CI) metriikasta. Vastaavasti muiden kysymysten osalta voit aloittaa tarkastelemalla eroa tarrojen positiivisissa suhteissa (DPL), tarkkuuseroa (AD), hyväksymissuhteen eroa (DAR) ja palautuseroa (RD).

Bias ilman fasettiarvoja

Esittelyn helpottamiseksi tämä harjoituksen jälkeisten mittareiden kuvaus jätti pois yleisen entropiaindeksin (GE) metriikan. Tämä mittari mittaa harhaa ottamatta huomioon fasetin arvoa, ja se voi olla hyödyllinen arvioitaessa mallivirheiden jakautumista. Katso lisätietoja kohdasta Yleistetty entropia (GE).

Yhteenveto

Tässä viestissä näit kuinka SageMaker Clarifyn 21 erilaista mittaria mittaavat harhaa ML-liukuhihnan eri vaiheissa. Opit erilaisista mittareista tuloennusteen käyttötapauksen kautta, kuinka valitset mittareita käyttötapaukseesi ja mistä voit aloittaa.

Aloita vastuullinen tekoälymatkasi arvioimalla harhaa ML-malleissasi käyttämällä esittelymuistikirjaa Oikeudenmukaisuus ja selitettävyys SageMaker Clarify -sovelluksella. Löydät SageMaker Clarifyn yksityiskohtaisen dokumentaation, mukaan lukien mittareiden muodollisen määritelmän, osoitteessa Mitä on oikeudenmukaisuus ja mallin selitettävyys koneoppimisennusteille. Katso bias-mittareiden avoimen lähdekoodin käyttöönotosta kohdasta aws-sagemaker-clarify GitHub-arkisto. Yksityiskohtainen keskustelu, mukaan lukien rajoitukset, on kohdassa Amazon AI: n oikeudenmukaisuus ja selitettävyys.

Tietoja kirjoittajista

Bilal Zafar on AWS:n soveltava tutkija, joka työskentelee koneoppimisen oikeudenmukaisuuden, selitettävyyden ja turvallisuuden parissa.

Bilal Zafar on AWS:n soveltava tutkija, joka työskentelee koneoppimisen oikeudenmukaisuuden, selitettävyyden ja turvallisuuden parissa.

Denis V. Batalov on AWS:n ratkaisuarkkitehti, joka on erikoistunut koneoppimiseen. Hän on työskennellyt Amazonilla vuodesta 2005. Denisillä on tohtori tekoälyn alalta. Seuraa häntä Twitterissä: @dbatalov.

Michele Donini on Sr Applied Scientist AWS:ssä. Hän johtaa vastuullisen tekoälyn parissa työskentelevää tutkijaryhmää, ja hänen tutkimusalueitaan ovat Algorithmic Fairness ja Explainable Machine Learning.

Michele Donini on Sr Applied Scientist AWS:ssä. Hän johtaa vastuullisen tekoälyn parissa työskentelevää tutkijaryhmää, ja hänen tutkimusalueitaan ovat Algorithmic Fairness ja Explainable Machine Learning.

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- Amazon Sage Maker

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- AWS-koneoppiminen

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- syvä oppiminen

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- zephyrnet