Johdatus taulukon purkamiseen

Kerättävän tiedon määrä kasvaa rajusti päivä päivältä sovellusten, ohjelmistojen ja verkkoalustojen määrän kasvaessa.

Jotta tätä valtavaa dataa voitaisiin käsitellä/käyttää tehokkaasti, on tarpeen kehittää arvokkaita tiedonpoimintatyökaluja.

Yksi tiedonpoimintakentässä huomiota vaativista osa-alueista on taulukoiden poimiminen kuvista tai taulukkotietojen tunnistaminen lomakkeista, PDF-tiedostoista ja asiakirjoista.

Taulukon uuttaminen on tehtävä tunnistaa ja hajottaa taulukon tiedot asiakirjassa.

Kuvittele, että sinulla on paljon asiakirjoja, joissa on taulukkotietoja, jotka sinun on poimittava jatkokäsittelyä varten. Perinteisesti voit kopioida ne manuaalisesti (paperille) tai ladata ne Excel-arkeille.

Taulukon tekstintunnistusohjelmiston avulla voit kuitenkin tunnistaa taulukot automaattisesti ja poimia kaikki taulukkotiedot asiakirjoista yhdellä kertaa. Tämä säästää paljon aikaa ja uusintatyötä.

Tässä artikkelissa tarkastellaan ensin, kuinka nanonetit voivat poimia taulukoita automaattisesti kuvista tai asiakirjoista. Käsittelemme sitten joitain suosittuja DL-tekniikoita asiakirjojen taulukoiden havaitsemiseksi ja purkamiseksi.

Haluatko poimia taulukkotietoja laskuista, kuiteista tai mistä tahansa muusta asiakirjasta? Tutustu Nanonetsiin PDF-taulukon purku poimimaan taulukkotietoja. Aikataulu esittely saadaksesi lisätietoja automatisoinnista pöydän erottaminen.

Sisällysluettelo

Pura taulukko kuvasta Nanonets Table OCR:lla

-

Luo tili ilmaista Nanonets-tiliä varten

- Lataa kuvat/tiedostot Nanonets Table OCR -malliin

- Nanonets tunnistaa ja poimii automaattisesti kaikki taulukkotiedot

- Muokkaa ja tarkista tietoja (tarvittaessa)

- Vie käsitellyt tiedot Excel-, csv- tai JSON-muodossa

Haluatko kaapia tietoja PDF-tiedostosta asiakirjoja, muuntaa PDF-taulukko Exceliksi or automatisoida taulukon purkaminen? Selvittää kuinka Nanonets PDF-kaavin or PDF jäsentäjä voi tehostaa yrityksesi tuottavuutta.

Nanonets Table OCR API

- Nanonets OCR -sovellusliittymä antaa sinun rakentaa OCR-malleja helposti. Sinun ei tarvitse huolehtia kuvien esikäsittelystä tai murehtia mallien sovittamisesta tai luoda sääntöpohjaisia moottoreita lisätäksesi tekstintunnistusmallisi tarkkuutta.

Voit ladata tietosi, merkitä ne, asettaa mallin harjoittelemaan ja odottaa ennusteiden saamista selainpohjaisen käyttöliittymän kautta kirjoittamatta riviäkään koodia, huolehtimatta GPU:ista tai etsimättä oikeat arkkitehtuurit taulukon havaitsemiseen syväoppimismalleja käyttämällä.

Voit myös hankkia kunkin ennusteen JSON-vastaukset integroidaksesi sen omiin järjestelmiisi ja rakentaaksesi koneoppimiseen perustuvia sovelluksia, jotka perustuvat huippuluokan algoritmeihin ja vahvaan infrastruktuuriin.

https://nanonets.com/documentation/

Käsitteleekö yrityksesi datan tai tekstin tunnistamista digitaalisissa asiakirjoissa, PDF-tiedostoissa tai kuvissa? Oletko miettinyt, kuinka poimia taulukkotietoja, poimi teksti kuvista , poimia tietoja PDF-tiedostosta or poista teksti PDF-tiedostosta tarkasti ja tehokkaasti?

Kenelle taulukon purkaminen on hyödyllistä

Kuten edellisessä osiossa mainittiin, taulukoita käytetään usein esittämään tiedot puhtaassa muodossa. Näemme niitä niin usein useilla eri aloilla, aina työmme järjestämisestä ryhmittelemällä tietoja taulukoiden välillä yritysten valtavan omaisuuden tallentamiseen. Monet organisaatiot joutuvat käsittelemään miljoonia pöytiä päivittäin. Helpottaaksemme tällaisia työläitä tehtäviä tehdä kaikki manuaalisesti meidän on turvauduttava nopeampiin tekniikoihin. Keskustellaan muutamista käyttötapauksista, joissa taulukoiden purkaminen voi olla välttämätöntä:

Henkilökohtaiseen käyttöön tarkoitetut tapaukset

- pöydän erottaminen prosessi voi olla hyödyllinen myös pienissä henkilökohtaisessa käytössä. Joskus tallennamme asiakirjoja matkapuhelimeen ja kopioimme ne myöhemmin tietokoneillemme. Tämän prosessin käyttämisen sijaan voimme kaapata asiakirjat suoraan ja tallentaa ne muokattavissa olevissa muodoissa mukautetuissa malleissamme. Alla on muutamia käyttötapauksia siitä, kuinka voimme sovittaa pöydän poiston henkilökohtaiseen rutiinimme -

Asiakirjojen skannaaminen puhelimeen: Kaappaamme usein kuvia tärkeistä taulukoista puhelimeen ja tallennamme ne, mutta taulukon erotustekniikan avulla voimme kaapata taulukoiden kuvat ja tallentaa ne suoraan taulukkomuodossa joko excel- tai google-arkkeihin. Tämän avulla meidän ei tarvitse etsiä kuvia tai kopioida taulukon sisältöä uusiin tiedostoihin, sen sijaan voimme käyttää suoraan tuontitaulukoita ja aloittaa poimittujen tietojen käsittely.

Asiakirjat HTML: ään: Verkkosivuilta löytyy paljon taulukoilla esitettyä tietoa. Ne auttavat meitä verrattuna tietoihin ja antavat meille nopean muistiinpanon numeroista organisoidulla tavalla. Pöydän erotusprosessin avulla voimme skannata PDF-dokumentteja tai JPG / PNG-kuvia ja ladata tiedot suoraan räätälöityyn taulukomuotoon. Voimme edelleen kirjoittaa komentosarjoja lisätäksesi uusia taulukoita olemassa olevien taulukoiden perusteella ja siten digitalisoidaksesi tiedot. Tämä auttaa meitä sisällön muokkaamisessa ja nopeuttaa tallennusprosessia.

Teollisuuskäyttöön tarkoitetut tapaukset

On useita toimialoja ympäri maailmaa, jotka hoitavat valtavasti paperityötä ja dokumentaatiota, etenkin pankki- ja vakuutussektoreilla. Taulukoita käytetään laajasti asiakkaiden yksityiskohtien tallentamisesta asiakkaiden tarpeisiin. Nämä tiedot välitetään jälleen asiakirjana (paperiversiona) eri haaroille hyväksyttäväksi, jolloin joskus virheellinen viestintä voi johtaa virheisiin tarttumalla tietoihin taulukoista. Sen sijaan automaation käyttäminen täällä helpottaa elämäämme. Kun alkuperäiset tiedot on kaapattu ja hyväksytty, voimme skannata nämä asiakirjat suoraan taulukoihin ja jatkaa digitoidun tiedon käsittelyä. Puhumattakaan ajan kulutuksesta ja virheistä, voimme ilmoittaa asiakkaille ajankohdan ja paikan, jossa tiedot käsitellään. Siksi varmistetaan tietojen luotettavuus ja yksinkertaistetaan tapaa toimia. Tarkastellaan nyt muita mahdollisia käyttötapauksia:

Quality Control: Laadunvalvonta on yksi ydinpalveluista, joita huipputeollisuus tarjoaa. Se tehdään yleensä yrityksen sisällä ja sidosryhmille. Osana tätä on paljon palautelomakkeita, jotka kerätään kuluttajilta palautteen saamiseksi palvelusta. Teollisuuden aloilla he käyttävät taulukoita päivittäisten tarkistuslistojen ja muistiinpanojen muokkaamiseen nähdäkseen, kuinka tuotantolinjat toimivat. Kaikki nämä voidaan dokumentoida yhdessä paikassa käyttämällä pöydän erottamista helposti.

Varojen seuranta: Valmistusteollisuudessa ihmiset käyttävät koodattuja taulukoita seuratakseen valmistettuja kokonaisuuksia, kuten terästä, rautaa, muovia jne. Jokainen valmistettu tuote on merkitty yksilöivällä numerolla, jossa he käyttävät taulukoita seuratakseen päivittäin valmistettuja ja toimitettuja esineitä. Automaatio voi säästää paljon aikaa ja omaisuutta väärinkäytösten tai tietojen epäjohdonmukaisuuden kannalta.

Liikekäyttöön tarkoitetut tapaukset

On olemassa useita yrityksiä, jotka toimivat excel-lomakkeilla ja offline-lomakkeilla. Mutta yhdellä hetkellä on vaikea etsiä näitä arkkeja ja lomakkeita. Jos kirjoitamme näitä taulukoita manuaalisesti, se vie aikaa ja väärin syötettyjen tietojen todennäköisyys on suuri. Siksi taulukon erottaminen on parempi vaihtoehto ratkaista yrityskäytöt, koska sellaisia on vähän.

Lasku Automaatio: On monia pienimuotoisia ja suuria teollisuudenaloja laskut luodaan edelleen taulukkomuodossa. Nämä eivät tarjoa asianmukaisesti suojattuja veroilmoituksia. Tällaisten esteiden voittamiseksi voimme muuntaa kaikki käyttämällä taulukon purkamista laskut muokattavaan muotoon ja päivittää ne siten uudempaan versioon.

Lomakeautomaatio: Verkkolomakkeet häiritsevät tätä hyväksi havaittua menetelmää auttamalla yrityksiä keräämään tarvitsemansa tiedot ja yhdistämään ne samanaikaisesti muihin työnkulkuun sisäänrakennettuihin ohjelmistoalustoihin. Sen lisäksi, että manuaalisen tietojen syöttämisen tarve vähenee (jossa automaattinen tiedonsyöttö).

Onko sinulla OCR-ongelma mielessä? Haluaa digitalisoida laskut, PDF vai rekisterikilvet? Suuntaa kohti Nanonetit ja rakenna OCR-malleja ilmaiseksi!

Syvä oppiminen toiminnassa

Syväoppiminen on osa laajempaa keinotekoisiin hermoverkkoihin perustuvien koneoppimismenetelmien perhettä.

Neuraaliverkko on kehys, joka tunnistaa tietyn tiedon taustalla olevat suhteet prosessin avulla, joka jäljittelee ihmisen aivojen toimintaa. Heillä on erilaisia keinotekoisia kerroksia, joiden läpi tiedot kulkevat, jossa he oppivat ominaisuuksista. On olemassa erilaisia arkkitehtuureja, kuten Convolution NN, toistuvat NN, Autoencoderit, Generative Adversarial NN käsittelemään erilaisia tietoja. Ne ovat monimutkaisia, mutta kuvaavat korkeaa suorituskykyä ongelmien ratkaisemiseksi reaaliajassa. Tarkastellaan nyt tutkimusta, joka on tehty taulukonpoimintakentässä käyttämällä Neuraalisia verkkoja, ja tarkastellaan niitä myös lyhyesti.

TableNet

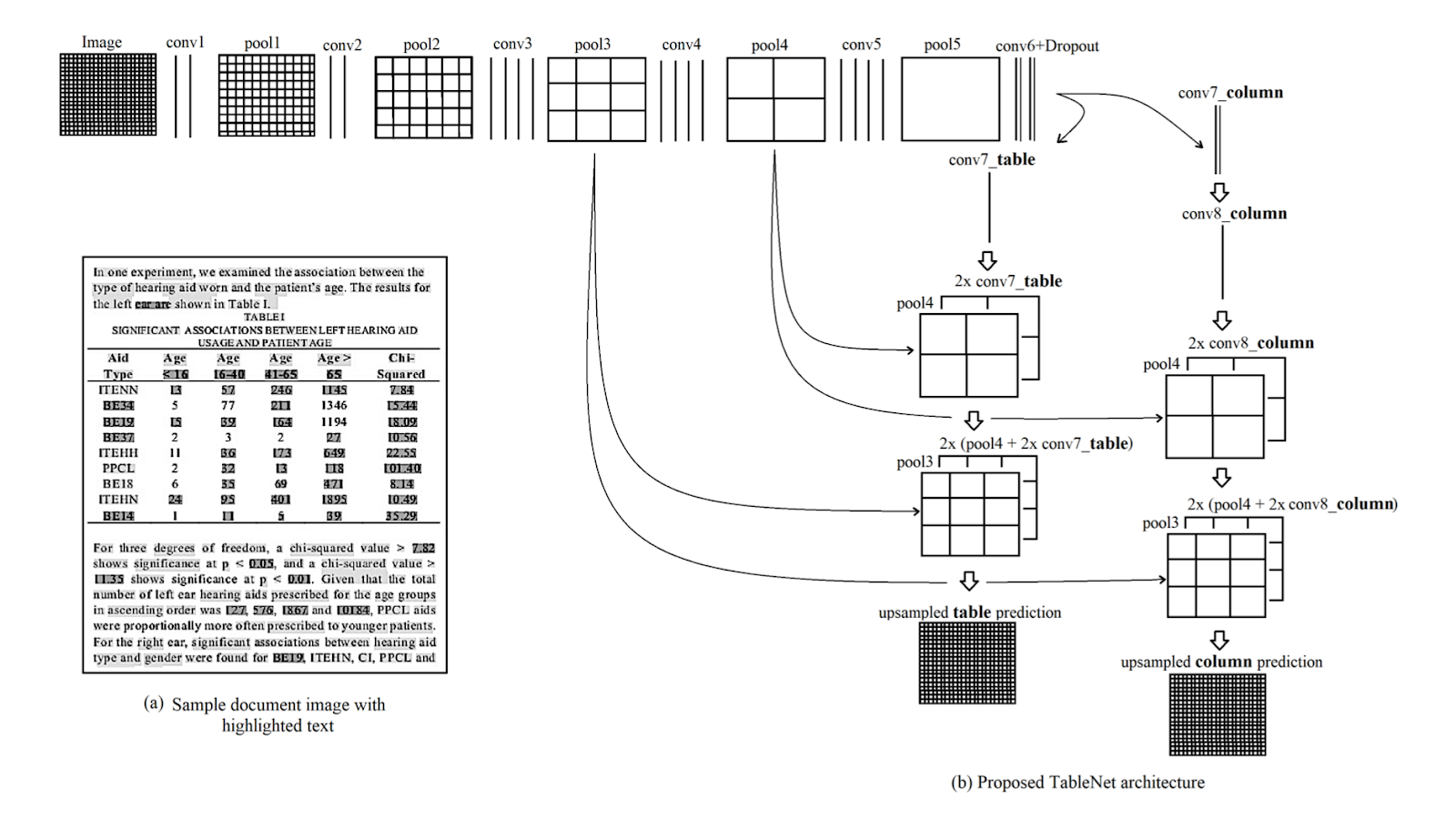

Esittely: TableNet on moderni syvän oppimisen arkkitehtuuri, jonka ehdotti TCS-tutkimusvuoden ryhmä vuonna 2019. Tärkein motivaatio oli tietojen poimiminen skannattuista taulukoista matkapuhelimien tai kameroiden avulla.

He ehdottivat ratkaisua, joka sisältää kuvan taulukoidun alueen tarkan havaitsemisen ja myöhemmin tiedon havaitsemisen ja poimimisen havaitun taulukon riveistä ja sarakkeista.

aineisto: Käytetty tietojoukko oli Marmot. Sillä on 2000 sivua PDF-muodossa, jotka on kerätty vastaavilla perusteilla. Tämä sisältää myös kiinalaiset sivut. Linkki - http://www.icst.pku.edu.cn/cpdp/sjzy/index.htm

Arkkitehtuuri: Arkkitehtuuri perustuu Long et al.:iin, semanttisen segmentoinnin kooderi-dekooderimalliin. Samaa kooderi/dekooderiverkkoa käytetään FCN-arkkitehtuurina taulukon purkamiseen. Kuvat esikäsitellään ja muokataan käyttämällä Tesseract OCR.

Malli johdetaan kahdessa vaiheessa alistamalla panos syvän oppimisen tekniikoille. Ensimmäisessä vaiheessa he ovat käyttäneet ennalta koulutetun VGG-19-verkon painoja. He ovat korvanneet käytetyn VGG-verkon täysin kytketyt kerrokset 1 × 1 -volyvoidulla kerroksella. Kaikkia konvoluutiokerroksia seuraa ReLU-aktivointi ja todennäköisyyden poistumiskerros 0.8. He kutsuvat toista vaihetta dekoodattuun verkkoon, joka koostuu kahdesta haarasta. Tämä on intuition mukaan, että sarakealue on osa taulukkoaluetta. Siten yksi koodausverkko voi suodattaa aktiiviset alueet paremmin tarkkuudella käyttämällä sekä taulukko- että sarakealueiden ominaisuuksia. Ensimmäisen verkon tuotos jaetaan kahteen haaraan. Ensimmäisessä haarassa käytetään kahta konvoluutiooperaatiota ja lopullinen ominaisuuskartta skaalataan vastaamaan alkuperäisiä kuvan mittoja. Toisessa pilarien havaitsemiseksi tarkoitetussa haarassa on ylimääräinen konvoluutiokerros, jossa on ReLU-aktivointitoiminto, ja poistumiskerros, jolla on sama tippujen todennäköisyys kuin edellä mainittiin. Ominaisuuskartat näytteistetään ylöspäin käyttämällä jaksotettuja konvoluutioita (1x1) -voluutiokerroksen jälkeen. Alla on kuva arkkitehtuurista:

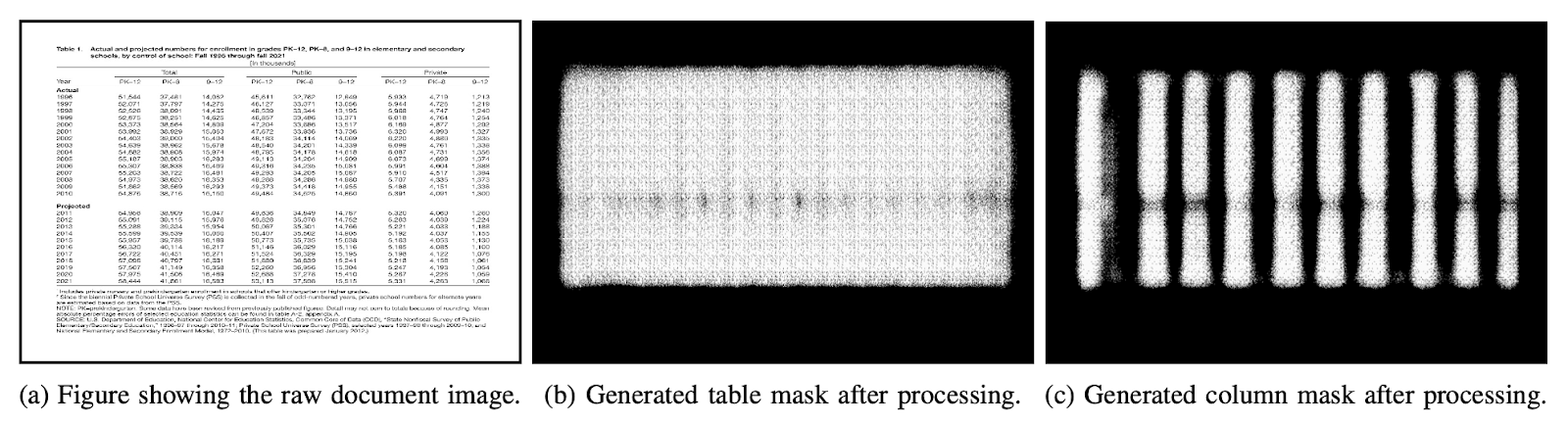

Lähdöt: Kun asiakirjat on käsitelty mallilla, taulukkojen ja sarakkeiden peitteet luodaan. Näitä maskeja käytetään suodattamaan taulukko ja sen sarakealueet kuvasta. Nyt käyttämällä Tesseract-tekstintunnistusta, tiedot puretaan segmentoiduista alueista. Alla on kuva maskeista, jotka luodaan ja myöhemmin poistetaan taulukoista:

He ehdottivat myös samaa mallia, joka on hienosäädetty ICDAR: lla, joka toiminut paremmin kuin alkuperäinen malli. Hienosäädetyn mallin Recall-, Precision- ja F1-Score-arvot ovat vastaavasti 0.9628, 0.9697, 0.9662. Alkuperäisen mallin mittatiedot ovat 0.9621, 0.9547, 0.9583 samassa järjestyksessä. Sukellaan nyt uuteen arkkitehtuuriin.

DeepDeSRT

Paperi: DeepDeSRT: Syvä oppiminen asiakirjakuvien taulukoiden havaitsemiseksi ja rakenteen tunnistamiseksi

Esittely: DeepDeSRT on hermoverkkokehys, jota käytetään dokumenttien tai kuvien taulukkojen havaitsemiseen ja ymmärtämiseen. Sillä on kaksi otsikossa mainittua ratkaisua:

- Se tarjoaa syvän oppimispohjaisen ratkaisun asiakirjakuvien taulukkojen havaitsemiseksi.

- Se ehdottaa uutta syvälle oppimiseen perustuvaa lähestymistapaa taulukkorakenteen tunnistamiseen, toisin sanoen rivien, sarakkeiden ja solujen tunnistamiseen havaituissa taulukoissa.

Ehdotettu malli on täysin tietopohjainen, se ei vaadi heuristiikkaa tai asiakirjojen tai kuvien metatietoja. Yksi tärkein etu koulutukseen nähden on se, että he eivät käyttäneet suuria koulutustietojoukkoja, vaan käyttivät siirto-oppimisen ja verkkotunnuksen mukauttamisen käsitettä sekä taulukon havaitsemiseksi että taulukon rakenteen tunnistamiseen.

aineisto: Käytetty tietoaineisto on ICDAR 2013 -taulukkokilpailuja sisältävä tietokokonaisuus, joka sisältää 67 asiakirjaa ja 238 sivua.

Arkkitehtuuri:

- Taulukon tunnistus Ehdotetussa mallissa käytettiin nopeaa RCNN: ää peruskehyksenä taulukoiden havaitsemiseksi. Arkkitehtuuri on jaettu kahteen osaan. Ensimmäisessä osassa he tuottivat alueellisia ehdotuksia ns. Alueehdotusverkoston (RPN) syöttökuvan perusteella. Toisessa osassa he luokittelivat alueet Fast-RCNN-menetelmällä. Tämän arkkitehtuurin tukemiseksi he käyttivät ZFNet ja VGG-16: n painot.

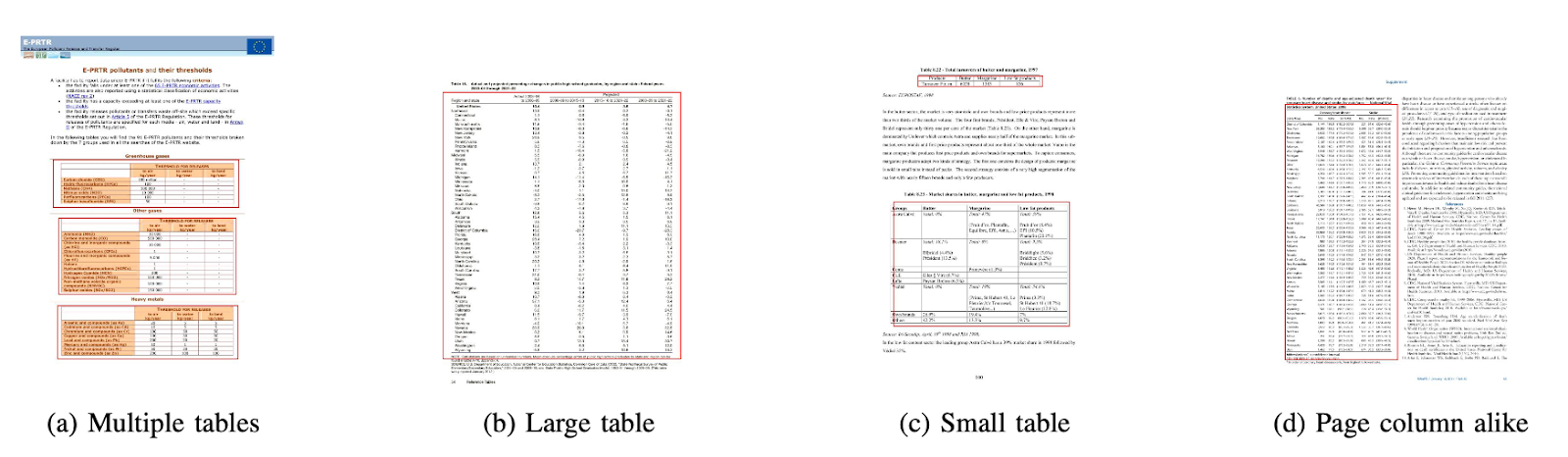

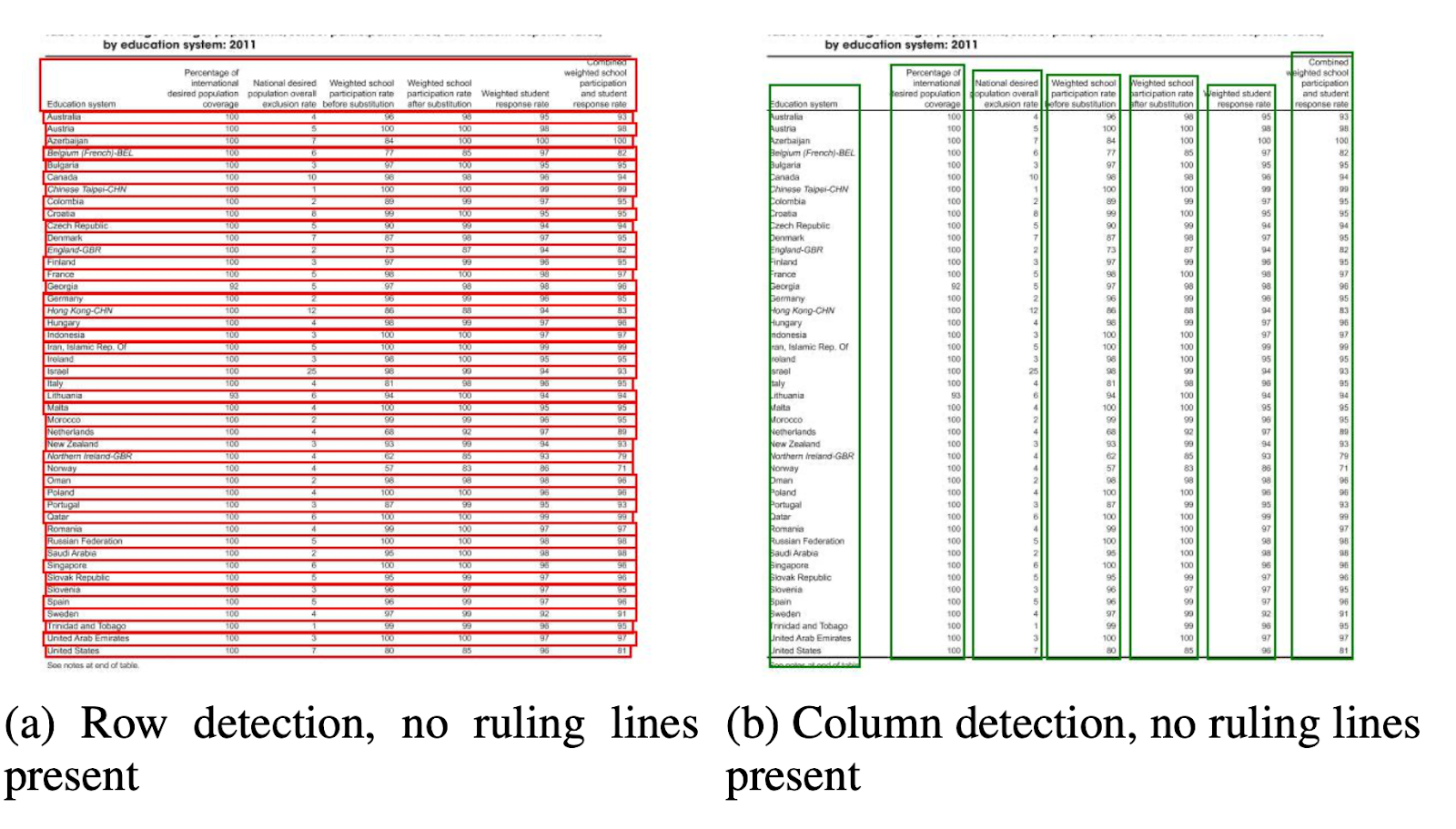

- Rakenteen tunnustaminen Kun taulukko on onnistuneesti havaittu ja sen sijainti on tiedossa järjestelmälle, seuraava haaste sen sisällön ymmärtämisessä on tunnistaa ja paikantaa rivit ja sarakkeet, jotka muodostavat taulukon fyysisen rakenteen. Siksi he ovat käyttäneet täysin kytkettyä verkkoa VGG-16: n painoilla, joka poimii tietoja riveistä ja sarakkeista. Alla on DeepDeSRT: n tulokset:

Lähdöt:

Arviointitulokset paljastavat, että DeepDeSRT ylittää huipputekniset menetelmät taulukon havaitsemiseksi ja rakenteen tunnistamiseksi ja saavuttaa taulukon havaitsemiseksi ja rakenteen tunnistamiseksi vastaavasti F1-mitat 96.77% ja 91.44% vuoteen 2015 saakka.

Graafiset neuroverkot

Paperi: Taulukon tunnistuksen uudelleentarkastelu Graph Neural Networks -verkkojen avulla

Esittely: Tässä tutkimuksessa kansallisen tekoälyn keskuskeskuksen (NCAI) syvän oppimisen laboratorion kirjoittajat ehdottivat graafisia neuroverkkoja tietojen poimimiseksi taulukoista. He väittivät, että kuvaajaverkot ovat luonnollisempi valinta näihin ongelmiin, ja tutkittiin edelleen kahta gradienttipohjaista graafista hermoverkkoa.

Tämä ehdotettu malli yhdistää sekä konvoluutiohermoverkkojen edut visuaalisten ominaisuuksien poiminnassa että kuvaajaverkkojen edut ongelman rakenteen käsittelemisessä.

aineisto: Kirjoittajat ehdottivat uutta synteettisesti tuotettua 0.5 miljoonan taulukon tietokokonaisuutta, jotka on jaettu neljään luokkaan.

- Kuvat ovat tavallisia kuvia ilman sulautumista ja hallitsevia viivoja

- Kuvilla on erilaisia reunatyyppejä, mukaan lukien ajoittain puuttuvat hallitsevat viivat

- Esittää solujen ja sarakkeiden yhdistämisen

- Kamera otti kuvia lineaarisella perspektiivimuutoksella

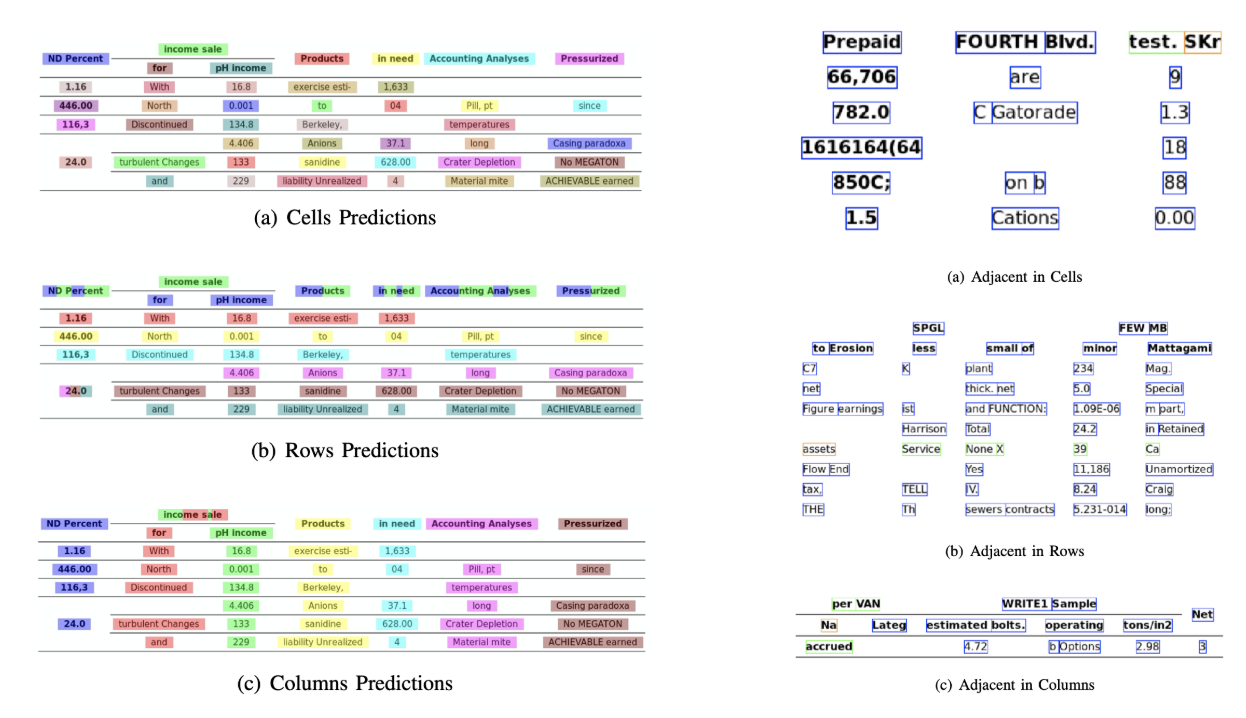

Arkkitehtuuri: He käyttivät matalaa konvoluutioverkkoa, joka tuottaa vastaavat konvoluutioominaisuudet. Jos lähtöominaisuuksien tilamitat eivät ole samat kuin syöttökuva, ne keräävät sijainnit, jotka pienennetään lineaarisesti tulo- ja lähtömittojen suhteesta riippuen, ja lähettävät ne vuorovaikutusverkkoon, jossa on kaksi graafista verkkoa, joka tunnetaan nimellä DGCNN ja GravNet. Graafiverkon parametrit ovat samat kuin alkuperäinen CNN. Loppujen lopuksi he ovat käyttäneet runtime pair -näytteitä luokittelemaan uutettavan sisällön, joka käytti sisäisesti Monte Carlo -algoritmia. Alla on tuotokset:

Lähdöt:

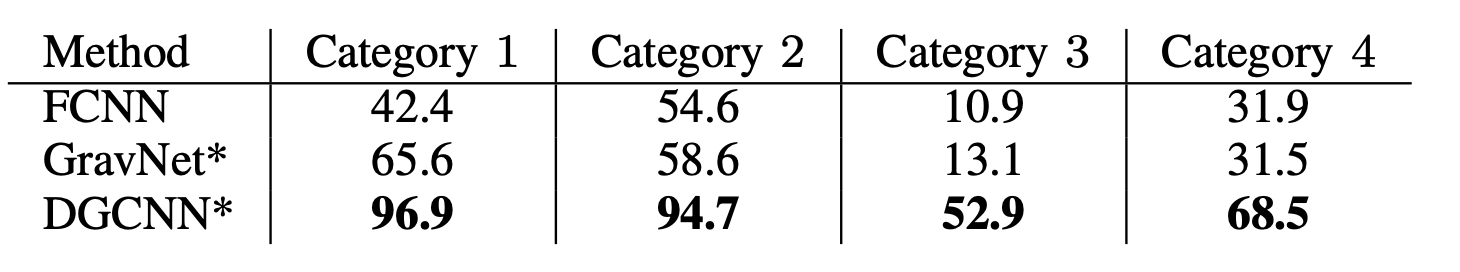

Alla on taulukkojen tarkkuusnumerot, jotka verkot muodostavat neljälle verkkokategorialle, kuten aineisto jakso:

CGAN ja geneettiset algoritmit

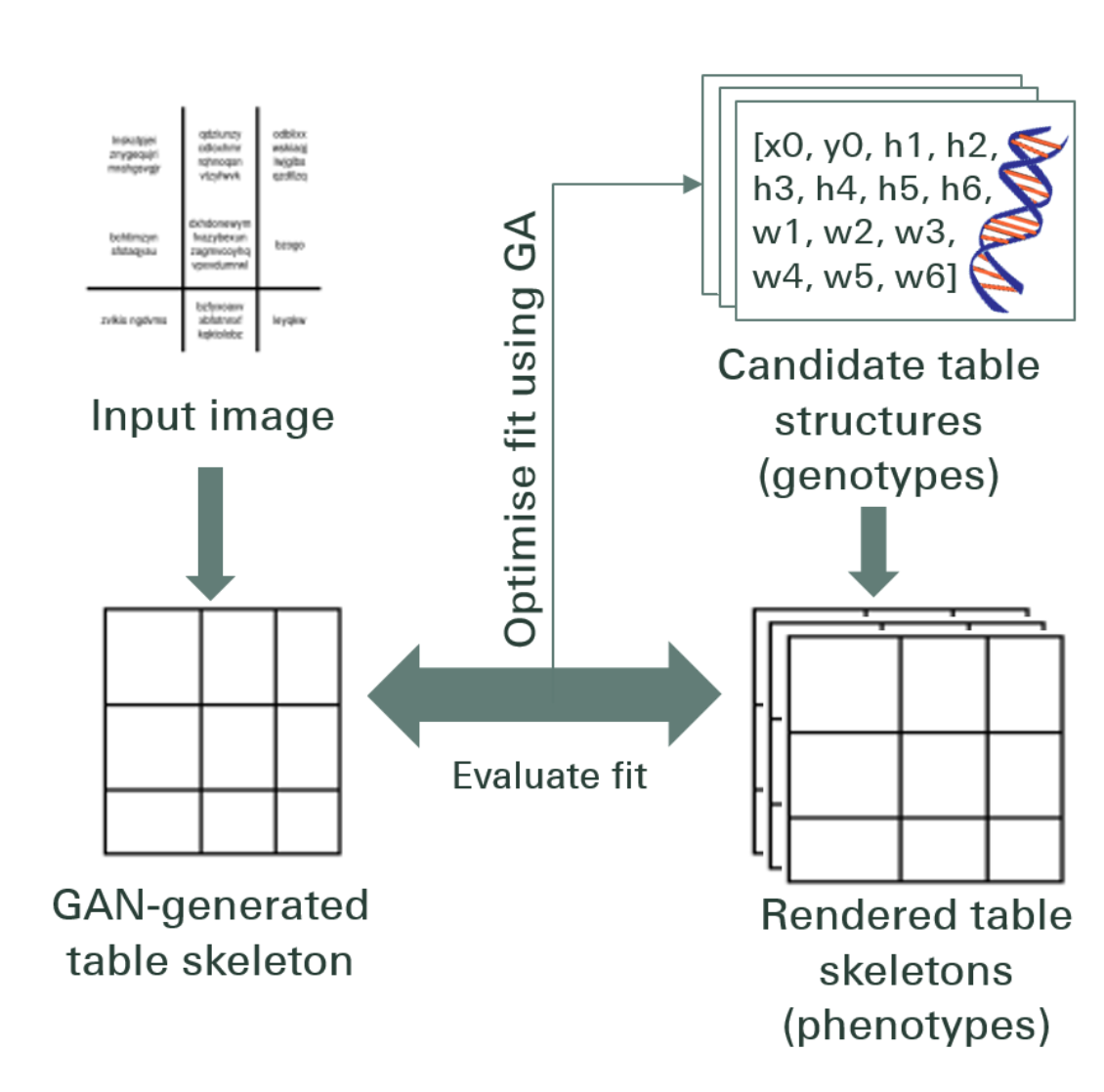

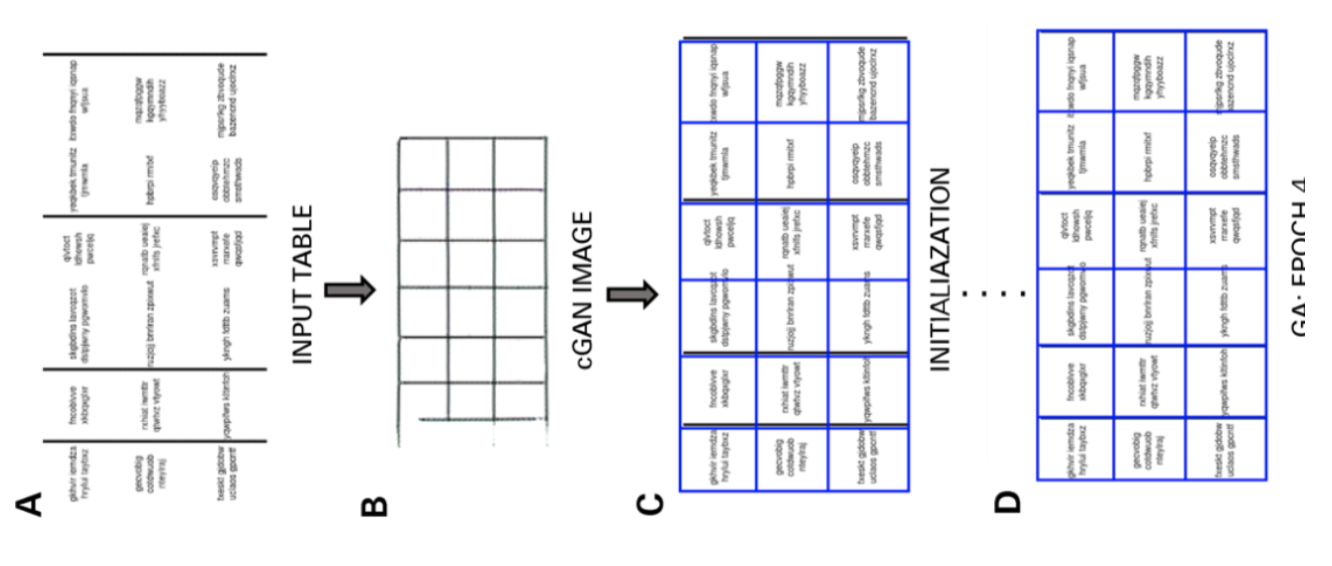

Esittely: Tässä tutkimuksessa kirjoittajat käyttivät ylhäältä alas suuntautuvaa lähestymistapaa sen sijaan, että käyttäisivät alhaalta ylöspäin suuntautuvaa (linjojen integrointi soluihin, riveihin tai sarakkeisiin) -lähestymistapaa.

Tässä menetelmässä, käyttämällä generatiivista kilpailevaa verkostoa, he kartoittivat taulukkokuvan standardoituun "luurankoon" taulukon muotoon. Tämä luurankotaulukko tarkoittaa likimääräisiä rivien ja sarakkeiden reunoja ilman taulukon sisältöä. Seuraavaksi ne sopivat ehdokkaiden piilevien taulukkorakenteiden renderöinnit luurankorakenteeseen käyttämällä etäisyysmittaa, joka on optimoitu geneettisellä algoritmilla.

aineisto: Kirjoittajat käyttivät omaa tietojoukkoa, jossa on 4000 taulukkoa.

Arkkitehtuuri: Ehdotettu malli koostuu kahdesta osasta. Ensimmäisessä osassa syöttökuvat on abstrakti luustotaulukoihin käyttämällä ehdollista generatiivista vastustavaa hermoverkkoa. GAN-verkossa on jälleen kaksi verkkoa, generaattori, joka generoi satunnaisia näytteitä, ja erotin, joka kertoo onko generoidut kuvat vääriä vai alkuperäisiä. Generaattori G on kooderi-dekooderiverkko, jossa syötekuva johdetaan asteittain alaspäin otettavien kerrosten sarjan läpi pullonkaulakerrokseen, jossa prosessi käännetään. Riittävän tiedon siirtämiseksi dekoodauskerroksille käytetään ohitusyhteyksillä varustettua U-Net-arkkitehtuuria ja lisätään ohitusyhteys kerrosten i ja n - i väliin yhdistämällä, missä n on kerrosten kokonaismäärä ja i on kerroksen numero kooderissa. Erottelijaan D käytetään PatchGAN-arkkitehtuuria. Tämä rankaisee lähtökuvan rakennetta korjaustietojen mittakaavassa. Ne tuottavat tuotoksen luurankoina.

Toisessa osassa ne optimoivat latenttiehdokkaiden ehdokasrakenteiden sopivuuden generoituun luurankokuvaan käyttämällä mittaa etäisyyttä kunkin ehdokkaan ja luurankon välillä. Näin kuvien sisäinen teksti puretaan. Alla on arkkitehtuuria kuvaava kuva:

ulostulo: Arvioidut taulukkorakenteet arvioidaan vertaamalla - Rivin ja sarakkeen numero, vasemman yläkulman sijainti, rivin korkeus ja sarakkeen leveys

Geneettinen algoritmi antoi 95.5% tarkkuuden rivittäin ja 96.7% tarkkuuden sarakkeittain samalla, kun uutettiin tietoja taulukoista.

Asiakirjat on digitoitava, tulot or laskut mutta liian laiska koodaamaan? Suuntaa kohti Nanonetit ja rakenna OCR-malleja ilmaiseksi!

[Koodi] Perinteiset lähestymistavat

Tässä osiossa opitaan prosessi, jolla tiedot voidaan poimia taulukoista käyttämällä Deep Learning- ja OpenCV-ohjelmia. Voit ajatella tätä selitystä johdannona, mutta huipputeknisten mallien rakentaminen vaatii paljon kokemusta ja käytäntöä. Tämä auttaa sinua ymmärtämään perusteet siitä, kuinka voimme kouluttaa tietokoneita erilaisilla mahdollisilla lähestymistavoilla ja algoritmeilla.

Jotta ongelma ymmärrettäisiin tarkemmin, määrittelemme joitain perustermejä, joita käytetään koko artikkelissa:

- teksti: sisältää merkkijonon ja viisi määritteitä (ylä, vasen, leveys, korkeus, fontti)

- linja: sisältää tekstiobjekteja, joiden oletetaan olevan samalla rivillä alkuperäisessä tiedostossa

- Yksilinjainen: riviobjekti, jossa on vain yksi tekstiobjekti.

- Monirivinen: rivikohta, jossa on useampi kuin yksi tekstiobjekti.

- Monirivinen Tukkia: sarja jatkuvia monirivisiä objekteja.

- Rivi: Vaakasuorat lohkot taulukossa

- Sarake: Pystysuorat lohkot taulukossa

- Solu: rivin ja sarakkeen leikkauspiste

- Solu - tyyny: sisäinen pehmuste tai tila kennon sisällä.

Taulukon havaitseminen OpenCV: llä

Käytämme perinteisiä tietokonenäkötekniikoita tietojen poimimiseksi skannatusta taulukosta. Tässä on putkilinjamme; aluksi kaappaamme tiedot (taulukot, joista meidän on poistettava tiedot) tavallisilla kameroilla, ja sitten tietokonenäkymän avulla yritämme löytää reunat, reunat ja solut. Käytämme erilaisia suodattimia ja muotoja, ja korostamme taulukkojen keskeiset piirteet.

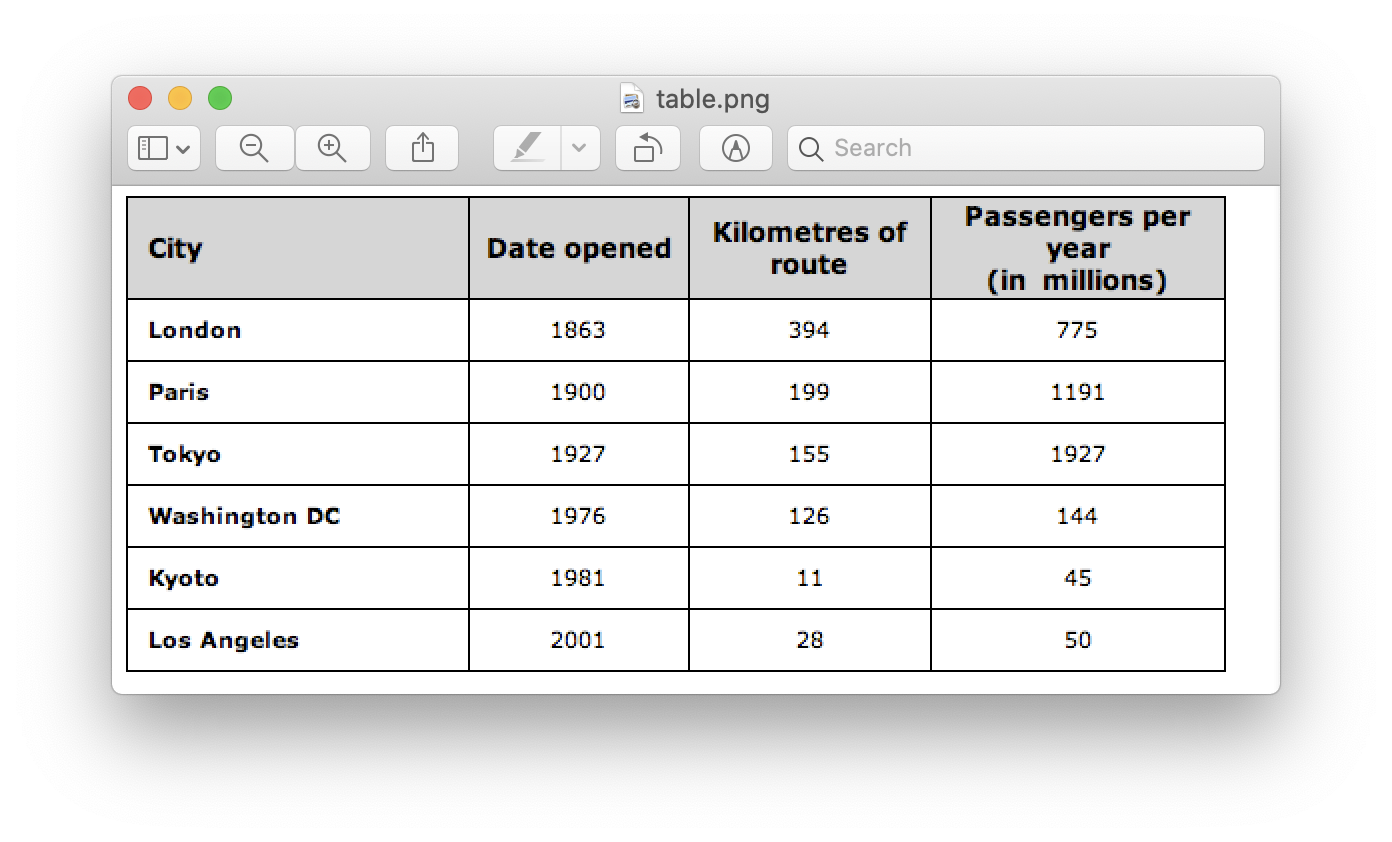

Tarvitsemme kuvan taulukosta. Voimme kaapata tämän puhelimessa tai käyttää mitä tahansa olemassa olevaa kuvaa. Alla on koodinpätkä,

file = r’table.png’

table_image_contour = cv2.imread(file, 0)

table_image = cv2.imread(file)

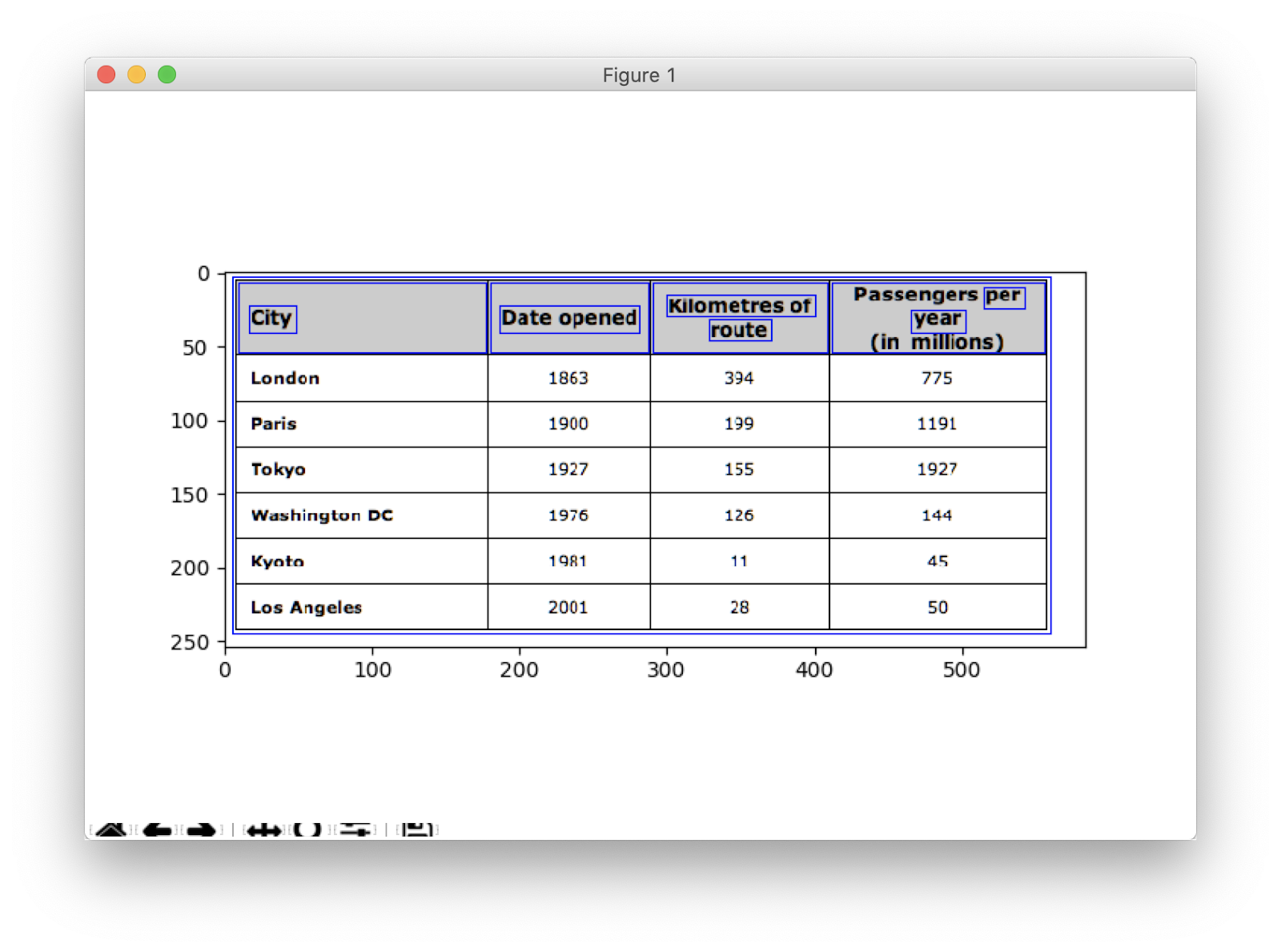

Täällä olemme ladaneet saman kuvakuvan kaksi muuttujaa, koska käytämme table_image_contour kun piirrät havaitut muodot ladattuun kuvaan. Alla on taulukon kuva, jota käytämme ohjelmassamme:

Käytämme tekniikkaa, jota kutsutaan Kuvan käänteinen kynnys joka parantaa annetussa kuvassa olevaa dataa.

ret, thresh_value = cv2.threshold( table_image_contour, 180, 255, cv2.THRESH_BINARY_INV)

Toinen tärkeä esikäsittelyvaihe on kuvan laajentuminen. Laajennus on yksinkertainen matemaattinen toimenpide, jota käytetään binaarikuviin (mustavalkoinen) ja joka laajentaa asteittain etualan pikselien alueiden rajoja (eli valkoiset pikselit, tyypillisesti).

kernel = np.ones((5,5),np.uint8)

dilated_value = cv2.dilate(thresh_value,kernel,iterations = 1)

OpenCV: ssä käytämme menetelmää, etsi Contours muotojen saamiseksi esillä olevasta kuvasta. Tämä menetelmä vie kolme argumenttia, ensin on laajennettu kuva (kuva, jota käytetään laajennetun kuvan luomiseen, on taulukon kuva / muoto) - findContours-menetelmä tukee vain binaarikuvia), toinen on cv2.RETR_TREE joka kehottaa meitä käyttämään muodon hakutilaa, kolmas on cv2.CHAIN_APPROX_SIMPLE mikä on muodon lähentämistila. etsi Contours purkaa kaksi arvoa, joten lisäämme vielä yhden muuttujan nimeltä hierarkia. Kun kuvat ovat sisäkkäisiä, ääriviivat aiheuttavat keskinäistä riippuvuutta. Tällaisten suhteiden esittämiseksi käytetään hierarkiaa.

contours, hierarchy = cv2.findContours( dilated_value, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

Muodot merkitsevät sitä, missä tiedot tarkalleen ovat kuvassa. Nyt siirrymme edellisessä vaiheessa laskettujen muotojen luetteloon ja laskemme suorakulmaisten laatikoiden koordinaatit alkuperäisessä kuvassa havaittujen menetelmien avulla, cv2.boundingRect. Viimeisessä iteraatiossa laitoimme nuo ruudut alkuperäiseen kuvataulukkoon_kuva käyttämällä menetelmää, cv2.rectangle ().

for cnt in contours: x, y, w, h = cv2.boundingRect(cnt) # bounding the images if y < 50: table_image = cv2.rectangle(table_image, (x, y), (x + w, y + h), (0, 0, 255), 1) Tämä on viimeinen askelmme. Käytämme tässä menetelmää nimetty ikkuna tehdä pöydästämme upotettu sisältö ja siihen upotetut muodot. Alla on koodinpätkä:

plt.imshow(table_image)

plt.show()

cv2.namedWindow('detecttable', cv2.WINDOW_NORMAL)

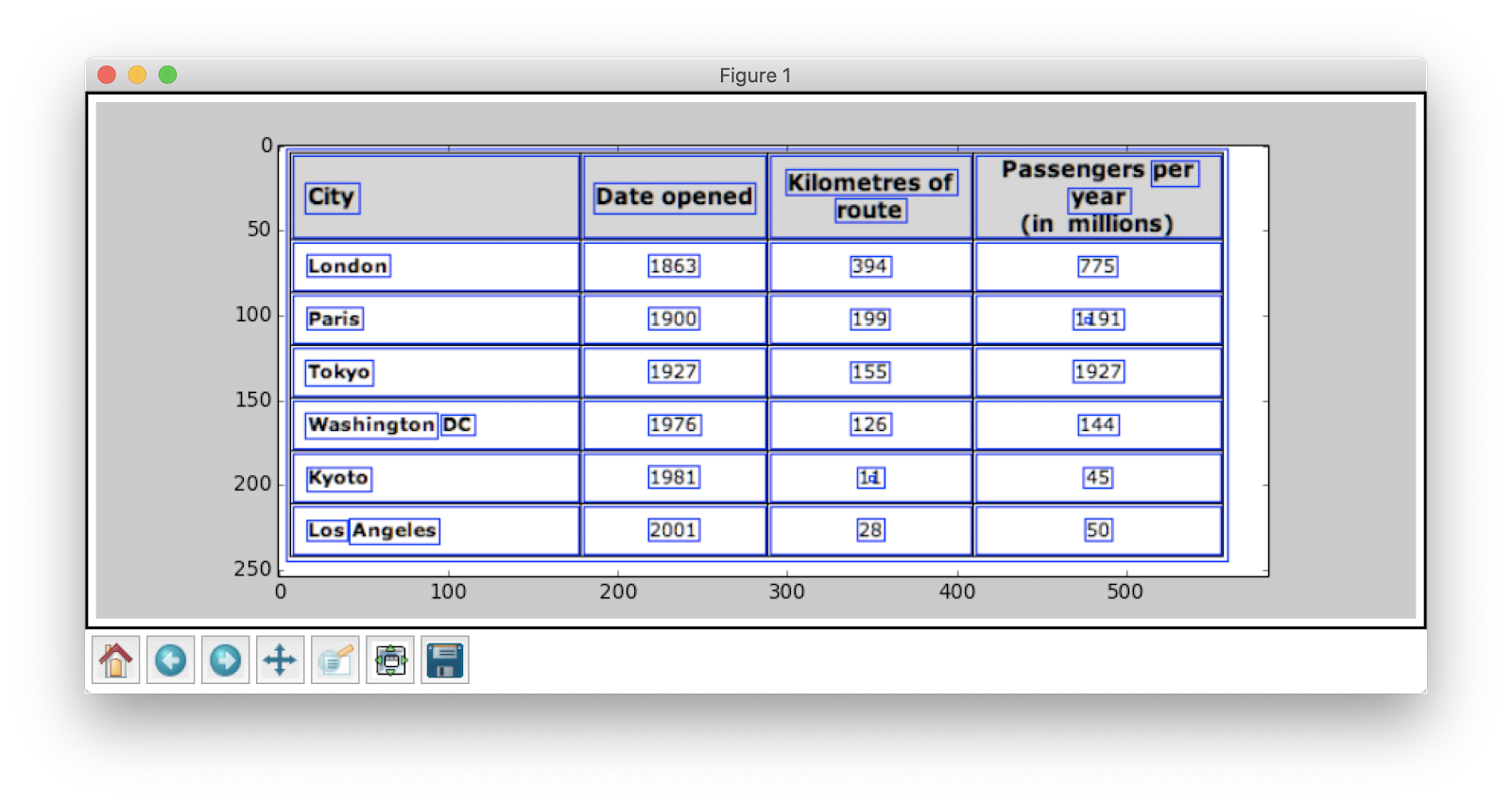

Muuta y-arvo arvoon 300 yllä olevassa koodinpätkässä, tämä on tulos:

Kun pöydät on poimittu, voit suorittaa jokaisen muodon rajauksen tesseract OCR -moottorin kautta, jonka opas löytyy tätä. Kun meillä on laatikot jokaisesta tekstistä, voimme ryhmitellä ne niiden x- ja y-koordinaattien perusteella saadakseen vastaavan rivin ja sarakkeen.

Tämän lisäksi PDFMinerillä on mahdollisuus muuttaa pdf-dokumentit HTML-tiedostoiksi, jotka voimme jäsentää säännöllisten lausekkeiden avulla saadaksemme vihdoin taulukot. Näin voit tehdä sen.

PDFMiner- ja Regex-jäsennys

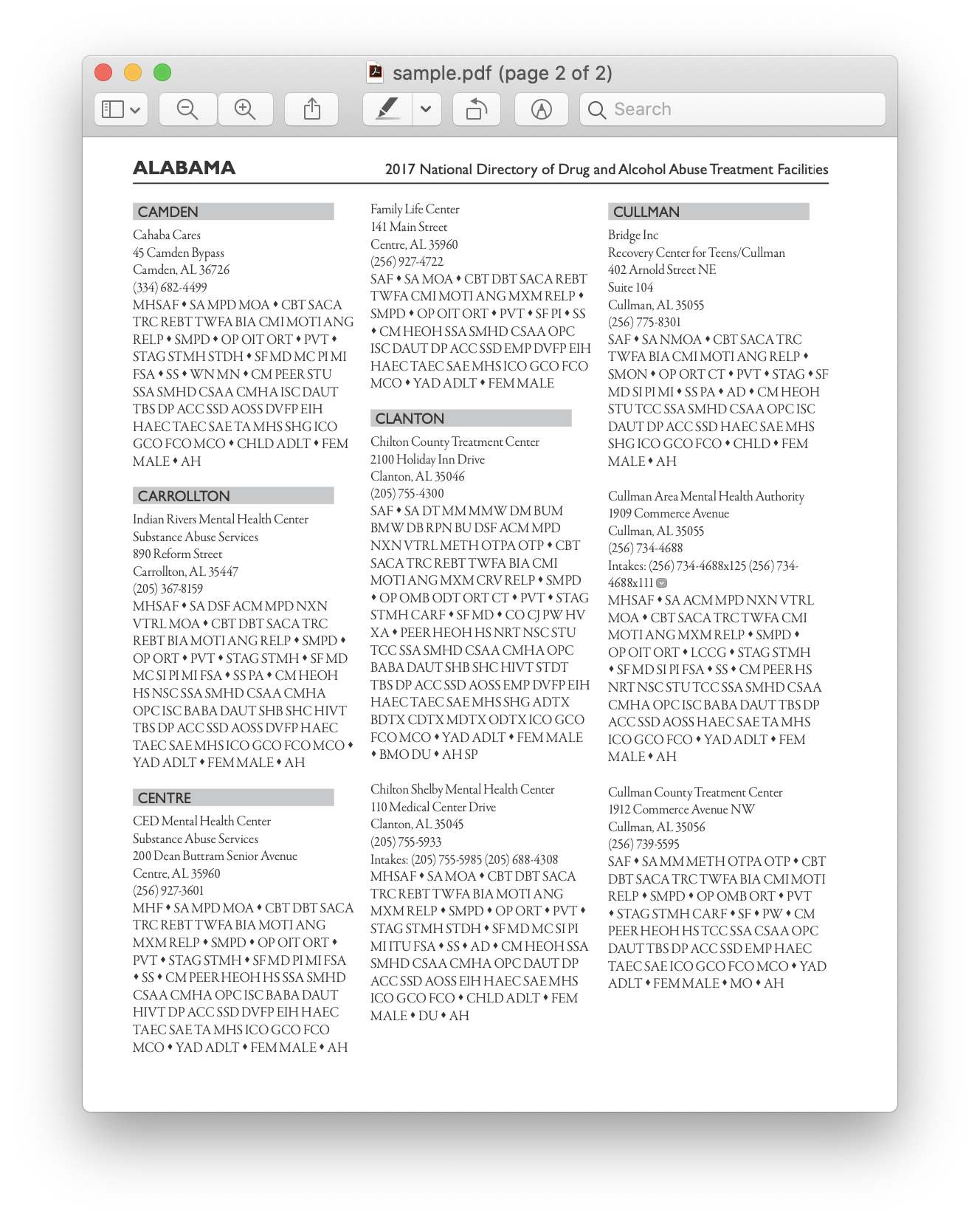

Tietojen poimimiseksi pienemmistä asiakirjoista on aikaa määrittää syväoppimismalleja tai kirjoittaa tietokonenäköalgoritmeja. Sen sijaan voimme käyttää Pythonissa säännöllisiä lausekkeita poimia tekstiä PDF-dokumenteista. Muista myös, että tämä tekniikka ei toimi kuville. Voimme käyttää tätä vain tietojen poimimiseen HTML-tiedostoista tai PDF-dokumenteista. Tämä johtuu siitä, että kun käytät säännöllistä lauseketta, sinun on sovitettava sisältö lähdekoodiin ja poimittava tiedot. Kuvien kanssa et pysty täsmäämään tekstiä ja säännölliset lausekkeet epäonnistuvat. Työstetään nyt yksinkertaisen PDF-dokumentin kanssa ja poimitaan tiedot sen taulukoista. Alla on kuva:

Ensimmäisessä vaiheessa lataamme PDF-ohjelman ohjelmaan. Kun se on valmis, muuntamme PDF-tiedoston HTML-muotoon, jotta voimme käyttää suoraan säännöllisiä lausekkeita ja siten purkaa sisältöä taulukoista. Tätä varten käyttämämme moduuli on pdfminer. Tämä auttaa lukemaan sisältöä PDF: stä ja muuntamaan sen HTML-tiedostoksi.

Alla on koodinpätkä:

from pdfminer.pdfinterp import PDFResourceManager from pdfminer.pdfinterp import PDFPageInterpreter

from pdfminer.converter import HTMLConverter

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from pdfminer.pdfpage import PDFPage

from cStringIO import StringIO

import re def convert_pdf_to_html(path): rsrcmgr = PDFResourceManager() retstr = StringIO() codec = 'utf-8' laparams = LAParams() device = HTMLConverter(rsrcmgr, retstr, codec=codec, laparams=laparams) fp = file(path, 'rb') interpreter = PDFPageInterpreter(rsrcmgr, device) password = "" maxpages = 0 #is for all caching = True pagenos=set() for page in PDFPage.get_pages(fp, pagenos, maxpages=maxpages,password=password,caching=caching, check_extractable=True): interpreter.process_page(page) fp.close() device.close() str = retstr.getvalue() retstr.close() return str

Koodipisteet: zevross

Tuomme paljon moduuleja, mukaan lukien Regular Expression- ja PDF-kirjastoja. Menetelmässä convert_pdf_to_html, lähetämme PDF-tiedoston polun, joka on muunnettava HTML-tiedostoksi. Menetelmän tulos on HTML-merkkijono, kuten alla on esitetty:

'<span style="font-family: XZVLBD+GaramondPremrPro-LtDisp; font-size:12px">Changing Echoesn<br>7632 Pool Station Roadn<br>Angels Camp, CA 95222n<br>(209) 785-3667n<br>Intake: (800) 633-7066n<br>SA </span><span style="font-family: GDBVNW+Wingdings-Regular; font-size:11px">s</span><span style="font-family: UQGGBU+GaramondPremrPro-LtDisp; font-size:12px"> TX DT BU </span><span style="font-family: GDBVNW+Wingdings-Regular; font-size:11px">s</span><span style="font-family: UQGGBU+GaramondPremrPro-LtDisp; font-size:12px"> RS RL OP PH </span><span style="font-family: GDBVNW+Wingdings-Regular; font-size:11px">s</span><span style="font-family: UQGGBU+GaramondPremrPro-LtDisp; font-size:12px"> CO CJ n<br></span><span style="font-family: GDBVNW+Wingdings-Regular; font-size:11px">s</span><span style="font-family: UQGGBU+GaramondPremrPro-LtDisp; font-size:12px"> SF PI </span><span style="font-family: GDBVNW+Wingdings-Regular; font-size:11px">s</span><span style="font-family: UQGGBU+GaramondPremrPro-LtDisp; font-size:12px"> AH SPn<br></span></div>' Säännöllinen lauseke on yksi vaikeimmista ja tyylikkäimmistä ohjelmointitekniikoista, joita käytetään kuvioiden sovittamiseen. Niitä käytetään laajasti useissa sovelluksissa, esimerkiksi koodin muotoiluun, web-kaavioon ja validointitarkoituksiin. Ennen kuin aloitamme uutettavan sisältöä HTML-taulukoistamme, opitaan nopeasti muutamia asioita säännöllisistä lausekkeista.

Tämä kirjasto tarjoaa erilaisia sisäänrakennettuja menetelmiä mallien hakuun ja hakuun. Alla on muutama:

import re # Match the pattern in the string

re.match(pattern, string) # Search for a pattern in a string

re.search(pattern, string) # Finds all the pattern in a string

re.findall(pattern, string) # Splits string based on the occurrence of pattern

re.split(pattern, string, [maxsplit=0] # Search for the pattern and replace it with the given string

re.sub(pattern, replace, string)

Merkkejä / lausekkeita, joita yleensä näet säännöllisissä lausekkeissa, ovat:

- [AZ] - mikä tahansa iso kirjain

- d - numero

- w - sanamerkki (kirjaimet, numerot ja alaviivat)

- s - välilyönti (välilyönnit, sarkaimet ja välilyönnit)

Nyt selvittääksemme tietyn mallin HTML: ssä, käytämme säännöllisiä lausekkeita ja kirjoitamme sitten mallit vastaavasti. Jaotimme ensin tiedot siten, että osoitepalikat erotetaan erillisiksi lohkoiksi ohjelman nimen (ANGELS CAMP, APPLE VALLEY jne.) Mukaisesti:

pattern = '(?<=<span style="font-family: XZVLBD+GaramondPremrPro-LtDisp; font-size:12px">)(.*?)(?=<br></span></div>)' for programinfo in re.finditer(pattern, biginputstring, re.DOTALL): do looping stuff…

Myöhemmin löydämme ohjelman nimen, kaupungin, osavaltion ja postinumeron, jotka seuraavat aina samaa mallia (teksti, pilkku, kaksinumeroiset isot kirjaimet, 5 numeroa (tai 5 numeroa yhdysmerkkejä neljä numeroa) - nämä ovat läsnä PDF-tiedostossa, joka pidimme panoksena). Tarkista seuraava koodinpätkä:

# To identify the program name

programname = re.search('^(?!<br>).*(?=\n)', programinfo.group(0))

# since some programs have odd characters in the name we need to escape

programname = re.escape(programname) citystatezip =re.search('(?<=>)([a-zA-Zs]+, [a-zA-Zs]{2} d{5,10})(?=\n)', programinfo.group(0))

mainphone =re.search('(?<=<br>)(d{3}) d{3}-d{4}x{0,1}d{0,}(?=\n)', programinfo.group(0))

altphones = re.findall('(?<=<br>)[a-zA-Zs]+: (d{3}) d{3}-d{4}x{0,1}d{0,}(?=\n)(?=\n)', programinfo.group(0)) Tämä on yksinkertainen esimerkki, joka selittää kuinka poimimme tietoja PDF-tiedostoista säännöllisen lausekkeen avulla. Kun olet purkanut kaikki vaadittavat tiedot, lataamme nämä tiedot CSV-tiedostoon.

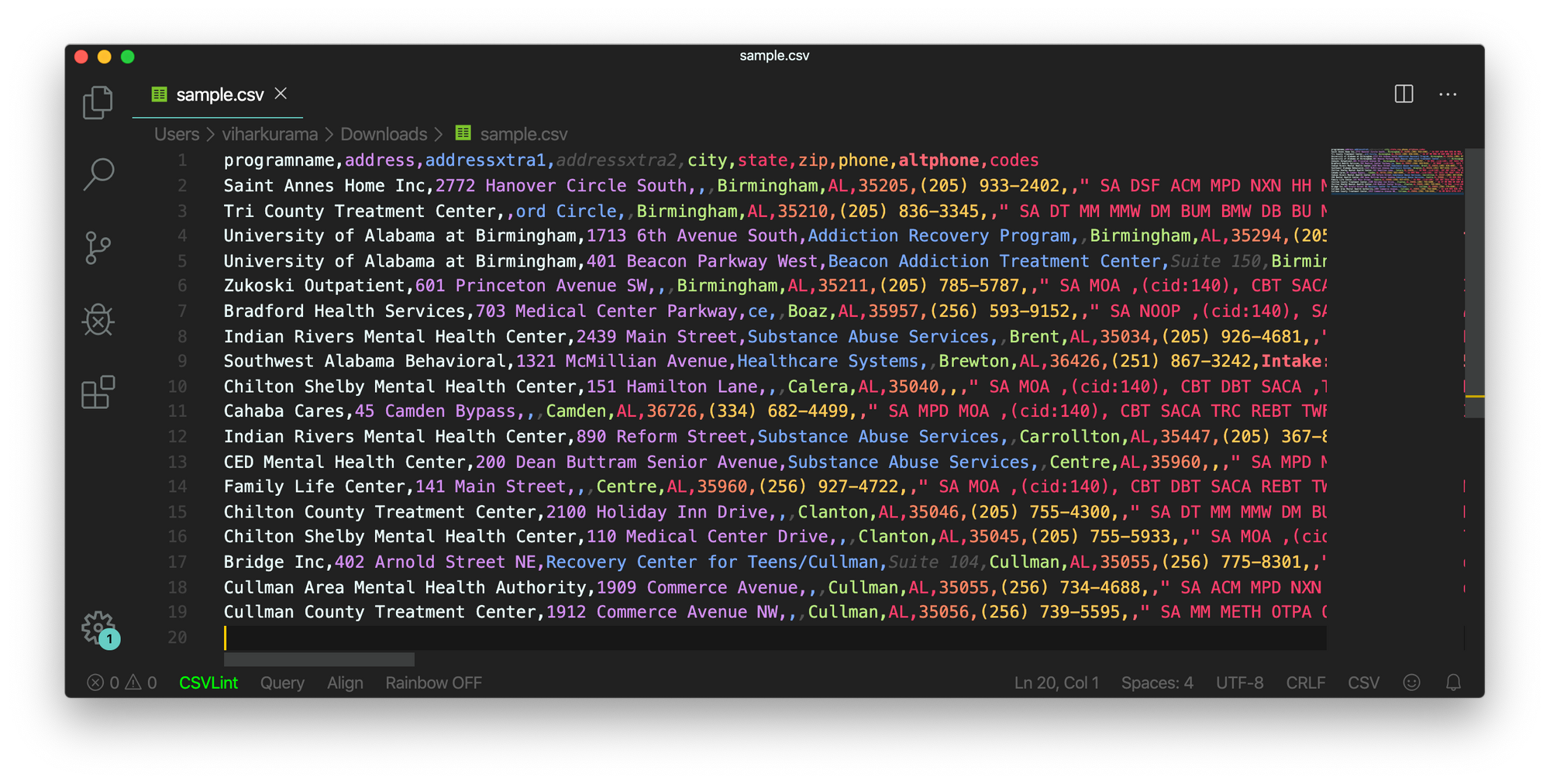

def createDirectory(instring, outpath, split_program_pattern): i = 1 with open(outpath, 'wb') as csvfile: filewriter = csv.writer(csvfile, delimiter=',' , quotechar='"', quoting=csv.QUOTE_MINIMAL) # write the header row filewriter.writerow(['programname', 'address', 'addressxtra1', 'addressxtra2', 'city', 'state', 'zip', 'phone', 'altphone', 'codes']) # cycle through the programs for programinfo in re.finditer(split_program_pattern, instring, re.DOTALL): print i i=i+1 # pull out the pieces programname = getresult(re.search('^(?!<br>).*(?=\n)', programinfo.group(0))) programname = re.escape(programname) # some facilities have odd characters in the name

Joten tämä on yksinkertainen esimerkki, joka selittää kuinka voit viedä puretun HTML-tiedoston CSV-tiedostoon. Ensin luomme CSV-tiedoston, löydämme kaikki määritteemme ja työnnä yksi kerrallaan vastaaviin sarakkeisiin. Alla on kuvakaappaus:

Toisinaan yllä mainitut tekniikat vaikuttavat monimutkaisilta ja aiheuttavat haasteita ohjelmoijille, jos kaikki taulukot ovat sisäkkäisiä ja monimutkaisia. Täällä CV: n tai syvän oppimisen mallin valitseminen säästää paljon aikaa. Katsotaanpa, mitkä haitat ja haasteet estävät näiden perinteisten menetelmien käyttöä.

Haasteet perinteisillä menetelmillä

Tässä osassa opitaan perusteellisesti siitä, missä pöydän erotusprosessit saattavat epäonnistua, ja ymmärrämme entistä paremmin tapoja poistaa nämä esteet nykyaikaisilla syvän oppimisen menetelmillä syntyneillä menetelmillä. Tämä prosessi ei kuitenkaan ole koukutie. Syynä on, että taulukot eivät yleensä pysy vakiona koko ajan. Niillä on erilaiset rakenteet edustamaan tietoja, ja taulukoiden sisällä olevat tiedot voivat olla monikielisiä erilaisilla muotoilutyyleillä (fonttityyli, väri, fontin koko ja korkeus). Joten rakentaa vankka malli, tulisi olla tietoinen kaikista näistä haasteista. Yleensä tämä prosessi sisältää kolme vaihetta: taulukon havaitseminen, erottaminen ja muuntaminen. Tunnistetaan ongelmat kaikissa vaiheissa yksi kerrallaan:

Taulukon tunnistus

Tässä vaiheessa tunnistetaan missä taulukot tarkalleen ovat annetussa syötteessä. Syöttö voi olla missä tahansa muodossa, kuten Kuvat, PDF / Word-asiakirjat ja joskus videot. Käytämme erilaisia tekniikoita ja algoritmeja havaitaksesi taulukoita joko viivoilla tai koordinaateilla. Joissain tapauksissa saatamme kohdata taulukot, joissa ei ole lainkaan reunoja, joissa meidän on valittava eri menetelmät. Näiden lisäksi tässä on muutama haaste:

- Kuvan muuntaminen: Kuvanmuutos on ensisijainen vaihe tarrojen havaitsemiseksi. Tähän sisältyy taulukossa olevien tietojen ja reunojen parantaminen. Meidän on valittava oikeat esikäsittelyalgoritmit taulukossa esitettyjen tietojen perusteella. Esimerkiksi, kun käsittelemme kuvia, meidän on käytettävä kynnystä ja reuna-ilmaisimia. Tämä muutosvaihe auttaa meitä löytämään sisällön tarkemmin. Joissakin tapauksissa muodot saattavat mennä pieleen ja algoritmit eivät pysty parantamaan kuvaa. Siksi oikeiden kuvanmuunnosvaiheiden ja esikäsittelyn valinta on ratkaisevan tärkeää.

- Kuvanlaatu: Kun skannaamme taulukoita tietojen keräämistä varten, meidän on varmistettava, että nämä asiakirjat skannataan vaaleammassa ympäristössä, mikä varmistaa laadukkaat kuvat. Kun valaistusolosuhteet ovat huonot, CV- ja DL-algoritmit eivät välttämättä pysty havaitsemaan tauluja annetussa tulossa. Jos käytämme syvää oppimista, meidän on varmistettava, että aineisto on yhdenmukainen ja siinä on hyvä vakiokuva. Jos käytämme näitä malleja vanhoissa rypistetyissä papereissa olevissa taulukoissa, ensin on esikäsiteltävä ja poistettava melu näistä kuvista.

- Erilaisia rakenteellisia asetteluja ja malleja: Kaikki taulukot eivät ole ainutlaatuisia. Yksi solu voi ulottua useiden solujen yli, joko pystysuoraan tai vaakasuoraan, ja ulottuvien solujen yhdistelmät voivat luoda suuren määrän rakennevariaatioita. Jotkut korostavat myös tekstin piirteitä, ja taulukkorivit voivat vaikuttaa tapaan, jolla taulukon rakenne ymmärretään. Esimerkiksi vaakaviivat tai lihavoitu teksti voivat korostaa taulukon useita otsikoita. Taulukon rakenne määrittelee visuaalisesti solujen väliset suhteet. Taulukoiden visuaaliset suhteet vaikeuttavat niihin liittyvien solujen löytämistä laskennallisesti ja niistä poimintaa. Siksi on tärkeää rakentaa algoritmeja, jotka ovat kestäviä käsitellessään taulukoiden erilaisia rakenteita.

- Solutyyny, reunat, reunat: Nämä ovat olennaisia asioita kaikille pöydälle - tyynyt, reunat ja reunat eivät aina ole samat. Joissakin taulukoissa on paljon pehmusteita solujen sisällä, ja toisissa ei. Hyvälaatuisten kuvien ja esikäsittelyvaiheiden käyttö auttaa pöydän erotusprosessia sujuvasti.

Taulukon uuttaminen

Tässä vaiheessa tiedot poimitaan, kun taulukot on tunnistettu. Sisällön rakenteeseen ja taulukossa olevaan sisältöön liittyy paljon tekijöitä. Siksi on tärkeää ymmärtää kaikki haasteet ennen kuin algoritmi rakennetaan.

- Tiheä sisältö: Solujen sisältö voi olla joko numeerista tai tekstimuotoista. Tekstisisältö on kuitenkin yleensä tiheää, ja se sisältää epäselviä lyhyitä tekstin paloja lyhenteiden ja lyhenteiden avulla. Taulukoiden ymmärtämiseksi teksti on yksilöitävä ja lyhenteet ja lyhenteet on laajennettava.

- Eri fontit ja muodot: Fontit ovat yleensä eri tyylejä, värejä ja korkeuksia. Meidän on varmistettava, että nämä ovat yleisiä ja helppo tunnistaa. Muutamia kirjasinperheitä, etenkin niitä, jotka kuuluvat kohdistuviin tai käsin kirjoitettuihin, on vähän vaikea saada. Siksi hyvän kirjasimen ja oikean muotoilun käyttö auttaa algoritmia tunnistamaan tiedot tarkemmin.

- Useita sivuja sisältävät PDF-tiedostot ja sivunvaihdot: Taulukoiden tekstirivi on herkkä ennalta määritetylle kynnykselle. Lisäksi, kun solut ulottuvat useille sivuille, taulukoiden tunnistaminen on vaikeaa. Usean pöydän sivulla on vaikea erottaa erilaisia taulukoita toisistaan. Harvojen ja epäsäännöllisten pöytien kanssa on vaikea työskennellä. Siksi graafisia viivoja ja sisällön asettelua tulisi käyttää yhdessä tärkeinä lähteinä taulukkoalueiden havaitsemiseksi.

Taulukon muuntaminen

Viimeinen vaihe sisältää taulukoista poimitun tiedon muuntamisen kääntämällä ne muokattavaksi asiakirjaksi joko excelissä tai käyttämällä muuta ohjelmistoa. Otetaan oppia muutamasta haasteesta.

- Aseta asettelut: Kun skannatuista asiakirjoista poimitaan erilaisia taulukoiden muotoja, meillä on oltava oikea taulukon asettelu sisällön työntämiseksi sisään. Joskus algoritmi ei pysty poimimaan tietoja soluista. Siksi oikean asettelun suunnittelu on myös yhtä tärkeää.

- Erilaisia arvoesitystapoja: Solujen arvot voidaan esittää käyttämällä erilaisia syntaktisia esitysmalleja. Katsotaan taulukon tekstin arvoksi 6 ± 2. Algoritmi saattaa epäonnistua muuntamaan kyseistä tietoa. Siksi numeeristen arvojen erottaminen vaatii mahdollisten esitysmallien tuntemusta.

- Esitys visualisoinnista: Suurin osa taulukkojen esitysmuodoista, kuten merkintäkielet, joilla taulukoita voidaan kuvata, on suunniteltu visualisointiin. Siksi on haastavaa käsitellä taulukoita automaattisesti.

Nämä ovat haasteita, joita kohtaamme pöydän erottamisprosessissa perinteisiä tekniikoita käyttämällä. Nyt katsotaan kuinka voittaa nämä syvän oppimisen avulla. Sitä tutkitaan laajasti eri aloilla.

Tarve digitoida asiakirjat, kuitit tai laskut mutta liian laiska koodaamaan? Suuntaa kohti Nanonetit ja rakenna OCR-malleja ilmaiseksi!

Yhteenveto

Tässä artikkelissa olemme tarkastelleet yksityiskohtaisesti tietojen poimimista taulukoista. Olemme nähneet, kuinka modernit tekniikat, kuten Deep Learning ja Computer Vision, voivat automatisoida arkipäiväisiä tehtäviä rakentamalla vankkoja algoritmeja tarkkojen tulosten tuottamiseksi. Alkuosissa olemme oppineet taulukoiden purkamisen roolista yksilöiden, toimialojen ja toimialojen tehtävien helpottamisessa ja myös käyneet läpi käyttötapauksia, joissa käsitellään taulukoiden purkamista PDF/HTML-tiedostoista, lomakeautomaatiota, lasku Automaatio jne. Olemme koodannut algoritmin Computer Visionin avulla löytääksemme tietojen sijainnin taulukoista käyttämällä kynnys-, laajennus- ja ääriviivan havaitsemistekniikoita. Olemme keskustelleet haasteista, joita saatamme kohdata taulukon havaitsemis-, poiminta- ja muunnosprosesseissa käytettäessä perinteisiä tekniikoita, ja todenneet, kuinka syvällinen oppiminen voi auttaa meitä voittamaan nämä ongelmat. Lopuksi olemme käyneet läpi muutamia hermoverkkoarkkitehtuureja ja ymmärtäneet niiden tavat saavuttaa taulukon purkaminen annettujen koulutustietojen perusteella.

Päivitys:

Lisätty lisää luettavaa erilaisista lähestymistavoista taulukon havaitsemiseen ja tiedon poimimiseen syväoppimisen avulla.

- &

- 2019

- 67

- Meistä

- Mukaan

- sen mukaisesti

- tarkka

- hankkia

- poikki

- aktiivinen

- lisä-

- osoite

- Etu

- algoritmi

- algoritmit

- Kaikki

- vaihtoehto

- vaihtoehdot

- aina

- määrä

- enkelit

- omena

- sovellukset

- käyttää

- lähestymistapa

- sovellukset

- arkkitehtuuri

- perustelut

- Art

- artikkeli

- keinotekoinen

- tekoäly

- Varat

- huomio

- attribuutteja

- Tekijät

- automatisoida

- Automaatio

- tausta

- Pankkitoiminta

- ennen

- ovat

- alle

- Hyödyt

- Bitti

- Musta

- reunus

- taukoja

- selain

- rakentaa

- Rakentaminen

- rakentaa

- liiketoiminta

- yritykset

- soittaa

- kamerat

- ehdokkaat

- pääoma

- kaapata

- tapauksissa

- haaste

- haasteet

- haastava

- kiinalainen

- valinta

- Valita

- Kaupunki

- CNN

- koodi

- kerätä

- Sarake

- yhdistelmät

- Yritykset

- kilpailu

- täysin

- monimutkainen

- tietokone

- tietokoneet

- käsite

- kytketty

- Kytkeminen

- liitäntä

- Liitännät

- johdonmukainen

- Kuluttajat

- kulutus

- sisältää

- pitoisuus

- sisältö

- ohjaus

- Muuntaminen

- Ydin

- vastaava

- kattaa

- luoda

- Laajuus

- sato

- ratkaiseva

- asiakassuhde

- Asiakkaat

- tiedot

- päivä

- sopimus

- tekemisissä

- toimitettu

- Riippuen

- on kuvattu

- suunniteltu

- suunnittelu

- yksityiskohta

- yksityiskohdat

- havaittu

- Detection

- kehittää

- laite

- DID

- eri

- vaikea

- digitaalinen

- digitalisoida

- numeroa

- suoraan

- pohtia

- etäisyys

- jaettu

- asiakirjat

- verkkotunnuksen

- alas

- haitat

- piirustus

- aikana

- reuna

- tehokkaasti

- poistaa

- upotettu

- päittäin

- Moottori

- astui sisään

- yksiköt

- erityisesti

- olennainen

- olennaiseen

- arvioidaan

- jne.

- kaikki

- esimerkki

- kunnostautua

- olemassa

- laajeni

- experience

- ilmauksia

- otteet

- Kasvot

- tekijät

- väärennös

- perheet

- perhe

- FAST

- nopeampi

- Ominaisuus

- Ominaisuudet

- palaute

- suodattimet

- Vihdoin

- löytäminen

- löydöt

- Etunimi

- Ensin näytä

- sovittaa

- seurata

- jälkeen

- muoto

- muoto

- lomakkeet

- löytyi

- Puitteet

- Ilmainen

- toiminto

- Perusteet

- edelleen

- tuottaa

- generatiivinen

- generaattori

- saada

- hyvä

- Kasvava

- Käsittely

- pää

- korkeus

- auttaa

- hyödyllinen

- auttaa

- auttaa

- tätä

- hierarkia

- Korkea

- Korostaa

- Vaakasuora

- Miten

- Miten

- Kuitenkin

- HTTPS

- valtava

- ihmisen

- Aitajuoksu

- tunnistaa

- tunnistaminen

- kuva

- tärkeä

- sisältää

- sisältää

- Mukaan lukien

- Kasvaa

- lisää

- henkilöt

- teollinen

- teollisuuden

- tiedot

- Infrastruktuuri

- panos

- vakuutus

- yhdistää

- Älykkyys

- vuorovaikutus

- leikkauspiste

- kysymykset

- IT

- tuntemus

- tunnettu

- tarrat

- kielet

- suuri

- kerros

- johtaa

- OPPIA

- oppinut

- oppiminen

- Kirjasto

- linja

- LINK

- Lista

- kuormitus

- sijainti

- Pitkät

- kone

- koneoppiminen

- TEE

- manuaalinen

- käsin

- valmistus

- kartta

- Kartat

- Merkitse

- Maskit

- ottelu

- matching

- materiaali

- matematiikka

- mitata

- mainitsi

- menetelmät

- Metrics

- ehkä

- miljoona

- miljoonia

- mielessä

- Puhelinnumero

- kännykkä

- matkapuhelimet

- malli

- mallit

- Kuukausi

- lisää

- eniten

- moninkertainen

- kansallinen

- Luonnollinen

- välttämätön

- tarpeet

- verkko

- verkot

- Melu

- normaali

- Huomautuksia

- numero

- numerot

- offline

- verkossa

- verkkokaupan

- toiminta

- Operations

- Optimoida

- optimoitu

- Vaihtoehto

- tilata

- organisaatioiden

- Järjestetty

- organisointi

- Muut

- yleinen

- oma

- Paperi

- osa

- erityinen

- Salasana

- Merkit

- Kuvio

- Ihmiset

- suorituskyky

- henkilöstö

- näkökulma

- vaihe

- puhelimet

- fyysinen

- muovi

- Platforms

- Kohta

- pool

- kehno

- Suosittu

- sijainti

- mahdollinen

- teho

- harjoitusta.

- tarkasti

- ennustus

- Ennusteet

- esittää

- esitys

- edellinen

- ensisijainen

- Ongelma

- ongelmia

- prosessi

- Prosessit

- käsittely

- tuottaa

- tuotanto

- Ohjelma

- Ohjelmoijat

- Ohjelmointi

- Ohjelmat

- ehdotus

- ehdotettu

- toimittaa

- tarjoaa

- tarkoituksiin

- laatu

- nopea

- nopeasti

- RE

- Lukeminen

- reaaliaikainen

- tunnistaa

- tunnustaa

- vähentämällä

- suhteen

- säännöllinen

- Ihmissuhteet

- jäädä

- korvataan

- edustaa

- edustus

- edellyttää

- tarvitaan

- Vaatii

- tutkimus

- Resort

- tulokset

- palata

- arviot

- ajaa

- Asteikko

- skannata

- Haku

- sektorit

- jakautuminen

- Sarjat

- palvelu

- Palvelut

- setti

- useat

- Lyhyt

- esitetty

- Yksinkertainen

- koska

- Koko

- pieni

- So

- Tuotteemme

- vankka

- ratkaisu

- Ratkaisumme

- SOLVE

- jonkin verran

- Tila

- tilat

- jakaa

- splits

- standardi

- Alkaa

- Osavaltio

- huippu-

- totesi

- lausuntoja

- asema

- Levytila

- verkkokaupasta

- vahva

- jäsennelty

- tyyli

- Myöhemmin

- Onnistuneesti

- Tukee

- järjestelmä

- järjestelmät

- ottaen

- tehtävät

- vero

- joukkue-

- tekniikat

- Technologies

- kertoo

- malleja

- Lähde

- siksi

- kynnys

- Kautta

- kauttaaltaan

- aika

- aikaavievä

- kertaa

- Otsikko

- yhdessä

- työkalut

- ylin

- raita

- perinteinen

- koulutus

- siirtää

- Muutos

- TX

- tyypit

- tyypillisesti

- ui

- varten

- ymmärtää

- ymmärtäminen

- ymmärsi

- unique

- us

- käyttää

- yleensä

- validointi

- arvo

- eri

- versio

- Videoita

- visio

- visualisointi

- W

- odottaa

- verkko

- Mitä

- vaikka

- sisällä

- ilman

- Referenssit

- työskentely

- kirjoittaminen

- X

- vuosi

- youtube