Kun yhä useammat organisaatiot ottavat käyttöön generatiivisia tekoälyteknologioita – esitysten tekemiseen, apurahahakemusten täyttämiseen ja kirjoittamiseen yleiskoodi - Turvatiimit ymmärtävät, että on tarpeen vastata uuteen kysymykseen: Kuinka turvaat tekoälytyökalut?

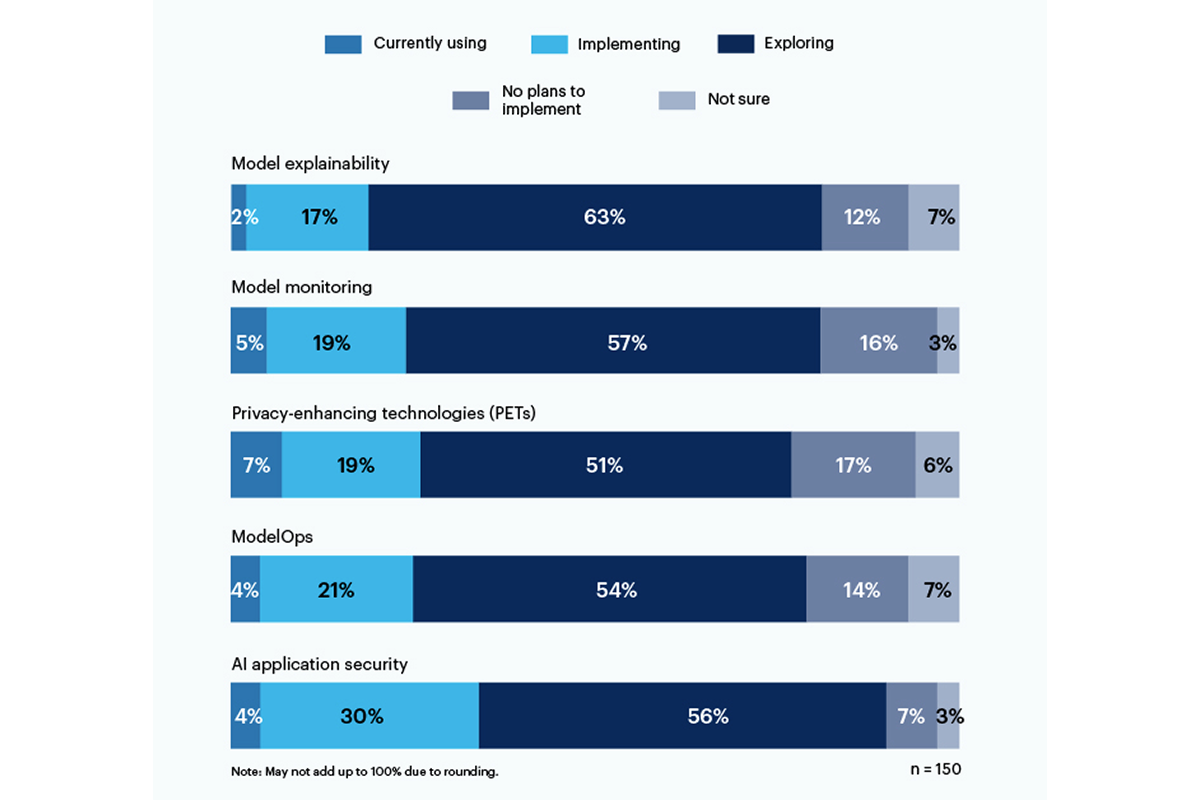

Kolmasosa Gartnerin hiljattain tekemän kyselyn vastaajista ilmoitti myös tekoälypohjaisten sovellusten suojaustyökalujen käyttäminen tai käyttöönotto puuttua riskeihin, joita generatiivisen tekoälyn käyttö organisaatiossaan aiheuttaa.

Yksityisyyttä lisääviä tekniikoita (PET) käytettiin tällä hetkellä eniten, 7 prosenttia vastaajista, ja vankka 19 prosenttia yrityksistä ottaa sen käyttöön. tämä luokka sisältää tapoja suojata henkilötietoja, kuten homomorfinen salaus, Tekoälyn luoma synteettinen data, turvallinen monen osapuolen laskenta, yhdistynyt oppiminenja erilainen yksityisyys. Kiinteällä 17 prosentilla ei kuitenkaan ole suunnitelmia ottaa käyttöön PET:itä ympäristöönsä.

Vain 19 % käyttää tai ottaa käyttöön työkaluja mallin selitettävyyteen, mutta vastaajista on huomattava kiinnostus (56 %) tutkia ja ymmärtää näitä työkaluja generatiiviseen tekoälyriskiin puuttumiseksi. Gartnerin mukaan selitettävyys, mallin seuranta ja tekoälysovellusten suojaustyökalut voidaan käyttää avoimen lähdekoodin tai patentoiduissa malleissa luotettavuuden ja luotettavuuden saavuttamiseksi, jota yrityskäyttäjät tarvitsevat.

Eniten vastaajia huolestuttavia riskejä ovat virheelliset tai puolueelliset lähdöt (58 %) sekä tekoälyn luoman koodin haavoittuvuudet tai vuotaneet salaisuudet (57 %). Merkittävää on, että 43 % mainitsi mahdollisia tekijänoikeus- tai lisensointiongelmia, jotka johtuvat tekoälyn luomasta sisällöstä, suurimpana riskinä organisaatiolleen.

"Ei ole vieläkään läpinäkyvyyttä tietomalleista, joita harjoitellaan, joten harhaan ja yksityisyyteen liittyvää riskiä on erittäin vaikea ymmärtää ja arvioida", C-suiten johtaja kirjoitti vastauksena Gartnerin kyselyyn.

Kesäkuussa National Institute of Standards and Technology (NIST) käynnisti julkisen työryhmän auttaa vastaamaan tähän kysymykseen tammikuussa julkaistun tekoälyn riskinhallintakehyksen perusteella. Kuten Gartnerin tiedot osoittavat, yritykset eivät odota NIST-direktiiveille.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :On

- :ei

- 7

- a

- Meistä

- Mukaan

- Saavuttaa

- osoite

- hyväksyä

- AI

- Kaikki

- keskuudessa

- ja

- Hakemus

- sovellusten suojaus

- sovellukset

- OVAT

- AS

- liittyvä

- At

- perustua

- BE

- puolueellisuus

- puolueellinen

- mutta

- by

- C-sarja

- CAN

- Kategoria

- mainittu

- koodi

- Yritykset

- täydellinen

- huolestunut

- pitoisuus

- tekijänoikeus

- veneet

- Nykyinen

- tiedot

- vaikea

- direktiivien

- do

- myöskään

- yritys

- ympäristö

- arvio

- johtaja

- Tutkiminen

- varten

- Puitteet

- alkaen

- Gartner

- generatiivinen

- Generatiivinen AI

- myöntää

- suurin

- Olla

- auttaa

- Miten

- Kuitenkin

- HTTPS

- täytäntöönpanosta

- in

- sisältää

- sisältää

- Instituutti

- korko

- kysymykset

- IT

- SEN

- tammikuu

- kesäkuu

- käynnistettiin

- Licensing

- johto

- menetelmät

- malli

- mallit

- seuranta

- lisää

- eniten

- moninkertainen

- kansallinen

- Tarve

- Uusi

- NIST

- Nro

- of

- on

- avata

- avoimen lähdekoodin

- or

- organisaatio

- organisaatioiden

- henkilöstö

- henkilökohtaiset tiedot

- Lemmikit

- kentillä

- suunnitelmat

- Platon

- Platonin tietotieto

- PlatonData

- aiheuttamia

- mahdollinen

- yksityisyys

- patentoitu

- suojella

- julkinen

- kysymys

- ymmärtämättä

- äskettäinen

- luotettavuus

- luottaa

- raportoitu

- vastaajat

- vastaus

- Riski

- riskienhallinta

- riskit

- salaisuuksia

- turvallinen

- turvallisuus

- osoittivat

- Näytä

- merkittävä

- merkittävästi

- So

- vankka

- lähde

- standardit

- Yhä

- niin

- Tutkimus

- synteettinen

- tiimit

- Technologies

- Elektroniikka

- että

- -

- heidän

- Siellä.

- Nämä

- tätä

- että

- työkalut

- ylin

- koulutus

- Läpinäkyvyys

- luotettavuus

- ymmärtää

- ymmärtäminen

- käyttää

- käytetty

- Käyttäjät

- käyttämällä

- hyvin

- haavoittuvuuksia

- tavalla

- with

- työskentely

- kirjoittaa

- kirjoitti

- Voit

- zephyrnet