Les informaticiens affirment avoir trouvé un moyen de contrecarrer les tentatives des systèmes d'apprentissage automatique de manipuler numériquement les images et de créer des deepfakes.

De nos jours, vous pouvez non seulement créer des images à partir de zéro à l'aide de modèles d'IA - il suffit de leur donner une description écrite et elles produiront les photos correspondantes - vous pouvez également manipuler des images existantes en utilisant la même technologie. Vous pouvez donner une image à ces systèmes formés et décrire comment vous voulez qu'elle soit modifiée, ou utiliser une interface graphique pour les diriger, et c'est parti.

Cela crée le potentiel d'un avenir terrifiant dans lequel les médias sociaux sont inondés de désinformation de masse automatisée, ou les gens sont soumis à un chantage pour des clichés tordus par des machines. Si personne ne peut distinguer les faux des vrais, ils peuvent être tout aussi dommageables.

Une approche pour éviter cela consiste à filigraner ou à signer numériquement les images et autres contenus afin que les manipulations soient détectables. Une autre voie – proposée par les cerveaux du MIT – consiste à concevoir des clichés afin que les modèles d'IA ne puissent pas du tout les modifier en premier lieu.

"Envisagez la possibilité d'une propagation frauduleuse de faux événements catastrophiques, comme une explosion à un point de repère important", a affirmé Valérie Plante. Hadi Salman, un étudiant diplômé du département de génie électrique et d'informatique de l'université qui a travaillé sur ce projet.

« Cette tromperie peut manipuler les tendances du marché et l'opinion publique, mais les risques ne se limitent pas à la sphère publique. Les images personnelles peuvent être modifiées de manière inappropriée et utilisées à des fins de chantage, ce qui entraîne des implications financières importantes lorsqu'elles sont exécutées à grande échelle.

Salman a peut-être raison. Les deepfakes ont déjà été utilisés pour diffuser des informations erronées ou tromper et harceler les internautes, et les images conçues par l'IA sont devenues de plus en plus réalistes. À mesure que la technologie s'améliorera à l'avenir, les gens pourront également créer des vidéos avec un faux son réaliste, a-t-il averti.

C'est pourquoi Salman et ses collègues ont décidé de développer un logiciel d'apprentissage automatique, baptisé PhotoGuard, pour empêcher les malfaiteurs d'utiliser ces outils à mauvais escient pour manipuler le contenu.

Les images sont essentiellement traitées par les modèles ML comme des tableaux de nombres. PhotoGuard ajuste ces tableaux afin d'empêcher d'autres modèles d'apprentissage automatique de percevoir correctement l'image d'entrée - de sorte que l'image ne puisse finalement pas être manipulée. Les pixels sont laissés intacts en ce qui concerne les personnes, de sorte que l'image protégée est la même pour l'œil humain, mais pas pour un ordinateur.

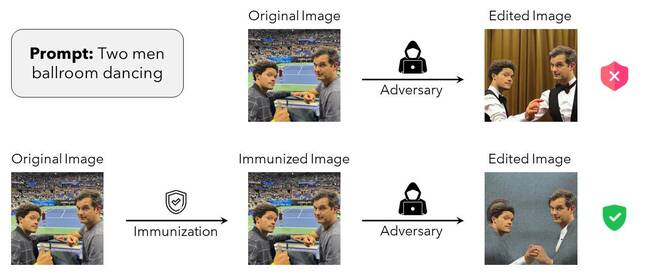

Dans l'exemple ci-dessous, une photo montre les humoristes de la télévision américaine Trevor Noah et Michael Kosta à l'US Open. La photo originale – non protégée – peut être manipulée par un modèle de diffusion basé sur le texte pour les faire apparaître dans un cadre complètement différent : dans une salle de bal dansant ensemble. Cependant, avec les modifications PhotoGuard appliquées, le modèle de diffusion est éjecté par les perturbations invisibles et ne peut pas complètement modifier l'image.

Figure de l'article MIT PhotoGuard décrivant le fonctionnement de cette immunisation des données contre la manipulation - Cliquez pour agrandir

"Dans cette attaque, nous perturbons l'image d'entrée afin que l'image finale générée par le [grand modèle de diffusion] soit une image cible spécifique (par exemple, un bruit aléatoire ou une image grise)", ont écrit les universitaires dans leur article non évalué par des pairs. papier décrivant PhotoGuard, publié sur ArXiv.

À proprement parler, cette approche est qualifiée d'attaque par diffusion par l'équipe du MIT. Son objectif est d'embrouiller l'IA de manipulation d'images et de lui faire ignorer efficacement l'invite de texte qui lui a été donnée.

Il existe une deuxième technique plus simple appelée attaque d'encodeur, qui tente de faire en sorte que l'IA manipulatrice perçoive une photo comme autre chose - comme un carré gris - qui contrecarre son édition automatisée. Le résultat est plus ou moins le même, dans les deux sens : les tentatives d'utilisation de l'IA pour manipuler les images déraillent.

"Lors de l'application de l'attaque de l'encodeur, notre objectif est de mapper la représentation de l'image d'origine sur la représentation d'une image cible (image grise)", écrit l'équipe dans son article. "Notre attaque de diffusion (plus complexe), d'autre part, vise à briser le processus de diffusion en manipulant l'ensemble du processus pour générer une image qui ressemble à une image cible donnée (image grise)."

Ils ont mené leurs expériences contre le modèle de diffusion stable v1.5 de Stability AI et ont noté que bien que PhotoGuard puisse protéger les images contre la modification numérique par l'IA, il est difficile à appliquer en pratique. D'une part, l'attaque par diffusion nécessite une capacité GPU considérable - donc si vous n'avez pas ce type de silicium à portée de main, vous n'avez pas de chance.

Vraiment, la responsabilité devrait incomber aux organisations développant ces outils d'IA plutôt qu'aux individus essayant de protéger leurs images, affirment les chercheurs.

« Une approche collaborative impliquant des développeurs de modèles, des plateformes de médias sociaux et des décideurs présente une défense solide contre la manipulation d'images non autorisée. Travailler sur cette question urgente est d'une importance primordiale aujourd'hui », a déclaré Salman.

"Et bien que je sois heureux de contribuer à cette solution, beaucoup de travail est nécessaire pour rendre cette protection pratique. Les entreprises qui développent ces modèles doivent investir dans la conception d'immunisations robustes contre les menaces potentielles posées par ces outils d'IA. Alors que nous entrons dans cette nouvelle ère de modèles génératifs, luttons pour le potentiel et la protection dans des mesures égales.

PhotoGuard n'est pas une solution parfaite. Si une image peut être téléchargée par n'importe qui sans qu'aucune protection ne lui soit appliquée, un malfaiteur pourrait saisir cette version non protégée de la photo, la modifier à l'aide de l'IA et la distribuer. De plus, le recadrage, la rotation ou l'application de certains filtres pourraient interrompre les perturbations de PhotoGuard.

Les bods du MIT ont déclaré qu'ils travaillaient pour essayer de rendre leur logiciel open source (licence MIT, natch) plus robuste contre de telles modifications.

Le registre a demandé à Salman de commenter davantage. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2023/08/01/photoguard_deepfake_ai/

- :possède

- :est

- :ne pas

- $UP

- 7

- a

- Capable

- universitaires

- à opposer à

- AI

- Modèles AI

- vise

- Tous

- déjà

- aussi

- altérations

- modifié

- Bien que

- am

- an

- et de

- Une autre

- tous

- chacun.e

- apparaître

- appliqué

- Appliquer

- Application

- une approche

- SONT

- argumenté

- AS

- At

- attaquer

- Tentatives

- acoustique

- Automatisation

- disponibles

- En gros

- BE

- devenez

- était

- va

- ci-dessous

- Chantage

- Pause

- mais

- by

- appelé

- CAN

- ne peut pas

- Compétences

- réalisée

- catastrophique

- réclamer

- cliquez

- CO

- collaborative

- collègues

- comment

- commentaire

- Sociétés

- complètement

- complexe

- ordinateur

- Informatique

- concerné

- Considérer

- considérable

- contenu

- contribuer

- Correspondant

- pourriez

- engendrent

- crée des

- endommager

- Danse

- données

- jours

- décidé

- deepfakes

- Défense

- Département

- décrire

- la description

- développer

- mobiles

- développement

- différent

- difficile

- La diffusion

- numériquement

- désinformation

- distribuer

- Don

- download

- doublé

- de manière efficace

- non plus

- d'autre

- ingénieur

- ENGINEERING

- égal

- Ère

- événements

- exemple

- réalisé

- existant

- expériences

- explosion

- œil

- faux

- non

- loin

- Figure

- filtres

- finale

- la traduction de documents financiers

- Prénom

- inondé

- Pour

- frauduleux

- De

- d’étiquettes électroniques entièrement

- plus

- avenir

- générer

- généré

- génératif

- Donner

- donné

- Go

- objectif

- GPU

- saisir

- diplôme

- gris

- main

- Vous avez

- he

- sa

- Comment

- Cependant

- HTTPS

- humain

- i

- if

- image

- satellite

- implications

- importance

- in

- de plus en plus

- individus

- contribution

- développement

- Investir

- impliquant

- ISN

- aide

- IT

- SES

- jpg

- juste

- Genre

- repère

- gros

- apprentissage

- à gauche

- moins

- laisser

- Autorisé

- mensonge

- comme

- limité

- ll

- LOOKS

- chance

- click

- machine learning

- Les machines

- a prendre une

- manipulé

- manipuler

- Manipulation

- Localisation

- Marché

- Tendances du marché

- Masse

- Mai..

- les mesures

- Médias

- Michael

- Désinformation

- MIT

- ML

- modèle

- numériques jumeaux (digital twin models)

- Modifications

- PLUS

- beaucoup

- Besoin

- nécessaire

- Nouveauté

- Noé

- Bruit

- noté

- numéros

- of

- de rabais

- Offres Speciales

- on

- ONE

- uniquement

- ouvert

- open source

- or

- de commander

- organisations

- original

- Autre

- nos

- ande

- plus de

- Papier

- PARAMOUNT

- chemin

- Personnes

- parfaite

- personnel

- photo

- image

- Place

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- créateurs de politiques

- possibilité

- possible

- défaillances

- Méthode

- pratiquement

- cadeaux

- pressant

- empêcher

- processus

- Traité

- Projet

- proposé

- protéger

- protégé

- protection

- public

- des rails

- aléatoire

- plutôt

- RE

- réal

- réaliste

- visée

- libéré

- représentation

- a besoin

- chercheurs

- Ressemble

- responsabilité

- résultat

- résultant

- bon

- risques

- robuste

- s

- Saïd

- même

- Escaliers intérieurs

- Sciences

- scientifiques

- gratter

- Deuxièmement

- sentiment

- mise

- devrait

- montré

- Spectacles

- signer

- significative

- Silicium

- plus simple

- So

- Réseaux sociaux

- réseaux sociaux

- plateformes de médias sociaux

- Logiciels

- sur mesure

- quelques

- quelque chose

- Identifier

- parlant

- groupe de neurones

- propagation

- carré

- Stabilité

- stable

- s'efforcer

- Étudiant

- tel

- Système

- Target

- équipe

- Technologie

- dire

- que

- qui

- La

- El futuro

- leur

- Les

- Ces

- l'ont

- chose

- this

- des menaces

- contrecarrer

- à

- aujourd'hui

- ensemble

- trop

- les outils

- vers

- qualifié

- Trends

- Trevor

- Essai

- tv

- En fin de compte

- université

- us

- utilisé

- d'utiliser

- en utilisant

- v1

- Ve

- version

- Vidéos

- souhaitez

- était

- filigrane

- Façon..

- we

- WELL

- quelle que soit

- quand

- qui

- tout en

- WHO

- la totalité

- why

- sera

- comprenant

- sans

- activités principales

- travaillé

- de travail

- vos contrats

- code écrit

- écrit

- Vous n'avez

- zéphyrnet