Interview Si vous pensez que l’IA générative a automatiquement sa place à la table du monde du droit, détrompez-vous.

Les grands modèles linguistiques ont tendance à générer des informations juridiques inexactes et ne devraient pas être invoqués en cas de litige, selon de nouvelles recherches.

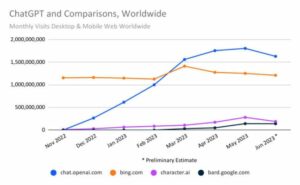

L'année dernière, lorsque OpenAI a montré GPT-4 était capable de réussir l'examen du barreau, cela a été présenté comme une percée dans l'IA et a amené certaines personnes à se demander si la technologie pourrait bientôt remplacer avocats. Certains espéraient que ces types de modèles pourraient permettre aux personnes qui n’ont pas les moyens de se payer des avocats coûteux de poursuivre la justice, rendant ainsi l’accès à l’aide juridique plus équitable. La réalité, cependant, est que les LLM ne peuvent même pas aider efficacement les avocats professionnels, selon une étude récente.

La plus grande préoccupation est que l’IA fabrique souvent de fausses informations, ce qui pose un énorme problème, en particulier dans une industrie qui s’appuie sur des preuves factuelles. Une équipe de chercheurs de Yale et de l'Université de Stanford analysant les taux d'hallucinations dans les grands modèles de langage populaires a constaté que souvent, ils ne récupéraient pas ou ne généraient pas avec précision les informations juridiques pertinentes, ni ne comprenaient et ne raisonnaient pas sur diverses lois.

En fait, le GPT-3.5 d’OpenAI, qui alimente actuellement la version gratuite de ChatGPT, hallucine environ 69 % du temps lorsqu’il est testé sur différentes tâches. Les résultats ont été pires pour PaLM-2, le système qui était auparavant à l’origine du chatbot Bard de Google, et pour Llama 2, le grand modèle de langage publié par Meta, qui ont généré des mensonges à des taux de 72 et 88 %, respectivement.

Sans surprise, les modèles ont du mal à accomplir des tâches plus complexes que des tâches plus faciles. Demander à l'IA de comparer différentes affaires et de voir si elles s'accordent sur une question, par exemple, est un défi, et cela générera plus probablement des informations inexactes que lorsqu'elle est confrontée à une tâche plus facile, comme vérifier auprès du tribunal auprès duquel une affaire a été déposée.

Bien que les LLM excellent dans le traitement de grandes quantités de textes et puissent être formés sur d’énormes quantités de documents juridiques – plus que ce qu’un avocat humain pourrait lire au cours de sa vie – ils ne comprennent pas le droit et ne peuvent pas formuler des arguments solides.

"Bien que nous ayons vu ce type de modèles faire de grands progrès dans les formes de raisonnement déductif dans les problèmes de codage ou de mathématiques, ce n'est pas le genre de compétences qui caractérisent un avocat de premier ordre", Daniel Ho, co-auteur de le journal Yale-Stanford, raconte Le registre.

"Ce pour quoi les avocats sont vraiment bons et où ils excellent est souvent décrit comme une forme de raisonnement analogique dans un système de common law, pour raisonner sur la base de précédents", a ajouté Ho, directeur associé du Stanford Institute for Human-Centered. Intelligence artificielle.

Les machines échouent souvent également dans des tâches simples. Lorsqu'on leur demande d'inspecter un nom ou une citation pour vérifier si un cas est réel, GPT-3.5, PaLM-2 et Llama 2 peuvent inventer de fausses informations dans leurs réponses.

« Le modèle n’a pas besoin de connaître honnêtement la loi pour répondre correctement à cette question. Il lui suffit de savoir si un cas existe ou non, et de pouvoir le voir n'importe où dans le corpus de formation », explique Matthew Dahl, doctorant en droit à l'Université de Yale.

Cela montre que l’IA ne peut même pas récupérer des informations avec précision et qu’il existe une limite fondamentale aux capacités de la technologie. Ces modèles sont souvent conçus pour être agréables et utiles. Ils ne prennent généralement pas la peine de corriger les hypothèses des utilisateurs et se rangent plutôt de leur côté. Si l’on demande aux chatbots de générer une liste de cas à l’appui d’un argument juridique, par exemple, ils sont plus prédisposés à inventer des poursuites qu’à répondre sans rien. Deux avocats l'ont appris à leurs dépens lorsqu'ils étaient sanctionné pour avoir cité des cas qui ont été complètement inventés par ChatGPT d'OpenAI dans leur dossier judiciaire.

Les chercheurs ont également découvert que les trois modèles testés étaient plus susceptibles de connaître les litiges fédéraux liés à la Cour suprême des États-Unis que les procédures judiciaires localisées concernant des tribunaux plus petits et moins puissants.

Étant donné que GPT-3.5, PaLM-2 et Llama 2 ont été formés sur du texte récupéré sur Internet, il est logique qu'ils soient plus familiers avec les avis juridiques de la Cour suprême des États-Unis, qui sont publiés publiquement par rapport aux documents juridiques déposés sous d'autres types. de tribunaux qui ne sont pas aussi facilement accessibles.

Ils étaient également plus susceptibles d’avoir des difficultés dans les tâches impliquant la mémorisation d’informations provenant de cas anciens et nouveaux.

"Les hallucinations sont les plus courantes parmi les affaires les plus anciennes et les plus récentes de la Cour suprême, et les moins courantes parmi les affaires de la Cour Warren d'après-guerre (1953-1969)", selon le journal. « Ce résultat suggère une autre limitation importante des connaissances juridiques des LLM dont les utilisateurs doivent être conscients : les performances maximales des LLM peuvent être en retard de plusieurs années par rapport à l'état actuel de la doctrine, et les LLM peuvent ne pas réussir à internaliser une jurisprudence très ancienne mais toujours applicable. et la loi pertinente.

Trop d’IA pourrait créer une « monoculture »

Les chercheurs craignaient également qu’une dépendance excessive à l’égard de ces systèmes puisse créer une « monoculture » légale. Étant donné que l’IA est formée sur une quantité limitée de données, elle fera référence à des cas plus importants et bien connus, ce qui amènera les avocats à ignorer d’autres interprétations juridiques ou précédents pertinents. Ils peuvent négliger d’autres affaires qui pourraient les aider à voir des perspectives ou des arguments différents, ce qui pourrait s’avérer crucial dans un litige.

« La loi elle-même n’est pas monolithique », déclare Dahl. « Une monoculture est particulièrement dangereuse dans un cadre légal. Aux États-Unis, nous avons un système fédéral de common law dans lequel le droit évolue différemment selon les États et les différentes juridictions. Il existe en quelque sorte différentes lignes ou tendances jurisprudentielles qui se développent au fil du temps.

"Cela pourrait conduire à des résultats erronés et à une confiance injustifiée d'une manière qui pourrait en fait nuire aux justiciables", ajoute Ho. Il a expliqué qu'un modèle pourrait générer des réponses inexactes aux avocats ou aux personnes cherchant à comprendre quelque chose comme les lois sur les expulsions.

"Lorsque vous demandez l'aide d'un grand modèle linguistique, vous risquez d'obtenir une réponse totalement erronée quant à la date d'échéance de votre dépôt ou au type de règle d'expulsion dans cet État", dit-il, citant un exemple. "Parce que ce qu'il vous dit est la loi de New York ou la loi de Californie, par opposition à la loi qui compte réellement dans votre situation particulière dans votre juridiction."

Les chercheurs concluent que les risques liés à l’utilisation de ces types de modèles populaires pour des tâches juridiques sont plus élevés pour ceux qui soumettent des documents aux tribunaux inférieurs des petits États, en particulier s’ils ont moins d’expertise et interrogent les modèles sur la base de fausses hypothèses. Ces personnes sont plus susceptibles d'être des avocats, moins puissants, issus de petits cabinets disposant de moins de ressources, ou de personnes cherchant à se représenter elles-mêmes.

« En bref, nous constatons que les risques sont les plus élevés pour ceux qui bénéficieraient le plus des LLM », indique le document. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2024/01/10/top_large_language_models_struggle/

- :possède

- :est

- :ne pas

- :où

- $UP

- 7

- 72

- a

- A Propos

- accès

- accessible

- Selon

- Avec cette connaissance vient le pouvoir de prendre

- avec précision

- à travers

- actually

- ajoutée

- Ajoute

- encore

- AI

- aussi

- parmi

- montant

- quantités

- an

- l'analyse

- et les

- Une autre

- répondre

- tous

- quoi que ce soit d'artificiel

- de n'importe où

- en vigueur

- SONT

- argument

- arguments

- artificiel

- intelligence artificielle

- AS

- demandant

- aider

- Associé(e)

- hypothèses

- At

- Automatique

- conscients

- barre

- basé

- BE

- car

- derrière

- profiter

- Le plus grand

- déranger

- percée

- mais

- by

- Californie

- CAN

- ne peut pas

- capacités

- capable

- maisons

- cas

- difficile

- caractérise

- Chatbot

- Chatbots

- ChatGPT

- vérifier

- vérification

- conditions

- CO

- Coauteur

- Codage

- Commun

- Loi commune

- comparer

- par rapport

- complet

- complètement

- complexe

- PROBLÈMES DE PEAU

- concerné

- concernant

- conclut

- correctement

- pourriez

- Court Intérieur

- Dépôt au tribunal

- Cours

- engendrent

- crucial

- Courant

- État actuel

- Lecture

- dangereux

- Daniel

- données

- décrit

- développer

- développe

- différent

- différemment

- Directeur

- do

- INSTITUTIONNELS

- doesn

- Don

- deux

- plus facilement

- même

- de manière efficace

- vous accompagner

- équitable

- notamment

- Pourtant, la

- preuve

- examen

- exemple

- Excel

- existe

- cher

- nous a permis de concevoir

- expliqué

- face

- fait

- FAIL

- faux

- non

- faussetés

- familier

- National

- moins

- déposé

- Dépôt

- Trouvez

- entreprises

- Pour

- formulaire

- document

- trouvé

- gratuitement ici

- fraiche entreprise

- De

- fondamental

- générer

- généré

- génératif

- IA générative

- obtention

- Bien

- l'

- Dur

- nuire

- Vous avez

- he

- vous aider

- utile

- le plus élevé

- Honnêtement

- Cependant

- HTTPS

- majeur

- humain

- if

- ignorer

- important

- in

- Dans d'autres

- inexacte

- industrie

- info

- d'information

- plutôt ;

- Institut

- Intelligence

- Internet

- A inventé

- impliqué

- aide

- IT

- SES

- lui-même

- jpg

- juridiction

- juridictions

- juste

- Justice

- Genre

- Savoir

- spécialisées

- Libellé

- langue

- gros

- Droit applicable et juridiction compétente

- cabinets d'avocats

- Lois

- Poursuites

- avocat

- Les avocats.

- conduire

- conduisant

- savant

- au

- LED

- Légal

- poursuite judiciaire

- moins

- durée de vie

- comme

- Probable

- LIMIT

- limitation

- limité

- lignes

- Liste

- Contentieux

- Flamme

- recherchez-

- baisser

- a prendre une

- FAIT DU

- Fabrication

- math

- compte

- matthew

- Mai..

- Meta

- pourrait

- modèle

- numériques jumeaux (digital twin models)

- Monolithique

- PLUS

- (en fait, presque toutes)

- beaucoup

- prénom

- Besoin

- Besoins

- Nouveauté

- New York

- Date

- rien

- of

- souvent

- Vieux

- plus vieux

- on

- et, finalement,

- OpenAI

- Avis

- opposé

- or

- Autre

- les résultats

- plus de

- paire

- Papier

- documents

- particulier

- particulièrement

- En passant

- Courant

- Personnes

- pour cent

- performant

- perspectives

- phd

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Populaire

- solide

- pouvoirs

- précédemment

- Problème

- d'ouvrabilité

- Procédures

- traitement

- produire

- professionels

- important

- Prouver

- publiquement

- publié

- poursuivre

- question

- Tarifs

- Lire

- réal

- Réalité

- vraiment

- raison

- rappel

- récent

- reportez-vous

- en relation

- libéré

- pertinent

- dépendance

- représentent

- un article

- chercheurs

- Resources

- respectivement

- Réagir

- réponses

- résultat

- Résultats

- risques

- Règle

- s

- dit

- sur le lien

- Chercher

- vu

- sens

- set

- mise

- plusieurs

- Shorts

- devrait

- montré

- montré

- Spectacles

- côté

- étapes

- depuis

- compétence

- faibles

- quelques

- quelque chose

- Bientôt

- Son

- Stanford

- Stanford University

- Région

- États

- Encore

- progrès

- Lutter

- Étudiant

- Étude

- tel

- Suggère

- Support

- Le Suprême

- Cour suprême

- combustion propre

- Système

- table

- Tâche

- tâches

- équipe

- Technologie

- la technologie

- dire

- raconte

- Avoir tendance

- examiné

- texte

- que

- qui

- Le

- la loi

- le monde

- leur

- Les

- se

- Là.

- Ces

- l'ont

- penser

- this

- ceux

- trois

- fiable

- à

- trop

- top

- qualifié

- Formation

- Trends

- types

- comprendre

- Uni

- États-Unis

- université

- injustifié

- sur

- us

- utilisateurs

- en utilisant

- d'habitude

- divers

- Ve

- version

- très

- garenne

- était

- Façon..

- we

- bien connu

- ont été

- Quoi

- Qu’est ce qu'

- quand

- que

- qui

- tout en

- WHO

- sera

- comprenant

- A gagné

- world

- pire

- pourra

- faux

- an

- années

- york

- Vous n'avez

- Votre

- zéphyrnet