Aujourd'hui, nous sommes ravis d'annoncer que les modèles de fondation Meta Llama 3 sont disponibles via Amazon SageMaker JumpStart pour déployer et exécuter l'inférence. Les modèles Llama 3 sont une collection de modèles de texte génératifs pré-entraînés et affinés.

Dans cet article, nous expliquons comment découvrir et déployer des modèles Llama 3 via SageMaker JumpStart.

Qu'est-ce que Meta Llama 3

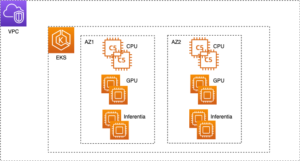

Llama 3 est disponible en deux tailles de paramètres — 8B et 70B avec une longueur de contexte de 8 Ko — qui peuvent prendre en charge un large éventail de cas d'utilisation avec des améliorations dans le raisonnement, la génération de code et le suivi des instructions. Llama 3 utilise une architecture de transformateur uniquement décodeur et un nouveau tokenizer qui offre des performances de modèle améliorées avec une taille de 128 Ko. De plus, Meta a amélioré les procédures post-formation qui ont considérablement réduit les taux de faux refus, amélioré l'alignement et accru la diversité des réponses des modèles. Vous pouvez désormais bénéficier des avantages combinés des performances de Llama 3 et des contrôles MLOps avec les fonctionnalités Amazon SageMaker telles que SageMaker Pipelines, SageMaker Debugger ou les journaux de conteneur. De plus, le modèle sera déployé dans un environnement sécurisé AWS sous les contrôles de votre VPC, contribuant ainsi à assurer la sécurité des données.

Qu'est-ce que SageMaker JumpStart

Avec SageMaker JumpStart, vous pouvez choisir parmi une large sélection de modèles de fondation accessibles au public. Les praticiens du ML peuvent déployer des modèles de base sur des instances SageMaker dédiées à partir d'un environnement réseau isolé et personnaliser les modèles à l'aide de SageMaker pour la formation et le déploiement de modèles. Vous pouvez désormais découvrir et déployer les modèles Llama 3 en quelques clics Amazon SageMakerStudio ou par programmation via le SDK SageMaker Python, vous permettant de dériver les performances du modèle et les contrôles MLOps avec des fonctionnalités SageMaker telles que Pipelines SageMaker, Débogueur SageMakerou les journaux de conteneur. Le modèle est déployé dans un environnement sécurisé AWS et sous les contrôles de votre VPC, contribuant ainsi à assurer la sécurité des données. Les modèles Llama 3 sont disponibles aujourd'hui pour le déploiement et l'inférence dans Amazon SageMaker Studio en us-east-1 (Virginie du Nord), us-east-2 (Ohio), us-west-2 (Oregon), eu-west-1 (Irlande) et ap-northeast-1 (Tokyo) Régions AWS.

Découvrez les modèles

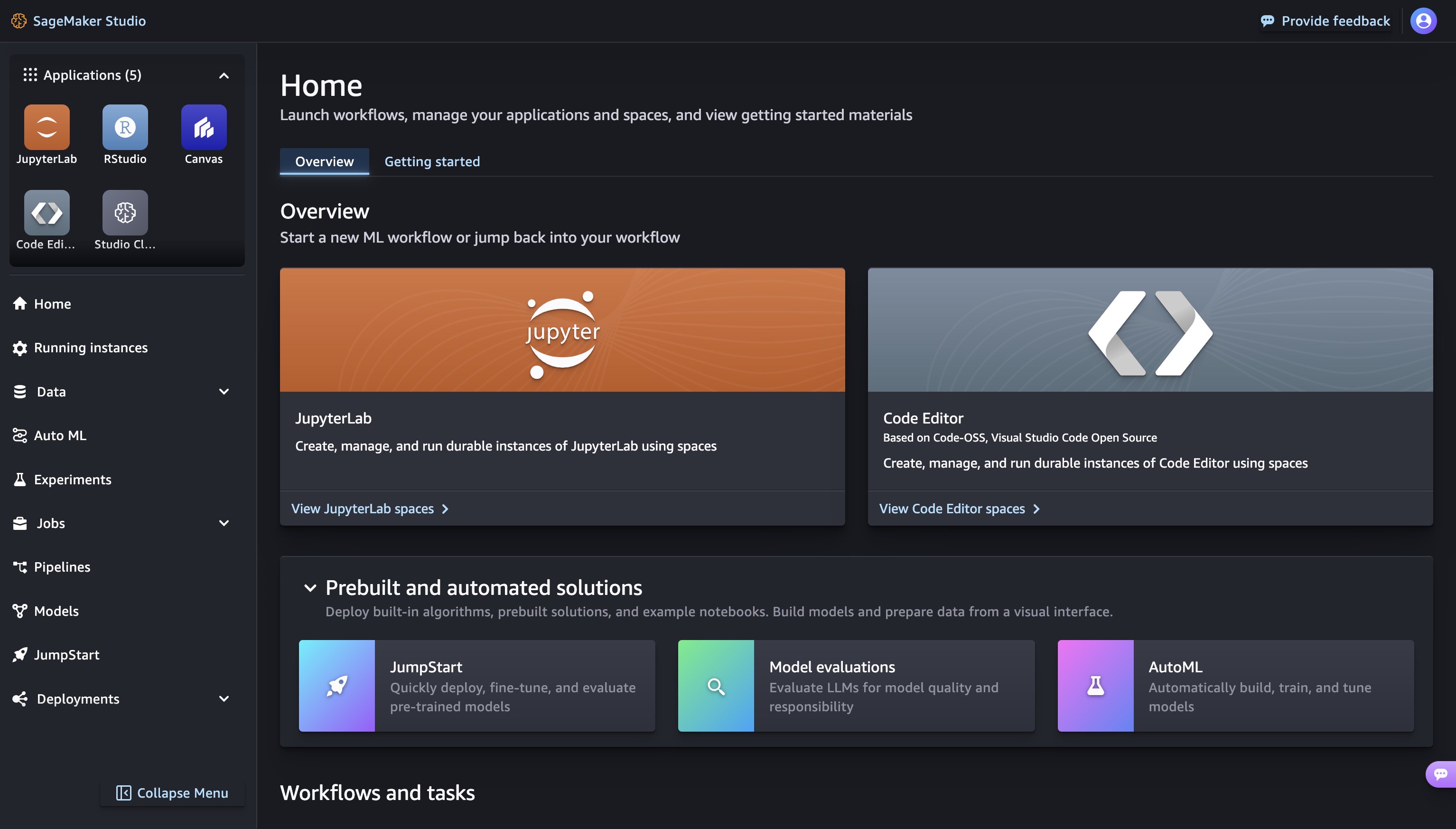

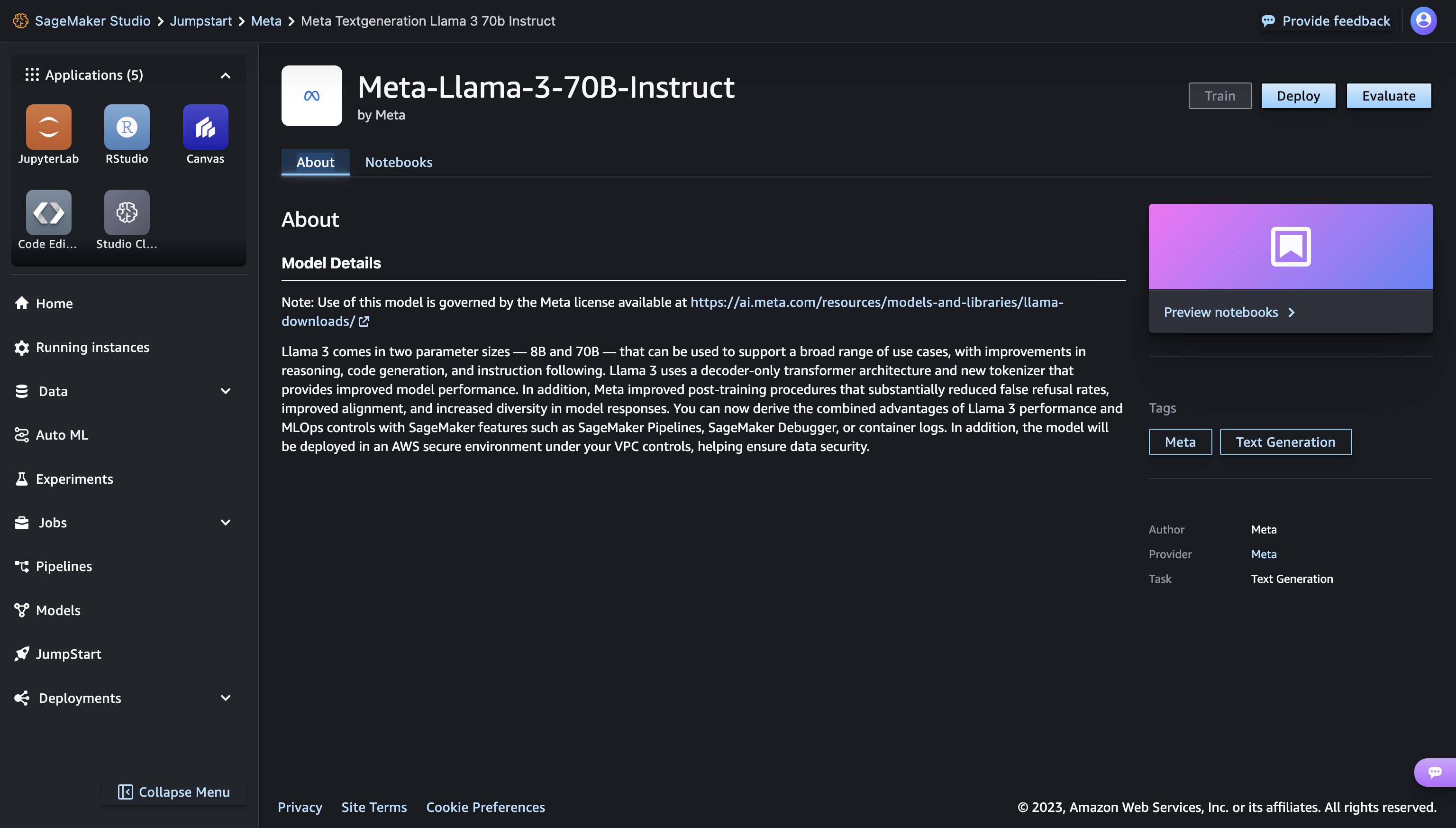

Vous pouvez accéder aux modèles de base via SageMaker JumpStart dans l'interface utilisateur SageMaker Studio et le SDK Python SageMaker. Dans cette section, nous allons voir comment découvrir les modèles dans SageMaker Studio.

SageMaker Studio est un environnement de développement intégré (IDE) qui fournit une interface visuelle Web unique où vous pouvez accéder à des outils spécialement conçus pour effectuer toutes les étapes de développement ML, de la préparation des données à la création, la formation et le déploiement de vos modèles ML. Pour plus de détails sur la façon de démarrer et de configurer SageMaker Studio, reportez-vous à Amazon SageMakerStudio.

Dans SageMaker Studio, vous pouvez accéder à SageMaker JumpStart, qui contient des modèles, des blocs-notes et des solutions prédéfinis, sous Solutions prédéfinies et automatisées.

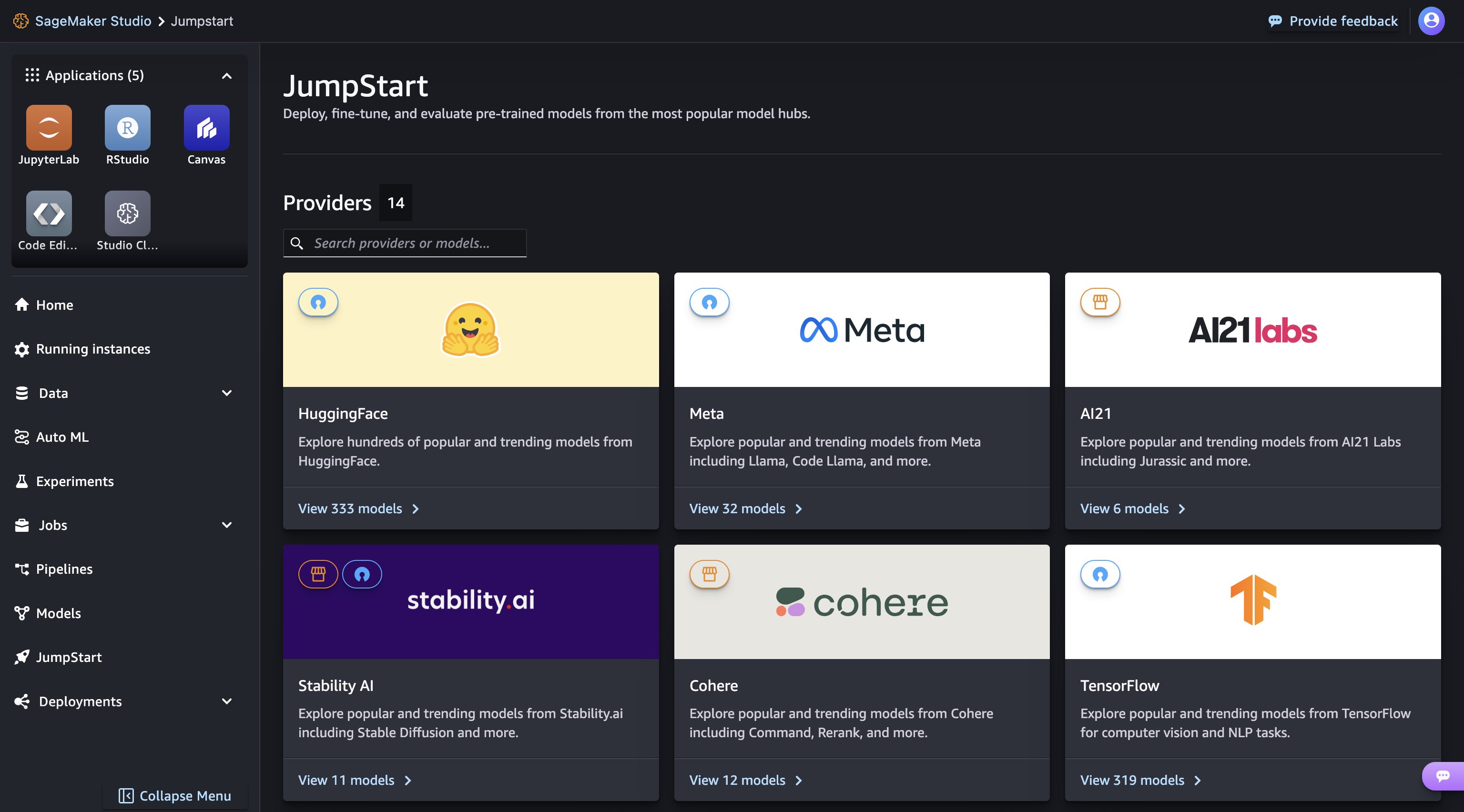

À partir de la page de destination de SageMaker JumpStart, vous pouvez facilement découvrir différents modèles en parcourant différents hubs nommés d'après les fournisseurs de modèles. Vous pouvez trouver des modèles Llama 3 dans le hub Meta. Si vous ne voyez pas les modèles Llama 3, veuillez mettre à jour votre version de SageMaker Studio en arrêtant et en redémarrant. Pour plus d'informations, reportez-vous à Arrêter et mettre à jour les applications Studio Classic.

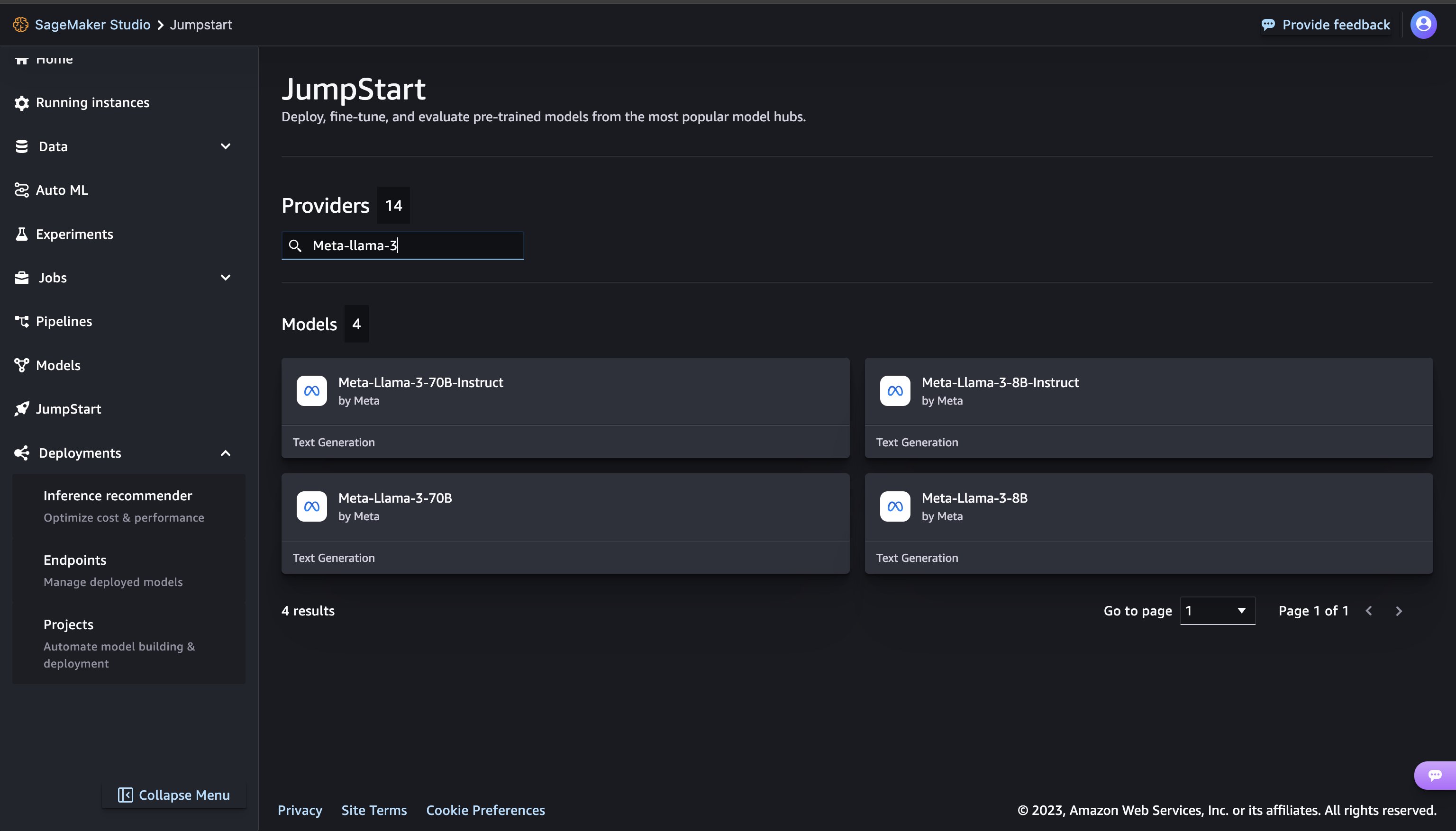

Vous pouvez trouver des modèles Llama 3 en recherchant « Meta-llama-3 » dans le champ de recherche situé en haut à gauche.

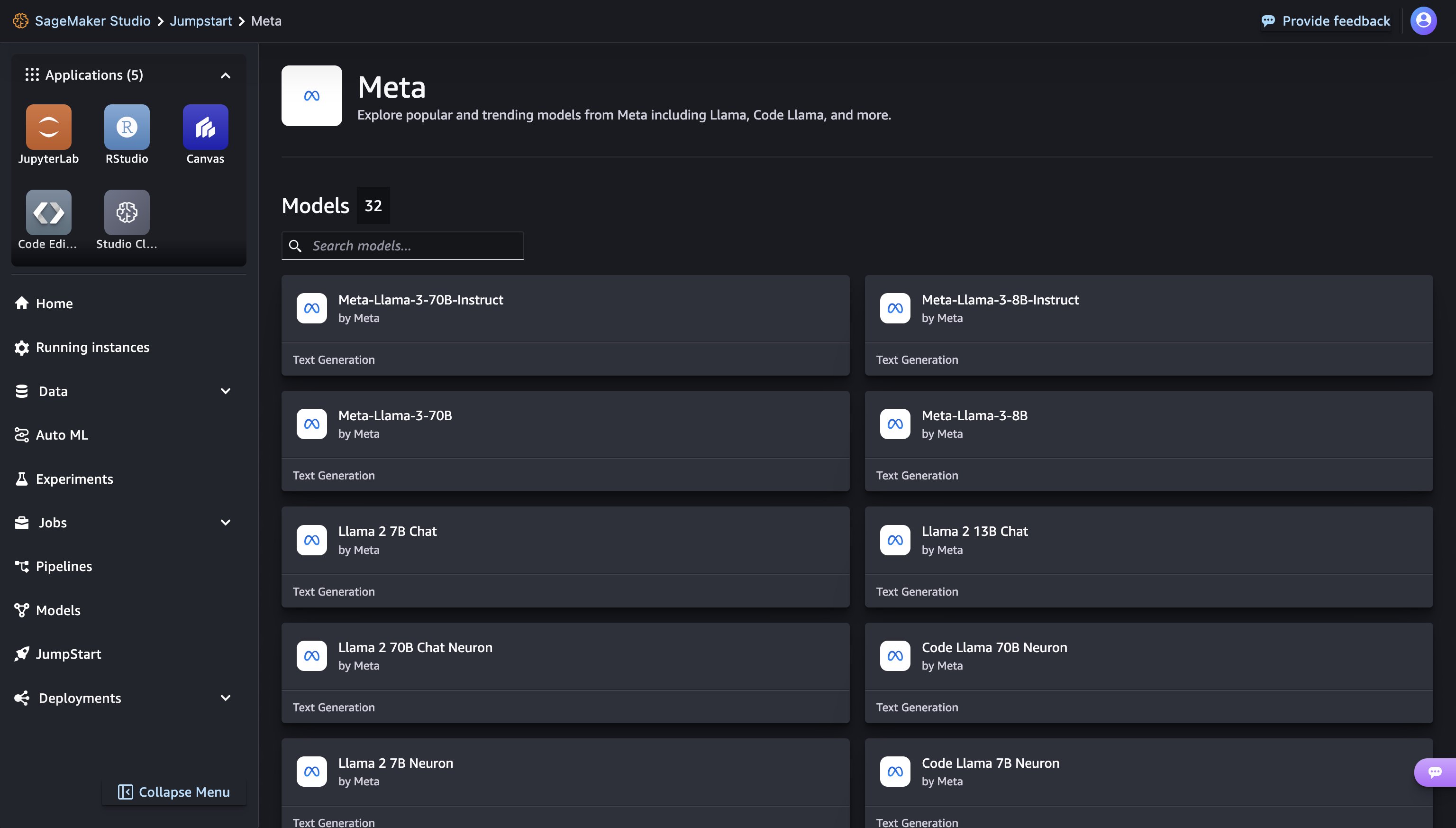

Vous pouvez découvrir tous les modèles Meta disponibles dans SageMaker JumpStart en cliquant sur Meta hub.

Cliquer sur une fiche de modèle ouvre la page de détails du modèle correspondante, à partir de laquelle vous pouvez facilement déployer le modèle.

Déployer un modèle

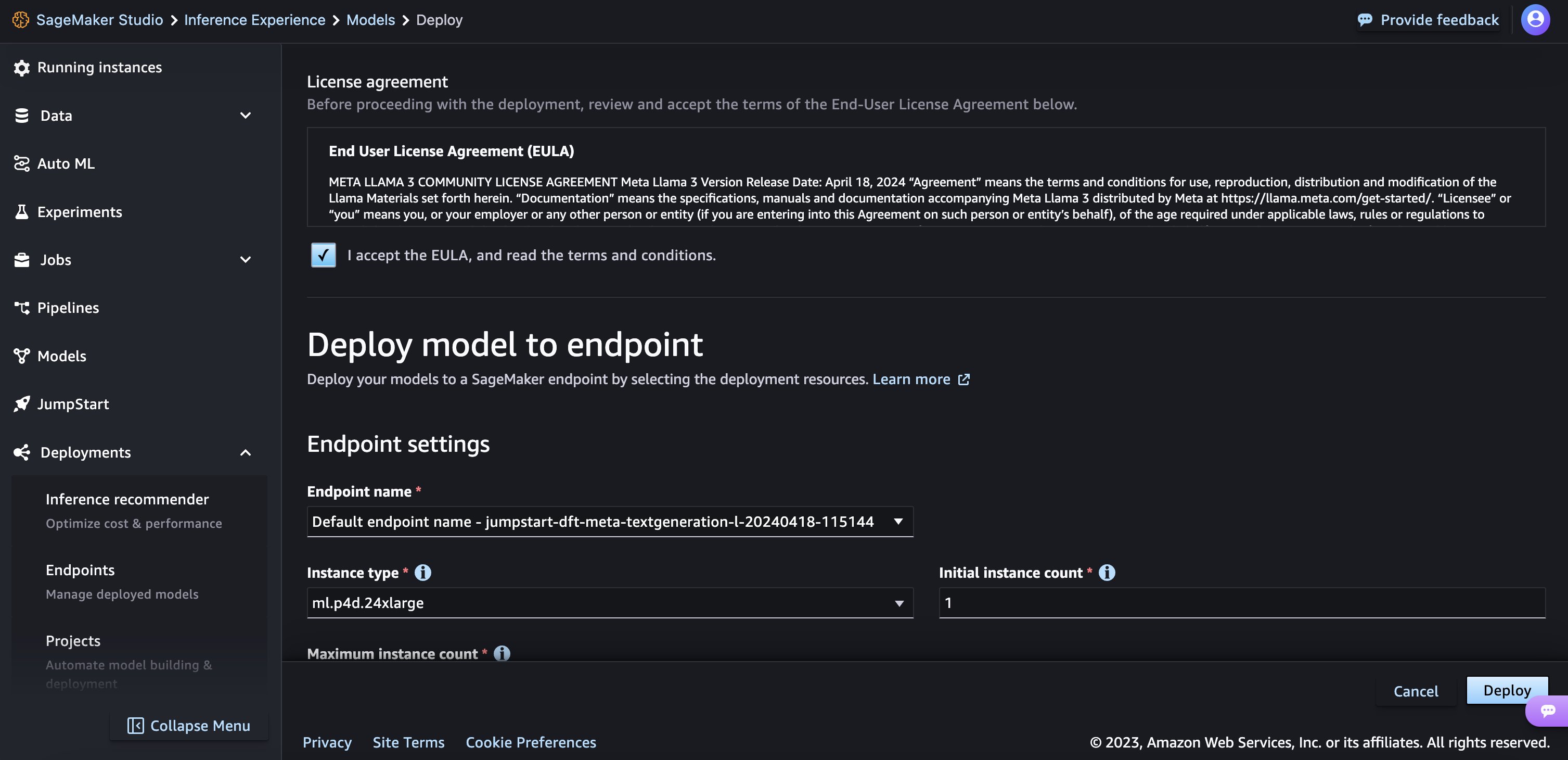

Quand vous choisissez Déployer et reconnaissez les termes du CLUF, le déploiement commencera.

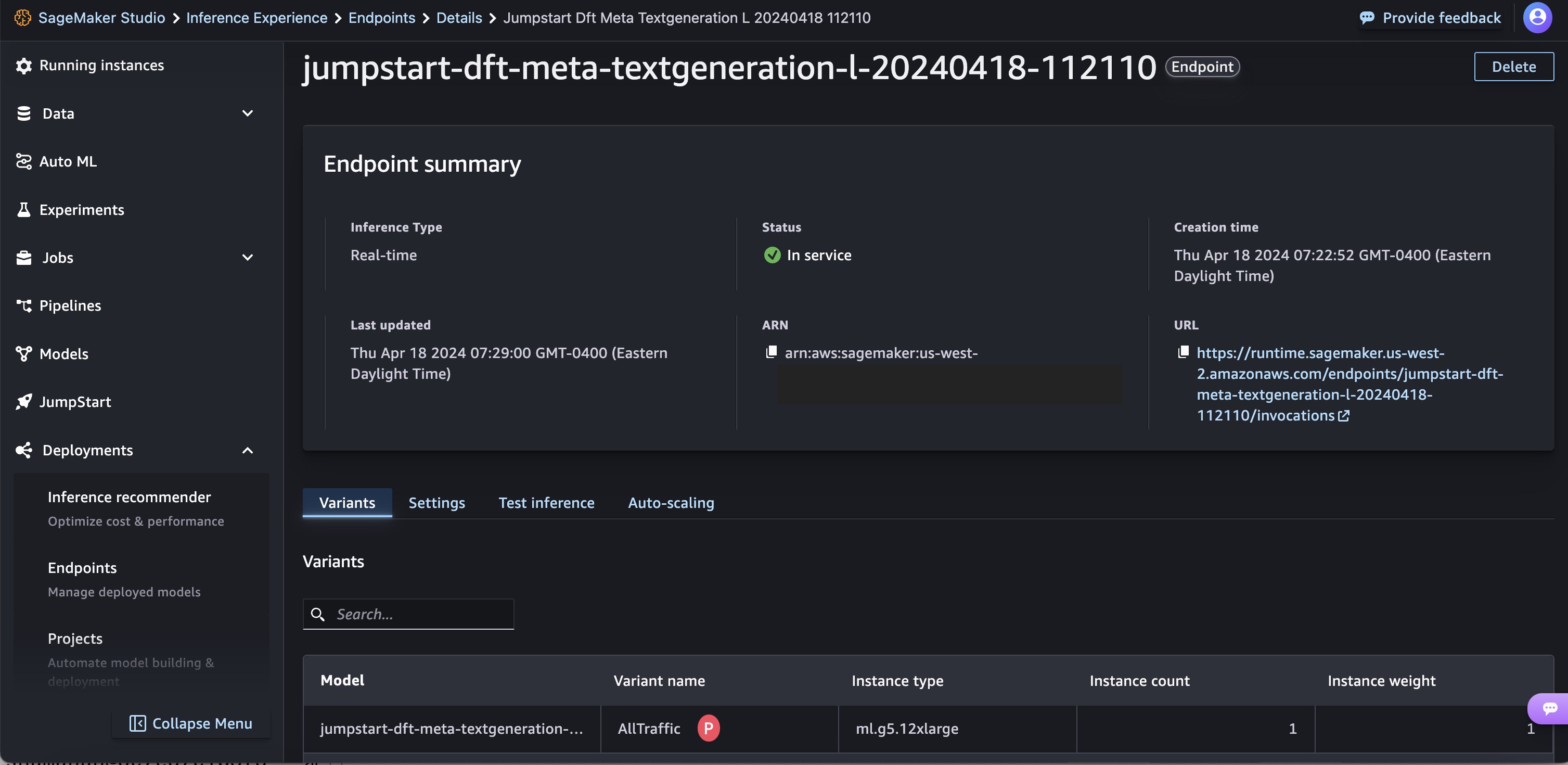

Vous pouvez suivre la progression du déploiement sur la page qui s'affiche après avoir cliqué sur le bouton Déployer.

Alternativement, vous pouvez choisir Cahier ouvert à déployer via l'exemple de notebook. L'exemple de bloc-notes fournit des conseils de bout en bout sur la manière de déployer le modèle pour l'inférence et de nettoyer les ressources.

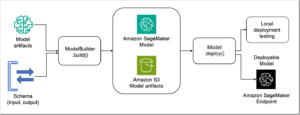

Pour déployer à l'aide du notebook, vous commencez par sélectionner un modèle approprié, spécifié par le model_id. Vous pouvez déployer n'importe lequel des modèles sélectionnés sur SageMaker avec le code suivant.

Par défaut accept_eula est fixé à False. Vous devez accepter manuellement le CLUF pour déployer le point de terminaison avec succès. Ce faisant, vous acceptez le contrat de licence utilisateur et la politique d'utilisation acceptable. Vous pouvez également trouver le contrat de licence Site Web de Lama. Cela déploie le modèle sur SageMaker avec les configurations par défaut, y compris le type d'instance par défaut et les configurations VPC par défaut. Vous pouvez modifier ces configurations en spécifiant des valeurs autres que celles par défaut dans JumpStartModel. Pour en savoir plus, veuillez vous référer à ce qui suit Documentation.

Le tableau suivant répertorie tous les modèles Llama 3 disponibles dans SageMaker JumpStart ainsi que les model_ids, types d'instances par défaut et nombre maximum de jetons totaux (somme du nombre de jetons d'entrée et du nombre de jetons générés) pris en charge pour chacun de ces modèles.

| Nom du modèle | ID du modèle | Total maximum de jetons | Type d'instance par défaut |

| Méta-Lama-3-8B | méta-textgénération-llama-3-8B | 8192 | ml.g5.12xlarge |

| Meta-Llama-3-8B-Instruct | méta-textgénération-llama-3-8B-instruct | 8192 | ml.g5.12xlarge |

| Méta-Lama-3-70B | méta-textgénération-llama-3-70b | 8192 | ml.p4d.24xlarge |

| Meta-Llama-3-70B-Instruct | méta-textgénération-llama-3-70b-instruct | 8192 | ml.p4d.24xlarge |

Exécuter l'inférence

Après avoir déployé le modèle, vous pouvez exécuter une inférence sur le point de terminaison déployé via le prédicteur SageMaker. Les modèles d'instructions affinés (Llama 3 : 8B Instruct et 70B Instruct) acceptent un historique des discussions entre l'utilisateur et l'assistant de discussion et génèrent la discussion ultérieure. Les modèles pré-entraînés (Llama 3 : 8B et 70B) nécessitent une invite de chaîne et effectuent la complétion du texte à l'invite fournie.

Les paramètres d'inférence contrôlent le processus de génération de texte au point final. Les nouveaux jetons Max contrôlent la taille de la sortie générée par le modèle. Ce n'est pas la même chose que le nombre de mots car le vocabulaire du modèle n'est pas le même que le vocabulaire de la langue anglaise, et chaque jeton ne peut pas être un mot de la langue anglaise. Le paramètre de température contrôle le caractère aléatoire de la sortie. Une température plus élevée entraîne des sorties plus créatives et hallucinées. Tous les paramètres d'inférence sont facultatifs.

Exemples d'invites pour le modèle 70B

Vous pouvez utiliser les modèles Llama 3 pour compléter le texte de n'importe quel morceau de texte. Grâce à la génération de texte, vous pouvez effectuer diverses tâches telles que la réponse aux questions, la traduction linguistique et l'analyse des sentiments, et bien plus encore. La charge utile d'entrée sur le point de terminaison ressemble au code suivant :

Voici quelques exemples d'invites et le texte généré par le modèle. Toutes les sorties sont générées avec des paramètres d'inférence {"max_new_tokens":64, "top_p":0.9, "temperature":0.6}.

Dans l'exemple suivant, nous montrons comment utiliser les modèles Llama 3 avec quelques plans d'apprentissage en contexte où nous fournissons des échantillons de formation disponibles pour le modèle. Nous effectuons uniquement l'inférence sur le modèle déployé et pendant ce processus, et les poids du modèle ne changent pas.

Exemples d'invites pour le modèle 70B-Instruct

Avec les modèles d'instruction Llama 3 optimisés pour les cas d'utilisation de dialogue, l'entrée dans les points de terminaison du modèle d'instruction correspond à l'historique précédent entre l'assistant de discussion et l'utilisateur. Vous pouvez poser des questions contextuelles à la conversation qui a eu lieu jusqu'à présent. Vous pouvez également fournir la configuration du système, telle que les personnages, qui définissent le comportement de l'assistant de chat. Bien que le format de la charge utile d'entrée soit le même que celui du modèle de base pré-entraîné, le texte d'entrée doit être formaté de la manière suivante :

Dans ce modèle d'instructions, vous pouvez éventuellement commencer par un system rôle et incluez autant de rôles alternés que vous le souhaitez dans l’histoire au tour par tour. Le rôle final devrait toujours être assistant et terminer par deux nouveaux sauts de ligne.

Examinons ensuite quelques exemples d’invites et de réponses du modèle. Dans l'exemple suivant, l'utilisateur pose une question simple à l'assistant.

Dans l'exemple suivant, l'utilisateur a une conversation avec l'assistant sur les sites touristiques de Paris. L'utilisateur s'enquiert ensuite de la première option recommandée par l'assistant de chat.

Dans les exemples suivants, nous définissons la configuration du système.

Nettoyer

Une fois que vous avez terminé d'exécuter le bloc-notes, assurez-vous de supprimer toutes les ressources que vous avez créées au cours du processus afin que votre facturation soit arrêtée. Utilisez le code suivant :

Conclusion

Dans cet article, nous vous avons montré comment démarrer avec les modèles Llama 3 dans SageMaker Studio. Vous avez désormais accès à quatre modèles de base Llama 3 contenant des milliards de paramètres. Étant donné que les modèles de base sont pré-entraînés, ils peuvent également contribuer à réduire les coûts de formation et d'infrastructure et permettre une personnalisation adaptée à votre cas d'utilisation. Vérifier SageMaker JumpStart dans SageMaker Studio maintenant pour commencer.

À propos des auteurs

Kyle Ulrich est un scientifique appliqué II chez AWS

Xin Huang est scientifique appliqué senior chez AWS

Lan Qing est ingénieur développeur de logiciels senior chez AWS

Haotian An est ingénieur développeur logiciel II chez AWS

Christophe Whitten est ingénieur en développement logiciel II chez AWS

Tyler Osterberg est ingénieur en développement logiciel I chez AWS

Manan Shah est responsable du développement logiciel chez AWS

Jonathan Guinégagne est ingénieur développeur de logiciels senior chez AWS

Adriana Simmons est responsable senior du marketing produit chez AWS

Juin gagné est chef de produit senior chez AWS

Ashish Khetan est scientifique appliqué senior chez AWS

Rachna Chadha est architecte de solutions principal – IA/ML chez AWS

Deepak Rupakula est un spécialiste principal GTM chez AWS

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/meta-llama-3-models-are-now-available-in-amazon-sagemaker-jumpstart/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 10

- 11

- 120

- 19

- 360-degree

- 43

- 7

- 8

- 8k

- 9

- a

- Qui sommes-nous

- Accepter

- acceptable

- accès

- accessible

- reconnaître

- ajouter

- ajoutée

- ajout

- avantages

- Après

- encore

- à opposer à

- contrat

- AI / ML

- alignement

- Tous

- le long de

- aussi

- toujours

- am

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon SageMakerStudio

- Amazon Web Services

- ambiance

- an

- selon une analyse de l’Université de Princeton

- ainsi que les

- et infrastructure

- Annoncer

- répondre

- répondre

- tous

- Apple

- appliqué

- approprié

- architecture

- SONT

- Art

- AS

- demander

- demandant

- Assistante gérante

- associé

- At

- Atmosphère

- attraction

- attractions

- Automatisation

- disponibles

- éviter

- AWS

- base

- BE

- Gardez

- pour créer les plus

- car

- était

- humain

- Beijing

- CROYONS

- jusqu'à XNUMX fois

- facturation

- milliards

- Box

- pauses

- stupéfiant

- vaste

- Cassé

- Parcourir

- Développement

- construit

- mais

- bouton (dans la fenêtre de contrôle qui apparaît maintenant)

- by

- Appels

- CAN

- capital

- carte

- maisons

- cas

- Change

- le chat

- chats

- vérifier

- Selectionnez

- Ville

- classiques

- espace extérieur plus propre,

- code

- collection

- combinaison

- combiné

- vient

- Communication

- achèvement

- configuration

- Considérer

- constant

- contiennent

- Contenant

- contient

- contexte

- contextuel

- continuellement

- des bactéries

- contrôles

- Pratique

- Conversation

- Correspondant

- Costs

- engendrent

- créée

- Conception

- crucial

- Culture

- Coupe

- Clients

- personnalisation

- personnaliser

- données

- la sécurité des données

- de

- dévoué

- Réglage par défaut

- Vous permet de définir

- déployer

- déployé

- déployer

- déploiement

- déploie

- dériver

- voulu

- destinations

- détail

- détails

- Développeur

- Développement

- Dialogue

- différence

- différent

- dîners

- découvrez

- Diversité

- do

- doesn

- faire

- Don

- fait

- Doublé

- down

- pendant

- Crépuscule

- e

- chacun

- même

- efforts

- permettre

- permettant

- fin

- end-to-end

- Endpoint

- ingénieur

- ENGINEERING

- Anglais

- assez

- assurer

- Environment

- Pourtant, la

- Chaque

- tout le monde

- exemple

- exemples

- excité

- d'experience

- juste

- non

- célèbre

- loin

- exploit

- en vedette

- Fonctionnalités:

- Pieds

- few

- BOPP

- finale

- Trouvez

- Prénom

- saveur

- flotteur

- flux

- Abonnement

- Pied

- Pour

- le format

- Fondation

- quatre

- France

- Français

- fraiche entreprise

- de

- Général

- Théorie générale de la relativité

- générer

- généré

- génération

- génératif

- doux

- Allemand

- obtenez

- en verre.

- Go

- aller

- peu à peu

- l'

- révolutionnaire

- l'orientation

- guidé

- arriver

- arrivé

- Dur

- travail acharné

- Vous avez

- santé

- vous aider

- aider

- ici

- augmentation

- historique

- Histoire

- appuyez en continu

- Accueil

- heure

- logement

- Comment

- How To

- HTML

- HTTPS

- Moyeu

- hubs

- i

- iconique

- if

- ii

- importer

- impressionnant

- amélioré

- améliorations

- in

- comprendre

- Y compris

- Améliore

- increased

- croissant

- d'information

- Infrastructure

- contribution

- instance

- immédiatement

- des services

- Interfaces

- développement

- Irlande

- isolé

- IT

- SES

- jpg

- juste

- XNUMX éléments à

- Savoir

- connu

- atterrissage

- repères

- langue

- le plus grand

- lancer

- Lois

- APPRENTISSAGE

- apprentissage

- à gauche

- Longueur

- Licence

- VIE

- Lifted

- lumière

- plus léger

- comme

- Gamme

- Liste

- littérature

- peu

- le travail

- Vit

- Flamme

- situé

- LOOKS

- Lot

- baisser

- LES PLANTES

- a prendre une

- Fabrication

- manager

- manière

- manuellement

- de nombreuses

- Stratégie

- max

- maximales

- Mai..

- sens

- message

- Meta

- minuit

- Minutes

- mixer

- mélange

- ML

- MLOps

- modèle

- numériques jumeaux (digital twin models)

- Surveiller

- PLUS

- (en fait, presque toutes)

- Le Plus Populaire

- beaucoup

- Musée

- Musées

- Nommé

- Besoin

- nécessaire

- réseau et

- Nouveauté

- next

- nuit

- aucune

- cahier

- maintenant

- nombre

- NY

- observation

- observateurs

- se produire

- of

- code

- offrant

- Offres Speciales

- souvent

- Ohio

- Huile

- on

- ONE

- uniquement

- ouvre

- optimaux

- optimisé

- Option

- or

- de commander

- Oregon

- Autres

- nos

- le nôtre

- ande

- sortie

- sorties

- plus de

- page

- paramètre

- paramètres

- Paris

- partie

- Effectuer

- performant

- Physique

- pièce

- Place

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joué

- veuillez cliquer

- politique

- Populaire

- Post

- Predictor

- en train de préparer

- précédent

- Directeur

- procédures

- processus

- Produit

- chef de produit

- Profils

- Progrès

- instructions

- Devis

- fournir

- à condition de

- fournisseurs

- fournit

- public

- les transports en commun

- publiquement

- but

- mettre

- Python

- question

- fréquemment posées

- aléatoire

- gamme

- Tarifs

- RE

- atteint

- Les raisons

- recette

- recommandé

- Prix Réduit

- reportez-vous

- refus

- Cordialement

- régions

- relativité

- exigent

- ressource

- Resources

- réponses

- Résultats

- Rivière

- Rôle

- rôle

- romance

- Salle

- Courir

- pour le running

- s

- sagemaker

- Pipelines SageMaker

- sel

- même

- échantillon

- dire

- Scientifique

- Sdk

- Rechercher

- recherche

- Deuxièmement

- Section

- sécurisé

- sécurité

- sur le lien

- choisi

- la sélection

- sélection

- supérieur

- sentiment

- Services

- service

- set

- plusieurs

- Forme

- coup

- devrait

- montrer

- montré

- Spectacles

- arrêter

- significative

- étapes

- simplement

- unique

- Sites

- Taille

- tailles

- lent

- Lentement

- lisse

- So

- jusqu'à présent

- Logiciels

- développement de logiciels

- sur mesure

- Solutions

- quelques

- Éclat

- spécial

- spécialiste

- spécifié

- en précisant

- vitesse

- Spot

- Utilisation d'un

- permanent

- Commencer

- j'ai commencé

- États

- stable

- Étapes

- Arrêter

- arrêté

- courant

- Chaîne

- structure

- studio

- Étourdissant

- ultérieur

- substantiellement

- Avec succès

- tel

- Support

- Appareils

- sûr

- symbole

- combustion propre

- table

- tailleur

- Prenez

- prend

- prise

- tâches

- clés

- équipe

- modèle

- conditions

- texte

- merci

- qui

- Les

- Le Capital

- le monde

- puis

- théorie

- Là.

- Ces

- l'ont

- mince

- this

- milliers

- Avec

- fiable

- à

- aujourd'hui

- ensemble

- jeton

- Tokens

- tokyo

- trop

- les outils

- top

- Total

- Tour

- La tour

- Formation

- transformateur

- traduire

- Traduction

- transport

- deux

- type

- types

- ui

- sous

- expérience unique et authentique

- jusqu'à

- Mises à jour

- utilisé

- cas d'utilisation

- Utilisateur

- Usages

- en utilisant

- Précieux

- Valeurs

- variations

- variété

- divers

- version

- très

- via

- vues

- Virginie

- visuel

- le volume

- vs

- marcher

- voulu

- guerre

- était

- Eau

- façons

- we

- web

- services Web

- Basé sur le Web

- mariages

- WELL

- est allé

- Quoi

- quand

- qui

- tout en

- blanc

- why

- sera

- fenêtres

- VIN

- comprenant

- se demander

- Word

- des mots

- activités principales

- world

- Vous n'avez

- Votre

- zéphyrnet