Aujourd'hui, nous sommes ravis d'annoncer que les modèles de fondation Llama 2 développés par Meta sont disponibles pour les clients via Amazon SageMaker JumpStart. La famille Llama 2 de grands modèles de langage (LLM) est une collection de modèles de texte génératif pré-entraînés et affinés dont l'échelle varie de 7 milliards à 70 milliards de paramètres. Les LLM affinés, appelés Llama-2-chat, sont optimisés pour les cas d'utilisation de dialogue. Vous pouvez facilement essayer ces modèles et les utiliser avec SageMaker JumpStart, qui est un hub d'apprentissage automatique (ML) qui donne accès à des algorithmes, des modèles et des solutions ML afin que vous puissiez rapidement démarrer avec ML.

Dans cet article, nous expliquons comment utiliser les modèles Llama 2 via SageMaker JumpStart.

Qu'est-ce que le lama 2

Llama 2 est un modèle de langage auto-régressif qui utilise une architecture de transformateur optimisée. Llama 2 est destiné à un usage commercial et de recherche en anglais. Il est disponible dans une gamme de tailles de paramètres - 7 milliards, 13 milliards et 70 milliards - ainsi que des variations pré-formées et affinées. Selon Meta, les versions optimisées utilisent un réglage fin supervisé (SFT) et un apprentissage par renforcement avec rétroaction humaine (RLHF) pour s'aligner sur les préférences humaines en matière d'utilité et de sécurité. Llama 2 a été pré-formé sur 2 billions de jetons de données provenant de sources accessibles au public. Les modèles optimisés sont destinés au chat de type assistant, tandis que les modèles pré-formés peuvent être adaptés à une variété de tâches de génération de langage naturel. Quelle que soit la version du modèle utilisée par un développeur, la guide d'utilisation responsable de Meta peut aider à guider les ajustements supplémentaires qui peuvent être nécessaires pour personnaliser et optimiser les modèles avec des mesures d'atténuation de sécurité appropriées.

Qu'est-ce que SageMaker JumpStart

Avec SageMaker JumpStart, les praticiens du ML peuvent choisir parmi une large sélection de modèles de base open source. Les praticiens du ML peuvent déployer des modèles de base sur des Amazon Sage Maker instances à partir d'un environnement isolé du réseau et personnalisez les modèles à l'aide de SageMaker pour la formation et le déploiement des modèles.

Vous pouvez maintenant découvrir et déployer Llama 2 en quelques clics dans Amazon SageMakerStudio ou par programmation via le SDK SageMaker Python, vous permettant de dériver les performances du modèle et les contrôles MLOps avec des fonctionnalités SageMaker telles que Pipelines Amazon SageMaker, Débogueur Amazon SageMaker, ou journaux de conteneur. Le modèle est déployé dans un environnement sécurisé AWS et sous les contrôles de votre VPC, ce qui contribue à garantir la sécurité des données. Les modèles Llama 2 sont disponibles aujourd'hui dans Amazon SageMaker Studio, initialement en us-east 1 ainsi que us-west 2 les régions.

Découvrez les modèles

Vous pouvez accéder aux modèles de base via SageMaker JumpStart dans l'interface utilisateur SageMaker Studio et le SDK Python SageMaker. Dans cette section, nous allons voir comment découvrir les modèles dans SageMaker Studio.

SageMaker Studio est un environnement de développement intégré (IDE) qui fournit une interface visuelle Web unique où vous pouvez accéder à des outils spécialement conçus pour effectuer toutes les étapes de développement ML, de la préparation des données à la création, la formation et le déploiement de vos modèles ML. Pour plus de détails sur la façon de démarrer et de configurer SageMaker Studio, reportez-vous à Amazon SageMakerStudio.

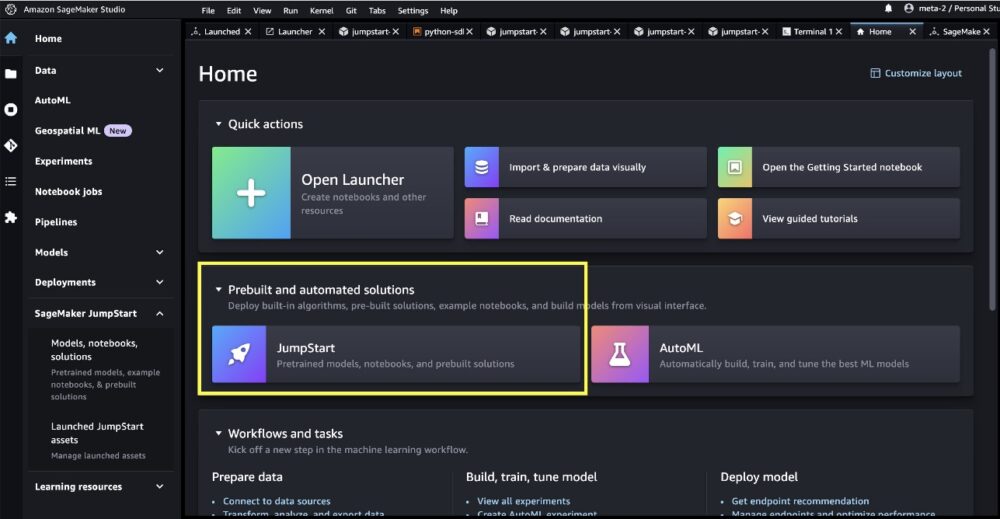

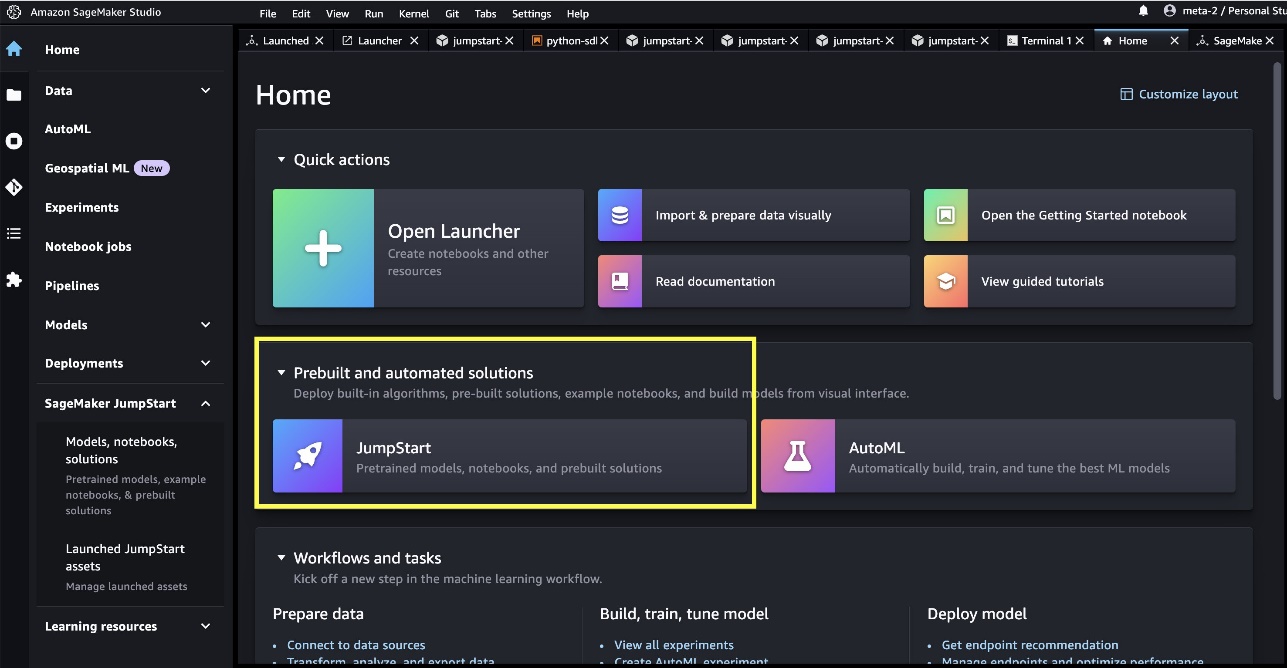

Une fois que vous êtes sur SageMaker Studio, vous pouvez accéder à SageMaker JumpStart, qui contient des modèles, des blocs-notes et des solutions prédéfinis pré-formés, sous Solutions prédéfinies et automatisées.

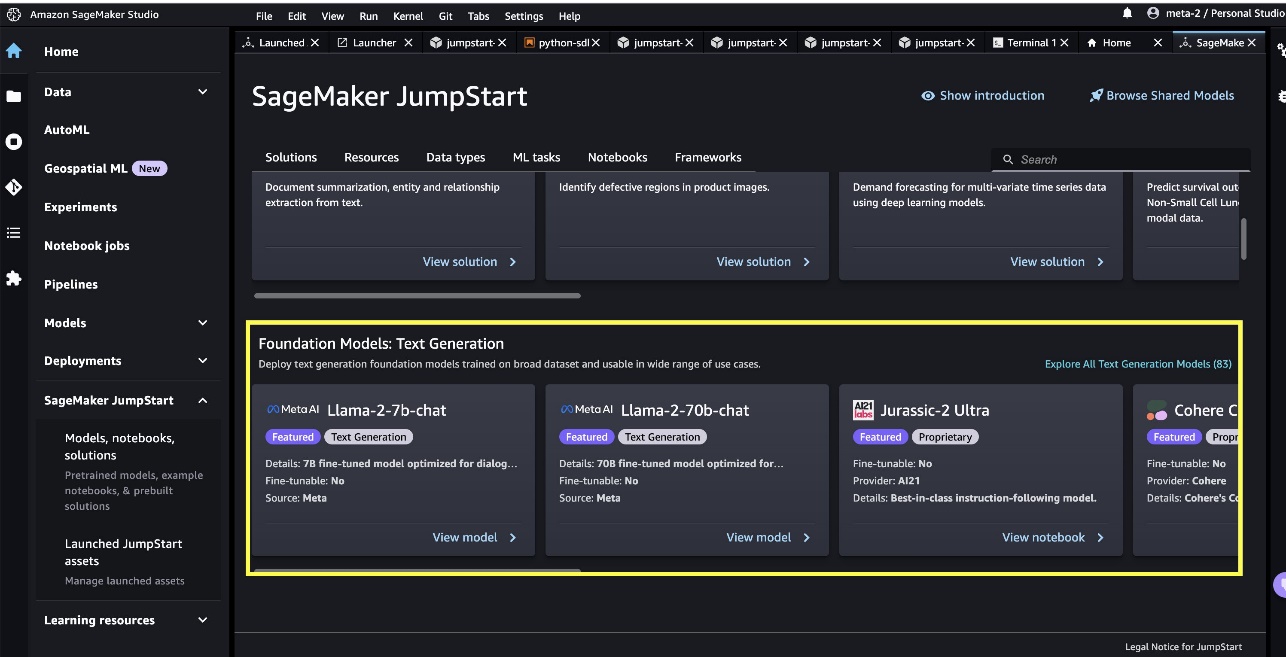

À partir de la page d'accueil SageMaker JumpStart, vous pouvez rechercher des solutions, des modèles, des blocs-notes et d'autres ressources. Vous pouvez trouver deux modèles phares de Llama 2 dans le Modèles de fondation : Génération de texte carrousel. Si vous ne voyez pas les modèles Llama 2, mettez à jour votre version de SageMaker Studio en fermant et en redémarrant. Pour plus d'informations sur les mises à jour de version, reportez-vous à Arrêter et mettre à jour les applications Studio.

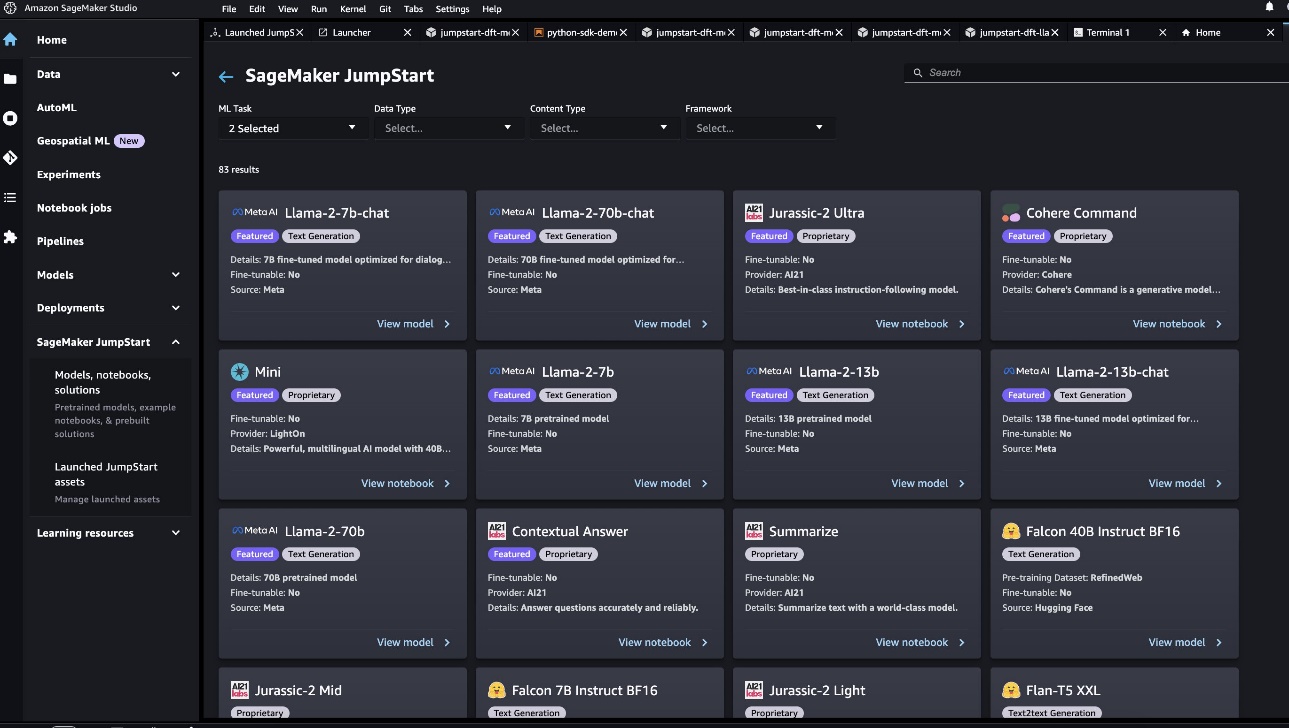

Vous pouvez également trouver quatre autres variantes de modèle en choisissant Explorer tous les modèles de génération de texte ou à la recherche de llama dans la boîte de recherche.

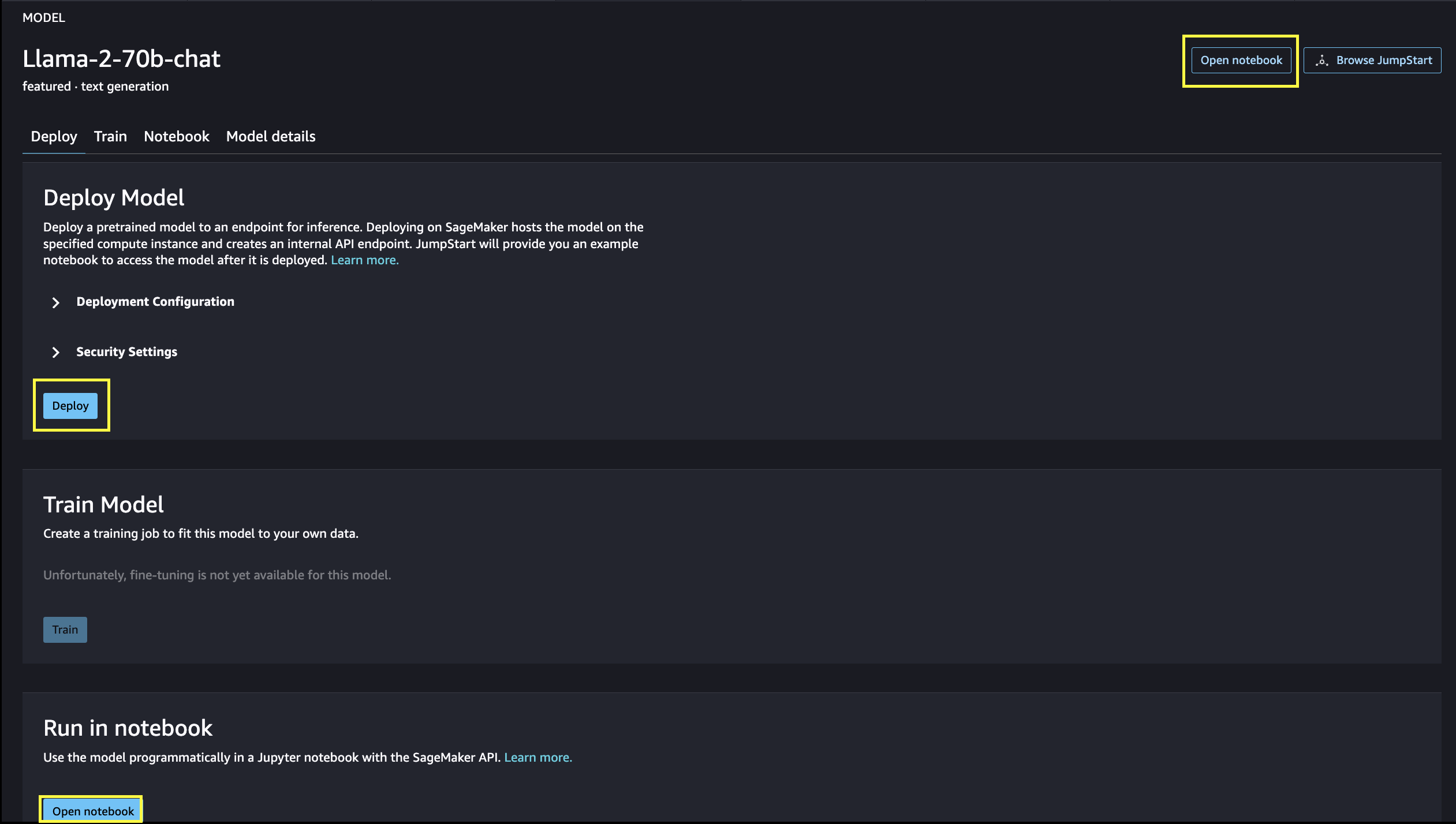

Vous pouvez choisir la carte de modèle pour afficher des détails sur le modèle, tels que la licence, les données utilisées pour l'entraînement et la manière de l'utiliser. Vous pouvez également trouver deux boutons, Déployer ainsi que Cahier ouvert, qui vous aident à utiliser le modèle.

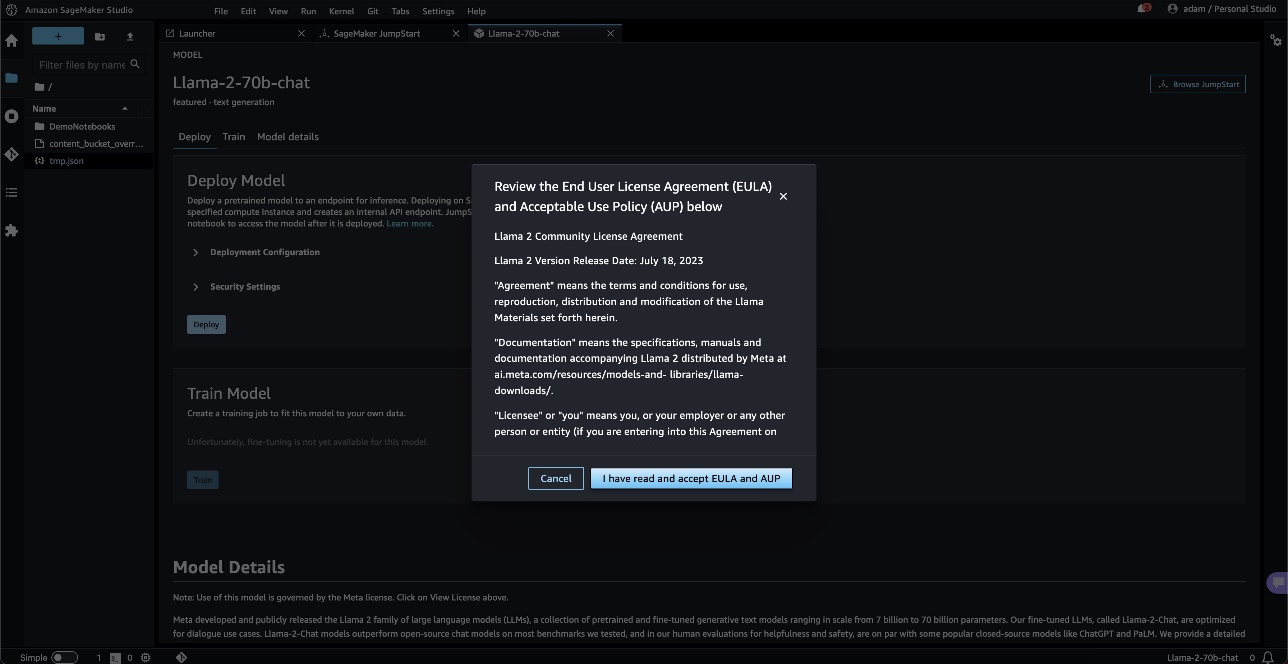

Lorsque vous choisissez l'un ou l'autre des boutons, une fenêtre contextuelle affiche le contrat de licence de l'utilisateur final et la politique d'utilisation acceptable que vous devez accepter.

Après confirmation, vous passerez à l'étape suivante pour utiliser le modèle.

Déployer un modèle

Quand vous choisissez Déployer et acceptez les termes, le déploiement du modèle commencera. Alternativement, vous pouvez déployer via l'exemple de bloc-notes qui s'affiche en choisissant Cahier ouvert. L'exemple de bloc-notes fournit des conseils de bout en bout sur la manière de déployer le modèle pour l'inférence et de nettoyer les ressources.

Pour déployer à l'aide d'un notebook, nous commençons par sélectionner un modèle approprié, spécifié par le model_id. Vous pouvez déployer n'importe lequel des modèles sélectionnés sur SageMaker avec le code suivant :

Cela déploie le modèle sur SageMaker avec les configurations par défaut, y compris le type d'instance par défaut et les configurations VPC par défaut. Vous pouvez modifier ces configurations en spécifiant des valeurs autres que celles par défaut dans Modèle JumpStart. Une fois déployé, vous pouvez exécuter une inférence sur le point de terminaison déployé via le prédicteur SageMaker :

Des modèles de chat affinés (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) acceptent un historique de chat entre l'utilisateur et l'assistant de chat, et génèrent le chat suivant. Les modèles pré-formés (Llama-2-7b, Llama-2-13b, Llama-2-70b) nécessitent une invite de chaîne et effectuent la complétion du texte à l'invite fournie. Voir le code suivant :

Notez que par défaut, accept_eula est défini sur faux. Vous devez définir accept_eula=true pour appeler le point de terminaison avec succès. Ce faisant, vous acceptez le contrat de licence utilisateur et la politique d'utilisation acceptable comme mentionné précédemment. Vous pouvez aussi download le contrat de licence.

Custom_attributes utilisés pour passer le CLUF sont des paires clé/valeur. La clé et la valeur sont séparées par = et les paires sont séparées par ;. Si l'utilisateur passe plusieurs fois la même clé, la dernière valeur est conservée et transmise au gestionnaire de script (c'est-à-dire, dans ce cas, utilisée pour la logique conditionnelle). Par exemple, si accept_eula=false; accept_eula=true est transmis au serveur, puis accept_eula=true est conservé et transmis au gestionnaire de script.

Les paramètres d'inférence contrôlent le processus de génération de texte au point de terminaison. Le contrôle du nombre maximal de nouveaux jetons fait référence à la taille de la sortie générée par le modèle. Notez que ce n'est pas le même que le nombre de mots car le vocabulaire du modèle n'est pas le même que le vocabulaire de la langue anglaise, et chaque jeton peut ne pas être un mot de la langue anglaise. La température contrôle le caractère aléatoire de la sortie. Une température plus élevée entraîne des sorties plus créatives et hallucinées. Tous les paramètres d'inférence sont facultatifs.

Le tableau suivant répertorie tous les modèles de lama disponibles dans SageMaker JumpStart ainsi que les model_ids, les types d'instance par défaut et le nombre maximal de jetons totaux (somme du nombre de jetons d'entrée et du nombre de jetons générés) pris en charge pour chacun de ces modèles.

| Nom du modèle | ID du modèle | Total maximum de jetons | Type d'instance par défaut |

| Lama-2-7b | méta-textgénération-llama-2-7b | 4096 | ml.g5.2xlarge |

| Lama-2-7b-chat | méta-textgénération-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| Lama-2-13b | méta-textgénération-llama-2-13b | 4096 | ml.g5.12xlarge |

| Lama-2-13b-chat | méta-textgénération-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| Lama-2-70b | méta-textgénération-llama-2-70b | 4096 | ml.g5.48xlarge |

| Lama-2-70b-chat | méta-textgénération-llama-2-70b-f | 4096 | ml.g5.48xlarge |

Notez que les points de terminaison SageMaker ont un délai d'expiration de 60 secondes. Ainsi, même si le modèle peut être capable de générer 4096 jetons, si la génération de texte prend plus de 60 secondes, la requête échouera. Pour les modèles 7B, 13B et 70B, nous recommandons de régler max_new_tokens pas plus de 1500, 1000 et 500 respectivement, tout en gardant le nombre total de jetons inférieur à 4K.

Inférence et exemples d'invites pour Llama-2-70b

Vous pouvez utiliser des modèles Llama pour la complétion de texte pour n'importe quel morceau de texte. Grâce à la génération de texte, vous pouvez effectuer diverses tâches, telles que répondre à des questions, traduire une langue, analyser des sentiments et bien d'autres. La charge utile d'entrée au point de terminaison ressemble au code suivant :

Voici quelques exemples d'invites et le texte généré par le modèle. Toutes les sorties sont générées avec des paramètres d'inférence {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

Dans l'exemple suivant, nous montrons comment utiliser des modèles Llama avec un apprentissage en contexte à quelques coups, où nous fournissons des échantillons de formation disponibles pour le modèle. Notez que nous ne faisons que des inférences sur le modèle déployé et pendant ce processus, les poids du modèle ne changent pas.

Inférence et exemples d'invites pour Llama-2-70b-chat

Avec les modèles Llama-2-Chat, qui sont optimisés pour les cas d'utilisation de dialogue, l'entrée aux points de terminaison du modèle de chat est l'historique précédent entre l'assistant de chat et l'utilisateur. Vous pouvez poser des questions contextuelles à la conversation qui a eu lieu jusqu'à présent. Vous pouvez également fournir la configuration du système, comme les personas qui définissent le comportement de l'assistant de chat. La charge utile d'entrée au point de terminaison ressemble au code suivant :

Voici quelques exemples d'invites et le texte généré par le modèle. Toutes les sorties sont générées avec les paramètres d'inférence {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

Dans l'exemple suivant, l'utilisateur a eu une conversation avec l'assistant sur les sites touristiques de Paris. Ensuite, l'utilisateur se renseigne sur la première option recommandée par l'assistant de chat.

Dans les exemples suivants, nous définissons la configuration du système :

Nettoyer

Une fois que vous avez terminé d'exécuter le bloc-notes, assurez-vous de supprimer toutes les ressources afin que toutes les ressources que vous avez créées au cours du processus soient supprimées et que votre facturation soit arrêtée :

Conclusion

Dans cet article, nous vous avons montré comment démarrer avec les modèles Llama 2 dans SageMaker Studio. Avec cela, vous avez accès à six modèles de fondation Llama 2 qui contiennent des milliards de paramètres. Étant donné que les modèles de base sont pré-formés, ils peuvent également aider à réduire les coûts de formation et d'infrastructure et permettre la personnalisation pour votre cas d'utilisation. Pour démarrer avec SageMaker JumpStart, consultez les ressources suivantes :

À propos des auteurs

Juin gagné est chef de produit chez SageMaker JumpStart. Il se concentre sur la création de modèles de base facilement détectables et utilisables pour aider les clients à créer des applications d'IA génératives. Son expérience chez Amazon comprend également l'application d'achat mobile et la livraison du dernier kilomètre.

Juin gagné est chef de produit chez SageMaker JumpStart. Il se concentre sur la création de modèles de base facilement détectables et utilisables pour aider les clients à créer des applications d'IA génératives. Son expérience chez Amazon comprend également l'application d'achat mobile et la livraison du dernier kilomètre.

Dr Vivek Madan est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign et a été chercheur postdoctoral à Georgia Tech. Il est un chercheur actif en apprentissage automatique et en conception d'algorithmes et a publié des articles dans les conférences EMNLP, ICLR, COLT, FOCS et SODA.

Dr Vivek Madan est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign et a été chercheur postdoctoral à Georgia Tech. Il est un chercheur actif en apprentissage automatique et en conception d'algorithmes et a publié des articles dans les conférences EMNLP, ICLR, COLT, FOCS et SODA.  Dr Kyle Ulrich est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Ses intérêts de recherche comprennent les algorithmes d'apprentissage automatique évolutifs, la vision par ordinateur, les séries chronologiques, les processus bayésiens non paramétriques et gaussiens. Son doctorat est de l'Université Duke et il a publié des articles dans NeurIPS, Cell et Neuron.

Dr Kyle Ulrich est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Ses intérêts de recherche comprennent les algorithmes d'apprentissage automatique évolutifs, la vision par ordinateur, les séries chronologiques, les processus bayésiens non paramétriques et gaussiens. Son doctorat est de l'Université Duke et il a publié des articles dans NeurIPS, Cell et Neuron.  Dr Ashish Khetan est un scientifique appliqué senior chez Amazon SageMaker JumpStart et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP.

Dr Ashish Khetan est un scientifique appliqué senior chez Amazon SageMaker JumpStart et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP.  Sundar Ranganathan est le responsable mondial des spécialistes GenAI/Frameworks GTM chez AWS. Il se concentre sur le développement d'une stratégie GTM pour les grands modèles de langage, GenAI et les charges de travail ML à grande échelle sur les services AWS comme Amazon EC2, EKS, EFA, AWS Batch et Amazon SageMaker. Son expérience comprend des rôles de direction dans la gestion et le développement de produits chez NetApp, Micron Technology, Qualcomm et Mentor Graphics.

Sundar Ranganathan est le responsable mondial des spécialistes GenAI/Frameworks GTM chez AWS. Il se concentre sur le développement d'une stratégie GTM pour les grands modèles de langage, GenAI et les charges de travail ML à grande échelle sur les services AWS comme Amazon EC2, EKS, EFA, AWS Batch et Amazon SageMaker. Son expérience comprend des rôles de direction dans la gestion et le développement de produits chez NetApp, Micron Technology, Qualcomm et Mentor Graphics.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-degree

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Capable

- A Propos

- Accepter

- acceptable

- accès

- accessibilité

- accessible

- Selon

- reconnaître

- à travers

- infection

- ajouter

- ajoutant

- Supplémentaire

- propos

- Après

- encore

- à opposer à

- contrat

- AI

- algorithme

- algorithmes

- aligner

- Tous

- permettre

- le long de

- aussi

- toujours

- am

- Amazon

- Amazon EC2

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon SageMakerStudio

- Amazon Web Services

- Américaine

- an

- selon une analyse de l’Université de Princeton

- ainsi que

- et infrastructure

- Annoncer

- Une autre

- répondre

- tous

- chacun.e

- Application

- applications

- appliqué

- apprécier

- approprié

- Arc

- architecture

- SONT

- Art

- AS

- aider

- Assistante gérante

- At

- Atmosphère

- attractions

- Automatisation

- disponibles

- AWS

- Banane

- Essentiel

- Bataille

- Bayésien

- BE

- pour créer les plus

- Beauté

- est devenu

- car

- devenez

- était

- Bière

- before

- humain

- Beijing

- CROYONS

- cru

- LES MEILLEURS

- jusqu'à XNUMX fois

- facturation

- Milliards

- milliards

- Noir

- Box

- Pause

- stupéfiant

- vaste

- construire

- Développement

- construit

- mais

- bouton (dans la fenêtre de contrôle qui apparaît maintenant)

- by

- appelé

- CAN

- capital

- fournisseur

- carte

- carrousel

- maisons

- cas

- CHAT

- Change

- le chocolat

- Selectionnez

- choose

- Ville

- classiques

- code

- collection

- combiné

- moissonneuses-batteuses

- vient

- Venir

- commercial

- Société

- achèvement

- ordinateur

- Vision par ordinateur

- conférences

- confiance

- configuration

- considéré

- constant

- construction

- contiennent

- Contenant

- contient

- contenu

- contextuel

- continuer

- continuellement

- des bactéries

- contrôles

- Pratique

- Conversation

- Costs

- Pays

- à

- couverture

- engendrent

- créée

- Conception

- à la diversité

- Culture

- Coupe

- Clients

- personnalisation

- personnaliser

- données

- la sécurité des données

- dévoué

- dédicace

- Réglage par défaut

- Vous permet de définir

- page de livraison.

- déployer

- déployé

- déployer

- déploiement

- déploie

- Conception

- un

- voulu

- destination

- destinations

- détails

- développer

- développé

- Développeur

- développement

- Développement

- Dialogue

- différence

- différent

- difficile

- découvrez

- distinctif

- do

- documentaires

- faire

- fait

- Ne pas

- Doublé

- down

- Duc

- université de Duke

- pendant

- e

- chacun

- Plus tôt

- même

- Easy

- Edward

- einstein

- non plus

- permettre

- permettant

- fin

- end-to-end

- Endpoint

- ENGINEERING

- Anglais

- jouir

- assez

- assurer

- Environment

- l'équipements

- Éther

- Pourtant, la

- événements

- tout le monde

- exemple

- exemples

- excité

- d'experience

- expérience

- expériences

- express

- FAIL

- Échoué

- juste

- non

- famille

- célèbre

- loin

- exploit

- en vedette

- Fonctionnalités:

- Réactions

- Pieds

- few

- BOPP

- finale

- finalement

- Trouvez

- Prénom

- vaisseau amiral

- flotteur

- Flux

- se concentre

- Abonnement

- Pour

- Avant

- trouvé

- Fondation

- quatre

- France

- Français

- De

- d’étiquettes électroniques entièrement

- plus

- avenir

- Général

- générer

- généré

- génération

- génératif

- IA générative

- État de la Georgie

- obtenez

- Donner

- en verre.

- Global

- Go

- aller

- graphique

- l'

- plus grand

- révolutionnaire

- Croître

- l'orientation

- guide

- ait eu

- Poignées

- arrivé

- heureux vous

- Dur

- travail acharné

- Vous avez

- ayant

- he

- front

- vous aider

- aider

- aide

- ici

- hi

- Haute

- augmentation

- sa

- historique

- Histoire

- logement

- Comment

- How To

- HTML

- HTTPS

- Moyeu

- humain

- i

- iconique

- idée

- if

- ii

- Illinois

- Impact

- importer

- important

- impressionnant

- in

- comprendre

- inclut

- Y compris

- Incorporée

- d'information

- Infrastructure

- possible

- contribution

- inspiré

- nous inspirer

- instance

- immédiatement

- Des instructions

- des services

- prévu

- intérêts

- Interfaces

- développement

- isolé

- IT

- SES

- chemin

- jpg

- juste

- en gardant

- conservé

- ACTIVITES

- Genre

- Savoir

- connu

- atterrissage

- repère

- langue

- gros

- grande échelle

- le plus grand

- Nom de famille

- En retard

- lancer

- Lois

- Leadership

- APPRENTISSAGE

- Apprenez et grandissez

- apprentissage

- au

- moins

- niveaux

- Licence

- VIE

- lumière

- comme

- LIMIT

- Liste

- littérature

- ll

- Flamme

- logique

- Location

- Longtemps

- recherchez-

- LOOKS

- love

- aimé

- baisser

- click

- machine learning

- LES PLANTES

- a prendre une

- FAIT DU

- Fabrication

- gestion

- manager

- de nombreuses

- merveille

- Matière

- maximales

- Mai..

- sens

- mesurer

- Médias

- moyenne

- mentionné

- message

- Meta

- micron

- minute

- Minutes

- mélange

- ML

- MLOps

- Breeze Mobile

- modèle

- numériques jumeaux (digital twin models)

- moment

- mois

- PLUS

- (en fait, presque toutes)

- Le Plus Populaire

- mouvement

- film

- beaucoup

- Musée

- Musées

- Musique

- prénom

- Nature

- nécessaire

- Besoin

- nécessaire

- réseau et

- Nouveauté

- New York

- next

- aucune

- cahier

- maintenant

- nombre

- nombreux

- NY

- of

- code

- offrant

- Offres Speciales

- Huile

- on

- une fois

- ONE

- uniquement

- ouvert

- open source

- Optimiser

- optimisé

- Option

- or

- Autre

- Autres

- autrement

- nos

- ande

- sortie

- plus de

- global

- page

- paires

- Papier

- papiers

- paramètre

- paramètres

- Paris

- partie

- pass

- passé

- passes

- passé

- paix

- Effectuer

- performant

- permanent

- Téléphone

- photographies

- Physique

- pièce

- Pizza

- Plastique

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joué

- politique

- pop-up

- Populaire

- Post

- postal

- Predictor

- préférences

- en train de préparer

- représentent

- précédent

- processus

- les process

- Produit

- le développement de produits

- gestion des produits

- chef de produit

- Devis

- proud

- fournir

- à condition de

- fournit

- aportando

- public

- les transports en commun

- publiquement

- publié

- but

- mettre

- Python

- Qualcomm

- fréquemment posées

- Rapide

- vite.

- Rampes

- aléatoire

- gamme

- allant

- solutions

- Les raisons

- recevoir

- recette

- recommander

- recommandé

- se réfère

- Indépendamment

- régions

- relatif

- relativité

- répété

- représentent

- nécessaire

- a besoin

- un article

- chercheur

- Resources

- respectivement

- Réagir

- REST

- résultat

- Résultats

- Rivière

- Rôle

- rôle

- Courir

- pour le running

- s

- Sécurité

- sagemaker

- sel

- même

- évolutive

- Escaliers intérieurs

- Scientifique

- scientifiques

- Sdk

- MER

- Rechercher

- recherche

- Section

- sécurisé

- sécurité

- sur le lien

- voir

- semblait

- choisi

- la sélection

- sélection

- envoyer

- supérieur

- sentiment

- Série

- Services

- service

- set

- mise

- Forme

- requin

- Shopping

- devrait

- montrer

- montré

- Spectacles

- arrêter

- importance

- significative

- étapes

- simplement

- unique

- site

- Sites

- SIX

- Taille

- Lentement

- petit

- So

- jusqu'à présent

- Réseaux sociaux

- réseaux sociaux

- Solutions

- quelques

- Identifier

- Sources

- spécial

- spécialistes

- spécifié

- vitesse

- peuplements

- Commencer

- j'ai commencé

- Région

- États

- statistique

- étapes

- Étapes

- arrêté

- de Marketing

- Chaîne

- structure

- studio

- Étourdissant

- sujet

- ultérieur

- succès

- Avec succès

- tel

- Appareils

- sûr

- symbole

- combustion propre

- table

- Prenez

- prend

- tâches

- clés

- équipe

- technologie

- Technologie

- temporaire

- conditions

- que

- Merci

- qui

- La

- Le Capital

- El futuro

- La Source

- le monde

- leur

- Les

- théorie

- Là.

- Ces

- l'ont

- des choses

- penser

- this

- bien que?

- Avec

- Tiger

- fiable

- Des séries chronologiques

- fois

- Titre

- à

- aujourd'hui

- ensemble

- jeton

- Tokens

- les outils

- top

- Total

- La tour

- Train

- Formation

- transformateur

- traduire

- Traduction

- transport

- Billion

- Essai

- deux

- type

- types

- ui

- sous

- inoubliable

- expérience unique et authentique

- université

- jusqu'à

- Mises à jour

- Actualités

- utilisable

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- Plus-value

- Valeurs

- variété

- version

- versions

- très

- via

- Voir

- vues

- vision

- Visiter

- visiteurs

- le volume

- voulu

- guerre

- était

- we

- web

- services Web

- Basé sur le Web

- Site Web

- WELL

- Baleine

- Quoi

- Qu’est ce qu'

- quand

- Les

- qui

- tout en

- why

- sera

- fenêtres

- comprenant

- Word

- des mots

- activités principales

- vos contrats

- world

- de renommée mondiale

- envelopper

- années

- york

- Vous n'avez

- Votre

- vous-même

- zéphyrnet

- Zip