Généré avec Midjourney

La conférence NeurIPS 2023, qui s'est tenue dans la ville animée de la Nouvelle-Orléans du 10 au 16 décembre, a mis un accent particulier sur l'IA générative et les grands modèles de langage (LLM). À la lumière des récentes avancées révolutionnaires dans ce domaine, il n’est pas surprenant que ces sujets aient dominé les discussions.

L’un des thèmes centraux de la conférence de cette année était la recherche de systèmes d’IA plus efficaces. Les chercheurs et les développeurs recherchent activement des moyens de construire une IA qui non seulement apprend plus rapidement que les LLM actuels, mais qui possède également des capacités de raisonnement améliorées tout en consommant moins de ressources informatiques. Cette poursuite est cruciale dans la course vers l’intelligence générale artificielle (IAG), un objectif qui semble de plus en plus réalisable dans un avenir prévisible.

Les conférences invitées à NeurIPS 2023 étaient le reflet de ces intérêts dynamiques et en évolution rapide. Des présentateurs de divers domaines de la recherche en IA ont partagé leurs dernières réalisations, offrant ainsi une fenêtre sur les développements de pointe en IA. Dans cet article, nous approfondissons ces discussions, en extrayant et en discutant les principaux enseignements et enseignements essentiels à la compréhension des paysages actuels et futurs de l’innovation en IA.

NextGenAI : l'illusion de la mise à l'échelle et l'avenir de l'IA générative

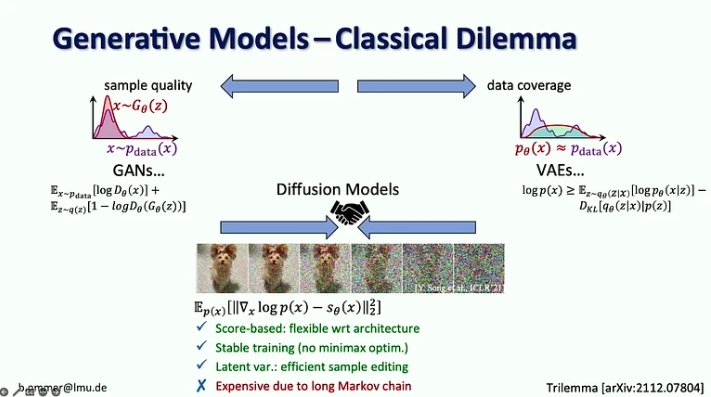

In son discours, Björn Ommer, responsable du groupe de vision par ordinateur et d'apprentissage à l'université Ludwig Maximilian de Munich, a expliqué comment son laboratoire en est venu à développer la diffusion stable, quelques leçons tirées de ce processus et les développements récents, notamment la façon dont nous pouvons mélanger des modèles de diffusion avec correspondance de flux, augmentation de la récupération et approximations LoRA, entre autres.

Principales sorties:

- À l’ère de l’IA générative, nous sommes passés de l’accent mis sur la perception dans les modèles de vision (c’est-à-dire la reconnaissance d’objets) à la prédiction des éléments manquants (par exemple, la génération d’images et de vidéos avec des modèles de diffusion).

- Pendant 20 ans, la vision par ordinateur s’est concentrée sur la recherche de référence, ce qui a permis de se concentrer sur les problèmes les plus importants. Dans l’IA Générative, nous n’avons aucun benchmark à optimiser, ce qui a ouvert le champ à chacun pour aller dans sa propre direction.

- Les modèles de diffusion combinent les avantages des modèles génératifs précédents en étant basés sur des scores avec une procédure de formation stable et une édition efficace des échantillons, mais ils sont coûteux en raison de leur longue chaîne de Markov.

- Le défi des modèles à forte vraisemblance est que la plupart des bits entrent dans des détails qui sont à peine perceptibles par l’œil humain, alors que l’encodage de la sémantique, qui compte le plus, ne prend que quelques bits. La mise à l’échelle à elle seule ne résoudrait pas ce problème, car la demande en ressources informatiques augmente 9 fois plus vite que l’offre de GPU.

- La solution suggérée consiste à combiner les atouts des modèles de diffusion et des ConvNets, en particulier l'efficacité des convolutions pour représenter les détails locaux et l'expressivité des modèles de diffusion pour un contexte à longue portée.

- Björn Ommer suggère également d'utiliser une approche de correspondance de flux pour permettre la synthèse d'images haute résolution à partir de petits modèles de diffusion latente.

- Une autre approche pour augmenter l’efficacité de la synthèse d’images consiste à se concentrer sur la composition de la scène tout en utilisant l’augmentation de la récupération pour remplir les détails.

- Enfin, il a introduit l'approche iPoke pour la synthèse vidéo stochastique contrôlée.

Si ce contenu approfondi vous est utile, abonnez-vous à notre liste de diffusion AI d'être alerté lorsque nous publierons du nouveau matériel.

Les nombreux visages de l’IA responsable

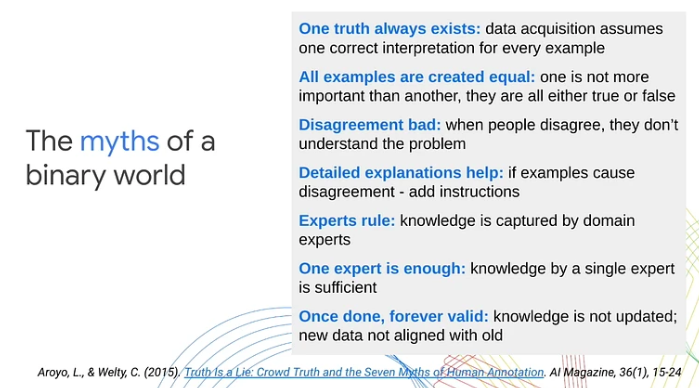

In sa présentation, Lora Aroyo, chercheuse scientifique chez Google Research, a souligné une limite clé des approches traditionnelles d'apprentissage automatique : leur dépendance à l'égard de catégorisations binaires de données comme exemples positifs ou négatifs. Selon elle, cette simplification excessive néglige la subjectivité complexe inhérente aux scénarios et au contenu du monde réel. À travers divers cas d'utilisation, Aroyo a démontré comment l'ambiguïté du contenu et la variance naturelle des points de vue humains conduisent souvent à des désaccords inévitables. Elle a souligné l’importance de traiter ces désaccords comme des signaux significatifs plutôt que comme de simples bruits.

Voici les principaux points à retenir de la conférence :

- Les désaccords entre les travailleurs humains peuvent être productifs. Au lieu de traiter toutes les réponses comme étant correctes ou fausses, Lora Aroyo a introduit la « vérité par désaccord », une approche de vérité distributionnelle pour évaluer la fiabilité des données en exploitant le désaccord des évaluateurs.

- La qualité des données est difficile, même avec des experts, car les experts sont autant en désaccord que les travailleurs. Ces désaccords peuvent être bien plus instructifs que les réponses d’un seul expert.

- Dans les tâches d'évaluation de la sécurité, les experts sont en désaccord sur 40 % des exemples. Au lieu d’essayer de résoudre ces désaccords, nous devons collecter davantage d’exemples de ce type et les utiliser pour améliorer les modèles et les paramètres d’évaluation.

- Lora Aroyo a également présenté leur Sécurité et diversité méthode pour examiner les données en termes de contenu et de qui les a annotées.

- Cette méthode a produit un ensemble de données de référence avec une variabilité des jugements de sécurité LLM parmi divers groupes démographiques d'évaluateurs (2.5 millions de notes au total).

- Pour 20 % des conversations, il était difficile de décider si la réponse du chatbot était sûre ou dangereuse, car un nombre à peu près égal de personnes interrogées les qualifiaient de sûres ou dangereuses.

- La diversité des évaluateurs et des données joue un rôle crucial dans l'évaluation des modèles. Ne pas reconnaître le large éventail de perspectives humaines et l’ambiguïté présente dans le contenu peut entraver l’alignement des performances de l’apprentissage automatique sur les attentes du monde réel.

- 80 % des efforts de sécurité de l’IA sont déjà assez bons, mais les 20 % restants nécessitent de doubler les efforts pour traiter les cas extrêmes et toutes les variantes dans l’espace infini de la diversité.

Statistiques de cohérence, expérience auto-générée et pourquoi les jeunes humains sont beaucoup plus intelligents que l'IA actuelle

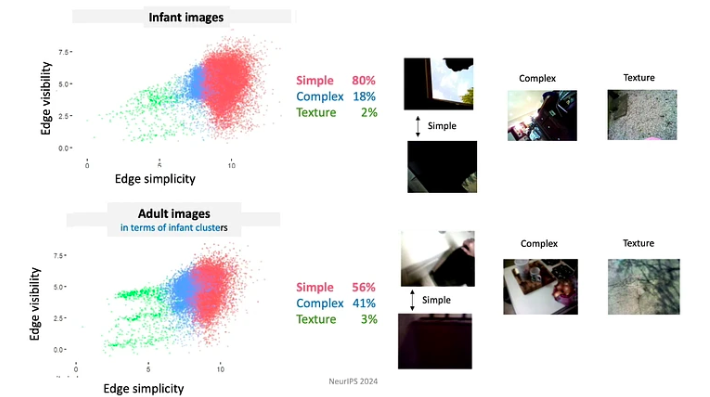

In son discours, Linda Smith, professeure émérite à l'Université de l'Indiana à Bloomington, a exploré le sujet de la rareté des données dans les processus d'apprentissage des nourrissons et des jeunes enfants. Elle s'est spécifiquement concentrée sur la reconnaissance d'objets et l'apprentissage des noms, explorant comment les statistiques des expériences auto-générées par les nourrissons offrent des solutions potentielles au défi de la rareté des données.

Principales sorties:

- Dès l’âge de trois ans, les enfants ont développé la capacité d’apprendre de manière ponctuelle dans divers domaines. En moins de 16,000 1,000 heures d’éveil jusqu’à leur quatrième anniversaire, ils parviennent à apprendre plus de XNUMX XNUMX catégories d’objets, à maîtriser la syntaxe de leur langue maternelle et à s’imprégner des nuances culturelles et sociales de leur environnement.

- Le Dr Linda Smith et son équipe ont découvert trois principes de l’apprentissage humain qui permettent aux enfants de capturer autant de données à partir de données aussi rares :

- Les apprenants contrôlent l’entrée, à chaque instant ils façonnent et structurent l’entrée. Par exemple, au cours des premiers mois de leur vie, les bébés ont tendance à regarder davantage des objets aux bords simples.

- Puisque les bébés évoluent continuellement dans leurs connaissances et leurs capacités, ils suivent un programme scolaire très contraint. Les données auxquelles ils sont exposés sont organisées de manière profondément significative. Par exemple, les bébés de moins de 4 mois passent le plus de temps à regarder des visages, environ 15 minutes par heure, tandis que ceux de plus de 12 mois se concentrent principalement sur leurs mains, les observant pendant environ 20 minutes par heure.

- Les épisodes d’apprentissage consistent en une série d’expériences interconnectées. Les corrélations spatiales et temporelles créent une cohérence, qui à son tour facilite la formation de souvenirs durables à partir d'événements ponctuels. Par exemple, lorsqu’on leur présente un assortiment aléatoire de jouets, les enfants se concentrent souvent sur quelques jouets « préférés ». Ils interagissent avec ces jouets en utilisant des schémas répétitifs, ce qui facilite un apprentissage plus rapide des objets.

- Les souvenirs transitoires (de travail) persistent plus longtemps que l’entrée sensorielle. Les propriétés qui améliorent le processus d'apprentissage comprennent la multimodalité, les associations, les relations prédictives et l'activation des souvenirs passés.

- Pour un apprentissage rapide, il faut une alliance entre les mécanismes qui génèrent les données et les mécanismes qui apprennent.

Esquisse : outils de base, augmentation de l'apprentissage et robustesse adaptative

Jelani Nelson, professeur de génie électrique et d'informatique à l'UC Berkeley, introduit le concept de « croquis » de données – une représentation compressée en mémoire d’un ensemble de données qui permet toujours de répondre à des requêtes utiles. Bien que l'exposé ait été assez technique, il a fourni un excellent aperçu de certains outils fondamentaux de dessin, y compris les avancées récentes.

Points clés à retenir :

- CountSketch, l'outil de dessin de base, a été introduit pour la première fois en 2002 pour résoudre le problème des « gros frappeurs », en fournissant une petite liste des éléments les plus fréquents du flux d'éléments donné. CountSketch a été le premier algorithme sublinéaire connu utilisé à cette fin.

- Deux applications hors streaming de gros frappeurs incluent :

- Méthode basée sur les points intérieurs (IPM) qui donne un algorithme connu asymptotiquement le plus rapide pour la programmation linéaire.

- Méthode HyperAttention qui répond au défi informatique posé par la complexité croissante des contextes longs utilisés dans les LLM.

- De nombreux travaux récents se sont concentrés sur la conception de croquis robustes à l'interaction adaptative. L'idée principale est d'utiliser les informations issues de l'analyse adaptative des données.

Panneau Au-delà de la mise à l’échelle

Ce grand panel sur les grands modèles de langage a été animé par Alexander Rush, professeur agrégé à Cornell Tech et chercheur à Hugging Face. Les autres participants comprenaient :

- Aakanksha Chowdhery – Chercheur scientifique chez Google DeepMind avec des intérêts de recherche dans les systèmes, la pré-formation LLM et la multimodalité. Elle faisait partie de l'équipe développant PaLM, Gemini et Pathways.

- Angela Fan – Chercheuse scientifique chez Meta Generative AI avec des intérêts de recherche dans l'alignement, les centres de données et le multilinguisme. Elle a participé au développement de Llama-2 et Meta AI Assistant.

- Percy Liang – Professeur à Stanford chargé de recherches sur les créateurs, l'open source et les agents génératifs. Il est directeur du Centre de recherche sur les modèles de fondation (CRFM) à Stanford et fondateur de Together AI.

La discussion s'est concentrée sur quatre sujets clés : (1) architectures et ingénierie, (2) données et alignement, (3) évaluation et transparence, et (4) créateurs et contributeurs.

Voici quelques-uns des points à retenir de ce panel :

- La formation des modèles linguistiques actuels n’est pas difficile en soi. Le principal défi de la formation d'un modèle comme Llama-2-7b réside dans les exigences d'infrastructure et la nécessité de coordonner entre plusieurs GPU, centres de données, etc. Cependant, si le nombre de paramètres est suffisamment petit pour permettre la formation sur un seul GPU, même un étudiant de premier cycle peut y parvenir.

- Alors que les modèles autorégressifs sont généralement utilisés pour la génération de texte et les modèles de diffusion pour générer des images et des vidéos, des expériences ont été menées pour inverser ces approches. Plus précisément, dans le projet Gemini, un modèle autorégressif est utilisé pour la génération d'images. Des études ont également été menées sur l'utilisation de modèles de diffusion pour la génération de texte, mais ceux-ci ne se sont pas encore révélés suffisamment efficaces.

- Compte tenu de la disponibilité limitée de données en anglais pour les modèles de formation, les chercheurs explorent des approches alternatives. Une possibilité consiste à former des modèles multimodaux sur une combinaison de texte, de vidéo, d'images et d'audio, dans l'espoir que les compétences acquises grâce à ces modalités alternatives puissent être transférées au texte. Une autre option consiste à utiliser des données synthétiques. Il est important de noter que les données synthétiques se fondent souvent dans les données réelles, mais cette intégration n’est pas aléatoire. Le texte publié en ligne fait généralement l'objet d'une conservation et d'une édition humaines, ce qui peut ajouter une valeur supplémentaire à la formation des modèles.

- Les modèles à fondation ouverte sont souvent considérés comme bénéfiques pour l’innovation mais potentiellement dangereux pour la sécurité de l’IA, car ils peuvent être exploités par des acteurs malveillants. Cependant, le Dr Percy Liang soutient que les modèles ouverts contribuent également positivement à la sécurité. Il fait valoir qu’en étant accessibles, ils offrent à davantage de chercheurs la possibilité de mener des recherches sur la sécurité de l’IA et d’examiner les modèles pour détecter les vulnérabilités potentielles.

- Aujourd’hui, l’annotation de données nécessite beaucoup plus d’expertise dans le domaine de l’annotation qu’il y a cinq ans. Cependant, si les assistants IA fonctionnent comme prévu à l’avenir, nous recevrons des données de retour plus précieuses de la part des utilisateurs, réduisant ainsi la dépendance aux données détaillées des annotateurs.

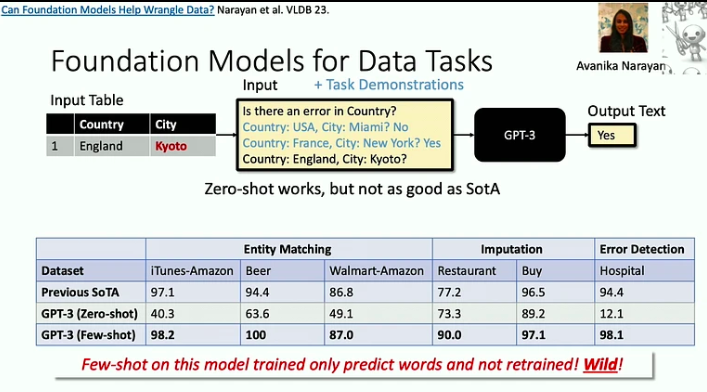

Systèmes pour modèles de fondation et modèles de fondation pour systèmes

In ce discours, Christopher Ré, professeur agrégé au département d'informatique de l'université de Stanford, montre comment les modèles de fondation ont modifié les systèmes que nous construisons. Il explore également comment créer efficacement des modèles de fondation, en empruntant des informations issues de la recherche sur les systèmes de bases de données, et discute d'architectures potentiellement plus efficaces pour les modèles de fondation que Transformer.

Voici les principaux points à retenir de cette conférence :

- Les modèles de fondation sont efficaces pour résoudre les problèmes de « mort par 1000 XNUMX coupes », dans lesquels chaque tâche individuelle peut être relativement simple, mais l’ampleur et la variété des tâches constituent un défi de taille. Un bon exemple en est le problème du nettoyage des données, que les LLM peuvent désormais aider à résoudre de manière beaucoup plus efficace.

- À mesure que les accélérateurs deviennent plus rapides, la mémoire apparaît souvent comme un goulot d'étranglement. Il s’agit d’un problème auquel les chercheurs en bases de données s’attaquent depuis des décennies, et nous pouvons adopter certaines de leurs stratégies. Par exemple, l’approche Flash Attention minimise les flux d’entrées-sorties grâce au blocage et à la fusion agressive : chaque fois que nous accédons à une information, nous y effectuons autant d’opérations que possible.

- Il existe une nouvelle classe d'architectures, ancrées dans le traitement du signal, qui pourraient être plus efficaces que le modèle Transformer, notamment pour gérer de longues séquences. Le traitement du signal offre stabilité et efficacité, jetant les bases de modèles innovants comme le S4.

Apprentissage par renforcement en ligne dans les interventions de santé numérique

In son discours, Susan Murphy, professeur de statistiques et d'informatique à l'Université Harvard, a partagé les premières solutions à certains des défis auxquels ils sont confrontés dans le développement d'algorithmes RL en ligne destinés à être utilisés dans les interventions de santé numérique.

Voici quelques points à retenir de la présentation :

- La Dre Susan Murphy a discuté de deux projets sur lesquels elle travaille :

- HeartStep, où des activités ont été suggérées sur la base des données des smartphones et des trackers portables, et

- Oralytics pour le coaching en santé bucco-dentaire, où les interventions étaient basées sur les données d'engagement reçues d'une brosse à dents électronique.

- En élaborant une politique comportementale pour un agent d’IA, les chercheurs doivent s’assurer qu’elle est autonome et qu’elle peut être mise en œuvre de manière réaliste dans le système de santé au sens large. Cela implique de s’assurer que le temps requis pour l’engagement d’un individu est raisonnable et que les actions recommandées sont à la fois éthiquement fondées et scientifiquement plausibles.

- Les principaux défis liés au développement d'un agent RL pour les interventions de santé numérique incluent la gestion des niveaux de bruit élevés, car les gens mènent leur vie et ne sont pas toujours en mesure de répondre aux messages, même s'ils le souhaitent, ainsi que la gestion des effets négatifs importants et retardés. .

Comme vous pouvez le constater, NeurIPS 2023 a fourni un aperçu éclairant de l’avenir de l’IA. Les conférences invitées ont mis en évidence une tendance vers des modèles plus efficaces et plus soucieux des ressources et l'exploration de nouvelles architectures au-delà des paradigmes traditionnels.

Vous aimez cet article? Inscrivez-vous pour plus de mises à jour de recherche sur l'IA.

Nous vous informerons lorsque nous publierons d'autres articles résumés comme celui-ci.

Services Connexes

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.topbots.com/neurips-2023-invited-talks/

- :possède

- :est

- :ne pas

- :où

- $UP

- 000

- 1

- 10

- 10ème

- 11

- 12

- 12 mois

- 125

- 13

- 14

- 15%

- 154

- 16

- 16ème

- 17

- 20

- 20 ans

- 2023

- 32

- 35%

- 41

- 58

- 7

- 70

- 710

- 8

- 9

- a

- capacité

- Capable

- Qui sommes-nous

- accélérateurs

- accès

- accessible

- réalisations

- la réalisation de

- reconnaître

- à travers

- actes

- Activation

- activement

- activités

- acteurs

- adaptatif

- ajouter

- Supplémentaire

- propos

- adresses

- adresser

- adopter

- progrès

- avantages

- âge

- Agent

- agents

- agressif

- AGI

- depuis

- AI

- Assistant IA

- recherche ai

- Systèmes d'IA

- SIDA

- Alexandre

- algorithme

- algorithmes

- alignement

- Tous

- Alliance

- permettre

- seul

- déjà

- aussi

- alternative

- Bien que

- toujours

- Ambiguïté

- parmi

- an

- selon une analyse de l’Université de Princeton

- ainsi que les

- Une autre

- tous

- applications

- une approche

- approches

- d'environ

- SONT

- argumenté

- Arguments

- article

- sur notre blog

- artificiel

- intelligence générale artificielle

- AS

- Évaluation

- Assistante gérante

- assistants

- Associé(e)

- associations

- assortiment

- At

- Réalisable

- précaution

- acoustique

- autonome

- disponibilité

- basé

- BE

- car

- devenez

- était

- humain

- va

- référence

- repères

- avantageux

- Berkeley

- jusqu'à XNUMX fois

- Au-delà

- Mélangeurs Spéciaux

- mélanges

- blocage

- Emprunt

- tous les deux

- largeur

- plus large

- construire

- mais

- by

- venu

- CAN

- capacités

- capturer

- cas

- catégories

- Canaux centraux

- Centres

- chaîne

- challenge

- globaux

- modifié

- Chatbot

- Enfants

- Christopher

- Ville

- classe

- Nettoyage

- entraînement

- recueillir

- combinaison

- combiner

- par rapport

- complexe

- complexité

- composition

- calcul

- ordinateur

- Informatique

- Vision par ordinateur

- informatique

- concept

- Conduire

- Congrès

- construire

- consommant

- contenu

- contexte

- contextes

- continuellement

- contribuer

- contributeurs

- des bactéries

- contrôlée

- conversations

- coordonner

- Core

- Cornell

- correct

- corrélations

- pourriez

- engendrent

- créateurs

- foule

- crucial

- à la diversité

- curation

- Courant

- Programme d'études

- En investissant dans une technologie de pointe, les restaurants peuvent non seulement rester compétitifs dans un marché en constante évolution, mais aussi améliorer significativement l'expérience de leurs clients.

- données

- l'analyse des données

- les centres de données

- Base de données

- traitement

- décennies

- Décembre

- décider

- DeepMind

- différé

- delve

- Demande

- demandes

- démographique

- démontré

- Département

- conception

- détail

- détails

- développer

- développé

- mobiles

- développement

- Développement

- développements

- difficile

- La diffusion

- numérique

- Santé numérique

- direction

- Directeur

- découvert

- discuté

- discuter

- spirituelle

- discussions

- Distingué

- Diversité

- domaine

- domaines

- dominé

- Ne pas

- doubler

- dr

- deux

- pendant

- Dynamic

- e

- chacun

- Edge

- Efficace

- les effets

- efficace

- efficace

- efficacement

- effort

- efforts

- non plus

- Electronique

- émerge

- l'accent

- souligné

- permettre

- permet

- codage

- s'engager

- participation

- ENGINEERING

- de renforcer

- améliorée

- assez

- assurer

- assurer

- Environment

- égal

- notamment

- essential

- etc

- évaluer

- évaluation

- Pourtant, la

- événements

- tout le monde

- évolue

- évolution

- exemple

- exemples

- excellent

- attente

- attentes

- attendu

- cher

- d'experience

- Expériences

- expériences

- expert

- nous a permis de concevoir

- de santé

- Exploités

- exploration

- Exploré

- explore

- Explorer

- exposé

- les

- œil

- Visage

- visages

- facilite

- défaut

- ventilateur

- plus rapide

- le plus rapide

- Réactions

- few

- moins

- champ

- remplir

- Prénom

- cinq

- Flash

- flux

- Flux

- Focus

- concentré

- suivre

- Pour

- prévisible

- formation

- Fondation

- fondateur

- quatre

- Quatrièmement

- fréquent

- fréquemment

- de

- fondamental

- la fusion

- avenir

- GEMINI

- Général

- intelligence générale

- générer

- générateur

- génération

- génératif

- IA générative

- donné

- donne

- Coup d'œil

- Go

- objectif

- Bien

- GPU

- GPU

- révolutionnaire

- Réservation de groupe

- Groupes

- Croissance

- ait eu

- Maniabilité

- Mains

- nuisible

- Exploiter

- harvard

- Harvard University

- Vous avez

- he

- front

- Santé

- la médecine

- lourd

- Tenue

- vous aider

- a aidé

- ici

- Haute

- haute résolution

- Surbrillance

- très

- empêcher

- sa

- heure

- HEURES

- Comment

- How To

- Cependant

- http

- HTTPS

- humain

- Les êtres humains

- i

- idée

- if

- éclairant

- image

- satellite

- mis en œuvre

- importance

- important

- améliorer

- in

- en profondeur

- comprendre

- inclus

- Y compris

- croissant

- de plus en plus

- individuel

- inévitable

- Infini

- d'information

- informatif

- Infrastructure

- inhérent

- intrinsèquement

- Innovation

- technologie innovante

- contribution

- idées.

- instance

- plutôt ;

- l'intégration

- Intelligence

- l'interaction

- interconnecté

- intérêts

- interventions

- développement

- introduit

- invité

- IT

- articles

- jpg

- jugements

- ACTIVITES

- Savoir

- spécialisées

- connu

- laboratoire

- l'étiquetage

- paysages

- langue

- gros

- durable

- Nouveautés

- pose

- conduire

- conduisant

- APPRENTISSAGE

- savant

- apprenants

- apprentissage

- apprend

- Legacy

- moins

- Cours

- laisser

- niveaux

- se trouve

- lumière

- comme

- probabilité

- limitation

- limité

- linda

- Liste

- Vit

- LLM

- locales

- Location

- plus long

- Style

- recherchez-

- click

- machine learning

- mailing

- Entrée

- gérer

- les gérer

- de nombreuses

- maître

- assorti

- Matériel

- compte

- largeur maximale

- Mai..

- significative

- mécanismes

- Souvenirs

- Mémoire

- simple

- messages

- Meta

- méthode

- Métrique

- pourrait

- million

- minimise

- Minutes

- manquant

- modèle

- numériques jumeaux (digital twin models)

- moment

- mois

- PLUS

- plus efficace

- (en fait, presque toutes)

- déménagé

- beaucoup

- plusieurs

- must

- prénom

- indigène

- Nature

- Besoin

- négatif

- Nouveauté

- Nouvelle Orléans

- aucune

- Bruit

- Aucun

- noter

- roman

- maintenant

- nuances

- nombre

- objet

- objets

- of

- code

- offrant

- Offres Speciales

- souvent

- plus

- on

- ONE

- en ligne

- uniquement

- ouvert

- open source

- ouvert

- Opérations

- Opportunités

- Optimiser

- Option

- or

- Santé bucco-dentaire

- Organisé

- orleans

- Autre

- Autres participants

- Autres

- nos

- plus de

- vue d'ensemble

- propre

- paume

- panneau

- paradigmes

- paramètres

- partie

- participants

- participé

- particulier

- particulièrement

- les pièces

- passé

- voies

- motifs

- Personnes

- /

- perception

- Effectuer

- performant

- perspectives

- pièce

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plausible

- joue

- politique

- posé

- positif

- positivement

- possède

- possibilité

- possible

- défaillances

- l'éventualité

- prévoir

- représentent

- présentation

- présenté

- précédent

- qui se déroulent

- primaire

- principes

- Problème

- d'ouvrabilité

- procédure

- processus

- les process

- traitement

- Produit

- productif

- Professeur

- profondément

- Programmation

- Projet

- projets

- important

- propriétés

- proven

- fournir

- à condition de

- publié

- but

- poursuite

- qualité

- requêtes

- quête

- assez

- Race

- aléatoire

- gamme

- Nos tests de diagnostic produisent des résultats rapides et précis sans nécessiter d'équipement de laboratoire complexe et coûteux,

- rapidement

- plutôt

- votes

- réal

- monde réel

- raisonnable

- recevoir

- reçu

- récent

- reconnaissance

- recommandé

- réduire

- réflexion

- rapports

- relativement

- libérer

- fiabilité

- dépendance

- restant

- répétitif

- Rapports

- représentation

- représentation

- exigent

- conditions

- Exigences

- un article

- chercheur

- chercheurs

- résoudre

- Resources

- Réagir

- répondants

- réponse

- réponses

- responsables

- Avis

- robuste

- Rôle

- enraciné

- grossièrement

- se ruer

- des

- Sécurité

- mise à l'échelle

- scénarios

- scène

- Sciences

- STARFLEET SCIENCES

- Scientifique

- sur le lien

- recherche

- semble

- vu

- sémantique

- Série

- mise en forme

- commun

- elle

- Spectacles

- signer

- Signal

- signaux

- significative

- de façon significative

- étapes

- unique

- compétences

- petit

- plus intelligents

- smartphones

- So

- Réseaux sociaux

- sur mesure

- Solutions

- RÉSOUDRE

- quelques

- Son

- Identifier

- Space

- Spatial

- spécifiquement

- passer

- Stabilité

- stable

- Stanford

- Stanford University

- statistiques

- Encore

- les stratégies

- courant

- forces

- STRONG

- structurant

- tel

- Suggère

- RÉSUMÉ

- la quantité

- surprise

- Susan

- syntaxe

- synthèse

- haute

- données synthétiques

- combustion propre

- Système

- Points clés à retenir

- prend

- discutons-en

- Talks

- Tâche

- tâches

- équipe

- technologie

- Technique

- Avoir tendance

- conditions

- texte

- que

- qui

- Les

- El futuro

- leur

- Les

- thèmes

- Là.

- Ces

- l'ont

- this

- ceux

- trois

- Avec

- fiable

- à

- ensemble

- outil

- les outils

- TOPBOTS

- sujet

- Les sujets

- Total

- vers

- Trackers

- traditionnel

- Formation

- transférer

- transformateur

- Transparence

- traitement

- Trend

- Vérité

- essayer

- TOUR

- deux

- typiquement

- sous

- subit

- compréhension

- université

- Actualités

- utilisé

- d'utiliser

- utilisateurs

- en utilisant

- d'habitude

- utilisé

- Précieux

- Plus-value

- variété

- divers

- vibrante

- Vidéo

- Vidéos

- points de vue

- vision

- vulnérabilités

- W3

- était

- façons

- we

- portable

- WELL

- ont été

- Quoi

- quand

- chaque fois que

- Les

- que

- qui

- tout en

- WHO

- why

- large

- Large gamme

- sera

- fenêtre

- souhaiter

- comprenant

- activités principales

- de travail

- faux

- années

- encore

- Vous n'avez

- jeune

- zéphyrnet