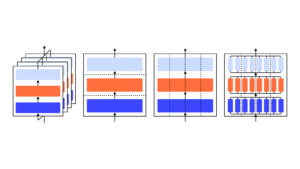

Nous montrons qu'un modèle GPT-3 peut apprendre à exprimer l'incertitude sur ses propres réponses en langage naturel, sans utiliser de logits de modèle. Lorsqu'on lui pose une question, le modèle génère à la fois une réponse et un niveau de confiance (par exemple « confiance à 90 % » ou « confiance élevée »). Ces niveaux correspondent à des probabilités bien calibrées. Le modèle reste également modérément calibré en cas de changement de distribution et est sensible à l'incertitude de ses propres réponses, plutôt que d'imiter des exemples humains. À notre connaissance, c’est la première fois qu’un modèle exprime une incertitude calibrée sur ses propres réponses en langage naturel. Pour tester l'étalonnage, nous introduisons la suite de tâches CalibratedMath. Nous comparons le calibrage de l’incertitude exprimée en mots (« probabilité verbalisée ») à l’incertitude extraite des logits du modèle. Les deux types d’incertitude sont capables de généraliser l’étalonnage sous changement de distribution. Nous fournissons également la preuve que la capacité de GPT-3 à généraliser l'étalonnage dépend de représentations latentes pré-entraînées qui sont en corrélation avec l'incertitude épistémique sur ses réponses.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :est

- a

- capacité

- A Propos

- et les

- répondre

- réponses

- SONT

- CAN

- capable

- comparer

- confiance

- dépend

- distribution

- e

- preuve

- exemples

- express

- exprimé

- Prénom

- première fois

- Pour

- De

- génère

- donné

- Haute

- HTTPS

- humain

- in

- introduire

- SES

- spécialisées

- langue

- APPRENTISSAGE

- Niveau

- niveaux

- Localisation

- modèle

- numériques jumeaux (digital twin models)

- Nature

- of

- on

- propre

- Platon

- Intelligence des données Platon

- PlatonDonnées

- fournir

- question

- plutôt

- reste

- s

- sensible

- décalage

- montrer

- montré

- suite

- tâches

- Enseignement

- Essais

- qui

- Le

- leur

- Ces

- fiable

- à

- Incertitude

- sous

- utilisé

- WELL

- comprenant

- des mots

- zéphyrnet