Les escroqueries sur Internet pourraient devenir beaucoup plus dangereuses maintenant, grâce aux fraudeurs ayant un accès sans entrave à ChatGPT, Techradar rapports.

Le très populaire chatbot alimenté par l'IA, ChatGPT, fait continuellement la une des journaux. Avec sa capacité à tout écrire, du débogage du code iframe au code de programmation informatique complexe, ChatGPT a établi l'IA comme le mot à la mode technologique de l'année.

Malgré son énorme popularité et son engagement, ChatGPT a suscité des inquiétudes concernant l'éthique et la réglementation.

A lire également: Les utilisateurs de ChatGPT 'Jailbreak' AI, libèrent Dan Alter Ego

Une rapport publié par des chercheurs en cybersécurité de Norton Labs a présenté trois façons principales dont les acteurs de la menace pourraient abuser de ChatGPT. Le rapport indique que ChatGPT pourrait être utilisé à mauvais escient pour rendre les escroqueries sur Internet plus efficaces : via la génération de contenu profondément faux, la création de phishing et la création de logiciels malveillants.

"Norton Labs prévoit que les escrocs examinent également les capacités des grands modèles de langage et testent des moyens d'améliorer leurs cybercrimes pour les rendre plus réalistes et crédibles", indique le rapport.

La capacité de l'outil à produire "de la désinformation de haute qualité ou à grande échelle" pourrait aider les fermes de bots à intensifier plus efficacement la discorde. Cela pourrait permettre à des acteurs malveillants de « semer le doute et de manipuler des récits dans plusieurs langues », sans effort, selon Norton.

"Désinformation" très convaincante

Rédiger des plans d'affaires, des stratégies et des descriptions d'entreprise de manière convaincante est un jeu d'enfant pour ChatGPT. Cependant, ce potentiel augmente également les risques de désinformation, qui peuvent se transformer en arnaque.

"Non seulement le contenu généré par ChatGPT est parfois involontairement incorrect, mais un mauvais acteur peut également utiliser ces outils pour créer intentionnellement du contenu utilisé pour nuire aux gens d'une manière ou d'une autre", indique le rapport.

Sa capacité à générer "une désinformation ou une désinformation de haute qualité à grande échelle pourrait conduire à la méfiance et façonner des récits dans différentes langues".

Rédiger des critiques de produits est devenu de plus en plus facile avec ChatGPT, qui ne peut pas être suivi car il génère à chaque fois des réponses individuelles avec les mêmes informations fournies. Malgré sa capacité, il pose le défi de "repérer les fausses critiques et les produits de mauvaise qualité".

Fait inquiétant, l'outil pourrait également être utilisé pour l'intimidation.

"L'utilisation de ces outils dans des campagnes de harcèlement sur les réseaux sociaux pour faire taire ou intimider les gens est également un résultat possible qui aurait un effet dissuasif sur la parole", note le rapport.

ChatGPT dans les campagnes de phishing

ChatGPT est particulièrement efficace pour générer du texte à consonance humaine dans différentes langues, les lecteurs ne sachant pas si le texte a été produit par l'IA ou par un humain. Même OpenAI, le développeur de ChatGPT, n'est pas en mesure d'identifier si un texte a été écrit par l'IA, déclarant qu'"il est impossible de détecter de manière fiable tous les textes écrits par l'IA".

La perspective que ChatGPT soit utilisé dans des campagnes de phishing est réelle.

"Les acteurs malveillants peuvent utiliser ChatGPT pour créer des e-mails de phishing ou des publications sur les réseaux sociaux qui semblent provenir de sources légitimes, ce qui rend plus difficile la détection et la défense contre ces types de menaces", indique le rapport.

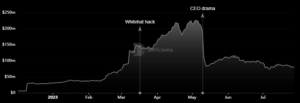

À mesure que sa popularité augmente, un corollaire probable est une augmentation du nombre de "campagnes de phishing et de leur sophistication".

Le rapport suggère que "les acteurs malveillants peuvent alimenter ChatGPT avec des exemples concrets de messages non malveillants provenant des entreprises qu'ils souhaitent imiter et ordonner à l'IA d'en créer de nouveaux basés sur le même style avec une intention malveillante".

De telles campagnes pourraient s'avérer très efficaces pour inciter les individus à divulguer des informations personnelles ou à envoyer de l'argent à des entités criminelles. Norton Labs a conseillé aux consommateurs d'être prudents lorsqu'ils "cliquent sur des liens ou fournissent des informations personnelles".

ChatGPT peut créer des logiciels malveillants

Générer du code et adapter différents langages de programmation fait tout simplement partie intégrante des services de ChatGPT. Il n'est donc pas étonnant que les fraudeurs l'utilisent pour générer des logiciels malveillants.

"Avec la bonne invite, les auteurs de logiciels malveillants novices peuvent décrire ce qu'ils veulent faire et obtenir des extraits de code fonctionnels", selon le rapport. Cela constitue une menace sérieuse d'attaques de logiciels malveillants suffisamment avancées pour faire des ravages.

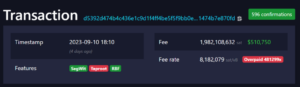

"Un exemple consiste à générer du code pour détecter quand une adresse de portefeuille bitcoin est copiée dans le presse-papiers afin qu'elle puisse être remplacée par une adresse malveillante contrôlée par l'auteur du logiciel malveillant", explique le rapport.

En conséquence, la disponibilité d'un tel chatbot entraînera une augmentation de la sophistication des logiciels malveillants.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://metanews.com/chatgpt-is-being-used-to-make-quality-scams/

- :est

- 7

- 8

- a

- capacité

- Capable

- A Propos

- abus

- accès

- Selon

- acteurs

- propos

- Avancée

- à opposer à

- AI

- Alimenté par l'IA

- Aide

- Tous

- et de

- anticipant

- apparaître

- SONT

- AS

- At

- Attaques

- auteur

- auteurs

- disponibilité

- Mal

- basé

- BE

- car

- devenez

- va

- Bitcoin

- Bitcoin Wallet

- Bot

- l'intimidation

- la performance des entreprises

- by

- Campagnes

- CAN

- ne peut pas

- capacités

- Compétences

- Causes

- prudent

- challenge

- Chatbot

- ChatGPT

- code

- Sociétés

- Société

- complexe

- ordinateur

- Préoccupations

- Les consommateurs

- contenu

- Génération de contenu

- continuellement

- contrôlée

- pourriez

- élaborer

- engendrent

- création

- Criminel

- Cybersécurité

- dangereux

- décrire

- Développeur

- différent

- difficile

- Divulgation

- discorde

- désinformation

- doute

- chacun

- effet

- Efficace

- de manière efficace

- emails

- permettre

- participation

- entités

- établies

- éthique

- Pourtant, la

- peut

- exemple

- exemples

- expliqué

- faux

- Fermes

- Pour

- fraudeurs

- De

- générer

- généré

- génère

- générateur

- génération

- obtenez

- Bien

- Vous avez

- ayant

- Titres

- très

- Cependant

- HTTPS

- majeur

- humain

- identifier

- impossible

- in

- Améliore

- Augmente

- de plus en plus

- indiqué

- individuel

- individus

- d'information

- intention

- intentionnellement

- Internet

- IT

- SES

- ACTIVITES

- Labs

- langue

- Langues

- gros

- conduire

- VIE

- Gauche

- peu

- Lot

- a prendre une

- Fabrication

- malware

- largeur maximale

- Médias

- messages

- pourrait

- Désinformation

- méfiance

- numériques jumeaux (digital twin models)

- de l'argent

- PLUS

- plusieurs

- récit

- Nouveauté

- Notes

- novice

- nombre

- of

- on

- ONE

- OpenAI

- de commander

- Résultat

- partie

- particulièrement

- Personnes

- personnel

- phishing

- plans

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Jouez

- Jouer pour

- Populaire

- popularité

- pose

- possible

- Poteaux

- défaillances

- produire

- Produit

- Produits

- Programmation

- langages de programmation

- perspective

- Prouver

- à condition de

- aportando

- publié

- Lire

- lecteurs

- réal

- la vie réelle

- réaliste

- récent

- Règlement

- remplacé

- rapport

- chercheurs

- résultat

- Avis

- risques

- même

- Escaliers intérieurs

- Arnaque

- Les escrocs

- les escroqueries

- envoi

- grave

- Services

- Forme

- Silence

- simplement

- So

- Réseaux sociaux

- réseaux sociaux

- Publications sur les réseaux sociaux

- quelques

- Sources

- discours

- Dépit

- A déclaré

- les stratégies

- Catégorie

- réussi

- tel

- technologie

- Essais

- Merci

- qui

- La

- leur

- Les

- Ces

- menace

- acteurs de la menace

- des menaces

- trois

- Avec

- fiable

- à

- outil

- les outils

- TOUR

- types

- déchaîner

- utilisé

- utilisateurs

- Wallet

- Façon..

- façons

- Quoi

- que

- qui

- largement

- sera

- comprenant

- de travail

- pourra

- écrire

- code écrit

- zéphyrnet