Dans le monde dynamique du streaming sur Amazon Music, chaque recherche d'une chanson, d'un podcast ou d'une playlist recèle une histoire, une ambiance ou un flot d'émotions qui attendent d'être dévoilées. Ces recherches servent de passerelle vers de nouvelles découvertes, des expériences précieuses et des souvenirs impérissables. La barre de recherche ne sert pas seulement à trouver une chanson ; il s'agit des millions d'utilisateurs actifs qui commencent leur voyage personnel dans le monde riche et diversifié qu'Amazon Music a à offrir.

Offrir une expérience client supérieure pour trouver instantanément la musique que les utilisateurs recherchent nécessite une plate-forme à la fois intelligente et réactive. Amazon Music utilise la puissance de l'IA pour y parvenir. Cependant, optimiser l'expérience client tout en gérant les coûts de formation et d'inférence des modèles d'IA qui alimentent les capacités de la barre de recherche, comme la vérification orthographique en temps réel et la recherche vectorielle, est difficile pendant les heures de pointe.

Amazon Sage Maker fournit un ensemble de services de bout en bout qui permettent à Amazon Music de créer, de former et de déployer sur le cloud AWS avec un minimum d'effort. En prenant en charge le gros du travail indifférencié, SageMaker vous permet de vous concentrer sur le travail sur vos modèles d'apprentissage automatique (ML) et de ne pas vous soucier de choses telles que l'infrastructure. Dans le cadre du modèle de responsabilité partagée, SageMaker s'assure que les services qu'ils fournissent sont fiables, performants et évolutifs, tout en vous assurant que l'application des modèles ML utilise au mieux les capacités fournies par SageMaker.

Dans cet article, nous passons en revue le parcours parcouru par Amazon Music pour optimiser les performances et les coûts à l'aide de SageMaker, NVIDIA Triton Inference Server et TensorRT. Nous approfondissons en profondeur le fonctionnement de cette barre de recherche apparemment simple, mais complexe, garantissant un voyage ininterrompu dans l'univers d'Amazon Music avec des retards de faute de frappe frustrants de peu à zéro et des résultats de recherche pertinents en temps réel.

Amazon SageMaker et NVIDIA : offrent des fonctionnalités de recherche vectorielle et de vérification orthographique rapides et précises

Amazon Music propose une vaste bibliothèque de plus de 100 millions de chansons et des millions d'épisodes de podcast. Cependant, trouver la bonne chanson ou le bon podcast peut être difficile, surtout si vous ne connaissez pas le titre exact, l'artiste ou le nom de l'album, ou si la requête recherchée est très large, comme « podcasts d'actualités ».

Amazon Music a adopté une approche en deux volets pour améliorer le processus de recherche et de récupération. La première étape consiste à introduire la recherche vectorielle (également connue sous le nom de récupération basée sur l'intégration), une technique de ML qui peut aider les utilisateurs à trouver le contenu le plus pertinent qu'ils recherchent en utilisant la sémantique du contenu. La deuxième étape consiste à introduire un modèle de correction orthographique basé sur un transformateur dans la pile de recherche. Cela peut être particulièrement utile lors de la recherche de musique, car les utilisateurs ne connaissent pas toujours l'orthographe exacte du titre d'une chanson ou du nom d'un artiste. La correction orthographique peut aider les utilisateurs à trouver la musique qu'ils recherchent même s'ils font une faute d'orthographe dans leur requête de recherche.

L'introduction de modèles Transformer dans un pipeline de recherche et de récupération (dans la génération d'intégration de requêtes nécessaire à la recherche vectorielle et le modèle génératif Seq2Seq Transformer dans Spell Correction) peut entraîner une augmentation significative de la latence globale, affectant négativement l'expérience client. Par conséquent, il est devenu une priorité absolue pour nous d’optimiser la latence d’inférence en temps réel pour les modèles de recherche vectorielle et de correction orthographique.

Amazon Music et NVIDIA se sont associés pour offrir la meilleure expérience client possible dans la barre de recherche, en utilisant SageMaker pour mettre en œuvre à la fois des fonctionnalités de vérification orthographique rapides et précises et des suggestions de recherche sémantique en temps réel à l'aide de techniques basées sur la recherche vectorielle. La solution comprend l'utilisation d'un hébergement SageMaker alimenté par des instances G5 qui utilisent des GPU NVIDIA A10G Tensor Core, un conteneur de serveur d'inférence NVIDIA Triton pris en charge par SageMaker et le NVIDIA TensorRT format du modèle. En réduisant la latence d'inférence du modèle de vérification orthographique à 25 millisecondes en cas de trafic de pointe, et en réduisant la latence de génération d'intégration de requêtes de recherche de 63 % en moyenne et le coût de 73 % par rapport à l'inférence basée sur le processeur, Amazon Music a amélioré les performances de la barre de recherche.

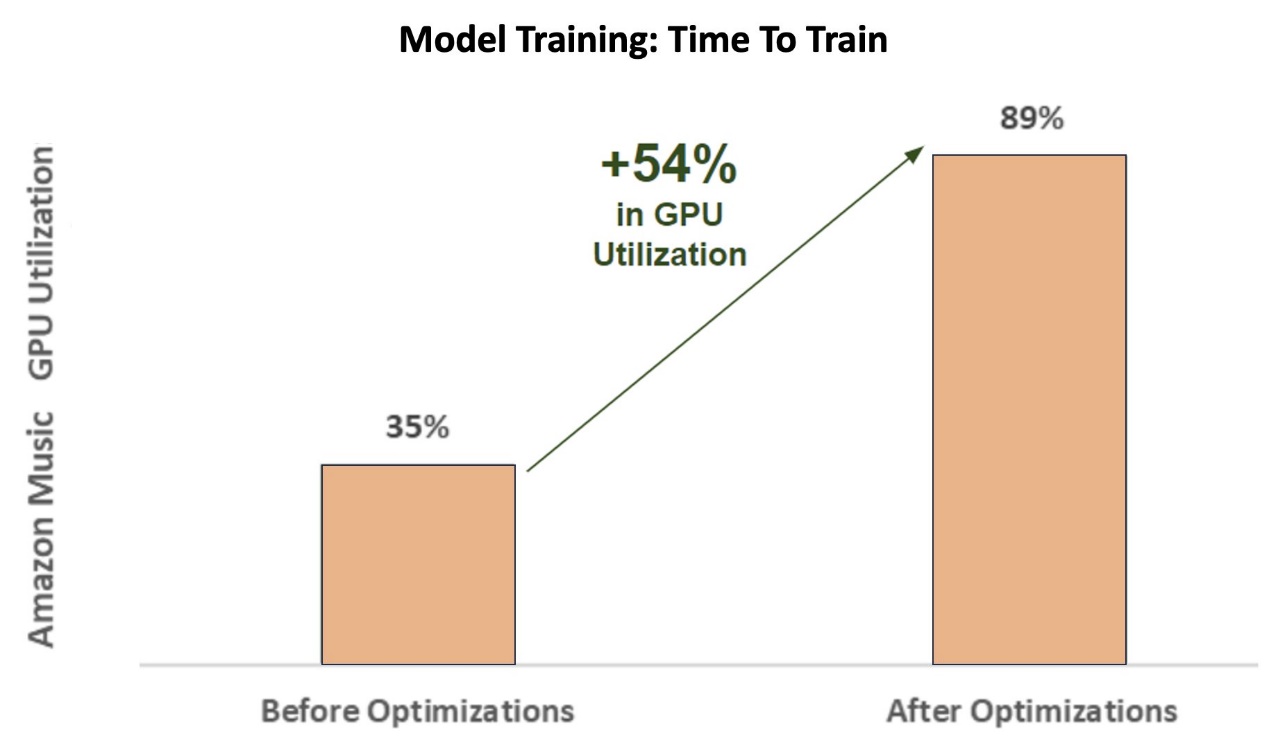

De plus, lors de la formation du modèle d'IA pour fournir des résultats précis, Amazon Music a obtenu une accélération de 12 fois le temps de formation pour son modèle de transformateur de correcteur orthographique séquence à séquence BART, ce qui lui a permis d'économiser du temps et de l'argent, en optimisant l'utilisation de son GPU.

Amazon Music s'est associé à NVIDIA pour donner la priorité à l'expérience de recherche des clients et créer une barre de recherche avec des fonctionnalités de vérification orthographique et de recherche vectorielle bien optimisées. Dans les sections suivantes, nous expliquons davantage comment ces optimisations ont été orchestrées.

Optimiser la formation avec les GPU NVIDIA Tensor Core

Avoir accès à un GPU NVIDIA Tensor Core pour la formation de grands modèles de langage ne suffit pas pour capturer son véritable potentiel. Certaines étapes d'optimisation clés doivent être effectuées pendant la formation afin de maximiser pleinement l'utilisation du GPU. Cependant, un GPU sous-utilisé entraînera sans aucun doute une utilisation inefficace des ressources, des durées de formation prolongées et une augmentation des coûts opérationnels.

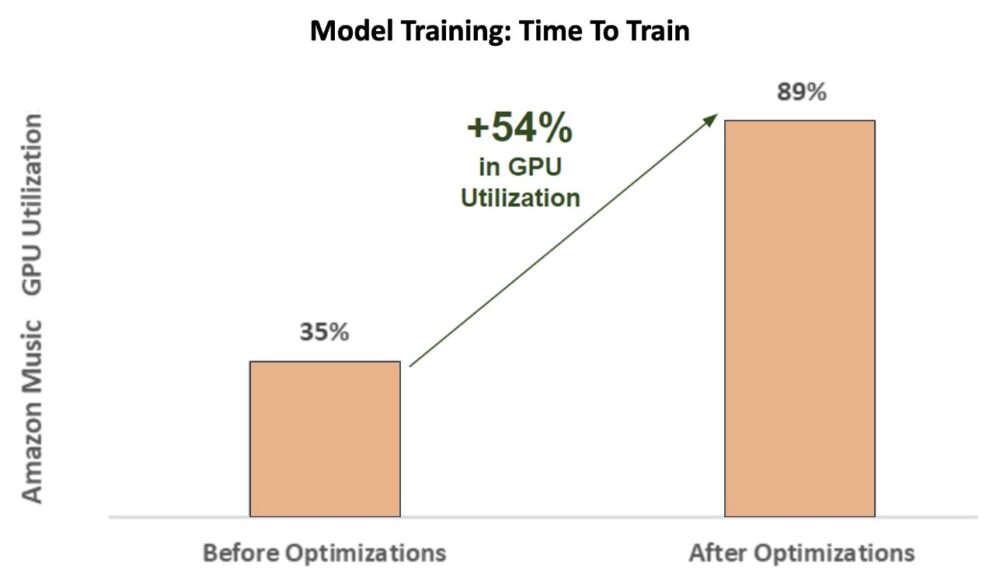

Durant les phases initiales de formation du correcteur orthographique BART (Bart-base) modèle de transformateur sur une instance SageMaker ml.p3.24xlarge (8 GPU NVIDIA V100 Tensor Core), l'utilisation du GPU d'Amazon Music était d'environ 35 %. Pour maximiser les avantages de la formation accélérée par GPU NVIDIA, les architectes de solutions AWS et NVIDIA ont aidé Amazon Music à identifier les domaines d'optimisation, en particulier autour de la taille des lots et des paramètres de précision. Ces deux paramètres cruciaux influencent l’efficacité, la rapidité et la précision de la formation des modèles d’apprentissage profond.

Les optimisations qui en ont résulté ont donné lieu à une nouvelle utilisation améliorée du GPU V100, stable à environ 89 %, réduisant considérablement le temps de formation d'Amazon Music de 3 jours à 5 à 6 heures. En faisant passer la taille du lot de 32 à 256 et en utilisant des techniques d'optimisation comme l'exécution entraînement automatique de précision mixte au lieu d'utiliser uniquement la précision FP32, Amazon Music a pu économiser du temps et de l'argent.

Le graphique suivant illustre l'augmentation de 54 % de l'utilisation du GPU après les optimisations.

La figure suivante illustre l’accélération du temps de formation.

Cette augmentation de la taille des lots a permis au GPU NVIDIA de traiter beaucoup plus de données simultanément sur plusieurs cœurs Tensor, ce qui a accéléré le temps de formation. Cependant, il est important de maintenir un équilibre délicat avec la mémoire, car des lots de plus grande taille nécessitent plus de mémoire. L'augmentation de la taille des lots et l'utilisation d'une précision mixte peuvent être essentielles pour libérer la puissance des GPU NVIDIA Tensor Core.

Une fois le modèle entraîné à la convergence, il était temps d'optimiser le déploiement d'inférence sur la barre de recherche d'Amazon Music.

Correction orthographique : inférence de modèle BART

Avec l'aide des instances SageMaker G5 et de NVIDIA Triton Inference Server (un logiciel de service d'inférence open source), ainsi que de NVIDIA TensorRT, un SDK pour l'inférence d'apprentissage en profondeur hautes performances qui comprend un optimiseur d'inférence et un runtime, Amazon Music limite son correcteur orthographique BART. (Bart-base) modélise la latence d'inférence du serveur à seulement 25 millisecondes en cas de trafic de pointe. Cela inclut les frais généraux tels que l'équilibrage de charge, le prétraitement, l'inférence de modèle et les temps de post-traitement.

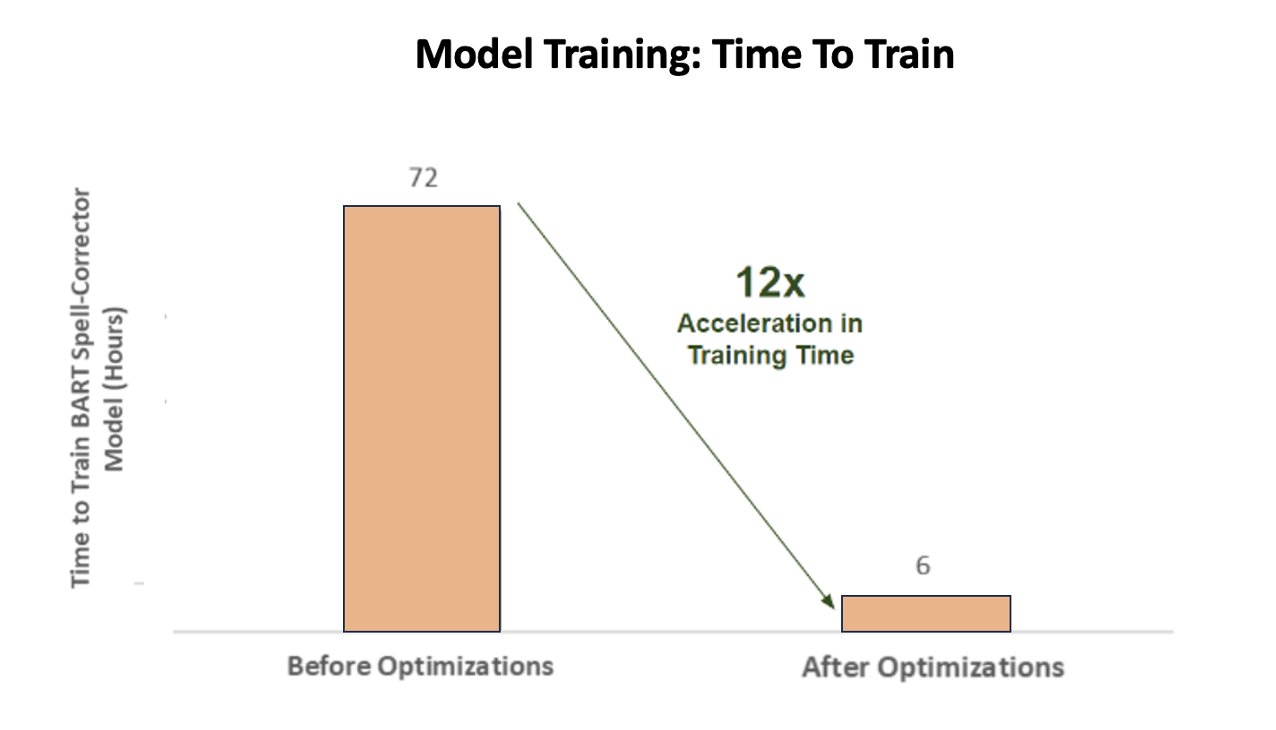

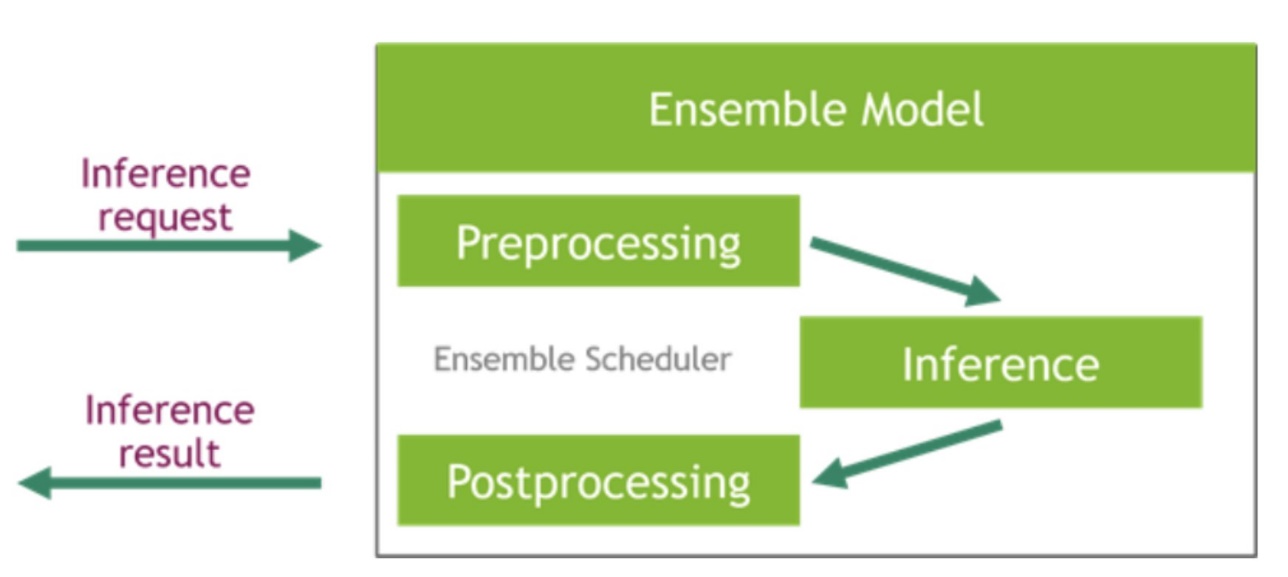

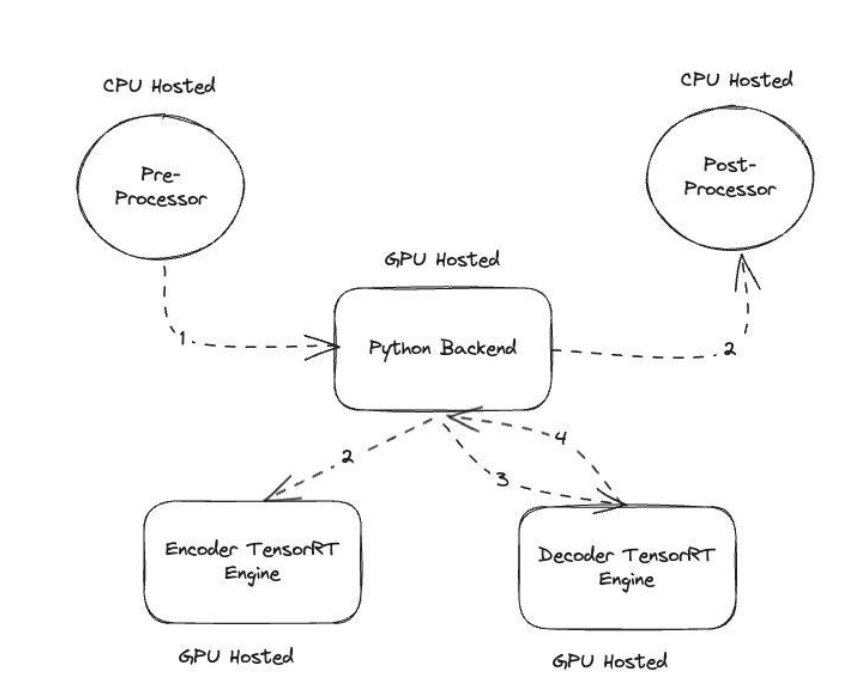

NVIDIA Triton Inference Server propose deux types de backends différents : un pour l'hébergement de modèles sur GPU et un backend Python dans lequel vous pouvez apporter votre propre code personnalisé à utiliser dans les étapes de prétraitement et de post-traitement. La figure suivante illustre le schéma d'ensemble modèle.

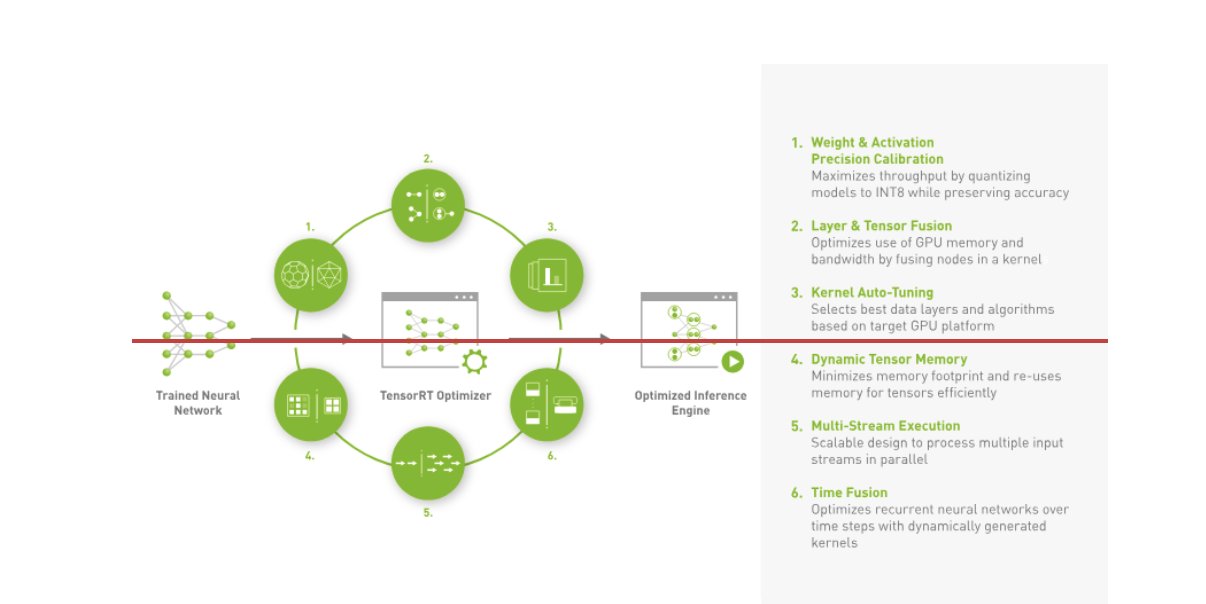

Amazon Music a construit son BART pipeline d'inférence en exécutant à la fois les étapes de prétraitement (tokénisation de texte) et de post-traitement (jetons en texte) sur les processeurs, alors que l'étape d'exécution du modèle s'exécute sur GPU NVIDIA A10G Tensor Core. Un backend Python se situe au milieu des étapes de prétraitement et de post-traitement et est responsable de la communication avec les modèles BART convertis en TensorRT ainsi qu'avec les réseaux d'encodeurs/décodeurs. TensorRT améliore les performances d'inférence avec un calibrage de précision, une fusion de couches et de tenseurs, un réglage automatique du noyau, une mémoire de tenseurs dynamique, une exécution multi-flux et une fusion temporelle.

La figure suivante illustre la conception de haut niveau des modules clés qui composent le pipeline d'inférence du modèle BART du correcteur orthographique.

Recherche de vecteur : phrase de génération d'intégration de requêtes inférence de modèle BERT

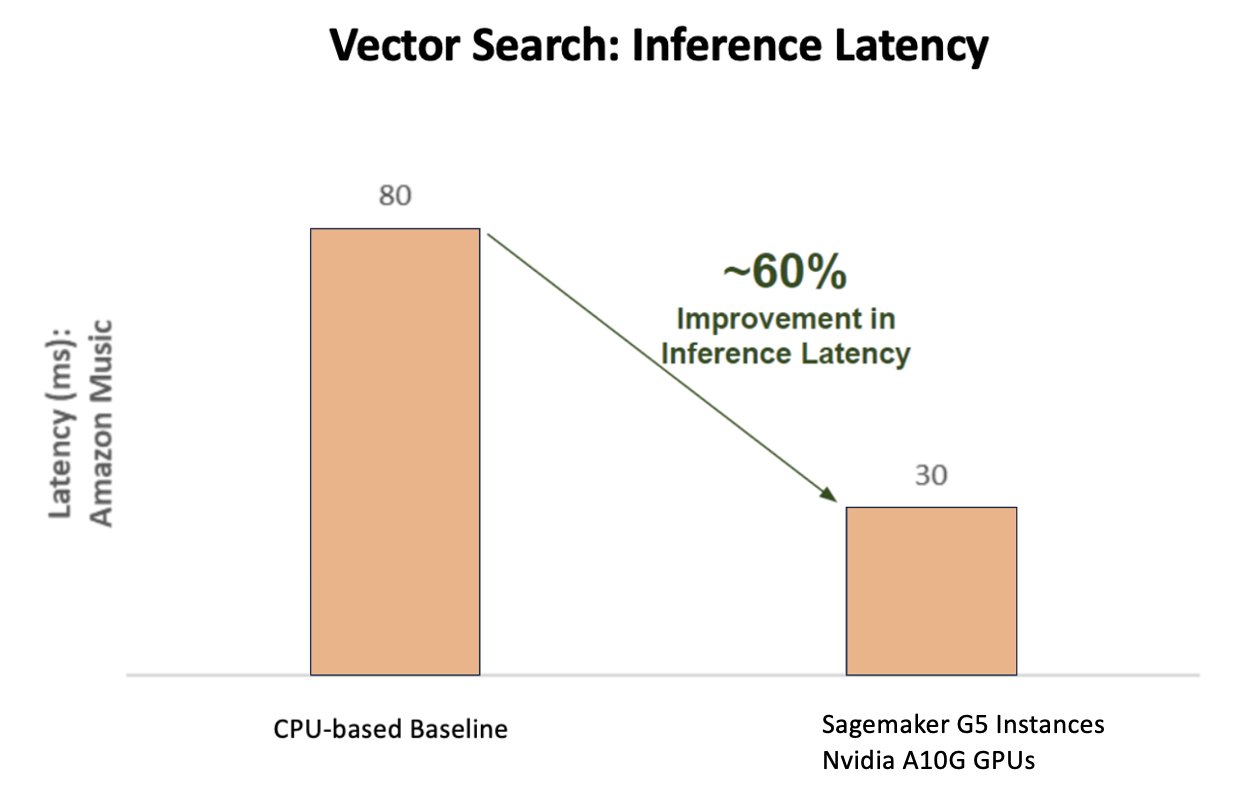

Le graphique suivant illustre l'amélioration de 60 % de la latence (desservant p90 entre 800 et 900 TPS) lors de l'utilisation de la plateforme d'inférence NVIDIA AI par rapport à une référence basée sur le processeur.

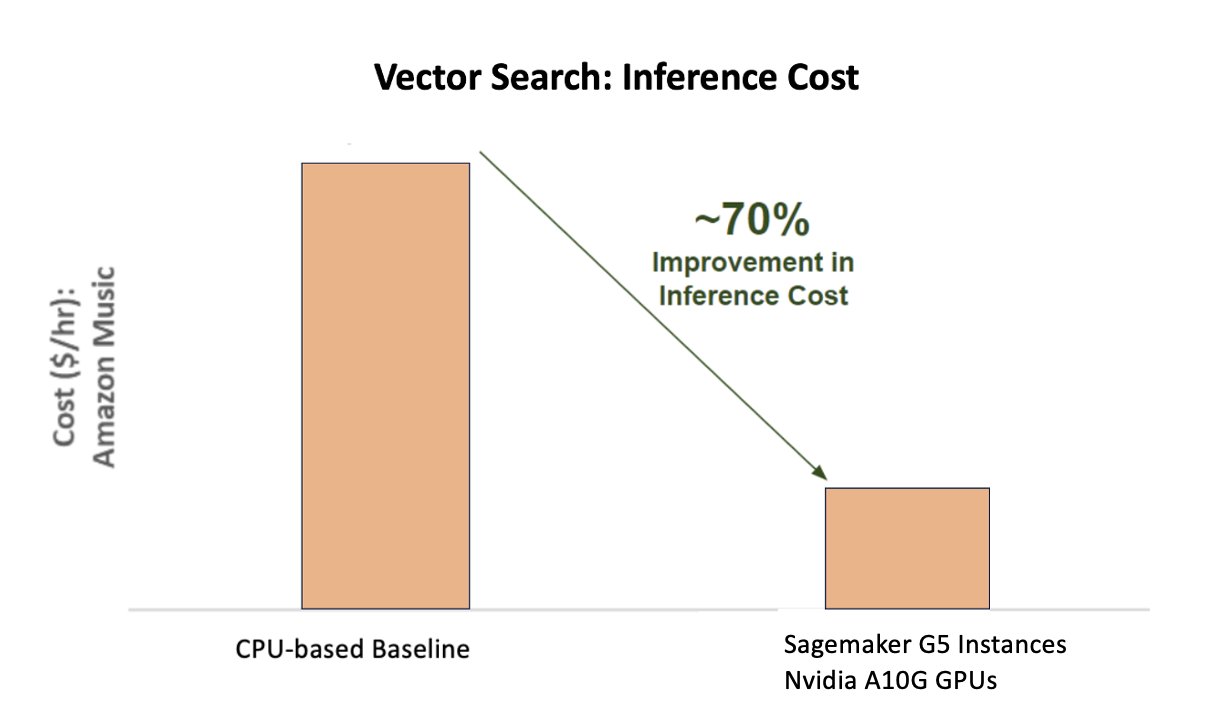

Le graphique suivant montre une amélioration de 70 % du coût lors de l'utilisation de la plateforme d'inférence NVIDIA AI par rapport à une référence basée sur le processeur.

La figure suivante illustre un SDK pour l'inférence d'apprentissage profond hautes performances. Il comprend un optimiseur d'inférence d'apprentissage profond et un moteur d'exécution qui offre une faible latence et un débit élevé pour les applications d'inférence.

Pour obtenir ces résultats, Amazon Music a expérimenté plusieurs paramètres de déploiement Triton différents en utilisant Analyseur de modèle Triton, un outil qui aide à trouver la meilleure configuration de modèle NVIDIA Triton pour déployer une inférence efficace. Pour optimiser l'inférence de modèle, Triton offre des fonctionnalités telles que le traitement par lots dynamique et l'exécution simultanée de modèles, et prend en charge d'autres fonctionnalités de flexibilité. Le traitement par lots dynamique rassemble les demandes d'inférence, les regroupant de manière transparente en cohortes afin de maximiser le débit, tout en garantissant des réponses en temps réel aux utilisateurs d'Amazon Music. La capacité d'exécution simultanée de modèles améliore encore les performances d'inférence en hébergeant plusieurs copies du modèle sur le même GPU. Enfin, en utilisant Analyseur de modèle Triton, Amazon Music a pu affiner soigneusement les paramètres d'hébergement d'inférence de traitement par lots dynamique et de modèle de concurrence pour trouver les paramètres optimaux qui maximisent les performances d'inférence à l'aide du trafic simulé.

Conclusion

L'optimisation des configurations avec Triton Inference Server et TensorRT sur SageMaker a permis à Amazon Music d'obtenir des résultats exceptionnels pour les pipelines de formation et d'inférence. La plateforme SageMaker est la plateforme ouverte de bout en bout pour l'IA de production, offrant un délai de rentabilisation rapide et la polyvalence nécessaire pour prendre en charge tous les principaux cas d'utilisation de l'IA, tant sur le plan matériel que logiciel. En optimisant l'utilisation du GPU V100 pour la formation et le passage des processeurs aux instances G5 à l'aide des GPU NVIDIA A10G Tensor Core, ainsi qu'en utilisant des logiciels NVIDIA optimisés tels que Triton Inference Server et TensorRT, des entreprises comme Amazon Music peuvent économiser du temps et de l'argent tout en améliorant les performances dans les deux domaines. formation et inférence, se traduisant directement par une meilleure expérience client et des coûts d’exploitation réduits.

SageMaker gère le gros du travail indifférencié pour la formation et l'hébergement ML, permettant à Amazon Music de fournir des opérations ML fiables et évolutives sur le matériel et les logiciels.

Nous vous encourageons à vérifier que vos charges de travail sont optimisées à l'aide de SageMaker en évaluant toujours vos choix matériels et logiciels pour voir s'il existe des moyens d'obtenir de meilleures performances avec des coûts réduits.

Pour en savoir plus sur NVIDIA AI dans AWS, reportez-vous à ce qui suit :

À propos des auteurs

Siddharth Sharma est responsable technique de l'apprentissage automatique au sein de l'équipe Science et modélisation d'Amazon Music. Il se spécialise dans les problèmes de modélisation liés à la recherche, à la récupération, au classement et à la PNL. Siddharth possède une riche expérience de travail sur des problèmes d'apprentissage automatique à grande échelle sensibles à la latence, par exemple le ciblage des publicités, la récupération multimodale, la compréhension des requêtes de recherche, etc. Avant de travailler chez Amazon Music, Siddharth a travaillé dans des entreprises comme Meta, Walmart Labs, Rakuten. sur les problèmes de ML centrés sur le commerce électronique. Siddharth a passé le début de sa carrière à travailler avec des startups de technologie publicitaire de la région de la Baie.

Siddharth Sharma est responsable technique de l'apprentissage automatique au sein de l'équipe Science et modélisation d'Amazon Music. Il se spécialise dans les problèmes de modélisation liés à la recherche, à la récupération, au classement et à la PNL. Siddharth possède une riche expérience de travail sur des problèmes d'apprentissage automatique à grande échelle sensibles à la latence, par exemple le ciblage des publicités, la récupération multimodale, la compréhension des requêtes de recherche, etc. Avant de travailler chez Amazon Music, Siddharth a travaillé dans des entreprises comme Meta, Walmart Labs, Rakuten. sur les problèmes de ML centrés sur le commerce électronique. Siddharth a passé le début de sa carrière à travailler avec des startups de technologie publicitaire de la région de la Baie.

Tarun Sharma est un responsable du développement de logiciels leader dans la pertinence de la recherche Amazon Music. Son équipe de scientifiques et d'ingénieurs ML est chargée de fournir des résultats de recherche contextuellement pertinents et personnalisés aux clients Amazon Music.

Tarun Sharma est un responsable du développement de logiciels leader dans la pertinence de la recherche Amazon Music. Son équipe de scientifiques et d'ingénieurs ML est chargée de fournir des résultats de recherche contextuellement pertinents et personnalisés aux clients Amazon Music.

James Park est architecte de solutions chez Amazon Web Services. Il travaille avec Amazon.com pour concevoir, construire et déployer des solutions technologiques sur AWS, et s'intéresse particulièrement à l'IA et à l'apprentissage automatique. Pendant son temps libre, il aime rechercher de nouvelles cultures, de nouvelles expériences et se tenir au courant des dernières tendances technologiques. Vous pouvez le trouver sur LinkedIn.

James Park est architecte de solutions chez Amazon Web Services. Il travaille avec Amazon.com pour concevoir, construire et déployer des solutions technologiques sur AWS, et s'intéresse particulièrement à l'IA et à l'apprentissage automatique. Pendant son temps libre, il aime rechercher de nouvelles cultures, de nouvelles expériences et se tenir au courant des dernières tendances technologiques. Vous pouvez le trouver sur LinkedIn.

Kshitiz Gupta est architecte de solutions chez NVIDIA. Il aime éduquer les clients du cloud sur les technologies GPU AI que NVIDIA a à offrir et les aider à accélérer leurs applications d'apprentissage automatique et d'apprentissage en profondeur. En dehors du travail, il aime courir, faire de la randonnée et observer la faune.

Kshitiz Gupta est architecte de solutions chez NVIDIA. Il aime éduquer les clients du cloud sur les technologies GPU AI que NVIDIA a à offrir et les aider à accélérer leurs applications d'apprentissage automatique et d'apprentissage en profondeur. En dehors du travail, il aime courir, faire de la randonnée et observer la faune.

Jia Hong Liu est architecte de solutions au sein de l'équipe Cloud Service Provider de NVIDIA. Il aide les clients à adopter des solutions d'apprentissage automatique et d'IA qui tirent parti de l'informatique accélérée de NVIDIA pour relever leurs défis de formation et d'inférence. Dans ses temps libres, il aime l'origami, les projets de bricolage et jouer au basket.

Jia Hong Liu est architecte de solutions au sein de l'équipe Cloud Service Provider de NVIDIA. Il aide les clients à adopter des solutions d'apprentissage automatique et d'IA qui tirent parti de l'informatique accélérée de NVIDIA pour relever leurs défis de formation et d'inférence. Dans ses temps libres, il aime l'origami, les projets de bricolage et jouer au basket.

Tugrul Konuk est architecte de solutions senior chez NVIDIA, spécialisé dans la formation à grande échelle, l'apprentissage profond multimodal et le calcul scientifique haute performance. Avant de rejoindre NVIDIA, il a travaillé dans le secteur de l'énergie, en se concentrant sur le développement d'algorithmes pour l'imagerie informatique. Dans le cadre de son doctorat, il a travaillé sur l’apprentissage profond basé sur la physique pour les simulations numériques à grande échelle. Dans ses temps libres, il aime lire, jouer de la guitare et du piano.

Tugrul Konuk est architecte de solutions senior chez NVIDIA, spécialisé dans la formation à grande échelle, l'apprentissage profond multimodal et le calcul scientifique haute performance. Avant de rejoindre NVIDIA, il a travaillé dans le secteur de l'énergie, en se concentrant sur le développement d'algorithmes pour l'imagerie informatique. Dans le cadre de son doctorat, il a travaillé sur l’apprentissage profond basé sur la physique pour les simulations numériques à grande échelle. Dans ses temps libres, il aime lire, jouer de la guitare et du piano.

Rohil Bhargava est responsable du marketing produit chez NVIDIA, axé sur le déploiement de cadres d'applications et de SDK NVIDIA sur des plates-formes CSP spécifiques.

Rohil Bhargava est responsable du marketing produit chez NVIDIA, axé sur le déploiement de cadres d'applications et de SDK NVIDIA sur des plates-formes CSP spécifiques.

Eliuth Triana Isaza est responsable des relations avec les développeurs chez NVIDIA, permettant aux experts techniques AI MLOps, DevOps, scientifiques et AWS d'Amazon de maîtriser la pile informatique NVIDIA pour accélérer et optimiser les modèles Generative AI Foundation allant de la conservation des données, de la formation GPU, de l'inférence de modèles et du déploiement de production sur les instances GPU AWS. . De plus, Eliuth est un passionné de VTT, de ski, de tennis et de poker.

Eliuth Triana Isaza est responsable des relations avec les développeurs chez NVIDIA, permettant aux experts techniques AI MLOps, DevOps, scientifiques et AWS d'Amazon de maîtriser la pile informatique NVIDIA pour accélérer et optimiser les modèles Generative AI Foundation allant de la conservation des données, de la formation GPU, de l'inférence de modèles et du déploiement de production sur les instances GPU AWS. . De plus, Eliuth est un passionné de VTT, de ski, de tennis et de poker.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :possède

- :est

- :ne pas

- :où

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Capable

- A Propos

- accéléré

- accélérer

- accélération

- accès

- accomplir

- précision

- Avec cette connaissance vient le pouvoir de prendre

- atteindre

- atteint

- à travers

- infection

- ajout

- propos

- L'adoption d'

- annonces

- affectant

- Après

- AI

- Modèles AI

- cas d'utilisation de l'IA

- Album

- algorithmes

- Tous

- permettre

- permis

- Permettre

- permet

- aussi

- toujours

- Amazon

- Amazon Web Services

- -

- an

- et les

- Application

- applications

- une approche

- architectes

- SONT

- Réservé

- domaines

- autour

- artiste

- AS

- assistant

- aide

- At

- moyen

- AWS

- backend

- Balance

- équilibrage

- barre

- basé

- Baseline

- Basketball

- baie

- BE

- est devenu

- car

- avantages.

- LES MEILLEURS

- Améliorée

- stimuler

- l'attrait

- tous les deux

- apporter

- vaste

- construire

- construit

- by

- CAN

- capacités

- aptitude

- capturer

- les soins

- Carrière

- prudemment

- cas

- globaux

- difficile

- Graphique

- vérifier

- chéri

- choix

- CLIENTS

- le cloud

- code

- COM

- comment

- communicant

- Sociétés

- par rapport

- calcul

- informatique

- concurrent

- configuration

- Contenant

- contenu

- Convergence

- Core

- Prix

- Costs

- élaborer

- critique

- crucial

- CSP

- curation

- Customiser

- des clients

- expérience client

- Clients

- données

- Date

- jours

- diminué

- profond

- l'apprentissage en profondeur

- retards

- livrer

- livrer

- offre

- Demande

- déployer

- déployer

- déploiement

- Conception

- Développeur

- développement

- Développement

- différent

- difficile

- directement

- plongeon

- plusieurs

- Bricolage

- Ne pas

- drastiquement

- pendant

- Dynamic

- e

- e-commerce

- "Early Bird"

- l'éducation

- efficace

- efficace

- effort

- élevée

- enrobage

- émotions

- employant

- l'autonomisation des

- activé

- encourager

- end-to-end

- énergie

- Les ingénieurs

- Améliore

- assez

- assurer

- notamment

- etc

- évaluer

- Pourtant, la

- Chaque

- exécution

- d'experience

- Expériences

- de santé

- RAPIDE

- Fonctionnalités:

- Figure

- finalement

- Trouvez

- trouver

- Prénom

- Flexibilité

- inondation

- Focus

- concentré

- mettant l'accent

- Abonnement

- Pour

- le format

- Fondation

- Framework

- cadres

- De

- frustrant

- d’étiquettes électroniques entièrement

- fonctionnalités

- plus

- la fusion

- porte

- génération

- génératif

- IA générative

- GPU

- GPU

- Poignées

- arriver

- Matériel

- Vous avez

- he

- lourd

- levage de charges lourdes

- vous aider

- utile

- aide

- Haute

- de haut niveau

- haute performance

- lui

- sa

- détient

- hébergement

- HEURES

- Comment

- Cependant

- HTML

- HTTPS

- identifier

- if

- illustre

- Imagerie

- Mettre en oeuvre

- important

- améliorer

- amélioré

- amélioration

- in

- inclut

- Améliore

- increased

- croissant

- industrie

- inefficace

- influencer

- Infrastructure

- initiale

- instance

- immédiatement

- plutôt ;

- intérêt

- développement

- introduire

- Découvrez le tout nouveau

- IT

- SES

- chemin

- jpg

- juste

- ACTIVITES

- Genre

- Savoir

- connu

- Labs

- langue

- gros

- grande échelle

- plus importantes

- durable

- Latence

- Nouveautés

- couche

- conduire

- conduisant

- APPRENTISSAGE

- apprentissage

- Levier

- Bibliothèque

- lifting

- comme

- limites

- charge

- recherchez-

- Faible

- baisser

- click

- machine learning

- maintenir

- majeur

- a prendre une

- FAIT DU

- manager

- les gérer

- Stratégie

- maître

- Maximisez

- Mai..

- Souvenirs

- Mémoire

- Meta

- Milieu

- million

- des millions

- millisecondes

- minimal

- erreur

- mixte

- ML

- MLOps

- modèle

- modélisation statistique

- numériques jumeaux (digital twin models)

- Modules

- de l'argent

- PLUS

- (en fait, presque toutes)

- Montagne

- multi

- plusieurs

- Musique

- must

- prénom

- nécessaire

- négativement

- réseaux

- Nouveauté

- nlp

- Nvidia

- of

- code

- Offres Speciales

- on

- ONE

- uniquement

- ouvert

- open source

- d'exploitation

- opérationnel

- Opérations

- optimaux

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Optimiser

- optimisé

- l'optimisation

- or

- orchestrée

- de commander

- Autre

- ande

- au contrôle

- exceptionnel

- plus de

- global

- propre

- paramètres

- partie

- particulier

- particulièrement

- en partenariat

- passionné

- Courant

- pourcentage

- performant

- personnel

- Personnalisé

- phd

- pipeline

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joueur

- jouer

- Podcast

- Podcasts

- Point

- poker

- possible

- Post

- défaillances

- power

- alimenté

- La précision

- Avant

- Prioriser

- priorité

- d'ouvrabilité

- processus

- Produit

- Vidéo

- projets

- fournir

- de voiture.

- fournit

- aportando

- Python

- Rapide

- Classement

- en cours

- en temps réel

- réduire

- reportez-vous

- en relation

- rapports

- pertinence

- pertinent

- fiable

- demandes

- a besoin

- Resources

- réponses

- responsabilité

- responsables

- sensible

- résultant

- Résultats

- Rich

- bon

- pour le running

- fonctionne

- d'exécution

- sagemaker

- même

- Épargnez

- économie

- évolutive

- Escaliers intérieurs

- Sciences

- sur une base scientifique

- scientifiques

- Sdk

- SDK

- de façon transparente

- Rechercher

- recherches

- recherche

- Deuxièmement

- les sections

- sur le lien

- recherche

- apparemment

- sémantique

- supérieur

- sensible

- phrase

- besoin

- serveur

- service

- Prestataire de services

- Services

- service

- set

- Paramétres

- plusieurs

- Partager

- commun

- Spectacles

- significative

- de façon significative

- étapes

- siège

- Taille

- tailles

- smart

- Logiciels

- développement de logiciels

- sur mesure

- Solutions

- chanson

- Identifier

- enjambant

- spécialise

- spécialisation

- groupe de neurones

- vitesse

- ÉPELER

- orthographe

- dépensé

- empiler

- Commencez

- Startups

- rester

- stable

- étapes

- Étapes

- Histoire

- streaming

- tel

- haut

- Support

- Appareils

- sûr

- tâches

- prise

- ciblage

- équipe

- technologie

- Technique

- technique

- techniques

- Les technologies

- Technologie

- texte

- qui

- Le

- leur

- Les

- Là.

- donc

- Ces

- l'ont

- des choses

- this

- Avec

- débit

- fiable

- fois

- Titre

- à

- ensemble

- tokenization

- Tokens

- a

- outil

- top

- tps

- circulation

- Train

- qualifié

- Formation

- transformateur

- Trends

- Triton

- oui

- deux

- compréhension

- indubitablement

- Univers

- déverrouillage

- dévoilé

- us

- utilisé

- d'utiliser

- utilisateurs

- Usages

- en utilisant

- Utilisant

- Plus-value

- Vaste

- la versatilité

- très

- Attendre

- marcher

- Walmart

- était

- personne(s) regarde(nt) cette fiche produit

- façons

- we

- web

- services Web

- WELL

- ont été

- quand

- Les

- tout en

- sera

- comprenant

- activités principales

- travaillé

- de travail

- vos contrats

- world

- s'inquiéter

- encore

- a abouti

- Vous n'avez

- Votre

- zéphyrnet