Introduction

Les voitures et les avions sans conducteur ne sont plus l’affaire du futur. Rien que dans la ville de San Francisco, deux compagnies de taxi ont parcouru collectivement 8 millions de kilomètres de conduite autonome jusqu'en août 2023. Et plus de 850,000 XNUMX véhicules aériens autonomes, ou drones, sont immatriculés aux États-Unis, sans compter ceux appartenant à l'armée.

Mais il existe des inquiétudes légitimes concernant la sécurité. Par exemple, sur une période de 10 mois terminée en mai 2022, la National Highway Traffic Safety Administration rapporté près de 400 accidents impliquant des automobiles utilisant une forme de contrôle autonome. Six personnes sont mortes des suites de ces accidents et cinq ont été grièvement blessées.

La manière habituelle de résoudre ce problème – parfois appelée « test par épuisement » – consiste à tester ces systèmes jusqu’à ce que vous soyez convaincu qu’ils sont sûrs. Mais vous ne pouvez jamais être sûr que ce processus révélera toutes les failles potentielles. "Les gens effectuent des tests jusqu'à épuisement de leurs ressources et de leur patience", a déclaré Saïan Mitra, informaticien à l'Université de l'Illinois, Urbana-Champaign. Toutefois, les tests à eux seuls ne peuvent pas fournir de garanties.

Mitra et ses collègues le peuvent. Son équipe a réussi à prouver le sécurité de capacités de suivi de voie pour les voitures et systèmes d'atterrissage pour les avions autonomes. Leur stratégie est désormais utilisée pour aider à faire atterrir des drones sur des porte-avions, et Boeing prévoit de la tester sur un avion expérimental cette année. « Leur méthode pour fournir des garanties de sécurité de bout en bout est très importante », a déclaré Corina Pasareanu, chercheur scientifique à l’Université Carnegie Mellon et au centre de recherche Ames de la NASA.

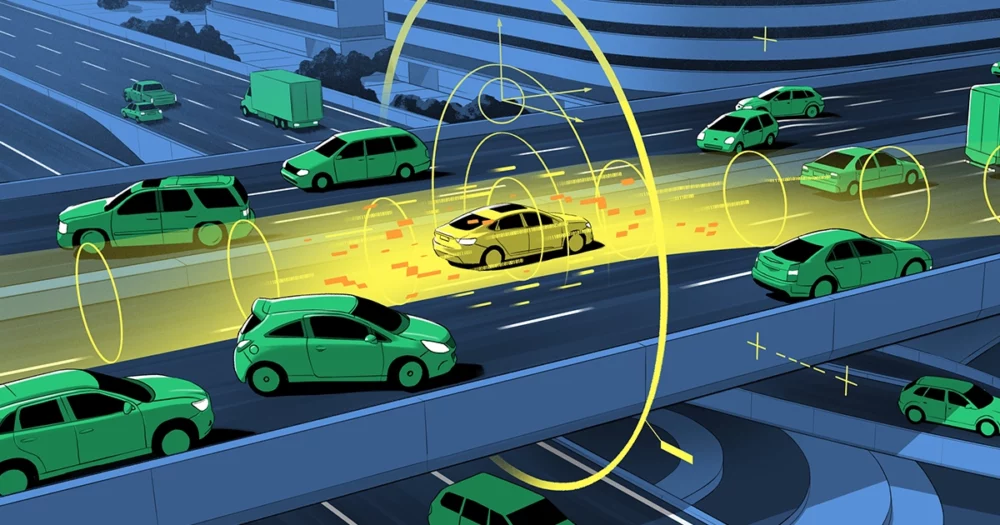

Leur travail consiste à garantir les résultats des algorithmes d’apprentissage automatique utilisés pour informer les véhicules autonomes. À un niveau élevé, de nombreux véhicules autonomes comportent deux composants : un système de perception et un système de contrôle. Le système de perception vous indique, par exemple, à quelle distance se trouve votre voiture du centre de la voie, ou dans quelle direction se dirige un avion et quel est son angle par rapport à l'horizon. Le système fonctionne en transmettant les données brutes des caméras et autres outils sensoriels aux algorithmes d’apprentissage automatique basés sur des réseaux neuronaux, qui recréent l’environnement à l’extérieur du véhicule.

Ces évaluations sont ensuite envoyées à un système distinct, le module de contrôle, qui décide quoi faire. S’il y a un obstacle imminent, par exemple, il décide d’appliquer les freins ou de le contourner. Selon Luca Carlone, professeur agrégé au Massachusetts Institute of Technology, même si le module de contrôle s'appuie sur une technologie bien établie, "il prend des décisions basées sur les résultats de la perception, et il n'y a aucune garantie que ces résultats soient corrects".

Pour offrir une garantie de sécurité, l’équipe de Mitra a travaillé sur la fiabilité du système de perception du véhicule. Ils ont d’abord supposé qu’il était possible de garantir la sécurité lorsqu’un rendu parfait du monde extérieur était disponible. Ils ont ensuite déterminé le degré d’erreur que le système de perception introduisait dans sa recréation de l’environnement du véhicule.

La clé de cette stratégie est de quantifier les incertitudes impliquées, connues sous le nom de bande d’erreur – ou les « inconnues connues », comme le dit Mitra. Ce calcul provient de ce que lui et son équipe appellent un contrat de perception. En génie logiciel, un contrat est un engagement selon lequel, pour une entrée donnée dans un programme informatique, le résultat se situera dans une plage spécifiée. Déterminer cette gamme n’est pas facile. Quelle est la précision des capteurs de la voiture ? Quelle quantité de brouillard, de pluie ou d’éblouissement solaire un drone peut-il tolérer ? Mais si vous parvenez à maintenir le véhicule dans une plage d’incertitude spécifiée et si la détermination de cette plage est suffisamment précise, l’équipe de Mitra a prouvé que vous pouvez garantir sa sécurité.

Introduction

C’est une situation familière pour quiconque possède un compteur de vitesse imprécis. Si vous savez que l'appareil ne s'éteint jamais à plus de 5 km/h, vous pouvez toujours éviter les excès de vitesse en restant toujours à 5 km/h en dessous de la limite de vitesse (comme l'indique votre compteur de vitesse peu fiable). Un contrat de perception offre une garantie similaire quant à la sécurité d’un système imparfait dépendant de l’apprentissage automatique.

"Vous n'avez pas besoin d'une perception parfaite", a déclaré Carlone. « Vous voulez juste que ce soit suffisamment bon pour ne pas mettre la sécurité en danger. » Les plus grandes contributions de l’équipe, a-t-il déclaré, consistent à « introduire l’idée générale des contrats de perception » et à fournir les méthodes permettant de les construire. Pour ce faire, ils ont utilisé des techniques issues de la branche informatique appelée vérification formelle, qui fournissent un moyen mathématique de confirmer que le comportement d'un système satisfait à un ensemble d'exigences.

"Même si nous ne savons pas exactement comment le réseau neuronal fait ce qu'il fait", a déclaré Mitra, ils ont montré qu'il est toujours possible de prouver numériquement que l'incertitude de la sortie d'un réseau neuronal se situe dans certaines limites. Et si tel est le cas, le système sera sécurisé. "Nous pouvons alors fournir une garantie statistique quant à savoir si (et dans quelle mesure) un réseau neuronal donné respectera réellement ces limites."

L'entreprise aérospatiale Sierra Nevada teste actuellement ces garanties de sécurité lors de l'atterrissage d'un drone sur un porte-avions. Ce problème est à certains égards plus compliqué que celui de conduire une voiture en raison de la dimension supplémentaire impliquée par le vol. "Lors de l'atterrissage, il y a deux tâches principales", a déclaré Dragos Margineantu, technologue en chef de l'IA chez Boeing, « en alignant l'avion avec la piste et en s'assurant que la piste est exempte d'obstacles. Notre travail avec Sayan consiste à obtenir des garanties pour ces deux fonctions.

"Les simulations utilisant l'algorithme de Sayan montrent que l'alignement [d'un avion avant l'atterrissage] s'améliore", a-t-il déclaré. La prochaine étape, prévue plus tard cette année, consiste à utiliser ces systèmes lors de l'atterrissage d'un avion expérimental Boeing. L’un des plus grands défis, a noté Margineantu, sera de comprendre ce que nous ne savons pas – « déterminer l’incertitude de nos estimations » – et de voir comment cela affecte la sécurité. "La plupart des erreurs se produisent lorsque nous faisons des choses que nous pensons connaître – et il s'avère que ce n'est pas le cas."

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.quantamagazine.org/how-to-guarantee-the-safety-of-autonomous-vehicles-20240116/

- :possède

- :est

- :ne pas

- ][p

- 000

- 2022

- 2023

- 400

- 8

- a

- A Propos

- accidents

- Selon

- Avec cette connaissance vient le pouvoir de prendre

- ACM

- actually

- adresser

- administration

- Industrie aerospatiale

- AI

- avion

- algorithme

- algorithmes

- alignement

- Tous

- seul

- toujours

- an

- et les

- chacun.e

- Appliquer

- SONT

- autour

- AS

- évaluations

- Associé(e)

- assumé

- At

- Août

- autonome

- véhicules autonomes

- disponibles

- éviter

- BANDE

- basé

- BE

- car

- humain

- va

- ci-dessous

- Le plus grand

- Boeing

- bornes

- Branche

- mais

- by

- calcul

- Appelez-nous

- appelé

- de CAMÉRAS de surveillance

- CAN

- ne peut pas

- capacités

- fournisseur

- Carnegie Mellon

- transporteurs

- porter

- voitures

- maisons

- Canaux centraux

- certaines

- globaux

- chef

- Ville

- collègues

- collectivement

- vient

- engagement

- Sociétés

- Société

- compliqué

- composants électriques

- ordinateur

- Informatique

- Préoccupations

- la construction

- contrat

- contributions

- des bactéries

- correct

- compte

- Lecture

- données

- décisions

- Degré

- dépend

- détermination

- déterminé

- dispositif

- DID

- mort

- Dimension

- direction

- do

- Ne pas

- dessin

- conduite

- Drone

- Drones

- Easy

- end-to-end

- terminé

- ENGINEERING

- assez

- assurer

- assurer

- Tout

- Environment

- erreur

- Erreurs

- exactement

- exemple

- expérimental

- supplémentaire

- Automne

- familier

- loin

- alimentation

- Prénom

- cinq

- défauts

- vol

- Brouillard

- Pour

- formulaire

- formel

- Francisco

- gratuitement ici

- De

- fonctions

- avenir

- obtention

- donné

- Bien

- guarantir

- garantit

- arriver

- Vous avez

- he

- Titre

- vous aider

- Haute

- Autoroute

- sa

- horizon

- heure

- Comment

- How To

- Cependant

- HTML

- HTTPS

- idée

- IEEE

- if

- Illinois

- important

- améliorer

- in

- indiqué

- informer

- contribution

- instance

- Institut

- développement

- Introduit

- impliqué

- impliquant

- aide

- IT

- SES

- juste

- XNUMX éléments à

- ACTIVITES

- Savoir

- connu

- Transport routier

- atterrissage

- Voie

- plus tard

- apprentissage

- légitime

- Niveau

- se trouve

- LIMIT

- Connecté

- plus long

- click

- machine learning

- magazine

- Entrée

- Fabrication

- gérés

- de nombreuses

- Massachusetts

- Massachusetts Institute of Technology

- mathématique

- Mai..

- Découvrez

- Mellon

- méthode

- méthodes

- Militaire

- million

- MIT

- Module

- PLUS

- beaucoup

- Nationales

- presque

- Besoin

- réseau et

- réseaux

- neural

- Réseau neuronal

- les réseaux de neurones

- NEVADA

- n'allons jamais

- next

- aucune

- noté

- maintenant

- obstacle

- obstacles

- of

- de rabais

- on

- ONE

- exploite

- or

- Autre

- nos

- ande

- sortie

- au contrôle

- propriété

- Patience

- Personnes

- /

- perception

- parfaite

- période

- avion

- prévu

- plans

- Platon

- Intelligence des données Platon

- PlatonDonnées

- possible

- défaillances

- Avant

- Problème

- processus

- Professeur

- Programme

- Prouver

- prouvé

- fournir

- fournit

- aportando

- mettre

- PLUIE

- gamme

- raw

- inscrit

- fiabilité

- rendu

- Exigences

- un article

- Resources

- respect

- résultat

- Résultats

- Analyse

- piste

- des

- Sécurité

- Saïd

- San

- San Francisco

- satisfait

- Sciences

- Scientifique

- voir

- capteur

- envoyé

- séparé

- dangereux

- set

- montrer

- montré

- similaires

- situation

- SIX

- So

- Logiciels

- génie logiciel

- solaire

- quelques

- parfois

- spécifié

- vitesse

- États

- statistique

- rester

- diriger

- étapes

- Encore

- de Marketing

- sûr

- combustion propre

- Système

- tâches

- équipe

- techniques

- technologue

- Technologie

- raconte

- tester

- Essais

- tests

- que

- qui

- Le

- El futuro

- leur

- Les

- puis

- Là.

- Ces

- l'ont

- des choses

- penser

- this

- cette année

- ceux

- bien que?

- Avec

- à

- les outils

- circulation

- se tourne

- deux

- incertitudes

- Incertitude

- devoiler

- Uni

- États-Unis

- université

- jusqu'à

- prochain

- d'utiliser

- en utilisant

- habituel

- véhicule

- Véhicules

- Vérification

- très

- souhaitez

- Façon..

- façons

- we

- webp

- ont été

- Quoi

- quand

- que

- qui

- tout en

- sera

- comprenant

- dans les

- activités principales

- travaillé

- world

- an

- Vous n'avez

- Votre

- zéphyrnet