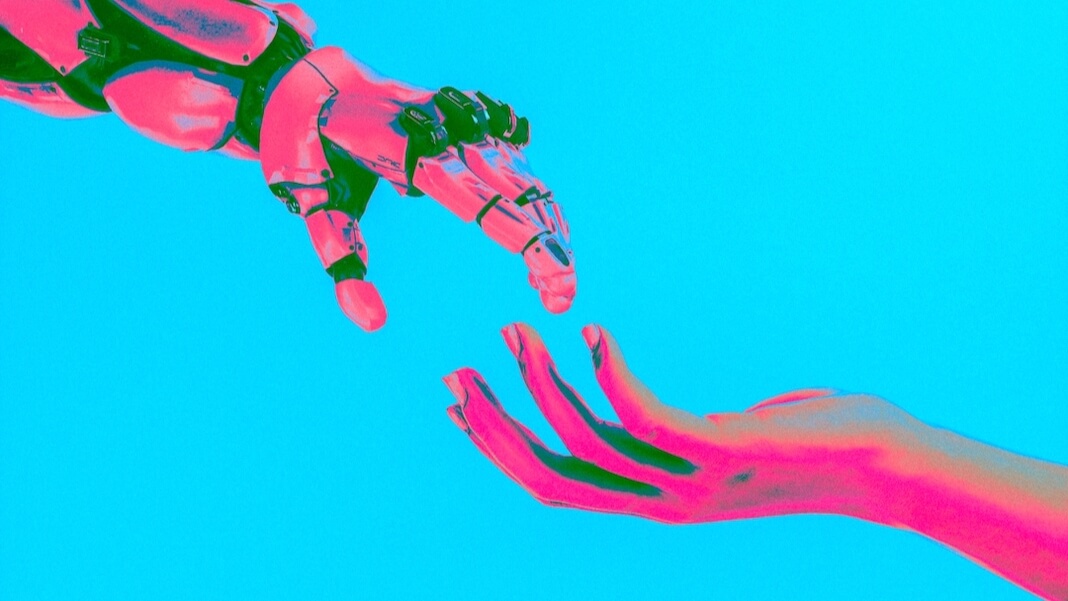

intelligence artificielle a progressé si rapidement que même certains des scientifiques responsables de nombreux développements clés sont troublés par le rythme du changement. Plus tôt cette année, plus de 300 professionnels travaillant dans l'IA et d'autres personnalités publiques concernées ont publié un avertissement brutal sur le danger que représente la technologie, comparant le risque à celui de pandémies ou de guerre nucléaire.

Juste sous la surface de ces préoccupations se cache la question de la conscience de la machine. Même s'il n'y a « personne à la maison » à l'intérieur des IA d'aujourd'hui, certains chercheurs se demandent si elles pourraient un jour montrer une lueur de conscience, ou plus. Si cela se produit, cela soulèvera une foule de préoccupations morales et éthiques, dit Jonathan Bouleau, professeur de philosophie à la London School of Economics and Political Science.

Alors que la technologie de l'IA progresse, les questions éthiques suscitées par les interactions homme-IA ont pris une nouvelle urgence. "Nous ne savons pas s'il faut les intégrer à notre cercle moral ou les exclure", a déclaré Birch. « Nous ne savons pas quelles seront les conséquences. Et je prends cela au sérieux comme un risque réel dont nous devrions commencer à parler. Pas vraiment parce que je pense ChatGPT est dans cette catégorie, mais parce que je ne sais pas ce qui va se passer dans les 10 ou 20 prochaines années.

En attendant, dit-il, nous ferions bien d'étudier d'autres esprits non humains, comme ceux des animaux. Birch dirige l'université Projet Fondements de la Sentience Animale, un effort financé par l'Union européenne qui "vise à essayer de faire des progrès sur les grandes questions de la sensibilité animale", comme l'a dit Birch. « Comment pouvons-nous développer de meilleures méthodes pour étudier scientifiquement les expériences conscientes des animaux ? Et comment pouvons-nous mettre la science émergente de la sensibilité animale au travail, pour concevoir de meilleures politiques, lois et façons de prendre soin des animaux ? »

Notre entretien a été réalisé sur Zoom et par e-mail, et a été modifié pour plus de longueur et de clarté.

(Cet article a été publié initialement le Undark. Lis le article original.)

Non sombre : Il y a eu un débat en cours sur la question de savoir si l'IA peut être consciente ou sensible. Et il semble y avoir une question parallèle de savoir si l'IA peut sembler être sensible. Pourquoi cette distinction est-elle si importante ?

Jonathan Bouleau : Je pense que c'est un énorme problème, et quelque chose qui devrait nous faire peur, en fait. Même maintenant, les systèmes d'IA sont tout à fait capables de convaincre leurs utilisateurs de leur sensibilité. On l'a vu l'année dernière avec le cas de Blake Lemoine, l'ingénieur de Google qui est devenu convaincu que le système sur lequel il travaillait était sensible - et c'est juste lorsque la sortie est purement textuelle et que l'utilisateur est un expert hautement qualifié en IA.

Imaginez donc une situation où l'IA est capable de contrôler un visage humain et une voix humaine et l'utilisateur est inexpérimenté. Je pense que l'IA est déjà dans une position où elle peut convaincre assez facilement un grand nombre de personnes qu'elle est un être sensible. Et c'est un gros problème, parce que je pense que nous allons commencer à voir des gens faire campagne pour le bien-être de l'IA, Droits de l'IA, et des choses dans le genre.

Et nous ne saurons pas quoi faire à ce sujet. Parce que ce que nous aimerions, c'est un argument de renversement très fort qui prouve que les systèmes d'IA dont ils parlent sont ne sauraient conscient. Et nous n'avons pas cela. Notre compréhension théorique de la conscience n'est pas suffisamment mûre pour nous permettre de déclarer avec confiance son absence.

UD : Un robot ou un système d'IA pourrait être programmé pour dire quelque chose comme : "Arrête ça, tu me fais mal." Mais une simple déclaration de ce genre n'est pas suffisante pour servir de test décisif pour la sensibilité, n'est-ce pas ?

JB : Vous pouvez avoir des systèmes très simples [comme ceux] développés à l'Imperial College de Londres pour aider les médecins dans leur formation qui imiter les expressions de la douleur humaine. Et il n'y a absolument aucune raison de penser que ces systèmes sont sensibles. Ils ne ressentent pas vraiment de douleur; tout ce qu'ils font est de mapper les entrées aux sorties d'une manière très simple. Mais les expressions de douleur qu'ils produisent sont assez réalistes.

Je pense que nous sommes dans une position quelque peu similaire avec des chatbots comme ChatGPT - ils sont entraînés sur plus d'un billion de mots de données d'entraînement pour imiter les schémas de réponse d'un humain pour répondre d'une manière qu'un humain répondrait.

Donc, bien sûr, si vous lui donnez une invite à laquelle un humain répondrait en faisant une expression de douleur, il sera capable d'imiter habilement cette réponse.

Mais je pense que lorsque nous savons que c'est la situation - lorsque nous savons que nous avons affaire à un mimétisme habile - il n'y a aucune raison valable de penser qu'il y a une réelle douleur derrière cela.

UD : Cette entité sur laquelle les étudiants en médecine s'entraînent, je suppose que c'est quelque chose comme un robot ?

JB : C'est vrai, oui. Donc, ils ont une chose ressemblant à un mannequin, avec un visage humain, et le médecin est capable d'appuyer sur le bras et d'obtenir une expression imitant les expressions que les humains donneraient pour différents degrés de pression. Il s'agit d'aider les médecins à apprendre à appliquer les techniques aux patients de manière appropriée sans causer trop de douleur.

Et nous sommes très facilement dupes dès que quelque chose a un visage humain et fait des expressions comme le ferait un humain, même s'il n'y a aucune véritable intelligence derrière cela.

Donc, si vous imaginez qu'être jumelé avec le type d'IA que nous voyons dans ChatGPT, vous avez une sorte de mimétisme qui est vraiment très convaincant, et qui convaincra beaucoup de gens.

UD : La sensibilité semble être quelque chose que nous connaissons de l'intérieur, pour ainsi dire. Nous comprenons notre propre sensibilité, mais comment testeriez-vous la sensibilité des autres, qu'il s'agisse d'une IA ou de toute autre entité au-delà de vous-même ?

JB : Je pense que nous sommes dans une position très forte avec d'autres humains, qui peuvent nous parler, parce que nous avons là un corpus de preuves incroyablement riche. Et la meilleure explication à cela est que les autres humains ont des expériences conscientes, tout comme nous. Et nous pouvons donc utiliser ce type d'inférence que les philosophes appellent parfois "l'inférence à la meilleure explication".

Je pense que nous pouvons aborder le sujet des autres animaux exactement de la même manière - que les autres animaux ne nous parlent pas, mais qu'ils affichent des comportements qui s'expliquent très naturellement en attribuant des états comme la douleur. Par exemple, si vous voyez un chien lécher ses plaies après une blessure, soigner cette zone, apprendre à éviter les endroits où il risque de se blesser, vous expliquerez naturellement ce comportement en postulant un état de douleur.

Et je pense que lorsque nous avons affaire à d'autres animaux qui ont des systèmes nerveux assez similaires au nôtre, et qui ont évolué comme nous, je pense que ce genre d'inférence est tout à fait raisonnable.

UD : Qu'en est-il d'un système d'IA ?

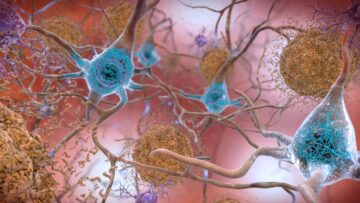

JB : Dans le cas de l'IA, nous avons un énorme problème. Nous avons tout d'abord le problème que substrat est différent. Nous ne savons pas vraiment si l'expérience consciente est sensible au substrat - doit-elle avoir un substrat biologique, c'est-à-dire un système nerveux, un cerveau ? Ou est-ce quelque chose qui peut être réalisé dans un matériau totalement différent - un substrat à base de silicium ?

Mais il y a aussi le problème que j'ai appelé le « problème du jeu » : lorsque le système a accès à des milliards de mots de données d'entraînement et a été entraîné dans le but d'imiter le comportement humain, les types de modèles de comportement qu'il produit pourraient s'expliquer par le fait d'avoir véritablement l'expérience consciente. Ou, alternativement, ils pourraient simplement s'expliquer par le fait que l'objectif est de se comporter comme un humain réagirait dans cette situation.

Je pense donc vraiment que nous avons des problèmes dans le cas de l'IA, car il est peu probable que nous nous retrouvions dans une position où c'est clairement la meilleure explication de ce que nous voyons - que l'IA soit consciente. Il y aura toujours des explications alternatives plausibles. Et c'est une impasse très difficile à sortir.

UD : Selon vous, qu'est-ce qui pourrait être notre meilleur pari pour faire la distinction entre quelque chose qui est réellement conscient et une entité qui a juste le apparence de sensibilité ?

JB : Je pense que la première étape consiste à reconnaître qu'il s'agit d'un problème très profond et difficile. La deuxième étape consiste à essayer d'apprendre le plus possible du cas d'autres animaux. Je pense que lorsque nous étudions des animaux qui sont assez proches de nous, en termes d'évolution, comme les chiens et d'autres mammifères, nous ne savons toujours pas si l'expérience consciente pourrait dépendre de mécanismes cérébraux très spécifiques qui sont distinctifs du cerveau des mammifères.

Pour dépasser cela, nous devons examiner un éventail d'animaux aussi large que possible. Et nous devons penser en particulier aux invertébrés, comme les pieuvres et les insectes, où il s'agit potentiellement d'un autre exemple d'expérience consciente évolué indépendamment. Tout comme l'œil d'une pieuvre a évolué complètement séparément de nos propres yeux - il a ce mélange fascinant de similitudes et de différences - je pense que ses expériences conscientes seront également comme ça : évolué indépendamment, similaire à certains égards, très, très différent dans d'autres moyens.

Et en étudiant les expériences d'invertébrés comme les pieuvres, nous pouvons commencer à comprendre quelles sont les caractéristiques vraiment profondes qu'un cerveau doit avoir pour soutenir des expériences conscientes, des choses qui vont plus loin que d'avoir simplement ces structures cérébrales spécifiques qui sont là chez les mammifères. Quels types de calcul sont nécessaires ? Quels types de traitement ?

Ensuite, et je vois cela comme une stratégie à long terme, nous pourrons peut-être revenir au cas de l'IA et dire, eh bien, a-t-elle ces types spéciaux de calcul que nous trouvons chez les animaux conscients comme les mammifères et les pieuvres ?

UD : Croyez-vous que nous créerons un jour une IA sensible ?

JB : Je suis à environ 50:50 là-dessus. Il est possible que la sensibilité dépende de caractéristiques spéciales d'un cerveau biologique, et il n'est pas clair comment tester si c'est le cas. Je pense donc qu'il y aura toujours une incertitude substantielle dans l'IA. Je suis plus confiant à ce sujet : si la conscience peut en principe être réalisé dans un logiciel informatique, alors les chercheurs en IA trouveront un moyen de le faire.

Crédit image: Trésorerie Macanaya / Unsplash

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://singularityhub.com/2023/07/17/studying-animal-sentience-could-help-solve-the-ethical-puzzle-of-sentient-ai/

- :possède

- :est

- :ne pas

- :où

- $UP

- 10

- 20

- 20 ans

- 50

- a

- Capable

- A Propos

- absolument

- AC

- accès

- atteint

- présenter

- actually

- peur

- Après

- AI

- Tous

- permettre

- déjà

- aussi

- alternative

- toujours

- am

- an

- et de

- animal

- animaux

- Une autre

- tous

- une approche

- de manière appropriée

- SONT

- Réservé

- argument

- BRAS

- article

- AS

- At

- éviter

- RETOUR

- bbc

- BE

- car

- était

- humain

- comportements

- derrière

- va

- CROYONS

- ci-dessous

- LES MEILLEURS

- Pari

- Améliorée

- jusqu'à XNUMX fois

- Au-delà

- Big

- lier

- Mélangeurs Spéciaux

- corps

- Cerveau

- apporter

- mais

- by

- Appelez-nous

- appelé

- faire campagne

- CAN

- capable

- porter

- maisons

- Catégories

- causer

- Chance

- Change

- Chatbots

- ChatGPT

- Réseautage et Mentorat

- clarté

- clair

- clairement

- Fermer

- Université

- comparant

- complètement

- calcul

- ordinateur

- concerné

- Préoccupations

- menée

- confiance

- avec confiance

- conscient

- Conscience

- Conséquences

- des bactéries

- convaincre

- pourriez

- Cours

- engendrent

- crédit

- DANGER

- données

- journée

- traitement

- débat

- profond

- profond

- dépend

- Conception

- développer

- développé

- développements

- différent

- difficile

- Commande

- distinction

- distinctif

- do

- Docteur

- Docteur

- Chien

- faire

- Ne pas

- Plus tôt

- même

- Économie

- Edge

- effort

- économies émergentes.

- ingénieur

- assez

- entièrement

- entité

- éthique

- du

- Pourtant, la

- preuve

- évolué

- exactement

- exemple

- exposer

- d'experience

- Expériences

- expert

- Expliquer

- expliqué

- explication

- expression

- expressions

- œil

- Visage

- fascinant

- Fonctionnalités:

- Figures

- Trouvez

- Prénom

- Pour

- Avant

- De

- véritable

- obtenez

- Donner

- Go

- objectif

- aller

- arriver

- arrive

- Vous avez

- ayant

- he

- aider

- très

- Comment

- How To

- HTTPS

- majeur

- humain

- Les êtres humains

- i

- if

- image

- Imperial

- Imperial College

- Imperial College London

- important

- in

- Dans d'autres

- incroyablement

- indépendamment

- entrées

- à l'intérieur

- instance

- Intelligence

- interactions

- Interview

- développement

- Publié

- IT

- SES

- juste

- ACTIVITES

- Genre

- Savoir

- gros

- Nom

- L'année dernière

- Lois

- Conduit

- sauts

- APPRENTISSAGE

- apprentissage

- à gauche

- Longueur

- léchage

- comme

- London

- Location

- Style

- Lot

- LSE

- click

- a prendre une

- FAIT DU

- Fabrication

- de nombreuses

- cartographie

- mature

- Mai..

- me

- entre-temps

- mécanismes

- médical

- méthodes

- pourrait

- moral

- PLUS

- beaucoup

- Nature

- Besoin

- nécessaire

- Nouveauté

- next

- aucune

- maintenant

- nucléaire

- numéros

- of

- on

- ONE

- en cours

- or

- de commander

- initialement

- Autre

- Autres

- nos

- nous-mêmes

- ande

- sortie

- plus de

- propre

- Rythme

- Pain

- apparié

- Pandémies

- Parallèle

- particulier

- passé

- patients

- Patron de Couture

- motifs

- Personnes

- philosophie

- Des endroits

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plausible

- politiques

- politique

- pose

- position

- l'éventualité

- Press

- la parfaite pression

- Problème

- traitement

- produire

- produit

- ,une équipe de professionnels qualifiés

- Professeur

- programmé

- Progrès

- progressé

- Prouve

- public

- publié

- purement

- mettre

- puzzle

- question

- fréquemment posées

- augmenter

- gamme

- rapidement

- Lire

- réal

- vraiment

- raison

- raisonnable

- reconnaître

- chercheurs

- Réagir

- réponse

- responsables

- Rich

- bon

- Analyse

- systèmes de robot

- Saïd

- même

- scie

- dire

- dit

- L'école

- Sciences

- scientifiques

- Deuxièmement

- sur le lien

- semble

- sensible

- dangereux

- besoin

- set

- devrait

- similaires

- similitudes

- étapes

- situation

- qualifié

- So

- Logiciels

- RÉSOUDRE

- quelques

- quelque chose

- quelque peu

- Bientôt

- suscité

- parler

- spécial

- groupe de neurones

- Étape

- Commencer

- Région

- États

- de Marketing

- STRONG

- Étudiante

- Étude

- Étudier

- Ces

- Support

- Surface

- combustion propre

- Système

- Prenez

- tâches

- discutons-en

- parlant

- techniques

- Technologie

- conditions

- tester

- que

- qui

- La

- leur

- Les

- puis

- théorique

- Là.

- Ces

- l'ont

- chose

- des choses

- penser

- En pensant

- this

- cette année

- ceux

- Avec

- à

- aujourd'hui

- trop

- sujet

- TOTALEMENT

- qualifié

- Formation

- Billion

- trillions

- difficulté

- Essai

- Incertitude

- comprendre

- compréhension

- improbable

- urgence

- us

- utilisé

- Utilisateur

- utilisateurs

- Versus

- très

- Voix

- guerre

- était

- Façon..

- façons

- we

- Welfare

- WELL

- Quoi

- quand

- que

- qui

- WHO

- why

- large

- sera

- comprenant

- sans

- des mots

- activités principales

- de travail

- pourra

- donnerait

- blessures

- an

- années

- Oui

- Vous n'avez

- zéphyrnet

- zoom