J'étais à un événement « tout ce qui concerne l'analyse comparative des données et des analyses » la semaine dernière. C'était fabuleux, la plupart des grandes banques étaient représentées, ainsi que les fonds spéculatifs les plus en vogue, un grand nombre de bourses et certains vendeurs inhabituels.

J'ai trouvé cela rafraîchissant, comme la plupart des événements où des analyses tangibles sont discutées. Mon début de carrière était axé sur la quantification, la science des données et l'analyse, mais maintenant je suis dans le, hum,

La profession de « données », qui est composée d'un éventail confus de produits (pour la plupart) commerciaux qui sous-tendent les infrastructures « entrepôts de données », « lacs de données » et « maillage de données », « structure de données », « marais de données », s'élevant à $ des milliards de dollars de dépenses et le maintien de certaines très grandes organisations. Personnellement, je trouve le langage, le jargon et l'écosystème de cette industrie abstraits de la réalité, mais ils aident les fournisseurs commerciaux à proposer des produits et des catégories joliment nommés. Suivez l'argent, comme on dit : une plate-forme de données « complexe » coûte beaucoup plus cher qu'un outil de modélisation que n'importe quel étudiant du MSC peut utiliser.

L’industrie des données était à l’origine de cet événement très pragmatique, mais elle a été discutée de manière agréable et explicite lors d’un panel sur ce que l’on appelle «lignage de données.» Le lignage des données est principalement un processus linéaire séquentiel qui capture la transformation des données de l'ingestion à l'utilisation et contribue à soutenir ce que l'on appelle la gouvernance des données, qui génère une multitude d'outils d'entrepôt coûteux. À l’ère du cloud, les entrepôts de données cloud font fureur, un en particulier. Mais voici le problème. La transformation des données n'est en réalité pas linéaire, surtout lorsqu'elle est utile. C’est complexe, cyclique, se transformant comme Doctor Who et les Tardis, voyageant à travers le temps et à travers les galaxies. Mis à part la pseudo-philosophie et la physique populaire, en finance, les mêmes données, une fois peaufinées, transformées et analysées, peuvent servir à de nombreux cas d'utilisation différents, également dans le temps et dans l'espace. De plus, les régulateurs nous demandent de documenter les changements, en étant transparents sur ce que nous avons fait, quand, pourquoi et ce qui a changé. Vous pourriez dire : « c’est la gouvernance des données qu’ils demandent ». Type de. Mais les régulateurs demandent en réalité de rendre compte des décisions concrètes qui nécessitent des modèles, un engagement et aboutissent à des actions qui ont un impact. Cela implique des personnes, des décisions et des cas d’utilisation tangibles, pas seulement des données.

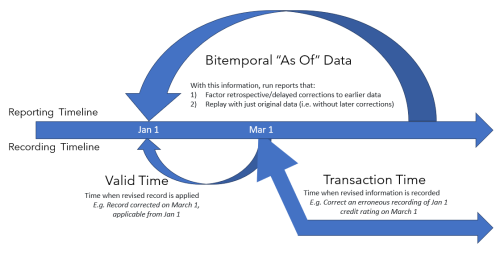

La table ronde a introduit et discuté longuement le concept de bitemporalité, une tactique pratique de gestion des données qui répond parfaitement aux cas d'utilisation financière et aux processus réglementaires. Un panéliste d’une banque de niveau 1 (très) réglementée a loué avec effusion la bitemporalité. Son architecture utilisait la bitemporalité pour s'ajuster dans le temps et rejouer les modifications des données. Supposons que vous souhaitiez recréer un ancien rapport financier ou une transaction sur produits dérivés tel qu'il se présentait au moment de sa création, puis tel qu'il aurait dû apparaître compte tenu des corrections/ajouts/remboursements ultérieurs, par exemple dans un rapport de conformité. Avec la bitemporalité dans son cas, une seule source de données informe plusieurs vues (validées) des données, au moment où elles se produisent et plus tard, avec « sagesse ». C’est simple à mettre en œuvre, peu coûteux, et voici ce que vous devez savoir à ce sujet.

- Un modèle de données doit stocker et faciliter l'analyse des données sur deux dimensions temporelles : un modèle de données bitemporel, c'est-à-dire un modèle prenant en compte les données au début et à tout moment dans le futur lorsque des révisions de leur état se produisent et peut être représenté « comme -de” un temps donné.

- Ce modèle stocke plusieurs horodatages pour chaque propriété, objet et valeur.

- Les points de données peuvent être joints et connectés – une jointure « à partir de »

Dans une architecture de type entrepôt de données traditionnelle, un tel lignage peut entraîner des copies de données coûteuses, ainsi que des inefficacités et des complexités de récupération intempestives. C'est une façon pour les fournisseurs d'entrepôts de données cloud de gagner de l'argent, en gérant plusieurs copies de données, une approche brutale.

Une alternative simple consiste simplement à de simples modèles de données avec un processus de stockage/en mémoire pris en charge. Cela peut et doit être bon marché, centré sur Python. Utilisez simplement des horodatages (avec vos données) et des jointures à partir de (dans le code) pour simplifier le processus, avec la possibilité d'approfondir les enregistrements individuels si nécessaire.

Pour réduire les coûts sur votre entrepôt de données, concevez avec du Python simple, en prêtant attention aux performances en mémoire. Il est moins nécessaire de recourir à l’ingénierie au sein d’un processus coûteux d’entrepôt de données.

Où utilisez-vous la bitemporalité en finance ? Eh bien, la conformité est un cas évident. Prends pour exemple

spoofing. Aujourd’hui, l’usurpation d’identité est au fond un modèle d’intention commerciale, bien que frauduleux, dans lequel des types particuliers de transactions sont effectuées mais ne sont pas suivies d’effet. La raison des usurpations approfondies est avant tout la conformité, mais le schéma des transactions approfondies, réussies, infructueuses, frauduleuses ou tout simplement géniales, profite également au front office. Cela éclaire à son tour les back-testings et l’élaboration de stratégies, qui peuvent également inclure des notions de temps. En effet, les stratégies, lorsqu’elles entrent dans les systèmes de trading de production, de risque ou de gestion de portefeuille, ne savent que ce qui les attend, mais le back-test peut essayer d’incorporer des hypothèses connues pour atténuer les risques. Les exemples incluent la comparaison des coûts de transaction à court terme par rapport aux coûts estimés, la comparaison des corrélations de paires réelles et anticipées à court terme, les gains à moyen terme pour, par exemple, les produits dérivés et les instruments à revenu fixe, les dividendes sur les actions, les corrélations actions/secteurs dans la gestion de portefeuille, et les régimes de marché/risques « macro » à plus long terme, appréciés des économistes. Le temps – et la bitemporalité – comptent. Les cas d’utilisation concernés rendent la technique bien plus précieuse qu’une simple manœuvre d’ingénierie des données.

Au-delà des marchés de capitaux, pensez aux paiements. Par exemple, les actions sur un appareil de paiement signaleront les transactions de manière centralisée. Ce qui est connu au moment de la transaction est ensuite mis à jour par des informations, par exemple celles du client. La détection de la fraude est un cas d’utilisation évident à cet égard, et elle doit être effectuée en temps opportun. Les données de paiement intelligent sont traitées à un moment donné, mais ajustées pour améliorer la qualité des données et informer les événements en aval. L'utilisation d'un modèle de données bitemporel sur les données principales et les séries chronologiques permet de gérer les activités à un moment donné.

En conclusion, ce qui peut potentiellement être une transformation linéaire et coûteuse de la lignée d’entrepôts « hautement gouvernée » peut être simplifiée grâce à des analyses de bon sens et à une empathie avec les cas d’utilisation du monde réel. La bitemporalité vaut le détour.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.finextra.com/blogposting/25203/bitemporality-helping-lower-costs-for-financial-services-use-cases?utm_medium=rssfinextra&utm_source=finextrablogs

- :est

- :ne pas

- :où

- $UP

- 1

- a

- capacité

- A Propos

- à propos de ça

- à travers

- passible d'action

- actes

- d'activités

- actually

- Ajusté

- Tous

- aussi

- alternative

- an

- selon une analyse de l’Université de Princeton

- analytique

- analysé

- ainsi que

- Prévoir

- tous

- une approche

- architecture

- SONT

- tableau

- AS

- de côté

- demander

- demandant

- hypothèses

- At

- précaution

- fond

- Banque

- Banks

- BE

- magnifiquement

- car

- va

- aimé

- avantages.

- mais

- by

- CAN

- capital

- Marchés de capitaux

- captures

- Carrière

- maisons

- cas

- catégories

- VIP gastronomie à bord,

- Change

- modifié

- Modifications

- pas cher

- le cloud

- code

- commercial

- comparer

- comparant

- complexe

- complexités

- conformité

- concept

- conclusion

- confusion

- connecté

- Considérer

- corrélations

- cher

- Costs

- création

- des clients

- Cyclique

- données

- gestion des données

- Plateforme de données

- décisions

- profond

- Dérivés

- Détection

- Développement

- dispositif

- DID

- différent

- dimensions

- discuté

- spirituelle

- plongeon

- dividendes

- plongée

- do

- Docteur

- document

- les lecteurs

- e

- chacun

- "Early Bird"

- économistes

- risque numérique

- empathie

- participation

- ingénieur

- ENGINEERING

- Actions

- Ère

- estimé

- événement

- événements

- exemple

- exemples

- Échanges

- cher

- explicitement

- .

- faciliter

- finance

- la traduction de documents financiers

- rapport financier

- services financiers

- Trouvez

- Finextra

- fixé

- revenu fixe

- suivre

- suivi

- Pour

- trouvé

- fraude

- détection de fraude

- frauduleux

- De

- avant

- fonds

- En outre

- avenir

- Galaxies

- donné

- Go

- eu

- gouvernance

- l'

- arrivé

- Vous avez

- Cœur

- haie

- Hedge Funds

- aider

- aide

- augmentation

- sa

- HOT

- les plus en vogue

- HTML

- HTTPS

- i

- Impact

- impact

- Mettre en oeuvre

- améliorer

- in

- début

- comprendre

- passif

- intégrer

- individuel

- industrie

- inefficacités

- informer

- d'information

- informe

- infrastructures

- à l'intérieur

- instruments

- intention

- développement

- introduit

- IT

- SES

- jargon

- rejoint

- Joint

- juste

- Genre

- Savoir

- connu

- des lacs

- langue

- gros

- Nom de famille

- plus tard

- moins

- comme

- lignage

- plus long

- Style

- regardé

- Lot

- baisser

- LES PLANTES

- majeur

- a prendre une

- gagnez de l'argent

- gérer

- gérés

- gestion

- de nombreuses

- Marchés

- maître

- compte

- signifier

- moyenne

- engrener

- pourrait

- Réduire les

- modèle

- la modélisation

- numériques jumeaux (digital twin models)

- de l'argent

- PLUS

- (en fait, presque toutes)

- la plupart

- beaucoup

- plusieurs

- my

- Nommé

- Besoin

- nécessaire

- Besoins

- maintenant

- objet

- évident

- of

- Bureaux

- Vieux

- on

- ONE

- et, finalement,

- uniquement

- opposé

- or

- organisations

- paires

- panneau

- panel de discussion

- particulier

- particulièrement

- Patron de Couture

- motifs

- payant

- Paiement

- Paiements

- Personnes

- performant

- Personnellement

- Physique

- Place

- plateforme

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- des notes bonus

- Populaire

- portefeuille

- gestion de portefeuille

- l'éventualité

- Méthode

- pragmatique

- Loué

- principalement

- prix

- qui se déroulent

- processus

- Traité

- les process

- Vidéo

- Produits

- profession

- propriété

- fournisseurs

- Python

- qualité

- Quant

- Rage

- réal

- monde réel

- Réalité

- raison

- Articles

- régimes

- réglementé

- Régulateurs

- régulateurs

- rapport

- Rapports

- représenté

- exigent

- résultant

- révisions

- Analyse

- risques

- même

- Épargnez

- dire

- besoin

- Services

- Shorts

- devrait

- étapes

- simplifié

- simplement

- unique

- smart

- quelques

- Identifier

- Région

- Boutique

- STORES

- simple

- les stratégies

- de Marketing

- Étudiant

- réussi

- tel

- Appuyer

- Système

- Prenez

- tangible

- technique

- terme

- que

- qui

- La

- Les

- puis

- l'ont

- chose

- des choses

- this

- Avec

- billet

- étage

- fiable

- opportun

- horodatage

- à

- trop

- outil

- commerce

- métiers

- Commerce

- traditionnel

- transaction

- coûts de transaction

- Transactions

- De La Carrosserie

- transformé

- communication

- Essai

- TOUR

- deux

- type

- types

- étayer

- a actualisé

- us

- utilisé

- cas d'utilisation

- cas d'utilisation

- d'utiliser

- validé

- Précieux

- Plus-value

- fournisseurs

- très

- vues

- souhaitez

- était

- Façon..

- we

- semaine

- WELL

- ont été

- Quoi

- Qu’est ce qu'

- quand

- qui

- WHO

- why

- Wikipédia

- sera

- comprenant

- world

- vaut

- Vous n'avez

- Votre

- zéphyrnet