Introduction

En apprentissage automatique, le compromis biais-variance est un concept fondamental affectant les performances de tout modèle prédictif. Il fait référence à l'équilibre délicat entre l'erreur de biais et l'erreur de variance d'un modèle, car il est impossible de minimiser simultanément les deux. Trouver le bon équilibre est crucial pour obtenir des performances optimales du modèle.

Dans ce court article, nous définirons le biais et la variance, expliquerons comment ils affectent un modèle d'apprentissage automatique et fournirons des conseils pratiques sur la façon de les gérer dans la pratique.

Comprendre le biais et la variance

Avant de plonger dans la relation entre biais et variance, définissons ce que ces termes représentent dans l'apprentissage automatique.

L'erreur de biais fait référence à la différence entre la prédiction d'un modèle et les valeurs correctes qu'il essaie de prédire (vérité terrain). En d'autres termes, le biais est l'erreur qu'un modèle commet en raison de ses hypothèses incorrectes sur la distribution des données sous-jacentes. Les modèles à fort biais sont souvent trop simplistes et ne parviennent pas à saisir la complexité des données, ce qui entraîne un sous-ajustement.

L'erreur de variance, quant à elle, fait référence à la sensibilité du modèle aux petites fluctuations des données d'apprentissage. Les modèles à forte variance sont trop complexes et ont tendance à s'adapter au bruit dans les données plutôt qu'au modèle sous-jacent, ce qui entraîne un surajustement. Cela se traduit par de mauvaises performances sur les nouvelles données invisibles.

Un biais élevé peut conduire à un sous-ajustement, où le modèle est trop simple pour saisir la complexité des données. Il fait des hypothèses solides sur les données et ne parvient pas à saisir la véritable relation entre les variables d'entrée et de sortie. D'autre part, une variance élevée peut conduire à un surajustement, où le modèle est trop complexe et apprend le bruit dans les données plutôt que la relation sous-jacente entre les variables d'entrée et de sortie. Ainsi, les modèles de surajustement ont tendance à s'adapter trop étroitement aux données d'apprentissage et ne se généraliseront pas bien aux nouvelles données, tandis que les modèles de sous-ajustement ne sont même pas capables d'ajuster les données d'apprentissage avec précision.

Comme mentionné précédemment, le biais et la variance sont liés, et un bon modèle équilibre entre l'erreur de biais et l'erreur de variance. Le compromis biais-variance est le processus de recherche de l'équilibre optimal entre ces deux sources d'erreur. Un modèle avec un faible biais et une faible variance fonctionnera probablement bien à la fois sur la formation et sur les nouvelles données, minimisant l'erreur totale.

Le compromis biais-variance

L'équilibre entre la complexité du modèle et sa capacité à généraliser à des données inconnues est au cœur du compromis biais-variance. En général, un modèle plus complexe aura un biais plus faible mais une variance plus élevée, tandis qu'un modèle plus simple aura un biais plus élevé mais une variance plus faible.

Puisqu'il est impossible de minimiser simultanément le biais et la variance, trouver l'équilibre optimal entre eux est crucial pour construire un modèle d'apprentissage automatique robuste. Par exemple, à mesure que nous augmentons la complexité d'un modèle, nous augmentons également la variance. En effet, un modèle plus complexe est plus susceptible de s'adapter au bruit dans les données d'apprentissage, ce qui entraînera un surajustement.

En revanche, si nous gardons le modèle trop simple, nous augmenterons le biais. En effet, un modèle plus simple ne pourra pas capturer les relations sous-jacentes dans les données, ce qui entraînera un sous-ajustement.

L'objectif est de former un modèle suffisamment complexe pour capturer les relations sous-jacentes dans les données de formation, mais pas si complexe qu'il s'adapte au bruit dans les données de formation.

Le compromis biais-variance en pratique

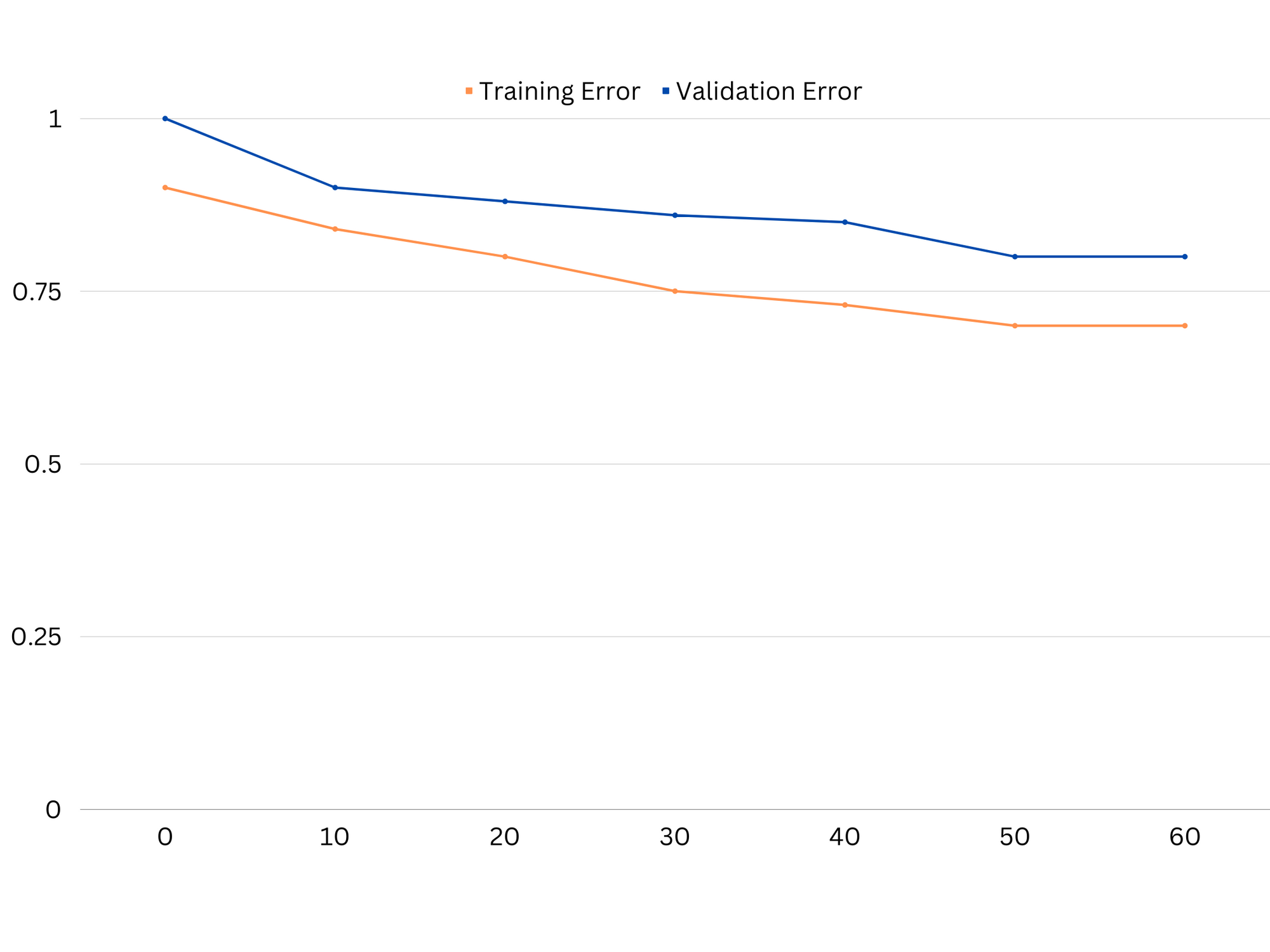

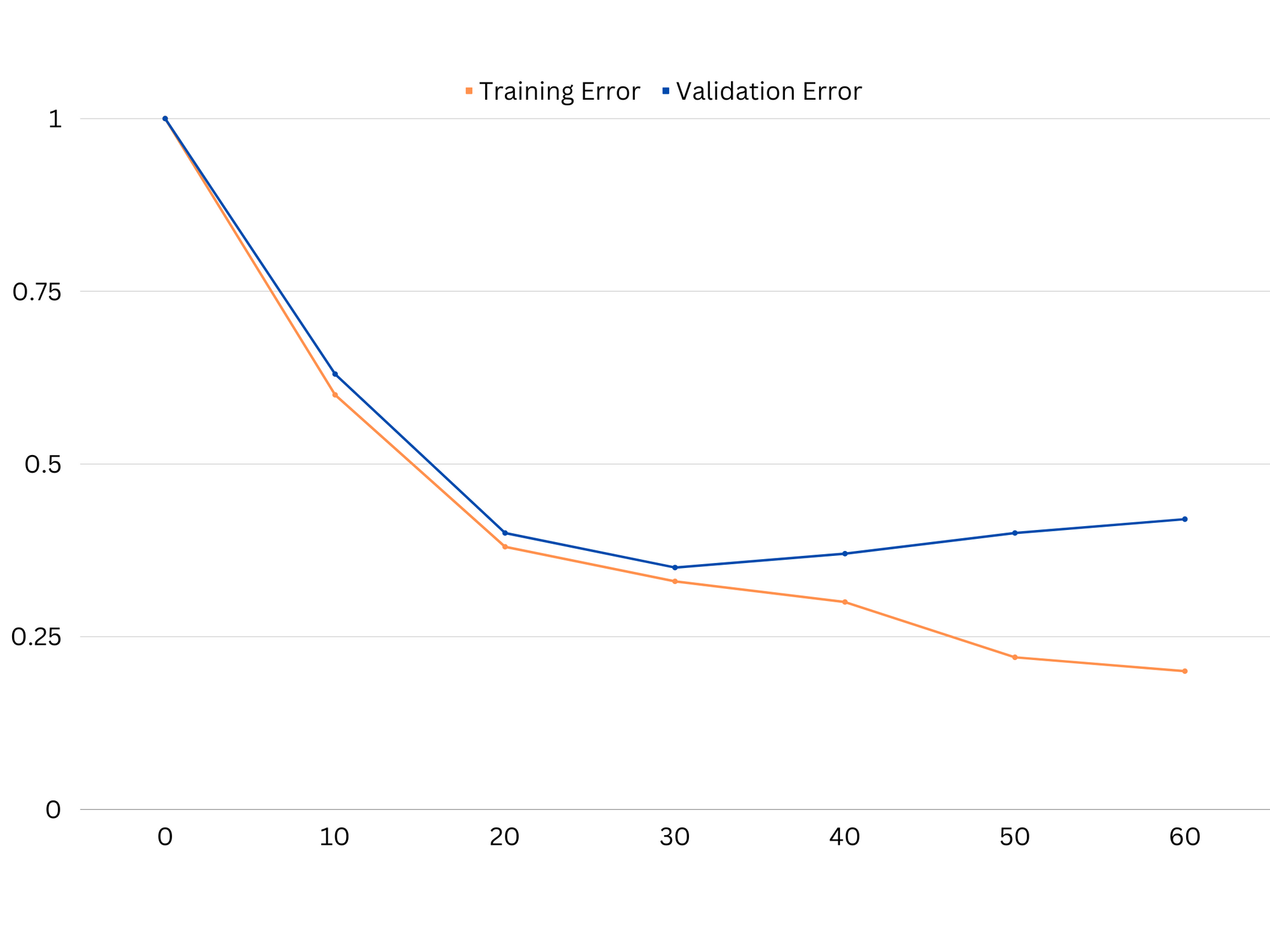

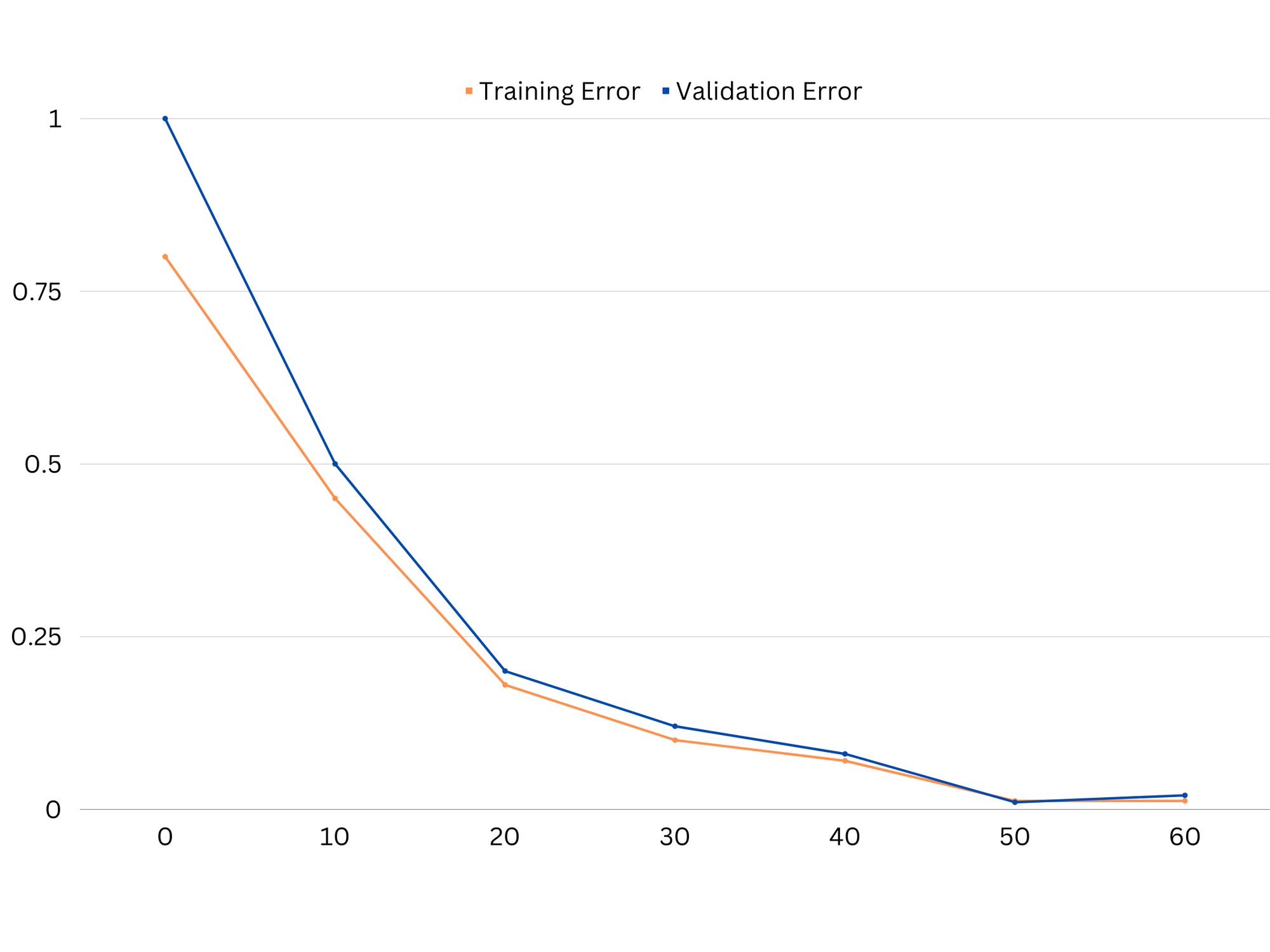

Pour diagnostiquer les performances du modèle, nous calculons et comparons généralement les erreurs d'entraînement et de validation. Un outil utile pour visualiser cela est un tracé des courbes d'apprentissage, qui affiche les performances du modèle à la fois sur les données d'entraînement et de validation tout au long du processus de formation. En examinant ces courbes, nous pouvons déterminer si un modèle est sur-ajusté (variance élevée), sous-ajusté (biais élevé) ou bien ajusté (équilibre optimal entre biais et variance).

Exemple de courbes d'apprentissage d'un modèle de sous-ajustement. L'erreur de train et l'erreur de validation sont élevées.

En pratique, de faibles performances sur les données d'entraînement et de validation suggèrent que le modèle est trop simple, ce qui conduit à un sous-ajustement. D'un autre côté, si le modèle fonctionne très bien sur les données d'apprentissage mais mal sur les données de test, la complexité du modèle est probablement trop élevée, ce qui entraîne un surajustement. Pour remédier au sous-ajustement, nous pouvons essayer d'augmenter la complexité du modèle en ajoutant plus de fonctionnalités, en modifiant l'algorithme d'apprentissage ou en choisissant différents hyperparamètres. En cas de surajustement, nous devrions envisager de régulariser le modèle ou d'utiliser des techniques comme la validation croisée pour améliorer ses capacités de généralisation.

Exemple de courbes d'apprentissage d'un modèle de surajustement. L'erreur de train diminue tandis que l'erreur de validation commence à augmenter. Le modèle est incapable de généraliser.

La régularisation est une technique qui peut être utilisée pour réduire l'erreur de variance dans les modèles d'apprentissage automatique, aidant à résoudre le compromis biais-variance. Il existe un certain nombre de techniques de régularisation différentes, chacune avec ses propres avantages et inconvénients. Certaines techniques de régularisation populaires incluent la régression de crête, la régression au lasso et la régularisation nette élastique. Toutes ces techniques permettent d'éviter le surajustement en ajoutant un terme de pénalité à la fonction objectif du modèle, ce qui décourage les valeurs extrêmes des paramètres et encourage les modèles plus simples.

Régression Ridge, également appelée régularisation L2, ajoute un terme de pénalité proportionnel au carré des paramètres du modèle. Cette technique a tendance à produire des modèles avec des valeurs de paramètres plus petites, ce qui peut conduire à une variance réduite et à une généralisation améliorée. Cependant, il n'effectue pas de sélection de fonctions, de sorte que toutes les fonctions restent dans le modèle.

Consultez notre guide pratique et pratique pour apprendre Git, avec les meilleures pratiques, les normes acceptées par l'industrie et la feuille de triche incluse. Arrêtez de googler les commandes Git et en fait apprendre il!

Régression au lasso, ou régularisation L1, ajoute un terme de pénalité proportionnel à la valeur absolue des paramètres du modèle. Cette technique peut conduire à des modèles avec des valeurs de paramètres clairsemées, effectuant efficacement la sélection des fonctionnalités en définissant certains paramètres sur zéro. Cela peut se traduire par des modèles plus simples et plus faciles à interpréter.

Régularisation nette élastique est une combinaison de la régularisation L1 et L2, permettant un équilibre entre la régression de crête et de lasso. En contrôlant le rapport entre les deux termes de pénalité, le filet élastique peut obtenir les avantages des deux techniques, tels qu'une généralisation et une sélection de fonctionnalités améliorées.

Exemple de courbes d'apprentissage d'un bon modèle d'ajustement.

Conclusions

Le compromis biais-variance est un concept crucial dans l'apprentissage automatique qui détermine l'efficacité et la qualité d'un modèle. Alors qu'un biais élevé conduit à un sous-ajustement et qu'une variance élevée conduit à un surajustement, il est nécessaire de trouver l'équilibre optimal entre les deux pour construire des modèles robustes qui se généralisent bien aux nouvelles données.

À l'aide de courbes d'apprentissage, il est possible d'identifier les problèmes de surajustement ou de sous-ajustement, et en ajustant la complexité du modèle ou en mettant en œuvre des techniques de régularisation, il est possible d'améliorer les performances sur les données d'entraînement et de validation, ainsi que sur les données de test.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoAiStream. Intelligence des données Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- Achetez et vendez des actions de sociétés PRE-IPO avec PREIPO®. Accéder ici.

- La source: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :est

- :ne pas

- :où

- 1

- 12

- 20

- 8

- a

- capacité

- Capable

- A Propos

- Absolute

- avec précision

- atteindre

- la réalisation de

- actually

- ajoutant

- propos

- Ajoute

- avantages

- conseils

- affecter

- affectant

- algorithme

- Tous

- Permettre

- aussi

- an

- ainsi que

- tous

- SONT

- article

- AS

- Balance

- soldes

- BE

- car

- avantages.

- jusqu'à XNUMX fois

- biais

- frontière

- tous les deux

- Développement

- mais

- by

- calculer

- CAN

- capacités

- capturer

- maisons

- en changeant

- choose

- étroitement

- combinaison

- comparer

- complexe

- complexité

- concept

- Considérer

- contrôle

- Core

- correct

- crucial

- données

- affaire

- diminue

- Déterminer

- détermine

- différence

- différent

- affiche

- distribution

- deux

- chacun

- Plus tôt

- plus facilement

- de manière efficace

- efficacité

- encourage

- assez

- erreur

- Erreurs

- Pourtant, la

- Examiner

- exemple

- Expliquer

- extrême

- défaut

- échoue

- Fonctionnalité

- Fonctionnalités:

- trouver

- s'adapter

- raccord

- fluctuations

- Focus

- Pour

- fonction

- fondamental

- Général

- Git

- objectif

- Bien

- Sol

- guide

- main

- hands-on

- Vous avez

- vous aider

- aider

- Haute

- augmentation

- flotter

- Comment

- How To

- Cependant

- HTTPS

- identifier

- if

- la mise en œuvre

- impossible

- améliorer

- amélioré

- in

- Dans d'autres

- comprendre

- inclus

- Améliore

- croissant

- contribution

- développement

- Introduction

- IT

- SES

- XNUMX éléments à

- connu

- L1

- l2

- conduire

- conduisant

- Conduit

- apprentissage

- laisser

- LG

- comme

- Probable

- ll

- Faible

- baisser

- click

- machine learning

- FAIT DU

- mentionné

- réduisant au minimum

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- nécessaire

- net

- Nouveauté

- Bruit

- nombre

- objectif

- of

- souvent

- on

- optimaux

- or

- Autre

- nos

- ande

- sortie

- propre

- paramètre

- paramètres

- Patron de Couture

- Effectuer

- performant

- effectuer

- effectue

- Platon

- Intelligence des données Platon

- PlatonDonnées

- pauvres

- Populaire

- possible

- Méthode

- pratique

- prévoir

- prédiction

- empêcher

- d'ouvrabilité

- processus

- fournir

- plutôt

- rapport

- réduire

- Prix Réduit

- se réfère

- en relation

- relation amoureuse

- Les relations

- rester

- représentent

- résultat

- résultant

- Résultats

- bon

- Bagues

- robuste

- s

- sélection

- Sensibilité

- mise

- Shadow

- feuille

- Shorts

- devrait

- étapes

- simultanément

- petit

- faibles

- So

- quelques

- Sources

- carré

- Stackabuse

- Normes

- Arrêter

- STRONG

- tel

- Suggère

- techniques

- terme

- conditions

- tester

- que

- qui

- La

- leur

- Les

- Là.

- Ces

- l'ont

- this

- tout au long de

- à

- trop

- outil

- Total

- Train

- Formation

- transition

- oui

- Vérité

- Essai

- deux

- typiquement

- incapable

- sous-jacent

- inconnu

- d'utiliser

- en utilisant

- validation

- Plus-value

- Valeurs

- très

- we

- WELL

- Quoi

- que

- qui

- tout en

- sera

- comprenant

- des mots

- zéphyrnet

- zéro