Cet article de blog est co-écrit avec Hwalsuk Lee chez Upstage.

Aujourd'hui, nous sommes ravis d'annoncer que le Solaire Le modèle de fondation développé par Upstage est désormais disponible pour les clients utilisant Amazon SageMaker JumpStart. Solar est un grand modèle de langage (LLM) 100 % pré-entraîné avec Amazon Sage Maker qui surpasse et utilise sa taille compacte et ses puissants antécédents pour se spécialiser dans la formation ciblée, ce qui le rend polyvalent dans toutes les langues, domaines et tâches.

Vous pouvez maintenant utiliser le Mini-chat solaire ainsi que les Mini Chat Solaire – Quant modèles pré-entraînés dans SageMaker JumpStart. SageMaker JumpStart est le hub d'apprentissage automatique (ML) de SageMaker qui donne accès aux modèles de base en plus des algorithmes intégrés pour vous aider à démarrer rapidement avec le ML.

Dans cet article, nous expliquons comment découvrir et déployer le modèle solaire via SageMaker JumpStart.

Quel est le modèle solaire ?

Solar est un modèle compact et puissant pour les langues anglaise et coréenne. Il est spécialement conçu pour les discussions multitours, démontrant des performances améliorées sur un large éventail de tâches de traitement du langage naturel.

Le modèle Solar Mini Chat est basé sur Solaire 10.7B, avec un 32 couches Llama 2 structure, et initialisé avec des poids pré-entraînés de Mistral7B compatible avec l'architecture Llama 2. Ce réglage précis lui confère la capacité de gérer plus efficacement des conversations prolongées, ce qui le rend particulièrement adapté aux applications interactives. Il utilise une méthode de mise à l'échelle appelée mise à l'échelle de la profondeur (DUS), qui comprend une mise à l'échelle en profondeur et une pré-formation continue. DHS permet un agrandissement beaucoup plus simple et efficace de modèles plus petits que d'autres méthodes de mise à l'échelle telles que mélange d'experts (MdE).

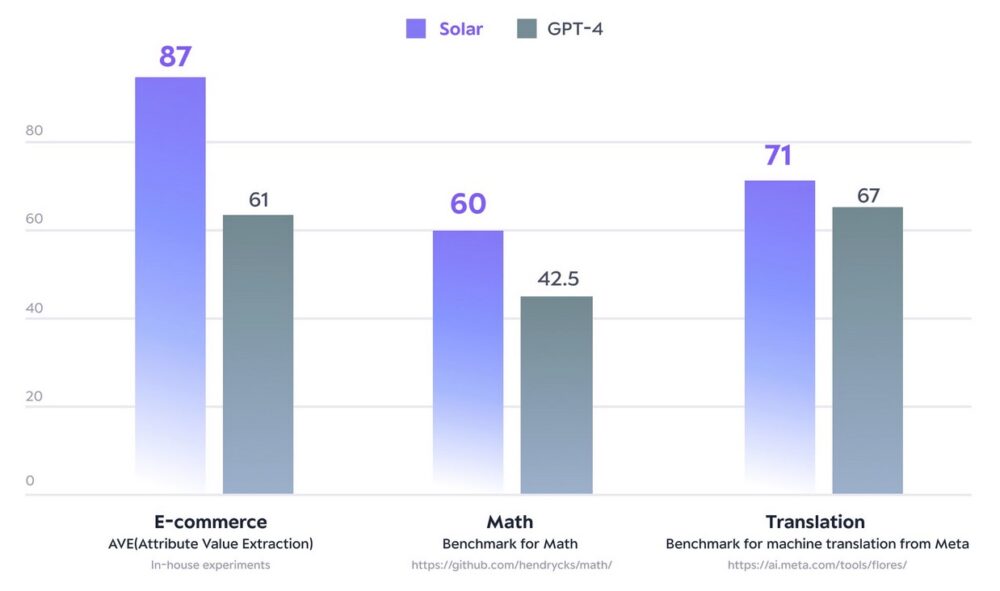

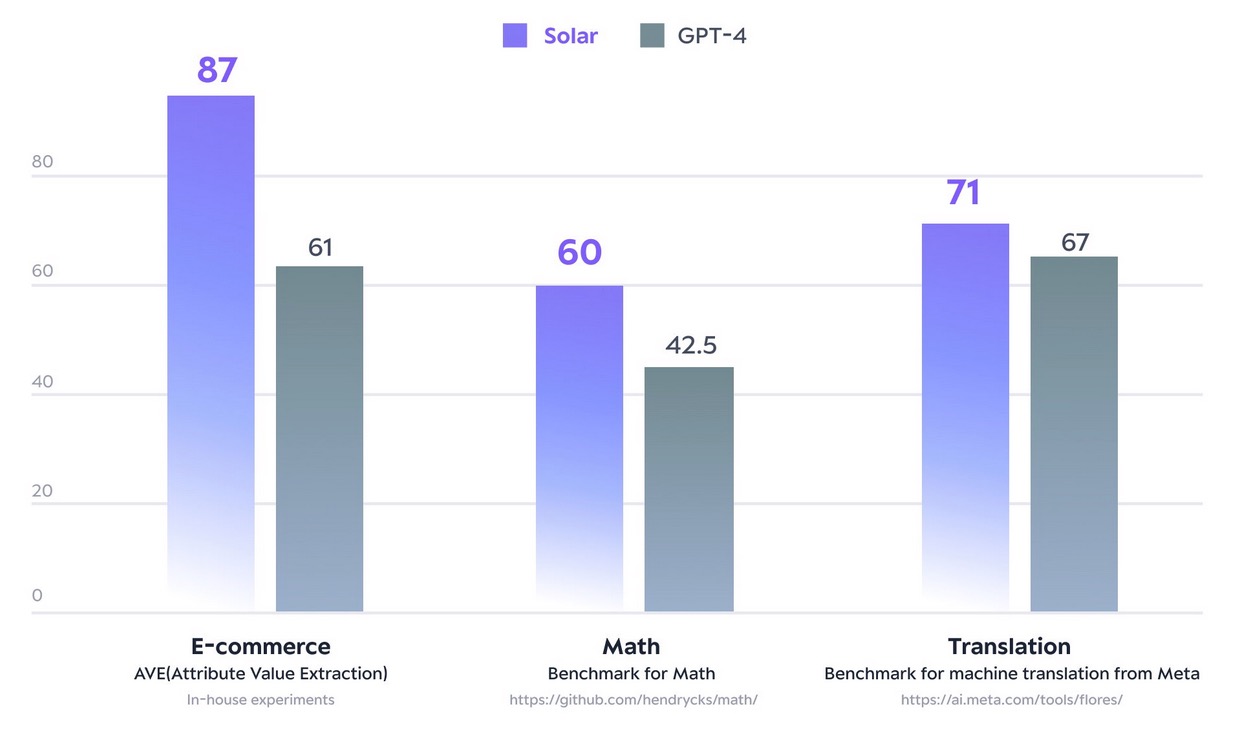

En décembre 2023, le modèle Solar 10.7B fait des vagues en atteignant le sommet du Classement ouvert LLM de câliner le visage. Utilisant nettement moins de paramètres, Solar 10.7B fournit des réponses comparables à GPT-3.5, mais est 2.5 fois plus rapide. En plus d'être en tête du classement Open LLM, Solar 10.7B surpasse GPT-4 avec des modèles spécialement formés sur certains domaines et tâches.

La figure suivante illustre certaines de ces mesures :

la source: https://www.upstage.ai/solar-llm

Avec SageMaker JumpStart, vous pouvez déployer des modèles pré-entraînés basés sur Solar 10.7B : Solar Mini Chat et une version quantifiée de Solar Mini Chat, optimisée pour les applications de chat en anglais et en coréen. Le modèle Solar Mini Chat offre une compréhension avancée des nuances de la langue coréenne, ce qui améliore considérablement les interactions des utilisateurs dans les environnements de chat. Il fournit des réponses précises aux entrées de l'utilisateur, garantissant une communication plus claire et une résolution plus efficace des problèmes dans les applications de chat en anglais et en coréen.

Premiers pas avec les modèles solaires dans SageMaker JumpStart

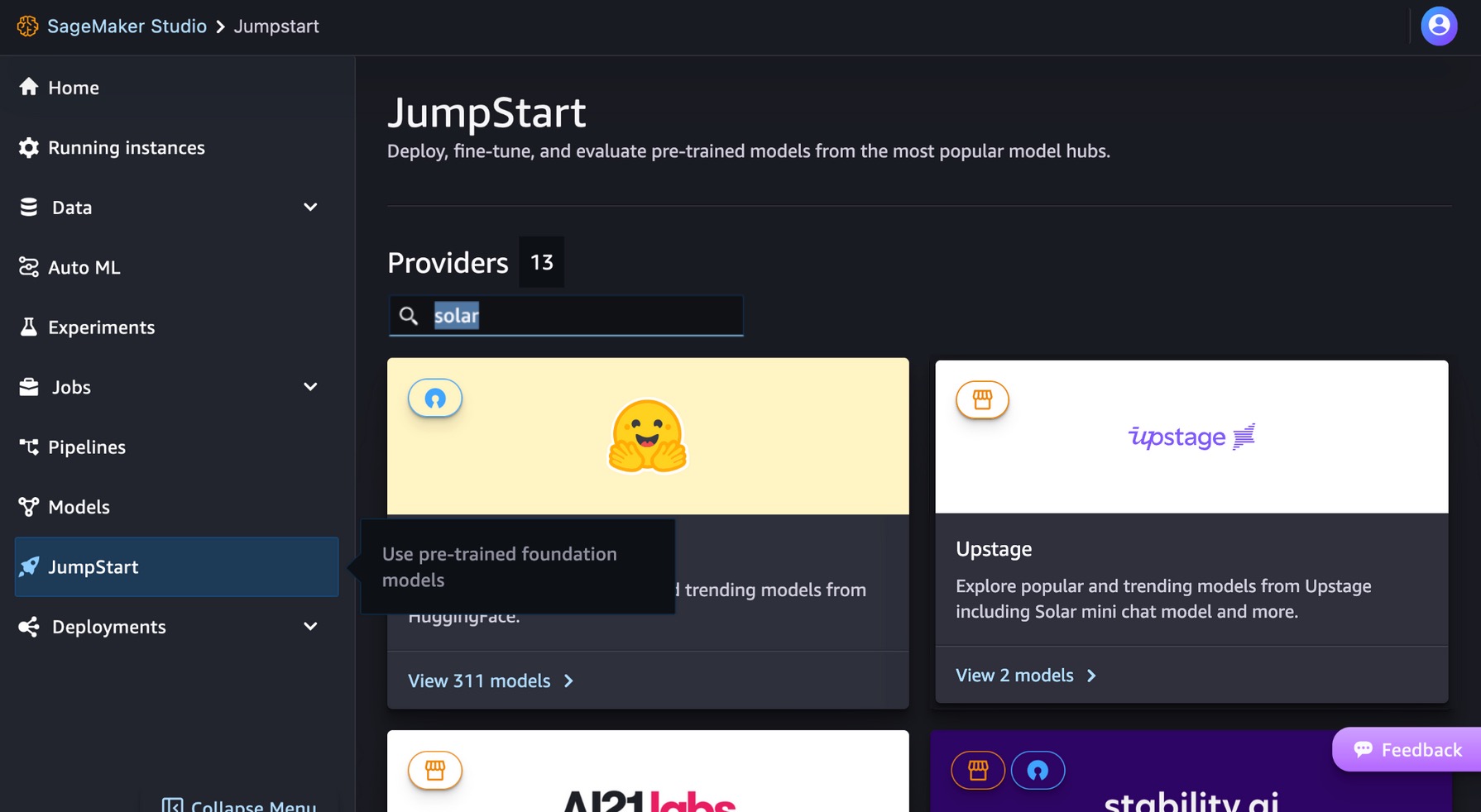

Pour démarrer avec les modèles Solar, vous pouvez utiliser SageMaker JumpStart, un service hub ML entièrement géré pour déployer des modèles ML prédéfinis dans un environnement hébergé prêt pour la production. Vous pouvez accéder aux modèles solaires via SageMaker JumpStart dans Amazon SageMakerStudio, un environnement de développement intégré (IDE) basé sur le Web dans lequel vous pouvez accéder à des outils spécialement conçus pour effectuer toutes les étapes de développement de ML, de la préparation des données à la création, la formation et le déploiement de vos modèles de ML.

Sur la console SageMaker Studio, choisissez Début de saut dans le volet de navigation. Vous pouvez saisir « solaire » dans la barre de recherche pour trouver les modèles solaires d'Upstage.

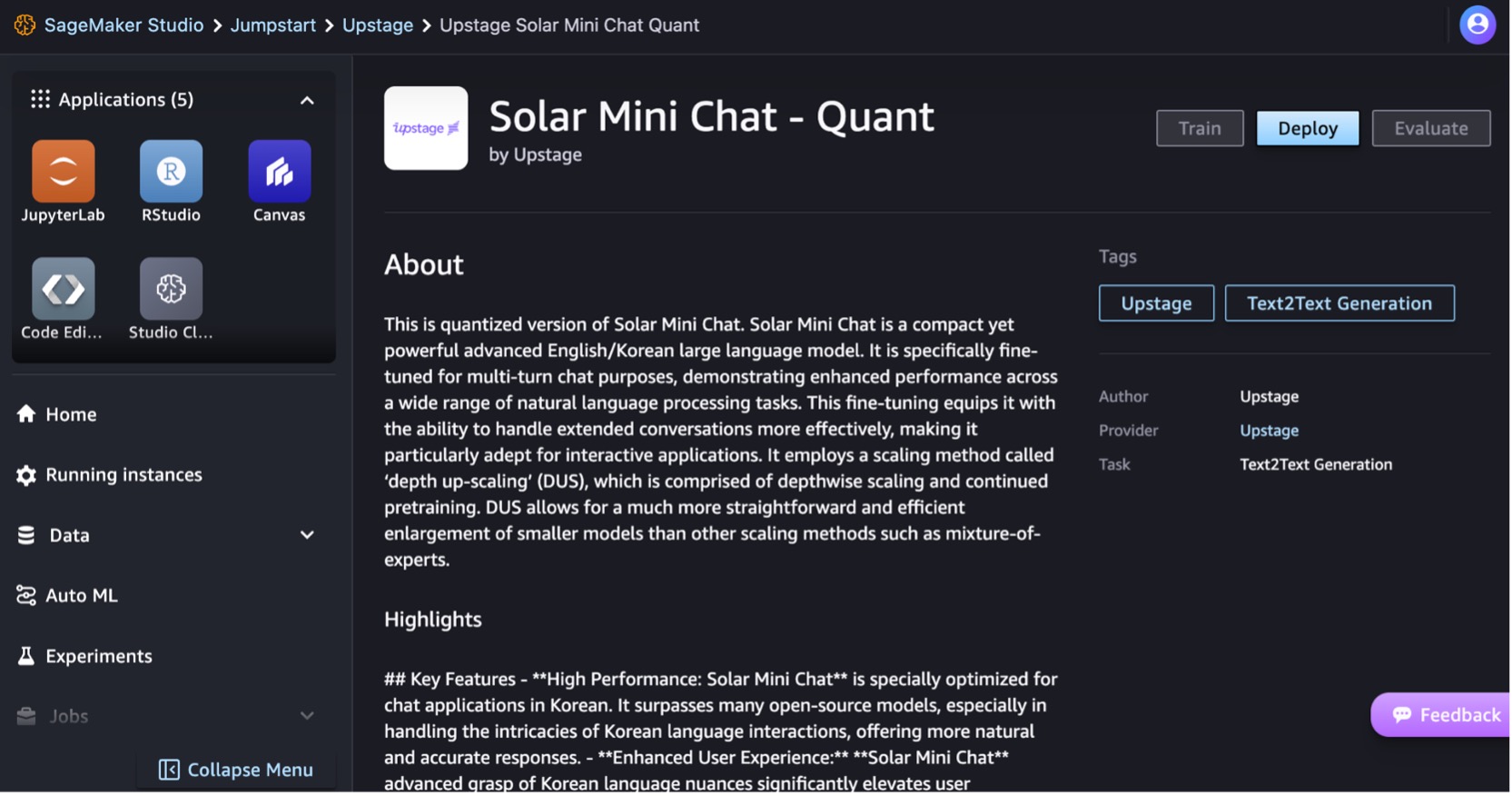

Déployons le modèle Solar Mini Chat – Quant. Choisissez la fiche de modèle pour afficher les détails du modèle, tels que la licence, les données utilisées pour l'entraînement et la manière d'utiliser le modèle. Vous trouverez également un Déployer option, qui vous amène à une page de destination où vous pouvez tester l'inférence avec un exemple de charge utile.

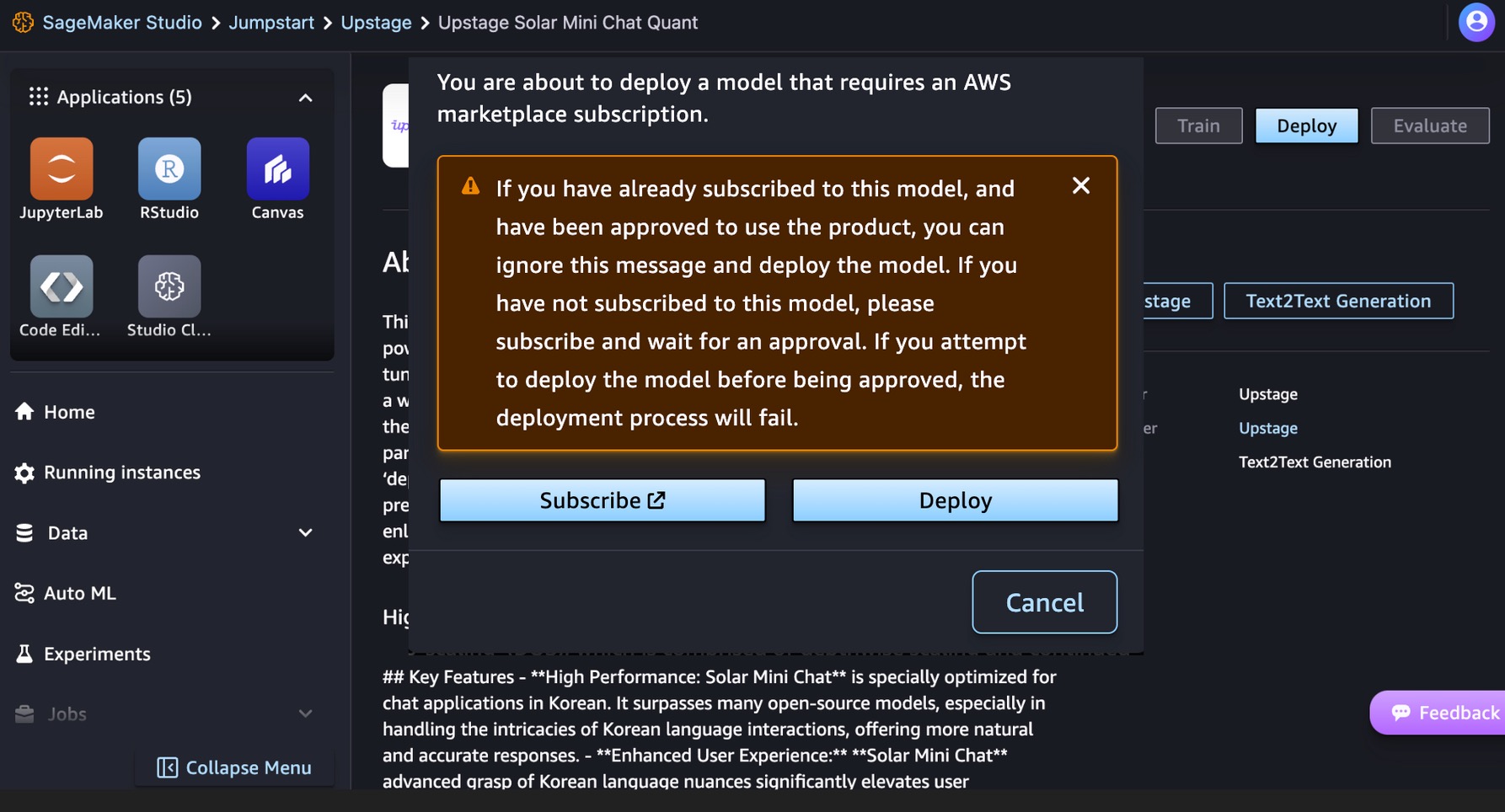

Ce modèle nécessite un Marketplace AWS abonnement. Si vous êtes déjà abonné à ce modèle et que vous avez été autorisé à utiliser le produit, vous pouvez déployer le modèle directement.

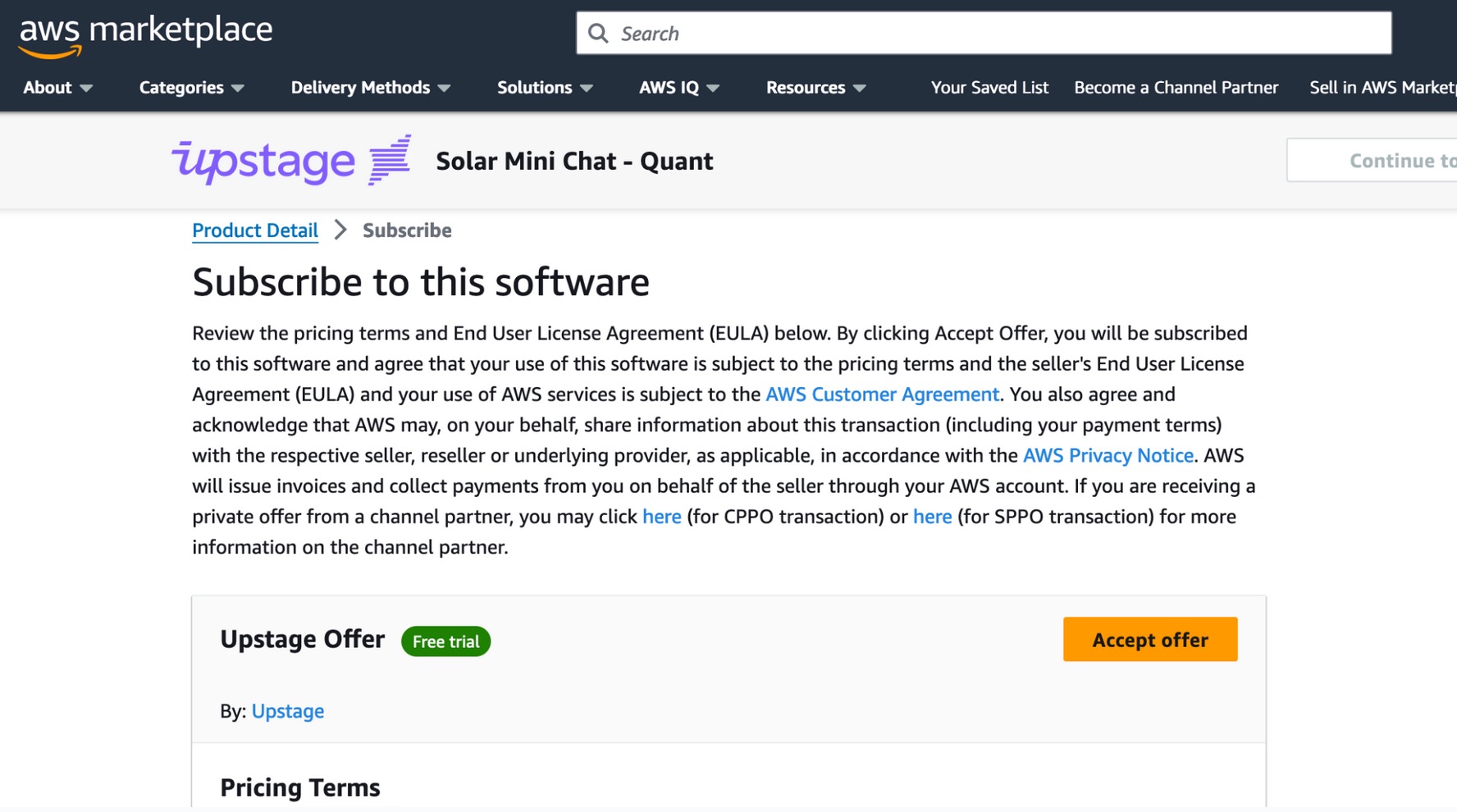

Si vous n'êtes pas abonné à ce modèle, choisissez S'abonner, accédez à AWS Marketplace, consultez les conditions tarifaires et le contrat de licence utilisateur final (CLUF), puis choisissez Accepter l'offre.

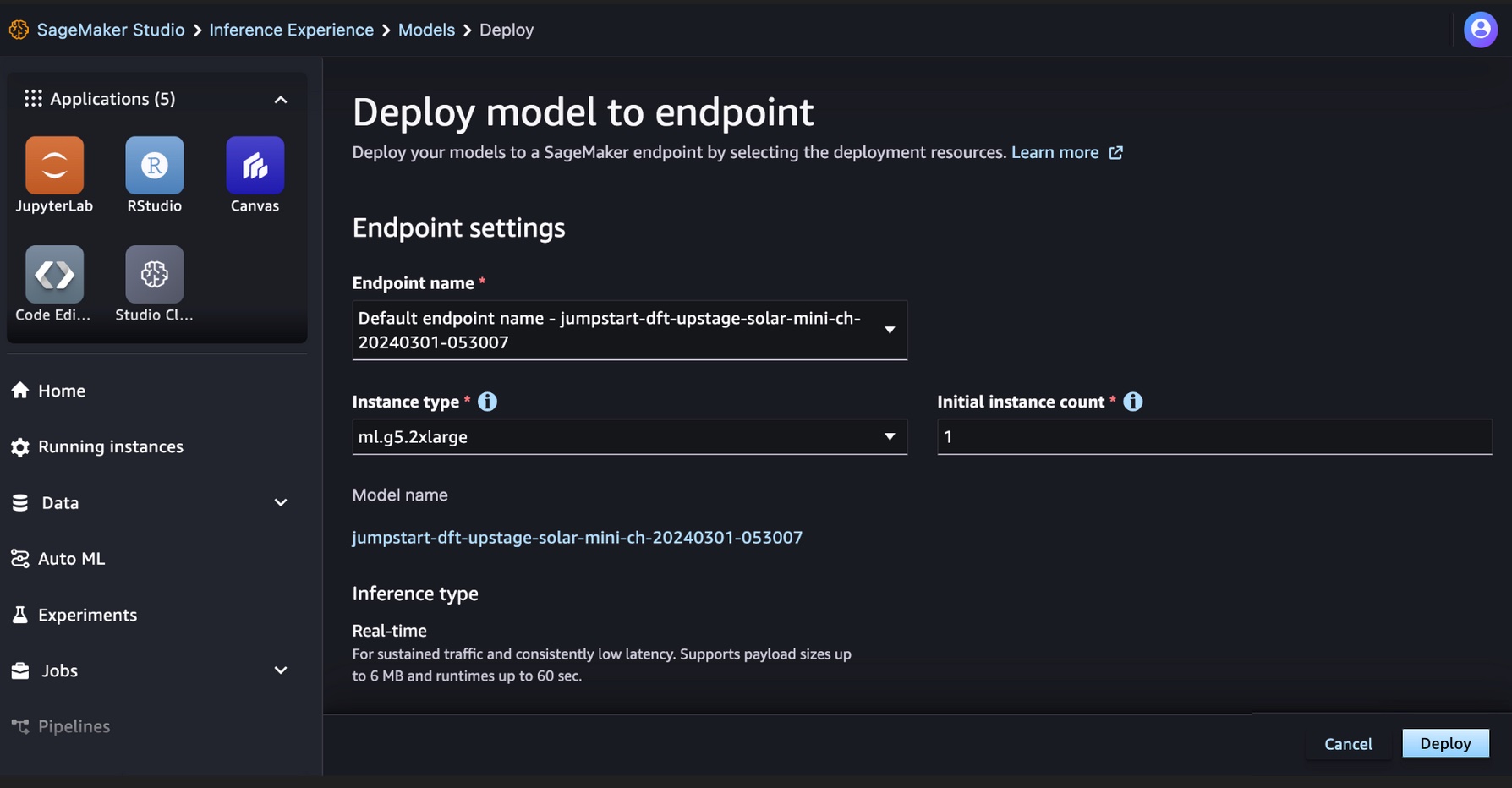

Une fois abonné au modèle, vous pouvez déployer votre modèle sur un point de terminaison SageMaker en sélectionnant les ressources de déploiement, telles que le type d'instance et le nombre initial d'instances. Choisir Déployer et attendez qu'un point de terminaison soit créé pour l'inférence du modèle. Vous pouvez sélectionner un ml.g5.2xlarge par exemple comme une option moins coûteuse pour l’inférence avec le modèle solaire.

Une fois votre point de terminaison SageMaker créé avec succès, vous pouvez le tester via les différents environnements d'application SageMaker.

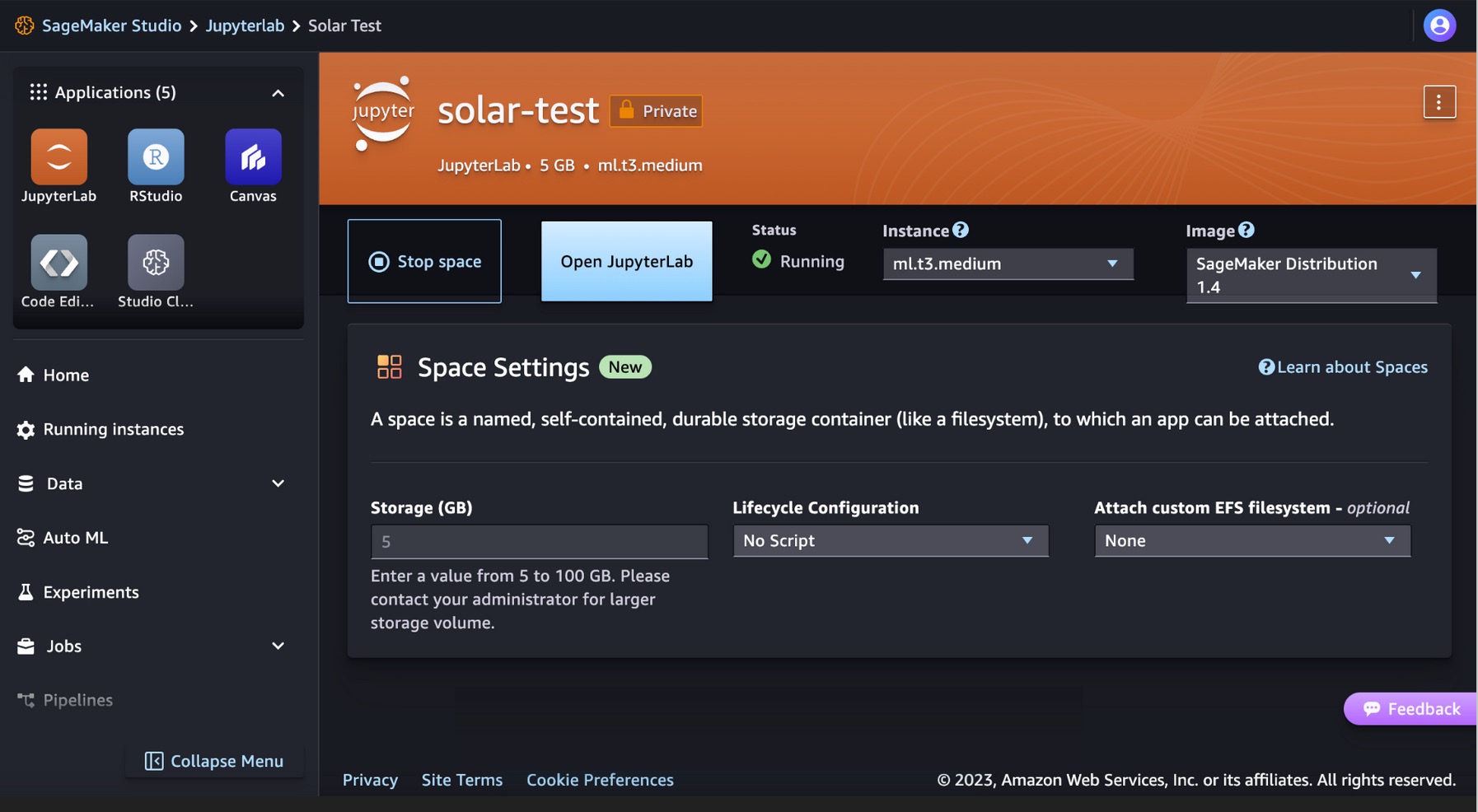

Exécutez votre code pour les modèles solaires dans SageMaker Studio JupyterLab

SageMaker Studio prend en charge divers environnements de développement d'applications, notamment JupyterLab, un ensemble de fonctionnalités qui augmentent l'offre de notebooks entièrement gérés. Il comprend des noyaux qui démarrent en quelques secondes, un environnement d'exécution préconfiguré avec une science des données populaire, des frameworks ML et un stockage par blocs privés hautes performances. Pour plus d'informations, voir SageMaker JupyterLab.

Créez un espace JupyterLab dans SageMaker Studio qui gère les ressources de stockage et de calcul nécessaires à l'exécution de l'application JupyterLab.

Vous pouvez trouver le code montrant le déploiement des modèles Solar sur SageMaker JumpStart et un exemple d'utilisation du modèle déployé dans le GitHub repo. Vous pouvez maintenant déployer le modèle à l'aide de SageMaker JumpStart. Le code suivant utilise l'instance par défaut ml.g5.2xlarge pour le point de terminaison d'inférence de modèle Solar Mini Chat – Quant.

Les modèles solaires prennent en charge une charge utile de demande/réponse compatible avec le point de terminaison de complétion de chat d'OpenAI. Vous pouvez tester des exemples de discussion à un ou plusieurs tours avec Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultVous avez effectué avec succès une inférence en temps réel avec le modèle Solar Mini Chat.

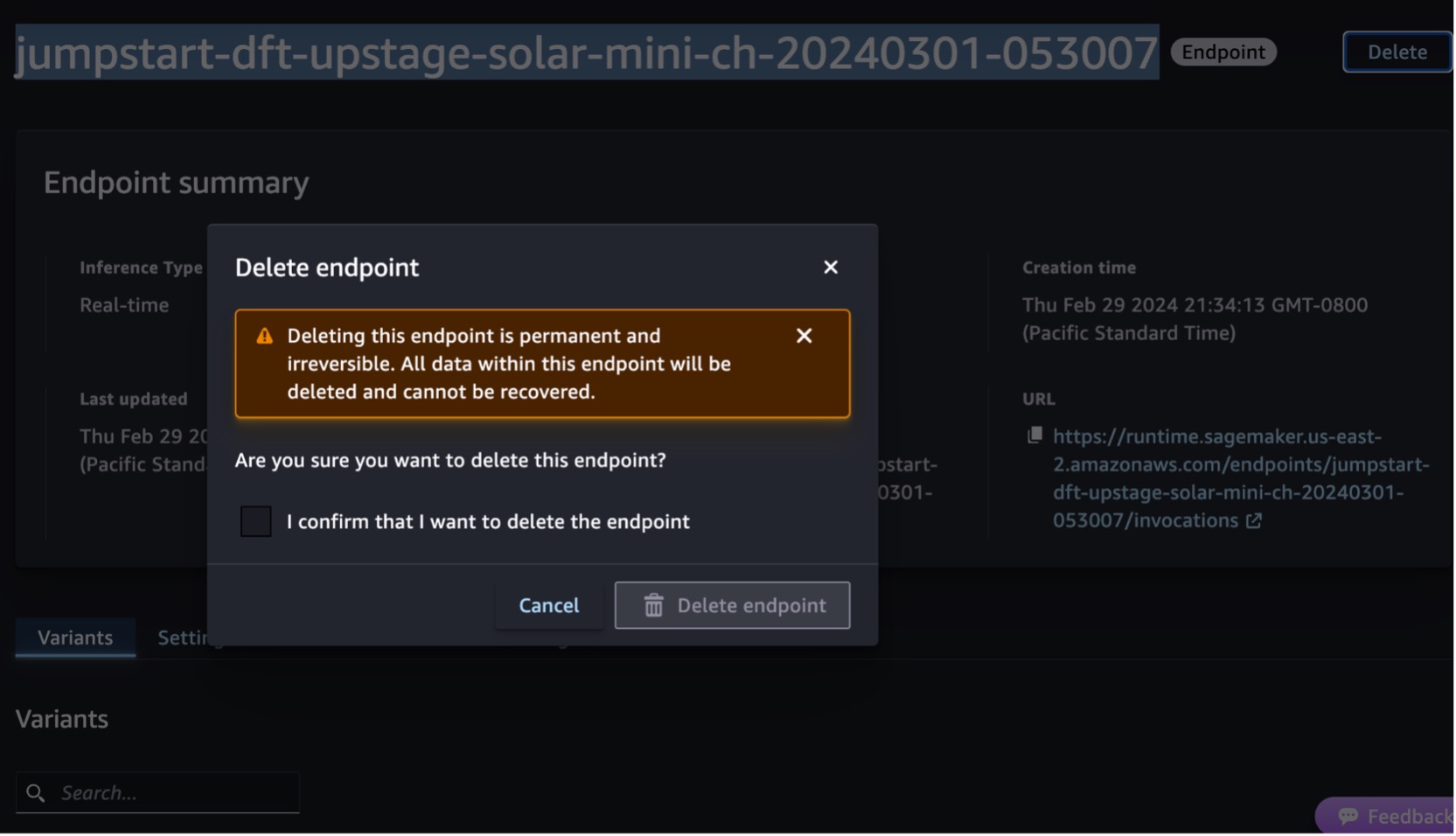

Nettoyer

Après avoir testé le point de terminaison, supprimez le point de terminaison d'inférence SageMaker et supprimez le modèle pour éviter d'encourir des frais.

Vous pouvez également exécuter le code suivant pour supprimer le point de terminaison et le mode dans le bloc-notes de SageMaker Studio JupyterLab :

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()Pour plus d'informations, voir Supprimer des terminaux et des ressources. De plus, vous pouvez arrêter les ressources de SageMaker Studio qui ne sont plus nécessaires.

Conclusion

Dans cet article, nous vous avons montré comment démarrer avec les modèles solaires d'Upstage dans SageMaker Studio et déployer le modèle pour l'inférence. Nous vous avons également montré comment exécuter votre exemple de code Python sur SageMaker Studio JupyterLab.

Étant donné que les modèles Solar sont déjà pré-entraînés, ils peuvent contribuer à réduire les coûts de formation et d'infrastructure et permettre la personnalisation de vos applications d'IA générative.

Essayez-le sur le Console SageMaker JumpStart or Console SageMaker Studio! Vous pouvez également regarder la vidéo suivante, Essayez « Solaire » avec Amazon SageMaker.

Ces conseils sont fournis à titre informatif uniquement. Vous devez toujours effectuer votre propre évaluation indépendante et prendre des mesures pour garantir que vous respectez vos propres pratiques et normes spécifiques de contrôle de qualité, ainsi que les règles, lois, réglementations, licences et conditions d'utilisation locales qui s'appliquent à vous, à votre contenu, et le modèle tiers référencé dans ce guide. AWS n'a aucun contrôle ni autorité sur le modèle tiers référencé dans ce guide et ne fait aucune déclaration ni garantie que le modèle tiers est sécurisé, exempt de virus, opérationnel ou compatible avec votre environnement et vos normes de production. AWS ne fait aucune déclaration, garantie ou garantie que les informations contenues dans ce guide entraîneront un résultat ou un résultat particulier.

À propos des auteurs

Channy Yun est l'un des principaux défenseurs des développeurs chez AWS et se passionne pour aider les développeurs à créer des applications modernes sur les derniers services AWS. C'est un développeur pragmatique et un blogueur dans l'âme, et il aime l'apprentissage communautaire et le partage de la technologie.

Channy Yun est l'un des principaux défenseurs des développeurs chez AWS et se passionne pour aider les développeurs à créer des applications modernes sur les derniers services AWS. C'est un développeur pragmatique et un blogueur dans l'âme, et il aime l'apprentissage communautaire et le partage de la technologie.

Hwalsuk Lee est directeur de la technologie (CTO) chez Upstage. Il a travaillé pour Samsung Techwin, NCSOFT et Naver en tant que chercheur en IA. Il poursuit son doctorat en génie informatique et électrique à l’Institut supérieur coréen des sciences et technologies (KAIST).

Hwalsuk Lee est directeur de la technologie (CTO) chez Upstage. Il a travaillé pour Samsung Techwin, NCSOFT et Naver en tant que chercheur en IA. Il poursuit son doctorat en génie informatique et électrique à l’Institut supérieur coréen des sciences et technologies (KAIST).

Brandon Lee est architecte de solutions senior chez AWS et aide principalement les grands clients de technologies éducatives du secteur public. Il possède plus de 20 ans d’expérience dans la direction du développement d’applications au sein d’entreprises mondiales et de grandes sociétés.

Brandon Lee est architecte de solutions senior chez AWS et aide principalement les grands clients de technologies éducatives du secteur public. Il possède plus de 20 ans d’expérience dans la direction du développement d’applications au sein d’entreprises mondiales et de grandes sociétés.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :possède

- :est

- :ne pas

- :où

- 10

- 120

- 152

- 20

- 20 ans

- 2023

- 7

- 990

- a

- capacité

- Qui sommes-nous

- Accepter

- accès

- à travers

- ajout

- En outre

- adepte

- Avancée

- avocat

- contrat

- AI

- algorithmes

- Tous

- permet

- le long de

- déjà

- aussi

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- ainsi que les

- et infrastructure

- Annoncer

- tous

- Application

- Le développement d'applications

- applications

- Appliquer

- ,

- architecture

- SONT

- AS

- Évaluation de risque climatique

- Assistante gérante

- At

- augmenter

- autorité

- disponibles

- éviter

- AWS

- Marketplace AWS

- barre

- basé

- BE

- était

- Block

- Blog

- corps

- Brandon

- construire

- Développement

- intégré

- mais

- by

- appelé

- CAN

- capacités

- carte

- certaines

- des charges

- le chat

- moins chère

- chef

- Chief Technology Officer

- Selectionnez

- plus clair

- code

- Communication

- Axé sur la communauté

- compact

- Sociétés

- comparable

- compatible

- achèvement

- se conformer

- Composé

- calcul

- ordinateur

- Console

- contenu

- a continué

- des bactéries

- conversations

- Corporations

- Costs

- compter

- engendrent

- créée

- CTO

- Clients

- personnalisation

- données

- science des données

- Décembre

- Réglage par défaut

- offre

- démontrer

- déployer

- déployé

- déployer

- déploiement

- détails

- développé

- Développeur

- mobiles

- Développement

- directement

- découvrez

- domaines

- down

- pédagogique

- de manière efficace

- efficace

- élève

- emploie

- permettre

- fin

- Endpoint

- ENGINEERING

- Anglais

- améliorée

- assurer

- assurer

- Entrer

- Environment

- environnements

- exemple

- exemples

- excité

- d'experience

- prolongé

- Visage

- plus rapide

- moins

- Figure

- Trouvez

- Abonnement

- Pour

- Fondation

- cadres

- de

- d’étiquettes électroniques entièrement

- fonction

- génératif

- IA générative

- obtenez

- Global

- Go

- saisir

- garantit

- l'orientation

- manipuler

- Vous avez

- he

- Cœur

- vous aider

- utile

- aider

- aide

- ici

- haute performance

- sa

- organisé

- Comment

- How To

- HTML

- HTTPS

- Moyeu

- if

- illustre

- in

- inclut

- Y compris

- indépendant

- d'information

- D'information

- Infrastructure

- initiale

- contribution

- entrées

- instance

- Institut

- des services

- interactions

- Interactif

- développement

- IT

- SES

- jpg

- json

- Corée

- Coréen

- atterrissage

- langue

- Langues

- gros

- Nouveautés

- Lois

- classement

- conduisant

- apprentissage

- Lee

- Licence

- licences

- Liste

- Flamme

- LLM

- locales

- plus long

- aime

- baisser

- click

- machine learning

- LES PLANTES

- a prendre une

- Fabrication

- gérés

- gère

- marché

- les mesures

- aller

- messages

- Meta

- méthode

- méthodes

- Métrique

- ML

- Mode

- modèle

- numériques jumeaux (digital twin models)

- Villas Modernes

- PLUS

- plus efficace

- beaucoup

- Nature

- Traitement du langage naturel

- Naver

- Navigation

- nécessaire

- aucune

- notamment

- cahier

- maintenant

- nuances

- of

- code

- offrant

- Financier

- on

- uniquement

- ouvert

- opérationnel

- optimisé

- Option

- or

- Autre

- ande

- Résultat

- Surperforme

- plus de

- propre

- page

- pain

- paramètres

- particulier

- particulièrement

- passionné

- Effectuer

- performant

- effectué

- phd

- photo

- Pinnacle

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Populaire

- Post

- solide

- pratiques

- pragmatique

- précis

- en train de préparer

- établissement des prix

- qui se déroulent

- Directeur

- Imprimé

- Privé

- Problème

- traitement

- Produit

- Vidéo

- fournir

- fournit

- public

- des fins

- Python

- qualité

- Quant

- vite.

- gamme

- atteindre

- réal

- en temps réel

- Articles

- référencé

- règlements

- conditions

- a besoin

- chercheur

- Résolution

- Resources

- réponse

- réponses

- résultat

- retourner

- Avis

- Rôle

- Courir

- d'exécution

- sagemaker

- Inférence SageMaker

- échantillon

- Samsung

- mise à l'échelle

- Sciences

- Science et technologie

- scénario

- Rechercher

- secondes

- secteur

- sécurisé

- sur le lien

- Sélectionner

- la sélection

- supérieur

- service

- Services

- set

- partage

- devrait

- montré

- montrant

- de façon significative

- Taille

- faibles

- solaire

- Solutions

- quelques

- Space

- spécialiser

- groupe de neurones

- spécifiquement

- Normes

- Commencer

- j'ai commencé

- Étapes

- Encore

- storage

- simple

- structure

- studio

- inscrire

- abonnement

- Avec succès

- tel

- Support

- Les soutiens

- sûr

- combustion propre

- Prenez

- prend

- tâches

- Technologie

- conditions

- tester

- examiné

- que

- qui

- Les

- Ces

- l'ont

- des tiers.

- this

- Avec

- fiable

- fois

- à

- les outils

- suivre

- Train

- Formation

- deux

- type

- utilisé

- d'utiliser

- Utilisateur

- Usages

- en utilisant

- divers

- polyvalente

- version

- via

- Vidéo

- Voir

- attendez

- marcher

- garanties

- Montres

- vagues

- we

- web

- services Web

- Basé sur le Web

- qui

- large

- Large gamme

- sera

- comprenant

- dans les

- travaillé

- années

- Vous n'avez

- Votre

- Youtube

- zéphyrnet