Aujourd'hui, nous sommes ravis d'annoncer que le Mixtral-8x7B le grand modèle de langage (LLM), développé par Mistral AI, est disponible pour les clients via Amazon SageMaker JumpStart à déployer en un clic pour exécuter l'inférence. Le LLM Mixtral-8x7B est un mélange clairsemé pré-entraîné de modèles experts, basé sur une structure de 7 milliards de paramètres avec huit experts par couche de rétroaction. Vous pouvez essayer ce modèle avec SageMaker JumpStart, un hub d'apprentissage automatique (ML) qui donne accès à des algorithmes et des modèles afin que vous puissiez rapidement démarrer avec le ML. Dans cet article, nous expliquons comment découvrir et déployer le modèle Mixtral-8x7B.

Qu'est-ce que Mixtral-8x7B

Mixtral-8x7B est un modèle de base développé par Mistral AI, prenant en charge les textes en anglais, français, allemand, italien et espagnol, avec des capacités de génération de code. Il prend en charge une variété de cas d'utilisation tels que le résumé de texte, la classification, la complétion de texte et la complétion de code. Il se comporte bien en mode chat. Pour démontrer la simplicité de personnalisation du modèle, Mistral AI a également publié un modèle Mixtral-8x7B-instruct pour les cas d'utilisation du chat, affiné à l'aide d'une variété d'ensembles de données de conversation accessibles au public. Les modèles Mixtral ont une grande longueur de contexte pouvant atteindre 32,000 XNUMX jetons.

Mixtral-8x7B offre des améliorations significatives des performances par rapport aux modèles de pointe précédents. Son mélange d'architecture d'experts lui permet d'obtenir de meilleurs résultats de performances sur 9 des 12 tests de traitement du langage naturel (NLP) testés par IA Mistral. Mixtral égale ou dépasse les performances des modèles jusqu'à 10 fois sa taille. En utilisant seulement une fraction des paramètres par jeton, il atteint des vitesses d'inférence plus rapides et un coût de calcul inférieur à celui des modèles denses de tailles équivalentes (par exemple, avec 46.7 milliards de paramètres au total mais seulement 12.9 milliards utilisés par jeton). Cette combinaison de hautes performances, de prise en charge multilingue et d'efficacité informatique fait de Mixtral-8x7B un choix attrayant pour les applications PNL.

Le modèle est mis à disposition sous la licence permissive Apache 2.0, pour une utilisation sans restrictions.

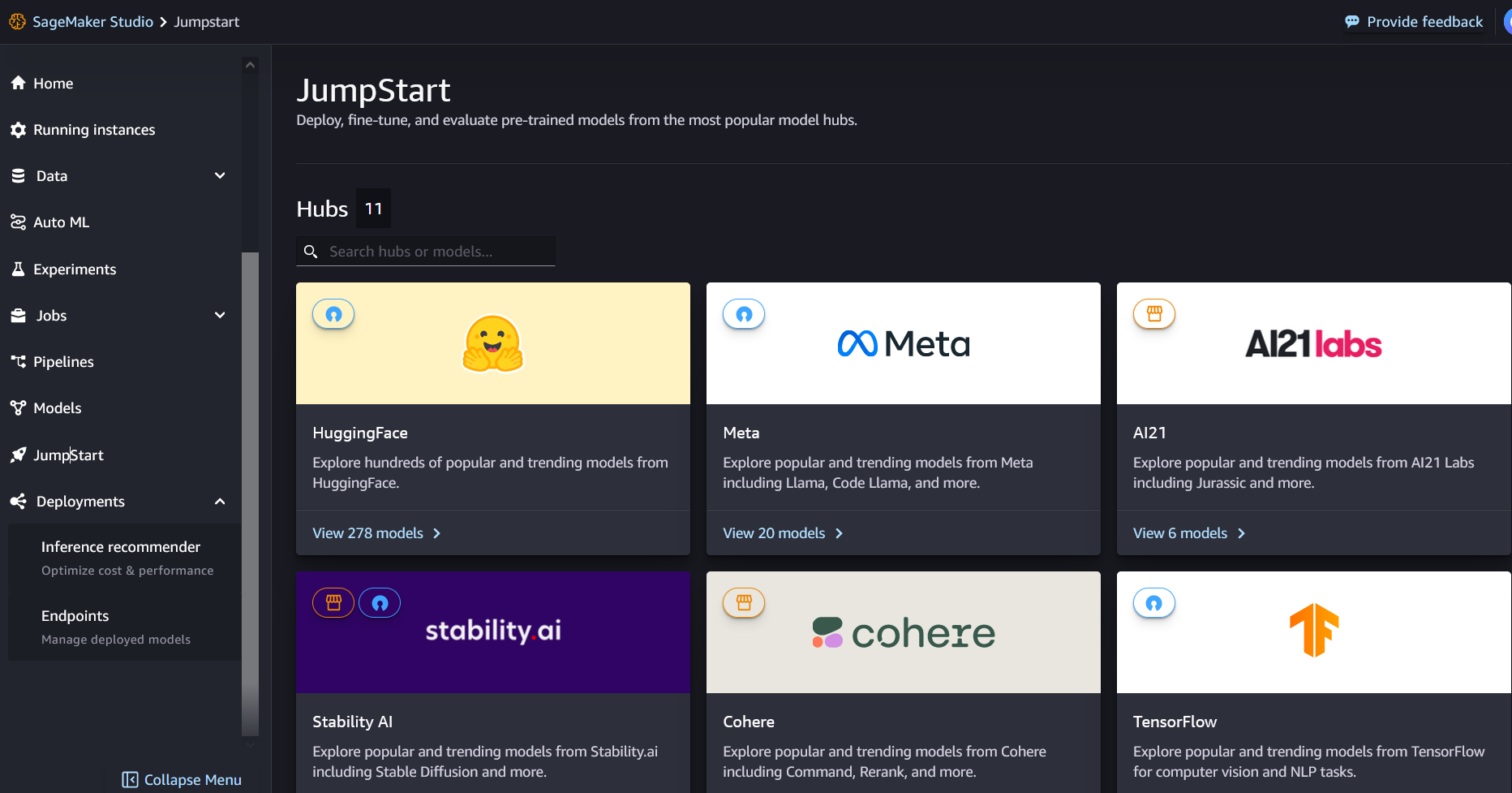

Qu'est-ce que SageMaker JumpStart

Avec SageMaker JumpStart, les praticiens du ML peuvent choisir parmi une liste croissante de modèles de fondation les plus performants. Les praticiens du ML peuvent déployer des modèles de base sur des sites dédiés. Amazon Sage Maker instances dans un environnement isolé en réseau et personnalisez les modèles à l'aide de SageMaker pour la formation et le déploiement des modèles.

Vous pouvez désormais découvrir et déployer Mixtral-8x7B en quelques clics Amazon SageMakerStudio ou par programmation via le SDK SageMaker Python, vous permettant de dériver les performances du modèle et les contrôles MLOps avec des fonctionnalités SageMaker telles que Pipelines Amazon SageMaker, Débogueur Amazon SageMakerou les journaux de conteneur. Le modèle est déployé dans un environnement sécurisé AWS et sous les contrôles de votre VPC, contribuant ainsi à garantir la sécurité des données.

Découvrez les modèles

Vous pouvez accéder aux modèles de base Mixtral-8x7B via SageMaker JumpStart dans l'interface utilisateur de SageMaker Studio et le SDK SageMaker Python. Dans cette section, nous expliquons comment découvrir les modèles dans SageMaker Studio.

SageMaker Studio est un environnement de développement intégré (IDE) qui fournit une interface visuelle Web unique où vous pouvez accéder à des outils spécialement conçus pour effectuer toutes les étapes de développement ML, de la préparation des données à la création, la formation et le déploiement de vos modèles ML. Pour plus de détails sur la façon de démarrer et de configurer SageMaker Studio, reportez-vous à Amazon SageMakerStudio.

Dans SageMaker Studio, vous pouvez accéder à SageMaker JumpStart en choisissant Début de saut dans le volet de navigation.

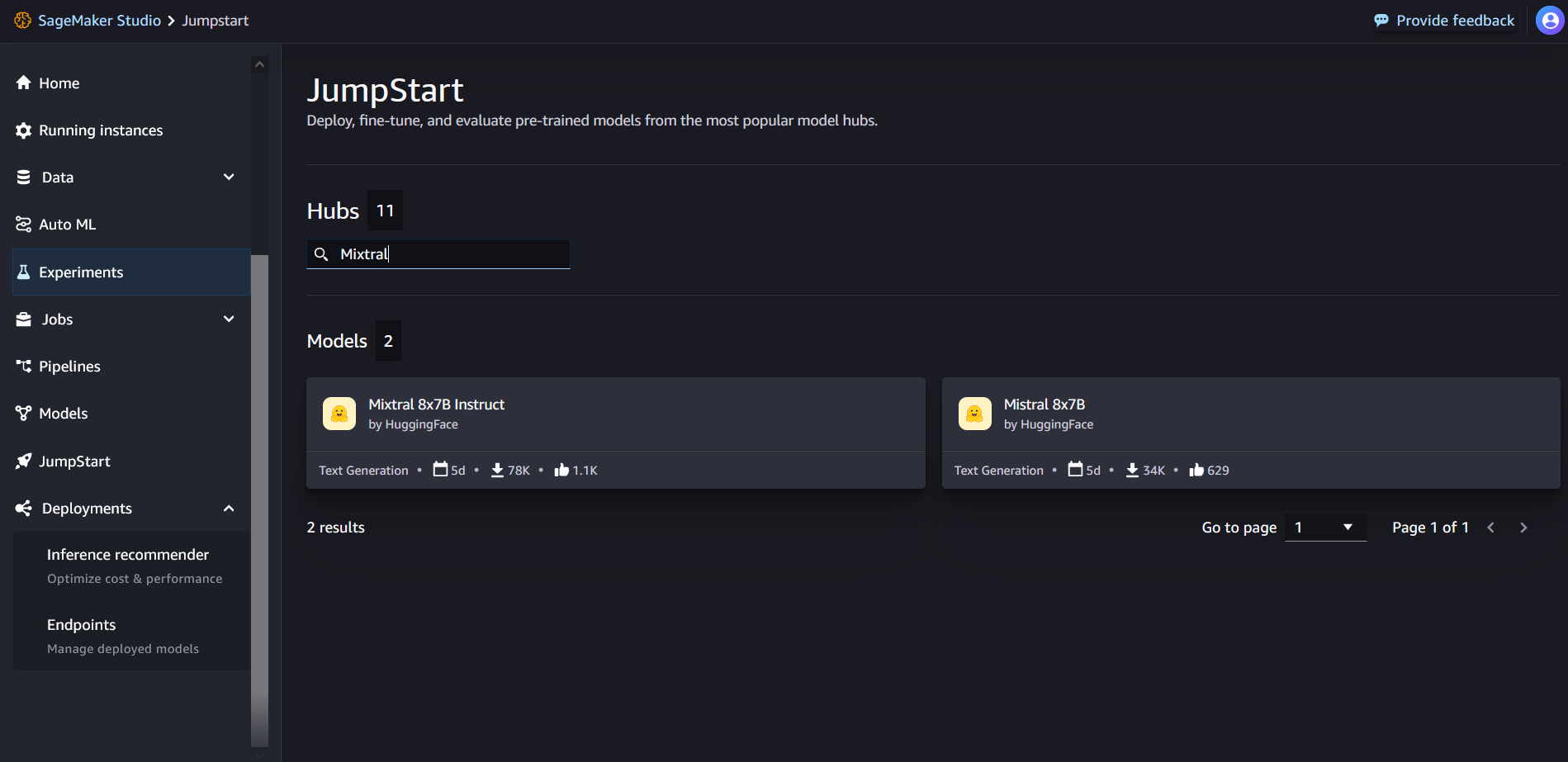

Depuis la page de destination de SageMaker JumpStart, vous pouvez rechercher « Mixtral » dans la zone de recherche. Vous verrez les résultats de recherche montrant Mixtral 8x7B et Mixtral 8x7B Instruct.

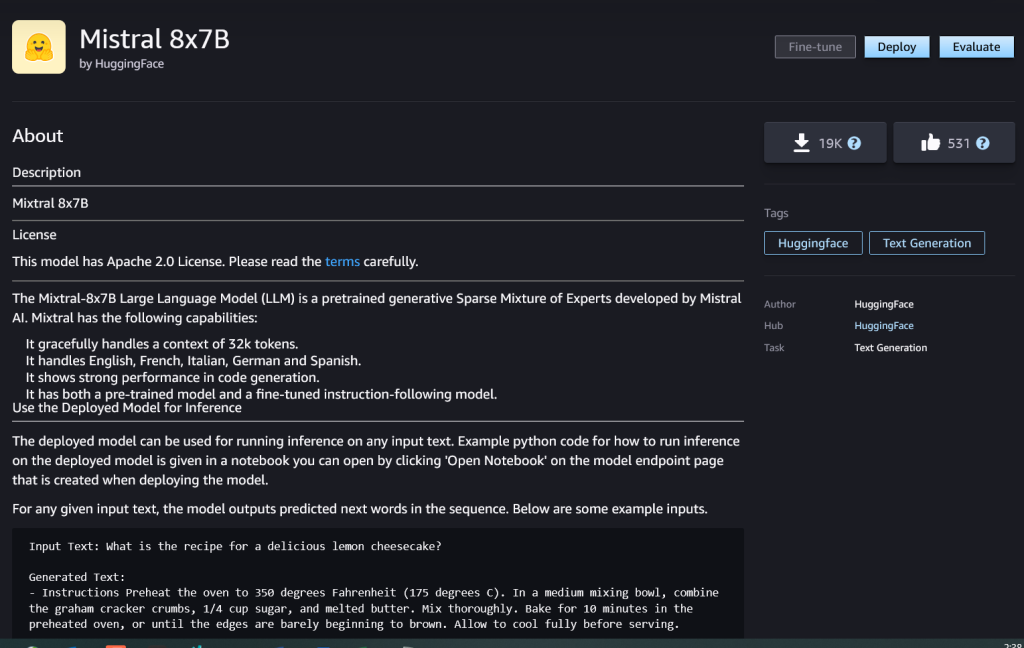

Vous pouvez choisir la fiche de modèle pour afficher les détails du modèle, tels que la licence, les données utilisées pour l'entraînement et la manière de l'utiliser. Vous trouverez également le Déployer , que vous pouvez utiliser pour déployer le modèle et créer un point de terminaison.

Déployer un modèle

Le déploiement commence lorsque vous choisissez Déployer. Une fois le déploiement terminé, un point de terminaison a été créé. Vous pouvez tester le point de terminaison en transmettant un exemple de charge utile de demande d'inférence ou en sélectionnant votre option de test à l'aide du SDK. Lorsque vous sélectionnez l'option d'utilisation du SDK, vous verrez un exemple de code que vous pouvez utiliser dans votre éditeur de bloc-notes préféré dans SageMaker Studio.

Pour déployer à l'aide du SDK, nous commençons par sélectionner le modèle Mixtral-8x7B, spécifié par le model_id with value huggingface-llm-mixtral-8x7b. Vous pouvez déployer n'importe lequel des modèles sélectionnés sur SageMaker avec le code suivant. De même, vous pouvez déployer l'instruction Mixtral-8x7B en utilisant son propre ID de modèle :

Cela déploie le modèle sur SageMaker avec les configurations par défaut, y compris le type d'instance par défaut et les configurations VPC par défaut. Vous pouvez modifier ces configurations en spécifiant des valeurs autres que celles par défaut dans Modèle JumpStart.

Une fois déployé, vous pouvez exécuter une inférence sur le point de terminaison déployé via le prédicteur SageMaker :

Exemples d'invites

Vous pouvez interagir avec un modèle Mixtral-8x7B comme n'importe quel modèle de génération de texte standard, dans lequel le modèle traite une séquence d'entrée et génère les mots suivants prédits dans la séquence. Dans cette section, nous fournissons des exemples d'invites.

Génération de code

En utilisant l'exemple précédent, nous pouvons utiliser des invites de génération de code comme celles-ci :

Vous obtenez la sortie suivante:

Invite d'analyse des sentiments

Vous pouvez effectuer une analyse des sentiments à l'aide d'une invite comme celle-ci avec Mixtral 8x7B :

Vous obtenez la sortie suivante:

Invites de réponse aux questions

Vous pouvez utiliser une invite de réponse aux questions comme celle-ci avec Mixtral-8x7B :

Vous obtenez la sortie suivante:

Instruction Mixtral-8x7B

La version optimisée pour les instructions de Mixtral-8x7B accepte les instructions formatées dans lesquelles les rôles de conversation doivent commencer par une invite utilisateur et alterner entre les instructions utilisateur et l'assistant (réponse modèle). Le format des instructions doit être strictement respecté, sinon le modèle générera des résultats sous-optimaux. Le modèle utilisé pour créer une invite pour le modèle Instruct est défini comme suit :

Notez que <s> et de </s> sont des jetons spéciaux pour le début de chaîne (BOS) et la fin de chaîne (EOS), alors que [INST] et de [/INST] sont des chaînes régulières.

Le code suivant montre comment formater l'invite au format instruction :

Récupération de connaissances

Vous pouvez utiliser le code suivant pour une invite de récupération de connaissances :

Vous obtenez la sortie suivante:

Codage

Les modèles Mixtral peuvent démontrer des atouts comparés pour les tâches de codage, comme le montre le code suivant :

Mathématiques et raisonnement

Les modèles mixtes font également état de points forts en termes de précision mathématique :

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :possède

- :est

- :ne pas

- :où

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- capacités

- A Propos

- au dessus de

- accélérer

- Accepte

- accès

- hybrides

- précision

- atteindre

- Atteint

- à travers

- infection

- ajoutée

- ajoutant

- Après

- à opposer à

- AI

- AI / ML

- algorithmes

- Tous

- aussi

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- montant

- an

- selon une analyse de l’Université de Princeton

- et de

- et infrastructure

- Annoncer

- répondre

- tous

- Apache

- attirant

- applications

- appliqué

- Application

- architecture

- SONT

- argument

- article

- AS

- Assistante gérante

- At

- disponibles

- AWS

- RETOUR

- Colonne vertébrale

- basé

- bash

- batterie

- Bayésien

- BE

- car

- était

- before

- Début

- croit

- Bell

- référencé

- repères

- Améliorée

- jusqu'à XNUMX fois

- Projet de loi

- facturation

- Milliards

- goupille

- acheté

- Box

- Pause

- apporter

- construire

- Développement

- intégré

- la performance des entreprises

- mais

- by

- calculer

- Appelez-nous

- appelé

- Appels

- CAN

- carte

- maisons

- cas

- Change

- le chat

- le choix

- Selectionnez

- choose

- Chris

- classification

- cliquez

- code

- Codage

- combinaison

- par rapport

- compilé

- achèvement

- calcul

- calcul

- ordinateur

- Vision par ordinateur

- conférences

- constamment

- Contenant

- contenu

- contexte

- continue

- continuellement

- contrôles

- Conversation

- Prix

- Costs

- pourriez

- engendrent

- créée

- crucial

- Coupe

- Courant

- Clients

- personnalisation

- personnaliser

- données

- la sécurité des données

- ensembles de données

- journée

- jours

- dévoué

- Réglage par défaut

- défini

- Démocratiser

- démontrer

- déployer

- déployé

- déployer

- déploiement

- déploie

- dériver

- détails

- développer

- développé

- Développeur

- Développement

- DICT

- DID

- découvrez

- do

- dollars

- domaines

- fait

- down

- Goutte

- Duc

- université de Duke

- chacun

- Économique

- éditeur

- efficace

- œufs

- d'autre

- permettre

- permet

- permettant

- fin

- Endpoint

- ENGINEERING

- Anglais

- assurer

- Environment

- EOS

- égal

- Équivalent

- éthique

- exemple

- dépasse

- excité

- à l'exclusion

- expert

- de santé

- Expliquer

- explication

- extension

- famille

- plus rapide

- Fonctionnalités:

- few

- Fichiers

- filtres

- Trouvez

- Prénom

- Abonnement

- suit

- Pour

- le format

- Fondation

- fraction

- Français

- De

- fonction

- avenir

- à usage général

- générer

- généré

- génération

- génératif

- IA générative

- Allemand

- obtenez

- Go

- Bien

- eu

- Croissance

- haine

- Vous avez

- he

- aider

- aider

- aide

- ici

- ici

- Haute

- Hills

- sa

- Comment

- How To

- HTML

- HTTPS

- Moyeu

- i

- VÉLO

- crème glacée

- ID

- if

- Illinois

- maladie

- importer

- important

- améliorer

- améliorations

- in

- comprendre

- Y compris

- Incorporée

- Infrastructure

- contribution

- entrées

- instance

- Des instructions

- intégrer

- des services

- interagir

- intérêts

- Interfaces

- A inventé

- isolé

- IT

- italien

- SES

- lui-même

- jpg

- enfants

- spécialisées

- kyle

- Labs

- atterrissage

- langue

- gros

- Nom

- couche

- Conduit

- apprentissage

- Longueur

- laisser

- Licence

- comme

- aime

- limites

- LINK

- Liste

- Écoute

- peu

- LLM

- logique

- recherchez-

- baisser

- click

- machine learning

- LES PLANTES

- FAIT DU

- Fabrication

- manager

- de nombreuses

- allumettes

- math

- mathématiques

- me

- moyenne

- mélange

- ML

- MLOps

- Mode

- modèle

- numériques jumeaux (digital twin models)

- modifié

- Mois

- PLUS

- moto

- beaucoup

- multiplié

- Musique

- must

- my

- Nature

- Traitement du langage naturel

- Navigation

- négatif

- réseau et

- Neutri

- Nouveauté

- next

- nlp

- Aucun

- noter

- cahier

- maintenant

- nombre

- of

- Huile

- on

- une fois

- ONE

- uniquement

- d'exploitation

- le système d'exploitation

- Option

- or

- Autre

- autrement

- ande

- sortie

- sorties

- au contrôle

- plus de

- propre

- page

- payé

- pain

- papiers

- paramètre

- paramètres

- En passant

- passion

- passionné

- chemins

- /

- Effectuer

- performant

- phd

- Téléphone

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- portable

- positif

- Post

- précédant

- prédit

- Predictor

- préféré

- en train de préparer

- précédent

- Directeur

- Imprimé

- de procédure

- processus

- les process

- traitement

- Produit

- Programme

- Programmation

- instructions

- prospérité

- fournir

- fournisseurs

- fournit

- publiquement

- publié

- Python

- Trimestre

- question

- vite.

- RE

- en cours

- recette

- Récursif

- réduire

- reportez-vous

- Standard

- libéré

- rapport

- nécessaire

- un article

- chercheur

- Resources

- respecté

- réponse

- responsables

- restrictions

- résultat

- Résultats

- retourner

- Retours

- équitation

- Analyse

- Rôle

- rôle

- Salle

- Courir

- pour le running

- s

- SA

- sagemaker

- sel

- évolutive

- Escaliers intérieurs

- Sciences

- Scientifique

- Sdk

- Rechercher

- Section

- sécurisé

- sécurité

- sur le lien

- Sélectionner

- choisi

- la sélection

- sélection

- supérieur

- sentiment

- séparé

- Séquence

- Série

- Services

- set

- montré

- montré

- Spectacles

- significative

- De même

- étapes

- depuis

- unique

- Taille

- So

- Réseaux sociaux

- Société

- Logiciels

- sur mesure

- Espagnol

- spécial

- spécialiste

- spécifié

- vitesses

- Dépenses

- Standard

- Commencer

- j'ai commencé

- départs

- state-of-the-art

- statistique

- étapes

- Étapes

- Encore

- arrêté

- Boutique

- simple

- Stratégique

- courant

- forces

- Chaîne

- structuré

- studio

- tel

- Support

- Appuyer

- Les soutiens

- combustion propre

- prend

- tâches

- clés

- équipe

- Technologie

- modèle

- tester

- examiné

- Essais

- texte

- qui

- La

- El futuro

- puis

- Ces

- l'ont

- this

- Avec

- fiable

- Des séries chronologiques

- fois

- à

- ensemble

- jeton

- Tokens

- trop

- les outils

- Total

- Train

- Formation

- oui

- Essai

- Tweet

- type

- ui

- sous

- université

- unix

- ouvrir

- jusqu'à

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- Usages

- en utilisant

- Utilisant

- Vallée

- Plus-value

- Valeurs

- variété

- version

- Vidéo

- Voir

- vision

- Visiter

- visuel

- marcher

- était

- Eau

- we

- web

- services Web

- Basé sur le Web

- WELL

- Quoi

- Qu’est ce qu'

- quand

- Les

- qui

- blanc

- WHO

- sera

- comprenant

- dans les

- sans

- des mots

- activités principales

- pourra

- écrire

- code écrit

- Vous n'avez

- Votre

- zéphyrnet

Rachna Chadha est architecte principal de solutions AI/ML dans les comptes stratégiques chez AWS. Rachna est une optimiste qui croit qu'une utilisation éthique et responsable de l'IA peut améliorer la société à l'avenir et apporter la prospérité économique et sociale. Dans ses temps libres, Rachna aime passer du temps avec sa famille, faire de la randonnée et écouter de la musique.

Rachna Chadha est architecte principal de solutions AI/ML dans les comptes stratégiques chez AWS. Rachna est une optimiste qui croit qu'une utilisation éthique et responsable de l'IA peut améliorer la société à l'avenir et apporter la prospérité économique et sociale. Dans ses temps libres, Rachna aime passer du temps avec sa famille, faire de la randonnée et écouter de la musique. Dr Kyle Ulrich est un scientifique appliqué avec le

Dr Kyle Ulrich est un scientifique appliqué avec le  Christophe Whitten est un développeur de logiciels au sein de l'équipe JumpStart. Il aide à mettre à l'échelle la sélection de modèles et à intégrer des modèles avec d'autres services SageMaker. Chris est passionné par l'accélération de l'omniprésence de l'IA dans une variété de domaines commerciaux.

Christophe Whitten est un développeur de logiciels au sein de l'équipe JumpStart. Il aide à mettre à l'échelle la sélection de modèles et à intégrer des modèles avec d'autres services SageMaker. Chris est passionné par l'accélération de l'omniprésence de l'IA dans une variété de domaines commerciaux. Dr Fabio Nonato de Paula est un directeur principal chez Specialist GenAI SA, qui aide les fournisseurs de modèles et les clients à faire évoluer l'IA générative dans AWS. Fabio a une passion pour démocratiser l’accès à la technologie d’IA générative. En dehors du travail, vous pouvez trouver Fabio conduisant sa moto dans les collines de la vallée de Sonoma ou lisant ComiXology.

Dr Fabio Nonato de Paula est un directeur principal chez Specialist GenAI SA, qui aide les fournisseurs de modèles et les clients à faire évoluer l'IA générative dans AWS. Fabio a une passion pour démocratiser l’accès à la technologie d’IA générative. En dehors du travail, vous pouvez trouver Fabio conduisant sa moto dans les collines de la vallée de Sonoma ou lisant ComiXology. Dr Ashish Khetan est un scientifique appliqué senior avec les algorithmes intégrés d'Amazon SageMaker et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP.

Dr Ashish Khetan est un scientifique appliqué senior avec les algorithmes intégrés d'Amazon SageMaker et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP. Karl Albertsen dirige les produits, l'ingénierie et la science pour les algorithmes Amazon SageMaker et JumpStart, le centre d'apprentissage automatique de SageMaker. Il est passionné par l'application de l'apprentissage automatique pour libérer de la valeur commerciale.

Karl Albertsen dirige les produits, l'ingénierie et la science pour les algorithmes Amazon SageMaker et JumpStart, le centre d'apprentissage automatique de SageMaker. Il est passionné par l'application de l'apprentissage automatique pour libérer de la valeur commerciale.