Les communautés en ligne stimulent l'engagement des utilisateurs dans des secteurs tels que les jeux, les médias sociaux, le commerce électronique, les rencontres et l'apprentissage en ligne. Les membres de ces communautés en ligne font confiance aux propriétaires de plateformes pour leur fournir un environnement sûr et inclusif dans lequel ils peuvent librement consommer du contenu et contribuer. Les modérateurs de contenu sont souvent employés pour examiner le contenu généré par les utilisateurs et vérifier qu'il est sûr et conforme à vos conditions d'utilisation. Cependant, l’ampleur, la complexité et la variété toujours croissantes des contenus inappropriés rendent les flux de travail de modération humaine non évolutifs et coûteux. Le résultat est des communautés pauvres, nuisibles et non inclusives qui désengagent les utilisateurs et ont un impact négatif sur la communauté et les entreprises.

Parallèlement au contenu généré par les utilisateurs, le contenu généré par les machines a posé un nouveau défi à la modération du contenu. Il crée automatiquement un contenu très réaliste qui peut être inapproprié ou nuisible à grande échelle. L'industrie est confrontée au nouveau défi consistant à modérer automatiquement le contenu généré par l'IA pour protéger les utilisateurs contre les contenus nuisibles.

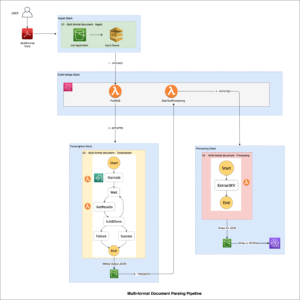

Dans cet article, nous présentons la détection de toxicité, une nouvelle fonctionnalité de Amazon comprendre qui vous aide à détecter automatiquement le contenu nuisible dans le texte généré par l'utilisateur ou la machine. Cela inclut le texte brut, le texte extrait d’images et le texte transcrit à partir de contenu audio ou vidéo.

Détectez la toxicité dans le contenu textuel avec Amazon Comprehend

Amazon Comprehend est un service de traitement du langage naturel (NLP) qui utilise l'apprentissage automatique (ML) pour découvrir des informations et des connexions précieuses dans le texte. Il propose une gamme de modèles ML qui peuvent être pré-entraînés ou personnalisés via des interfaces API. Amazon Comprehend propose désormais une solution simple, basée sur le NLP, pour la détection du contenu toxique dans le texte.

L'API Amazon Comprehend Toxicity Detection attribue un score de toxicité global au contenu du texte, allant de 0 à 1, indiquant la probabilité qu'il soit toxique. Il classe également le texte dans les sept catégories suivantes et fournit un score de confiance pour chacune :

- HATE_SPEECH – Discours qui critique, insulte, dénonce ou déshumanise une personne ou un groupe sur la base d’une identité, qu’il s’agisse de race, d’origine ethnique, d’identité de genre, de religion, d’orientation sexuelle, de capacité, d’origine nationale ou d’un autre groupe identitaire.

- GRAPHIQUE – Discours utilisant des images visuellement descriptives, détaillées et désagréablement vives. Un tel langage est souvent verbeux afin d'amplifier une insulte, un inconfort ou un préjudice pour le destinataire.

- HARASSMENT_OR_ABUSE – Un discours qui impose une dynamique de pouvoir perturbatrice entre le locuteur et l’auditeur (quelle que soit l’intention), cherche à affecter le bien-être psychologique du destinataire ou objective une personne.

- SEXUELLE – Discours qui indique un intérêt, une activité ou une excitation sexuelle en utilisant des références directes ou indirectes à des parties du corps, des traits physiques ou du sexe.

- VIOLENCE_OR_THREAT – Discours incluant des menaces visant à infliger de la douleur, des blessures ou de l’hostilité à l’égard d’une personne ou d’un groupe.

- INSULTER – Discours comportant un langage humiliant, humiliant, moqueur, insultant ou dépréciant.

- IMPIÉTÉ – Discours contenant des mots, des phrases ou des acronymes impoli, vulgaire ou offensant.

Vous pouvez accéder à l'API de détection de toxicité en l'appelant directement à l'aide du Interface de ligne de commande AWS (AWS CLI) et les kits SDK AWS. La détection de toxicité dans Amazon Comprehend est actuellement prise en charge en anglais.

Les cas d'utilisation

La modération du texte joue un rôle crucial dans la gestion du contenu généré par les utilisateurs dans divers formats, notamment les publications sur les réseaux sociaux, les messages de chat en ligne, les discussions sur les forums, les commentaires sur les sites Web, etc. De plus, les plateformes qui acceptent le contenu vidéo et audio peuvent utiliser cette fonctionnalité pour modérer le contenu audio transcrit.

L’émergence de l’IA générative et des grands modèles linguistiques (LLM) représente la dernière tendance dans le domaine de l’IA. Par conséquent, il existe un besoin croissant de solutions réactives pour modérer le contenu généré par les LLM. L'API Amazon Comprehend Toxicity Detection est parfaitement adaptée pour répondre à ce besoin.

Demande d'API de détection de toxicité Amazon Comprehend

Vous pouvez envoyer jusqu'à 10 segments de texte à l'API de détection de toxicité, chacun avec une taille limite de 1 Ko. Chaque segment de texte de la demande est traité indépendamment. Dans l'exemple suivant, nous générons un fichier JSON nommé toxicity_api_input.json contenant le contenu du texte, y compris trois exemples de segments de texte pour la modération. Notez que dans l’exemple, les mots profanes sont masqués en XXXX.

Vous pouvez utiliser l'AWS CLI pour appeler l'API de détection de toxicité à l'aide du fichier JSON précédent contenant le contenu textuel :

Réponse de l'API de détection de toxicité Amazon Comprehend

La sortie JSON de la réponse de l'API de détection de toxicité inclura le résultat de l'analyse de toxicité dans le fichier ResultList champ. ResultList répertorie les éléments de segment de texte et la séquence représente l'ordre dans lequel les séquences de texte ont été reçues dans la requête API. La toxicité représente le score de confiance global de détection (entre 0 et 1). Les étiquettes comprennent une liste d'étiquettes de toxicité avec des scores de confiance, classées par type de toxicité.

Le code suivant montre la réponse JSON de l'API de détection de toxicité basée sur l'exemple de requête de la section précédente :

Dans le JSON précédent, le premier segment de texte est considéré comme sûr avec un faible score de toxicité. Cependant, les deuxième et troisième segments de texte ont reçu des scores de toxicité de 73 % et 98 %, respectivement. Pour le deuxième segment, Amazon Comprehend détecte un score de toxicité élevé pour VIOLENCE_OR_THREAT; pour le troisième segment, il détecte PROFANITY avec un score de toxicité élevé.

Exemple de requête utilisant le SDK Python

L'extrait de code suivant montre comment utiliser le SDK Python pour appeler l'API de détection de toxicité. Ce code reçoit la même réponse JSON que la commande AWS CLI illustrée précédemment.

Résumé

Dans cet article, nous avons fourni un aperçu de la nouvelle API de détection de toxicité Amazon Comprehend. Nous avons également décrit comment analyser la réponse API JSON. Pour plus d'informations, reportez-vous à Comprendre le document API.

La détection de toxicité Amazon Comprehend est désormais généralement disponible dans quatre régions : us-east-1, us-west-2, eu-west-1 et ap-southeast-2.

Pour en savoir plus sur la modération du contenu, consultez Conseils pour la modération de contenu sur AWS. Faites le premier pas vers rationaliser vos opérations de modération de contenu avec AWS.

À propos des auteurs

Lana Zhang est architecte de solutions senior au sein de l'équipe AWS WWSO AI Services, spécialisée dans l'IA et le ML pour la modération de contenu, la vision par ordinateur, le traitement du langage naturel et l'IA générative. Grâce à son expertise, elle se consacre à la promotion des solutions AWS AI/ML et à aider les clients à transformer leurs solutions commerciales dans divers secteurs, notamment les médias sociaux, les jeux, le commerce électronique, les médias, la publicité et le marketing.

Lana Zhang est architecte de solutions senior au sein de l'équipe AWS WWSO AI Services, spécialisée dans l'IA et le ML pour la modération de contenu, la vision par ordinateur, le traitement du langage naturel et l'IA générative. Grâce à son expertise, elle se consacre à la promotion des solutions AWS AI/ML et à aider les clients à transformer leurs solutions commerciales dans divers secteurs, notamment les médias sociaux, les jeux, le commerce électronique, les médias, la publicité et le marketing.

Ravisha SK est chef de produit senior, technique chez AWS, avec un accent sur l'IA/ML. Elle possède plus de 10 ans d’expérience en analyse de données et en apprentissage automatique dans différents domaines. Dans ses temps libres, elle aime lire, expérimenter en cuisine et découvrir de nouveaux cafés.

Ravisha SK est chef de produit senior, technique chez AWS, avec un accent sur l'IA/ML. Elle possède plus de 10 ans d’expérience en analyse de données et en apprentissage automatique dans différents domaines. Dans ses temps libres, elle aime lire, expérimenter en cuisine et découvrir de nouveaux cafés.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/flag-harmful-content-using-amazon-comprehend-toxicity-detection/

- :possède

- :est

- :où

- $UP

- 1

- 10

- 100

- 118

- 12

- 13

- 54

- 7

- a

- capacité

- A Propos

- Accepter

- accès

- à travers

- activité

- adresser

- Numérique

- affecter

- AI

- Services d'IA

- AI / ML

- aussi

- Amazon

- Amazon comprendre

- Amazon Web Services

- amplifier

- an

- selon une analyse de l’Université de Princeton

- analytique

- ainsi que

- Une autre

- api

- SONT

- AS

- assistant

- At

- acoustique

- auteur

- automatiquement

- disponibles

- AWS

- basé

- base

- BE

- va

- jusqu'à XNUMX fois

- corps

- Apporté

- la performance des entreprises

- by

- Appelez-nous

- appel

- CAN

- catégories

- challenge

- vérifier

- client

- code

- Café

- commentaires

- Communautés

- Communautés

- complexité

- comprendre

- ordinateur

- Vision par ordinateur

- confiance

- Connexions

- par conséquent

- considéré

- consommer

- contient

- contenu

- contribuer

- crée des

- Critique

- crucial

- Lecture

- Clients

- sont adaptées

- données

- Analyse de Donnée

- Rencontres

- dévoué

- démontré

- démontre

- décrit

- détaillé

- détecter

- Détection

- didn

- différent

- directement

- discussions

- perturbateur

- plusieurs

- document

- faire

- domaines

- Porte

- conduite

- dynamique

- e-commerce

- chacun

- Plus tôt

- e-commerce

- non plus

- émergence

- employés

- participation

- Anglais

- Environment

- ethnicité

- de plus en plus

- Chaque

- exemple

- cher

- d'experience

- nous a permis de concevoir

- Explorer

- Fonctionnalité

- champ

- Déposez votre dernière attestation

- Prénom

- Focus

- Abonnement

- Pour

- Forum

- quatre

- fraiche entreprise

- De

- jeux

- Sexe

- généralement

- générer

- généré

- génératif

- IA générative

- Go

- Graphique

- Réservation de groupe

- Croissance

- nuire

- nuisible

- he

- aide

- ici

- Haute

- très

- lui

- Comment

- How To

- Cependant

- http

- HTTPS

- humain

- i

- idéalement

- Identite

- satellite

- Impact

- importer

- in

- comprendre

- inclut

- Y compris

- Compris

- indépendamment

- indique

- secteurs

- industrie

- infliger

- d'information

- blessure

- idées.

- Insulter

- intention

- intérêt

- interfaces

- développement

- introduire

- IT

- articles

- jpg

- json

- Etiquettes

- langue

- gros

- Nouveautés

- APPRENTISSAGE

- apprentissage

- comme

- probabilité

- LIMIT

- Gamme

- Liste

- Liste

- Faible

- click

- machine learning

- LES PLANTES

- FAIT DU

- man

- manager

- les gérer

- Stratégie

- Matériel

- Mai..

- Médias

- Membres

- messages

- ML

- numériques jumeaux (digital twin models)

- modération

- PLUS

- Par ailleurs

- prénom

- Nommé

- Nationales

- Nature

- Traitement du langage naturel

- Besoin

- négativement

- Nouveauté

- nlp

- maintenant

- objet

- of

- offensive

- Offres Speciales

- souvent

- on

- en ligne

- communautés en ligne

- Opérations

- or

- de commander

- origine

- sortie

- plus de

- global

- vue d'ensemble

- propriétaires

- Pain

- les pièces

- personne

- les expressions clés

- Physique

- Plaine

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Jouez

- joue

- pauvres

- Post

- Poteaux

- power

- précédent

- traitement

- Produit

- chef de produit

- IMPIÉTÉ

- la promotion de

- protéger

- fournir

- à condition de

- fournit

- psychologique

- Python

- Race

- gamme

- allant

- en cours

- réaliste

- reçu

- reçoit

- reportez-vous

- Indépendamment

- régions

- religion

- représente

- nécessaire

- respectivement

- réponse

- sensible

- résultat

- Avis

- bon

- Rôle

- s

- des

- même

- Escaliers intérieurs

- But

- Sdk

- SDK

- Deuxièmement

- Section

- Chercher

- Cherche

- clignotant

- segments

- envoyer

- supérieur

- Séquence

- service

- Services

- Session

- sept

- Relations sexuelles

- Sexuel

- elle

- magasins

- Spectacles

- Taille

- Fragment

- So

- Réseaux sociaux

- réseaux sociaux

- Publications sur les réseaux sociaux

- sur mesure

- Solutions

- Speaker

- spécialisation

- discours

- étapes

- simple

- tel

- Appareils

- Prenez

- équipe

- Technique

- conditions

- texte

- qui

- La

- leur

- Là.

- Ces

- l'ont

- Troisièmement

- this

- des menaces

- trois

- Avec

- fiable

- à

- vers

- transformer

- Trend

- La confiance

- type

- devoiler

- utilisé

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- utiliser

- Précieux

- variété

- Vidéo

- vision

- visuellement

- vif

- vulgaire

- souhaitez

- we

- web

- services Web

- Site Web

- ont été

- Quoi

- qui

- why

- sera

- comprenant

- des mots

- workflows

- années

- Vous n'avez

- Votre

- zéphyrnet