Le résumé est la technique permettant de condenser des informations volumineuses sous une forme compacte et significative, et constitue la pierre angulaire d'une communication efficace à notre époque riche en informations. Dans un monde rempli de données, résumer de longs textes en brefs résumés permet de gagner du temps et aide à prendre des décisions éclairées. Le résumé condense le contenu, ce qui permet de gagner du temps et d'améliorer la clarté en présentant les informations de manière concise et cohérente. La synthèse est inestimable pour la prise de décision et la gestion de grands volumes de contenu.

Les méthodes de synthèse ont un large éventail d'applications répondant à divers objectifs, tels que :

- Agrégation de nouvelles - Agrégation de nouvelles consiste à résumer des articles de presse dans un bulletin d'information destiné à l'industrie des médias

- Résumé des documents juridiques - Résumé des documents juridiques aide les professionnels du droit à extraire des informations juridiques clés à partir de documents volumineux tels que les termes, conditions et contrats

- Recherche académique – La synthèse annote, indexe, condense et simplifie les informations importantes provenant d’articles universitaires

- Curation de contenu pour blogs et sites Web – Vous pouvez créer des résumés de contenu engageants et originaux pour les lecteurs, notamment en marketing

- Rapports financiers et analyses de marché – Vous pouvez extraire aperçu financier à partir de rapports et créer des résumés pour les présentations aux investisseurs dans le secteur financier

Avec les progrès du traitement du langage naturel (NLP), des modèles linguistiques et de l’IA générative, la synthèse de textes de différentes longueurs est devenue plus accessible. Des outils comme LangChaîne, combiné à un grand modèle de langage (LLM) alimenté par Socle amazonien or Amazon SageMaker JumpStart, simplifiez le processus de mise en œuvre.

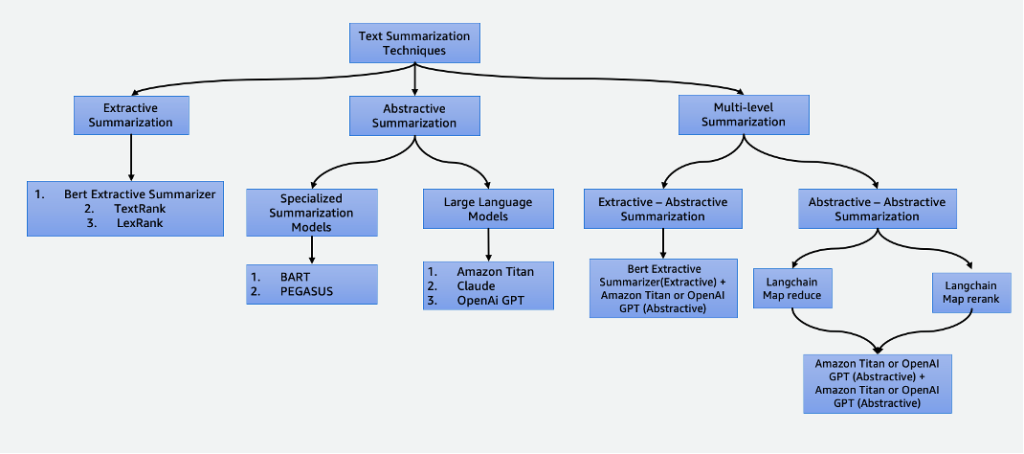

Cet article aborde les techniques de résumé suivantes :

- Résumé extractif à l'aide du résumeur extractif BERT

- Résumé abstrait à l'aide de modèles de résumé spécialisés et de LLM

- Deux techniques de synthèse multi-niveaux :

- Récapitulatif extractif-abstractif utilisant la stratégie de résumé de contenu extractif-abstractif (EACSS)

- Résumé abstractif-abstractif à l'aide de Map Reduction et Map ReRank

L'exemple de code complet se trouve dans le GitHub repo. Vous pouvez lancez cette solution in Amazon SageMakerStudio.

Cliquez ici pour ouvrir la console AWS et suivre.

Types de résumés

Il existe plusieurs techniques pour résumer un texte, qui sont globalement classées en deux approches principales : extractif ainsi que le abstrait récapitulation. De plus, les méthodologies de synthèse à plusieurs niveaux intègrent une série d'étapes, combinant des techniques extractives et abstraites. Ces approches multi-niveaux sont avantageuses lorsqu'il s'agit de texte avec des jetons plus longs que la limite d'un LLM, permettant une compréhension de récits complexes.

Résumé extractif

Le résumé extractif est une technique utilisée en PNL et en analyse de texte pour créer un résumé en extrayant des phrases clés. Au lieu de générer de nouvelles phrases ou de nouveaux contenus comme dans le résumé abstrait, le résumé extractif repose sur l'identification et l'extraction des parties les plus pertinentes et informatives du texte original pour créer une version condensée.

Le résumé extractif, bien qu'avantageux pour préserver le contenu original et garantir une grande lisibilité en extrayant directement les phrases importantes du texte source, présente des limites. Il manque de créativité, est incapable de générer des phrases nouvelles et peut négliger des détails nuancés, manquant ainsi potentiellement des informations importantes. De plus, il peut produire de longs résumés, submergeant parfois les lecteurs d'informations excessives et indésirables. Il existe de nombreuses techniques de synthèse extractive, telles que TextRang ainsi que le Classement Lex. Dans cet article, nous nous concentrons sur le résumé extractif BERT.

Récapitulateur extractif BERT

Les Récapitulateur extractif BERT est un type de modèle de synthèse extractive qui utilise le modèle de langage BERT pour extraire les phrases les plus importantes d'un texte. BERT est un modèle de langage pré-entraîné qui peut être affiné pour diverses tâches, y compris le résumé de texte. Cela fonctionne en intégrant d'abord les phrases dans le texte à l'aide de BERT. Cela produit une représentation vectorielle pour chaque phrase qui capture sa signification et son contexte. Le modèle utilise ensuite un algorithme de clustering pour regrouper les phrases en clusters. Les phrases les plus proches du centre de chaque cluster sont sélectionnées pour former le résumé.

Par rapport aux LLM, l'avantage du résumé extractif BERT est qu'il est relativement simple de former et de déployer le modèle et qu'il est plus explicable. L'inconvénient est que le résumé n'est pas créatif et ne génère pas de phrases. Il sélectionne uniquement les phrases du texte original. Cela limite sa capacité à résumer des textes complexes ou nuancés.

Résumé abstrait

Le résumé abstrait est une technique utilisée en PNL et en analyse de texte pour créer un résumé qui va au-delà de la simple extraction de phrases ou d'expressions du texte source. Au lieu de sélectionner et de réorganiser le contenu existant, le résumé abstrait génère de nouvelles phrases ou expressions qui capturent le sens principal et les idées principales du texte original sous une forme plus condensée et cohérente. Cette approche nécessite que le modèle comprenne le contenu du texte et l'exprime d'une manière qui n'est pas nécessairement présente dans le matériel source.

Modèles de synthèse spécialisés

Ces modèles de langage naturel pré-entraînés, tels que BART ainsi que le PEGASUS, sont spécialement conçus pour les tâches de résumé de texte. Ils utilisent des architectures codeur-décodeur et ont des paramètres plus petits que leurs homologues. Cette taille réduite facilite le réglage et le déploiement sur des instances plus petites. Cependant, il est important de noter que ces modèles de synthèse sont également dotés de tailles de jetons d'entrée et de sortie plus petites. Contrairement à leurs homologues plus généraux, ces modèles sont exclusivement conçus pour des tâches de synthèse. Par conséquent, l’entrée requise pour ces modèles est uniquement le texte qui doit être résumé.

Grands modèles de langage

A grand modèle de langage fait référence à tout modèle qui subit une formation sur des ensembles de données étendus et diversifiés, généralement par le biais d'un apprentissage auto-supervisé à grande échelle, et qui est capable d'être affiné pour s'adapter à un large éventail de tâches spécifiques en aval. Ces modèles ont une taille de paramètre plus grande et sont plus performants dans les tâches. Notamment, ils comportent des tailles de jetons d'entrée considérablement plus grandes, certains allant jusqu'à 100,000, comme celui d'Anthropic Claude. Pour utiliser l'un de ces modèles, AWS propose le service entièrement géré Amazon Bedrock. Si vous avez besoin de plus de contrôle sur le cycle de vie de développement du modèle, vous pouvez déployer des LLM via SageMaker.

Compte tenu de leur nature polyvalente, ces modèles nécessitent des instructions de tâches spécifiques fournies sous forme de texte de saisie, une pratique appelée ingénierie rapide. Ce processus créatif produit des résultats variables en fonction du type de modèle et du texte saisi. L'efficacité des performances du modèle et la qualité de l'invite influencent considérablement la qualité finale des résultats du modèle. Voici quelques conseils lorsque l’ingénierie vous demande un résumé :

- Inclure le texte pour résumer – Saisissez le texte qui doit être résumé. Ceci sert de matériau source pour le résumé.

- Définir la tâche – Indiquer clairement que l’objectif est la synthèse de texte. Par exemple, « Résumez le texte suivant : [texte de saisie] ».

- Fournir un contexte – Proposez une brève introduction ou un contexte pour le texte donné qui doit être résumé. Cela aide le modèle à comprendre le contenu et le contexte. Par exemple, « Vous recevez l'article suivant sur l'intelligence artificielle et son rôle dans les soins de santé : [texte de saisie] ».

- Demander le résumé – Inviter le modèle à générer un résumé du texte fourni. Soyez clair sur la longueur ou le format souhaité du résumé. Par exemple, « Veuillez générer un résumé concis de l'article donné sur l'intelligence artificielle et son rôle dans les soins de santé : [texte de saisie] ».

- Définir des contraintes ou des directives de longueur – Éventuellement, guidez la longueur du résumé en spécifiant le nombre de mots, le nombre de phrases ou la limite de caractères souhaités. Par exemple, « Veuillez générer un résumé ne dépassant pas 50 mots : [texte de saisie] ».

Une ingénierie rapide efficace est essentielle pour garantir que les résumés générés sont précis, pertinents et alignés sur la tâche de synthèse prévue. Affinez l'invite pour obtenir un résultat de synthèse optimal avec des expériences et des itérations. Après avoir établi l'efficacité des invites, vous pouvez les réutiliser à l'aide de modèles d'invite.

Résumé à plusieurs niveaux

Les résumés extractifs et abstractifs sont utiles pour les textes plus courts. Cependant, lorsque le texte saisi dépasse la limite maximale de jetons du modèle, une synthèse à plusieurs niveaux devient nécessaire. Le résumé à plusieurs niveaux implique une combinaison de diverses techniques de résumé, telles que des méthodes extractives et abstraites, pour condenser efficacement des textes plus longs en appliquant plusieurs couches de processus de résumé. Dans cette section, nous discutons de deux techniques de synthèse à plusieurs niveaux : la synthèse extractive-abtractive et la synthèse abstractive-abtractive.

Résumé extractif-abstractif

Le résumé extractif-abstractif fonctionne en générant d’abord un résumé extractif du texte. Ensuite, il utilise un système de résumé abstrait pour affiner le résumé extractif, le rendant plus concis et informatif. Cela améliore la précision en fournissant des résumés plus informatifs par rapport aux méthodes extractives seules.

Stratégie de synthèse de contenu extractive-abtractive

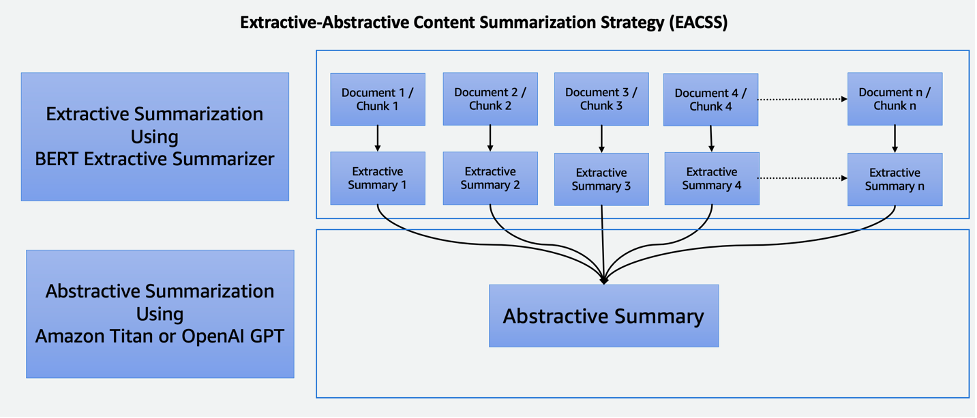

La technique EACSS combine les atouts de deux techniques puissantes : le synthétiseur extractif BERT pour la phase extractive et les LLM pour la phase abstractive, comme illustré dans le schéma suivant.

L’EACSS offre plusieurs avantages, notamment la préservation des informations cruciales, une lisibilité améliorée et une adaptabilité. Cependant, la mise en œuvre de l’EACSS est coûteuse et complexe en termes de calcul. Il existe un risque potentiel de perte d'informations et la qualité de la synthèse dépend fortement des performances des modèles sous-jacents, ce qui rend une sélection et un réglage minutieux des modèles essentiels pour obtenir des résultats optimaux. La mise en œuvre comprend les étapes suivantes :

- La première étape consiste à diviser le document volumineux, tel qu'un livre, en sections plus petites, ou morceaux. Ces morceaux sont définis sous forme de phrases, de paragraphes ou même de chapitres, selon la granularité souhaitée pour le résumé.

- Pour la phase extractive, nous utilisons le résumeur extractif BERT. Ce composant fonctionne en intégrant les phrases dans chaque bloc, puis en employant un algorithme de clustering pour identifier les phrases les plus proches des centroïdes du cluster. Cette étape d'extraction permet de préserver le contenu le plus important et le plus pertinent de chaque morceau.

- Après avoir généré des résumés extractifs pour chaque morceau, nous passons à la phase de résumé abstrait. Ici, nous utilisons des LLM connus pour leur capacité à générer des résumés cohérents et contextuellement pertinents. Ces modèles prennent les résumés extraits en entrée et produisent des résumés abstraits qui capturent l'essence du document original tout en garantissant la lisibilité et la cohérence.

En combinant des techniques de synthèse extractives et abstraites, cette approche offre un moyen efficace et complet de résumer de longs documents tels que des livres. Il garantit que les informations importantes sont extraites tout en permettant la génération de résumés concis et lisibles par l'homme, ce qui en fait un outil précieux pour diverses applications dans le domaine de la synthèse de documents.

Résumé abstractif-abstractif

La synthèse abstractive-abtractive est une approche où des méthodes abstractives sont utilisées à la fois pour extraire et générer des résumés. Il offre des avantages notables, notamment une lisibilité améliorée, une cohérence et la flexibilité d’ajuster la longueur et les détails du résumé. Il excelle dans la génération de langage, permettant la paraphrase et évitant la redondance. Cependant, il existe des inconvénients. Par exemple, il est coûteux en calcul et gourmand en ressources, et sa qualité dépend fortement de l'efficacité des modèles sous-jacents qui, s'ils ne sont pas bien formés ou polyvalents, peuvent avoir un impact sur la qualité des résumés générés. La sélection de modèles est cruciale pour atténuer ces défis et garantir des résumés abstraits de haute qualité. Pour la synthèse abstractive-abtractive, nous discutons de deux stratégies : Map Reduction et Map ReRank.

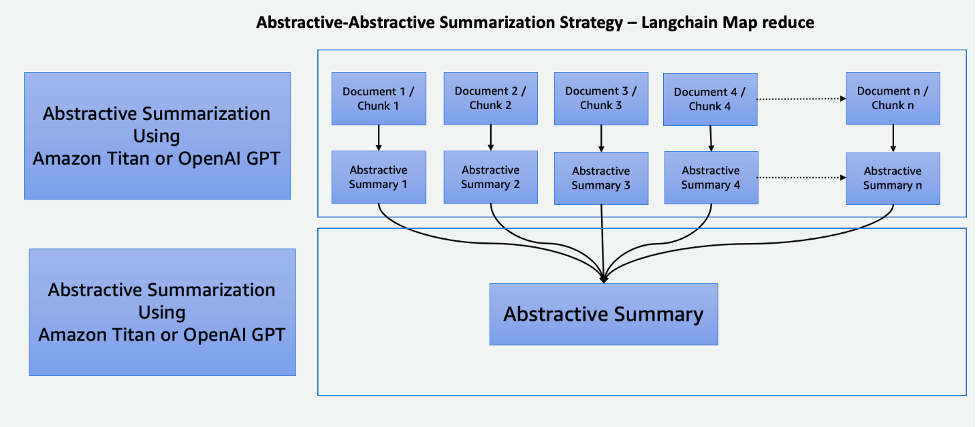

Réduire la carte à l'aide de LangChain

Ce processus en deux étapes comprend une Étape Mapper et étape Réduire, comme illustré dans le diagramme suivant. Cette technique vous permet de résumer une entrée plus longue que la limite de jetons d'entrée du modèle.

Le processus comprend trois étapes principales :

- Les corpus sont divisés en morceaux plus petits qui correspondent à la limite de jetons du LLM.

- Nous utilisons une étape Map pour appliquer individuellement une chaîne LLM qui extrait toutes les informations importantes de chaque passage, et sa sortie est utilisée comme un nouveau passage. Selon la taille et la structure des corpus, cela peut prendre la forme de thèmes généraux ou de courts résumés.

- L'étape Réduire combine les passages de sortie de l'étape Map ou d'une étape Réduire de telle sorte qu'ils correspondent à la limite de jetons et les alimentent dans le LLM. Ce processus est répété jusqu'à ce que le résultat final soit un passage singulier.

L’avantage d’utiliser cette technique est qu’elle est hautement évolutive et parallélisable. Tous les traitements de chaque étape sont indépendants les uns des autres, ce qui tire parti des systèmes distribués ou des services sans serveur et réduit le temps de calcul.

Cartographier le classement à l'aide de LangChain

Cette chaîne exécute une invite initiale sur chaque document qui tente non seulement de terminer une tâche, mais donne également un score en fonction de la certitude de sa réponse. La réponse ayant obtenu le score le plus élevé est renvoyée.

Cette technique est très similaire à Map Reduction mais avec l'avantage de nécessiter moins d'appels globaux, rationalisant ainsi le processus de synthèse. Cependant, sa limite réside dans son incapacité à fusionner les informations de plusieurs documents. Cette restriction le rend plus efficace dans les scénarios où une réponse unique et simple est attendue d'un document unique, ce qui le rend moins adapté aux tâches de recherche d'informations plus complexes ou à multiples facettes impliquant plusieurs sources. Un examen attentif du contexte et de la nature des données est essentiel pour déterminer la pertinence de cette méthode pour des besoins spécifiques de synthèse.

Cohere ReRank utilise un système de reclassement sémantique qui contextualise la signification de la requête d'un utilisateur au-delà de la pertinence des mots clés. Il est utilisé avec les systèmes de magasins vectoriels ainsi qu'avec les moteurs de recherche basés sur des mots clés, ce qui lui confère une certaine flexibilité.

Comparaison des techniques de synthèse

Chaque technique de résumé a ses propres avantages et inconvénients :

- Le résumé extractif préserve le contenu original et garantit une grande lisibilité, mais manque de créativité et peut produire de longs résumés.

- Le résumé abstrait, tout en offrant de la créativité et en générant des résumés concis et fluides, comporte le risque de modification involontaire du contenu, des problèmes d'exactitude du langage et un développement gourmand en ressources.

- La synthèse multi-niveaux extractive-abtractive résume efficacement les documents volumineux et offre une meilleure flexibilité dans le réglage fin de la partie extractive des modèles. Cependant, cette méthode est coûteuse, prend du temps et manque de parallélisation, ce qui rend le réglage des paramètres difficile.

- Le résumé abstrait-abstractif à plusieurs niveaux résume également efficacement les documents volumineux et excelle dans une lisibilité et une cohérence améliorées. Cependant, cette méthode est coûteuse en calcul et gourmande en ressources, et dépend fortement de l'efficacité des modèles sous-jacents.

Une sélection minutieuse des modèles est cruciale pour atténuer les défis et garantir des résumés abstraits de haute qualité dans cette approche. Le tableau suivant résume les fonctionnalités de chaque type de synthèse.

| Aspect | Résumé extractif | Résumé abstrait | Résumé à plusieurs niveaux |

| Générez des résumés créatifs et engageants | Non | Oui | Oui |

| Préserver le contenu original | Oui | Non | Non |

| Équilibrer préservation de l’information et créativité | Non | Oui | Oui |

| Convient pour un texte court et objectif (longueur du texte de saisie inférieure au nombre maximum de jetons du modèle) | Oui | Oui | Non |

| Efficace pour les documents plus longs et complexes tels que les livres (longueur du texte saisi supérieure au nombre maximal de jetons du modèle) | Non | Non | Oui |

| Combine l'extraction et la génération de contenu | Non | Non | Oui |

Les techniques de résumé à plusieurs niveaux conviennent aux documents longs et complexes dans lesquels la longueur du texte saisi dépasse la limite symbolique du modèle. Le tableau suivant compare ces techniques.

| Technique | Avantages | Inconvénients |

| EACSS (extractif-abstractif) | Préserve les informations cruciales, offre la possibilité d’affiner la partie extractive des modèles. | Coûteux en termes de calcul, perte d'informations potentielle et manque de parallélisation. |

| Map Réduire (abstraction-abstraction) | Évolutif et parallélisable, avec moins de temps de calcul. La meilleure technique pour générer des résumés créatifs et concis. | Processus gourmand en mémoire. |

| Map ReRank (abstractif-abstractif) | Résumé simplifié avec classement sémantique. | Fusion d’informations limitée. |

Conseils pour résumer un texte

Tenez compte des bonnes pratiques suivantes lors de la synthèse de texte :

- Soyez conscient de la taille totale du jeton – Soyez prêt à diviser le texte s'il dépasse les limites de jetons du modèle ou à utiliser plusieurs niveaux de résumé lors de l'utilisation de LLM.

- Soyez conscient des types et du nombre de sources de données – La combinaison d’informations provenant de plusieurs sources peut nécessiter des transformations, une organisation claire et des stratégies d’intégration. Trucs LangChain a une intégration sur une grande variété de sources de données et types de documents. Cela simplifie le processus de combinaison de texte provenant de différents documents et sources de données grâce à l'utilisation de cette technique.

- Soyez conscient de la spécialisation du modèle – Certains modèles peuvent exceller dans certains types de contenu mais avoir des difficultés avec d’autres. Il existe peut-être des modèles affinés qui conviennent mieux à votre domaine de texte.

- Utiliser le résumé à plusieurs niveaux pour les gros corps de texte – Pour les textes qui dépassent les limites des jetons, envisagez une approche de synthèse à plusieurs niveaux. Commencez par un résumé de haut niveau pour capturer les idées principales, puis résumez progressivement les sous-sections ou les chapitres pour des informations plus détaillées.

- Résumer le texte par sujets – Cette approche permet de maintenir un flux logique et de réduire la perte d’informations, et donne la priorité à la conservation des informations cruciales. Si vous utilisez des LLM, créez des invites claires et spécifiques qui guident le modèle pour résumer un sujet particulier au lieu de l'ensemble du corps du texte.

Conclusion

La synthèse constitue un outil essentiel à notre époque riche en informations, permettant la distillation efficace d’informations détaillées sous des formes concises et significatives. Elle joue un rôle central dans de nombreux domaines et offre de nombreux avantages. La synthèse permet de gagner du temps en transmettant rapidement le contenu essentiel de documents longs, facilite la prise de décision en extrayant des informations critiques et améliore la compréhension dans l'éducation et la curation de contenu.

Cet article a fourni un aperçu complet de diverses techniques de synthèse, y compris les approches extractives, abstraites et multi-niveaux. Avec des outils tels que LangChain et des modèles linguistiques, vous pouvez exploiter la puissance de la synthèse pour rationaliser la communication, améliorer la prise de décision et libérer tout le potentiel de vastes référentiels d'informations. Le tableau comparatif de cet article peut vous aider à identifier les techniques de synthèse les plus adaptées à vos projets. De plus, les conseils partagés dans l'article constituent des lignes directrices précieuses pour éviter les erreurs répétitives lors de l'expérimentation des LLM pour le résumé de texte. Ces conseils pratiques vous permettent d'appliquer les connaissances acquises, garantissant une synthèse réussie et efficace dans les projets.

Bibliographie

À propos des auteurs

Nick Biso est ingénieur en apprentissage automatique chez AWS Professional Services. Il résout des défis organisationnels et techniques complexes en utilisant la science des données et l'ingénierie. De plus, il crée et déploie des modèles AI/ML sur le cloud AWS. Sa passion s'étend à sa propension aux voyages et aux diverses expériences culturelles.

Nick Biso est ingénieur en apprentissage automatique chez AWS Professional Services. Il résout des défis organisationnels et techniques complexes en utilisant la science des données et l'ingénierie. De plus, il crée et déploie des modèles AI/ML sur le cloud AWS. Sa passion s'étend à sa propension aux voyages et aux diverses expériences culturelles.

Chaudrée Suhas Jonnalagadda est Data Scientist chez AWS Global Services. Il a pour passion d'aider les entreprises clientes à résoudre leurs problèmes les plus complexes grâce à la puissance de l'IA/ML. Il a aidé des clients à transformer leurs solutions commerciales dans divers secteurs, notamment la finance, la santé, la banque, le commerce électronique, les médias, la publicité et le marketing.

Chaudrée Suhas Jonnalagadda est Data Scientist chez AWS Global Services. Il a pour passion d'aider les entreprises clientes à résoudre leurs problèmes les plus complexes grâce à la puissance de l'IA/ML. Il a aidé des clients à transformer leurs solutions commerciales dans divers secteurs, notamment la finance, la santé, la banque, le commerce électronique, les médias, la publicité et le marketing.

Quartier tigré est un architecte cloud principal/conseiller technique stratégique possédant une vaste expérience dans la migration de clients et la modernisation de leur charge de travail et de leurs services applicatifs vers AWS. Avec plus de 25 ans d'expérience dans le développement et l'architecture de logiciels, elle est reconnue pour sa capacité approfondie et pour gagner habilement la confiance des clients et des partenaires pour concevoir des architectures et des solutions sur plusieurs piles technologiques et fournisseurs de cloud.

Quartier tigré est un architecte cloud principal/conseiller technique stratégique possédant une vaste expérience dans la migration de clients et la modernisation de leur charge de travail et de leurs services applicatifs vers AWS. Avec plus de 25 ans d'expérience dans le développement et l'architecture de logiciels, elle est reconnue pour sa capacité approfondie et pour gagner habilement la confiance des clients et des partenaires pour concevoir des architectures et des solutions sur plusieurs piles technologiques et fournisseurs de cloud.

Shyam Desai est un ingénieur cloud pour les services Big Data et Machine Learning chez AWS. Il prend en charge les applications et les clients Big Data au niveau de l'entreprise en combinant son expertise en génie logiciel avec la science des données. Il possède des connaissances approfondies dans les applications de vision par ordinateur et d’imagerie pour l’intelligence artificielle, ainsi que dans les applications biomédicales et bioinformatiques.

Shyam Desai est un ingénieur cloud pour les services Big Data et Machine Learning chez AWS. Il prend en charge les applications et les clients Big Data au niveau de l'entreprise en combinant son expertise en génie logiciel avec la science des données. Il possède des connaissances approfondies dans les applications de vision par ordinateur et d’imagerie pour l’intelligence artificielle, ainsi que dans les applications biomédicales et bioinformatiques.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- :possède

- :est

- :ne pas

- :où

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- capacité

- Qui sommes-nous

- académique

- accessible

- précision

- Avec cette connaissance vient le pouvoir de prendre

- la réalisation de

- à travers

- ajout

- En outre

- progrès

- Avantage

- avantageux

- avantages

- Numérique

- conseils

- conseiller

- Après

- âge

- agrégation

- AI

- AI / ML

- SIDA

- algorithme

- aligné

- Tous

- Permettre

- permet

- seul

- le long de

- aussi

- Bien que

- Amazon

- Amazon Web Services

- an

- selon une analyse de l’Université de Princeton

- ainsi que le

- répondre

- Anthropique

- tous

- Application

- applications

- Appliquer

- Application

- une approche

- approches

- SONT

- tableau

- article

- sur notre blog

- artificiel

- intelligence artificielle

- AS

- At

- Automatique

- éviter

- en évitant

- conscients

- AWS

- Services professionnels AWS

- Services bancaires

- basé

- BE

- devenez

- devient

- va

- LES MEILLEURS

- les meilleures pratiques

- Améliorée

- Au-delà

- Big

- Big Data

- biomédical

- blogue

- corps

- corps

- livre

- Livres

- tous les deux

- Pause

- vaste

- largement

- construit

- la performance des entreprises

- mais

- bouton (dans la fenêtre de contrôle qui apparaît maintenant)

- by

- Appels

- CAN

- capacités

- capable

- capturer

- captures

- prudent

- Canaux centraux

- certaines

- chaîne

- globaux

- difficile

- chapitres

- caractère

- clarté

- clair

- clairement

- cliquez

- le cloud

- Grappe

- regroupement

- code

- COHÉRENT

- combinaison

- combiné

- moissonneuses-batteuses

- combinant

- comment

- vient

- Communication

- compact

- par rapport

- Comparaison

- complet

- complexe

- composant

- complet

- comprend

- calcul

- ordinateur

- Vision par ordinateur

- concis

- conditions

- Considérer

- considération

- consiste

- Console

- contraintes

- consommant

- contenu

- curation de contenu

- contexte

- des bactéries

- Core

- pierre angulaire

- pourriez

- homologues

- élaborer

- engendrent

- Conception

- notre créativité

- critique

- crucial

- à la diversité

- curation

- Clients

- données

- science des données

- Data Scientist

- ensembles de données

- traitement

- La prise de décision

- décisions

- défini

- Selon

- dépend

- déployer

- déploiement

- déploie

- Conception

- un

- voulu

- détail

- détaillé

- détails

- Déterminer

- développement

- Développement

- différent

- directement

- Désavantage

- discuter

- distribué

- systèmes distribués

- plusieurs

- document

- INSTITUTIONNELS

- Ne fait pas

- domaine

- domaines

- down

- désavantages

- chacun

- Revenus

- facilité

- e-commerce

- Éducation

- Efficace

- de manière efficace

- efficacité

- efficace

- enrobage

- employant

- responsabilise

- permet

- permettant

- engageant

- ingénieur

- ENGINEERING

- Moteurs

- améliorée

- Améliore

- assurer

- Assure

- assurer

- Entreprise

- niveau entreprise

- Ère

- Erreurs

- notamment

- essence

- essential

- établies

- Pourtant, la

- exemple

- dépassent

- dépasse

- Excel

- excessif

- uniquement au

- exécutif

- existant

- attendu

- cher

- d'experience

- Expériences

- expériences

- nous a permis de concevoir

- express

- S'étend

- les

- Une vaste expérience

- extrait

- extraction

- Extraits

- Fonctionnalité

- moins

- finale

- finance

- Prénom

- s'adapter

- Flexibilité

- flux

- Focus

- suivre

- Abonnement

- Pour

- formulaire

- le format

- document

- trouvé

- De

- plein

- d’étiquettes électroniques entièrement

- En outre

- gagné

- à usage général

- générer

- généré

- génère

- générateur

- génération

- génératif

- IA générative

- donné

- donne

- Don

- Global

- Goes

- aller

- plus grand

- Réservation de groupe

- guide

- lignes directrices

- harnais

- Vous avez

- he

- la médecine

- fortement

- vous aider

- a aidé

- aider

- aide

- ici

- ici

- Haute

- de haut niveau

- de haute qualité

- le plus élevé

- très

- sa

- Comment

- Cependant

- HTML

- HTTPS

- lisible par l'homme

- et idées cadeaux

- identifier

- identifier

- if

- Imagerie

- Impact

- la mise en oeuvre

- la mise en œuvre

- important

- améliorer

- l'amélioration de

- in

- incapacité

- inclut

- Y compris

- intégrer

- indépendant

- index

- Individuellement

- secteurs

- influencer

- d'information

- informatif

- Actualités

- initiale

- contribution

- idées.

- plutôt ;

- Des instructions

- l'intégration

- Intelligence

- prévu

- développement

- Introduction

- inestimable

- investor

- impliquer

- IT

- itérations

- SES

- jpg

- ACTIVITES

- spécialisées

- connu

- langue

- gros

- plus importantes

- poules pondeuses

- apprentissage

- Légal

- Longueur

- moins

- niveaux

- se trouve

- vos produits

- comme

- LIMIT

- limitation

- limites

- limites

- LLM

- logique

- Location

- plus long

- perte

- baisser

- click

- machine learning

- Entrée

- maintenir

- a prendre une

- FAIT DU

- Fabrication

- gérés

- les gérer

- de nombreuses

- Localisation

- Marché

- Stratégie

- Matériel

- maximales

- Mai..

- sens

- significative

- Médias

- simple

- aller

- fusion

- méthode

- méthodologies

- méthodes

- migrer

- manquant

- Réduire les

- modèle

- numériques jumeaux (digital twin models)

- la modernisation

- PLUS

- Par ailleurs

- (en fait, presque toutes)

- Bougez

- multiforme

- plusieurs

- récit

- Nature

- Traitement du langage naturel

- Nature

- nécessairement

- nécessaire

- Besoin

- Besoins

- Nouveauté

- nouvelles

- Newsletter

- nlp

- aucune

- notable

- notamment

- noter

- roman

- nombre

- nombreux

- objectif

- of

- code

- offrant

- Offres Speciales

- on

- ONE

- uniquement

- ouvert

- optimaux

- or

- organisation

- organisationnel

- original

- Autre

- Autres

- nos

- ande

- les résultats

- sortie

- sorties

- plus de

- global

- global

- vue d'ensemble

- accablant

- propre

- paramètre

- paramètres

- partie

- particulier

- partenaires,

- passage

- passion

- passionné

- Effectuer

- performant

- phase

- les expressions clés

- pivot

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joue

- Post

- défaillances

- l'éventualité

- power

- alimenté

- solide

- Méthode

- pratique

- pratiques

- préparé

- représentent

- Présentations

- préservation

- conservation

- Directeur

- priorise

- d'ouvrabilité

- processus

- les process

- traitement

- produire

- produit

- professionels

- ,une équipe de professionnels qualifiés

- progressivement

- projets

- instructions

- à condition de

- fournisseurs

- fournit

- aportando

- tirant

- des fins

- qualité

- gamme

- Classement

- lecteurs

- reconnu

- réduire

- Prix Réduit

- visée

- se réfère

- affiner

- relativement

- pertinence

- pertinent

- s'appuyer

- réorganiser

- répété

- répétitif

- Rapports

- représentation

- exigent

- conditions

- a besoin

- ressource

- gourmande en ressources

- réponse

- restriction

- résultat

- Résultats

- rétention

- réutiliser

- Analyse

- Rôle

- fonctionne

- sagemaker

- économie

- évolutive

- Escaliers intérieurs

- scénarios

- Sciences

- Scientifique

- But

- marquant

- Rechercher

- Les moteurs de recherche

- Section

- les sections

- choisi

- la sélection

- sélection

- phrase

- Série

- besoin

- Sans serveur

- sert

- service

- Services

- service

- plusieurs

- commun

- elle

- Shorts

- de façon significative

- similaires

- simplifie

- simplifier

- unique

- singulier

- considérable

- Taille

- tailles

- faibles

- Logiciels

- génie logiciel

- uniquement

- Solutions

- RÉSOUDRE

- Résout

- quelques

- parfois

- Identifier

- Sources

- spécialisé

- groupe de neurones

- spécifiquement

- scission

- Combos

- peuplements

- Commencer

- Région

- étapes

- Étapes

- Boutique

- simple

- les stratégies

- de Marketing

- rationaliser

- la rationalisation

- forces

- structure

- Lutter

- substantiellement

- réussi

- tel

- Combinaison

- convient

- résumé

- RÉSUMÉ

- Les soutiens

- rapidement

- combustion propre

- Système

- table

- Prenez

- prend

- Tâche

- tâches

- technologie

- Technique

- technique

- techniques

- conditions

- texte

- que

- qui

- Les

- Les projets

- La Source

- leur

- Les

- thèmes

- puis

- Là.

- Ces

- l'ont

- this

- trois

- Avec

- fiable

- conseils

- à

- jeton

- Tokens

- outil

- les outils

- sujet

- Les sujets

- Total

- Train

- Formation

- transformations

- transformer

- Voyage

- La confiance

- réglage

- deux

- type

- types

- typiquement

- incapable

- subit

- sous-jacent

- comprendre

- compréhension

- expérience unique et authentique

- contrairement à

- ouvrir

- jusqu'à

- indésirable

- utilisé

- d'utiliser

- Usages

- en utilisant

- utiliser

- Précieux

- variété

- divers

- variant

- Vaste

- polyvalente

- version

- très

- vision

- vital

- volumes

- Façon..

- we

- web

- services Web

- WELL

- quand

- qui

- tout en

- la totalité

- large

- Wikipédia

- comprenant

- dans les

- Word

- des mots

- vos contrats

- world

- années

- rendements

- Vous n'avez

- Votre

- zéphyrnet