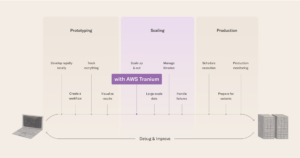

Socle amazonien propose une large gamme de modèles de base très performants d'Amazon et d'autres grandes sociétés d'IA, notamment Anthropique, AI21, Meta, Adhéreret une IA de stabilité, et couvre un large éventail de cas d'utilisation, notamment la génération de texte et d'images, la recherche, le chat, le raisonnement et les agents agissant, et bien plus encore. Le nouveau Générateur d'images Amazon Titan Le modèle permet aux créateurs de contenu de générer rapidement des images réalistes et de haute qualité à l’aide de simples invites de texte en anglais. Le modèle d'IA avancé comprend les instructions complexes avec plusieurs objets et renvoie des images de qualité studio adaptées à publicité, le commerce électronique et divertissement. Les fonctionnalités clés incluent la possibilité d'affiner les images en itérant sur les invites, l'édition automatique en arrière-plan et la génération de plusieurs variantes de la même scène. Les créateurs peuvent également personnaliser le modèle avec leurs propres données pour produire des images de marque dans un style spécifique. Il est important de noter que Titan Image Generator dispose de protections intégrées, comme des filigranes invisibles sur toutes les images générées par l'IA, pour encourager utilisation responsable et atténuer la propagation de la désinformation. Cette technologie innovante permet de produire des images personnalisées en grand volume pour toute industrie plus accessible et efficace.

Le nouveau système d’ Intégrations multimodales Amazon Titan Le modèle permet de créer une recherche et des recommandations plus précises en comprenant le texte, les images ou les deux. Il convertit les images et le texte anglais en vecteurs sémantiques, capturant le sens et les relations dans vos données. Vous pouvez combiner du texte et des images comme des descriptions de produits et des photos pour identifier les articles plus efficacement. Les vecteurs permettent des expériences de recherche rapides et précises. Titan Multimodal Embeddings est flexible en termes de dimensions vectorielles, permettant une optimisation pour les besoins de performances. Une API asynchrone et Service Amazon OpenSearch Le connecteur facilite l'intégration du modèle dans vos applications de recherche neuronale.

Dans cet article, nous expliquons comment utiliser les modèles Titan Image Generator et Titan Multimodal Embeddings via le SDK AWS Python.

Génération et édition d'images

Dans cette section, nous démontrons les modèles de codage de base permettant d'utiliser le kit AWS SDK pour générer de nouvelles images et effectuer des modifications basées sur l'IA sur des images existantes. Des exemples de code sont fournis en Python et JavaScript (Node.js) est également disponible dans ce GitHub référentiel.

Avant de pouvoir écrire des scripts qui utilisent l'API Amazon Bedrock, vous devez installer la version appropriée du kit SDK AWS dans votre environnement. Pour les scripts Python, vous pouvez utiliser le AWS SDK pour Python (Boto3). Les utilisateurs de Python peuvent également souhaiter installer le Module oreiller, qui facilite les opérations sur les images telles que le chargement et l'enregistrement d'images. Pour les instructions de configuration, reportez-vous au GitHub référentiel.

De plus, activez l’accès aux modèles Amazon Titan Image Generator et Titan Multimodal Embeddings. Pour plus d'informations, reportez-vous à Accès au modèle.

Fonctions d'assistance

La fonction suivante configure le client d'exécution Amazon Bedrock Boto3 et génère des images en prenant des charges utiles de différentes configurations (dont nous parlerons plus loin dans cet article) :

Générer des images à partir de texte

Les scripts qui génèrent une nouvelle image à partir d'une invite de texte suivent ce modèle d'implémentation :

- Configurez une invite de texte et une invite de texte négatif facultative.

- Utilisez l'option

BedrockRuntimeclient pour invoquer le modèle Titan Image Generator. - Analysez et décodez la réponse.

- Enregistrez les images résultantes sur le disque.

Texte à image

Ce qui suit est un script de génération d'image typique pour le modèle Titan Image Generator :

Cela produira des images similaires à celles suivantes.

| Image de réponse 1 | Image de réponse 2 |

|

|

Variantes d'images

La variation d'image permet de générer des variantes subtiles d'une image existante. L'extrait de code suivant utilise l'une des images générées dans l'exemple précédent pour créer des variantes d'images :

Cela produira des images similaires à celles suivantes.

| Image originale | Image de réponse 1 | Image de réponse 2 |

|

|

|

Modifier une image existante

Le modèle Titan Image Generator vous permet d'ajouter, de supprimer ou de remplacer des éléments ou des zones dans une image existante. Vous spécifiez la zone à affecter en fournissant l'un des éléments suivants :

- Image de masque – Une image de masque est une image binaire dans laquelle les pixels de valeur 0 représentent la zone que vous souhaitez affecter et les pixels de valeur 255 représentent la zone qui doit rester inchangée.

- Invite de masque – Une invite de masque est une description textuelle en langage naturel des éléments que vous souhaitez affecter, qui utilise un modèle de texte-segmentation interne.

Pour plus d'informations, reportez-vous à Directives d'ingénierie rapides.

Les scripts qui appliquent une modification à une image suivent ce modèle d'implémentation :

- Chargez l'image à modifier à partir du disque.

- Convertissez l'image en une chaîne codée en base64.

- Configurez le masque via l'une des méthodes suivantes :

- Chargez une image de masque à partir du disque, en la codant en base64 et en la définissant comme

maskImageparamètre. - Met le

maskTextparamètre à une description textuelle des éléments à affecter.

- Chargez une image de masque à partir du disque, en la codant en base64 et en la définissant comme

- Spécifiez le nouveau contenu à générer à l'aide de l'une des options suivantes :

- Pour ajouter ou remplacer un élément, définissez le

textparamètre à une description du nouveau contenu. - Pour supprimer un élément, omettez le

textparamètre complètement.

- Pour ajouter ou remplacer un élément, définissez le

- Utilisez l'option

BedrockRuntimeclient pour invoquer le modèle Titan Image Generator. - Analysez et décodez la réponse.

- Enregistrez les images résultantes sur le disque.

Édition d'objets : Inpainting avec une image de masque

Ce qui suit est un script d'édition d'image typique pour le modèle Titan Image Generator utilisant maskImage. Nous prenons l'une des images générées précédemment et fournissons une image de masque, où les pixels de valeur 0 sont rendus en noir et les pixels de valeur 255 en blanc. Nous remplaçons également l'un des chiens de l'image par un chat à l'aide d'une invite texte.

Cela produira des images similaires à celles suivantes.

| Image originale | Image du masque | Image modifiée |

|

|

|

Suppression d'objet : Inpainting avec une invite de masque

Dans un autre exemple, nous utilisons maskPrompt pour spécifier un objet dans l'image, issu des étapes précédentes, à modifier. En omettant l'invite de texte, l'objet sera supprimé :

Cela produira des images similaires à celles suivantes.

| Image originale | Image de réponse |

|

|

Édition d'arrière-plan : Outpainting

L'outpainting est utile lorsque vous souhaitez remplacer l'arrière-plan d'une image. Vous pouvez également étendre les limites d'une image pour un effet de zoom arrière. Dans l'exemple de script suivant, nous utilisons maskPrompt de préciser quel objet conserver ; vous pouvez aussi utiliser maskImage. Le paramètre outPaintingMode spécifie s'il faut autoriser la modification des pixels à l'intérieur du masque. Si défini comme DEFAULT, les pixels à l'intérieur du masque peuvent être modifiés afin que l'image reconstruite soit globalement cohérente. Cette option est recommandée si le maskImage fourni ne représente pas l'objet avec une précision au niveau du pixel. Si défini comme PRECISE, la modification des pixels à l'intérieur du masque est empêchée. Cette option est recommandée si vous utilisez un maskPrompt ou maskImage qui représente l'objet avec une précision au niveau du pixel.

Cela produira des images similaires à celles suivantes.

| Image originale | Texte | Image de réponse |

|

"plage" |  |

|

"forêt" |  |

De plus, les effets de différentes valeurs pour outPaintingMode, avec une maskImage qui ne décrit pas l'objet avec une précision au niveau du pixel, sont les suivants.

Cette section vous a donné un aperçu des opérations que vous pouvez effectuer avec le modèle Titan Image Generator. Plus précisément, ces scripts démontrent des tâches de conversion texte-image, de variation d'image, d'inpainting et d'outpainting. Vous devriez être en mesure d'adapter les modèles à vos propres applications en faisant référence aux détails des paramètres pour les types de tâches détaillés dans Documentation du générateur d'images Amazon Titan.

Intégration et recherche multimodales

Vous pouvez utiliser le modèle Amazon Titan Multimodal Embeddings pour des tâches d'entreprise telles que la recherche d'images et les recommandations basées sur la similarité, et il dispose d'une atténuation intégrée qui permet de réduire les biais dans les résultats de recherche. Il existe plusieurs tailles de dimension d'intégration pour obtenir les meilleurs compromis entre latence et précision pour différents besoins, et toutes peuvent être personnalisées avec une simple API pour s'adapter à vos propres données tout en préservant la sécurité et la confidentialité des données. Amazon Titan Multimodal Embeddings est fourni sous forme d'API simples pour les applications de recherche et de recommandation de transformation par lots en temps réel ou asynchrones, et peut être connecté à différentes bases de données vectorielles, notamment Service Amazon OpenSearch.

Fonctions d'assistance

La fonction suivante convertit une image, et éventuellement du texte, en intégrations multimodales :

La fonction suivante renvoie les principales intégrations multimodales similaires en fonction d'une requête d'intégrations multimodales. Notez qu'en pratique, vous pouvez utiliser une base de données vectorielles gérée, telle qu'OpenSearch Service. L'exemple suivant est à titre d'illustration :

Ensemble de données synthétiques

À des fins d’illustration, nous utilisons Modèle Claude 2.1 d'Anthropic dans Amazon Bedrock pour générer aléatoirement sept produits différents, chacun avec trois variantes, en utilisant l'invite suivante :

Generate a list of 7 items description for an online e-commerce shop, each comes with 3 variants of color or type. All with separate full sentence description.

Voici la liste des sorties renvoyées :

Attribuez la réponse ci-dessus à la variable response_cat. Ensuite, nous utilisons le modèle Titan Image Generator pour créer des images de produits pour chaque article :

Toutes les images générées se trouvent en annexe à la fin de cet article.

Indexation multimodale des ensembles de données

Utilisez le code suivant pour l'indexation multimodale des ensembles de données :

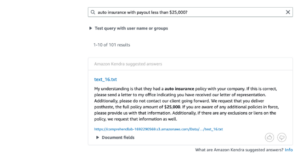

Recherche multimodale

Utilisez le code suivant pour la recherche multimodale :

Voici quelques résultats de recherche.

Conclusion

L'article présente les modèles Amazon Titan Image Generator et Amazon Titan Multimodal Embeddings. Titan Image Generator vous permet de créer des images personnalisées de haute qualité à partir d'invites textuelles. Les fonctionnalités clés incluent l'itération sur les invites, l'édition automatique en arrière-plan et la personnalisation des données. Il dispose de garanties telles que des filigranes invisibles pour encourager une utilisation responsable. Titan Multimodal Embeddings convertit le texte, les images ou les deux en vecteurs sémantiques pour alimenter des recherches et des recommandations précises. Nous avons ensuite fourni des exemples de code Python pour utiliser ces services et démontré la génération d'images à partir d'invites de texte et l'itération sur ces images ; modifier des images existantes en ajoutant, supprimant ou remplaçant des éléments spécifiés par des images de masque ou du texte de masque ; créer des intégrations multimodales à partir de texte, d'images ou des deux ; et rechercher des intégrations multimodales similaires à une requête. Nous avons également démontré l'utilisation d'un ensemble de données synthétiques de commerce électronique indexé et recherché à l'aide de Titan Multimodal Embeddings. L'objectif de cet article est de permettre aux développeurs de commencer à utiliser ces nouveaux services d'IA dans leurs applications. Les modèles de code peuvent servir de modèles pour des implémentations personnalisées.

Tout le code est disponible sur le GitHub référentiel. Pour plus d'informations, reportez-vous au Guide de l'utilisateur d'Amazon Bedrock.

À propos des auteurs

Rohit Mittal est chef de produit principal chez Amazon AI, qui crée des modèles de base multimodaux. Il a récemment dirigé le lancement du modèle Amazon Titan Image Generator dans le cadre du service Amazon Bedrock. Expérimenté en IA/ML, NLP et recherche, il souhaite créer des produits qui résolvent les problèmes des clients grâce à une technologie innovante.

Rohit Mittal est chef de produit principal chez Amazon AI, qui crée des modèles de base multimodaux. Il a récemment dirigé le lancement du modèle Amazon Titan Image Generator dans le cadre du service Amazon Bedrock. Expérimenté en IA/ML, NLP et recherche, il souhaite créer des produits qui résolvent les problèmes des clients grâce à une technologie innovante.

Dr Ashwin Swaminathan est un chercheur, ingénieur et gestionnaire en vision par ordinateur et en apprentissage automatique avec plus de 12 ans d'expérience dans l'industrie et plus de 5 ans d'expérience en recherche universitaire. Des fondamentaux solides et une capacité avérée à acquérir rapidement des connaissances et à contribuer à des domaines nouveaux et émergents.

Dr Ashwin Swaminathan est un chercheur, ingénieur et gestionnaire en vision par ordinateur et en apprentissage automatique avec plus de 12 ans d'expérience dans l'industrie et plus de 5 ans d'expérience en recherche universitaire. Des fondamentaux solides et une capacité avérée à acquérir rapidement des connaissances et à contribuer à des domaines nouveaux et émergents.

Dr Yusheng Xie est chercheur appliqué principal chez Amazon AGI. Son travail se concentre sur la construction de modèles de fondation multimodaux. Avant de rejoindre AGI, il dirigeait divers développements d'IA multimodaux chez AWS, tels que Amazon Titan Image Generator et Amazon Textract Queries.

Dr Yusheng Xie est chercheur appliqué principal chez Amazon AGI. Son travail se concentre sur la construction de modèles de fondation multimodaux. Avant de rejoindre AGI, il dirigeait divers développements d'IA multimodaux chez AWS, tels que Amazon Titan Image Generator et Amazon Textract Queries.

Dr Hao Yang est chercheur appliqué principal chez Amazon. Ses principaux intérêts de recherche sont la détection d'objets et l'apprentissage avec des annotations limitées. En dehors du travail, Hao aime regarder des films, photographier et pratiquer des activités de plein air.

Dr Hao Yang est chercheur appliqué principal chez Amazon. Ses principaux intérêts de recherche sont la détection d'objets et l'apprentissage avec des annotations limitées. En dehors du travail, Hao aime regarder des films, photographier et pratiquer des activités de plein air.

Dr Davide Modolo est responsable des sciences appliquées chez Amazon AGI, travaillant à la création de grands modèles fondamentaux multimodaux. Avant de rejoindre Amazon AGI, il a été manager/responsable pendant 7 ans chez AWS AI Labs (Amazon Bedrock et Amazon Rekognition). En dehors du travail, il aime voyager et pratiquer tout type de sport, notamment le football.

Dr Davide Modolo est responsable des sciences appliquées chez Amazon AGI, travaillant à la création de grands modèles fondamentaux multimodaux. Avant de rejoindre Amazon AGI, il a été manager/responsable pendant 7 ans chez AWS AI Labs (Amazon Bedrock et Amazon Rekognition). En dehors du travail, il aime voyager et pratiquer tout type de sport, notamment le football.

Dr Baichuan Sun, est actuellement architecte principal de solutions IA/ML chez AWS, se concentrant sur l'IA générative et applique ses connaissances en science des données et en apprentissage automatique pour fournir des solutions commerciales pratiques basées sur le cloud. Fort de son expérience en conseil en gestion et en architecture de solutions d'IA, il relève une gamme de défis complexes, notamment la vision par ordinateur robotique, la prévision de séries chronologiques et la maintenance prédictive, entre autres. Son travail s'appuie sur une solide expérience en gestion de projet, en R&D de logiciels et en activités académiques. En dehors du travail, le Dr Sun aime voyager et passer du temps avec sa famille et ses amis.

Dr Baichuan Sun, est actuellement architecte principal de solutions IA/ML chez AWS, se concentrant sur l'IA générative et applique ses connaissances en science des données et en apprentissage automatique pour fournir des solutions commerciales pratiques basées sur le cloud. Fort de son expérience en conseil en gestion et en architecture de solutions d'IA, il relève une gamme de défis complexes, notamment la vision par ordinateur robotique, la prévision de séries chronologiques et la maintenance prédictive, entre autres. Son travail s'appuie sur une solide expérience en gestion de projet, en R&D de logiciels et en activités académiques. En dehors du travail, le Dr Sun aime voyager et passer du temps avec sa famille et ses amis.

Dr Kai Zhu travaille actuellement en tant qu'ingénieur de support cloud chez AWS, aidant les clients avec des problèmes liés aux services liés à l'IA/ML comme SageMaker, Bedrock, etc. Il est un expert en la matière SageMaker. Expérimenté en science des données et en ingénierie des données, il s'intéresse à la construction de projets génératifs basés sur l'IA.

Dr Kai Zhu travaille actuellement en tant qu'ingénieur de support cloud chez AWS, aidant les clients avec des problèmes liés aux services liés à l'IA/ML comme SageMaker, Bedrock, etc. Il est un expert en la matière SageMaker. Expérimenté en science des données et en ingénierie des données, il s'intéresse à la construction de projets génératifs basés sur l'IA.

Kris Schultz a passé plus de 25 ans à donner vie à des expériences utilisateur engageantes en combinant des technologies émergentes avec un design de classe mondiale. Dans son rôle de chef de produit senior, Kris aide à concevoir et à créer des services AWS pour alimenter les médias et le divertissement, les jeux et l'informatique spatiale.

Kris Schultz a passé plus de 25 ans à donner vie à des expériences utilisateur engageantes en combinant des technologies émergentes avec un design de classe mondiale. Dans son rôle de chef de produit senior, Kris aide à concevoir et à créer des services AWS pour alimenter les médias et le divertissement, les jeux et l'informatique spatiale.

Appendice

Dans les sections suivantes, nous présentons des exemples de cas d'utilisation difficiles tels que l'insertion de texte, les mains et les réflexions pour mettre en évidence les capacités du modèle Titan Image Generator. Nous incluons également les exemples d’images de sortie produites dans les exemples précédents.

Texte

Le modèle Titan Image Generator excelle dans les flux de travail complexes tels que l'insertion de texte lisible dans des images. Cet exemple démontre la capacité de Titan à restituer clairement les lettres majuscules et minuscules dans un style cohérent au sein d'une image.

| un corgi portant une casquette de baseball avec le texte « genai » | un garçon heureux levant le pouce, portant un t-shirt avec le texte « IA générative » |

|

|

Mains

Le modèle Titan Image Generator a également la capacité de générer des images IA détaillées. L’image montre des mains et des doigts réalistes avec des détails visibles, allant au-delà de la génération d’images IA plus basiques qui peuvent manquer d’une telle spécificité. Dans les exemples suivants, remarquez la représentation précise de la pose et de l’anatomie.

| la main d'une personne vue d'en haut | un examen attentif des mains d'une personne tenant une tasse de café |

|

|

Miroir

Les images générées par le modèle Titan Image Generator organisent spatialement les objets et reflètent avec précision les effets de miroir, comme le démontrent les exemples suivants.

| Un joli chat blanc moelleux se tient sur ses pattes arrière, scrutant curieusement dans un miroir doré orné. Dans le reflet, le chat se voit | beau lac de ciel avec des reflets sur l'eau |

|

|

Images de produits synthétiques

Voici les images de produits générées plus tôt dans cet article pour le modèle Titan Multimodal Embeddings.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/use-amazon-titan-models-for-image-generation-editing-and-searching/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 10

- 100

- 12

- 125

- 14

- 15%

- 16

- 17

- 19

- 24

- 25

- 300

- 31

- 7

- a

- capacité

- Capable

- au dessus de

- académique

- recherche universitaire

- accès

- accessible

- Avec cette connaissance vient le pouvoir de prendre

- avec précision

- intérim

- d'activités

- activité

- adapter

- ajouter

- ajoutant

- ajout

- adresses

- réglable et

- Avancée

- affecter

- agents

- AGI

- AI

- Services d'IA

- Alimenté par l'IA

- AI / ML

- objectif

- Tous

- permettre

- permis

- permet

- aussi

- Amazon

- Amazon Reconnaissance

- Extrait d'Amazon

- Amazon Web Services

- parmi

- an

- selon une analyse de l’Université de Princeton

- anatomie

- ainsi que

- Une autre

- tous

- api

- Apis

- applications

- appliqué

- s'applique

- Appliquer

- approprié

- architecture

- SONT

- Réservé

- domaines

- tableau

- AS

- At

- auto

- Automatique

- disponibles

- AWS

- fond

- Mal

- Balance

- Baseball

- Essentiel

- BE

- Plage

- before

- LES MEILLEURS

- Au-delà

- biais

- Noir

- Bleu

- corps

- tous les deux

- bornes

- Apporter

- vaste

- marron

- construire

- Développement

- intégré

- la performance des entreprises

- by

- Calendrier

- appareil photo

- CAN

- la toile

- casquette

- capacités

- Capturer

- porter

- la réalisation

- voitures

- cas

- CHAT

- globaux

- difficile

- le chat

- classe

- classiques

- clairement

- client

- Fermer

- fermeture

- le cloud

- code

- Codage

- Café

- Couleur

- combiner

- combinant

- vient

- compact

- Sociétés

- complètement

- complexe

- ordinateur

- Vision par ordinateur

- informatique

- connecté

- cohérent

- consulting

- contenu

- créateurs de contenu

- contribuer

- contrôles

- Counter

- couverture

- Housses

- engendrent

- La création

- créateurs

- équipage

- Lecture

- Customiser

- des clients

- Clients

- personnalisables

- personnalisation

- personnaliser

- sont adaptées

- données

- science des données

- la sécurité des données

- sécurité et confidentialité des données

- Base de données

- bases de données

- Réglage par défaut

- démontrer

- démontré

- démontre

- Jeans

- la description

- Conception

- détail

- détaillé

- détails

- Détection

- mobiles

- Développement

- DICT

- différent

- Dimension

- dimensions

- discuter

- désinformation

- distance

- Ne fait pas

- Chien

- Don

- down

- dr

- e-commerce

- chacun

- Plus tôt

- Easy

- Éco-Responsable

- e-commerce

- effet

- de manière efficace

- les effets

- efficace

- non plus

- élément

- éléments

- d'autre

- enrobage

- économies émergentes.

- les technologies émergentes

- permettre

- permet

- permettant

- codage

- encourager

- fin

- engageant

- ingénieur

- ENGINEERING

- Anglais

- Entreprise

- Divertissement

- Environment

- notamment

- etc

- exemple

- exemples

- Exclusive

- existant

- d'experience

- expérimenté

- Expériences

- expert

- étendre

- visages

- facilite

- famille

- Fonctionnalité

- Fonctionnalités:

- BOPP

- s'adapter

- flexible

- flotteur

- se concentre

- mettant l'accent

- suivre

- Abonnement

- suit

- Pour

- forêt

- trouvé

- Fondation

- Fondationale

- amis

- De

- avant

- plein

- fonction

- Notions de base

- Gain

- jeux

- générer

- généré

- génère

- générateur

- génération

- génératif

- IA générative

- générateur

- donné

- Don

- en verre.

- aller

- Or

- Or

- gps

- gris

- Vert

- mis à la terre

- l'orientation

- guide

- main

- manipuler

- Mains

- heureux vous

- he

- Cœur

- la taille

- aider

- aide

- haute performance

- de haute qualité

- Souligner

- sa

- tenue

- Comment

- How To

- HTML

- HTTPS

- identifier

- if

- image

- Recherche d'images

- satellite

- la mise en oeuvre

- implémentations

- importer

- surtout

- in

- comprendre

- inclus

- Y compris

- indexé

- index

- industrie

- d'information

- technologie innovante

- technologie innovante

- contribution

- à l'intérieur

- installer

- Des instructions

- intégrer

- des services

- intéressé

- intérêts

- interieur

- développement

- Introduit

- invisible

- vous aider à faire face aux problèmes qui vous perturbent

- IT

- articles

- itérer

- SES

- JavaScript

- jeans

- joindre

- jpg

- json

- XNUMX éléments à

- ACTIVITES

- Genre

- spécialisées

- Labs

- Peindre

- lac

- langue

- portatif

- gros

- plus tard

- lancer

- conduisant

- apprentissage

- LED

- jambes

- VIE

- comme

- limité

- Liste

- chargement

- Style

- Faible

- click

- machine learning

- LES PLANTES

- Entrée

- facile

- a prendre une

- fabricant

- FAIT DU

- gérés

- gestion

- manager

- masque

- Match

- allumettes

- Matériel

- mat

- Matière

- max

- maximales

- Mai..

- sens

- Médias

- engrener

- méthodes

- miroir

- Réduire les

- atténuation

- modèle

- numériques jumeaux (digital twin models)

- modifié

- Surveiller

- PLUS

- plusieurs

- Musique

- Nature

- Besoin

- Besoins

- négatif

- Neon

- neural

- Nouveauté

- Plus récent

- nlp

- nœud

- Node.js

- Aucun

- noter

- Remarquer..

- Notifications

- nombre

- numpy

- objet

- Détection d'objet

- objets

- of

- on

- ONE

- en ligne

- uniquement

- Opérations

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Option

- Options

- or

- Autre

- Autres

- contour

- sortie

- sorties

- au contrôle

- plus de

- global

- vue d'ensemble

- propre

- Pain

- paramètre

- partie

- Patron de Couture

- motifs

- Effectuer

- performant

- Téléphone

- photographie

- Photos

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- veuillez cliquer

- les poches

- des notes bonus

- poser

- Post

- power

- alimenté

- Méthode

- pratique

- précis

- La précision

- Premium

- empêché

- précédent

- Directeur

- la confidentialité

- produire

- Produit

- produire

- Produit

- chef de produit

- Produits

- programmable

- Projet

- gestion de projet SUR mesure

- projets

- instructions

- proven

- fournir

- à condition de

- fournit

- aportando

- des fins

- Python

- qualité

- requêtes

- question

- vite.

- R

- R & D

- aléatoire

- gamme

- Tarif

- RE

- en temps réel

- réaliste

- récemment

- Recommandation

- recommandations

- recommandé

- Rouge

- réduire

- reportez-vous

- référencement

- affiner

- refléter

- réflexion

- en relation

- Les relations

- détendu

- rester

- enlèvement

- supprimez

- Supprimé

- enlever

- rendement

- rendu

- remplacer

- représentent

- représentation

- représente

- conditions

- un article

- chercheur

- réponse

- responsables

- résultant

- Résultats

- retourner

- Retours

- déchiré

- robotique

- Rôle

- ROSE

- Round

- d'exécution

- s

- garanties

- sagemaker

- même

- échantillon

- économie

- Escaliers intérieurs

- scène

- Sciences

- Scientifique

- écoper

- scénario

- scripts

- Sdk

- Rechercher

- recherche

- Section

- les sections

- sécurité

- seed

- voit

- sémantique

- supérieur

- phrase

- séparé

- Série

- besoin

- service

- Services

- service

- set

- Sets

- mise

- installation

- sept

- Boutique

- Shorts

- devrait

- Spectacles

- côté

- Argent

- similaires

- étapes

- unique

- Taille

- tailles

- Sky

- sleep

- Sneakers

- Fragment

- So

- Football

- Logiciels

- solide

- sur mesure

- Solutions

- Résout

- quelques

- Space

- Spatial

- calcul spatial

- groupe de neurones

- spécifiquement

- spécificité

- spécifié

- Dépenses

- dépensé

- Sportive

- propagation

- Standard

- peuplements

- Commencer

- étapes

- Étapes

- droit

- rue

- Chaîne

- STRONG

- fondamentaux solides

- Catégorie

- sujet

- tel

- convient

- Dimanche

- Support

- Appareils

- haute

- Prenez

- tâches

- prise

- réservoir

- Tâche

- tâches

- Les technologies

- Technologie

- modèles

- texte

- qui

- La

- La Région

- leur

- puis

- Là.

- Ces

- this

- ceux

- trois

- Avec

- fiable

- Des séries chronologiques

- Titan

- Titre

- titres

- à

- Tokens

- top

- traqueur

- Tracking

- Transformer

- Voyage

- Voyages

- arbre

- deux

- type

- types

- débutante

- compréhension

- comprend

- mobilier urbain

- utilisé

- d'utiliser

- incontournable

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- Valeurs

- variable

- Variante

- variations

- divers

- version

- via

- visible

- vision

- le volume

- marcher

- marche

- souhaitez

- chaud

- était

- Montres

- personne(s) regarde(nt) cette fiche produit

- Eau

- filigranes

- Façon..

- we

- web

- services Web

- Quoi

- quand

- que

- qui

- tout en

- blanc

- large

- Large gamme

- largeur

- sera

- comprenant

- dans les

- activités principales

- workflows

- de travail

- vos contrats

- world

- écrire

- X

- années

- Yoga

- Vous n'avez

- Votre

- zéphyrnet